無人機(jī)飛行高度對(duì)植被覆蓋度和植被指數(shù)估算結(jié)果的影響

何 勇,杜曉月,鄭力源,朱姜蓬,岑海燕,許麗佳

·農(nóng)業(yè)航空工程·

無人機(jī)飛行高度對(duì)植被覆蓋度和植被指數(shù)估算結(jié)果的影響

何 勇1,2,杜曉月1,2,鄭力源1,2,朱姜蓬1,2,岑海燕1,2,許麗佳3

(1. 浙江大學(xué)生物系統(tǒng)工程與食品科學(xué)學(xué)院,杭州 310058;2. 農(nóng)業(yè)農(nóng)村部光譜檢測(cè)重點(diǎn)實(shí)驗(yàn)室,杭州 310058;3. 四川農(nóng)業(yè)大學(xué)機(jī)電學(xué)院,四川 625014)

將無人機(jī)與多種成像傳感設(shè)備相結(jié)合可實(shí)現(xiàn)田間作物表型信息的全面獲取。針對(duì)田間復(fù)雜環(huán)境下無人機(jī)搭載多種成像傳感設(shè)備在不同飛行高度處提取的作物信息具有差異性的問題,該研究著重探究了無人機(jī)搭載2種成像傳感設(shè)備獲取圖像時(shí),不同飛行高度對(duì)估算植被覆蓋度以及植被指數(shù)結(jié)果的影響。首先為防止外界環(huán)境變化對(duì)獲取圖像質(zhì)量造成干擾,通過最近鄰插值算法將無人機(jī)飛行高度為25 m處獲取的2個(gè)多光譜和可見光圖像數(shù)據(jù)集分別退化為10個(gè)不同地面分辨率的模糊圖像數(shù)據(jù)集,模擬無人機(jī)在不同飛行高度下獲取的作物圖像。然后獲取50 m高度處的無人機(jī)圖像數(shù)據(jù)集,通過皮爾遜相關(guān)性分析驗(yàn)證模擬數(shù)據(jù)集的有效性。最后采用隨機(jī)森林模型估算不同數(shù)據(jù)集中的植被覆蓋度,分類精度大于91%。結(jié)果發(fā)現(xiàn),當(dāng)植被覆蓋度小于1/2時(shí),隨著地面分辨率的降低該指標(biāo)不斷被低估,反之則被高估。飛行高度50 m的真實(shí)圖像與模擬圖像估算植被覆蓋度結(jié)果的相關(guān)系數(shù)為0.992 8,兩者具有強(qiáng)相關(guān)性,模擬圖像估算得到的植被覆蓋度變化具備參考意義。植被指數(shù)估算結(jié)果中,首先對(duì)無人機(jī)圖像數(shù)據(jù)集進(jìn)行輻射校正、閾值分割等圖像預(yù)處理,然后根據(jù)公式計(jì)算得到植被指數(shù),最后通過假設(shè)性檢驗(yàn)對(duì)10個(gè)圖像數(shù)據(jù)集計(jì)算得出的植被指數(shù)進(jìn)行分析。結(jié)果發(fā)現(xiàn),可見光植被指數(shù)在飛行高度61 m時(shí)均具備顯著性差異(<0.05),在飛行高度42 m時(shí)沒有差異(>0.1),多光譜植被指數(shù)在10個(gè)高度下均沒有顯著性差異,因此為保證無人機(jī)獲取數(shù)據(jù)的準(zhǔn)確性與完整性,當(dāng)無人機(jī)搭載該研究的兩種相機(jī)獲取作物信息時(shí)建議飛行高度為42 m。研究結(jié)果可為研究者利用無人機(jī)搭載多傳感設(shè)備獲取作物信息設(shè)定合適的飛行高度、減小作業(yè)成本提供參考。

無人機(jī);植被指數(shù);植被覆蓋度;飛行策略

0 引 言

無人機(jī)(Unmanned Aerial Vehicle,UAV)作為中小型飛行平臺(tái)具有不需要專用機(jī)場(chǎng)、起降靈活、成本低等優(yōu)點(diǎn),與以時(shí)效性高、不損害目標(biāo)物體等特點(diǎn)著稱的遙感技術(shù)相結(jié)合可實(shí)現(xiàn)復(fù)雜農(nóng)田環(huán)境下高效、無損的采集作物表型信息[1],通過圖譜處理技術(shù)可監(jiān)測(cè)作物表型特征如植被覆蓋度[2],作物高度[3-5],氮素[6-7],葉綠素[8],生物量[9-10]等,在農(nóng)業(yè)領(lǐng)域具有廣泛的應(yīng)用。目前可用于無人機(jī)的機(jī)載成像傳感設(shè)備大致可分為高光譜成像設(shè)備、多光譜成像設(shè)備、可見光成像設(shè)備3種,采集到的光譜信息和空間信息各有不同,總體來看可見光成像設(shè)備可獲取高分辨率的作物三維信息但只可以提供R、G、B三通道的光譜信息,高光譜成像設(shè)備在光譜維可以捕捉更多的信息但受限于成像方式應(yīng)用較少,多光譜成像設(shè)備由于其體積與成像方式受到研究學(xué)者的青睞[11],但只可獲取部分空間信息和光譜信息。

因此為了滿足不同的農(nóng)情信息獲取需求,研究學(xué)者采用多種成像傳感設(shè)備相結(jié)合的方式采集作物信息[1,11-12]。但隨著無人機(jī)搭載成像傳感設(shè)備的多樣性逐漸增加,不同傳感設(shè)備分辨率、視場(chǎng)角各不相同,無人機(jī)飛行參數(shù)設(shè)定成為難題。現(xiàn)有的飛行參數(shù)設(shè)定大多依賴經(jīng)驗(yàn)法則,尤其是飛行高度設(shè)定一般都是在保證飛行安全、無障礙物、獲取圖像清晰、無人機(jī)風(fēng)場(chǎng)不擾動(dòng)作物的情況下人為設(shè)定,往往無法最大化的提高傳感設(shè)備利用效率,使得實(shí)驗(yàn)成本增加,耗費(fèi)人力物力。因此研究不同飛行高度變化對(duì)獲取作物信息準(zhǔn)確性的影響對(duì)優(yōu)化飛行策略、提高飛行效率、降低作業(yè)成本具有重要意義。

由于植被覆蓋度(Fractional Vegetation Cover,F(xiàn)VC)是作物非常重要的生理指標(biāo),它作為一個(gè)定量化描述作物生長(zhǎng)發(fā)育動(dòng)態(tài)差異的表型參數(shù)[8,12],與冠層理化參數(shù)如葉面積指數(shù)[13]等具有非常密切的關(guān)系,還可用來評(píng)估作物的生理生化指標(biāo),如作物氮素[14]、早期活力[15]和衰老狀態(tài)[16]等。同時(shí)植被指數(shù)(Vegetation Indices,VIs)可用來反演葉綠素含量[8,17]、干物質(zhì)含量[18]、植被覆蓋度[19]、產(chǎn)量[20]等,對(duì)生成處方圖、指導(dǎo)農(nóng)田增產(chǎn)施肥噴藥至關(guān)重要。

因此本研究采用植被覆蓋度和植被指數(shù)作為探究無人機(jī)飛行高度設(shè)定的參考,主要工作為針對(duì)無人機(jī)飛行高度設(shè)定往往難以兼顧搭載的多種成像傳感設(shè)備性能各有不同的難題,以搭載兩種不同的成像傳感設(shè)備為例,研究了無人機(jī)不同飛行高度變化對(duì)估算作物植被覆蓋度和植被指數(shù)結(jié)果的影響,根據(jù)信息不變性最終確定無人機(jī)最優(yōu)飛行高度,實(shí)現(xiàn)高效、無損獲取作物信息的同時(shí)提高飛行效率。

1 材料和方法

1.1 試驗(yàn)田和圖像獲取

本研究中使用多旋翼UAV[1]搭載2種傳感設(shè)備(多光譜傳感設(shè)備和可見光傳感設(shè)備)在浙江大學(xué)西區(qū)油菜試驗(yàn)田進(jìn)行試驗(yàn)(如圖1所示),試驗(yàn)田內(nèi)部小區(qū)為規(guī)則化分布,長(zhǎng)2 m,寬1.2 m,油菜生長(zhǎng)時(shí)期為抽薹早期。采用的UAV機(jī)身高約0.35 m,機(jī)翼圓周直徑約為1.1 m,為延長(zhǎng)續(xù)航時(shí)間使用16 000 mAh的鋰電池提供動(dòng)力,最長(zhǎng)可飛行25 min,最高載質(zhì)量8 kg傳感設(shè)備。UAV搭載的多光譜(Multispectral,MS)成像傳感設(shè)備為XIMEA的MQ022MG-CM工業(yè)相機(jī)(XIMEA,Munster,Germany),可采集400~1 000 nm范圍內(nèi)不連續(xù)的25個(gè)波段光譜信息(波長(zhǎng)分別為603、611、624、632、641、649、657、666、674、679、693、718、732、745、758、771、784、796、808、827、838、848、859、868和870 nm),感光元件尺寸為11.3 mm×6.0 mm,相機(jī)鏡頭采用Edmund 16 mm定焦鏡頭(Edmund,Barrington,USA),可獲取分辨率為409像素×216像素的圖像,相機(jī)質(zhì)量約123 g,同時(shí)該平臺(tái)搭載了索尼NEX-7 (Sony,Tokyo,Japan)作為可見光(Red-Green-Blue,RGB)成像傳感設(shè)備采集高分辨率圖像,感光元件尺寸為23.5 mm×15.6 mm圖像分辨率為6 000像素×4 000像素,鏡頭為索尼SEL16F28(Sony,Tokyo,Japan),相機(jī)質(zhì)量約285 g。

圖1 試驗(yàn)地點(diǎn)和場(chǎng)地分布圖

多旋翼無人機(jī)分別搭載多光譜相機(jī)和可見光相機(jī)以定點(diǎn)采集的方式在25和50 m處采集油菜圖像,重疊度設(shè)定為航向75%、旁向60%。采集當(dāng)天無云無風(fēng),手動(dòng)設(shè)置兩個(gè)傳感設(shè)備的曝光時(shí)間等參數(shù)。總共獲取飛行高度25 m時(shí)高精度多光譜(MS)和可見光(RGB)圖像各162張,飛行高度50 m時(shí)獲取MS和RGB圖像各88張。同一飛行架次的MS圖像經(jīng)過輻射一致性校正后利用Agisoft Photoscan軟件通過特征點(diǎn)匹配、對(duì)齊圖像、生成網(wǎng)格、建立正射影圖等步驟進(jìn)行圖像拼接得到正射影像圖,25 m高度處的正射影圖如圖2a所示。RGB圖像直接通過Agisoft Photoscan進(jìn)行圖像拼接獲取正射影圖,25 m高度處的正射影圖如圖2b所示。利用Matlab可視化分別將多光譜和可見光正射影圖根據(jù)種植小區(qū)的物理坐標(biāo)分布進(jìn)行批量裁剪,通過圖像像素坐標(biāo)與種植小區(qū)的感興趣區(qū)域(Region Of Interest,ROI)一一對(duì)應(yīng),最終獲得兩種真實(shí)高度下RGB和多光譜影像各315個(gè)樣本。

圖2 無人機(jī)正射影像圖

1.2 無人機(jī)圖像處理

地面分辨率大小在無人機(jī)圖像處理中至關(guān)重要,他定義了單位像素所描述的實(shí)際目標(biāo)長(zhǎng)度[21],數(shù)值越大說明地面分辨率越低,根據(jù)式(1)可知地面分辨率與飛行高度密切相關(guān),計(jì)算式如下:

GR×FH/FL(1)

式中GR表示圖像的地面分辨率,表示相機(jī)傳感器的單像素尺寸,F(xiàn)H表示飛行高度,F(xiàn)L表示傳感器鏡頭焦距。當(dāng)無人機(jī)飛行高度增加時(shí),相機(jī)傳感器的單像素尺寸保持不變,傳感器鏡頭焦距保持不變,則單位像素中描述的實(shí)際目標(biāo)長(zhǎng)度變長(zhǎng),涵蓋的地物信息增多,使得圖像的混合像元效應(yīng)加劇。因此地面分辨率越高意味著可以獲取更為細(xì)致的作物信息。

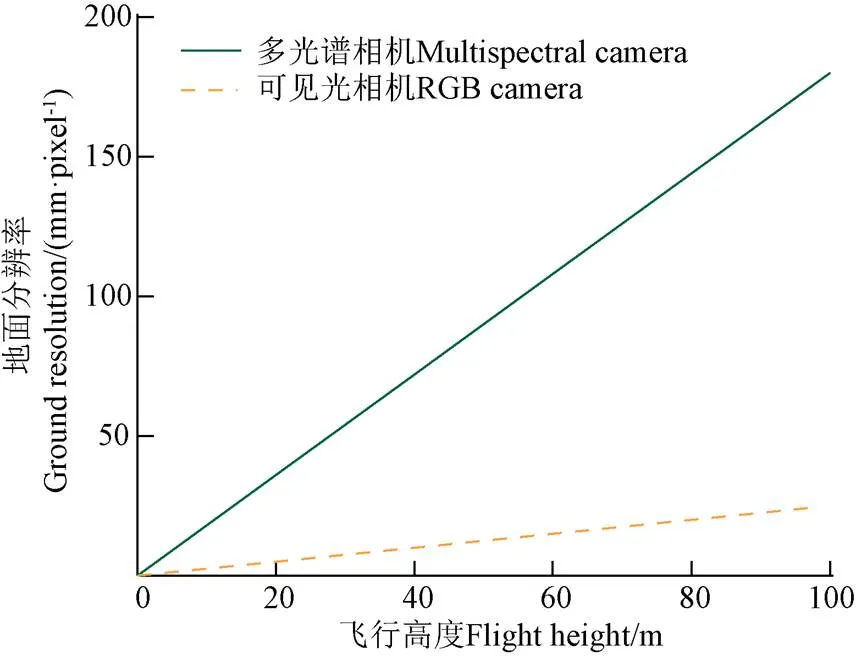

由式(1)可知,飛行高度與地面分辨率成線性關(guān)系(圖 3),因此為了控制單一變量?jī)H探究飛行高度對(duì)植被覆蓋度和植被指數(shù)估算結(jié)果的影響,避免受外界環(huán)境和相機(jī)配置(如光照條件、曝光時(shí)間等)對(duì)獲取圖像質(zhì)量造成干擾,采用最近鄰插值法將獲取的高分辨率多光譜圖像和可見光圖像(即飛行高度25 m)依次退化成為不同梯度的低地面分辨率的模糊圖像,以模擬無人機(jī)在不同飛行高度處獲取的圖像。該方法中新插值像素點(diǎn)的值的確定方式是先將新插值點(diǎn)映射至初始圖像中(圖4),假設(shè)坐標(biāo)是(x,y),然后計(jì)算該點(diǎn)和周圍相鄰4個(gè)像素點(diǎn)(0,0)、(1,1)、(2,2)、(3,3)的距離,距離數(shù)值最小的相鄰像素點(diǎn)的值即為該點(diǎn)的值。

圖3 多光譜相機(jī)和RGB相機(jī)不同飛行高度與地面分辨率關(guān)系圖

注:x代表橫坐標(biāo),y代表縱坐標(biāo),0為原點(diǎn);A,B,C,D分別代表需要求得點(diǎn)L的相鄰像素點(diǎn),坐標(biāo)值采用(xm, ym)(m=0,1,2,3)形式表示。xn代表求得像素點(diǎn)L的橫坐標(biāo),yn代表所求像素點(diǎn)L的縱坐標(biāo)。

根據(jù)式(1)設(shè)定FH=25 m,則計(jì)算得出多光譜相機(jī)的GR=43 mm/pixel,再將每個(gè)小區(qū)圖像通過最近鄰插值法降級(jí)為不同地面分辨率(從43~430 mm/pixel不均等的10個(gè)水平,第一水平為真實(shí)獲取的圖像即參考圖像)的圖像。25 m高度時(shí)可見光相機(jī)的地面分辨率為6 mm/pixel,運(yùn)用同樣方法降級(jí)為地面分辨率6~60 mm/pixel不等的10個(gè)水平的粗略圖像。

1.3 隨機(jī)森林估算植被覆蓋度

由于隨機(jī)森林[22]的像素分類模型無需大量的訓(xùn)練樣本和動(dòng)態(tài)設(shè)置閾值、在復(fù)雜光照條件(陰影和強(qiáng)光)下也能較好地對(duì)植被進(jìn)行分割[23],因此本研究采用該算法來估算油菜的植被覆蓋度(Fractional Vegetation Cover,F(xiàn)VC)。根據(jù)前人研究[8,13]利用高清可見光圖像可計(jì)算真實(shí)的FVC,RGB圖像較MS圖像具備更高的空間分辨率,25 m高度時(shí)地面分辨率為6 mm/pixel,可作為真實(shí)FVC。對(duì)獲取的全部可見光圖像進(jìn)行分類處理并計(jì)算植被覆蓋度,暫不討論多光譜圖像對(duì)其的計(jì)算結(jié)果。將兩種不同高度的可見光正射影圖通過Matlab圖像裁剪算法以不同種植小區(qū)為最小單位分別裁剪得到不同高度各315個(gè)樣本圖像,由于小區(qū)均勻分布當(dāng)飛行高度25 m時(shí)獲得每個(gè)樣本大小為480像素×160像素,飛行高度50 m時(shí)樣本大小240像素×80像素。隨機(jī)森林分類模型的主要步驟包括構(gòu)建訓(xùn)練集、利用所構(gòu)建的訓(xùn)練集進(jìn)行訓(xùn)練生成分類模型、再對(duì)所有圖像像素進(jìn)行分類。在不同地面分辨率的油菜小區(qū)圖像中分別建立分類模型,按照2∶1的比例隨機(jī)分為訓(xùn)練集和測(cè)試集,在訓(xùn)練圖像上選擇植被和背景類別的興趣區(qū)域,植被的興趣區(qū)域包含陰影葉和強(qiáng)光照射葉等植被,背景的興趣區(qū)域包括土壤和農(nóng)田設(shè)施等非植被場(chǎng)景。每個(gè)興趣區(qū)域只能屬于植被或者背景類別之一,并進(jìn)行類別標(biāo)記(植被標(biāo)簽為1,背景標(biāo)簽為0)。利用每個(gè)訓(xùn)練集數(shù)據(jù)的6個(gè)顏色特征(,,,,,)生成決策樹,應(yīng)用構(gòu)造的樹模型將像素分類為植被或背景類。然后去除背景,以植被像素除以圖像像素得到最終每個(gè)小區(qū)的FVC。

1.4 部分植被指數(shù)計(jì)算

由于油菜對(duì)不同波長(zhǎng)光的響應(yīng)不同,通常表現(xiàn)為在綠光、近紅外波段具有較強(qiáng)的反射效果,在藍(lán)光、紅光波段具有吸收效果,因此結(jié)合油菜不同波段的反射、吸收特性,研究者提出不同的植被指數(shù)用于增強(qiáng)植被信息、降低背景干擾,達(dá)到更好的對(duì)作物進(jìn)行后續(xù)研究的目的[24-27]。具體實(shí)現(xiàn)方式是首先對(duì)獲取的無人機(jī)圖像數(shù)據(jù)集通過地面反射率校正板進(jìn)行輻射一致性校正(式(2)),然后通過閾值分割去除背景得到不同光譜波段的作物光譜反射率曲線,通過不同光譜波段反射率進(jìn)行組合運(yùn)算最終得到作物的植被指數(shù)。

n=DNn×0×DN0-1(2)

式中DN0為地面反射率校正板的平均圖像灰度值,0為已知的地面反射率校正板的光譜反射率,并且地面反射率校正板光譜反射率均一,DNn為光譜圖像的各個(gè)像素的DN,n為求得的光譜圖像的各個(gè)像素的反射率。目前遙感領(lǐng)域中常用的植被指數(shù)根據(jù)使用波段的不同大致可分為近紅外植被指數(shù)和可見光植被指數(shù),應(yīng)用較為廣泛的近紅外波段范圍的有歸一化植被指數(shù)[28]、比值植被指數(shù)[29]和比值短波紅外指數(shù)[30]等。運(yùn)用可見光波段計(jì)算的主要有過綠指數(shù)[31]、歸一化綠紅差異指數(shù)[32]、差異植被指數(shù)[33]、可見大氣阻力指數(shù)[34]及紅綠比值指數(shù)[35]等。本研究基于可見光相機(jī)對(duì)比了歸一化綠紅差異指數(shù)、差異植被指數(shù)和過綠指數(shù),基于多光譜相機(jī)對(duì)比了歸一化植被指數(shù)和比值植被指數(shù),分別分析了在不同地面分辨率下圖像對(duì)其的影響。植被指數(shù)計(jì)算如表1所示。

表1 基于多光譜和可見光相機(jī)的植被指數(shù)

注:=/(++),=/(++),=B/(++),、、分別為紅、綠、藍(lán)通道的灰度值;R代表600~1 000 nm波段范圍內(nèi)的光譜反射率值。

Note:=/(++),=/(++),=/(++),,andare the DNs of Red, Blue and Green channels, respectively.Rrepresents the reflectance of a variable band in the spectral region of 600-1000 nm.

2 結(jié)果評(píng)價(jià)與飛行策略

本研究采用決定系數(shù)(2)和均方根誤差(Root Mean Square Error,RMSE)兩個(gè)常規(guī)指標(biāo)作為估算結(jié)果的評(píng)價(jià)指標(biāo),針對(duì)不同地面分辨率圖像計(jì)算得到的植被指數(shù)采用假設(shè)性檢驗(yàn)方式判別是否具有顯著性差異。將參考圖像分別與9個(gè)水平圖像進(jìn)行假設(shè)性檢驗(yàn),假設(shè)2個(gè)樣本為獨(dú)立的隨機(jī)樣本并遵循正態(tài)分布,給定置信區(qū)間(1-)為0.95,顯著性水平()為0.05,計(jì)算得到值。≤0.001為有極顯著差異,0.001≤≤0.01為顯著差異,0.01≤≤0.05為有差異,0.05<為沒有差異。

當(dāng)出現(xiàn)FHm-1高度的假設(shè)性檢驗(yàn)結(jié)果>0.05且FHm高度的假設(shè)性檢驗(yàn)結(jié)果≤0.05時(shí)說明該高度(FHm)及以上高度獲取的作物信息與真實(shí)獲得作物信息具有統(tǒng)計(jì)學(xué)差異,因此無人機(jī)在搭載該設(shè)備進(jìn)行圖像獲取時(shí)應(yīng)該低于FHm飛行。為了提高飛行效率降低飛行成本并獲取正確的光譜圖像,最優(yōu)的飛行高度應(yīng)設(shè)定為FHm-1。值得注意的是為了得到更為精確的飛行高度可以進(jìn)行更為精細(xì)的圖像退化處理研究。

3 結(jié)果與分析

3.1 模擬圖像估算植被覆蓋度變化

將無人機(jī)獲取的高精度(飛行高度25 m)可見光圖像通過最近鄰插值法依次得到9個(gè)水平的低地面分辨率圖像,由于不同高度獲取圖像特征不同,為每一個(gè)高度的可見光數(shù)據(jù)集分別建立RF分類模型,并按照2∶1隨機(jī)分為訓(xùn)練集和測(cè)試集,測(cè)試集數(shù)據(jù)用來評(píng)估模型的分類準(zhǔn)確性,在本研究中總體平均準(zhǔn)確性>91%。不同地面分辨率圖像植被分割效果如圖5所示,可以看出,F(xiàn)VC準(zhǔn)確度與地面分辨率高低息息相關(guān),參照?qǐng)D像上的植被部分能夠被準(zhǔn)確地分割,隨著地面分辨率的降低,植被區(qū)域的細(xì)節(jié)逐漸模糊和丟失。將低地面分辨率圖像與參考圖像估算得到的FVC作線性回歸,如圖6所示,發(fā)現(xiàn)隨著地面分辨率降低,2不斷減小,RMSE呈上升趨勢(shì),即隨著飛行高度的增加對(duì)FVC計(jì)算產(chǎn)生的影響越大。

注:?jiǎn)挝? mm·pixel-1。

圖6 不同低地面分辨率圖像與參考圖像的植被覆蓋度關(guān)系

選取植被覆蓋度大于0.5的所有田塊做統(tǒng)計(jì)分析,發(fā)現(xiàn)隨著地面分辨率降低,F(xiàn)VC呈上升趨勢(shì)并趨近于1,而對(duì)于植被覆蓋度小于0.5的所有田塊發(fā)現(xiàn)隨著地面分辨率降低FVC呈下降趨勢(shì)并趨近于0,分別抽取了FVC>0.5和<0.5的3個(gè)樣本小區(qū)(如圖7)展示了各小區(qū)的植被覆蓋度隨地面分辨率的變化趨勢(shì)。由于沒有FVC=0.5的樣本小區(qū),特別選取了FVC最接近于0.5(FVC=0.497)的樣本小區(qū),如圖7b 中樣本編號(hào)3所示。Hu等[36]同樣驗(yàn)證了此結(jié)論。綜上,隨著飛行高度的增加,估算植被覆蓋度的結(jié)果呈現(xiàn)規(guī)律性變化,當(dāng)FVC大于0.5時(shí)估算FVC逐漸增大,當(dāng)FVC小于0.5時(shí)估算FVC逐漸減小。

3.2 真實(shí)圖像估算植被覆蓋度變化

為了驗(yàn)證利用最近鄰插值算法得出的不同高度圖像與真實(shí)飛行高度得到的圖像的差異性。采用飛行高度50 m(GR為12 mm/pixel)的真實(shí)圖像作相同處理,即首先將該高度下的正射影圖像首先通過Matlab根據(jù)樣本進(jìn)行剪裁,然后運(yùn)用隨機(jī)森林分類算法分割植被與背景,計(jì)算得到該高度下的不同樣本的植被覆蓋度,最后與模擬該高度圖像的植被覆蓋作皮爾遜相關(guān)性分析,結(jié)果顯示相關(guān)系數(shù)為0.992 8,具有強(qiáng)相關(guān)性,說明模擬圖像估算得到的植被覆蓋度具備參考意義。

由于外界擾動(dòng)作用,飛行高度50 m(GR為12 mm/pixel)時(shí)獲取的原始圖像和25 m(GR為6 mm/pixel)時(shí)獲取的圖像存在時(shí)間、光照、作物形態(tài)的差異,使得參考圖像與模擬圖像對(duì)植被覆蓋度估算產(chǎn)生不同。但研究發(fā)現(xiàn)不同地面分辨率圖像估算植被覆蓋度變化的規(guī)律不變,對(duì)于真實(shí)獲取的2種不同地面分辨率圖像估算FVC的結(jié)果如表2所示。當(dāng)FVC>0.5的樣本在飛行高度50 m處得到的植被覆蓋度估算結(jié)果中中位數(shù)和標(biāo)準(zhǔn)偏差均比25 m處的更高,即估算的植被覆蓋度數(shù)據(jù)較25 m處整體偏高且數(shù)據(jù)更離散。當(dāng)FVC<0.5的樣本在飛行高度50 m處得到的植被覆蓋度各項(xiàng)指標(biāo)均比25 m處得到的更低,這與模擬圖像估算植被覆蓋度結(jié)果的規(guī)律相同,驗(yàn)證了模擬圖像估算FVC的可靠性。

圖7 不同樣本小區(qū)估算植被覆蓋度隨地面分辨率的變化

表2 不同地面分辨率圖像的植被覆蓋度估算結(jié)果

3.3 植被指數(shù)變化

3.3.1 可見光圖像

將可見光傳感設(shè)備(NEX-7)在飛行高度25 m時(shí)拍攝的圖像根據(jù)最近鄰插值法退化成10個(gè)不同水平地面分辨率(6.0、6.7、7.5、8.6、10.0、12.0、15.0、20.0、30.0和60.0 mm/pixel)圖像。研究發(fā)現(xiàn)隨著地面分辨率降低,圖像灰度值(Digital Number,DN)呈下降趨勢(shì)(圖8),且在大于30 mm/pixel地面分辨率時(shí)會(huì)出現(xiàn)一個(gè)平緩現(xiàn)象。將計(jì)算得到的歸一化綠紅差值指數(shù)NGRDI、可見光波段差異植被指數(shù)VDVI、過綠指數(shù)EXG分別作假設(shè)性檢驗(yàn),結(jié)果如圖9所示。

圖8 DN值隨地面分辨率的變化

圖9 不同地面分辨率RGB圖像獲取的植被指數(shù)假設(shè)性檢驗(yàn)結(jié)果

當(dāng)?shù)孛娣直媛蕿?0 mm/pixel時(shí)(即飛行高度約42 m)3種植被指數(shù)的值均大于0.05((NGRDI)=0.41,(VDVI)=0.24,(EXG)=0.12),即該飛行高度可見光相機(jī)獲取的作物信息與25 m飛行高度相比沒有差異。當(dāng)?shù)孛娣直媛蕿?2 mm/pixel時(shí)(即飛行高度約50 m)(NGRDI)=0.09,(VDVI)=0.03,(EXG)=0.02,說明部分植被指數(shù)計(jì)算結(jié)果有差異(VDVI和EXG)。當(dāng)?shù)孛娣直媛蕿?5 mm/pixel時(shí)(即飛行高度約61 m)3種植被指數(shù)的值均小于0.01((NGRDI)=0.008,(VDVI)=0.003,(EXG)=0.002),且后3個(gè)水平趨近于0,說明當(dāng)飛行高度大于等于61 m時(shí)該可見光相機(jī)獲取的作物信息與25 m飛行高度相比具有顯著性差異。因此,當(dāng)無人機(jī)搭載該可見光相機(jī)進(jìn)行試驗(yàn)時(shí),為準(zhǔn)確的獲取3種植被指數(shù),建議飛行高度不高于61m,最佳飛行高度為42 m左右。若只需要獲取準(zhǔn)確的NGRDI,則建議飛行高度為50 m左右。

3.3.2 多光譜圖像

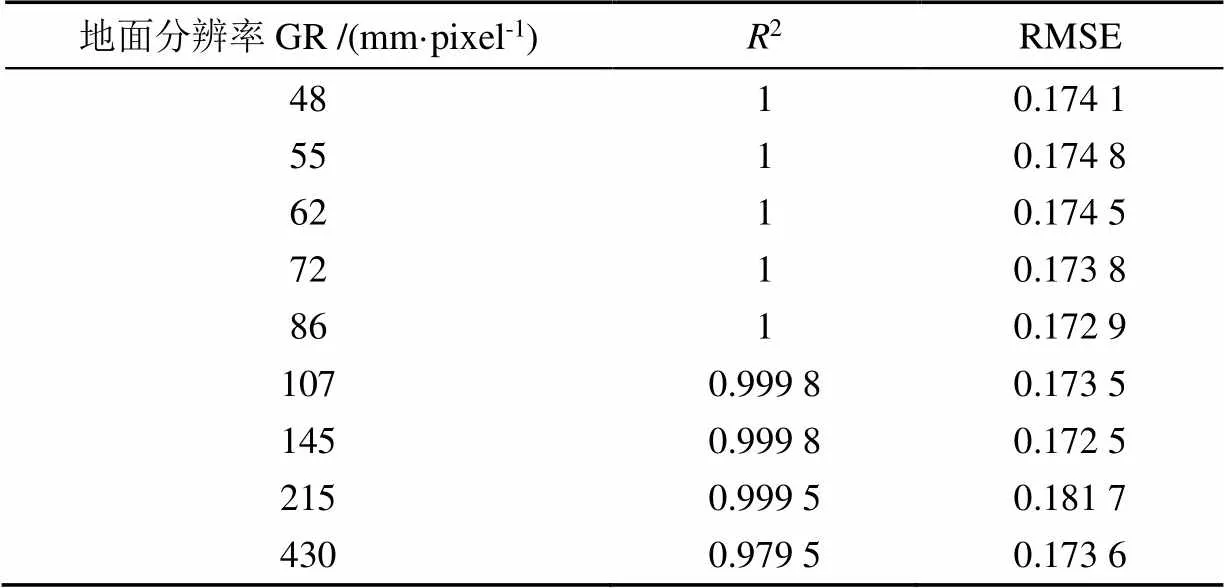

無人機(jī)搭載的多光譜相機(jī)獲取的圖像波段范圍為600~875 nm,將飛行高度25 m時(shí)的多光譜圖像根據(jù)最近鄰插值法退化成10個(gè)不同水平地面分辨率(43、48、55、62、72、86、107、145、215和430 mm/pixel)圖像,根據(jù)光譜反射率計(jì)算式(2)計(jì)算得出整個(gè)小區(qū)的光譜反射率,取平均得到該小區(qū)的平均反射率光譜曲線,將不同地面分辨率水平下的得到的平均反射率光譜與參考圖像下的平均反射率光譜作一元線性回歸,結(jié)果發(fā)現(xiàn)決定系數(shù)以及均方根誤差受高度影響幾乎可以忽略不計(jì)(表 3)。這可能是由于多光譜相機(jī)的分辨率較可見光相機(jī)低很多,在飛行高度25 m時(shí)獲取的多光譜圖像可能已經(jīng)出現(xiàn)了一定程度的作物和背景信息融合的現(xiàn)象,又由于實(shí)驗(yàn)對(duì)象為大尺度的小區(qū)冠層的平均反射率光譜,所以在飛行高度的逐步增加的前期階段變化并不明顯,但是當(dāng)飛行高度大于一定高度時(shí)(即地面分辨率為430 mm/pixel),由于圖像退化程度過高,圖像混元現(xiàn)象嚴(yán)重,會(huì)使得獲取的作物光譜信息發(fā)生明顯變化(圖10)。

表3 不同地面分辨率下的平均反射率光譜的線性擬合結(jié)果

圖10 單小區(qū)不同地面分辨率平均反射率光譜

將不同地面分辨率圖像根據(jù)公式分別計(jì)算歸一化植被指數(shù)NDVI和比值短波紅外指數(shù)RSI,并將低地面分辨率圖像與參考圖像獲取的兩種指數(shù)分別作假設(shè)性檢驗(yàn),結(jié)果如圖11所示,研究發(fā)現(xiàn)在本研究選擇的10個(gè)水平中值均大于0.5,即2個(gè)樣本不具備顯著性差異。由此可知,飛行高度在25 m及以上9個(gè)飛行高度時(shí)該多光譜相機(jī)獲取的平均反射率光譜與植被指數(shù)差異不大。因此在無人機(jī)飛行高度的選擇上可以根據(jù)搭載的可見光相機(jī)來確定最終參數(shù),盡可能的提高作業(yè)效率降低作業(yè)成本。在前9個(gè)水平多光譜相機(jī)獲取的植被指數(shù)無明顯差異的原因可能是由于多光譜相機(jī)與可見光相機(jī)相比空間分辨率較低,且使用無人機(jī)搭載該相機(jī)需要減少風(fēng)場(chǎng)對(duì)作物的擾動(dòng)作用,需要保持一定的飛行高度而不能完全貼近作物,而25 m的飛行高度可能在一定程度上已超出多光譜相機(jī)獲取最精準(zhǔn)信息的臨界值,有待后續(xù)研究驗(yàn)證。

圖11 不同地面分辨率多光譜圖像獲取的植被指數(shù)假設(shè)性檢驗(yàn)結(jié)果

3.4 飛行策略

基于本研究中無人機(jī)搭載的多光譜和可見光相機(jī)獲取的作物圖像,通過對(duì)作物表型參數(shù)中的重要指標(biāo)植被覆蓋度和植被指數(shù)進(jìn)行計(jì)算分析,結(jié)果發(fā)現(xiàn)植被覆蓋度估算結(jié)果會(huì)隨著飛行高度的增加會(huì)呈現(xiàn)趨勢(shì)性變化,當(dāng)植被覆蓋度小于0.5時(shí)隨著飛行高度增加會(huì)不斷被低估,反之被高估。這是由于植被覆蓋度的估算精準(zhǔn)度直接受到圖像地面分辨率的影響,無人機(jī)飛行高度越高,圖像地面分辨率越低,估算結(jié)果誤差越大。同時(shí)結(jié)果發(fā)現(xiàn)由光譜反射率計(jì)算得出的植被指數(shù)在一定飛行高度內(nèi)不會(huì)產(chǎn)生顯著性差異,除非當(dāng)飛行高度過高、圖像混元效應(yīng)過于嚴(yán)重時(shí)才會(huì)出現(xiàn)顯著變化。因此,當(dāng)無人機(jī)作業(yè)時(shí),若提高飛行高度必將損失一定的植被覆蓋度估算精度,但可以保證一定程度的光譜信息的準(zhǔn)確性,綜合考慮獲取的作物光譜、空間信息以及無人機(jī)作業(yè)效率和成本,研究者可以根據(jù)實(shí)驗(yàn)?zāi)康倪x擇合適的飛行高度。本研究中搭載的兩款機(jī)載設(shè)備的試驗(yàn)結(jié)果表明多光譜相機(jī)信息獲取的最優(yōu)高度不可高于120 m,即地面分辨率為215 mm/pixel時(shí),可見光相機(jī)信息獲取的最優(yōu)高度為42 m,即地面分辨率為10 mm/pixel時(shí)。綜上,在42 m的高度下可以更好的發(fā)揮多光譜相機(jī)和可見光相機(jī)的數(shù)據(jù)采集優(yōu)勢(shì)。

4 總結(jié)與展望

無人機(jī)遙感平臺(tái)通常用于在大田條件下的作物生長(zhǎng)動(dòng)態(tài)監(jiān)控,同時(shí)也為作物隨生長(zhǎng)季節(jié)產(chǎn)生的發(fā)育狀態(tài)提供一個(gè)實(shí)時(shí)的監(jiān)測(cè)方法。利用無人機(jī)遙感平臺(tái)搭載多種傳感器獲取高分辨率田間作物圖像并結(jié)合數(shù)字圖像處理技術(shù)提取作物表型信息和表型數(shù)據(jù)分析方法,能夠?yàn)樘镩g作物無損監(jiān)測(cè)與表型評(píng)估提供有效的解決方案。進(jìn)一步的,無人機(jī)作業(yè)平臺(tái)通過搭載不同的傳感器來實(shí)現(xiàn)田間作物全面生長(zhǎng)信息監(jiān)測(cè),一般飛行高度為10~100 m不等。根據(jù)選擇不同的傳感設(shè)備類型獲取的地面分辨率1~100 mm/pixel不等,同一傳感設(shè)備獲取更高的地面分辨率的圖像則需要更低的飛行高度,更大的作業(yè)量和更高的作業(yè)成本。若同時(shí)搭載不同的傳感器,無人機(jī)飛行參數(shù)設(shè)置則需加入設(shè)備參數(shù)各有不同如何協(xié)同合作的考量。因此為平衡無人機(jī)飛行成本和獲取高地面分辨率圖像的同時(shí)充分發(fā)揮各傳感設(shè)備獲取作物信息的能力、優(yōu)化飛行參數(shù)(高度)具有必要性和重要意義。

在本研究中,通過無人機(jī)平臺(tái)搭載不同的傳感器(多光譜相機(jī),索尼NEX-7相機(jī))獲取兩種飛行高度的油菜冠層圖像,分別為25 和50 m。利用可見光相機(jī)捕獲高分辨率圖像。再將在25 m處獲得的圖像作為參照?qǐng)D像,依次將該圖像退化成-系列具有不同地面分辨率大小水平的圖像,以模擬基于UAV的平臺(tái)在不同飛行高度處采集的圖像。利用基于隨機(jī)森林算法對(duì)多類無人機(jī)遙感圖像進(jìn)行分類,計(jì)算各圖像的植被覆蓋度。將可見光相機(jī)在25 m處捕獲的高分辨率圖像的植被覆蓋度作為參照植被覆蓋度,以評(píng)估無人機(jī)不同飛行高度對(duì)植被覆蓋度計(jì)算精度的影響。結(jié)果發(fā)現(xiàn)植被覆蓋度會(huì)隨著地面分辨率的變化而變化,且當(dāng)參照植被覆蓋度高于0.5時(shí),隨著飛行高度的增加FVC逐漸偏向于1,易被高估;當(dāng)植被覆蓋度低于0.5時(shí),隨著飛行高度的增加植被覆蓋度FVC逐漸偏向于0,易被低估。并將飛行高度50 m的真實(shí)圖像與模擬圖像得到的植被覆蓋度作皮爾遜相關(guān)性分析,相關(guān)系數(shù)為0.992 8,驗(yàn)證了模擬圖像與真實(shí)圖像具有一致性。同時(shí)針對(duì)可見光相機(jī)分析了不同地面分辨率對(duì)于NGRDI、VDVI和EXG的影響,結(jié)果表明當(dāng)飛行高度不低于61 m時(shí)可見光植被指數(shù)發(fā)生顯著性差異(<0.05),飛行高度42 m時(shí)沒有顯著性差異(>0.1)。針對(duì)多光譜植被指數(shù)分析了不同地面分辨率對(duì)于NDVI、RSI的影響,發(fā)現(xiàn)兩類指數(shù)在飛行高度42 和61 m時(shí)均沒有顯著性差異,因此當(dāng)無人機(jī)搭載該兩種型號(hào)的成像設(shè)備高效全面的獲取作物農(nóng)情信息時(shí)為保證信息的準(zhǔn)確性可設(shè)定飛行高度為42 m。

綜上本研究無人機(jī)飛行高度參數(shù)設(shè)定在不要求極高植被覆蓋度的情況下可以根據(jù)可見光相機(jī)在植被指數(shù)中的表現(xiàn)選擇。本研究?jī)H針對(duì)少類作物表型參數(shù)指標(biāo)探究其與不同地面分辨率的變化關(guān)系,具有一定局限性。后期可以利用基于無人機(jī)近感的田間作物表型平臺(tái)在不同飛行高度上獲取實(shí)拍圖像,進(jìn)一步探索飛行高度對(duì)作物表型參數(shù)的影響,為設(shè)置最優(yōu)飛行高度提供參考。

[1] Wan L, Cen H, Zhu J, et al. Grain yield prediction of rice using multi-temporal UAV-based RGB and multispectral images and model transfer: A case study of small farmlands in the South of China[J]. Agriculture and Forest Meteorology, 2020, 291: 1-15.

[2] Ahmed O S, Shemrock A, Chabot D, et al. Hierarchical land cover and vegetation classification using multispectral data acquired from an unmanned aerial vehicle[J]. International Journal of Remote Sensing, 2017, 38(8/9/10): 2037-2052.

[3] Iersel W V, Straatsma M, Addink E, et al. Monitoring height and greenness of non-woody floodplain vegetation with UAV time series[J]. Remote Sensing, 2018, 141: 112-123.

[4] Hu P, Chapman S C, Wang X, et al. Estimation of plant height using a high throughput phenotyping platform based on unmanned aerial vehicle and self-calibration: Example for sorghum breeding[J]. European Journal of Agronomy, 2018, 95: 24-32.

[5] 宋磊,李嶸,焦義濤,等. 基于ResNeXt單目深度估計(jì)的幼苗植株高度測(cè)量方法[J]. 農(nóng)業(yè)工程學(xué)報(bào),2022,38(3):155-163.

Song Lei, Li Rong, Jiao Yitao, et al. Method for measuring seedling height based on ResNeXt monocular depth estimation[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(3): 155-163. (in Chinese with English abstract)

[6] Wang Z, Skidmore A K, Darvishzadeh R, et al. Mapping forest canopy nitrogen content by inversion of coupled leaf-canopy radiative transfer models from airborne hyperspectral imagery[J]. Agricultural and Forest Meteorology, 2018, 253: 247-260.

[7] 王玉娜,李粉玲,王偉東,等. 基于無人機(jī)高光譜的冬小麥氮素營(yíng)養(yǎng)監(jiān)測(cè)[J]. 農(nóng)業(yè)工程學(xué)報(bào),2020,36(22):31-39.

Wang Yuna, Li Fenling, Wang Weidong, et al. Monitoring of winter wheat nitrogen nutrition based on UAV hyperspectral images[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(22): 31-39. (in Chinese with English abstract)

[8] Jay S, Baret F, Dutartre D, et al. Exploiting the centimeter resolution of UAV multispectral imagery to improve remote-sensing estimates of canopy structure and biochemistry in sugar beet crops[J]. Remote Sensing of Environment, 2019, 231: 1-17.

[9] Cen H, Wan L, Zhu J, et al. Dynamic monitoring of biomass of rice under different nitrogen treatments using a lightweight UAV with dual image-frame snapshot cameras[J]. Plant Methods, 2019, 15: 1-16.

[10] 劉建剛,趙春江,楊貴軍,等. 無人機(jī)遙感解析田間作物表型信息研究進(jìn)展[J]. 農(nóng)業(yè)工程學(xué)報(bào),2016,32(24):98-106.

Liu Jiangang, Zhao Chunjiang, Yang Guijun, et al. Review of field-based phenotyping by unmanned aerial vehicle remote sensing platform[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2016, 32(24): 98-106. (in Chinese with English abstract)

[11] Wan L, Li Y, Cen H, et al. Combining UAV-based vegetation indices and image classification to estimate flower number in oilseed rape[J]. Remote Sensing, 2018, 10: 1-18.

[12] Kefauver S C, Vicente R, Vergara-Díaz O, et al. Comparative UAV and field phenotyping to assess yield and nitrogen use efficiency in hybrid and conventional barley[J]. Frontiers in Plant Science, 2017, 8: 1-15.

[13] Jin X, Liu S, Baret F, et al. Estimates of plant density of wheat crops at emergence from very low altitude UAV imagery[J]. Remote Sensing of Environment, 2017, 198: 105-114.

[14] Hunt E R, Horneck D A, Spinelli C B, et al. Monitoring nitrogen status of potatoes using small unmanned aerial vehicles[J]. Precision Agriculture, 2018, 19: 314-333.

[15] Kipp S, Mistele B, Baresel P, et al. High-throughput phenotyping early plant vigour of winter wheat[J]. European Journal of Agronomy, 2014, 52(B): 271-278.

[16] Walter A, Liebisch F, Hund A. Plant phenotyping: from bean weighing to image analysis[J]. Plant Methods, 2015, 11: 1-11.

[17] Xie M, Wang Z, Huete A, et al. Estimating peanut leaf chlorophyll content with dorsiventral leaf adjusted indices: Minimizing the impact of spectral differences between adaxial and abaxial leaf surfaces[J]. Remote Sensing, 2019, 11: 1-15

[18] Yi Q, Wang F, Bao A, et al. Leaf and canopy water content estimation in cotton using hyperspectral indices and radiative transfer models[J]. International Journal of Applied Earth Observation and Geoinformation, 2014, 33: 67-75.

[19] Lin G A, Xwa B, Baj C, et al. Remote sensing algorithms for estimation of fractional vegetation cover using pure vegetation index values: A review[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2020, 159: 364-377.

[20] Zhou X, Zheng H B, Xu X Q, et al. Predicting grain yield in rice using multi-temporal vegetation indices from UAV-based multispectral and digital imagery[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2017, 130: 246-255.

[21] Yao H, Qin R, Chen X. Unmanned aerial vehicle for remote sensing applications-a review[J]. Remote Sensing, 2019, 11:1-22.

[22] Mariana B, Lucian D. Random forest in remote sensing: A review of applications and future directions[J]. ISPRS Journal of Photogrammetry and Remote Sensing, 2016, 114: 24-31.

[23] Wei G, Zheng B, Tao D, et al. EasyPCC: Benchmark datasets and tools for high-throughput measurement of the plant canopy coverage ratio under field conditions[J]. Sensors, 2017, 17(4): 1-13.

[24] Inoue Y, Guerif M, Baret F, et al. Simple and robust methods for remote sensing of canopy chlorophyll content: A comparative analysis of hyperspectral data for different types of vegetation[J]. Plant Cell and Environment, 2016, 39(12): 2609-2623.

[25] Huang S, Tang L, Hupy J P, et al. A commentary review on the use of normalized difference vegetation index (NDVI) in the era of popular remote sensing[J]. Journal of Forestry Research, 2021, 32: 1-6.

[26] 劉峻明,周舟,和曉彤,等. 頻率直方圖與植被指數(shù)結(jié)合的冬小麥遙感產(chǎn)量估測(cè)[J]. 農(nóng)業(yè)工程學(xué)報(bào),2021,37(23):145-152.

Liu Junming, Zhou Zhou, He Xiaotong, et al. Estimating winter wheat yield under frequency histogram and vegetation index using remote sensing[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(23): 145-152. (in Chinese with English abstract)

[27] 于豐華,邢思敏,郭忠輝,等. 基于特征轉(zhuǎn)移植被指數(shù)的水稻葉片氮素含量定量估算[J]. 農(nóng)業(yè)工程學(xué)報(bào),2022,38(2):175-182.

Yu Fenghua, Xing Simin, Guo Zhonghui, et al. Remote sensing inversion of the nitrogen content in rice leaves using character transfer vegetation index[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(2): 175-182. (in Chinese with English abstract)

[28] Rebetzke G J, Jimenez-Berni J A, Bovill W D, et al. High-throughput phenotyping technologies allow accurate selection of stay-green[J]. Journal of Experimental Botany, 2016, 67(17): 4919-4924.

[29] Gitelson A A. Wide dynamic range vegetation index for remote quantification of biophysical characteristics of vegetation[J]. Journal of Plant Physiology, 2004, 161(2): 165-173.

[30] Das B, Sahoo R N, Pargal S, et al. Quantitative monitoring of sucrose, reducing sugar and total sugar dynamics for phenotyping of water-deficit stress tolerance in rice through spectroscopy and chemometrics[J]. Spectrochimica Acta Part A Molecular and Biomolecular Spectroscopy, 2018, 192: 41-51.

[31] Varela S, Pederson T, Bernacchi C J, et al. Understanding growth dynamics and yield prediction of sorghum using high temporal resolution uav imagery time series and machine learning [J]. Remote Sensing, 2021, 13:1- 17.

[32] Zhang J, Qiu X, Wu Y, et al. Combining texture, color, and vegetation indices from fixed-wing UAS imagery to estimate wheat growth parameters using multivariate regression methods[J]. Computers and Electronics in Agriculture, 2021, 185: 106-138.

[33] Louhaichi M, Borman M M, Johnson D E. Spatially located platform and aerial photography for documentation of grazing impacts on wheat[J]. Geocarto International, 2001, 16: 65-70.

[34] Gitelson A A, Kaufman Y J, Stark R, et al. Novel algorithms for remote estimation of vegetation fraction[J]. Remote Sensing of Environment, 2002, 80: 76-87.

[35] Zhang L, Niu Y, Zhang H, et al. Maize canopy temperature extracted from UAV thermal and RGB imagery and its application in water stress monitoring[J]. Frontiers in Plant Science, 2019, 10: 1-18.

[36] Hu P C, Guo W, Scott C, et al. Pixel size of aerial imagery constrains the applications of unmanned aerial vehicle in crop breeding[J]. Journal of Photogrammetry and Remote Sensing, 2019, 154: 1-9.

Effects of UAV flight height on estimated fractional vegetation cover and vegetation index

He Yong1,2, Du Xiaoyue1,2, Zheng Liyuan1,2, Zhu Jiangpeng1,2, Cen Haiyan1,2, Xu Lijia3

(1.,,310058,; 2.,,310058,; 3.,,625014,)

Accurate acquisition of crop information is very important for the real-time monitoring of crop growth status in crop breeding and agricultural precision management. The ever-increasing remote sensing (RS) and Unmanned Aerial vehicles (UAV) have been widely used to collect the big phenotypic data (especially image data) of various plants in a large area. Specific sensing devices are often used to obtain accurate and comprehensive information on crop growth. However, the diversity of sensing devices can bring a great challenge to the cooperation between them on UAV. It is very urgent to establish UAV flight parameters suitable for the complex field environment. In this study, an effective approach was developed to explore the effects of UAV flight height on the estimated fractional vegetation cover (FVC) and vegetation index (VI). The UAV can ultimately be utilized to collect the phenotypic data within the effective range under the multi-sensor combinations based on suitable flight height. The multispectral and high-resolution RGB cameras were simultaneously mounted on the UAV to acquire the images at a speed of 2.5 m/s. Among them, the heading and the side overlaps were set as 75% and 60%, respectively, particularly for the possibility of successful image stitching. The initial flight heights were set as 25 and 50 m, in order to exclude the wind field generated by the high-speed rotation of the UAV's paddles from disturbing the crop. The high ground resolution (GR) images were collected by the UAV at the low flight height. These images were then degraded by image processing into a series of images with different GR. The simulation was finally carried out to predict the crop images obtained by the UAV at different flight heights. As such, the impact of environmental changes on image quality was reduced, such as the light intensity. The FVC of every sample plot was estimated using Random Forest (RF). The results show that the vegetation classification accuracy was greater than 91%. The regular FVC changes were found in the different GR, due to the image blending phenomenon. Once the FVC was less than half, the indicator was constantly underestimated with the decrease of the GR. Otherwise, the indicator was overestimated. Pearson correlation analysis was also performed on the real and simulated images at a flight height of 50 m, in order to verify the feasibility of simulated images for FVC estimation. The results show that the Pearson correlation coefficient was 0.992 8 between the real and simulated images at a flight height of 50 m, indicating a high correlation. Moreover, a similar regular variation was also found in the FVC that was estimated by the real images. Five VIs (the combination of spectral reflectance) were calculated to enhance vegetation information and weaken non-vegetation one. The hypothesis testing was used to verify whether the vegetation indices had significant differences. The results show that significant differences (<0.05) occurred in the RGB VIs at a ground resolution of 15 mm/pixel (i.e., the flight height of 61 m), whereas no difference (>0.1) was found at 10 mm/pixel (i.e., flight height of 42 m). Meanwhile, the multispectral VIs were not significantly different at both ground resolutions (>0.5). Fortunately, the flight height range within 42 m presented less impact on the acquisition of RGB spectral information. Consequently, a flight height of less than 42 m can be the optimal parameter to collect the crop information using the two devices at the same time. Anyway, the spectral and spatial information using other devices at higher flight heights can also be further investigated in the future. The finding can provide a strong reference for setting the suitable flight height to obtain the crop information, in order to reduce the operating costs using multi-sensor equipment carried by UAVs.

UAV; vegetation index; fractional vegetation cover; flight strategy

10.11975/j.issn.1002-6819.2022.24.007

S24

A

1002-6819(2022)-24-0063-10

何勇,杜曉月,鄭力源,等. 無人機(jī)飛行高度對(duì)植被覆蓋度和植被指數(shù)估算結(jié)果的影響[J]. 農(nóng)業(yè)工程學(xué)報(bào),2022,38(24):63-72.doi:10.11975/j.issn.1002-6819.2022.24.007 http://www.tcsae.org

He Yong, Du Xiaoyue, Zheng Liyuan, et al. Effects of UAV flight height on estimated fractional vegetation cover and vegetation index[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(24): 63-72. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2022.24.007 http://www.tcsae.org

2022-09-05

2022-11-11

浙江省重點(diǎn)研發(fā)計(jì)劃項(xiàng)目(021C02023)

何勇,博士,教授,研究方向?yàn)槭轮参?土壤-環(huán)境信息感知技術(shù)與先進(jìn)傳感器、精細(xì)農(nóng)業(yè)與智能傳感技術(shù)及裝備、無人機(jī)低空遙感等。Email:yhe@zju.edu.cn