基于攝像機跟蹤和深度信息的三維合成

王高飛,余 剛,謝世斌

(成都索貝數碼科技股份有限公司 基礎技術研究院,四川 成都 610041)

基于攝像機跟蹤和深度信息的三維合成

王高飛,余 剛,謝世斌

(成都索貝數碼科技股份有限公司 基礎技術研究院,四川 成都 610041)

闡述一種新的基于攝像機跟蹤和深度信息的三維合成技術。此技術將2D視頻源轉為3D視頻,然后提取3D視頻源的深度信息,再將攝像機跟蹤和視頻深度信息有機結合起來,使得3D視頻和3D物件在三維場景中有機融合,進而獲得更加真實自然的三維合成效果。

三維合成;2D轉3D;深度信息提取;攝像機跟蹤

【本文獻信息】王高飛,余剛,謝世斌.基于攝像機跟蹤和深度信息的三維合成[J].電視技術,2015,39(2).

1 三維合成原理

三維合成是將3D視頻和3D物件在同一個三維場景中進行疊加和渲染,讓兩者有機融合在一起,形成一個真實自然的三維場景。三維合成一般是將3D物件融合進3D視頻場景中,為了達到真實的效果,需要提取出3D視頻和3D物件的深度信息,通過深度信息得到兩者之間的遮擋關系,然后進行疊加。基本疊加示意圖如圖1所示。

圖1 三維合成示意圖

圖1中,長方體遮擋住了小汽車,但又被松樹遮擋,這種遮擋關系,是根據小汽車、長方體和松樹之間的深度關系產生的,這樣,就營造出了符合邏輯的三維場景。對于視頻畫面,一般都是含有運動物體,比如行走的人和行駛的車輛,如果要在這種運動場景中融合進3D物件,僅有3D視頻和3D物件的深度信息,雖然可以產生疊加效果,但3D視頻中物體會產生自旋轉,而深度信息是不包含這種自旋轉信息的。這樣疊加出來的三維場景就會讓人感覺3D物件和3D視頻場景互相脫離,不是在一個統一的三維空間中,給人一種虛假的表象。類似的,3D視頻中一輛小汽車慢慢駛離鏡頭,逐漸遠去,如果和小汽車配合的3D物件沒有逐漸變小,變模糊,也會給人一種兩者相互脫離的感覺,瞬間讓三維合成效果大打折扣。

為了避免這種3D物件和3D視頻場景相互脫節的情況出現,本文提出一種基于攝像機跟蹤和深度信息的新的三維合成技術。三維合成的流程示意圖如圖2所示。

圖2 三維合成流程圖

圖2描述了本文闡述的三維合成技術的整個流程。整個流程的文字描述如下:

1)源視頻為2D視頻,則通過2D轉3D技術,轉換為3D視頻,同時獲取深度信息;源視頻為3D視頻,則提取深度信息。

2)對3D視頻進行攝像機跟蹤,獲得每一幀的攝像機參數。

3)根據深度信息和每幀的攝像機參數,將3D物件融合進3D視頻,從而得到三維合成場景。

下面對涉及到的重要技術點2D轉3D、3D視頻深度信息提取和攝像機跟蹤進行簡單描述。

2 2D轉3D

目前,不管是廣電行業,還是一般民用消費市場,視頻的片源主要是2D視頻。因此,在三維合成系統中,有相當一部分視頻源為2D視頻,這就需要將2D視頻轉換為3D視頻。2D轉3D的基本流程圖如圖3所示。

圖3 2D轉3D流程圖

2D轉3D流程的重點是深度信息的生成,目前有很多比較成熟的算法,主流算法都以圖像分割為基礎或作為一個支撐點。獲得深度信息之后,為避免“卡片堆積”效應,需要對獲得的深度信息進行平滑處理,一般采用高斯模糊即可。最后生成3D畫面時,如果質量要求不高或者對效率要求較高,可以只生成左眼畫面,直接使用源單眼畫面作為右眼畫面,使用源單眼畫面作為右眼畫面的原因是約70%人的視覺以右眼為主。

2D轉3D的主流算法分為兩種:基于離焦原理分割前景和背景區域算法[1]和基于運動估計的圖像深度區域分割算法[2]。離焦算法根據離焦原理,即處于人眼或攝像機焦點處的畫面銳利,含有較多的高頻信息,離焦點越遠的區域,越模糊,含有較多的低頻信息。通過Higher-Order Statistics,即高階統計量方法,加上區域生成等方法,將2D畫面分割為前景和背景區域。運動估計算法的主要原理為運動差越大的區域,離人眼或者攝像機越近。由于此方法能夠計算出物體之間的遮擋關系,因此提取出的深度更符合邏輯。這兩種算法各有優劣,前者可以將單張2D圖片轉換為3D圖片,對于多焦點畫面或者整幅比較模糊的運動畫面,效果比較差;后者提取出的深度信息更加符合邏輯,更加準確,但卻無法提取單張圖片的深度信息。

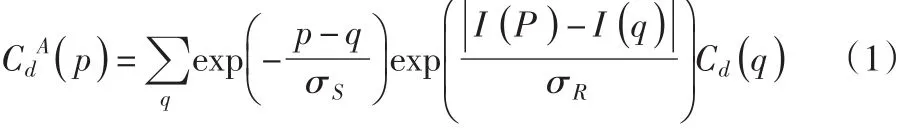

本文描述的技術采用離焦原理進行2D轉3D,樣例圖如圖4所示。

圖4中,圖像4a為虛擬產生的左眼圖像,圖像4b為原2D圖像(作為右眼圖像),圖像4c為從原2D圖像提取出來的深度信息圖像。

3 深度信息提取

目前,市場上大部分3D攝像機拍攝的3D視頻都不含深度信息,而在三維合成中,需要3D視頻和3D物件的深度信息,才可以判斷出兩者之間的遮擋關系。這樣,三維合成中就需要一個提取3D視頻深度信息的環節。

圖4 2D轉3D樣例圖

深度信息提取算法可以分為局部和全局兩大類。局部算法按照窗口對圖像進行劃分,以窗口為單位進行計算,這樣計算量小,但計算出來的深度信息會有較強的邊界效應。全局算法可以有效避免深度信息的邊界效應,但計算量大。楊慶雄[3]提出的非局部花費積累算法來提取深度信息,此算法使用樹形結構來計算像素間的相似性。在像素構成的最小生成樹上進行花費積累計算(雙邊濾波器即可達到較好效果),可以一方面避免局部算法產生的邊界效應,另一方面避免全局算法產生的巨大計算量。通過左右眼視差計算出深度信息后,可以使用樹形濾波[4]進行深度信息的平滑和縮放處理,以達到對深度信息提取流程和質量優化的目的。

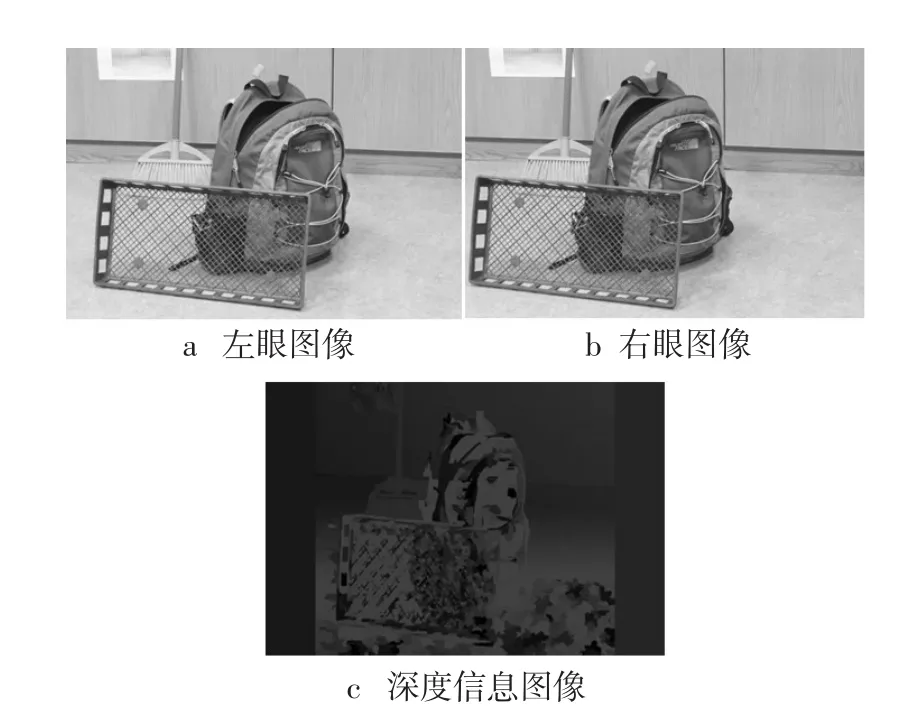

基于雙邊濾波花費積累公式為

式中:Cd(q)表示在視差等級為d時像素q的匹配花費;I表示引導圖像;σS和σR分別表示空間相似度常量和范圍相似度常量。

如果在MST上應用此花費積累公式,則可以轉換為

式中:D(p,q)表示像素p和像素q在MST上的距離;σ表示σS和σR的一個線性組合。這樣,可以在MST上計算花費積累,減少了計算量,同時可以避免邊界效應。

對3D視頻進行深度信息提取的樣例圖如圖5所示。

4 攝像機跟蹤

攝像機跟蹤技術主要用來獲取視頻拍攝時攝像機的角度,從而計算出視頻中物體的運動軌跡,以及旋轉角度。攝像機跟蹤技術是3D物件和視頻融合的基本技術,攝像機跟蹤得到的視頻攝像機幀參數的好壞直接決定了兩者融合產生的效果,要么渾然一體,要么漏洞百出。

圖5 深度信息提取樣例圖

攝像機跟蹤算法按照流程可以劃分為兩個階段——攝像機標定和攝像機跟蹤。攝像機標定的主要目的是得到視頻拍攝的攝像機的內部參數以及畸變參數,這樣才能在后期的攝像機跟蹤中更精確地計算出攝像機幀參數。目前無標記的攝像機標定技術都是基于張正友[5]的平面標定法,此算法對于視頻畫面要求低,具有較高的魯棒性。

攝像機跟蹤算法較多,可以按照是否需要模型庫進行劃分。董子龍[6]等提出實時攝像機跟蹤算法需要一個離線的特征模型庫,在跟蹤時只提取視頻關鍵幀參數進行匹配,以達到實時跟蹤的目的。

Georg Klein博士在2006年的博士論文中闡述了一種非標記且不需要特征數據庫的視頻跟蹤方法用于增強現實。在2007年,他將這種方法加以發展,提出了并行跟蹤和映射方法[7]用于增強現實。此方法使用光束平差法計算出畫面中點的3D空間坐標,為了精確匹配特征點,可以使用SIFT或SURF算子得到物體的精確匹配,最后使用基于擴展卡曼濾波的SLAM算法來估算3D空間中點的運動來達到精確跟蹤的效果。

攝像機跟蹤的樣例圖如圖6所示。

圖6 攝像機跟蹤樣例圖

從圖6可以看出,隨著手的移動,甚至是手指的相對移動,虛擬3D物件依然可以準確地找到跟蹤物體,并會隨著視頻中的物體做相應的旋轉和平移運動。

5 三維合成

通過深度信息提取可以得到3D視頻中不同物體的深度,3D物件在渲染的時候已經包含了深度信息,這樣通過深度信息可以將3D物件符合邏輯地融合進3D視頻場景。攝像機跟蹤可以比較精確地計算出3D視頻場景中一個物體的運動和旋轉信息。這樣在3D物件渲染時,調整3D物件的攝像機參數,使之配合3D視頻場景中一個物體的運動和旋轉,就能夠更加真實地將3D物件融合進行3D視頻,得到一個真實感強、符合視覺邏輯的三維合成場景。

3D物件和視頻的三維合成樣例圖如圖7所示。

圖7 三維合成樣例圖

[1] KO J,KIM M,KIM C.2D-To-3D stereoscopic conversion: depth-map estimation in a 2D single-view image[EB/OL].[2014-10-18].http://cat.inist.fr/?aModele=afficheN&cpsidt=205876 88.

[2] FENG Yue,REN Jinchang,JIANG Jianmin.Object-based 2D-to-3D video conversion for effective stereoscopic content gen?eration in 3D-TV applications[J].IEEE Trans.Broadcasting,2011,57(2):500-509.

[3] YANG Qingxiong.A non-local cost aggregation method for stereo matching[EB/OL].[2014-10-18].http://www.computer.org/csdl/pro?ceedings/cvpr/2012/1226/00/177P2A27-abs.htm l.

[4] YANG Qingxiong.Stereo matching using tree filtering[EB/OL].[2014-10-18].http://www.computer.org/csdl/trans/tp/preprint/06888 475-abs.htm l.

[5] ZHANG Z.A flexible new technique for camera calibration[J].IEEE Trans.Pattern Analysis and Machine Intelligence,2000,22(11):1330-1334.

[6]DONG Zilong,ZHANG Guofeng,JIA Jiaya,et al.Keyframe-based real-time camera tracking[EB/OL].[2014-10-18].http://www.docin.com/p-588205058.htm l.

[7] KLEIN G,MURRAY D.Parallel tracking and mapping for small AR workspaces[EB/OL].[2014-10-18].http://dl.acm.org/citation.cfm?id=1514363.

責任編輯:任健男

TN948

B

10.16280/j.videoe.2015.02.012

2014-11-18