面向交通流量預測的時空超關系圖卷積網絡

張永凱,武志昊,3,林友芳,3,趙苡積*

(1.北京交通大學計算機與信息技術學院,北京 100044;2.交通數據分析與挖掘北京市重點實驗室(北京交通大學),北京 100044;3.中國民用航空局民航旅客服務智能化應用技術重點實驗室,北京 100105)

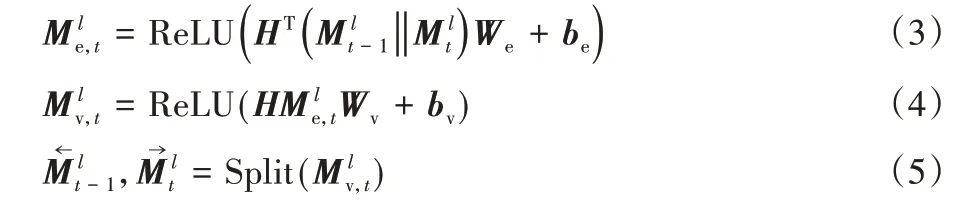

(?通信作者電子郵箱yijizhao@bjtu.edu.cn)

0 引言

交通流量預測是智能交通系統[1]中重要的研究課題之一,準確地預測交通流量對城市智能交通管理有著重大的意義[2]。例如,交通管理部門可以基于預測結果提前進行交通管控,疏導擁堵車流,降低安全隱患。

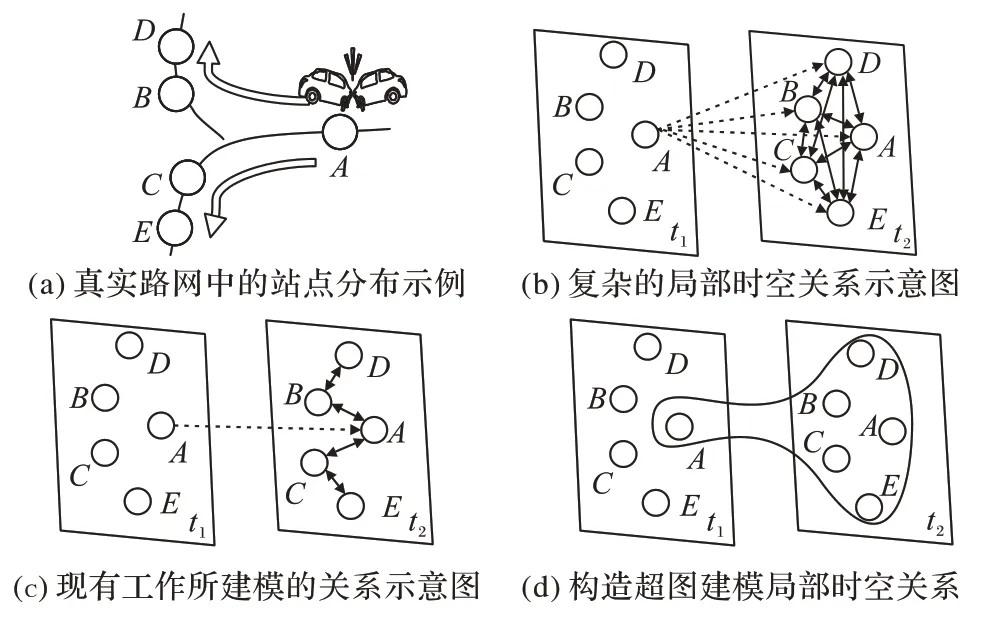

準確地預測交通流量是富有挑戰性的,主要原因在于一個站點的當前狀態會同時影響到自身及其鄰居的未來狀態。如圖1(a)所示,當位置A在t1時間步發生交通擁堵或事故時,其交通狀態可能直接影響到自身及其鄰近位置B、C、D、E在t2時間步的狀態。該影響可以被表示為圖1(b)中At1(即位置A在t1時間步的狀態,下同)與At2、Bt2、Ct2、Dt2、Et2之間存在的跨時空維度的直接關聯性(圖中虛線所示)。此外,位置A、B、C、D、E之間還存在空間關聯性(圖中實線所示),即它們因地理位置鄰近而在單個時間步內可能呈現相似的交通狀態。上述現象說明At1、At2、Bt2、Ct2、Dt2、Et2彼此之間都存在著緊密的關聯。這些關聯通常同時存在,共同組成了一種復雜的局部時空關系。

圖1 交通流量數據的復雜關系與建模方案Fig.1 Complex relationships and modeling schemes of traffic flow data

為了建模上述關系,近期的一些工作通過將流量預測問題轉化為時空圖預測問題取得了較大的進展。一種代表性的方案是從復雜的局部時空關系中抽取部分易于被現有模型所捕獲的關系,并構造深度學習模型來捕獲它們。如圖1(c)所示,大多數現有的模型遵循STGCN(Spatio-Temporal Graph Convolutional Network)[3]和DCRNN(Diffusion Convolutional Recurrent Neural Network)[4]的設計范式,采用空間組件(如圖卷積網絡(Graph Convolutional Network,GCN)[5]來捕獲空間維度上的相關性(圖中實線所示),并結合時間組件(如循環神經網絡(Recurrent Neural Network,RNN)[6-7]或一維卷積神經網絡(Convolutional Neural Network,CNN)[8])來捕獲時間維度上的相關性(圖中虛線所示)。由于空間組件和時間組件分離,這些模型無法建模時間維度和空間維度之間的相互作用。最近,Song 等[9]將時間維度和空間維度上的關系視為是同步的(即一個整體),并構造了一種時空同步圖卷積網絡STSGCN(Spatial-Temporal Synchronous Graph Convolutional Network)預測模型來同時捕獲兩個維度上的關系。盡管上述模型都取得了不錯的效果,但是它們只捕獲了局部時空關系中易于建模的一部分關系,大量的跨時空維度的直接關聯性在上述模型中沒有被顯式建模。雖然上述模型可以通過大量組件迭代來間接地將At1的信息傳遞給Dt2以模擬跨時空關聯,但是傳遞過程中的信息損耗導致這種模擬的關系存在誤差,隨著組件增多,迭代誤差會逐漸累積,因此上述方法不能準確且全面地建模復雜的局部時空關系。

為了解決上述問題,本文提出使用超圖[10]來對復雜的局部時空關系進行建模。具體而言,如圖1(d)所示,將t1時間步的At1節點和它在下一時間步t2的自身At2、周圍一定空間范圍內的鄰居Bt2、Ct2、Dt2和Et2組成一條超邊來建模這些關系。由于這條超邊同時連接著跨空間和時間維度的多個節點,本文稱之為時空超關系。在此基礎上,構造了一個新的時空超關系圖卷積網絡預測模型來捕獲這種關系用于交通流量預測。本文的工作主要有:

1)提出一種新穎的時空超圖建模方案,構造了一種時空超關系來全面地建模復雜的局部時空關系;

2)提出一種新穎的時空超關系圖卷積網絡(Spatio-Temporal Hyper-Relationship Graph Convolutional Network,STHGCN)預測模型用于交通流量預測;

3)在四個真實的公開數據集上進行了大量的實驗,驗證了本文模型的預測能力優于現有同類預測模型。

1 相關工作

交通流量預測是時空數據挖掘領域中的一個重要研究課題。早期的研究將它看作一個時間序列預測問題,常見的有統計學和傳統機器學習模型,如歷史均值(Historical Average,HA)法、向量自回歸(Vector Auto-Regression,VAR)[11]、自回歸綜合移動平均(AutoRegressive Integrated Moving Average,ARIMA)[12]、支持向量回歸(Support Vector Regression,SVR)[13]、梯度提升決策樹(Gradient Boosting Decision Tree,GBDT)[14]等。隨著深度學習技術的快速發展,RNN 被廣泛應用于時間序列預測任務中。RNN 雖然能夠捕獲序列在時間維度上的相關性,但是無法考慮節點在空間維度上的相關性。ST-ResNet(Spatio-Temporal Residual Network)[15]、ST-3DNet(Spatial-Temporal 3D Convolutional Neural Network)[16]和ConvLSTM(Convolutional LSTM)[17]能夠通過CNN 來捕獲空間信息,但是這類模型的輸入被限制為標準的網格數據,無法用于圖結構(如高速路網)的交通預測問題。

近年來,學者們開始利用GCN 來建模圖結構數據里空間維度上的相關性。例如,STGCN[3]、DCRNN[4]、多組件時空圖卷積網絡(Multi-Component Spatial-Temporal Graph Convolution Network,MCSTGCN)[18]均使用GCN 來捕獲空間維度上的相關性,并結合RNN或CNN來捕獲時間維度上的相關 性。ASTGCN(Attention based Spatial-Temporal Graph Convolutional Network)[19]、Graph WaveNet(Graph WaveNet for deep spatial-temporal graph modeling)[20]、MTGNN(Multivariate Time series forecasting with Graph Neural Network)[21]等考慮到預定義的圖結構是不精確的,于是通過注意力機制或者自適應參數學習的方式來動態地優化圖結構。Zhang 等[22]提出的SLCNN(Structure Learning Convolution Neural Network)則是直接以數據驅動的方式自適應地學習局部圖和全局圖兩種空間圖結構,以捕獲不同層面下空間維度上的相關性。這些模型雖然不同程度地改進了對空間維度上相關性建模的方案,但本質上都還是構造一個由不同組件組成的混合模型來分別捕獲時間維度和空間維度的關系,無法建模這兩種維度之間的相互作用。為了使模型更符合流量數據的演化規律,Song等[9]從時空同步的角度出發重構了鄰接矩陣,提出了一種新的時空同步圖卷積網絡預測模型STSGCN,采用一個組件同時捕獲在空間和時間維度上的相關性;Li 等[23]在此基礎上提出一個變種STFGNN(Spatial-Temporal Fusion Graph Neural Network),通過建模站點間流量相似性來補充空間維度上的關聯。這兩種模型雖然均取得了不錯的效果,但是仍然沒有顯式地建模跨時空維度的直接關聯性,只是捕獲了局部時空關系中易于建模的一部分關系。

近期的部分研究表明,超圖能夠建模圖數據中的復雜關系。Feng 等[10]提出了超圖神經網絡(Hypergraph Neural Network,HGNN)框架,模型中能夠使用超圖結構來編碼多個節點間的數據相關性。Dong 等[24]提出的HNHN(Hypergraph Networks with Hyperedge Neuron)設計了一種標準化方法來調整超邊和節點的重要性,并定義了由兩層非線性單元組成的超圖卷積模型,模型在分類任務上的精度和運行效率方面都有較大提升。目前超圖的工作集中于節點分類和圖分割任務,本文提出的STHGCN 使用超圖直接建模交通數據中存在的復雜局部時空關系,實驗結果證實了模型的有效性。

2 問題定義

2.1 空間交通路網

空間交通路網被定義為一個無向圖G=(V,E,A),其中:V為節點的集合,||V=N為節點個數;E為節點間連邊的集合;A∈RN×N為空間交通路網的鄰接矩陣,表示節點之間的相鄰關系。

2.2 交通流量預測

將第t個時間步下在空間交通路網G上觀測到的交通流量值定義為圖信號矩陣X(t) ∈RN×F,其中F是指每個節點所采集的特征數量。本文的預測任務是根據各節點若干個歷史時間步的流量觀測值,預測各節點在未來若干個時間步內的流量值。定義T個歷史時間步的觀測值所組成的X=(X(t-T+1),X(t-T+2),…,X(t))∈RT×N×F為輸入的圖信號矩陣,P個未來時間步的觀測值所組成的Y=(X(t+1),X(t+2),…,X(t+P))∈RP×N×F為待預測的圖信號矩陣。本文的目標則是學習一種如式(1)所示的函數映射關系f(?)。

3 時空超關系圖卷積網絡

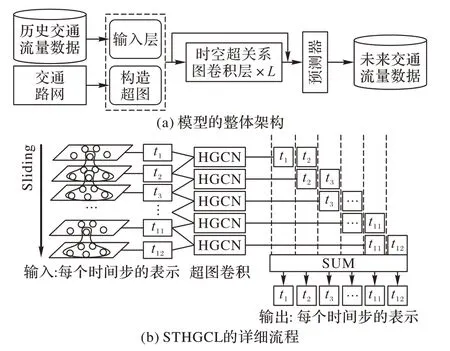

本文提出的STHGCN 架構如圖2 所示。首先使用輸入層將原始輸入的流量特征映射到高維空間,同時基于交通路網構造超圖;然后,堆疊多個帶有殘差連接的時空超關系圖卷積層來捕獲復雜的局部時空關系;最后,使用一個預測器預測未來一段時間的流量特征。

圖2 STHGCN示意圖Fig.2 Schematic diagram of STHGCN

3.1 局部時空關系建模

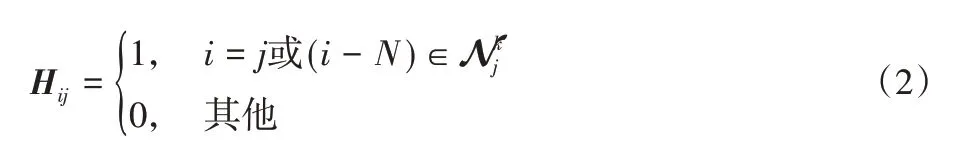

本文引入超圖來建模復雜的局部時空關系。具體而言,如圖1(d)所示,將前一時間步中的任意一個節點、該節點在下一時間步的自身以及它的前K(K為可選擇的超參數)階鄰居建模在一起,組成一條超邊。如此,兩個連續時間步的時空節點一共能夠組成N條超邊。用H∈R2N×N來定義由兩個連續時間步的時空節點所組成的超圖關聯矩陣。H標識了節點和超邊的隸屬關系(如果節點i是超邊j所包含的節點,則Hij=1)。H的符號化定義如下:

其中:i為節點的編號(兩個時間步的節點分別依次編號為0~N-1,N~2N-1);j為超邊的編號,依次為0~N-1;N jk是編號為j的節點的前k階鄰居節點組成的編號集合。

3.2 超圖卷積

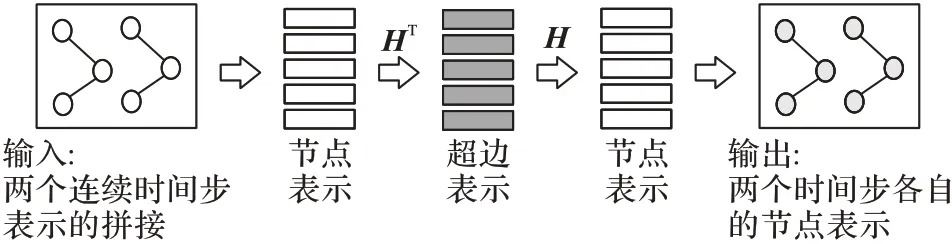

在使用超圖建模了局部時空關系后,受HNHN[24]的啟發,本文進一步構建了超圖卷積(Hypergraph Graph Convolutional Network,HGCN)方法來有效捕獲時空特征。如圖3 所示,該方法的本質是基于超圖結構進行一個兩階段的信息聚合與分發過程。方法的第一階段是捕獲局部時空范圍內特定的流量模式,例如在突發的暴雨天氣狀況下,整個局部區域的交通流量值都會驟減。超邊的表示即表征了局部區域內站點的流量變化趨勢。在第二階段將超邊的信息分發到各個站點上,能夠輔助站點感知周圍環境的變化,進而得到更好的節點表示。具體的符號化定義如下。

圖3 超圖卷積示意圖Fig.3 Schematic diagram of hypergraph convolution

3.3 Mask矩陣

在超圖卷積方法中,超圖關聯矩陣直接決定了信息聚合與分發過程的權重。前面的定義中,關聯矩陣只標識了節點與超邊的隸屬關系,即取值為0或1。這種關聯矩陣會限制聚合效果,無法應對以下兩種情況:

1)不能較好地應對異常情況。例如,由于采集設備故障,在某段時間內,一個站點的流量值缺失,那么即使這個站點屬于對應的超邊,通常也希望不聚合或者少聚合它的信息,因此可以考慮減小該點對應的聚合權重。

2)無法區分不同站點的重要性。每個節點對它局部區域學習的影響程度應當不同。例如一個中轉站點或者交叉路口往往承載著更大的流量,它的交通狀況通常能夠影響更多的鄰居站點,有著更大的影響力,此時可以適當增大該點對應的聚合權重。

上述兩種情況的存在往往限制了超圖卷積的效果,為了解決這一問題,本文考慮在每一個時空超關系圖卷積層STHGCL 中引入一個與關聯矩陣H形狀相同且可訓練學習的參數矩陣Wmask∈R2N×N,并如式(6)所示,使用哈達瑪積運算將它作用在H上以動態的調整聚合權重,得到更合理的信息聚合方式。

3.4 滑動窗信息融合

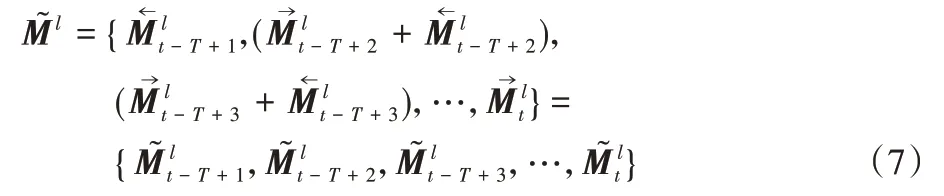

STHGCN 模型的輸入為T個歷史時間步的觀測值所組成的圖信號矩陣,而超圖僅僅定義了相鄰兩個時間步的局部時空關系,因此本文使用如圖2(b)所示的滑動窗口的方式來對輸入的圖信號進行切割,其中滑動窗口的大小為2,滑動步長1。滑動過程中,每兩個相鄰的時間步都會進行超圖卷積操作,因此除第一個時間步與最后一個時間步之外,所有的時間步均會與它前后的時間步拼接,并分別進行一次超圖卷積操作,進而得到兩組節點表示。本文使用SUM 聚合融合了兩組節點表示,以全面捕獲時空信息。具體的融合過程即是基于某一層(如第l層)中由超圖卷積得到的初始節點表示集合將同一時間步的表示進行SUM聚合,即

3.5 時空位置嵌入

在使用超圖建模局部時空關系時,相鄰兩個時間步的節點被壓縮到一個圖中,這些節點混合在一起會模糊每個節點所處的時間位置和空間位置。受STSGCN[9]啟發,本文創建了參數化的時間嵌入矩陣Temb∈RC×T和空間位置嵌入矩陣Semb∈RN×C來標識必要的時間和空間位置信息,以輔助模型更有效地捕獲時空特征。

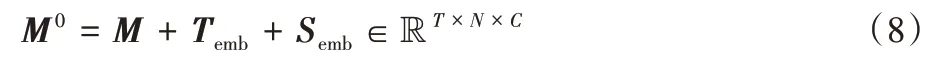

具體而言,本文是使用如式(8)中廣播的形式將兩種嵌入信息加到初始的時空圖信號M中。

3.6 時空超關系圖卷積層

如圖2(b)所示,時空超關系圖卷積層STHGCL 包含了滑動切割、超圖卷積和滑動窗信息融合三個步驟。通常而言,卷積層數的增加會導致深度神經網絡的退化,因此本文進一步使用了殘差網絡來解決這一問題,并在每一層中添加層歸一化(Layer Normal)操作以標準化數據分布。

其中:Ml∈RT×N×C為第l層的輸入表示。

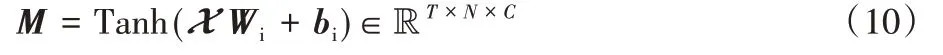

3.7 輸入層與預測器

輸入層為一個全連接層,將輸入的圖信號矩陣X=(X(t-T+1),X(t-T+2),…,X(t))∈RT×N×F映射到高維空間,如式(10)所示。

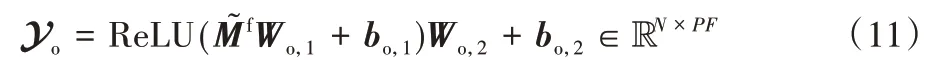

預測器是一個兩層的全連接網絡,它的輸入是最后一層STHGCL 的輸出表示經重塑形狀得到的,具體的運算過程如式(11)所示。

Yo再經過重塑形狀得到最終的預測結果。其中:是可訓練學習的參數,C'為預測器中第一個全連接層高維空間的維度。

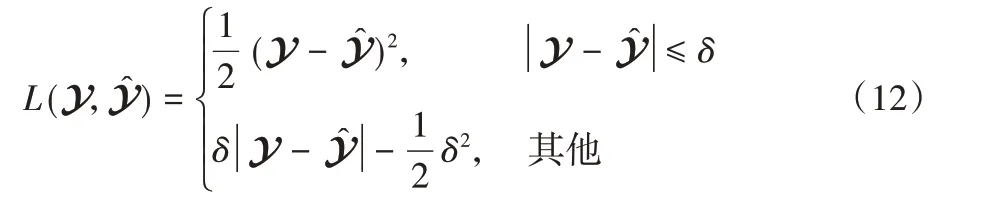

3.8 損失函數

本文使用對回歸問題具有較強魯棒性的Huber Loss 作為損失函數,該函數的定義如式(12)所示。

其中:Y為真實值,為預測值,δ是控制選擇兩種損失的閾值超參數(取默認值1)。

4 實驗與結果分析

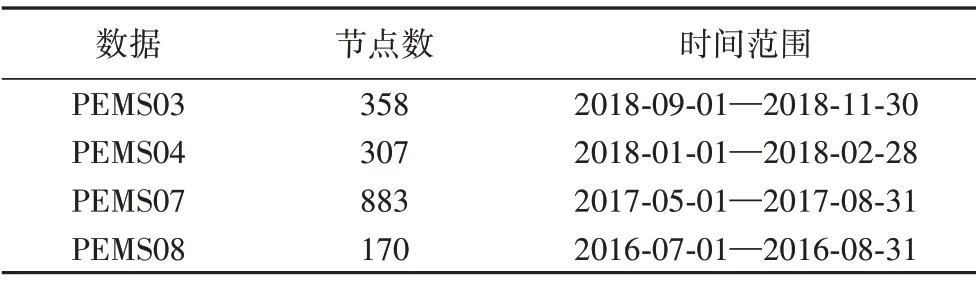

4.1 數據集

基于STSGCN[9]的4 個公開的交通數據集展開實驗,數據采集自美國加利福尼亞州的4 個不同區域的高速公路。按照5 min、10 min、15 min 的時間粒度進行聚合分別得到了3 種不同時間步粒度的數據集,詳細介紹如表1所示。

表1 數據集詳細信息Tab.1 Details of datasets

4.2 實驗設置

數據集全部以6∶2∶2 的比率被拆分為訓練集、驗證集和測試集,并使用如式(13)所示的Z-Score 方法進行標準化,其中Mean(Xtrain)和Std(Xtrain)分別是訓練集的均值和標準差。實驗均使用前12 個時間步的流量值來預測后12 個時間步的流量值。高維空間的維度C、C'分別被設置為64、256。模型使用MXNet 實現,并通過Adam 優化器進行訓練,學習率被設置為0.001。實驗結果為5次實驗的平均值。

4.3 基準方法與評價指標

本文對比的基準方法包括:1)統計學和傳統機器學習方法VAR[11]、SVR[13]。2)深度學習方法:GRU(Gated Recurrent Unit)[7]、STGCN[3]、DCRNN[4]、ASTGCN[19]、STSGCN[9]。實驗采用了交通流量預測領域中大多數工作經常使用的均方根誤差(Root Mean Square Error,RMSE)、平均絕對誤差(Mean Absolute Error,MAE)和平均絕對百分比誤差(Mean Absolute Percentage Error,MAPE)三個評價指標來評估所有模型的預測效果。

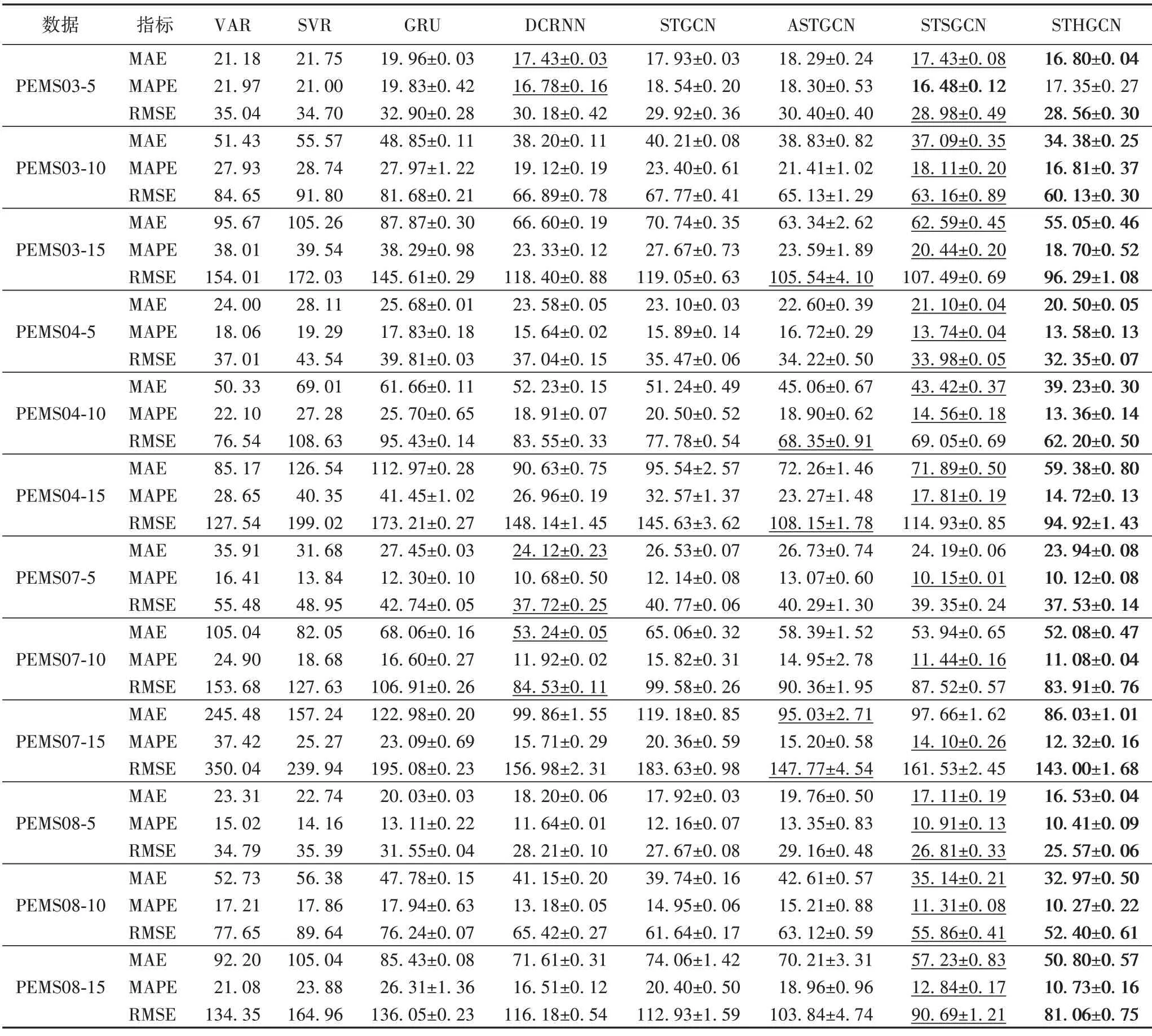

4.4 實驗結果與分析

表2顯示了不同模型在不同數據集上預測未來12個時間步的交通流量的整體預測性能。其中最優的結果用粗體標出,次優的結果用下劃線標出。三個評價指標值越低,代表模型性能越好。不難看出,傳統方法VAR 和SVR 由于缺乏非線性表達能力,所以預測性能往往不是特別理想。深度學習方法憑借著較強的非線性表達能力展現出很大的優勢,其中GRU 由于只能捕獲時間維度上的相關性,在深度方法中表現相對較差;同時考慮到空間和時間維度的深度模型DCRNN、STGCN、ASTGCN、STSGCN 和STHGCN 取得了更好的預測效果。近期較先進的模型STSGCN 通過同步建模時間、空間維度的相關性在基準方法中取得了較大的優勢。而本文模型STHGCN 通過構造超圖來全面地建模復雜的局部時空關系,在除PEMS03-5 外的所有數據集上均獲得了最佳性能。實驗效果展示了超圖建模局部時空關系的優勢。

表2 八種交通流量預測模型在不同數據集上的性能比較Tab.2 Performance comparison of 8 traffic flow forecasting models on different datasets

此外,還分別在5 min、10 min、15 min 的時間步粒度下進行了對比實驗。由于在預測步長固定為12 的情況下,隨著時間步粒度的增大,待預測的時間范圍也會相應增加,因此在不同時間步粒度上的對比實驗能夠檢驗模型的長期預測能力。從表2 可以發現隨著時間步粒度的增大,所有模型的預測性能均會下降。性能下降一方面是因為在時間步粒度更大的數據集中,流量特征的均值和方差也會更大,導致預測誤差也隨之增大;另一方面是因為時間步粒度的增大,會使得站點在一個時間步內能夠影響到處于更遠空間范圍內的其他站點,導致模型訓練學習的難度增加。實驗結果顯示了STHGCN 相對于基準方法性能下降更為緩慢,取得了更加穩定的效果。例如,在PEMS08 數據集的三個時間粒度上與STSGCN 相比,RMSE 指標的提升比分別是4.63%,6.19%,10.62%。這表明STHGCN 具有更強的長期預測能力,這種優勢主要是因為STHGCN 構建的超圖建模了處于更遠時空范圍內的鄰居信息(前K階鄰居),能夠更全面地捕獲局部時空關系。

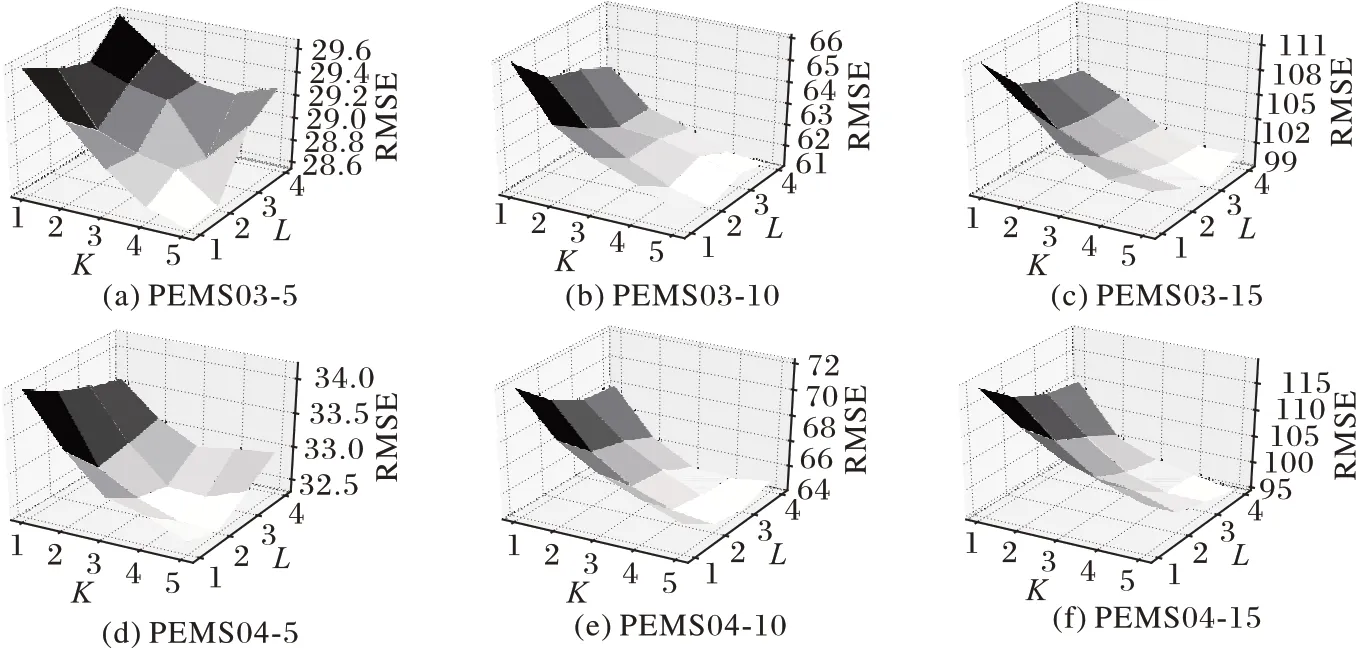

4.5 模型參數選擇

為了研究模型超參數對模型效果的影響,本文分別在1~5和1~4范圍內對K和STHGCL 堆疊的層數L兩個參數進行了網格搜索,結果如圖4 所示。可以看出隨著兩個參數值的增大,模型STHGCN 的性能開始會快速增長,隨后增長速度逐漸放緩;隨著數據集時間步粒度的增加,最優參數的取值也相對變大。例如在PEMS03數據集的三種時間步粒度上,最優的K取值均為5,而最優的L取值分別為1、2、3,這是因為這兩個參數直接決定了模型能夠捕獲的時空范圍。當數據集時間步的粒度變大時,站點在每個時間步往往能夠影響到更遠的鄰居站點,此時這兩個參數的取值會相應增大以捕獲更遠距離的時空信息。

圖4 不同參數組合的模型效果Fig.4 Model effect of different parameter combinations

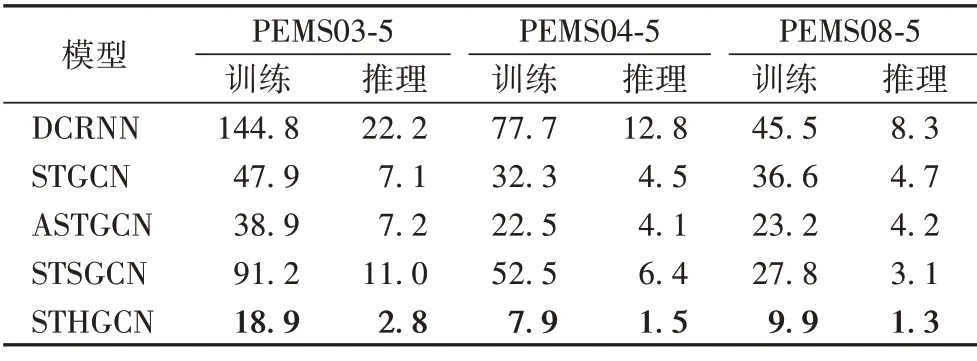

4.6 運行時間對比

表3 給出了不同模型在相同條件下的運行時間成本(僅模型部分,不包含數據處理)。

表3 部分數據集上的訓練時間和推理時間對比 單位:sTab.3 Comparison of training time and inference time on some datasets unit:s

本文為所有模型使用相同的Minibatch,同一計算平臺,并選取3 個不同規模的數據集進行比較。其中DCRNN 由于使用了循環預測多步的方式,運行速度與其他直接預測多步的方法相比較慢;STSGCN 為區分不同時間步的信息,模型中堆疊了大量的不共享圖卷積模塊,導致計算量較大,運行效率相對較低;本文模型在不同的時間步共享超圖結構,并使用超圖卷積來捕獲局部時空關系,其中卷積模塊里不包含大規模的復雜運算,計算量相對較小。從結果可以看出本文的模型無論是訓練還是推理都花費了最少的時間,有著較高的運行效率。

5 結語

本文針對交通流量預測問題提出了一種時空超關系圖卷積網絡(STHGCN)預測模型,在模型中使用超圖來建模交通流量數據中存在的復雜局部時空關系,并通過超圖卷積和滑動窗信息融合機制以有效捕獲時空特征。在不同公開數據集上的實驗結果表明,本文模型具有較好的預測性能,實際上該模型也適用于其他基于圖結構的時空預測問題,例如交通速度預測、空氣質量預測等。在下一步的研究工作中,將考慮從構建動態超圖的角度來優化模型架構,進一步提升模型的預測性能。