基于VGG16 網絡的超參數調整策略的研究*

張鎧臻,李艷武,劉博,李杰,謝輝,張忠義

(重慶三峽學院電子與信息工程學院,重慶 404100)

神經網絡的優化與學習率的調整有著很大的關系,如果學習率的策略調整合適,模型的泛化性能會有明顯的提升。通常神經網絡中使用的學習率衰減為指數衰減、余弦衰減。除此之外,SMITH[1]提出了一種循環學習率調整策略,他提出了三角形循環學習率,闡述了如何尋找循環學習率的上界和下界的方法。針對需要手動調整學習率的策略,DUCHI[2]等人提出了一種Adagrad 自適應調整學習率的算法,有效減少了人工經驗給模型帶來的影響。但是Adagrad 自適應調整學習率算法隨時間的增加,對歷史梯度的累加使得學習率越來越小,在訓練后期會使得模型的收斂速度很慢,針對這一問題,TIELEMAN[3]提出了RMSProp 算法,這種算法在對梯度進行指數加權平均上引入了平方根,有效緩解了Adagrad 算法在訓練后期學習率極小導致模型收斂緩慢的缺點。針對RMSProp 算法和Adagrad 算法的優點,KINGMA[4]等人提出了Adam 算法,這種算法不僅引入指數加權平均計算,而且引入了誤差修正。對于隨機梯度下降算法(Stochastic Gradient Descent,SGD)的損失函數容易出現振蕩,且梯度下降較慢的問題,NESTEROV[5]等人提出了Nesterov 加速方法并進行了理論證明,SUTSKEVER[6]等人提出了Momentum 算法以及說明了經典動量與Nesterov 加速梯度的聯系,明顯加快了梯度下降,文中還說明了可以以更大的曲率點緩慢梯度下降,不易振蕩,Nesterov 加速梯度比動量算法更加穩定。文獻[7]對梯度下降算法進行了詳細介紹。

基于以上出現的優秀的學習率調整方法,很多學者對其研究與應用比較廣泛。為了解決由于網絡訓練次數較多且收斂性較差的弊端,儲珺[8]等人提出了網絡可自適應調整學習率和樣本訓練方式的算法,主要根據訓練誤差來調整學習率同時根據輸出結果改變訓練樣本,傾向于訓練分類不準確的圖像。賀昱曜[9]等人提出了一種AdaMix 組合型學習策略,這種策略考慮到神經網絡傳播時的權重和偏置,分別設置不同的學習率策略,有效提高了模型的收斂速度同時減少了訓練時間。除了只考慮學習率的變化問題,仝衛國[10]等人還綜合考慮了網絡訓練優化、網絡結構選擇以及權重初始化的因素。文獻[11]講述了訓練神經網絡分為前期、中期、后期三個階段,通過實驗驗證了前期模型還是欠擬合狀態,需要適當大小的學習率去擬合模型,在中期和后期,模型基本有著較好的擬合能力但沒有達到最佳擬合能力,因此還要減小學習率,使得模型向著最佳擬合方向優化。文獻[12]提出了一種k-Decay 方法,它是一種對任意可導的衰減函數都適用的學習率衰減函數的調整方法,通過引入控制學習率的衰減程度。除此之外,IOFFE[13]等人也提出了一種批量歸一化的方法來優化神經網絡,主要是通過將網絡每層的輸入分布保持一致來消除內部協變量偏移最終使得模型性能更好。劉建偉[14]等人也對批量歸一化及相關算法的研究進行了綜述并對批量歸一化在神經網絡領域的應用進行了總結。因此學習率衰減和批量歸一化策略對模型的性能影響顯著。

1 優化神經網絡的方法

1.1 梯度下降法與動量法

梯度就是函數在某一點的方向導數上升最快的方向。而梯度的反方向就是在這個點下降最快的方向,在神經網絡中,通過梯度下降走到最低點使得損失函數最小來讓模型更有泛化能力。

設一個樣本點為x,初始迭代為x0,第t次迭代為xt,其目標函數為f(x),則梯度下降法的公式如下:

式(1)中:xt+1為樣本點的第t+1 次迭代;xt為樣本點的第t次迭代;η為學習率。

一種常用的梯度下降法是隨機梯度下降法,它是每次僅隨機選擇一個樣本進行梯度計算以更新權重,直到損失函數值不再下降或者下降到一個可接受的閾值以下才停止更新。因此,隨機梯度下降算法更適用于神經網絡的優化器。

動量法的核心思想是在一定次數迭代時,參數的更新方向通過計算其負梯度的加權移動平均得到。

1.2 學習率方法

常用的學習率調整策略分為非自適應調整學習率和自適應調整學習率。非自適應調整學習率有指數衰減、余弦變化、帶熱重啟的學習率調整;自適應調整學習率有Adagrad算法、RMSProp 算法、Adam 算法。自適應調整學習率算法可以解決隨機梯度下降法不能自動調節學習率的缺點。

指數衰減指一個初始的學習率η0,學習率隨著迭代次數以指數形式衰減。

水權制度 水權指按照水法行使的對水的管轄權力,也指經過水行政主管部門批準給予用水戶的對水資源處理和利用的權力。水權制度就是通過明晰水權,建立對水資源所有、使用、收益和處置的權利,形成一種與市場經濟體制相適應的水資源權屬管理制度。

余弦變化就是學習率隨著迭代次數以余弦的形式周期性變化。文獻[15]提出了一種帶熱重啟的學習率調整方法,其思想就是如果梯度下降過程中重啟n次,第n-1 次重啟后迭代Tcur 次再進行第n次重啟,在第n次重啟之前利用余弦衰減降低學習率。

Adagrad 算法[2]是對隨機梯度下降法手動調整學習率的一個改進,算法的思想是使用歷史梯度平方一直累加后開方調整學習率,分子為初始學習率,這樣就可以隨著時間或迭代次數改變學習率了。

RMSProp 算法[3]是對Adagrad 的一個改進,主要思想是摒棄直接使用小批量隨機梯度按元素平方和,而是將小批量隨機梯度平方和做指數加權平均,這樣就解決了由于隨時間的變化學習率急劇減小的問題。

Adam 算法[4]計算了梯度平方和的指數移動平均值,主要使用兩個參數來控制指數移動平均的衰減,通過一階矩和二階矩計算動量和速度,然后通過偏差校正來更新參數。

1.3 批量歸一化

批量歸一化的概念首先是IOFFE[13]提出的,由于在訓練神經網絡時,網絡前一層參數的變化會引起后一層輸入數據的分布發生變化,因此會導致飽和非線性的模型訓練困難。批量歸一化就是將每一層的輸入數據進行預處理操作,處理后使得網絡每層的輸入數據的分布基本保持一致,它可以很好地處理反向傳播的梯度消失和爆炸的行為。

因此,優化神經網絡的方法可以從以上幾個角度出發,除此之外還可以考慮權重初始化等優化方法讓模型的泛化能力更強。

2 實驗環境與測試方案

2.1 實驗環境

實驗在配有七彩虹RTX2080Ti 顯卡和Inter 的i7-8700cpu 的Windows10 系統環境中進行的,基于Python 語言的Pytorch 深度學習框架,使用Cifar10 數據集對VGG16網絡模型訓練并測試。Cifar10 數據集包含60 000 張32×32的RGB 彩色圖片,圖像內容有“飛機”“貓”和“狗”等10 個類別。數據集的每個類別包括6 000 張圖片,其中5 000張用于訓練,剩下的1 000 張用于測試。因此,Cifar10 的訓練集有50 000 張圖片,測試集有10 000 張圖片。

2.2 測試方案

本文通過研究指數衰減、余弦變化和1.2 節描述的自適應調整學習率算法對模型進行優化。使用了典型的VGG16網絡在Cifar10 數據集上進行了訓練與測試,實驗中所有使用了批量歸一化的模型的批量大小均為128 并且模型訓練50 輪。

首先針對是否使用批量歸一化方法對模型進行對比分析,分別使用兩種VGG16 網絡進行訓練:①未使用批量歸一化的VGG16 模型;②使用了批量歸一化的VGG16 模型,批量大小為128。兩種模型的優化器均為隨機梯度下降法,經過大量調整學習率和權重衰減,設置初始學習率為0.01并在訓練中保持不變,權重衰減為0.001。

其次針對不同學習率策略對模型的影響進行了對比分析,對于非自適應調整學習率方法,均使用隨機梯度下降優化器,權重衰減為0.001。對每一種學習率策略設置多個學習率初始值進行測試,各種策略的調整方案為:①以0.01為初始學習率,動量為0.9,采用指數衰減方法,每輪學習率降為原來的95%;②初始學習率為0.01,動量為0.9,利用余弦變化策略,最小學習率為0,余弦變化周期為20 輪;③初始學習率為0.01,使用Adagrad 算法;④初始學習率為0.001,衰減因子為0.9,利用RMSProp 算法;⑤初始學習率為0.001,矩估計的衰減速率分別設置為0.9 和0.999,利用了Adam 算法。

為讓實驗數據更具有準確性,測試損失、測試精度、訓練時間、訓練時間都是經過5 次訓練取平均值所得出的。

3 結果分析

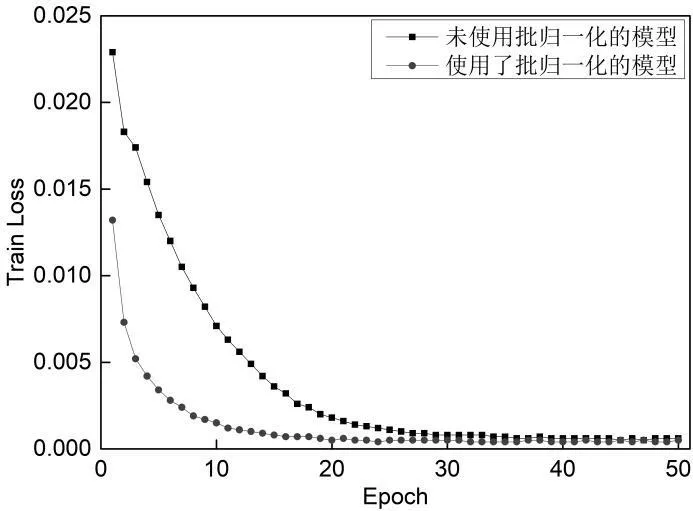

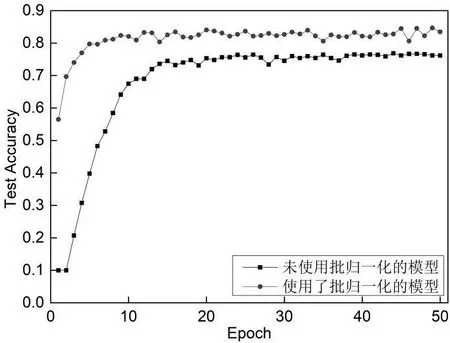

首先對于學習率固定而訓練的VGG16 網絡,采用了兩種不同的VGG16 模型,分別為不使用歸一化策略與使用歸一化策略的模型,兩種模型均使用了隨機梯度下降優化器,對應的收斂曲線和測試精度曲線分別如圖1 和圖2 所示。

圖1 兩種模型的收斂曲線

圖2 兩種模型的測試精度曲線

由圖1 和圖2 分析可知:從收斂的角度考慮,未使用歸一化的模型比使用了歸一化的模型的收斂速度慢,最終的訓練損失更高,使用了歸一化的模型好于未使用歸一化的模型;從測試精度的角度考慮,未使用歸一化的模型比使用了歸一化的模型測試精度要低約6.5%,從兩種模型的穩定性角度考慮,二者的穩定性相差不大,這可能是由于模型和數據集不足夠大而出現的情況。

針對批量歸一化策略,文獻[13]對于這種情況有了很好的解釋,他們認為,批量歸一化策略就是將每一層的輸入分布基本保持一致,這不僅可以使得輸入的數據內部協變量偏移更小,還可以很好地處理反向傳播的梯度消失和爆炸的行為,利用它可以使用相對較大的學習率在更深的網絡中實現較大的性能;他們還認為模型和數據集越大,批量歸一化的效果會更明顯。

未使用批量歸一化的模型的訓練損失、測試精度、訓練時間分別為0.000 5、78.192%、1 843.402 s,使用了批量歸一化的模型的訓練損失、測試精度、訓練時間分別為0.000 4、84.712%、1 376.647 s。因此,使用了歸一化的模型相對于沒使用歸一化的模型訓練時間大幅度縮減并且測試精度顯著提高,訓練時間減少了約8 min,測試精度提高了約6.5%。由于批量歸一化模型收斂時間、訓練時間更短并且測試精度更高,因此,本文后面的實驗是基于使用了批量歸一化的VGG16 網絡進行的學習率調整,批量大小設置為128。

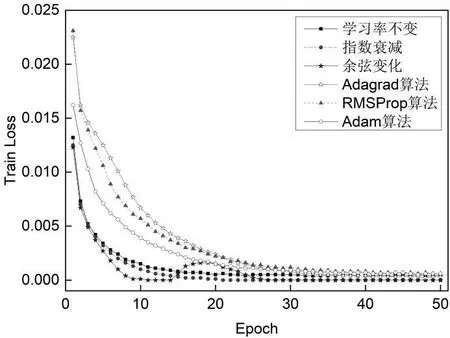

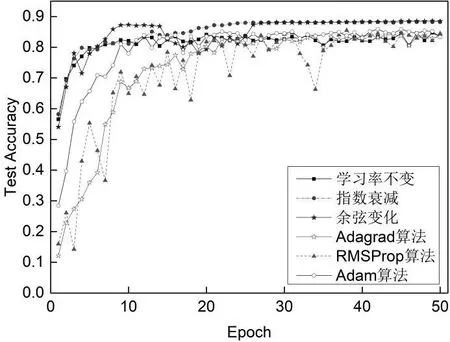

圖3 和圖4 分別是2.2 節所描述的5 種學習率策略和不使用任何學習率策略應用到帶有批量歸一化的VGG16 網路中的收斂曲線和測試精度曲線。

圖3 不同學習率策略下模型的收斂曲線

圖4 不同學習率策略下模型的測試精度曲線

由圖3 和圖4 得出:從收斂速度方面,余弦變化先達到收斂,但由于余弦衰減中有學習率變大的情況,因此會導致收斂后又出現了訓練損失上升,隨后下降到收斂值;指數衰減方法略慢于余弦變化;接下來是學習率不變策略;利用Adam 優化器的收斂速度略慢于學習率不變策略。利用Adagrad 算法和RMSProp 算法要比Adam 算法的收斂速度略遜。從測試精度方面,余弦變化的測試精度最高;指數衰減的測試精度相對于余弦變化略低,而且指數衰減比余弦變化在收斂前更穩定;Adam 算法的測試精度略差于指數衰減;隨后是RMSProp算法、學習率不變方法的測試精度;Adagrad算法的測試精度最低。RMSProp 算法最不穩定。

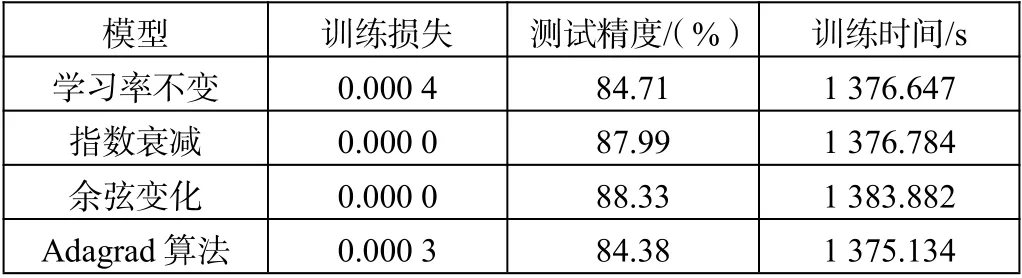

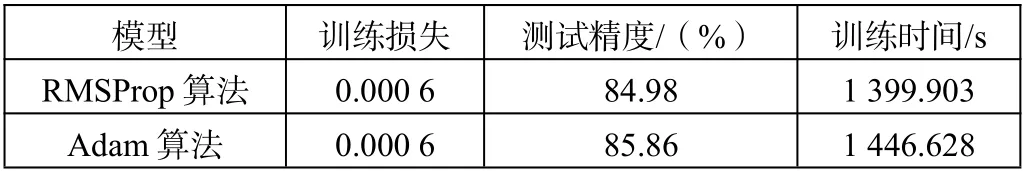

表1 展現出使用了上述各種學習率方法的模型的訓練損失、測試精度和訓練時間。從表1 中可知:指數衰減、余弦變化的訓練損失最小;余弦變化的測試精度最高,達到了88.33%;Adagrad 算法的訓練時間最短。前5 種學習率策略的模型的訓練時間相差不大,比Adam 算法顯著快。因此綜合考慮,使用余弦變化策略的模型性能更好。

表1 使用6 種學習率策略的模型性能對比

表1(續)

4 總結

通過對模型使用批量歸一化與不使用批量歸一化進行了對比,經過實驗驗證,使用了批量歸一化的模型在收斂速度、測試精度、訓練時間以及模型穩定性方面都有了明顯的提升。通過對學習率的衰減策略調整發現,雖然自適應學習率算法相對于非自適應學習率算法可以減少手動調節學習率,但性能不一定比非自適應學習率算法好。即隨機梯度下降算法性能不一定要遜于Adam 算法,與相關的參數大小設置及網絡模型的選擇也有關。通過實驗對比非自適應學習率算法和自適應算法的性能,證明了在VGG 網絡中使用余弦變化方法使得模型的性能更好。優化神經網絡除了使用不同的算法,調整學習率初始值與衰減方式、權重衰減值以及訓練輪數都是重要的因素。本文主要研究了學習率策略,基于本文的研究基礎上,將來的研究方向是:將權重初始化和學習率策略結合優化模型,探索可以加快網絡訓練并提高網絡模型泛化性的優化方法。