基于無人機影像自動檢測冠層果的油茶快速估產方法

嚴恩萍,棘 玉,尹顯明,莫登奎

基于無人機影像自動檢測冠層果的油茶快速估產方法

嚴恩萍,棘 玉,尹顯明,莫登奎※

(1. 中南林業科技大學林業遙感大數據與生態安全湖南省重點實驗室,長沙 410004;2. 中南林業科技大學南方森林資源經營與監測國家林業與草原局重點實驗室,長沙 410004;3. 中南林業科技大學林學院,長沙 410004)

快速準確的產量估算對油茶經營管理和可持續發展具有重要意義。該研究針對油茶快速估產的應用現狀,提出一種基于無人機影像自動檢測冠層果的方法用于油茶快速估產。首先借助無人機航拍影像,通過隨機抽樣選取120株油茶樹進行無人機近景攝影和人工采摘稱量;然后利用Mask RCNN(Mask Region Convolutional Neural Networks)網絡開展基于近景影像的油茶冠層果自動檢測與計數;采用線性回歸和K最鄰近建立冠層果數與單株果數之間的關系,同時結合研究區典型樣木株數和平均單果質量,構建基于冠層果自動檢測的估產模型。結果表明:1)無人機超低空近景影像結合Mask RCNN網絡能夠有效檢測不同光照條件油茶果,平均F1值達89.91%;2)同傳統衛星遙感相比,基于無人機近景攝影的冠層果自動檢測在作物產量估測方面顯示出明顯優勢,Mask RCNN網絡預測的冠層果數與油茶樣木單株果數之間具有良好的一致性,擬合決定系數2達0.871;3)結合線性回歸和K最鄰近構建的模型估產精度均較高,擬合決定系數2和標準均方根誤差NRMSE(Normalized Root Mean Square Error)分別在0.892~0.913和28.01%~31.00%之間,表明基于無人機影像自動檢測冠層果的油茶快速估產是一種切實可行的方法。研究結果可為油茶快速估產和智能監測提供參考。

無人機;自動檢測;油茶;快速估產;冠層果

0 引 言

油茶是中國南方特有的木本油料樹種,含有豐富的不飽和脂肪酸和維生素E,在醫藥保健方面具有重要的應用價值[1]。作為油茶產量的重要組成部分,油茶果數量和單果質量是反映油茶產量的重要指標,因此快速獲取油茶果數量和單果質量極為重要。傳統的油茶果數量和單果質量獲取主要采用人工采摘計數稱量,消耗大量的人力物力財力。因此,開發一種高效準確的油茶果數量和單果質量監測方法具有重要意義。

國內外學者對基于圖像分析技術的果實數量監測開展了相關研究[2],例如為克服外界復雜環境的影響,李昕等[3]提出基于多特征融合的油茶果識別方法;李立君等[4]提出基于改進凸殼理論的定位檢測算法。早期的果實監測研究主要集中于蘋果[5-6]、柑橘[7]、西紅柿[8]、油茶[9]和番石榴[10]等。這些研究均采用基于像元的光譜響應作為果實檢測的獨特特征,然而果實圖像存在顏色和形態多樣、遮擋重疊嚴重以及背景相似等問題,給油茶果的準確識別帶來挑戰。

隨著計算機技術的進步,深度學習理論廣泛用于基于果實數量監測的作物估產。例如為提高油茶果識別的速度與精度,張習之等[11]提出基于改進卷積自編碼機神經網絡的油茶果圖像識別方法;Koirala等[12]比較了6種現有深度學習算法在樹冠圖像中檢測芒果果實的性能,結果表明YOLO(You Only Look Once)算法檢測日間芒果圖像數據集的效果較好,F1分數達0.89。深度學習理論已被成功用于芒果[13]、柑橘[14]、番茄[15]和蘋果[16]等作物的產量估算。然而目前的研究均采用地面拍攝的近距離照片作為數據源,無法滿足大面積估產需求。

近年來,無人機遙感的發展為基于果實數量的大面積作物估產提供了條件。雖然衛星遙感應用于作物估產具有快速、無損、尺度大的優勢[17],但是由于空間分辨率的限制,無法獲取精確的果實數量[18]。同衛星遙感相比,無人機遙感具有空間分辨率高、獲取速度快、操作簡單的優點[19-20],可選擇最優作業時期獲取高分辨率航拍影像,實現基于果實數量的大面積作物估產[21]。例如Apolo等[22]基于無人機捕獲的柑橘園影像,采用Faster RCNN(Faster Region Convolutional Neural Networks)模型對柑橘類水果進行產量估算,模型估產精度較好,具有用于柑橘類相似作物產量估算的潛力。

鑒于此,本文擬開展基于冠層果自動檢測的油茶快速估產研究,以無人機近景航拍影像為數據源,通過Mask RCNN(Mask Region Convolutional Neural Networks)網絡從近景影像中自動檢測油茶冠層果數量,采用2種方法擬合Mask RCNN網絡預測的冠層果數與單株果數之間的關系,結合研究區油茶樣木株數和平均單果質量,構建基于冠層果自動檢測的估產模型,以期為大面積油茶林的快速估產提供新的研究思路。

1 材料與方法

1.1 研究區概況

試驗區位于湖南省中部的新邵縣陳家坊鎮江村,介于邵陽盆地和新漣盆地之間,屬典型的南方低矮丘陵,地處東經111°08′~111°05′,北緯27°15′~27°38′之間(圖 1)。境內春暖夏涼,四季分明,屬中亞熱帶大陸性季風濕潤氣候,年平均氣溫17.0 ℃,年均無霜期271 d,年降水量1 365.2 mm,油茶林面積300 hm2。江村油茶種植示范基地是新邵縣重點油茶產業基地,造林年度為2014年,總面積為59.18 hm2。

1.2 數據獲取與預處理

1.2.1 無人機影像數據

無人機影像數據包括航線規劃數據和近景攝影數據,其中前者用于獲取研究區油茶樣木的空間分布信息;后者用于油茶果樣本數據集的構建,包括訓練集、驗證集和測試集。兩種數據均采用大疆御Mavic 2 PRO四軸無人機獲取,航拍當日天氣晴朗、風速0.3~1.5 m/s、光線充足。搭載的傳感器為Hasselblad L1D-20C航拍相機,焦距為28 mm,光圈值為/2.8~/11。相機圖像分辨率為5 472 像素×3 648像素(JPEG格式)。

無人機航線規劃數據采集于2020年10月19日至21日,拍攝高度為100 m,速度5 m/s,鏡頭垂直于地面,航向重疊率70%,旁向重疊率分別為80%,像元大小2.75 cm×2.75 cm。具體數據處理流程包括:①剔除重疊率低、重復和模糊的照片;②通過Agisoft Metashape軟件加載和匹配影像,構建密集點云,利用密集點云重建三維模型生成正射影像;③基于正射影像顯示的油茶林空間分布信息,利用隨機抽樣選取120株典型油茶樣木。

無人機近景攝影數據采集于2020年10月25日至26 日,拍攝高度距離油茶樣木空間位置正上方3 m,鏡頭垂直于地面,連續拍攝,獲取油茶樣木的完整冠幅,像元大小0.082 5 cm×0.082 5 cm。共拍攝1 000張油茶冠幅影像,剔除重復、模糊等無效影像,最后保留800張近景影像。

1.2.2 地面實測數據

地面實測數據主要用于油茶冠層果標注和估產模型的精度驗證。采集時間為2020年10月25日至26日,通過隨機抽樣選取120株典型樣木進行實地調查,記錄每株油茶樣木的編號、空間位置(經度、緯度和海拔)、單株果數、單株產量和單果質量,空間位置信息利用手持GPS采集,單株果數通過人工采摘計數獲取,單株產量采用電子秤實際稱量獲取,單果質量由單株產量除以單株果數獲取。

2 研究方法

2.1 數據集構建

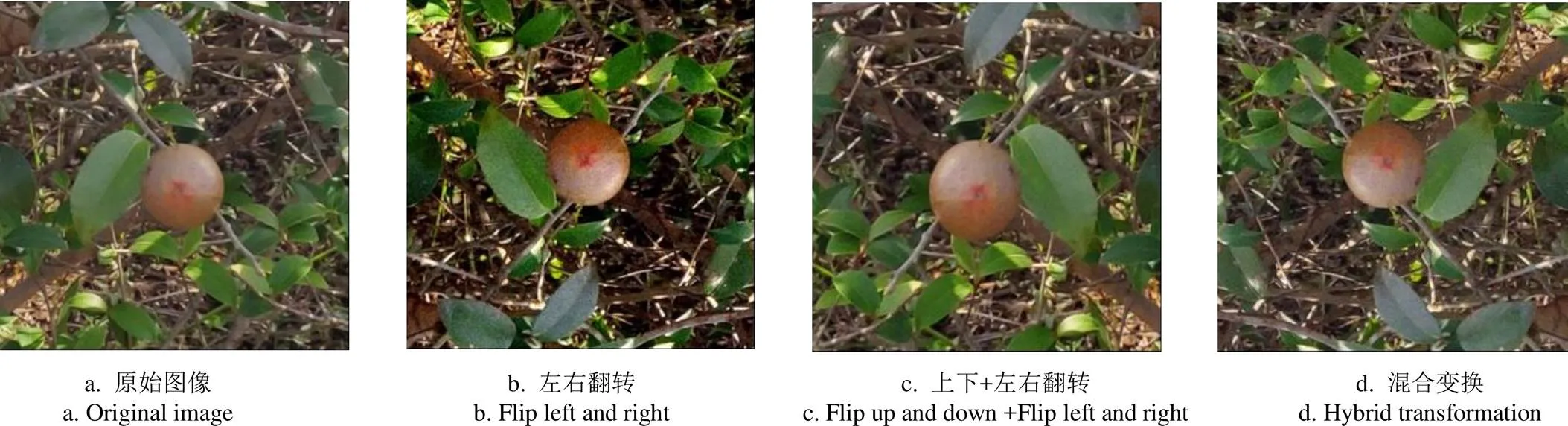

油茶果樣本數據集的構建包括數據標注、數據擴增和數據劃分3部分。①數據標注:為滿足網絡訓練的要求,利用Labeme軟件對油茶果的最小外接矩形進行人工標注,保證每個標注框僅含有單個油茶果目標;②數據擴增:為提高網絡的泛化能力,從拍攝的照片中隨機抽取400張作為標注樣本,采用圖像旋轉、圖像移動、圖像縮放、圖像增強、噪聲注入、對比度變換等方法進行數據擴增(圖2),最后保留1 200張作為樣本數據集;③數據劃分:將擴充數據集按8∶1∶1分為訓練集、測試集和驗證集。其中訓練集用于訓練模型參數,驗證集用于訓練模型的超參數調優,測試集用于評估模型的泛化能力。

注:混合變換指照片經過上下翻轉,亮度/對比度變換以及像素值放大/縮小等處理。

2.2 Mask RCNN算法

本研究采用目前經典的深度學習算法Mask RCNN網絡檢測油茶冠層果。該方法基于原有的Faster RCNN進行擴展,完成目標檢測的同時實現高質量的實例分割[23]。Mask RCNN算法包含3個任務分支:目標分類、目標框坐標和目標區域的二值掩碼。本文首先通過深度殘差網絡ResNet提取特征圖像,同時通過FPN(Feature Pyramid Networks)對特征圖像進行多尺度特征融合,實現低維信息和高維特征的融合,避免高維語義信息的丟失;然后結合區域生成網絡RPN(Region Proposal Network)提取潛在的目標區域ROI (Regions of Interest);利用ROI align層將ROI映射成固定維數的特征向量,其中2個分支經過全連接層進行分類和目標框回歸,另1個分支經過全卷積運算得到分割區域的二值掩碼[24]。具體Mask RCNN模型結構如圖3所示。

本文油茶冠層果檢測的訓練環境均為Google提供的云服務器Colaboratory,GPU為Tesla P100-PCIE-16 GB。訓練網絡為基于PyTorch的Mask RCNN網絡,采用Python3.6語言編程實現網絡的訓練和測試。訓練參數為:初始學習率0.004,學習率下降系數0.1,一次訓練迭代2個樣本,共進行54 000次迭代訓練,第20 250次迭代和第27 000次迭代時學習率下降。分別輸出學習模型至文件夾,記錄訓練日志。

由于精度評價需要同時考慮準確率和召回率,本研究采用F1值作為油茶冠層果識別的評價指標,具體表達式如下:

其中Precision代表精確率,%;Recall代表召回率,%;TP表示實際為油茶果且被模型預測為油茶果的樣本數;FP表示實際為背景但被模型預測為油茶果的樣本數;FN表示實際為油茶果但沒有被網絡識別為油茶果的樣本數。

2.3 估產模型構建

2.3.1 單株果數估計

以Mask RCNN網絡預測的冠層果數為自變量,實測的單株果數為因變量,采用線性回歸和K最鄰近算法2種方法構建冠層果數與單株果數之間的經驗模型。線性回歸(Linear Regression,LR)是利用回歸方程確定目標值與特征值之間線性關系的一種統計分析方法。本文采用的線性回歸滿足一元一次方程;K最鄰近(K-Nearest Neighbor,KNN)算法是經典的模式識別方法,首先給定測試數據和訓練數據之間的距離,其次選定距離最近的個訓練數據完成測試數據的預測。研究采用Python3.8語言構建油茶樣木單株果數預測模型,K最鄰近算法共設置5個值,最大值為5,值為2(即歐氏距離)。

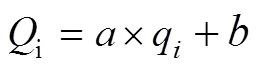

2.3.2 估產模型

本研究采用冠層果數擬合的單株果數,構建油茶樣木產量估算模型。具體計算公式如下:

式中Yield為研究區單株油茶估測產量,kg;代表研究區油茶樣木編號;代表研究區油茶樣木的平均單果質量;代表研究區隨機抽樣選取的10%典型油茶樣木株數;Q代表研究區第株油茶樣木的單株果數,通過冠層果數擬合獲取。

以線性回歸擬合為例,則Q的計算公式如下:

式中q代表研究區第株油茶樣木基于Mask RCNN網絡預測的冠層果數,和分別表示線性回歸的斜率和截距。

本文油茶樣木的平均單果質量= 0.020 kg,樣木株數=120,線性回歸擬合中和取值分別為1.016和4.943。油茶樣木單株產量估算公式為:

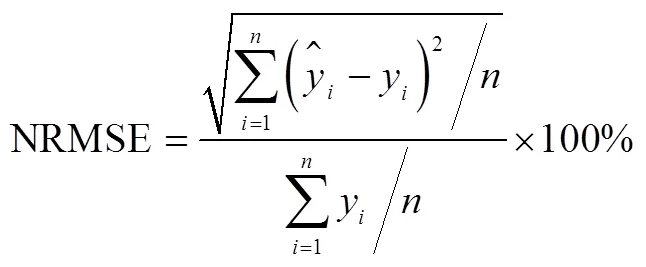

2.3.3 模型精度評價

采用決定系數(2)和標準均方根誤差(Normalized Root Mean Square Error,NRMSE)對油茶產量的預測結果進行評價[25]。2反映預測產量與實測產量之間的擬合程度;NRMSE衡量預測產量與實測產量之間的標準化偏差程度,反映估測模型的可靠性,NRMSE越小,預測精度越高。計算公式如下:

3 結果與分析

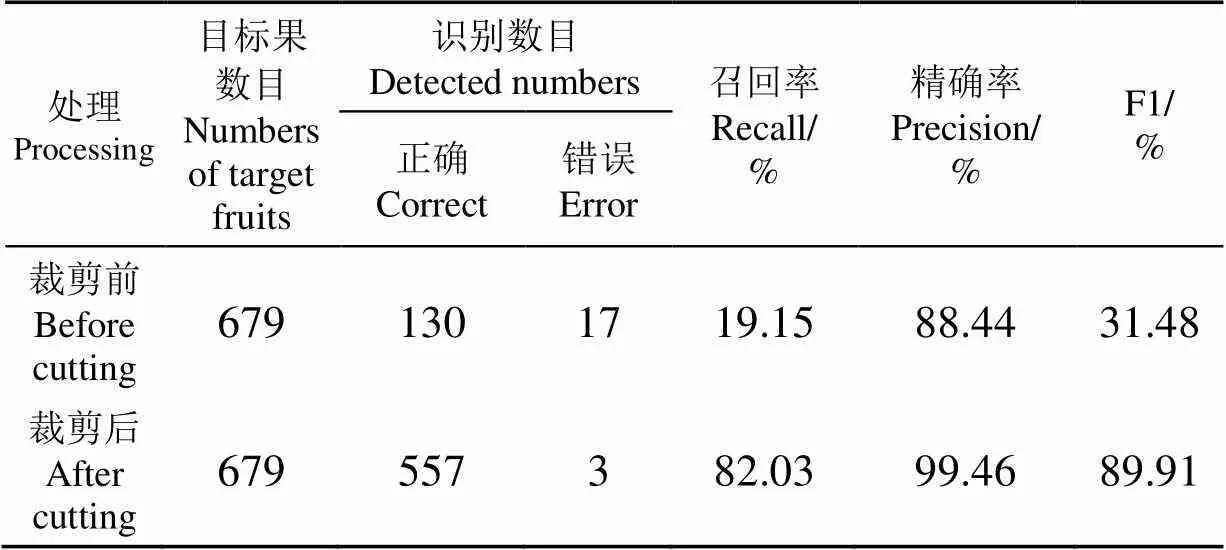

3.1 樣本數據集處理

研究表明,不同大小的圖像對網絡的訓練速度和特征提取均有一定影響。由于網絡結構和硬件限制,Mask RCNN網絡訓練時要求輸入特定尺寸的圖像,而無人機近景影像往往大于這個尺寸。因此為保證油茶果特征的提取精度,本文通過縮放裁剪操作使無人機影像滿足Mask RCNN網絡訓練的輸入要求(如表1所示)。

表1 影像裁剪前后油茶果識別精度比較

由表1可知,裁剪前圖像的F1值僅為31.48%,召回率僅為19.15%,說明裁剪前預測結果非常不理想,難以實現目標的準確分割。裁剪后各項指標均有提升,其中F1值達到89.91%,提高了約58個百分點;召回率從19.15%提高到82.03%,說明適當的圖像裁剪操作,能夠實現油茶果特征的準確提取,提高模型預測精度。

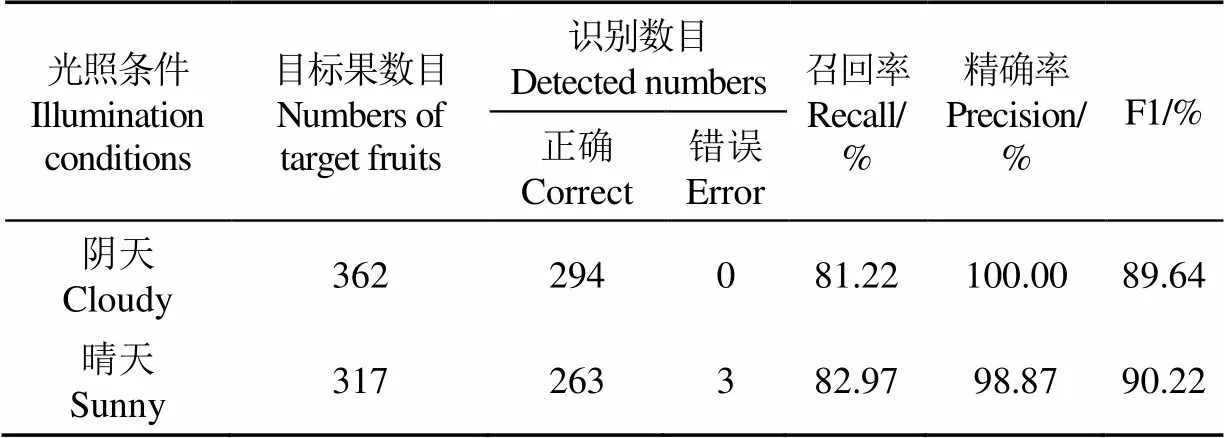

3.2 冠層果自動檢測

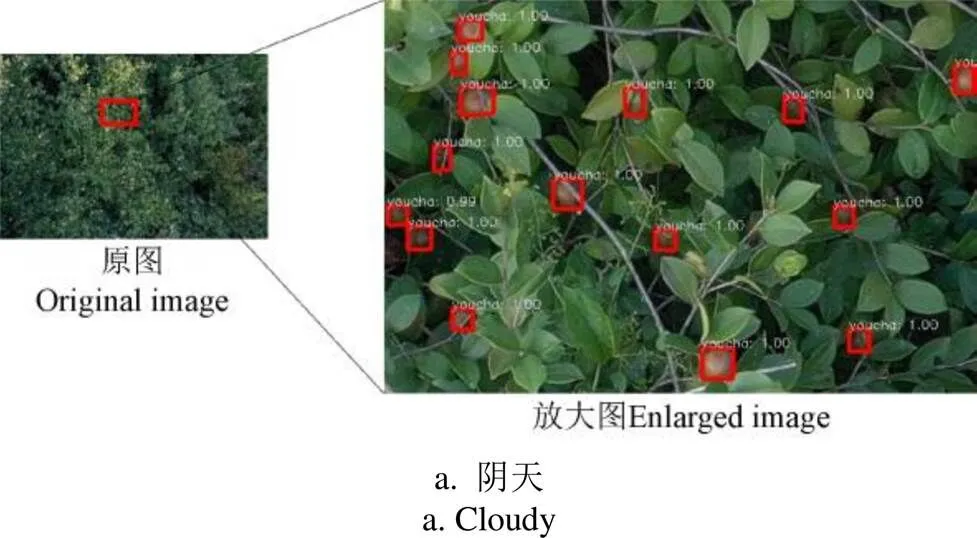

冠層果測試集為無人機近景圖像通過數據增強和隨機裁剪按比例隨機獲取,具體測試精度見表2。同時為更好地說明訓練模型的泛化能力,選擇不同光照條件(陰天和晴天)的油茶果照片進行檢測,具體檢測結果如圖4所示。

表2 測試集冠層果平均檢測精度

由表2可知,測試集共有679個油茶果目標,本文方法識別的油茶果數目為560個,其中557個為油茶果目標,平均召回率為82.03%,平均準確率為99.46%,平均F1值為89.91%,說明Mask RCNN網絡的檢測精度較高,不僅能檢測目標油茶果的定位框,而且能準確識別油茶果的二值掩碼。

結合圖4分析可知,Mask RCNN網絡不僅適用于陰天采集的光照均勻圖像,同樣適用于晴天采集的強光照射圖像,F1值分別為89.64%和90.22%。強光照射可能導致油茶果目標表面光線極強,導致肉眼無法將油茶果目標正確識別,本文網絡能有效識別圖像中的油茶果目標,召回率為82.97%;該網絡同樣適用于陰天部分遮擋情況的油茶果識別,召回率為81.22%。另外部分青色和紅色小果與檢測背景相似,存在一定的漏識別現象,說明不同成熟度的果實顏色對油茶果檢測精度有一定影響。總體上,Mask RCNN網絡檢測油茶果的精度較高,能夠用于后續油茶樣木的快速估產。

注:原圖大小均為5 472像素×3 648像素,放大圖大小為684像素×456像素;矩形框上方的數字表示目標為油茶果的概率。

Note: The size of the original image is 5 472 pixels×3 648 pixels, and the size of the enlarged image is 684 pixels×456 pixels; the number above the rectangular box represents the probability that the target is a camellia oleifera fruit.

圖4 Mask RCNN網絡對不同光照條件油茶果的檢測效果

Fig.4 Detection effects of Mask RCNN network on camellia oleifera under different lighting conditions

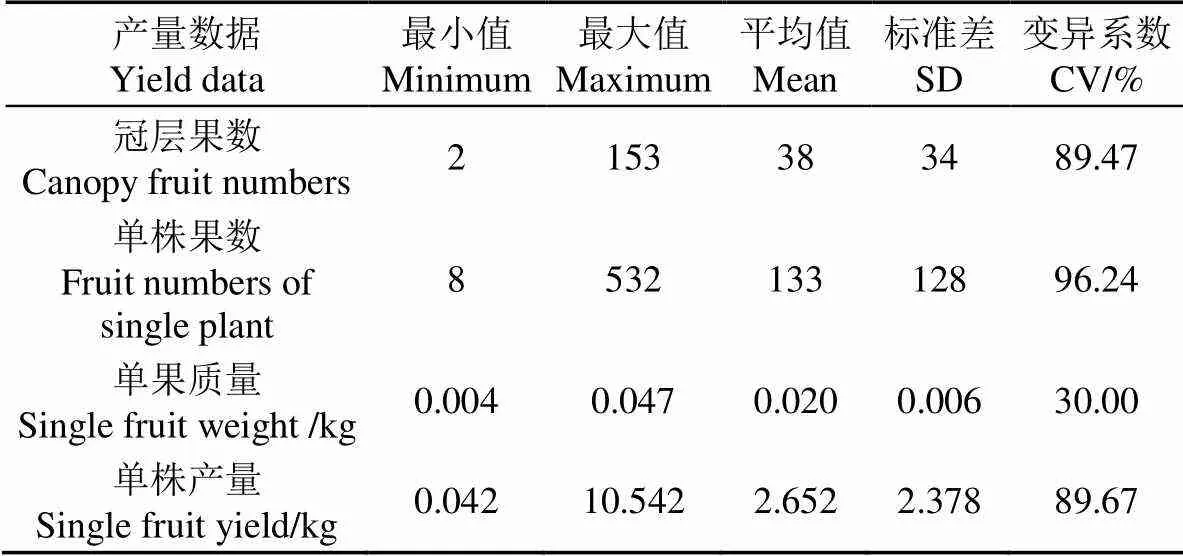

3.3 樣木產量數據統計

根據油茶冠層果識別結果,對研究區120株油茶樣木的產量數據分別進行統計(表3)。分析可知,油茶樣木冠層果數和單株果數平均值分別為38和133,在2~153和8~532之間變化;單株產量和單果質量平均值分別為2.652和0.020 kg,介于0.042~10.542和0.004~0.047 kg之間,說明研究區油茶樣木產量普遍不高,具有一定的改良空間。另外,4類油茶產量數據均表現出不同程度的差異性,變化范圍介于30.00%~96.42%之間,說明本文選擇的油茶樣木具有一定的代表性,可能受油茶結實大小年、油茶品種和種植環境等因素影響,統計的產量數據呈現出較強的變異性。

3.4 估產結果分析

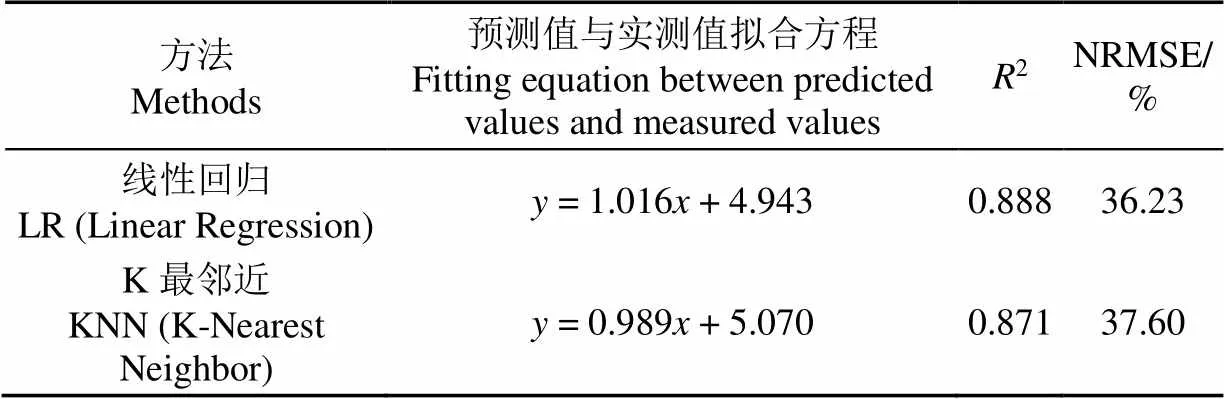

3.4.1 單株果數估計

基于預測的冠層果數據,構建冠層果數與單株果數之間的經驗模型,其中80株樣木數據用于模型構建,預留的40株樣木數據用于精度驗證,具體結果如表4所示。

分析可知,2種方法的2均不低于0.871,NRMSE均低于38%;其中LR模型估算精度較高,2和NRMSE分別為0.888和36.23%;KNN模型精度略低于LR模型。說明采用Mask RCNN網絡預測的冠層果數與實測的單株果數之間存在良好的線性擬合關系,證明了基于冠層果數擬合樣木單株果數的有效性。

表3 研究區油茶樣木產量數據統計結果

SD: Standard deviation; CV: Coefficient of variation.

表4 基于冠層果數擬合的單株果數精度檢驗結果

NRMSE: Normalized Root Mean Square Error.

3.4.2 估產精度評價

基于冠層果數擬合的單株果數,利用公式(4)對研究區剩余的40株油茶樣木進行產量估測,估產精度驗證結果如圖5所示。

分析圖5可知,2種方法均取得較好的估產效果,2和NRMSE分別在0.892~0.913和28.01%~31.00%之間變化。估產精度方面,LR的估產精度略高于KNN,2和NRMSE分別為0.913和28.01%,說明基于冠層果數擬合的油茶樣木單株果數與單株產量之間存在良好的線性關系,本文方法具有較好的穩定性和有效性。

4 討 論

4.1 油茶果樣本集擴增

相關研究表明,數據擴增是一種常用的數據增強方法,可在增加樣本數量的同時減少模型訓練出現的過度擬合[26]。考慮油茶果顏色與油茶葉片的相似性,以及無人機航拍的影像數量有限和環境的不確定性,難以滿足Mask RCNN網絡訓練的樣本需求,研究采用圖像縮放、亮度、對比度、噪聲注入以及翻轉等方法,對已標注的樣本進行數據擴增,結果表明適當的數據擴增操作,能夠提高模型的泛化能力,減少復雜環境對油茶果識別造成的不良影響,提高油茶果的識別精度。這與已有學者采用數據增強技術擴充樣本數據集緩解過擬合的研究結論相似[27],隨著研究的持續開展,后續將圍繞油茶果樣本數據集的標準化開展深入研究。

4.2 油茶果自動檢測的影響因素

本研究采用Mask RCNN網絡對不同光照條件的油茶冠層果進行識別,結果表明該網絡不僅能準確提取目標油茶果的定位框,還能準確繪制目標油茶果的二值掩碼,說明該網絡具有良好的準確性和穩定性,檢測油茶果的精度均較高[28],預測的油茶果數量能夠用于后續研究;已有研究表明,遮擋重疊、分布密集、背景相似以及表面陰影是影響目標對象精準識別的主要干擾因素[29],本文通過采用全卷積神經網絡FCN提取油茶果目標的準確特征,一定程度減少背景、遮擋、重疊和陰影等因素的干擾,實現油茶果目標的高效識別,這與已有學者采用全卷積神經網絡檢測蘋果的研究結論相似[30]。隨著樣本數據集的積累,后續將圍繞遮擋、重疊、背景(如不同成熟度的果實顏色)以及陰影等影響因素開展深入研究,以期進一步提高油茶果自動檢測的精度。

4.3 估產模型精度比較

為提高作物產量的估算精度,本研究以無人機航拍影像為數據源,采用Mask RCNN網絡開展基于近景影像的油茶冠層果自動檢測與計數,然后利用2種方法建立預測的冠層果數與單株果數之間的關系,構建基于冠層果自動檢測的估產模型,旨在為無人機遙感在大面積作物快速估產中的應用提供一種新的思路。雖然由傳統衛星遙感估算的作物產量在區域和國家尺度可以接受,但是不能精確到單株樣木的產量估算,主要受衛星遙感空間分辨率的限制[18, 31-32]。同傳統衛星遙感相比,基于無人機近景攝影的冠層果自動檢測在作物產量估測方面顯示出明顯的優勢,因為來自無人機超低空近景拍攝的高清影像可以實現油茶樣木冠層果的準確檢測與計數。

研究表明,由Mask RCNN網絡檢測的油茶冠層果數與單株果數之間具有良好的一致性,可作為大面積油茶林產量估算的真值數據。另外受無人機超低空航拍數據的限制,本文只是利用隨機抽樣采集部分典型油茶樣木的高清影像,通過高清影像預測的冠層果數擬合單株果數,同時結合研究區油茶樣木株數和實測單果質量,探索構建基于冠層果自動檢測的估產模型的可行性。利用無人機超低空近景影像和實測產量數據開展大面積油茶林的精細化估產將是下一步的研究重點。眾所周知,油茶產量的估算精度受多種因素的影響,如油茶的生長年份、大小年和不同品種等。隨著研究的持續推進,后續將圍繞不同區域、不同年份、不同品種和不同種植密度開展試驗研究,以填補油茶估產模型研究的空白。

5 結 論

隨著無人機遙感的快速發展,基于冠層影像的農作物估產得到了廣泛關注,然而鮮有基于冠層果自動檢測的油茶快速估產報道。鑒于此,研究以無人機航拍影像為數據源,通過隨機抽樣方法選取120株油茶樹進行無人機近景拍攝和人工采摘稱量;然后利用Mask RCNN開展油茶冠層果的自動檢測與計數;最后利用兩種方法擬合冠層果數和單株果數之間的關系,同時結合油茶樣木總株數和實測單果質量,構建基于冠層果自動檢測的估產模型。結果表明:

1)借助無人機超低空近景攝影,利用Mask RCNN網絡能夠有效識別不同光照條件的油茶果,平均F1值達89.91%,可作為后續產量估測的真值數據;

2)同傳統的衛星遙感相比,基于無人機近景攝影的冠層果自動檢測在作物產量估測方面顯示出明顯的優勢,Mask RCNN網絡預測的冠層果數與單株果數之間具有良好的一致性,決定系數2不低于0.871;

3)估產結果表明,結合2種方法(線性回歸和K最鄰近)構建的模型估產精度均較高,擬合決定系數2和NRMSE分別在0.892~0.913和28.01%~31.00%間變化,說明基于冠層果自動檢測的油茶估產方法具有較高的穩定性和適用性,是一種可推廣的作物估產方法。

[1] 張東生,金青哲,薛雅琳,等. 油茶籽油的營養價值及摻偽鑒定研究進展[J]. 中國油脂,2013,38(8):47-50.

Zhang Dongsheng, Jin Qingzhe, Xue Yalin, et al. Nutritional value and adulteration identification of oil tea camellia seed oil[J]. China Oils and Fats, 2013, 38(8): 47-50. (in Chinese with English abstract)

[2] Gongal A, Amatya S, Karkee M, et al. Sensors and systems for fruit detection and localization: A review[J]. Computers and Electronics in Agriculture, 2015, 116: 8-19.

[3] 李昕,李立君,高自成,等. 基于偏好人工免疫網絡多特征融合的油茶果圖像識別[J]. 農業工程學報,2012,28(14):133-137.

Li Xin, Li Lijun, Gao Zicheng, et al. Image recognition of camellia fruit based on preference for aiNET multi-features integration[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2012, 28(14): 133-137. (in Chinese with English abstract)

[4] 李立君,陽涵疆. 基于改進凸殼理論的遮擋油茶果定位檢測算法[J]. 農業機械學報,2016,47(12):285-292,346.

Li Lijun, Yang Hanjiang. Revised detection and localization algorithm for camellia oleifera fruits based on convex hull theory[J]. Transactions of the Chinese Society for Agricultural Machinery, 2016, 47(12): 285-292, 346. (in Chinese with English abstract)

[5] Gongal A, Karkee M, Amatya S. Apple fruit size estimation using a 3D machine vision system[J]. Information Processing in Agriculture, 2018, 5(4): 498-503.

[6] Zhou R, Damerow L, Sun Y, et al. Using colour features of cv. ‘Gala’ apple fruits in an orchard in image processing to predict yield[J]. Precision Agriculture, 2012, 13(5): 568-580.

[7] Kurtulmus F, Lee W S, Vardar A. Green citrus detection using ‘eigenfruit’, color and circular Gabor texture features under natural outdoor conditions[J]. Computers and Electronics in Agriculture, 2011, 78(2): 140-149.

[8] Yamamoto K, Guo W, Yoshioka Y, et al. On plant detection of intact tomato fruits using image analysis and machine learning methods[J]. Sensors, 2014, 14(7): 12191-12206.

[9] 李昕,李立君,高自成,等. 改進類圓隨機Hough變換及其在油茶果實遮擋識別中的應用[J]. 農業工程學報,2013,29(1):164-170.

Li Xin, Li Lijun, Gao Zicheng, et al. Revised quasi-circular randomized hough transform and its application in camellia-fruit recognition[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2013, 29(1): 164-170. (in Chinese with English abstract)

[10] Lin G C, Tang Y C, Zou X J, et al. Guava detection and pose estimation using a low-cost RGB-D sensor in the field[J]. Sensors, 2019, 19(2): 428.

[11] 張習之,李立君. 基于改進卷積自編碼機的油茶果圖像識別研究[J]. 林業工程學報,2019,4(3):118-124.

Zhang Xizhi, Li Lijun. Research of image recognition of camellia oleifera fruit based on improved convolutional auto-encoder[J]. Journal of Forestry Engineering, 2019, 4(3): 118-124. (in Chinese with English abstract)

[12] Koirala A, Walsh K B, Wang Z, et al. Deep learning for real-time fruit detection and orchard fruit load estimation: Benchmarking of ‘MangoYOLO’[J]. Precision Agriculture, 2019, 20(6): 1107-1135.

[13] Wang Z, Walsh K, Koirala A. Mango fruit load estimation using a video based Mango YOLO-Kalman filter-hungarian algorithm method[J]. Sensors, 2019, 19(12): 2742.

[14] Zhuang J J, Luo S M, Hou C J, et al. Detection of orchard citrus fruits using a monocular machine vision-based method for automatic fruit picking applications[J]. Computers and Electronics in Agriculture, 2018, 152: 64-73.

[15] Rahnemoonfar M, Sheppard C. Deep count: Fruit counting based on deep simulated learning[J]. Sensors, 2017, 17(4): 905.

[16] H?ni N, Roy P, Isler V. Apple counting using convolutional neural networks[C]//2018 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS). IEEE, 2018: 2559-2565.

[17] Wu S R, Yang P, Chen Z X, et al. Estimating winter wheat yield by assimilation of remote sensing data with a four-dimensional variation algorithm considering anisotropic background error and time window[J]. Agricultural and Forest Meteorology, 2021, 301: 108345.

[18] 徐權,郭鵬,祁佳峰,等. 基于無人機影像的SEGT棉花估產模型構建[J]. 農業工程學報,2020,36(16):44-51.

Xu Quan, Guo Peng, Qi Jiafeng, et al. Construction of SEGT cotton yield estimation model based on UAV image[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(16): 44-51. (in Chinese with English abstract)

[19] García-Martínez H, Flores-Magdaleno H, Ascencio-Hernández R, et al. Corn grain yield estimation from vegetation indices, canopy cover, plant density, and a neural network using multispectral and RGB images acquired with unmanned aerial vehicles[J]. Agriculture, 2020, 10(7): 277.

[20] 周小成,何藝,黃洪宇,等. 基于兩期無人機影像的針葉林伐區蓄積量估算[J]. 林業科學,2019,55(11):117-125.

Zhou Xiaocheng, He Yi, Huang Hongyu, et al. Estimation of forest stand volume on coniferous forest cutting area based on two periods unmanned aerial vehicle images[J]. Scientia Silvae Sinicae, 2019, 55(11): 117-125. (in Chinese with English abstract)

[21] Zhou J, Zhou J F, Ye H, et al. Yield estimation of soybean breeding lines under drought stress using unmanned aerial vehicle-based imagery and convolutional neural network[J]. Biosystems Engineering, 2021, 204: 90-103.

[22] Apolo Apolo O E, Martínez-Guanter J, Egea G, et al. Deep learning techniques for estimation of the yield and size of citrus fruits using a UAV[J]. European Journal of Agronomy, 2020, 115: 126030.

[23] Khan M A, Akram T, Zhang Y D, et al. Attributes based skin lesion detection and recognition: A mask RCNN and transfer learning-based deep learning framework[J]. Pattern Recognition Letters, 2021, 143: 58-66.

[24] Lin T Y, Dollár P, Girshick R, et al. Feature Pyramid networks for object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. 2017: 2117-2125.

[25] 嚴恩萍,趙運林,林輝,等. 基于地統計學和多源遙感數據的森林碳密度估算[J]. 林業科學,2017,53(7):72-84.

Yan Enping, Zhao Yunlin, Lin Hui, et al. Estimation of forest carbon density based on geostatistics and multi-r esource remote sensing data[J]. Scientia Silvae Sinicae, 2017, 53(7): 72-84. (in Chinese with English abstract)

[26] Pinheiro P O, Collobert R, Dollar P. Learning to segment object candidates[J]. NIPAS’15: Proceedings of the 28thInternational Conference on Neural Information Processing System, 2015, 2: 1990-1998.

[27] 趙立新,侯發東,呂正超,等. 基于遷移學習的棉花葉部病蟲害圖像識別[J]. 農業工程學報,2020,36(7):184-191.

Zhao Lixin, Hou Fadong, Lyu Zhengchao, et al. Image recognition of cotton leaf diseases and pests based on transfer learning[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(7): 184-191. (in Chinese with English abstract)

[28] Fan Z M, Xia W J, Liu X, et al. Detection and segmentation of underwater objects from forward-looking sonar based on a modified Mask RCNN[J]. Signal, Image and Video Processing, 2021, 15: 1135-1143.

[29] Jia W K, Tian Y Y, Luo R, et al. Detection and segmentation of overlapped fruits based on optimized mask R-CNN application in apple harvesting robot[J]. Computers and Electronics in Agriculture, 2020, 172: 105380.

[30] 王丹丹,何東健. 基于R-FCN深度卷積神經網絡的機器人疏果前蘋果目標的識別[J]. 農業工程學報,2019,35(3):156-163.

Wang Dandan, He Dongjian. Recognition of apple targets before fruits thinning by robot based on R-FCN deep convolution neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(3): 156-163. (in Chinese with English abstract)

[31] Yu N, Li L, Schmitz N, et al. Development of methods to improve soybean yield estimation and predict plant maturity with an unmanned aerial vehicle based platform[J]. Remote Sensing of Environment, 2016, 187: 91-101.

[32] 劉煥軍,孟令華,張新樂,等. 基于時間序列Landsat 影像的棉花估產模型[J]. 農業工程學報,2015,31(17):215-220.

Liu Huanjun, Meng Linghua, Zhang Xinle, et al. Estimation model of cotton yield with time series Landsat images[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2015, 31(17): 215-220. (in Chinese with English abstract)

Rapid estimation of camellia oleifera yield based on automatic detection of canopy fruits using UAV images

Yan Enping, Ji Yu, Yin Xianming, Mo Dengkui※

(1.,,410004,; 2.,,410004,; 3.,410004,)

Rapid and accurate yield estimation is of great significance to the management and sustainable development of Camellia oleifera production. The quantity and single fruit weight of camellia fruits are crucial indicators representing the Camellia yield. Therefore, a highly efficient and accurate monitoring of the quantity and single fruit weight of Camellia fruits can contribute to saving labor, material, and financial resources, as well as timely decision-making. Unmanned aerial vehicle (UAV) remote sensing has presented a high spatial resolution, fast data acquisition, and simple operation in recent years. An optimal operation period can be selected to obtain high-resolution aerial images, and thereby to realize the crop yield estimation in a large scale using the fruit numbers. However, only a few kinds of research are focused on the estimation of Camellia yield using UAV images and fruit number identification. In this study, a rapid yield estimation of Camellia oleifera was realized via the automatic detection of canopy fruit using UAV images. Firstly, a DJI Mavic 2 PRO UAV platform and Hasselblad L1D-20C camera were utilized to obtain UAV aerial images in the study area. 120 camellia oleifera trees were selected by random sampling for close-up UAV shooting, and manual picking, and weighing. A Mask RCNN framework was then employed to automatically detect and count the canopy fruits in the sample trees using UAV close-up images. Finally, two common Linear Regression (LR) and K-Nearest Neighbor (KNN) were used to build the relationship between the predicted fruit numbers of tree canopy and the measured. A yield estimation model was thus constructed using automatic detection of canopy fruits, according to the total numbers of sample trees and the average weight of single fruit. The results showed that: (1) There was an excellent performance of crop yield estimation via the automatic detection of canopy fruits using close-range photography of UAV, compared with the traditional method. (2) UAV ultra-low-altitude close-up images combined with Mask RCNN network effectively detected the camellia oleifera fruits under different lighting conditions, with an average F1 value of 89.91%. (3) There was well consistency between the predicted fruit numbers of tree canopy identified by Mask RCNN network and the measured, with2higher than 0.871. (4) The yield estimation results showed that the combined LR/KNN models presented a higher accuracy of yield estimation with2and NRMSE ranging from 0.892 to 0.913, and 28.01% to 31.00%, respectively. Consequently, the rapid yield estimation of Camellia oleifera sample trees can be achieved using automatic detection of canopy fruits from UAV images. The finding can provide highly versatile and great potential for rapid yield estimation and intelligent monitoring of the crops or trees in large areas.

UAV; automatic detection; Camellia oleifera; rapid yield estimation; canopy fruit

嚴恩萍,棘玉,尹顯明,等. 基于無人機影像自動檢測冠層果的油茶快速估產方法[J]. 農業工程學報,2021,37(16):39-46.doi:10.11975/j.issn.1002-6819.2021.16.006 http://www.tcsae.org

Yan Enping, Ji Yu, Yin Xianming, et al. Rapid estimation of camellia oleifera yield based on automatic detection of canopy fruits using UAV images[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(16): 39-46. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2021.16.006 http://www.tcsae.org

2021-04-01

2021-07-14

國家自然科學基金項目(31901311,32071682)

嚴恩萍,博士,講師,研究方向為林業遙感與地理信息系統應用。Email:Enpingyan@csuft.edu.cn

莫登奎,副教授,研究方向為林業遙感與人工智能應用。Email:dengkuimo@csuft.edu.cn

10.11975/j.issn.1002-6819.2021.16.006

S127;S757.2

A

1002-6819(2021)-16-0039-08