基于特征融合的極限學(xué)習(xí)機(jī)圖像分類方法

蔣 強(qiáng),陳 凱,王德元

(1.沈陽(yáng)理工大學(xué),遼寧 沈陽(yáng) 110000;2.沈陽(yáng)飛馳電氣設(shè)備有限公司,遼寧 沈陽(yáng) 110000)

1 引言

隨著我國(guó)自主建設(shè)、獨(dú)立運(yùn)行的衛(wèi)星導(dǎo)航系統(tǒng)北斗衛(wèi)星導(dǎo)航系統(tǒng)(BeiDou Navigation Satellite System)的日趨完善,填補(bǔ)了我國(guó)在衛(wèi)星導(dǎo)航系統(tǒng)領(lǐng)域的空白。北斗衛(wèi)星導(dǎo)航系統(tǒng)由三大部分組成,包括空間星座(空間段)、地面控制(地面段)和用戶終端(用戶段)[1]。北斗衛(wèi)星導(dǎo)航系統(tǒng)可以為用戶提供全天候、高精度的定位、導(dǎo)航及授時(shí)等方面的應(yīng)用,截至目前,我國(guó)已成功發(fā)射48顆衛(wèi)星,計(jì)劃在2020年底全面完成北斗衛(wèi)星導(dǎo)航系統(tǒng)的建設(shè),形成全球無(wú)源服務(wù)能力,達(dá)到世界一流水平[2-3]。

隨著北斗衛(wèi)星導(dǎo)航系統(tǒng)的不斷完善,系統(tǒng)在森林防火、軍事戰(zhàn)略、交通管理、農(nóng)業(yè)漁業(yè)、公共安全、減災(zāi)救災(zāi)、氣象探測(cè)、通信和電力等眾多領(lǐng)域得到應(yīng)用,并呈現(xiàn)出更為廣泛應(yīng)用的趨勢(shì)[4-7]。遙感圖像的場(chǎng)景分類作為這些應(yīng)用的基礎(chǔ),對(duì)北斗衛(wèi)星導(dǎo)航系統(tǒng)的進(jìn)一步應(yīng)用有著至關(guān)重要的作用,遙感圖像的分類已成為熱門的研究主題。遙感圖像主要有以下特點(diǎn):

1)遙感圖像分辨率逐漸增高,圖像數(shù)據(jù)維度越來(lái)越高,對(duì)計(jì)算機(jī)內(nèi)存及處理能力要求不斷提高,處理時(shí)間長(zhǎng);

2)圖像受天氣、光照、角度等外界因素影響比較大,增加了分類難度。

針對(duì)遙感圖像的特點(diǎn),本文提出一種結(jié)合圖像融合和極限學(xué)習(xí)機(jī)(Extreme Learning Machine,ELM)的遙感圖像分類方法。針對(duì)遙感圖像光照等外部條件復(fù)雜的問(wèn)題,通過(guò)融合遙感圖像的SIFT特征和CNN網(wǎng)絡(luò)特征,提高了遙感圖像的特征層次,更充分的利用了遙感圖像的信息,提取特征的魯棒性和判別性較好,從而有效提高了遙感圖像的分類準(zhǔn)確率。通過(guò)引入信息熵改進(jìn)的PCA對(duì)融合后的圖像特征進(jìn)行降維,提升了降維效率,減少了特征維度提高了特征質(zhì)量從而提升了遙感圖像的分類速度。

2 遙感圖象識(shí)別的基本框架

結(jié)合圖像融合和極限學(xué)習(xí)機(jī)的遙感圖像識(shí)別混合深度模型結(jié)構(gòu)圖如圖1示。本方法分別對(duì)輸入的圖像提取SIFT局部特征及CNN整體特征,特征提取完成后經(jīng)過(guò)由圖像信息熵改進(jìn)的PCA降維后輸入ELM分類器中最終完成遙感圖像的分類任務(wù)。

圖1 結(jié)合圖像融合和極限學(xué)習(xí)機(jī)的遙感圖像識(shí)別流程圖

2.1 特征提取

2.1.1 SIFT圖像特征

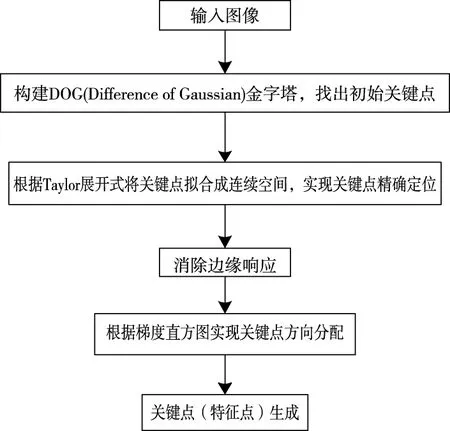

SIFT(Scale Invariant Feature Transformation),即尺度不變特征變換,是最為優(yōu)秀的目標(biāo)匹配與識(shí)別算法之一。尺度的概念為表達(dá)人視網(wǎng)膜成像過(guò)程中目標(biāo)的遠(yuǎn)近程度,尺度越大,看到的圖像范圍越大,但是細(xì)節(jié)越模糊;尺度越小,看到的范圍越小,但細(xì)節(jié)比較豐富。SIFT算法可以找出尺度變換過(guò)程中的穩(wěn)定點(diǎn)(特征點(diǎn)),這些特征點(diǎn)都含有三個(gè)信息,即位置、方向、尺度,這樣便保證了圖像在翻轉(zhuǎn)、平移和縮放時(shí)可以保持很好的魯棒性,對(duì)光照、陰影和噪聲等的穩(wěn)定性也極高。SIFT算法流程圖如圖2所示。

圖2 SIFT算法流程圖

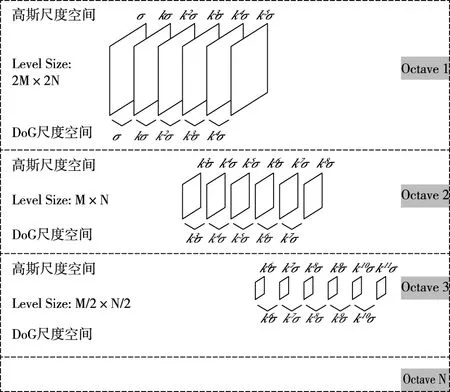

SIFT算法最重要的步驟為構(gòu)建高斯差分金字塔(Difference of Gaussian,DOG)。1994年,Tony Lindeberg證明高斯核是唯一可以產(chǎn)生多尺度空間的核[8],圖像尺度可定義為原始圖像與一個(gè)可變尺度的高斯函數(shù)卷積運(yùn)算,即

L(x,y,σ)=G(x,y,σ)*I(x,y)

(1)

其中,G(x,y,σ)為高斯函數(shù)。

首先需要建立高斯金字塔,分為兩步:

1)對(duì)圖像做高斯平滑

2)對(duì)圖像做將采樣

設(shè)高斯圖像金字塔共o組、s層,則有

σ(s)=σ02o+s/S

(2)

其中σ為尺度空間坐標(biāo),s為sub-level層坐標(biāo),σ0為初始尺度,S為每組層數(shù)。DoG金字塔過(guò)程如圖3所示。

圖3 DoG金字塔創(chuàng)建過(guò)程

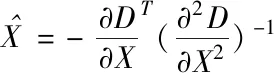

圖像的關(guān)鍵點(diǎn)由DoG空間的局部極值點(diǎn)組成,該極值點(diǎn)為圖像離散極值點(diǎn),根據(jù)Taylor展開式可以對(duì)尺度空間DoG函數(shù)進(jìn)行曲線擬合

(3)

求解得

(4)

(5)

取值小于0.04的極值點(diǎn)均拋棄。

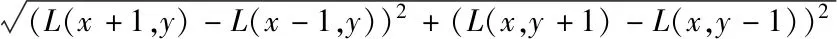

最后通過(guò)計(jì)算關(guān)鍵點(diǎn)周圍像素梯度的幅值和方向確定關(guān)鍵點(diǎn)基準(zhǔn)方向,從而保持翻轉(zhuǎn)穩(wěn)定性,其中,梯度幅值表示為

m(x,y)=

(6)

方向?yàn)?/p>

(7)

這樣確定的每個(gè)關(guān)鍵點(diǎn)都含有位置尺度方向三個(gè)信息,保證了提取的局部特征的穩(wěn)定性。

2.1.2 CNN提取圖像全局特征

卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Networks,CNN)自從Yann Lecun等在1998年提出以來(lái),迅速在圖像領(lǐng)域取得了廣泛的應(yīng)用。其本質(zhì)是一個(gè)多層感知機(jī)[9],CNN特點(diǎn)主要是其局部連接和權(quán)值共享模式,當(dāng)輸入數(shù)據(jù)為圖像時(shí)CNN能夠自動(dòng)完成特征提取,提取后的局部特征輸入第一層全連接層組成全局特征,進(jìn)而實(shí)現(xiàn)圖像的分類。CNN已成功應(yīng)用于圖像處理的各個(gè)任務(wù),因此CNN被認(rèn)為是圖像識(shí)別領(lǐng)域的主導(dǎo)算法。CNN雖然能夠很方便的提取到特征,但其全連接層在分類時(shí),占據(jù)了大量的計(jì)算時(shí)間與參數(shù)量,所以,近些年CNN被認(rèn)為是優(yōu)秀的全局特征提取結(jié)構(gòu),而在分類時(shí),會(huì)刪除全連接層,選用其它分類器。例如,2012年Niuxx等人提出的CNN-SVM模型[10],結(jié)合了卷積神經(jīng)網(wǎng)絡(luò)特征提取和支持向量機(jī)分類器的優(yōu)點(diǎn),在圖像分類試驗(yàn)中得到了較低的分類錯(cuò)誤率。

2.2 特征融合及優(yōu)化

圖像的特征融合技術(shù)已成為當(dāng)今圖像研究的熱門領(lǐng)域,圖像融合是一種將來(lái)自同一場(chǎng)景的許多圖像的不同信息融合在一起的方法,這些圖像取自各種傳感器或不同的特征范圍。融合圖像保留了輸入圖像的各種補(bǔ)充和冗余信息,這些信息對(duì)于人類的視覺(jué)感知和圖像處理任務(wù)非常有用。為了達(dá)到這些目的,融合結(jié)果應(yīng)滿足以下要求:

(a)融合圖像應(yīng)保留輸入圖像中最互補(bǔ)和重要的信息;

(b)融合技術(shù)不應(yīng)生成任何可能轉(zhuǎn)移方向的合成信息;

(c)必須避免出現(xiàn)不完善的狀態(tài),例如噪聲等[11]。

綜上所述,圖像融合將保留來(lái)自輸入圖像的互補(bǔ)信息和冗余信息,確保獲取更全面的圖像特征。

CNN提取的圖像全局特征和和圖像SIFT局部特征融合后,特征維度必然增大,為了減少后續(xù)分類過(guò)程的計(jì)算量,需要對(duì)特征進(jìn)行PCA降維。在PCA降維過(guò)程中,需要計(jì)算特征之間的協(xié)方差矩陣,內(nèi)存消耗很大且耗時(shí)。為了達(dá)到預(yù)期的效果,需要改進(jìn)PCA以盡可能地壓縮特征數(shù)據(jù)并減少特征維度,減少降維過(guò)程中的內(nèi)存占用和運(yùn)行時(shí)間,引入圖像信息熵來(lái)滿足這些要求。特征的信息熵值越大,原始數(shù)據(jù)中包含的信息量越大,它屬于應(yīng)保留的特征。如果特征的信息熵較低,則包含的數(shù)據(jù)信息越少[12],應(yīng)刪除或不保留該特征。圖4為改進(jìn)PCA降維的效果圖。

圖4 改進(jìn)PCA降維效果

改進(jìn)的PCA降維有效降低了數(shù)據(jù)維度及分類時(shí)間,提高了網(wǎng)絡(luò)在高維數(shù)據(jù)分類時(shí)的實(shí)時(shí)性表現(xiàn)。

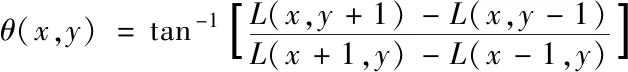

2.3 ELM分類器

在提出的系統(tǒng)中,使用基于ELM的分類器。

圖5 ELM結(jié)構(gòu)

ELM是一個(gè)淺層網(wǎng)絡(luò),結(jié)構(gòu)如圖5所示,ELM具有許多優(yōu)點(diǎn),例如學(xué)習(xí)速度快,易于收斂以及隨機(jī)性較低[13]。因?yàn)镋LM可以隨機(jī)初始化輸入權(quán)重和偏差,所以ELM的訓(xùn)練只需確定輸出權(quán)重及確定隱層神經(jīng)元個(gè)數(shù),其中,隱層神經(jīng)元個(gè)數(shù)對(duì)分類性能有比較大的影響。本文用ELM代替全連接層,有效減少計(jì)算量及參數(shù)量。為了驗(yàn)證本文所使用的ELM分類器的優(yōu)勢(shì),將ELM分類器從診斷準(zhǔn)確率、訓(xùn)練時(shí)間和診斷時(shí)間三個(gè)層面分別與Softmax分類器和SVM進(jìn)行對(duì)比,實(shí)驗(yàn)結(jié)果如表1所示。

表1 分類器性能比較

從表1可以看出,ELM平均準(zhǔn)確率高達(dá)97.13%,高于Softmax分類器的93.71%以及SVM分類器的94.23%。此外,由于ELM訓(xùn)練時(shí)只需隨機(jī)生成連接權(quán)重和偏置,極大的減少了訓(xùn)練過(guò)程中的參數(shù)量與計(jì)算量,避免了繁復(fù)的迭代過(guò)程,因此訓(xùn)練時(shí)間遠(yuǎn)低于其它兩種分類器,同時(shí),分類時(shí)間也只有7.32ms,基本達(dá)到實(shí)時(shí)識(shí)別的應(yīng)用要求。

3 實(shí)驗(yàn)平臺(tái)及數(shù)據(jù)集

搭建的測(cè)試平臺(tái)使用的操作系統(tǒng)為Windows 10,深度學(xué)習(xí)框架為TensorFlow,開發(fā)軟件為Python3.0x,主要硬件配置:處理器為E5-2660V2@2.6GHz;內(nèi)存為16GB;;GPU為GTX1080TIi 11G。

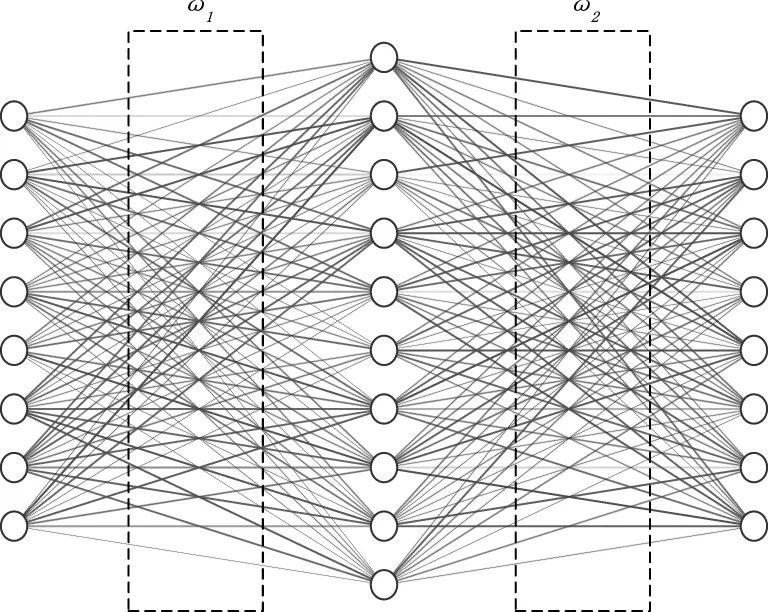

AID Dataset是一個(gè)遙感影像數(shù)據(jù)集,其包含30個(gè)類別的場(chǎng)景圖像,其中每個(gè)類別有約220~420張,整體共計(jì)10000張,其中每張像素大小約為600*600。該數(shù)據(jù)集由華中科技大學(xué)和武漢大學(xué)于2017年發(fā)布。

圖6 AID Dataset數(shù)據(jù)集中的遙感圖像

4 實(shí)驗(yàn)及結(jié)果分析

4.1 灰度處理與濾波

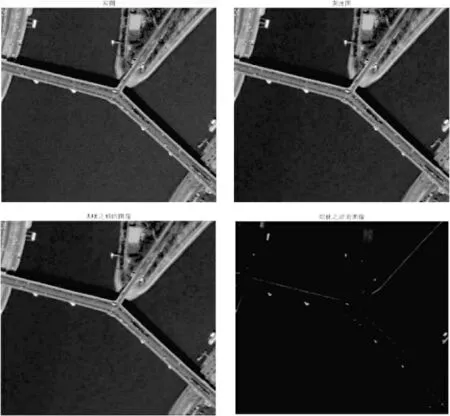

在本文中,需要分別用深度網(wǎng)絡(luò)和SIFT方法提取深層和淺層特征,首先需要對(duì)Dataset數(shù)據(jù)集圖像進(jìn)行灰度和濾波處理,這樣可以顯著減少圖像噪聲并將三維彩色圖像轉(zhuǎn)化為二維灰色圖像。

圖7 圖像預(yù)處理

4.2 輸入網(wǎng)絡(luò),統(tǒng)計(jì)時(shí)間及識(shí)別準(zhǔn)確度

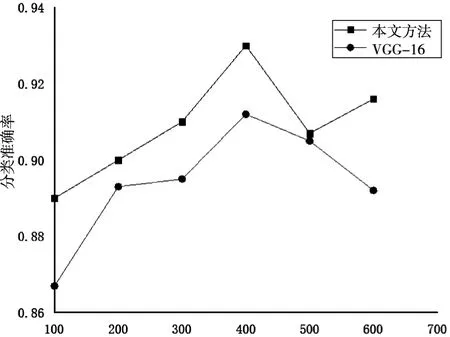

上文已經(jīng)驗(yàn)證改進(jìn)的PCA降維可以提高分類實(shí)時(shí)性能,為了驗(yàn)證本文方法中降維對(duì)遙感圖像分類準(zhǔn)確率的影響,設(shè)定了本算法和與VGG-16算法分類準(zhǔn)確率的兩組對(duì)比實(shí)驗(yàn)。

圖8 特征降至不同維度分類準(zhǔn)確率

由圖8可得,經(jīng)過(guò)特征融合加入SIFT特征后,豐富了圖像特征層次,有效提高了遙感圖像分類的準(zhǔn)確率,當(dāng)將特征維度降至400維時(shí)遙感圖像分類準(zhǔn)確率最高。

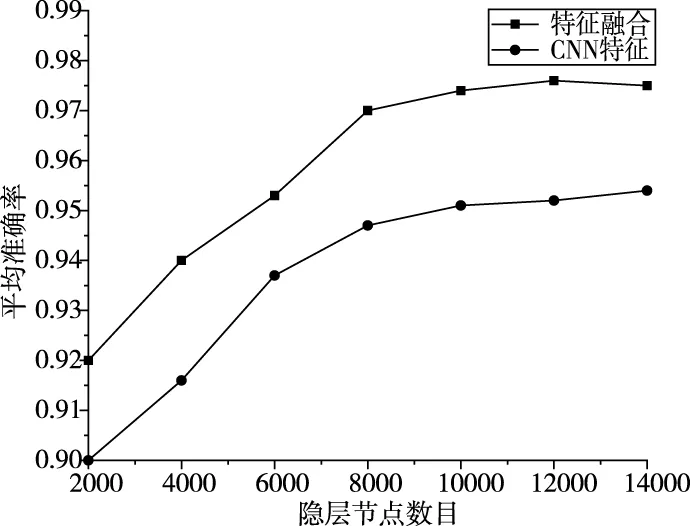

上文中提到隱層神經(jīng)元數(shù)目對(duì)ELM分類效果有著至關(guān)重要的作用。為驗(yàn)證隱藏節(jié)點(diǎn)數(shù)目對(duì)分類效果的影響,分別設(shè)置隱藏節(jié)點(diǎn)數(shù)目從2000增加到14000,結(jié)果如圖9所示。

圖9 不同隱藏節(jié)點(diǎn)數(shù)目下分類準(zhǔn)確率對(duì)比

從實(shí)驗(yàn)結(jié)果可以看到,隨著隱藏層節(jié)點(diǎn)數(shù)目增加,遙感圖像分類的準(zhǔn)確率會(huì)提高,但訓(xùn)練時(shí)間也會(huì)同時(shí)增加。綜合考慮準(zhǔn)確率和時(shí)間,本文選取隱藏層節(jié)點(diǎn)數(shù)量為10000。利用特征融合的分類準(zhǔn)確率明顯高于CNN特征下的分類準(zhǔn)確率,平均高出兩個(gè)百分點(diǎn)。

5 結(jié)論

綜上所述,通過(guò)融合遙感圖像的SIFT特征和CNN網(wǎng)絡(luò)特征,針對(duì)遙感圖像光照等外部條件復(fù)雜的問(wèn)題,提高了遙感圖像的特征層次,更充分的利用了遙感圖像的信息,提取特征的魯棒性和判別性較好,從而有效提高了遙感圖像的分類準(zhǔn)確率。通過(guò)引入信息熵改進(jìn)的PCA對(duì)融合后的圖像特征進(jìn)行降維,減少了特征維度提高了特征質(zhì)量從而提升了遙感圖像的分類速度。