自然資源多時(shí)相遙感影像智能匹配方法研究

史迪超,黎慧斌,李亭諭,史曉明

(1.中國(guó)地質(zhì)大學(xué)(武漢)地理與信息工程學(xué)院,湖北 武漢 430074;2.廣東省國(guó)土資源技術(shù)中心,廣東 廣州 510075;3.湖北省航測(cè)遙感院,湖北 武漢 430074)

全民所有自然資源資產(chǎn)清查是一項(xiàng)摸清全民所有土地、礦產(chǎn)、森林、草原、濕地和海洋等自然資源資產(chǎn)底數(shù)的基礎(chǔ)工作。遙感影像以其信息量豐富、現(xiàn)勢(shì)性好、實(shí)用性強(qiáng)、量測(cè)方便等特點(diǎn),成為全民所有自然資源資產(chǎn)清查工作中的一項(xiàng)重要基礎(chǔ)數(shù)據(jù),在實(shí)物量屬性清查、地類等因子內(nèi)業(yè)核查、經(jīng)濟(jì)價(jià)值核查等階段發(fā)揮著重要作用。時(shí)序影像是提高遙感影像自然資源資產(chǎn)清查單元解譯精度的關(guān)鍵,然而同一地區(qū)不同時(shí)相的遙感影像同名點(diǎn)的空間位置存在差異,不能直接使用,時(shí)序影像智能匹配是遙感影像在全民所有自然資源資產(chǎn)清查工作中規(guī)模化應(yīng)用的 基礎(chǔ)。

常見(jiàn)的影像匹配包括立體匹配和二維匹配,立體匹配是根據(jù)不同視點(diǎn)的影像找到對(duì)應(yīng)匹配點(diǎn),進(jìn)而重建三維場(chǎng)景[1];二維匹配是在不同時(shí)相或不同傳感器的影像間識(shí)別同名匹配點(diǎn),從而實(shí)現(xiàn)同一地區(qū)影像間的空間坐標(biāo)同化。時(shí)序影像匹配屬于二維匹配,具體步驟為:①檢測(cè)提取影像空間不變特征;②構(gòu)建特征描述符,并根據(jù)相似性提取時(shí)序匹配點(diǎn)對(duì);③根據(jù)基準(zhǔn)影像與待匹配影像之間的畸變特點(diǎn)確定幾何變換模型;④對(duì)影像進(jìn)行坐標(biāo)變換與插值。其中,提取更多的影像空間不變特征和構(gòu)建信息豐富的描述符是時(shí)序影像精準(zhǔn)匹配的關(guān)鍵。對(duì)于影像空間不變特征的提取,傳統(tǒng)方法首先提取兩幅影像間的不變特征,再進(jìn)行影像空間匹配[2];De C E[3]、CHEN Q S[4]和Reddy B S[5]等則利用傅里葉梅林變換分別將圖像配準(zhǔn)擴(kuò)展到了旋轉(zhuǎn)、平移、縮放等情況,但這些方法處理平坦地形時(shí)獲得的正確匹配點(diǎn)較少,匹配效果不佳。因此 ,本文提出了一種基于計(jì)算機(jī)視覺(jué)顧及地形梯度特征的時(shí)序影像匹配方法,已應(yīng)用于自然資源資產(chǎn)清查工作中,并取得了良好效果。

1 基于視野感知的CNN-SIFT描述符

1.1 視野感知區(qū)域劃分

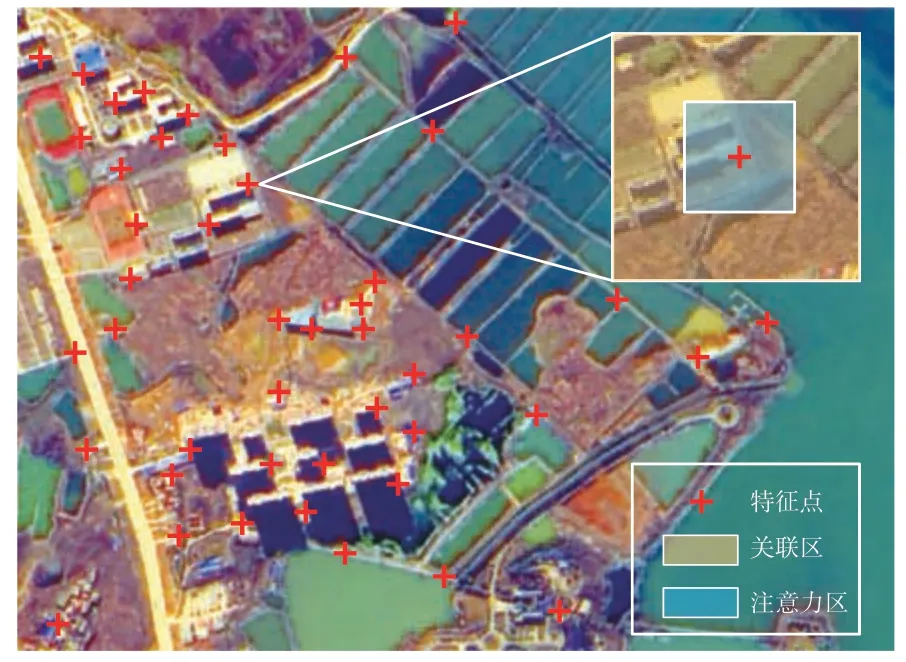

視覺(jué)對(duì)特征定位和特征描述具有先天優(yōu)勢(shì),首先關(guān)注大范圍場(chǎng)景(中高級(jí)語(yǔ)義)信息,視野感知范圍大、信息量多,形成高級(jí)語(yǔ)義;然后隨著注意力集中、視野縮小,信息密度降低,形狀、位置等低級(jí)特征形成區(qū)域的主要描述[6]。高級(jí)語(yǔ)義與低級(jí)語(yǔ)義相結(jié)合形成完整的視覺(jué)描述,CNN提取高級(jí)語(yǔ)義,SIFT獲取低級(jí)語(yǔ)義,語(yǔ)義融合形成視覺(jué)的CNN-SIFT描述符。以時(shí)序影像同名點(diǎn)對(duì)描述為例,同名點(diǎn)對(duì)提取是空間場(chǎng)景信息(中高級(jí)特征信息)和內(nèi)部結(jié)構(gòu)信息(梯度信息)綜合比對(duì)衡量的結(jié)果。受視野感知的啟發(fā),特征點(diǎn)區(qū)域分為注意力區(qū)和關(guān)聯(lián)區(qū),如圖1所示。其中,CNN提取關(guān)聯(lián)區(qū)的高級(jí)特征,SIFT提取注意力區(qū)的局部特征,再根據(jù)不同的感受野進(jìn)行自適應(yīng)權(quán)重分配,以提高描述符在影像匹配中的能力。

圖1 視野感知區(qū)域劃分示意圖

1.2 CNN-SIFT描述符結(jié)構(gòu)設(shè)計(jì)

深層次孿生網(wǎng)絡(luò)能根據(jù)樣本相似性標(biāo)簽訓(xùn)練,分支網(wǎng)絡(luò)可作為特征提取器單獨(dú)使用。本文設(shè)計(jì)了一個(gè)時(shí)序影像特征提取的孿生網(wǎng)絡(luò)感知模型,用于提取魯棒的影像神經(jīng)網(wǎng)絡(luò)相似度特征。

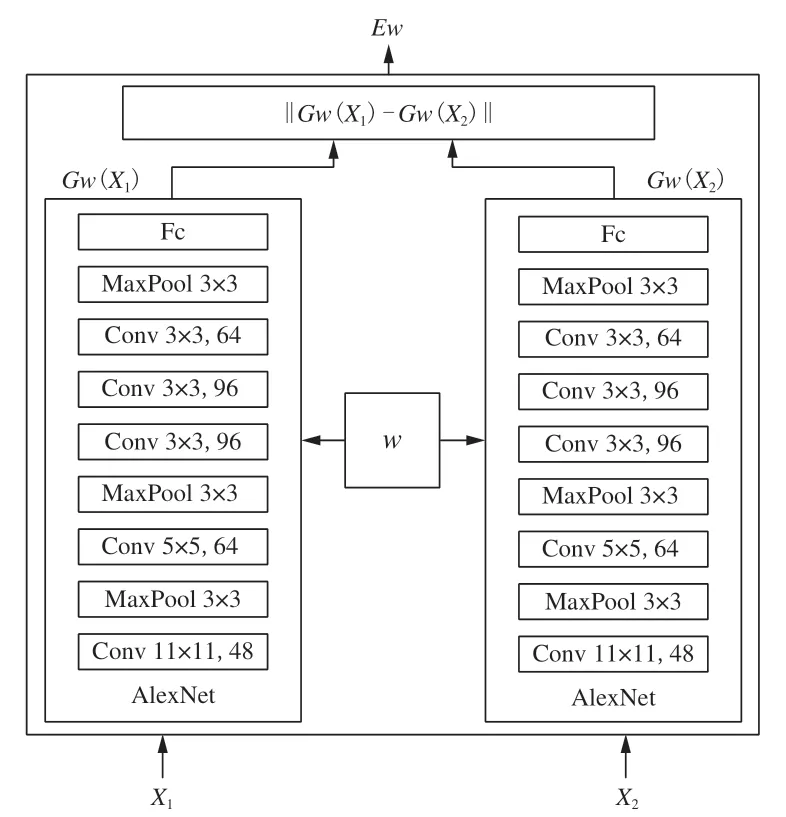

1.2.1 孿生網(wǎng)絡(luò)視野特征結(jié)構(gòu)

孿生網(wǎng)絡(luò)構(gòu)建結(jié)構(gòu)相似的雙重分支網(wǎng)絡(luò),使正樣本相關(guān)性盡可能高,負(fù)樣本相關(guān)性盡可能低。本文選用AlexNET網(wǎng)絡(luò),如圖2所示,左右支路具有相同的網(wǎng)絡(luò)結(jié)構(gòu),并共享權(quán)值。根據(jù)對(duì)應(yīng)匹配特性將樣本影像塊分為正、負(fù)樣本,正樣本代表對(duì)應(yīng)特征點(diǎn)的時(shí)序影像塊,負(fù)樣本代表誤匹配或隨機(jī)分配影像塊。加入激活函數(shù)非線性單元,使該神經(jīng)網(wǎng)絡(luò)能進(jìn)行有效的深度特征學(xué)習(xí),實(shí)現(xiàn)非線性特征映射。對(duì)比度損失函數(shù)使訓(xùn)練中負(fù)樣本距離度量增加,正樣本距離度量降低。在測(cè)試過(guò)程中,選取RGB局部影像塊樣本X1、X2分別輸入分支網(wǎng)絡(luò),再采用分支網(wǎng)絡(luò)特征Gw(X1)、Gw(X2)的相似性度量創(chuàng)建損失函數(shù),并利用歐氏距離判別,分支網(wǎng)絡(luò)的結(jié)構(gòu)參數(shù)與傳統(tǒng)的AlexNet參數(shù)相似。卷積層后加入采用雙曲正切單元(Tanh)的激活層,通過(guò)全連接層控制分支網(wǎng)絡(luò)提取的特征維數(shù)。

圖2 孿生網(wǎng)絡(luò)結(jié)構(gòu)示意圖

1.2.2 SIFT特征分析

SIFT匹配后仍有大量錯(cuò)誤匹配點(diǎn)對(duì),且經(jīng)過(guò)模糊處理和降采樣后提取的平坦地區(qū)匹配點(diǎn)較少,為了得到精確匹配點(diǎn)集,通常采用GMS、RANSAC等方法進(jìn)行二次篩選。GMS基于正確匹配點(diǎn)附近存在較多匹配點(diǎn)支持的思想,認(rèn)為匹配后每個(gè)匹配點(diǎn)鄰域內(nèi)匹配點(diǎn)數(shù)超過(guò)閾值則為匹配正確,此時(shí)梯度平坦地區(qū)的匹配點(diǎn)會(huì)因分布稀疏而被剔除。RANSAC算法則從初始點(diǎn)集中隨機(jī)選取內(nèi)點(diǎn)擬合數(shù)學(xué)模型,其余點(diǎn)作為驗(yàn)證,符合模型則加入內(nèi)點(diǎn),迭代后選擇內(nèi)點(diǎn)最多的模型。該方法沒(méi)有考慮點(diǎn)的空間分布,平坦地區(qū)匹配點(diǎn)由于數(shù)量少被選為初始內(nèi)點(diǎn)的概率較小,且因沒(méi)有相似點(diǎn)支持而被淘汰。這些算法容易漏掉平坦地區(qū)的匹配點(diǎn),不能全面反映地形總體特征;且目前已有的低、高級(jí)特征融合描述符局限于固定權(quán)重比[7-8],限制了匹配精度的提高。因此,本文提出了基于視覺(jué)感知的孿生網(wǎng)絡(luò)與顧及梯度的SIFT自適應(yīng)融合描述符,能增加平坦地區(qū)的匹配點(diǎn),實(shí)現(xiàn)精確高效的時(shí)序影像匹配。

1.2.3 自適應(yīng)權(quán)重分配策略

CNN-SIFT描述符的構(gòu)建采用了神經(jīng)網(wǎng)絡(luò)特征與SIFT描述符的加權(quán)融合策略,注意力區(qū)提供低級(jí)特征信息,關(guān)聯(lián)區(qū)提供中高級(jí)特征信息。

SIFT算法在差分金字塔層間檢測(cè)極值點(diǎn),在對(duì)應(yīng)的高斯金字塔影像上構(gòu)建描述符。本文采取4×4的鄰域構(gòu)建描述符[9],每個(gè)子區(qū)域的半徑為3σ_oct,對(duì)應(yīng)的表達(dá)式為:

式中,S為子層數(shù);s為高斯金字塔影像所在的層數(shù)。

針對(duì)不同尺度的特征點(diǎn),其映射在原圖上的范圍為D×D。D的表達(dá)式為:

式中,0為金字塔的組數(shù)。

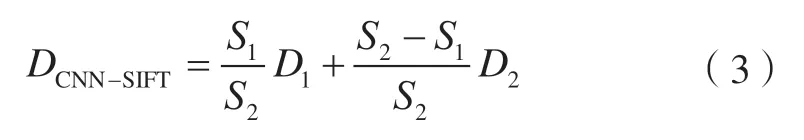

本文將注意力區(qū)與關(guān)聯(lián)區(qū)的面積比值作為描述子加權(quán)融合的權(quán)值。不同SIFT特征點(diǎn)所在的尺度空間不同,因此其映射在原圖的范圍也不同。本文根據(jù)特征點(diǎn)尺度自適應(yīng)設(shè)定動(dòng)態(tài)權(quán)值,CNN-SIFT描述符可表示為:

式中,S1為SIFT特征點(diǎn)映射的原圖面積;S2為神經(jīng)網(wǎng)絡(luò)樣本面積;D1為SIFT描述符;D2為CNN描述符。若SIFT映射區(qū)域大于CNN提取區(qū)域,則以CNN特征作為最終的CNN-SIFT特征。

1.3 樣本數(shù)據(jù)集的構(gòu)建方法

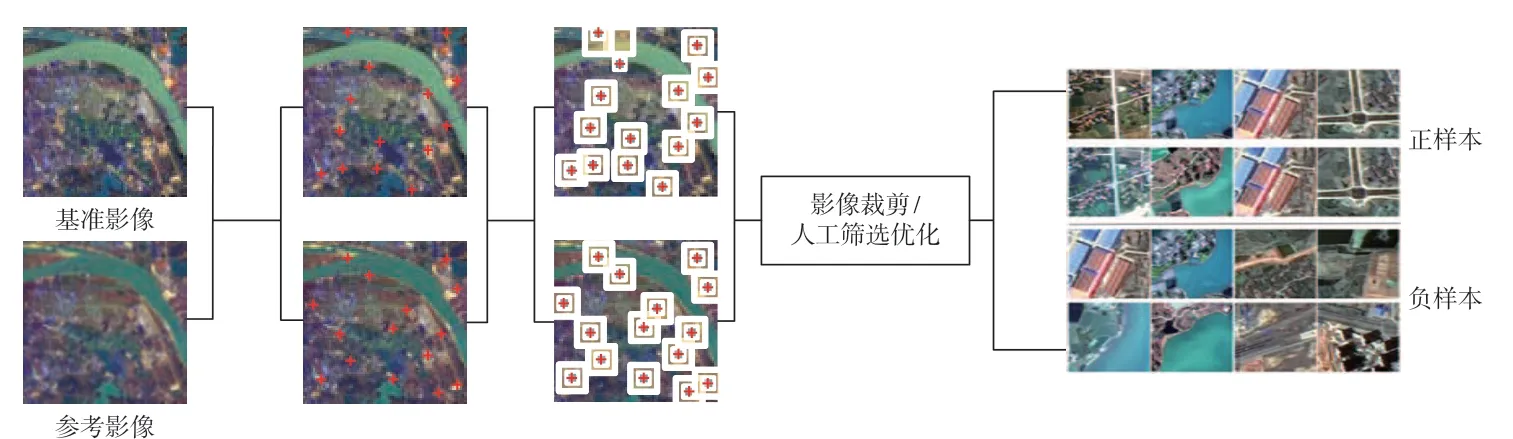

神經(jīng)網(wǎng)絡(luò)模型的學(xué)習(xí)能力依賴于訓(xùn)練數(shù)據(jù)集的質(zhì)量和數(shù)量[9],構(gòu)建準(zhǔn)確、可分的樣本集是模型擬合的 關(guān)鍵。本文選取時(shí)序影像構(gòu)建初始正負(fù)樣本集,如圖3所示,首先檢測(cè)時(shí)序影像特征點(diǎn),構(gòu)建特征描述符,并采用空間位置自適應(yīng)分塊策略處理影像;然后選取雙向最鄰近匹配策略匹配影像塊,正樣本由匹配的特征點(diǎn)對(duì)裁剪影像塊構(gòu)成,負(fù)樣本由正樣本打亂后非同名特征點(diǎn)對(duì)的影像塊構(gòu)成,正負(fù)樣本比例為1∶1;最后通過(guò)人工二次篩選保證樣本集的正確性。

圖3 樣本集制作流程圖

2 基于CNN-SIFT的視野感知模型匹配方法

首先分別對(duì)輸入的基準(zhǔn)影像和參考影像進(jìn)行SIFT特征點(diǎn)位提取,并根據(jù)輸入影像尺寸與SIFT相應(yīng)保留N個(gè)特征點(diǎn)位;再對(duì)特征點(diǎn)位計(jì)算SIFT描述符,提取局部影像塊,并將影像塊輸入對(duì)應(yīng)分支網(wǎng)絡(luò)進(jìn)行CNN特征提取,N的取值決定了CNN視野范圍;然后對(duì)SIFT特征與CNN特征進(jìn)行基于空間注意力模型的自適應(yīng)權(quán)值融合,構(gòu)建完整的CNN-SIFT描述符;最后將特征點(diǎn)對(duì)應(yīng)的CNN-SIFT描述符輸入描述符匹配器(最鄰近搜索庫(kù))中進(jìn)行匹配,并根據(jù)匹配點(diǎn)選取影像轉(zhuǎn)換模型,進(jìn)行影像匹配。雖然描述符描述能力的提升減少了誤匹配率,增加了匹配點(diǎn)位的個(gè)數(shù),但仍存在異常點(diǎn)位。因此,本文對(duì)CNN-SIFT描述符獲取的初始匹配結(jié)果進(jìn)行優(yōu)化,根據(jù)CNN-SIFT描述符進(jìn)行一階多項(xiàng)式擬合誤差分析,迭代刪除單點(diǎn)誤差較大的特征點(diǎn);并以“橫縱掃描線”的思想分析偏移點(diǎn)位的灰度曲線特征,增加點(diǎn)集中的可用點(diǎn)。對(duì)于高分辨率遙感影像匹配來(lái)說(shuō),均勻分布的特征點(diǎn)是保證影像匹配質(zhì)量的前提條件[7]。基于格網(wǎng)劃分的思想,本文在影像單個(gè)網(wǎng)格內(nèi)利用圖像信息熵、特征點(diǎn)與格網(wǎng)中心的歐式距離進(jìn)行綜合評(píng)判,以保留網(wǎng)格內(nèi)的最優(yōu)特征點(diǎn),改善點(diǎn)集的空間分布。

3 實(shí)驗(yàn)結(jié)果與分析

3.1 實(shí)驗(yàn)數(shù)據(jù)

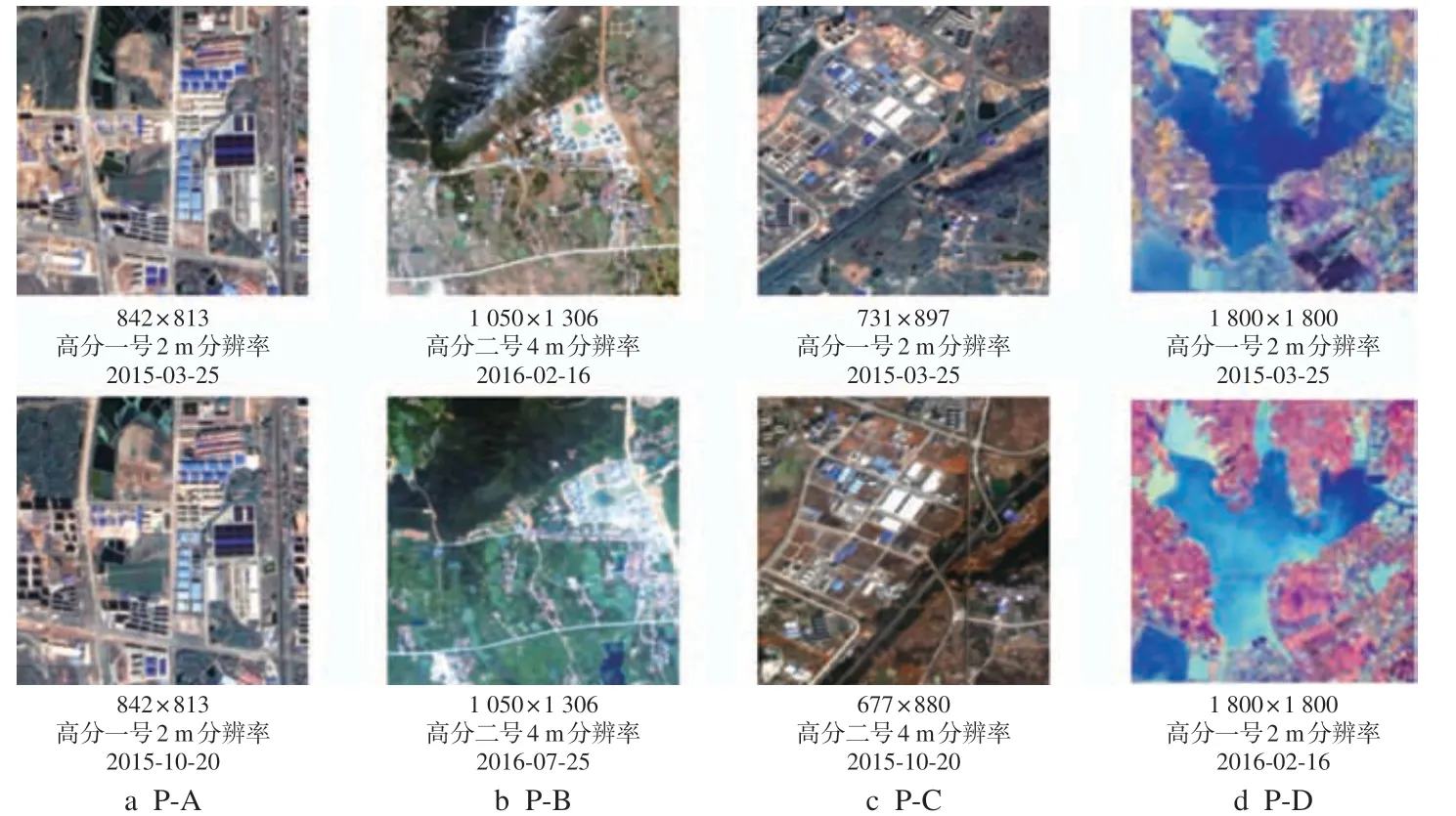

1)SIFT-PATCH訓(xùn)練數(shù)據(jù)集。為了驗(yàn)證CNN-SIFT描述符在影像匹配中的有效性以及視野擴(kuò)張的效果,本文基于2 m分辨率的全色影像和8 m分辨率的多光譜影像,制作了128×128、180×180、256×256三個(gè)SIFT-PATCH數(shù)據(jù)集,覆蓋建筑、農(nóng)田、道路、水域等典型地物,如圖4所示,顧及時(shí)序影像水色變化,加入了多水色的正負(fù)樣本。本文采用樣本尺度、旋轉(zhuǎn)、亮度變化等方法提高網(wǎng)絡(luò)能力,得到增強(qiáng)后的網(wǎng)絡(luò)訓(xùn)練集,樣本數(shù)量為20萬(wàn),正負(fù)樣本各占一半。

2)測(cè)試數(shù)據(jù)。本文選取4組影像數(shù)據(jù)驗(yàn)證CNNSIFT的魯棒性,分別記為P-A、P-B、P-C、P-D,具體參數(shù)如圖4所示。

圖4 實(shí)驗(yàn)影像數(shù)據(jù)

3.2 實(shí)驗(yàn)環(huán)境

實(shí)驗(yàn)采用Intel Xeon Scalable Silver 4210 CPU和Nvidia RTX 2080Ti服務(wù)器,神經(jīng)網(wǎng)絡(luò)在深度學(xué)習(xí)平臺(tái)Tensorflow上進(jìn)行訓(xùn)練。

3.3 評(píng)價(jià)指標(biāo)

本文采用均方根誤差、正確匹配點(diǎn)對(duì)數(shù)、正確匹配率和同名點(diǎn)覆蓋度進(jìn)行評(píng)價(jià)。

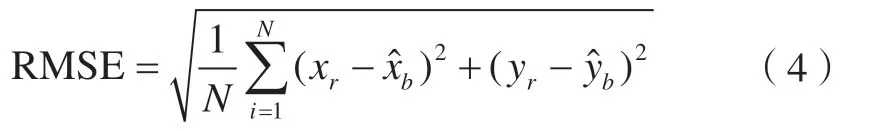

均方根誤差用以衡量影像配準(zhǔn)控制點(diǎn)的精準(zhǔn)度。其計(jì)算公式為:

式中,(x r,yr)為待匹配影像特征點(diǎn)坐標(biāo);為基準(zhǔn)影像特征點(diǎn)根據(jù)多項(xiàng)式模型預(yù)測(cè)的點(diǎn)坐標(biāo);N為匹配點(diǎn)數(shù)量。

正確匹配點(diǎn)對(duì)數(shù)為單點(diǎn)均方根值小于一定閾值(本文選取兩像素為有效閾值)的匹配點(diǎn)對(duì)數(shù)量,是限制匹配精度的關(guān)鍵因素,證明了描述符的魯棒性以及匹配策略中幾何約束的正確性。

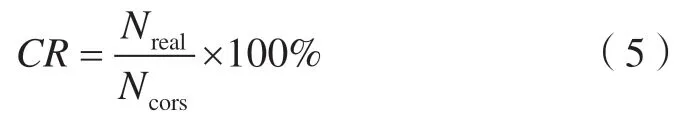

正確匹配率用以評(píng)價(jià)描述符的穩(wěn)定性,其值越高,描述符描述能力越強(qiáng),計(jì)算公式為:

式中,CR為正確匹配率;Nreal為匹配結(jié)果中正確匹配點(diǎn)對(duì)數(shù)量;Ncors為所有匹配點(diǎn)對(duì)數(shù)量。

同名點(diǎn)覆蓋度[8]用以評(píng)價(jià)匹配點(diǎn)對(duì)的均勻分布情況,計(jì)算公式為:

式中,N為匹配區(qū)域被劃分的網(wǎng)格數(shù);Nmatch為存在特征點(diǎn)的網(wǎng)格數(shù)。

3.4 基于視野感知的CNN-SIFT描述符實(shí)驗(yàn)

3.4.1 神經(jīng)網(wǎng)絡(luò)特征維度對(duì)比實(shí)驗(yàn)

基于SIFT-PATCH數(shù)據(jù)集,通過(guò)對(duì)比實(shí)驗(yàn),綜合描述符在后期匹配中的檢索速度,本文選取神經(jīng)網(wǎng)絡(luò)全連接層特征維度為128維。

3.4.2 CNN-SIFT自適應(yīng)權(quán)重評(píng)價(jià)實(shí)驗(yàn)

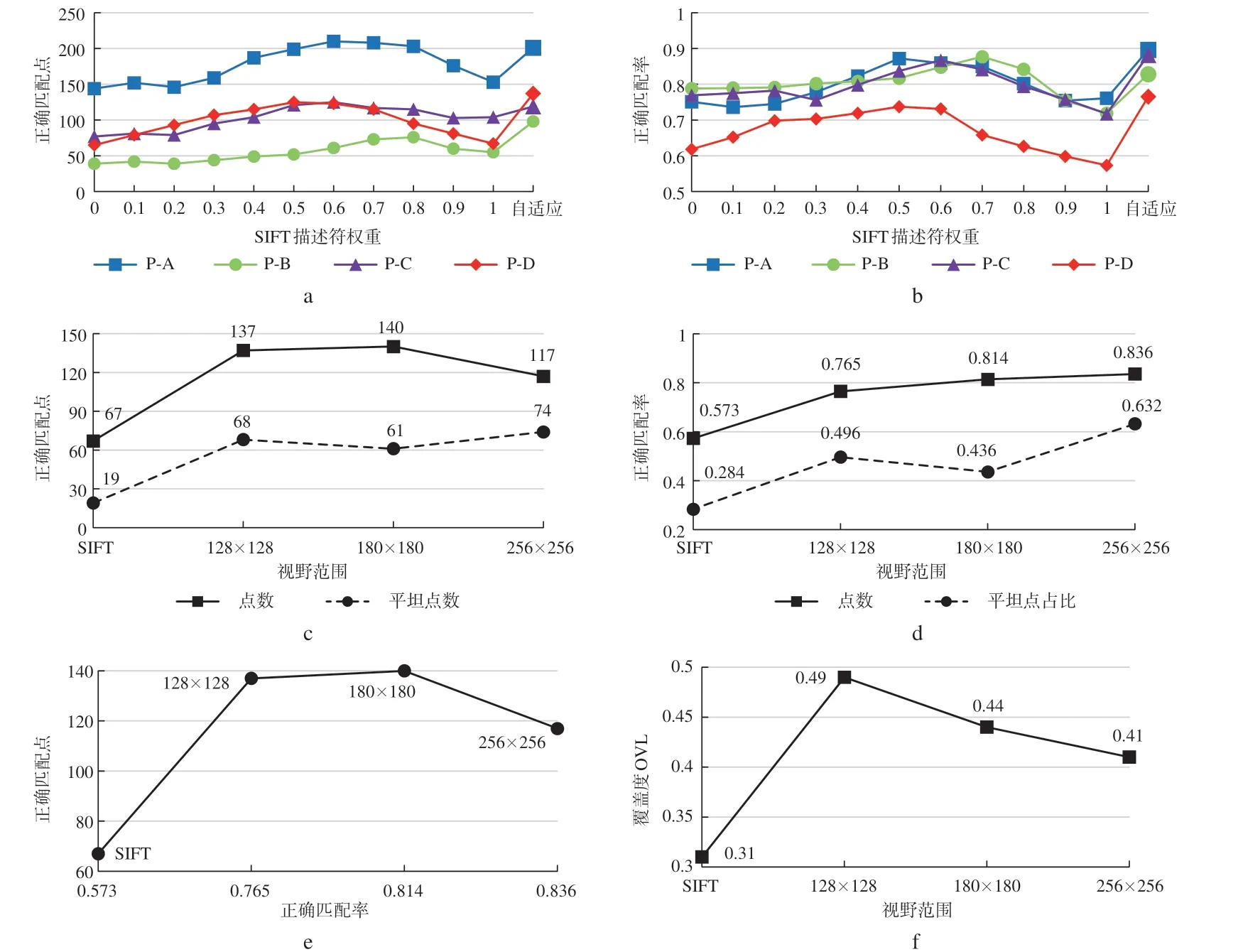

CNN-SIFT描述符是對(duì)CNN描述符和SIFT描述符的動(dòng)態(tài)加權(quán)融合,固定特征權(quán)重與自適應(yīng)權(quán)重的對(duì)比結(jié)果如圖5a、5b所示,其中特征權(quán)重比是指SIFT描述符占完整描述符的權(quán)重比例。實(shí)驗(yàn)結(jié)果表明,不同特征影像的特征權(quán)重比最優(yōu)區(qū)間不同,固定特征權(quán)重的描述符難以適應(yīng)復(fù)雜地形,而自適應(yīng)權(quán)重策略則可通過(guò)權(quán)重的調(diào)整,利用SIFT描述符保證位置的精確度,利用CNN描述符保證匹配的準(zhǔn)確率,使匹配結(jié)果始終處于最優(yōu)范圍區(qū)間。

圖5 CNN-SIFT權(quán)值分配和視野擴(kuò)張對(duì)比實(shí)驗(yàn)圖

3.4.3 視野擴(kuò)張對(duì)比實(shí)驗(yàn)

特征點(diǎn)SIFT描述符在平坦地區(qū)梯度特征相似,誤匹配率較高;然而隨著視野擴(kuò)張,描述符中包含田埂和岸線等輪廓特征時(shí),視覺(jué)特征可分性大幅提高。CNN-SIFT描述符處理富含水域的P-D組影像時(shí),選取視野128×128、180×180、256×256的關(guān)聯(lián)區(qū)范圍進(jìn)行實(shí)驗(yàn),以驗(yàn)證視野對(duì)影像匹配的影響。實(shí)驗(yàn)結(jié)果如圖5c~5f所示,可以看出,單純的湖泊水體可供描述符提取的特征有限;但隨著視野關(guān)聯(lián)區(qū)面積的增大,可提取的差異特征增多,正確匹配率上升。綜合正確點(diǎn)數(shù)量、正確匹配率以及覆蓋度的變化規(guī)律,本文選擇180×180為最優(yōu)視野范圍。

3.5 匹配實(shí)驗(yàn)結(jié)果與分析

本文在P-A、P-B、P-C、P-D四組影像上選取SIFT描述符、CNN描述符(視野128×128)、CNNSIFT描述符(視野180×180)進(jìn)行對(duì)比實(shí)驗(yàn);采用正確匹配點(diǎn)對(duì)數(shù)和正確匹配率作為評(píng)判匹配能力的指標(biāo),以分析描述符結(jié)構(gòu)和地形特征對(duì)正確匹配的影響;利用覆蓋度和算法耗時(shí)來(lái)評(píng)價(jià)SIFT、CNN和CNN-SIFT描述符的匹配質(zhì)量和性能。

3.5.1 描述符內(nèi)部結(jié)構(gòu)對(duì)匹配的影響

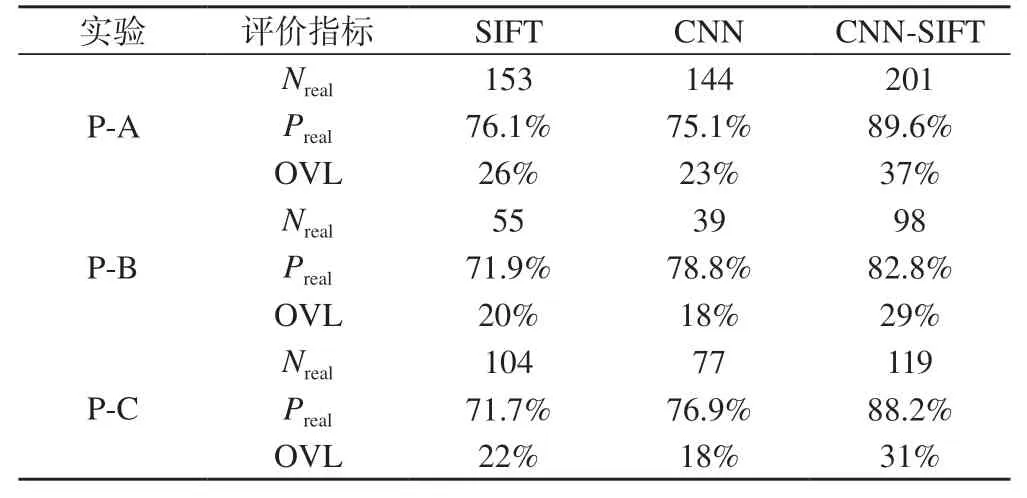

P-A、P-B、P-C三組實(shí)驗(yàn)的具體結(jié)果如表1所示,可以看出,與SIFT描述符相比,CNN-SIFT描述符的正確匹配點(diǎn)對(duì)數(shù)平均增加了41.32%,正確匹配率增加了13.63%。

表1 各分辨率影像匹配結(jié)果表

在正確匹配點(diǎn)對(duì)數(shù)量方面,CNN-SIFT描述符匹配點(diǎn)對(duì)最多,SIFT次之,CNN最少。CNN描述符受限于網(wǎng)絡(luò)池化,神經(jīng)網(wǎng)絡(luò)提供特征點(diǎn)區(qū)域大,范圍準(zhǔn)確性、精確定位能力弱。正樣本場(chǎng)景空間相似,負(fù)樣本區(qū)分度較高,空間位置相近的相似影像塊限制了神經(jīng)網(wǎng)絡(luò)的精確定位。CNN描述符為抽象層次的中高級(jí)特征,屬于匹配的強(qiáng)約束條件,為特征點(diǎn)提供局部范圍約束,能更準(zhǔn)確地定位特征點(diǎn)所在區(qū)域。SIFT描述符屬于梯度描述符,能反映小距離尺度的低級(jí)結(jié)構(gòu)特征,獲取空間距離相近的精確匹配點(diǎn)位。CNN-SIFT描述符融合了高級(jí)特征與低級(jí)特征,同時(shí)具有抽象的場(chǎng)景區(qū)分能力和鄰近點(diǎn)位判別能力,能始終保持匹配的正確性,獲取優(yōu)于CNN 描述符和SIFT 描述符的匹配結(jié)果。

在正確匹配率方面,SIFT描述符的正確匹配率偏低,存在一些局部特征相似但空間距離偏移量較大的點(diǎn)對(duì),說(shuō)明SIFT描述符的能力不足;CNN描述符在P-B與P-C中取得了優(yōu)于SIFT描述符的正確匹配率,在P-A 中略遜于SIFT描述符。其原因在于,在P-A 圖像對(duì)中,部分點(diǎn)位空間位置接近,CNN描述符獲得準(zhǔn)確的大范圍匹配區(qū)域后,小范圍內(nèi)具有多個(gè)點(diǎn)位,但CNN定位精度不足,導(dǎo)致匹配正確率下降;而P-B與P-C的特征點(diǎn)密度低于P-A,促使CNN的正確匹配率有一定提升。在3組實(shí)驗(yàn)中,CNN-SIFT描述符均獲得高于SIFT 描述符10%以上的正確匹配率。

3.5.2 平坦地形對(duì)匹配的影響

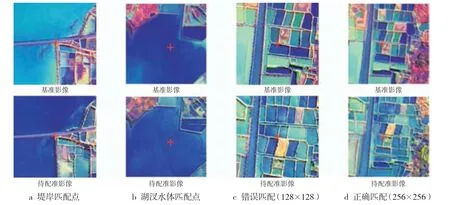

農(nóng)田和湖泊地區(qū)地勢(shì)平坦是影像匹配的難點(diǎn)[10],為了驗(yàn)證CNN-SIFT描述符在平坦地區(qū)的匹配能力,本文設(shè)計(jì)了P-D實(shí)驗(yàn)(平坦湖泊地區(qū)影像匹配),效果如圖6所示。隨著CNN-SIFT描述符視野范圍的擴(kuò)張,產(chǎn)生了湖泊輪廓的堤岸匹配點(diǎn)以及SIFT描述符也無(wú)法獲取的湖汊水體匹配點(diǎn)(圖6a、6b)。平坦匹配點(diǎn)的增加使得正確匹配點(diǎn)對(duì)數(shù)和匹配率大幅提升,與SIFT描述符相比,平坦地區(qū)匹配率提高了19.20%。CNN-SIFT描述符也存在少量誤匹配,如圖6c所示的平原區(qū)塊田匹配點(diǎn),其原因在于:①誤匹配特征點(diǎn)所在的高斯圖像尺度過(guò)大(過(guò)小),導(dǎo)致描述符權(quán)值過(guò)高,造成匹配;②存在特征相近的局部影像塊,使得描述符無(wú)法區(qū)分。通過(guò)擴(kuò)張視野能有效解決該問(wèn)題,如圖6d所示。

圖6 部分匹配結(jié)果實(shí)例圖

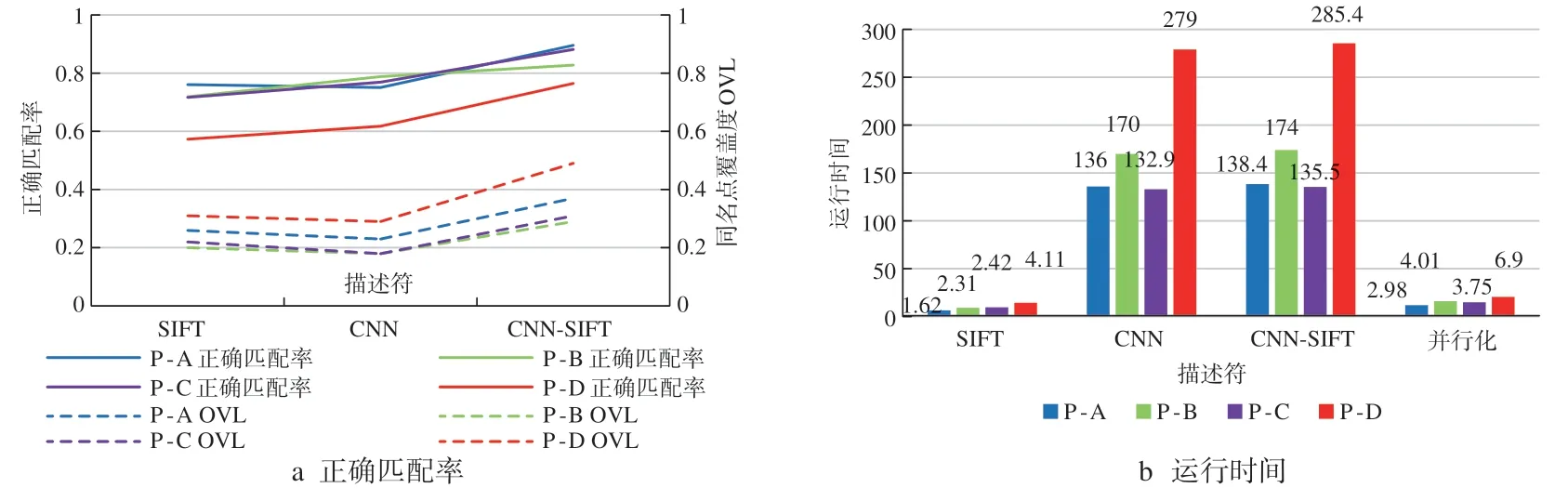

3.5.3 匹配質(zhì)量與性能分析

匹配點(diǎn)分布均勻是確保高質(zhì)量影像匹配的關(guān)鍵,同 名點(diǎn)覆蓋度定量表征了匹配點(diǎn)空間分布的均勻程度。CNN-SIFT描述符獲得了最高的同名點(diǎn)覆蓋度和正確匹配率,如圖7a所示,SIFT部分根據(jù)局部特征產(chǎn)生大量特征點(diǎn),CNN部分根據(jù)視覺(jué)可分抑制密度過(guò)高的重復(fù)匹配點(diǎn),二者自適應(yīng)融合能有效調(diào)劑匹配點(diǎn)的合理分布,使正確匹配點(diǎn)的平均同名點(diǎn)覆蓋度比SIFT描述符高9%以上。

神經(jīng)網(wǎng)絡(luò)描述符匹配的主要耗時(shí)為CNN計(jì)算,感受野越大,計(jì)算速度越慢,如圖7b所示。因此,自適應(yīng)的依區(qū)域地形梯度、并行分塊處理能顯著提升描述符匹配性能。本文改進(jìn)了單線程模式,GPU并行模式和多線程計(jì)算使資源得到充分利用,極大提升了CNNSIFT描述符影像匹配的效率,能滿足自然資源資產(chǎn)清查實(shí)際工作的要求。

圖7 影像匹配結(jié)果性能分析圖

4 結(jié) 語(yǔ)

本文構(gòu)建了基于視野感知的CNN-SIFT描述符,將影像特征提取轉(zhuǎn)換為相似度學(xué)習(xí),采用孿生網(wǎng)絡(luò)提取中高級(jí)特征,增強(qiáng)了描述符的視覺(jué)可分性,提高了時(shí)序影像正確匹配率。本文首先驗(yàn)證了CNN-SIFT描述符能涵蓋高中低級(jí)特征,正確匹配點(diǎn)數(shù)和匹配率均顯著優(yōu)于其他兩種描述符;然后驗(yàn)證了CNN-SIFT描述符的匹配能力,自適應(yīng)增強(qiáng)視野感知能有效處理平坦地形匹配的難點(diǎn)問(wèn)題;最后驗(yàn)證了CNN-SIFT描述符的匹配性能,同名點(diǎn)覆蓋度體現(xiàn)匹配質(zhì)量高, GPU分塊并行運(yùn)算解決了耗時(shí)瓶頸,綜合作用使得CNN-SIFT描述符性能全面優(yōu)于其他兩種描述符。描述符匹配能力來(lái)自于視覺(jué)可分的中高級(jí)特征和地形可分的梯度特征,CNN描述符在視野范圍較大時(shí)匹配率較高,SIFT描述符在地形復(fù)雜、梯度特征為主時(shí)匹配率較高,CNN-SIFT描述符依地形自適應(yīng)調(diào)整視野感知范圍和描述符權(quán)重,能同時(shí)提升影像正確匹配率與匹配速度。利用CNN-SIFT描述符匹配技術(shù)制作的高分辨遙感影像能滿足全民所有自然資源資產(chǎn)清查實(shí)際工作的要求,為其他衛(wèi)星影像進(jìn)行大范圍批量正射影像生產(chǎn)提供借鑒。