改進的YOLOv3睺iny網絡在風機葉片損傷檢測中的應用

武宇平,劉海旭,吳勁芳,賈洪巖,刁嘉,朱董軍

摘要:為了解決YOLOv3-Tiny對無人機采集的風機葉片圖像損傷檢測精度不高的問題,提出一種基于深度學習的風機葉片圖像損傷檢測方法。首先提出一種跨越式特征聯合網絡結構,由卷積層和拼接層構成,將不同深度的特征信息進行融合再學習,提取目標多層級特征信息;其次引入Inception模塊結構,其中4個平行通道的多個卷積核對輸入的特征圖進行組合和壓縮,在減少網絡的學習參數的同時更好地表征圖像特征信息,提高小目標的檢測精度。實驗表明,改進后算法的檢測精度提高了2.69%,在自制的數據集中mAP可以達到88.58%,并且模型的參數縮小了4倍。因此,改進的方法比傳統的YOLOv3-Tiny網絡具有更好的檢測效果。研究結果可為基于圖像的損傷檢測和風機葉片損傷智能識別提供參考。

關鍵詞:計算機神經網絡;缺陷檢測;深度學習;風機葉片;YOLOv3-Tiny

中圖分類號:TP391文獻標識碼:ADOI: 10.7535/hbgykj.2021yx05008

Application of improved YOLOv3-Tiny network

in fan blade damage detection

WU Yuping,LIU Haixu,WU Jinfang,JIA Hongyan,DIAO Jia,ZHU Dongjun

(Zhangjiakou Wind and Solar Power Energy Demonstration Station Company Limited.,State Grid Xin Yuan Company,Equipment Maintenance Center,Zhangjiakou,Hebei 075000,China)

Abstract:In order to solve the low precision of damage detection using YOLOv3-Tiny network for UAV collected fan blade images,a deep learning-based damage detection algorithm was proposed.Firstly,a leaping feature joint network structure was proposed,which was composed of a convolutional layer and a splicing layer.The feature information of different depths was fused and learned to extract the information of the target multi-level feature.Secondly,the inception module structure was introduced,and the input feature maps were compressed by multiple convolution kernels with 4 parallel channels,which reduced the learning parameters of the network and better characterized the image feature information.Then the detection accuracy of small targets was improved.Experiments show that the detection accuracy of the improved algorithm is increased by 2.69%,the mAP reaches 88.58% in the self-made dataset,and the parameters of the model are reduced by 4 times.The detect precision of this method is better than that of YOLOv3-Tiny network in the task of wind turbine blade damage detection.The results provide reference for image-based damage detection and intelligent identification work of fan blade damage.

Keywords:computer neural network;defect detection;deep learning;fan blade;YOLOv3-Tiny

隨著風能等清潔能源的發展,風力發電設備越來越普遍,但是由于風機設備所處的環境復雜、變化多樣,以及風機自身的應力耦合作用,極易發生故障和損壞[1]。為了保障風機葉片的正常運行,提高經濟效益,風機葉片缺陷檢測的質量越來越受到重視。隨著人工智能的發展,智能化檢測更加快速、便捷。利用無人機采集風機葉片的影像信息,并對采集到的信息進行算法檢測,可以快速有效地識別葉片的損傷部位,達到節省人力、物力、財力的效果。

要想精準地檢測到風機葉片損傷部位,首先必須了解風機葉片的缺陷成因以及損傷種類。除了生產葉片過程中的質量損傷外,引發風機葉片缺陷的外部因素還有很多。例如,在安裝風機葉片的過程中,由于其體積大、結構復雜,易受到外力擠壓而損壞;另外,風機葉片所處的外部環境復雜且變化多樣,受風沙、雨水、結冰[2]的侵蝕,以及外力的沖擊,導致風機葉片出現裂縫缺陷、斷裂和老化[3]等損壞形式。

顧桂梅等[4]利用果蠅優化算法結合SVM進行損傷識別,但是對環境的魯棒性較差;張超等[5]提出一種改進的Mask R-CNN方法,在提高檢測精度的同時也提高了檢測速度,但是仍然存在檢測速度較慢的問題;曹錦綱等[6]提出一種利用RPCA和視覺顯著性方法,考慮超像素的空間關系,檢測葉片表面缺陷,但是超像素對于微小缺陷的分割效果欠佳;劉艷霞等[7]提出一種利用遷移學習的方法進行裂縫識別,雖然提高了訓練速度,但是需要大量的裂縫圖片進行預先訓練;顧桂梅等[8]采用深度信念網絡提取風機葉片結構模態參數來識別葉片結構損傷,但是該方法不適用于戶外復雜環境的檢測;毛希瑋等[9]提出一種利用無人機技術結合彩色閾值處理技術和形態學方法進行缺陷檢測,但是該方法對環境的魯棒性較差;賀斌等[10]、趙春溢等 [11]介紹了無人機在風機葉片檢測中具有操作簡單、維修方便、效率高等優點。

基于深度學習的方法在圖像目標檢測中越來越受歡迎,利用深度學習的目標檢測技術一般分為2種:一種是Two-stage方法,先生成目標的候選框,再對候選框進行分類;另一種是One-stage方法,即直接檢測到目標并進行識別分類[12]。

Two-stage的目標檢測算法通常識別錯誤率低,漏識別率也較低,但是由于網絡層數的加深以及Two-stage作用,導致測試圖片的速度較低。R-CNN[13],Fast R-CNN[14],以及Faster R-CNN[15]均不能達到實時檢測要求。One-stage的目標檢測算法以YOLO系列和SSD為代表,One-stage的算法經過單次檢測就可以直接產生物體的坐標位置和類別概率值,得到最終的結果,因此One-stage算法有著更快的檢測速度。YOLO算法從YOLOv1到YOLOv4[16-19],模型越來越小,在公開數據集coco上的mAP值也依次提升。SSD網絡采取One-stage的思想[20],網絡中融入了Faster R-CNN中的anchors思想,并且對特征進行分層提取由此可以適應多種尺度目標的訓練和檢測任務。

傳統的風機葉片檢測方法對于實際場景中多變的復雜環境檢測的魯棒性較差,現有的深度學習算法通常對環境具有良好的魯棒性,目標檢測效果較好[21],但是隨著網絡深度的加深其檢測速度也會降低。本文針對原YOLOv3-Tiny檢測精度不高的問題,提出一種新的骨干網絡,旨在利用較少的參數達到更高的檢測精度,在提升模型精度的同時提高檢測速度。

1YOLOv3-Tiny網絡檢測原理

YOLOv3-Tiny是YOLOv3網絡的簡化版本[18],相比于YOLOv3具有參數少、速度快的特點。YOLOv3-Tiny網絡的輸入圖片的大小是固定的,一般為416×416,經過主干網絡對輸入圖片進行深度特征提取,獲得圖像信息深層次的多尺度特征,在13×13和26×26的特征圖上進行多尺度預測。YOLOv3-Tiny的網絡結構比較簡單同時速度也快,易于移植到嵌入式設備中,但其缺點是網絡的識別精度也相應下降。

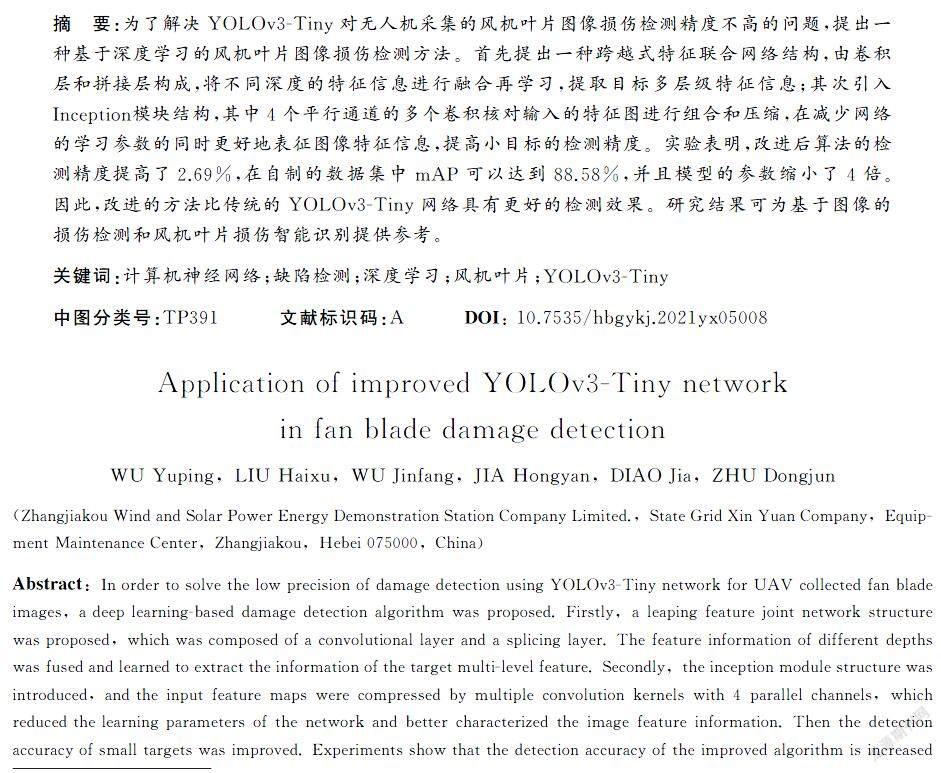

YOLOv3-Tiny利用卷積神經網絡來進行端到端的檢測,將整個圖片分成S×S個區域并逐區域檢測。每次檢測時有4個坐標參數,分別是預測框中心坐標(x,y)、寬度w、高度h和一個置信度。圖1中每個邊界框用(x,y)表示選框中心相對于單元格的坐標,w和h分別表示邊界框的寬度和高度,IoU表示算法預測框與真實框的交并比,用式(1)來表示。其中Bop表示預測框,Bgt表示真實框,IoU的值就相當于預測框區域與真實框區域重疊的部分除以2個部分集合得出的結果。

IoU=area(Bop∩Bgt)area(Bop∪Bgt)。(1)

算法得出一個目標的邊界框通常有很多,需要經過過濾。假設YOLO有M個檢測層,每個檢測層有B個anchor box(圖1中為3個),每個檢測層都要對每個網格進行檢測,最終一幅圖片會得到S×S×M×B個檢測框。但是通常希望最后看到一個目標只對應一個檢測框,于是YOLOv3使用了非極大值抑制算法來抑制多余的檢測框,用式(2)表示,使得每個檢測目標只顯示一個檢測框。

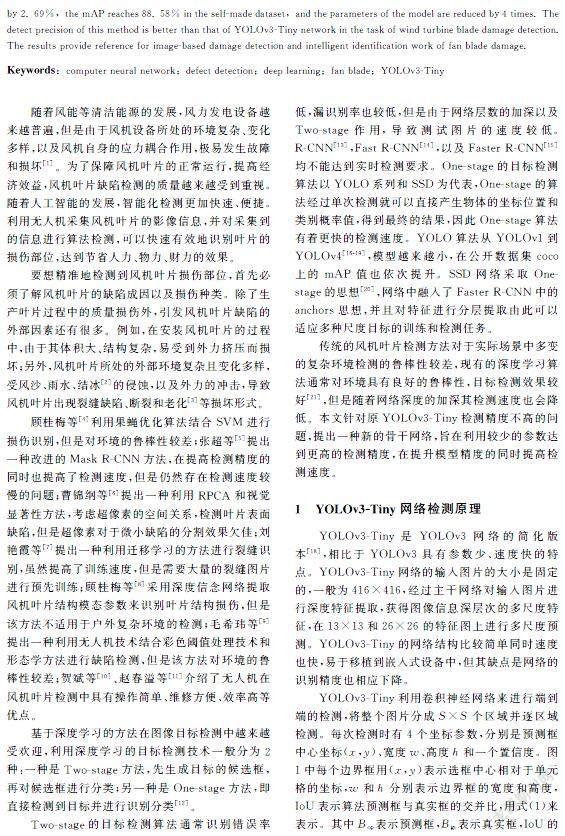

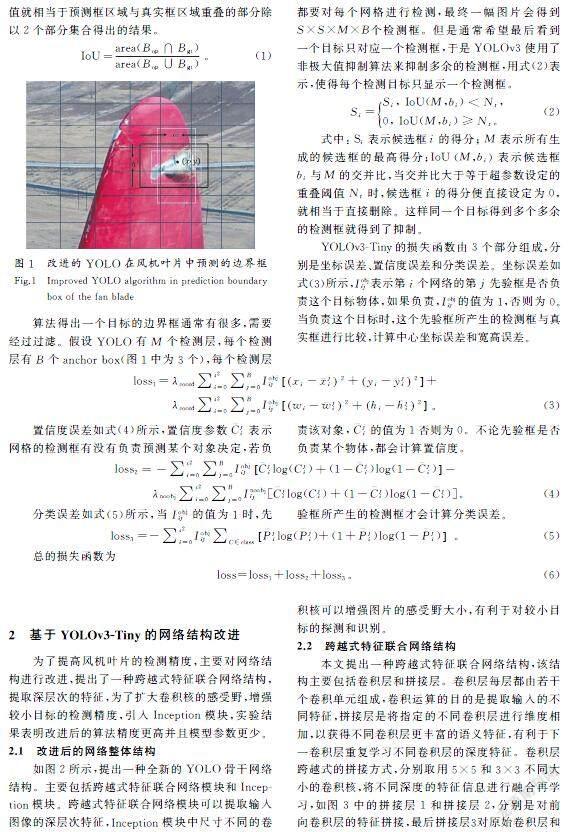

Si=Si, IoU(M,bi) 0, IoU(M,bi)≥Nt。(2) 式中:Si表示候選框i的得分;M表示所有生成的候選框的最高得分;IoU(M,bi)表示候選框bi與M的交并比,當交并比大于等于超參數設定的重疊閾值Nt時,候選框i的得分便直接設定為0,就相當于直接刪除。這樣同一個目標得到多個多余的檢測框就得到了抑制。 YOLOv3-Tiny的損失函數由3個部分組成,分別是坐標誤差、置信度誤差和分類誤差。坐標誤差如式(3)所示,Iobjij表示第i個網絡的第j先驗框是否負責這個目標物體,如果負責,Iobjij的值為1,否則為0。當負責這個目標時,這個先驗框所產生的檢測框與真實框進行比較,計算中心坐標誤差和寬高誤差。loss1=λcoord∑s2i=0∑Bj=0Iobjijxi-x-ji2+yi-y-ji2+ λcoord∑s2i=0∑Bj=0Iobjijwi-w-ji2+hi-h-ji2。(3) 置信度誤差如式(4)所示,置信度參數C-ji表示網格的檢測框有沒有負責預測某個對象決定,若負責該對象,C-ji的值為1否則為0。不論先驗框是否負責某個物體,都會計算置信度。loss2=-∑s2i=0∑Bj=0IobjijC-jilog(Cji)+(1-C-ji)log(1-C-ji)- λnoobj∑s2i=0∑Bj=0Inoobjij[C-jilog(Cji)+(1-C-ji)log(1-C-ji)]。(4) 分類誤差如式(5)所示,當Iobjij的值為1時,先驗框所產生的檢測框才會計算分類誤差。loss3=-∑s2i=0Iobjij∑C∈classP-jilog(P-ji)+(1+P-ji)log(1-P-ji)。(5) 總的損失函數為 loss=loss1+loss2+loss3。(6) 2基于YOLOv3-Tiny的網絡結構改進 為了提高風機葉片的檢測精度,主要對網絡結構進行改進,提出了一種跨越式特征聯合網絡結構,提取深層次的特征,為了擴大卷積核的感受野,增強較小目標的檢測精度,引入Inception模塊,實驗結果表明改進后的算法精度更高并且模型參數更少。 2.1改進后的網絡整體結構 如圖2所示,提出一種全新的YOLO骨干網絡結構。主要包括跨越式特征聯合網絡模塊和Inception模塊。跨越式特征聯合網絡模塊可以提取輸入圖像的深層次特征,Inception模塊中尺寸不同的卷積核可以增強圖片的感受野大小,有利于對較小目標的探測和識別。 2.2跨越式特征聯合網絡結構 本文提出一種跨越式特征聯合網絡結構,該結構主要包括卷積層和拼接層。卷積層每層都由若干個卷積單元組成,卷積運算的目的是提取輸入的不同特征,拼接層是將指定的不同卷積層進行維度相加,以獲得不同卷積層更豐富的語義特征,有利于下一卷積層重復學習不同卷積層的深度特征。卷積層跨越式的拼接方式,分別取用5×5和3×3不同大小的卷積核,將不同深度的特征信息進行融合再學習,如圖3中的拼接層1和拼接層2,分別是對前向卷積層的特征拼接,最后拼接層3對原始卷積層和 拼接層2再進行拼接。第一層中的base layer可以是網絡中的任意層,該結構可以連接到網絡中的任意層之后,是一種即插即用的結構。 跨越式特征聯合網絡結構通過對前向卷積層的多個拼接,使網絡在前向傳播的過程中多個層次的特征被多次聯合使用,在反向傳播的過程中多級特征被重復性學習,同時盡量減少每層網絡的卷積核的數量,使網絡盡量用更少的參數達到更高的精度。這樣一方面可以加強特征圖的學習效率,另一方面能夠減少網絡的參數,減少網絡的計算量。 2.3Inception模塊結構 Inception首次提出于GoogleNet中[22],GoogleNet在2014年ImageNet競賽上獲得冠軍。文獻[23]在Inception中加入了BN層,精度得到了提高。文獻[24]提出了Inception v3,n×n的卷積核被拆分成n×1和1×n兩種卷積核,降低了網絡的參數量。Inception的提出與改進大大提升了深度網絡的識別性能。 本文用到的Inception模塊結構由4個平行的通道共同輸入到下一級的特征組,4個平行的通道分別包括1×1的卷積和其他尺度大小的卷積核相結合[21]。1×1的卷積核不能很好地學習到特征圖中的臨近像素的信息,但是1×1的卷積核可以將輸入的特征圖壓縮成較少的特征圖組合,再經過3×3或者5×5不同的感受野卷積對特征圖信息進一步進行學習,獲得更豐富的特征信息組合。 Inception結構的1×1卷積核的加入可以大大減少網絡的學習參數,同時不同通道中具有豐富感受野的圖像信息最終匯聚成一組,可以得到更好的圖像表征信息。Inception模塊結構如圖4所示。 3實驗結果與分析 3.1實驗數據集與實驗環境 針對山地中的風機葉片的裂紋、裂縫、斷裂、老化等缺陷進行檢測,本文使用的數據集全部通過實地采集獲得,主要包括裂縫的風機葉片圖片和有磨損、老化現象的風機葉片圖片約450張。由于含有缺陷的真實數據較少,在輸入檢測網絡之前首先對圖片進行數據增廣,主要包括加噪聲、圖像旋轉、亮度變化等,得到最終的數據集為1 500張,其中1 000張作為訓練集,200張作為驗證集,300張用于測試。由于風機葉片不同類型的損傷在圖像上差異較大,因此將損傷類型分成2種。一是以裂縫、裂紋為代表的較小目標的缺陷,二是以磨損、老化為代表的較大目標的缺陷。 使用開源標注工具LabelImg對缺陷部位進行標注,將數據集中的圖像標注為.xml文件,標注結果會保存圖像中每個目標的類別、大小和位置信息。 所有的實驗均在配置為i7-9750H@2.60 GHz CPU,16 GB RAM,G5 5590的PC上實現訓練和測試,以保證結果的公平性。 軟件環境:操作系統為64位的Windows 10;深度學習框架:Darknet,CUDA 10.0,Cudnn 7.6;可視化軟件:OpenCV。 本次實驗迭代次數均設置為10 000次,學習率設置為0.001,輸入圖像大小設置為416×416,batch設置為64,subdivisions設置為8,每訓練1 000次保存一次權重并篩選出最佳權重保存。 3.2模型結果比較 3.2.1模型精度 在NIVIDIA RTX2070的顯卡上對數據集進行訓練。本文訓練所得到的模型采用mAP(mean average precision)進行目標檢測精度的描述。mAP的計算是通過精確率P與召回率R計算得到的。如式(7)所示,精確率P是指檢測結果中檢測正確的樣本數所占的比例,Tp表示檢測正確的個數,Fp表示未被檢測出的個數,Fn表示檢測錯誤的個數。召回率R是指檢測正確的樣本數占待檢測樣本總數的比例。計算出所有類別的AP值,取得平均值即為mAP。mAP的值越大表示該算法的精度越高。 P=TpFp+Tp,(7) R=TpFp+Fn。(8) 本文改進的YOLOv3-Tiny算法的mAP相比于原來的YOLOv3-Tiny提高了2.69%,如表1所示,改進的YOLOv3-Tiny中較小目標的裂紋、裂縫的精度提升明顯,磨損、老化的檢測也有提升。改進1表示YOLOv3-Tiny的骨干網絡只引入跨越式特征聯合網絡結構,相比于改進的YOLOv3-Tiny(同時引入跨越式特征聯合網絡結構和Inception模塊結構)精度低1.33%,相比于YOLOv3-Tiny精度高1.36%,此外改進的YOLOv3-Tiny比YOLOv4-Tiny的精度高0.26%。 3.2.2損失曲線 如圖5所示,改進后的YOLOv3-Tiny的損失函數曲線與原YOLOv3-Tiny的損失函數曲線相似,都是收斂的,說明改進后的模型訓練穩定。 3.2.3模型速度與模型參數 本文提出的跨越式特征聯合網絡結構能夠重復學習不同級層的網絡結構,因此需要較少的參數就能達到更高的精度。如表2所示,改進后的YOLOv3-Tiny模型大小只有7.34 MB,相比于原YOLOv3-Tiny參數量縮小了4倍,同時精度卻高于原YOLOv3-Tiny。 在模型速度上,在NIVIDIA RTX2070的顯卡上對數據集進行測試,由表2可知,平均檢測一幅圖像YOLOv3-Tiny用時最短為4.32 ms,改進1用時4.51 ms,YOLOv4-Tiny用時3.56 ms,而提出的改進的YOLOv3-Tiny用時5.01 ms,由于網絡的寬度增加,雖然改進后的模型參數較少但是速度略有降低。平均一幅圖像的檢測時間與YOLOv3-Tiny相差僅0.69 ms,本模型在基本不影響檢測速度的同時提高了檢測精度。 3.3檢測結果與分析 通過訓練得到3種模型,YOLOv2-Tiny,YOLOv3-Tiny和改進的YOLOv3-Tiny,使用相同的測試集進行測試對比,結果如圖6所示。由圖6中a1)—c1)可知,對于風機葉片中較大的磨損、老化缺陷,3種模型均能達到較好的檢測效果。由a2)—c2)可以看出,對于目標較小的磨損、老化,改進后的YOLOv3-Tiny檢測效果最佳,其他則存在漏檢測現象。由圖6中a3)—c3)可以看出,風機葉片上的裂縫、裂紋,改進后的YOLOv3-Tiny檢測效果好于其他2個模型。 由上可知,跨越式特征聯合網絡結構連同Inception模塊結構作為YOLOv3-Tiny新的骨干網絡起到了較好的作用,使整個模型用更少的參數就能得到更好的效果。 4結語 提出了一種改進的YOLOv3-Tiny風機葉片損傷檢測算法,提出跨越式特征聯合網絡結構并引入Inception模塊結構,擴大感受野并提升較小損傷的檢測能力,實驗結果表明改進后的算法精度更高并且模型參數更少,對于較小目標的缺陷檢測效果更加出色。 本文提出的跨越式特征聯合網絡結構與YOLOv3-Tiny相比,其精度提升了1.36%,引入的Inception模塊結構提升精度1.33%。算法相較于YOLOv3-Tiny,在不影響速度的情況下精度提高了2.69%,達到88.58%。利用深度學習的方法進行目標檢測,比傳統方法的魯棒性更強,更能適應外部復雜環境的變化。該方法在風機葉片損傷檢測中的應用可以及時快速發現葉片損傷問題,有效提升葉片檢修效率。此外,本文提出的算法模型較小,也適用于對實時性要求較高和需要微型計算平臺的應用場景。 本文算法模型未開展在NVIDIA Jetson TX2等微型嵌入式深度學習平臺中應用的研究。未來可將本算法模型進一步優化,開展模型裁剪研究,將其應用于微型嵌入式深度學習平臺,并集成在多旋翼無人機中,實現風機葉片的無人機在線智能識別作業。 參考文獻/References: [1]楊家歡,宗哲英,王禎,等.風機葉片檢測的研究現狀及進展[J].復合材料科學與工程,2020(6):109-113. YANG Jiahuan,ZONG Zheying,WANG Zhen,et al.Areview of research on detecting the wind turbine blades[J].Composites Science and Engineering,2020(6):109-113. [2]程杰,來永斌,王龍,等.典型風力機翼型結冰特性分析[J].河北科技大學學報,2019,40(1):9-14. CHENG Jie,LAI Yongbin,WANG Long,et al.Study on the icing characteristics of typical wind turbine[J].Journal of Hebei University of Science and Technology,2019,40(1):9-14. [3]劉雙,胡斌,賀鑄,等.風機葉片缺陷的無損檢測方法比較與評價[J].無損檢測,2015,37(3):47-51. LIU Shuang,HU Bin,HE Zhu,et al.Comparison and evaluation on the non-destructive testing methods for the wind turbine blades defects[J].Nondestructive Testing,2015,37(3):47-51. [4]顧桂梅,胡讓,李遠遠.果蠅優化算法融合SVM的風機葉片損傷識別研究[J].自動化儀表,2016,37(2):9-12. GU Guimei,HU Rang,LI Yuanyuan.Study on identification of damage for wind turbine blade by fusing FOA and SVM[J].Process Automation Instrumentation,2016,37(2):9-12. [5]張超,文傳博.基于改進Mask R-CNN的風機葉片缺陷檢測[J].可再生能源,2020,38(9):1181-1186. ZHANG Chao,WEN Chuanbo.Fault detection of wind turbine blade based on improved Mask R-CNN[J].Renewable Energy Resources,2020,38(9):1181-1186. [6]曹錦綱,楊國田,楊錫運.基于RPCA和視覺顯著性的風機葉片表面缺陷檢測[J].圖學學報,2019,40(4):704-710. CAO Jingang,YANG Guotian,YANG Xiyun.Surface defect detection of wind turbine blades based on RPCA and visual saliency[J].Journal of Graphics,2019,40(4):704-710. [7]劉艷霞,丁小燕,方建軍.基于遷移學習的風力發電機葉片裂縫識別[J].傳感器與微系統,2019,38(8):107-110. LIU Yanxia,DING Xiaoyan,FANG Jianjun.Wind turbine blade crack identification based on migration learning[J].Transducer and Microsystem Technologies,2019,38(8):107-110. [8]顧桂梅,張鑫.基于深度信念網絡的風機葉片結構損傷識別研究[J].甘肅農業大學學報,2016,51(4):134-138. GU Guimei,ZHANG Xin.Structural damage identification of wind turbine blade based on deep belief networks[J].Journal of Gansu Agricultural University,2016,51(4):134-138. [9]毛希瑋,徐瑩瑩.基于無人機的風機葉片缺陷自動檢測技術[J].復合材料科學與工程,2020(9):85-89. MAO Xiwei,XU Yingying.Automatic defect detection of wind blade surface via UAV[J].Composites Science and Engineering,2020(9):85-89. [10]賀斌,賈建華,趙峰,等.無人機在風機葉片檢測中的應用[J].電工技術,2019(13):64-65. HE Bin,JIA Jianhua,ZHAO Feng,et al.Application of UAV in detection of wind turbine blades[J].Electric Engineering,2019(13):64-65. [11]趙春溢,郭洪濤,郭濤,等.一種風機葉片圖像采集及缺陷檢測系統[J].紅外技術,2020,42(12):1203-1210. ZHAO Chunyi,GUO Hongtao,GUO Tao,et al.Defect detection system based on UAV images for wind turbine blades[J].Infrared Technology,2020,42(12):1203-1210. [12]趙永強,饒元,董世鵬,等.深度學習目標檢測方法綜述[J].中國圖象圖形學報,2020,25(4):629-654. ZHAO Yongqiang,RAO Yuan,DONG Shipeng,et al.Survey on deep learning object detection[J].Journal of Image and Graphics,2020,25(4):629-654. [13]GIRSHICK R,DONAHUE J,DARRELL T,et al.Rich feature hierarchies for accurate object detection and semantic segmentation[C]//2014 IEEE Conference on Computer Vision and Pattern Recognition.Columbus:IEEE,2014:580-587. [14]GIRSHICK R.Fast R-CNN[C]//2015 IEEE International Conference on Computer Vision (ICCV).Santiago:IEEE,2015:1440-1448. [15]REN Shaoqing,HE Kaiming,GIRSHICK R,et al.Faster R-CNN:Towardsreal-time object detection with region proposal networks[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(6):1137-1149. [16]REDMON J,DIVVALA S,GIRSHICK R,et al.You only look once:Unified,real-timeobject detection[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Las Vegas:IEEE,2016:779-788. [17]REDMON J,FARHADI A.YOLO9000:Better,faster,stronger[C]//2017 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Honolulu:IEEE,2017:6517-6525. [18]REDMON J,FARHADI A.YOLOv3:An incremental improvement[EB/OL].[2018-04-08].http://arxiv.org/pdf/1804.02767.pdf. [19]BOCHKOVSKIY A,WANG C Y,LIAO H Y M.Yolov4:Optimal speed and accuracy of object detection[EB/OL].[2020-04-23].http://arxiv.org/pdf/2004.10934.pdf. [20]LIU Wei,ANGUELOV D,ERHAN D,et al.SSD:Single shot MultiBox detector[C]//Computer Vision-ECCV 2016.Cham:Springer International Publishing,2016:21-37. [21]ZENG Yiliang,ZHANG Lihao,ZHAO Jiahong,et al.JRL-YOLO:A novel jump-join repetitious learning structure for real-time dangerous object detection[J].Computational Intelligence and Neuroscience,2021:5536152. [22]SZEGEDY C,LIU Wei,JIA Yangqing,et al.Going deeper with convolutions[C]//2015 IEEE Conference on Computer Vision and Pattern Recognition(CVPR).Boston:IEEE,2015:1-9. [23]IOFFE S,SZEGEDY C.Batchnormalization:Accelerating deep network training by reducing internal covariate shift[C]//Proceedings of the 32nd International Conference on International Conference on Machine Learning.Lille:PMLR,2015:448-456. [24]SZEGEDY C,VANHOUCKE V,IOFFE S,et al.Rethinking the inception architecture for computer vision[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR).Las Vegas:IEEE,2016:2818-2826.