基于卷積神經網絡的麥穗目標檢測算法研究

王宇歌,張涌,黃林雄,趙奉奎

摘? 要:麥穗數量檢測對于作物表型參數計算、產量預測和大田管理都具有重要的意義。為了解決人工計數工作量大且容易出錯的問題,提出了一種基于You Only Look Once (YOLO)的麥穗目標檢測與計數方法。首先利用大量小麥圖像對深度神經網絡進行訓練,然后利用神經網絡對小麥圖像進行麥穗目標檢測與計數,最后對神經網絡目標檢測的準確率和召回率進行計算評估,并通過分析檢測結果驗證其魯棒性。分析結果顯示,所訓練網絡對麥穗檢測的精確率為76.96%,召回率為93.16%,均值平均精度mean Average Precision (mAP)為89.52%。此外,該模型可以檢測不同生長時期的麥穗,具有較高的魯棒性。研究表明,該方法對比其他麥穗計數方法準確高效,可以實際應用到小麥的產量估算上。

關鍵詞:目標檢測;產量預測;YOLO;深度學習

中圖分類號:TP391.4? ? ?文獻標識碼:A

Research of Wheat Ear Target Detection based on Convolutional Neural Network

WANG Yuge, ZHANG Yong, HUANG Linxiong, ZHAO Fengkui

(College of Automobile and Traffic Engineering, Nanjing Forestry University, Nanjing 210037, China)

515400100@qq.com; zyjs111@126.com; 1773361196@qq.com; zfk@njfu.edu.cn

Abstract: Detecting the number of wheat ears is of great significance to the calculation of crop phenotypic parameters, yield prediction and field management. In order to solve the problem of heavy workload and error-prone manual counting, this paper proposes a wheat ear target detection and counting method based on You Only Look Once (YOLO). First, a large number of wheat images are used to train the deep neural network. Then, the neural network is used to detect and count wheat ears in the wheat images. Finally, the accuracy and recall rate of the neural network target detection are calculated and evaluated, and the robustness is verified by analyzing the detection results. The analysis results show that the trained network has an accuracy rate of 76.96% for wheat ear detection, a recall rate of 93.16%, and a mean Average Precision (mAP) of 89.52%. In addition, the model can detect wheat ears in different growth periods, and has high robustness. Studies have shown that this method is more accurate and efficient than other wheat ear counting methods, and can be applied to wheat yield estimation.

Keywords: target detection; output prediction; YOLO; deep learning

1? ?引言(Introduction)

小麥種植密度估算是小麥產量預測的重要手段,也是小麥大田管理的重要依據。目前,小麥產量預測方法有人工預測、年景預測[1]、基于遙感圖像預測[2]和基于多元線性回歸預測[3]等。人工預測費時費力,容易出錯;年景預測只適合地區大范圍產量預測;基于遙感圖像預測準確率低;基于多元線性回歸預測受降水等變量影響較大,準確率難以保證。相比之下,視覺傳感器可以獲取豐富的紋理和顏色信息,且成本較低。近年來,機器視覺在麥穗檢測研究中發揮著越來越大的作用。傳統圖像處理技術常使用移動窗法[4]或超像素分割法[5]采樣子圖像,從子圖像中提取顏色或紋理特征,然后訓練分類器,利用分類器識別麥穗,完成計數;或者通過圖像處理方法突出麥穗,如將圖像進行二值化處理,在去除粘連后識別麥穗[6]。

近年來,基于卷積神經網絡(Convolutional Neural Network, CNN)的機器學習方法在圖像處理領域取得了突破性進展。在物體識別、目標檢測與目標分割等應用上,基于CNN的圖像處理在技術表現上遠好于傳統方法[7]。因此,越來越多的研究采用目標檢測算法進行作物穗檢測。目標檢測方法可分為Two-stage和One-stage兩類。Two-stage方法先采用一定的算法生成候選框,然后通過卷積神經網絡對樣本進行分類,典型方法包括R-CNN[8]及Fast R-CNN[9]目標檢測模型,例如HE等[10]提出的SPP-net、REN等[11]提出的Faster R-CNN等。Two-stage目標檢測方法準確率高,但是速度相對較慢。One-stage方法直接回歸目標的類別概率和邊界框,運算速度相比于Two-stage方法有較大提高,常用方法包括Single Shot MultiBox Detector[12]等。YOLO系列目標檢測框架是一種非常典型的One-stage方法,包括王宇寧等改進的YOLO[13],李鵬飛等改進的YOLOv2[14],REDMON等提出的YOLOv3[15],以及BOCHKOVSKIY等[16]提出的YOLOv4。One-stage和Two-stage方法均已應用在作物穗的檢測上,如HASAN等[17]利用R-CNN進行麥穗檢測,MADEC等[18]利用Faster R-CNN進行麥穗檢測。還有研究開始使用One-stage目標檢測算法,如利用YOLO等對作物穗進行目標檢測[19],從而進行作物穗計數。由于麥穗目標尺寸小,相互遮擋嚴重,而且還有葉片的遮擋,目標識別困難,因此,仍然有必要對麥穗目標檢測開展進一步的研究。

本文研究基于YOLOv3的麥穗目標檢測算法,對目標檢測效果進行評價,并對比基于深度學習的麥穗計數與人工麥穗計數兩種方式,驗證該方法的可行性。

2? 麥穗小目標檢測機制(Detection mechanism of small wheat ear target)

2.1? ?YOLOv3目標檢測原理

YOLO系列目標檢測算法是一種典型的One-stage目標檢測算法。該系列算法可以直接回歸得出目標可能所處的位置,顯著提高了目標檢測的速度,并在實現實時性的同時確保檢測精度。YOLO系列算法在實踐中被廣泛使用。YOLOv3是YOLO系列目標檢測算法的典型代表,是目前實際工程應用領域最優秀的目標檢測算法之一。

YOLOv3網絡結構如圖1所示。由于ResNet[10]可以有效加深網絡深度并提高預測精度,YOLOv3使用了殘差網絡Residual,引入了多個ResNet模塊,并大量使用了殘差的跳層連接,減輕了深度神經網絡在加深深度時梯度消失的問題。YOLOv3最終設計了一個具有53 個卷積層的神經網絡,命名為Darknet-53,用以提取圖像特征。

YOLOv3生成3 個具有不同深度的特征圖,來預測不同尺度的目標。3 個特征層的shape分別為(52,52,256)、(26,26,512)、(13,13,1024),劃分越精細的特征圖所能檢測的目標就越精細,有效提高了小目標的檢測效果。YOLOv3通過將上采樣后的特征圖與較前層的特征圖融合,例如將26×26的特征層上采樣后與52×52的特征層融合,從而得到上采樣層的語義信息和前層特征圖的細粒度信息,再進行卷積運算后對目標進行準確預測。

特征層預測結果shape分別為(N,13,13,255)、(N,26,26,255)、(N,52,52,255),其中N為圖片數量。每個特征圖網格單元上生成3 個錨框,每個網格單元負責一個區域的檢測,因此YOLOv3的邊界框預測過程就是將特征圖每個網格點加上它對應的坐標偏移量,相加的結果即為預測框的中心,然后再利用先驗框和縮放尺度計算出預測框的長和寬,從而可以得到整個預測框的位置。

2.2? ?YOLOv3改進

神經網絡訓練之前,對YOLOv3的網絡結構進行改進。本文需要檢測麥穗和背景,因此,只有一個類別,則輸出特征層的最后一個維度為3×(5+1)=18,其中“3”表示每個網格生成3 個預測框;“5”則分別表示橫縱坐標偏置、預測框長寬、置信度;“1”表示分類結果。因此,3 個特征層的輸出結果的尺寸改為(N,13,13,18)、(N,26,26,18)、(N,52,52,18),其中N為圖片數量。

2.3? ?評價函數

目標檢測通常使用準確率和召回率這兩個指標來評估目標檢測算法的性能。精確率(Precision)是指正確檢測為正類的目標在所有判定為正類的目標中所占的比例;召回率(Recall)是指被正確檢測為正類的目標在所有正類目標中所占的比例。精確率和召回率的計算公式分別如式(1)和式(2)所示。

(1)

(2)

式中,TP表示正確識別為正類的目標個數;FP表示錯誤識別為正類的目標個數;FN表示錯誤識別為負類的目標個數。

在實際的應用過程中,精確率和召回率兩個指標無法同時滿足要求,因此使用AP值綜合考慮兩個指標,從而衡量網絡的性能。AP計算公式如式(3)所示。

(3)

式中,N表示測試集中圖片的數量;Precision(k)表示第k 張圖片的Precision值;?Recall(k)表示從k-1 張圖片到k 張圖片Recall值的變化情況。針對具有C類目標的具體任務時,一般采用平均AP值即mAP,來衡量網絡的性能,其計算如式(4)所示。

(4)

3? ?實驗分析(Analyses of experiment)

3.1? ?YOLOv3框架運行平臺

麥穗目標檢測程序運行環境為Ubuntu 18.04,采用keras開源框架,后端引擎為Tensorflow張量操作框架;硬件平臺為Intel i9-9900K CPU,主頻3.60 GHz,32 GB內存,顯卡為NVIDIA RTX 2080Ti。

3.2? ?數據集制作

神經網絡訓練數據來源于文獻[18]。然而該文獻提供的數據中存在很多錯誤,標簽位置與圖像中麥穗目標不匹配,無法用于神經網絡的訓練。因此,本文校正了文獻[18]提供的數據,查找標定錯誤的圖像,并對圖像進行翻轉和旋轉等操作,使標簽與麥穗目標匹配,最終獲得有效圖像222 張。將其中80%的數據用于網絡訓練,其余20%的數據作為測試集用于測試網絡的性能。在訓練過程中,將前文所述80%數據中90%的數據作為訓練集用于訓練神經網絡中的參數,其余10%的數據作為驗證集用于驗證模型性能的樣本集合。由于采用了YOLOv3的預訓練權重,設置batch_size=4,經過150 輪迭代后,損失函數趨于穩定。

3.3? ?實驗結果分析

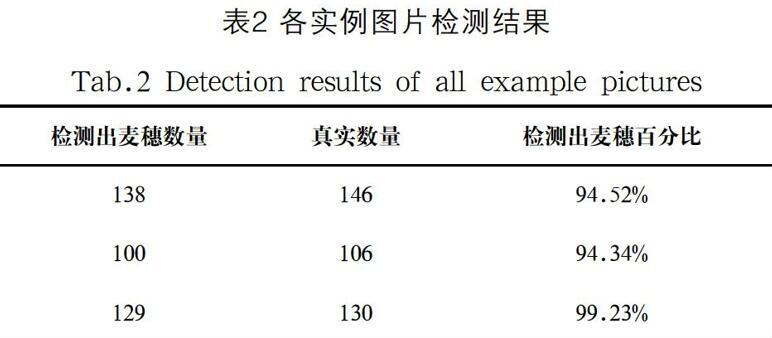

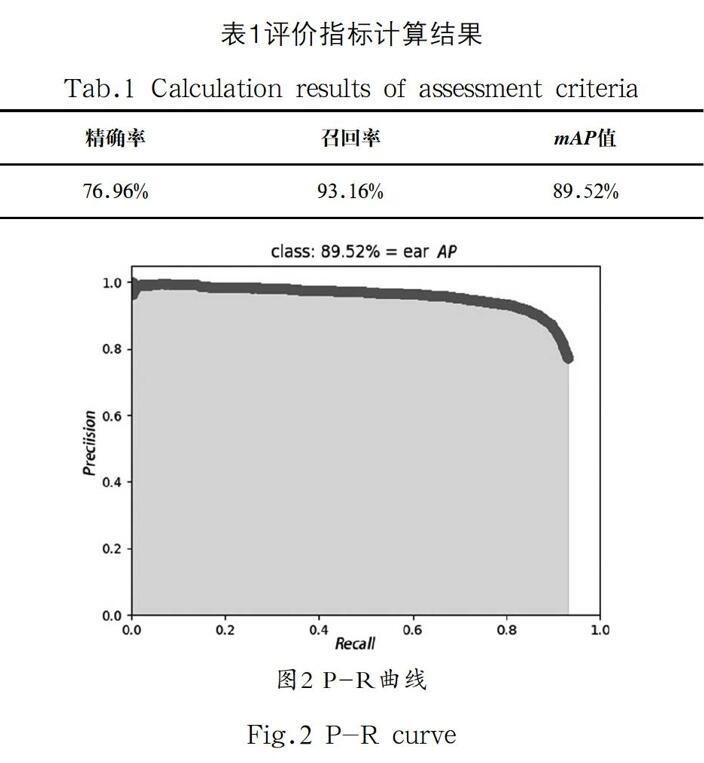

為了驗證YOLOv3在麥穗識別中的性能,基于上文所述的測試集,通過計算目標檢測算法典型評價指標來對YOLOv3算法進行評價。三種評價指標計算結果如表1所示。由于本文所識別的為單一目標,因此,本文中mAP值即為麥穗這一類別的AP值。從表1中的數據可以得出,YOLOv3在麥穗檢測中表現出較優的性能,其精確率為76.96%,召回率為93.16%。由于精確率和召回率取決于閾值設定,為了更準確地評估模型目標檢測性能,繪制精確率-召回率變化曲線如圖2所示,曲線包圍面積即mAP為89.52%。

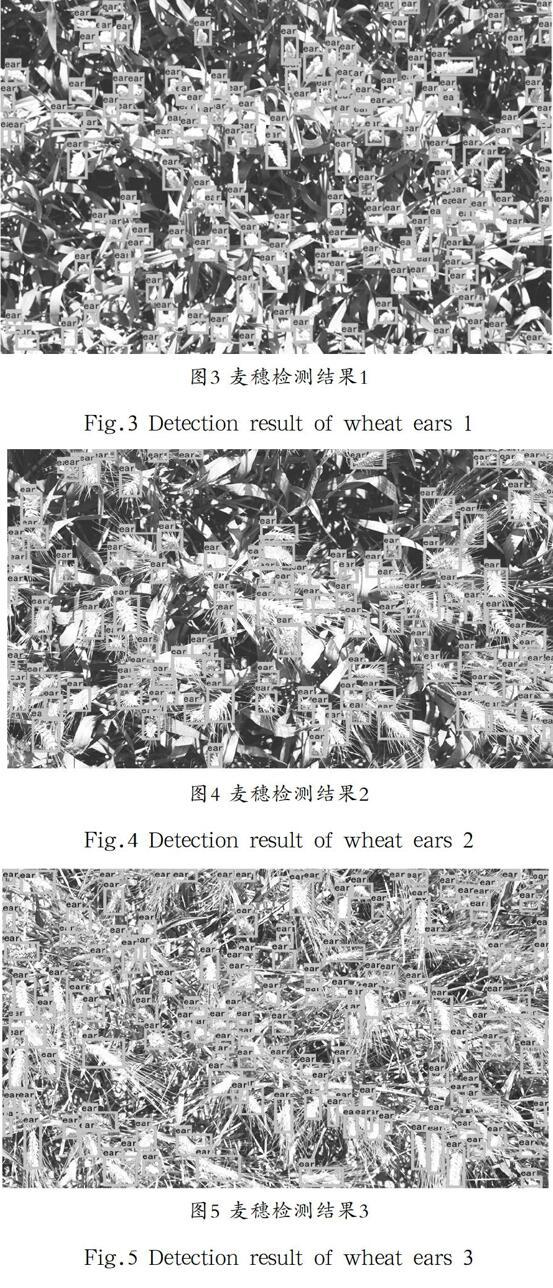

為了驗證YOLOv3在麥穗識別中具有較高的魯棒性,本文選取了小麥在不同生長時期所拍攝的照片進行測試分析。測試結果如圖3、圖4和圖5所示,測試圖片按生長周期進行排序。各實例圖片檢測結果如表2所示,其中,檢測成功的目標使用方框進行標注。在圖3中,成功檢測出138 個目標,有8 個目標未成功檢測,準確率為94.52%;在圖4中,成功檢測出100 個目標,有6 個目標未成功檢測,準確率為94.34%;在圖5中,成功檢測出129 個目標,有1 個目標檢測失敗,準確率為99.23%。通過以上數據可知,該算法漏檢少量麥穗,主要原因是麥穗目標比較小,麥穗與麥穗之間、葉片與麥穗之間相互遮擋。從上述圖片的總體檢測結果中可以看出,該算法在麥穗生長的各個時期均表現出較高的識別準確率,并且預測框的大小與位置也與麥穗非常匹配,可以認為該算法表現出較高的麥穗識別魯棒性。

4? ?結論(Conclusion)

本文基于YOLOv3目標檢測算法,對麥穗進行檢測和計數。首先對開源的小麥麥穗數據集進行校正,并且適當劃分訓練集、驗證集和測試集;其次,本文根據單類目標檢測需求對YOLOv3進行改進,基于劃分的數據集并結合YOLOv3的預訓練權重對YOLOv3網絡進行訓練;最后,利用訓練完成的神經網絡對測試集數據進行測試。最終的實驗結果證明,YOLOv3在麥穗檢測這一任務中具有較高的準確率和mAP指標,且表現出較高的魯棒性。同時也發現,由于麥穗目標較小,加之相互遮擋嚴重,仍存在部分麥穗漏檢的情況,對麥穗的目標檢測仍需要進一步的研究來提高準確率。

參考文獻(References)

[1] 侯英雨,王建林,毛留喜,等.美國玉米和小麥產量動態預測遙感模型[J].生態學雜志,2009,28(10):2142-2146.

[2] 朱秀紅,李秀珍,姚文軍,等.基于SPSS的日照市小麥產量年景預測模型[J].中國農學通報,2010,026(02):295-297.

[3]周永生,肖玉歡,黃潤生.基于多元線性回歸的廣西糧食產量預測[J].南方農業學報,2011,42(09):1165-1167.

[4] 劉濤,孫成明,王力堅,等.基于圖像處理技術的大田麥穗計數[J].農業機械學報,2014,45(2):282-290.

[5] 杜穎,蔡義承,譚昌偉,等.基于超像素分割的田間小麥穗數統計方法[J].中國農業科學,2019,52(01):21-33.

[6] 李毅念,杜世偉,姚敏,等.基于小麥群體圖像的田間麥穗計數及產量預測方法[J].農業工程學報,2018,34(21):193-202.

[7] 翁楊,曾睿,吳陳銘,等.基于深度學習的農業植物表型研究綜述[J].中國科學:生命科學,2019,49(06):698-716.

[8] 董靜,耿達,郭迎港,等.室內環境下基于R-CNN的光照自適應物體檢測[J].計算機工程與應用,2019,55(2):168-173.

[9] 莫宏偉,汪海波.基于Faster R-CNN的人體行為檢測研究[J].智能系統學報,2018,13(6):967-973.

[10] HE K, ZHANG X, REN S, et al. Spatial pyramid pooling in Deep Convolutional Networks for visual recognition[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2014, 37(9):1904-1916.

[11] REN S, HE K, GIRSHICK R, et al. Faster R-CNN: Towards real-time object detection with Region Proposal Networks[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2017, 39(6):1137-1149.

[12] 陳冰曲,鄧濤.基于改進型SSD算法的目標車輛檢測研究[J].重慶理工大學學報(自然科學),2019,33(1):58-63.

[13] 王宇寧,龐智恒,袁德明.基于YOLO算法的車輛實時檢測[J].武漢理工大學學報,2016,38(10):41-46.

[14] 李鵬飛,劉瑤,李珣,等.YOLO9000模型的車輛多目標視頻檢測系統研究[J].計算機測量與控制,2019,27(8):21-24,29.

[15] REDMON J, FARHADI A. YOLOv3: An incremental improvement[Z/OL]. [2021-05-26]. https://arxiv.org/abs/1804.02767.

[16] BOCHKOVSKIY A, WANG C Y, LIAO H. YOLOv4: Optimal speed and accuracy of object detection[Z/OL]. [2021-05-26]. https://arxiv.org/abs/2004.10934.

[17] HASAN M M, CHOPIN J P, LAGA H, et al. Detection and analysis of wheat spikes using Convolutional Neural Networks[J]. Plant Methods, 2018, 14(1):100-113.

[18] MADEC S, JIN X, LU H, et al. Ear density estimation from high resolution RGB imagery using deep learning technique[J]. Agricultural and Forest Meteorology, 2019(264):225-234.

[19] 梁胤豪,陳全,董彩霞,等.基于深度學習和無人機遙感技術的玉米雄穗檢測研究[J].福建農業學報,2020,35(4):456-464.

作者簡介:

王宇歌(1999-),女,本科生.研究領域:汽車電子.

張? 涌(1971-),男,博士,教授.研究領域:智能車底盤線控.

黃林雄(1996-),男,碩士生.研究領域:汽車電子.

趙奉奎(1986-),男,博士,講師.研究領域:智能車環境感知技術.本文通訊作者.