基于多智能體Nash-Q強化學習的綜合能源市場交易優化決策

孫慶凱,王小君,王 怡,張義志,劉 曌,和敬涵

(北京交通大學電氣工程學院,北京市 100044)

0 引言

隨著經濟的發展,低效、粗獷的能源利用方式與資源、環境間的矛盾逐步加深。打破現有能源體系行業壁壘,構建綜合能源交易市場,從市場角度切入,以價格激勵為手段,通過實際供需關系促進能源綜合利用和高效配置具有重要意義[1-2]。

綜合能源市場涉及多主體間的利益關系,影響因素眾多,各主體既會相互影響,又會不斷觀察和學習來調整自身行為,進而推動整個系統交易演化,整體是一個復雜適應性問題[3-5]。針對該問題,已有學者采用博弈理論構建市場交易競價框架[6-11],其中文獻[8]建立綜合能源服務商雙層博弈模型,通過Karush-Kuhn-Tucker(KKT)條件轉化為單層模型優化求解。文獻[9]提出綜合能源市場出清機制,采用對角算法研究計及供應側策略投標的市場均衡。文獻[10]采用雙層粒子群算法求解多方博弈競價均衡問題。文獻[11]基于Stackelberg博弈理論建立不同能源交易決策模型并利用改進粒子群算法求解。

上述研究普遍采用數學推導法和啟發式算法優化求解,其中前者忽略市場參與主體非凸非線性屬性,通過KKT條件將雙層模型轉換為具有平衡約束的單層模型求解,致使與實際問題間存在建模殘差[12]。后者雖無須建立精確博弈關系模型,但僅基于簡單生物群體行為尋優易陷入局部最優解,無法保證與Nash均衡解的一致性[13]。同時兩類方法均存在以下弊端:①須以完全信息環境作為前提假設,與實際交易存在差異;②不具有記憶特性,無法充分利用歷史信息,每次求解均為獨立過程。

強化學習作為新型人工智能算法,可通過在動態環境中反復探索與試錯的方式求解問題,對精確數學模型、完整信息以及參數設置要求較低,這為求解復雜系統優化決策問題提供了可能[14-16]。文獻[17]提出了基于強化學習的并網型綜合能源微網調度模型。文獻[18]采用強化學習研究綜合能源系統(integrated energy system,IES)動態經濟調度。文獻[19]基于強化學習研究家庭IES需求響應優化。雖然強化學習為復雜系統決策提供了重要求解工具,但目前未見其在綜合能源交易領域有詳細研究,同時已有研究普遍將對象簡化為單一智能體與固定環境間的交互學習,然而實際綜合能源交易市場是多主體復雜交互適應系統,如何將多智能體強化學習應用于綜合能源交易市場尚有不足。

為此,本文在多智能體強化學習基礎上結合博弈論,利用博弈強化學習協調綜合能源市場交易。主要貢獻歸納如下:①構建了“競價博弈-市場出清”電-氣綜合能源市場雙層交易框架;②利用多智能體Nash-Q強化學習優化求解電-氣綜合能源市場競價博弈問題。

1 電-氣綜合能源市場多智能體劃分及交易框架

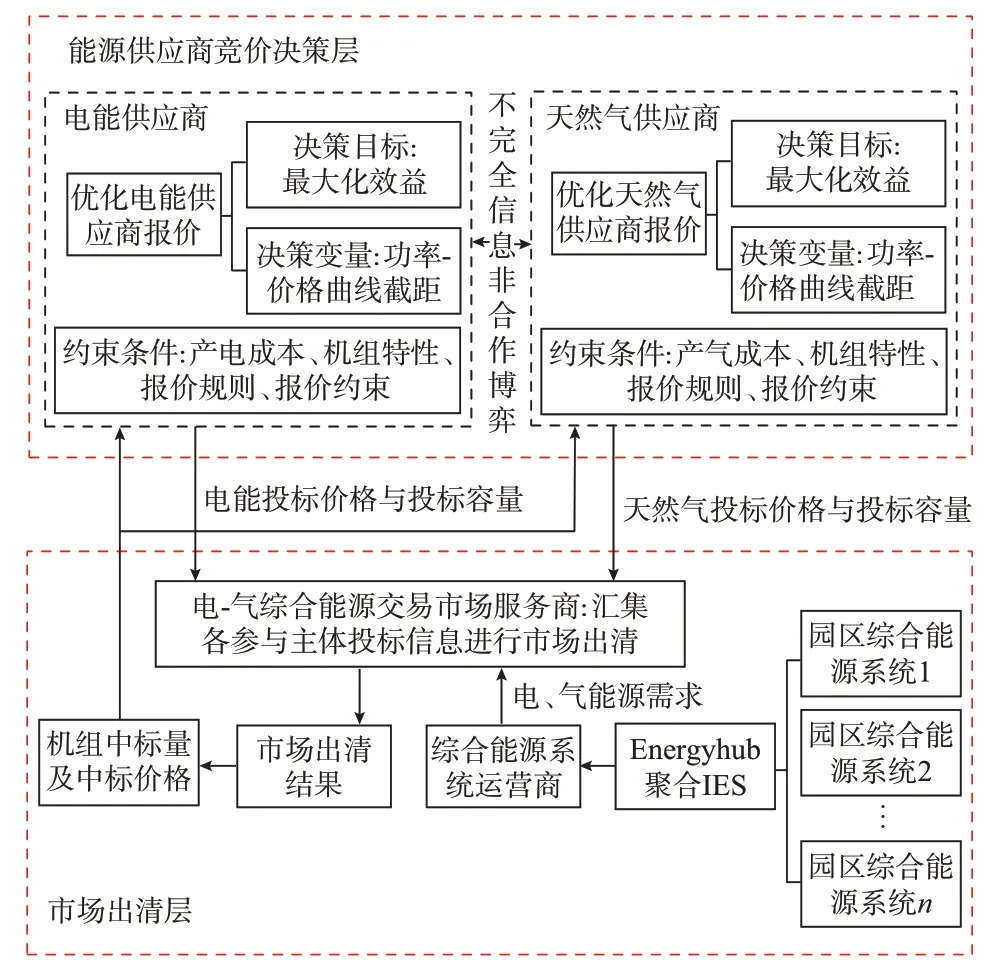

市場環境下能源供給、交易、消耗過程存在多個參與主體。供給層面中電能、天然氣供應商滿足能源供給;交易層面中電-氣綜合能源交易市場服務商作為紐帶,匯集能源供應商的投標價格與綜合能源系統運營商(integrated energy system operator,IESO)的能源需求,按社會福利最大化進行市場出清。消耗層面中IESO聚合多個IES的能源需求,在市場上購買能源。鑒于多參與主體分屬于不同利益集團,有著各自運行目標、用戶需求、控制手段等,但彼此之間利益聯系緊密;同時為配合后續強化學習應用,將市場參與者劃分為以下智能體:電能供應商、天然氣供應商、電-氣綜合能源交易市場服務商以及IESO。

依據功能定位將能源市場設定為競價決策層和市場出清層,如圖1所示。

圖1 市場交易框架Fig.1 Market transaction framework

1)競價決策層中能源供應商報價過程、運行成本、收益函數等信息不公布,是在不完全信息環境下向市場服務商提交投標價格與容量以進行非合作競價博弈。

2)市場出清層中市場服務商匯集能源供應商報價信息和IESO能源需求信息進行市場出清,決定各能源供應商中標容量及收益。

基于上述交易機制作如下假設:①參與主體皆為理性,即合理尋求自身決策目標最大化;②短時間內能源供應和負荷不產生變化;③博弈過程中僅考慮價格影響,暫不考慮其他因素。

2 電-氣綜合能源市場雙層優化決策模型

2.1 競價決策層

綜合能源市場由多參與主體構成,各方更多地考慮自身經濟性,致使傳統集中優化方法難以執行。鑒于博弈論作為解決不同主體利益沖突的有效工具[20],本文在競價決策層中建立多智能體非合作博弈決策模型:

式中:G為博弈均衡點;g(·)為博弈函數;N為智能體數量;S為策略集合;U為效益函數集合。

2.1.1 博弈參與者

依據智能體劃分標準將競價決策層中的博弈參與主體確定為電能供應商和天然氣供應商。

2.1.2 博弈策略

電能供應商博弈策略為電能投標價格和投標電量;天然氣供應商博弈策略為天然氣投標價格和投標氣量。

2.1.3 效益函數

2.1.3.1 電能供應商

1)投標價格制定

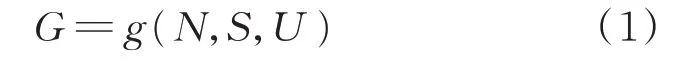

園區IES是中國用戶側參與市場交易的改革試點,采用包含利潤和邊際成本的功率價格曲線競價有助于提高能源利用率[21]。電能供應商運行邊際成本隨出力上升而增大,須針對不同類型機組按自身邊際成本函數制定功率-價格曲線[22]。同時考慮到調節斜率使得競價變動較大,故而采用了變截距方式,即交易中電能供應商通過市場服務商接收IESO的能源購買信息,以自身效益最大化來改變功率-價格曲線截距se(t),并將新曲線傳遞給市場服務商,其功率-價格曲線如式(2)所示。

式中:λe(t)為t時刻電能出售價格;ae為電能供應商考慮運行成本的二次項系數;Pe(t)為t時刻電能供應商出售功率。

2)效益函數

為清晰模擬能源供應商與IESO互動過程,目標函數只考慮出售給IESO的收入,向其他剛性負荷售能收入暫不考慮。電能供應商采用二次運行成本函數,如式(3)所示;以效益最大化構建決策目標,如式(4)所示。

式中:fe(t)為t時刻電能供應商運行成本;Ue為電能供應商的效益函數;be和ce分別為電能供應商考慮運行成本的一次項系數和常數項,均為不小于0的常 數;cnet為過網費 用;T為24 h總時 段 數;Δt為1 h時間長度。

2.1.3.2 天然氣供應商

1)投標價格制定

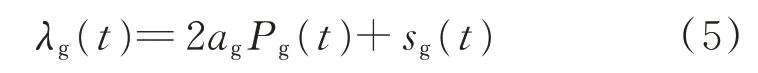

鑒于本文天然氣供應商并非大型天然氣交易商,而是擁有配氣站的區域天然氣供應商,故而出于對上述電能供應商價格制定的考慮,天然氣商也采用相似方式,其功率-價格曲線如式(5)所示。

式中:λg(t)為t時刻天然氣出售價格;ag為天然氣供應商考慮運行成本的二次項系數;Pg(t)為t時刻天然氣供應商出售功率;sg(t)為天然氣供應商的功率-價格曲線截距。

2)效益函數

天然氣供應商在滿足用戶需求前提下應盡可能提升自身效益,其成本函數如式(6)所示,目標函數如式(7)所示。

式中:fg(t)為t時刻天然氣商運行成本;Ug為天然氣供應商的效益函數;bg和cg分別為天然氣供應商考慮運行成本的一次項系數和常數項,均為不小于0的常數。

2.1.4 競價決策約束條件

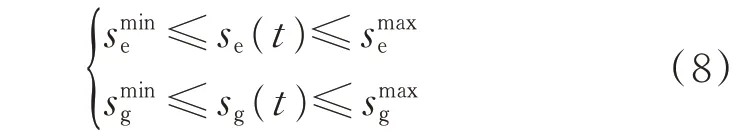

1)價格截距約束

價格截距約束既要考慮削價影響市場交易秩序不可過低報價,又要遵守市場規定不可過高報價。

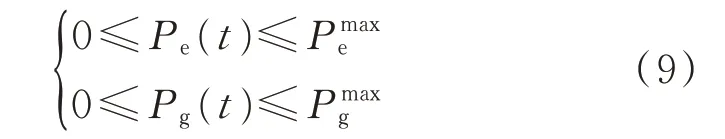

2)投標容量約束

能源供應商向綜合能源市場服務商提供能源,其值不小于0,也不大于供應商機組出力容量限制。

2.2 市場出清層

2.2.1 市場出清決策模型

相較于競價決策層寡頭博弈,市場出清層中園區IES數量較多,結構規模相對簡單,致使存在以下問題。

1)部分園區IES不滿足市場準入條件,無法進入市場交易。

2)所有園區IES參與市場交易導致市場參與者過多,難以管理。

故而采用市場分層管理模式,暫不考慮單一園區IES策略性投標,而是將多個園區IES經由Energyhub形式構建成一個聚合IES,該IES參與競價博弈-市場出清雙層模型優化求解;其次聚合IES內部存在能源分配環節,將獲得的能源按策略分配給各個園區IES。

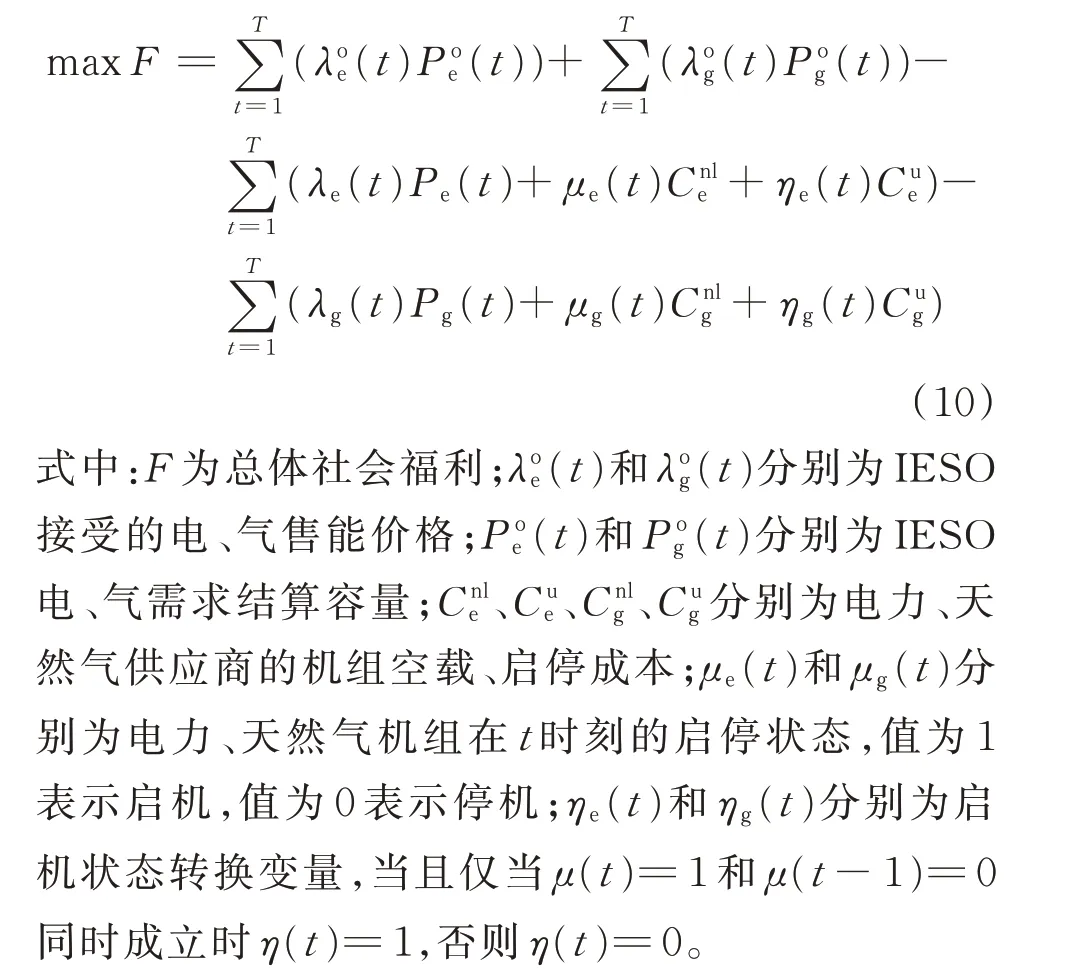

在此基礎上,電-氣綜合能源市場服務商匯集各參與主體投標信息,以最大化電、氣供需總體社會福利作為市場出清目標。

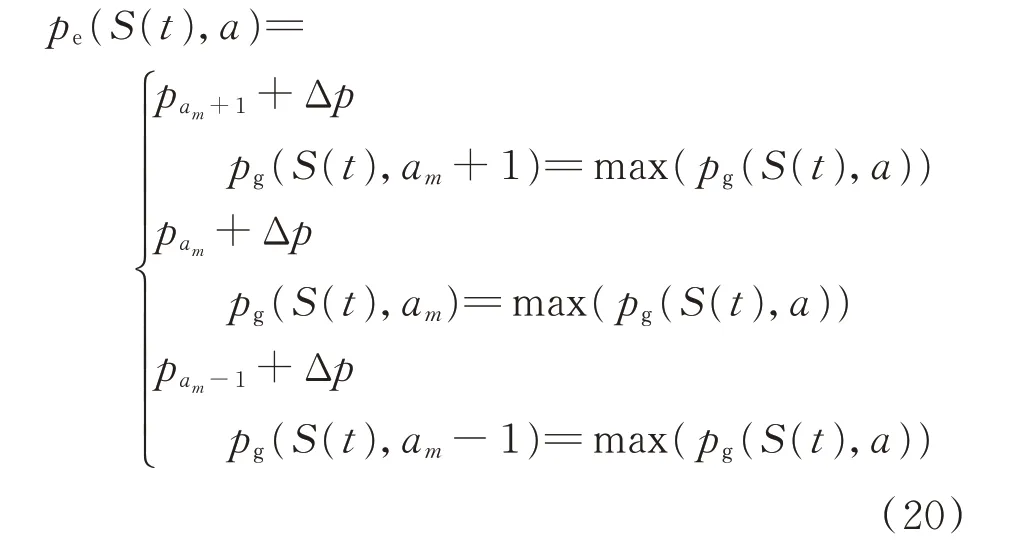

2.2.2 市場出清約束條件

1)電力供需約束

式中:Ns為聚合的園區IES個數;De,s(t)為t時刻第s個IES短期電力負荷預測;Pmaxe,l為輸 電線路 最大輸送功率。

2)天然氣供需約束

在競價決策層中考慮式(3)和式(6)引入能源供應商二次非線性成本函數;在市場出清層中考慮式(10)、式(16)至式(18)引入機組決策變量非凸特性,致使傳統求解算法具有一定困難,故而本文采用了多智能體Nash-Q強化學習算法。

3 多智能體Nash-Q強化學習求解流程

3.1 應用框架

將多智能體強化學習與博弈理論相結合,采用多智能體Nash-Q強化學習構建電-氣綜合能源市場多參與主體競價博弈應用框架,如附錄A圖A1所示。

首先利用歷史統計數據構建模擬環境,基于Nash-Q強化學習算法對多智能體進行預訓練,初步建立智能體對環境的認知和決策能力;其次借助文獻[23]遷移學習將學習到的經驗庫遷移到實際環境中,提高智能體對實際環境的快速適應和準確決策能力。同時可利用實際環境數據定期更新經驗庫,持續優化智能體Q表,不斷強化智能體實時決策性能。

3.2 學習過程

3.2.1 聯合狀態空間

區別于單一智能體強化學習,多智能體Nash-Q強化學習需通過聯合狀態空間表示,將電能、天然氣供應商價格截距se(t)和sg(t)作為狀態變量,依據文獻[24]將其離散化為區間形式,每段區間定義為一個狀態,可確定多智能體聯合狀態空間S(t)={se(t),sg(t)}。

3.2.2 聯合動作空間

動作主要表現為能源供應商售能價格調整,依據市場運營限定的售能價格上下限,以步長為1在上一輪售能價格基礎上浮動,第m+1次博弈過程中可選擇動作集合Am+1={am-1,am,am+1},其中am表示第m次博弈過程所選動作。

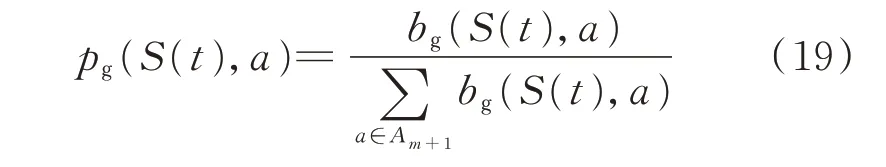

實際交易過程為不完全信息下非合作博弈,故而動作選擇策略采用競爭對手歷史數據描述。以電能供應商為例,假設bg(S(t),a)為天然氣供應商在聯合狀態S(t)下采取動作a(a∈Am+1)的歷史次數,則天然氣供應商選擇動作a的概率為:

電能供應商依據聯合狀態S(t)以及預測對手動作來調整自身動作選擇概率,規則如下:

式 中:pam+1、pam、pam-1分 別 為 電 能 供 應 商 選 擇am+1、am、am-1動作的基礎概率;Δp為概率調整常數。

依據當前聯合狀態和動作選擇策略即可確定聯合 動 作 空 間AS(t)={ae,S(t),ag,S(t)},其 中ae,S(t),ag,S(t)∈Am+1分別為聯合狀態S(t)下電能、天然氣供應商所選動作。

3.2.3 獎懲機制能源供應商對交易過程持續學習以優化各自效益函數,將供應商效益函數最大化轉化為強化學習獎勵最大化形式,可表示為:

3.2.4 Nash-Q函數更新

多智能體強化學習依賴博弈Nash均衡結果,在Nash均衡中每個智能體的策略對于其他智能體都是最佳反應,在聯合狀態S(t)下有:

式中:α為學習步長;QNash,e(S(t+1))為電能供應商在聯合狀態S(t+1)下根據所選擇Nash均衡策略得到的收益;←表示更新Q值。

3.2 .5學習流程

競價決策層屬于復雜優化決策問題,采用多智能體Nash-Q強化學習求解;市場出清層屬于線性問題,借用求解器Cplex計算。具體求解流程和步驟如附錄A圖A2所示。

4 算例分析

4.1 算例概況

在Python編譯環境中構建模型,數據來源于國內某重點項目園區,其中以Energyhub形式構建的IES見附錄A圖A3,電、熱、氣負荷需求曲線見圖A4;光伏、風電日前預測出力曲線見圖A5;IES所含設備類型和參數見附錄B表B1;設備運行維護費用見表B2;能源供應商運行成本系數見表B3;多智能體Nash-Q強化學習算法參數見表B4。強化學習訓練數據通過設定不同的能源供應商初始狀態持續與環境交互來模擬獲得。以1 h為一個時段進行日前市場交易決策與電、熱、氣供需平衡分析。

4.2 預學習結果分析

4.2.1 Nash均衡存在性證明

在預學習過程中能源供應商不斷交互,不同能源供應商的Q值Qe和Qg最終會收斂到Nash均衡,具體Nash均衡證明過程詳見附錄C。

4.2.2 預學習結果分析

1)競價決策博弈分析

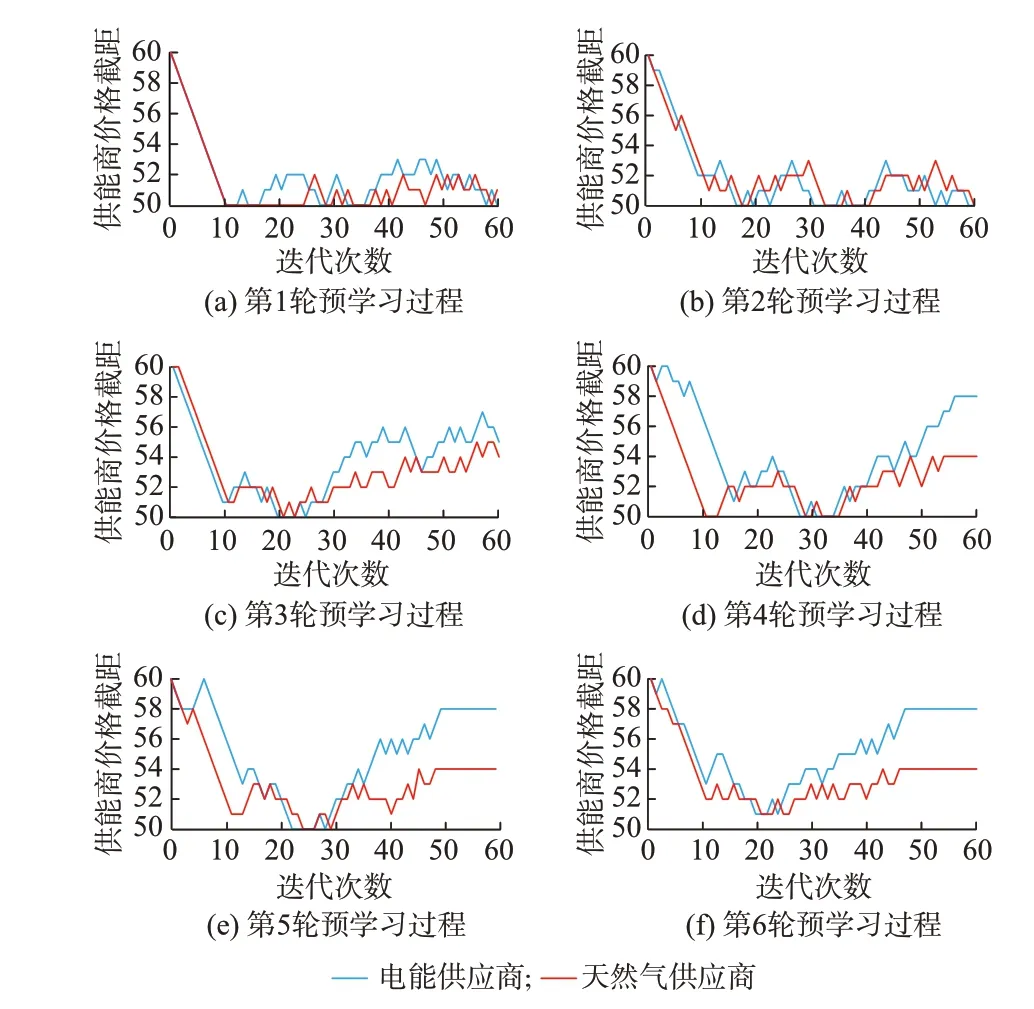

以第10 h為例進行電能、天然氣供應商競價博弈分析,該時刻IESO聚合的電負荷為6.69 MW,熱負荷為3.44 MW,氣負荷為3.19 MW。進行6輪博弈,每輪博弈60次,將天然氣等效轉化為電能形式結算后供應商價格截距博弈情況如圖2所示。Nash-Q強化學習過程中對應的Q表迭代完善情況如附錄A圖A6所示。

圖2 能源供應商競價博弈過程Fig.2 Bidding game process of energy suppliers

第1、2輪博弈中由于信息不完整,智能體僅能依據聯合狀態和對手歷史數據做出自身最佳動作策略選擇。隨著博弈的進行,雙方均增大了己方降低價格動作的概率,最終在低價格區間內競價博弈,此時雙方希望通過降價搶占市場來獲得利潤。經過盲目降價搶占市場后,強化學習獎勵值較低,供能商盈利處于較低水平,故而智能體在隨后第3輪學習過程中嘗試提高價格,但鑒于此階段智能體Q表尚未完全建立,無法經由Q表指引競價尋優,致使策略選擇波動性較大,并未達到均衡穩定。

隨著博弈的進行,智能體不斷與外界環境進行交互,逐漸完善Q表,初步建立起對環境的認知和決策能力,可通過環境反饋調整自身策略,故而在第4、5、6輪博弈初始階段智能體通過降低價格以求獲得利益失敗后能夠立即提高價格并分別于第54、50和46次博弈時達到Nash均衡,此時電能供應商策略為se=58,將天然氣等效轉化為電能形式結算后天然氣供應商策略為sg=54。

2)市場出清分析

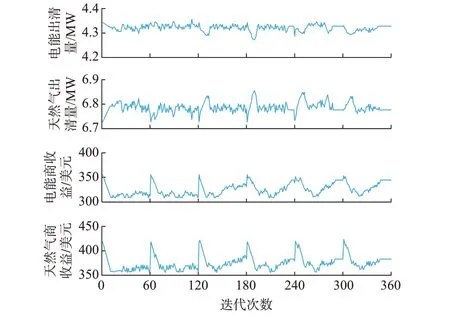

經競價決策-市場出清后能源供應商收益與出清量收斂情況如圖3所示。

圖3 市場出清迭代收斂過程Fig.3 Iterative convergence process of market clearing

可知博弈雙方收益均受對方策略影響,供應商通過調整se和sg來改變功率-價格曲線,其收益從較大波動逐漸到達均衡點。初始階段各供應商趨于降價,搶占市場獲益,故而在該階段內供應商收益波動較大且出現收益下降,但隨著博弈進行各供應商在各自輪次優化自身策略可明顯改變收益分配,提高自身收益,當任意供應商難以獨自改變收益格局時逐步收斂,策略接近均衡策略。此時電能供應商電能售價為203.59美元/(MW·h),出清量為4.33 MW;收益為344.38美元。天然氣供應商將博弈價格轉換為天然氣售價后為144.94美元/(MW·h),出清量為6.78 MW,收益為383.09美元。

4.3 在線應用

4.3.1 在線應用結果分析

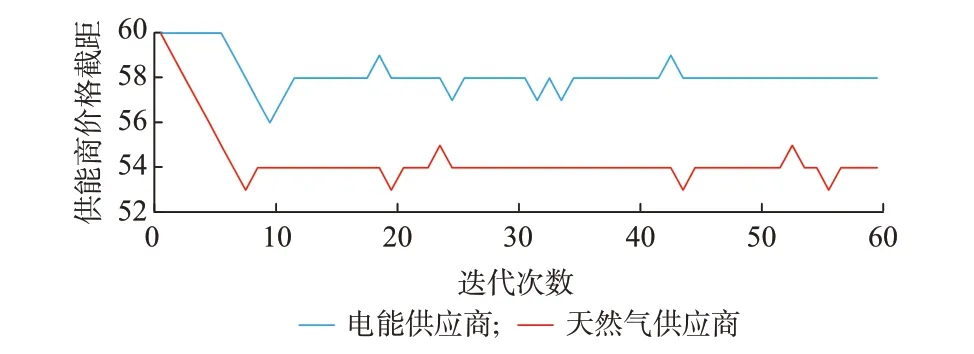

為進一步驗證方法的在線決策能力,選擇另外某一時刻,該時刻聚合后的電負荷為6.12 MW,熱負荷為4.03 MW,氣負荷為2.61 MW。經遷移學習計算新、源任務動態歐氏距離可知,新任務與源任務可劃歸為同一類型。故而可采用預學習階段已經訓練好的智能體對該時刻競價環節進行博弈分析,能源供應商在線應用競價博弈過程如圖4所示,Q表迭代完善情況如附錄A圖A7所示。

圖4 能源供應商在線應用競價博弈過程Fig.4 Bidding game process of energy suppliers in online application

由圖4可知,智能體在博弈11次時即可達到收斂,在此后過程中智能體仍舊嘗試通過改變自身價格來提高收益,但簡單嘗試后便會回歸穩定。因為經預學習后智能體Q表已訓練充分,具備了一定的環境認知和決策能力,在線學習過程中再次遇到相似任務時可在Q表指引下快速做出自身博弈策略調整。

4.3.2 基于Nash均衡的IES能源供需平衡分析

考慮到聚合IES能源分配環節并不影響競價博弈-市場出清模型求解結果,為簡化分析選取聚合IES進行電、熱、氣供需平衡分析,以驗證市場博弈Nash均衡解合理性。聚合IES經由Energyhub方式建模,通過市場交易獲得電能和天然氣,可依據價格優勢選擇內部設備進行能源轉化與利用。24 h能源供應商售能情況和基于Nash均衡的IES電、熱、氣供需平衡如附錄A圖A8所示。

結合圖A4、圖A5和圖A8分析可知,22:00—07:00時段風電出力較大,超出電負荷需求,IES可利用電轉氣(P2G)設備將多余電量轉換以彌補氣負荷需求,此時無須過多向能源市場購買能源,供應商售能均處于較低水平。在10:00—22:00時段光伏和風機總體出力較小,但用戶電負荷需求較大,依據市場博弈可知此時氣價更便宜,IESO更趨向于購買天然氣,利用熱電聯產(CHP)機組產電、產熱。在07:00—10:00時段用戶電、氣需求呈上升趨勢,此時IESO趨于削減天然氣購買,而加大電能購買,經由電轉熱(P2H)設備彌補熱需求。博弈過程中IESO可依據市場博弈Nash均衡結果及時調整外部購能計劃,并優化內部設備出力,經過多次博弈后可獲得較為合理的Nash均衡解和機組出力結果。

4.4 算法性能對比

4.4.1 計算精度對比

為驗證本文方法求解綜合能源市場多參與主體競價博弈問題的優勢,與數學推導方法(以對角算法為例)、啟發式算法(以粒子群算法為例)進行對比分析,并設置以下2種情形。

情形1:簡化模型非凸非線性屬性,在完全信息環境下進行市場交易競價博弈。

情形2:考慮模型非凸非線性屬性,在不完全信息環境下進行市場交易競價博弈。

4.4.1.1 情形1

附錄B表B5基于3類算法對比分析能源供應商收益,可知對角算法利潤最大,因為在完全信息與簡化模型情況下原始的雙層優化問題經由KKT條件轉換為單層封閉形式的優化問題,可使用商業優化求解器有效解決。同時可知多智能體Nash-Q強化學習方法獲得的利潤與對角算法非常接近,電能、天然氣供應商利潤僅低了2.39%、3.14%;而粒子群算法結果與其他2種算法有所差距。

4.4.1.2 情形2

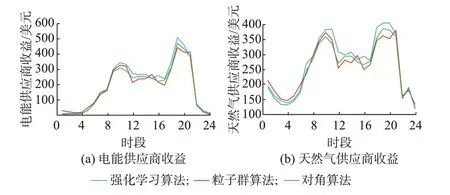

圖5對比分析基于不同算法的能源供應商24 h收益。附錄B表B6對比了不同算法在連續時刻下詳細出清結果。

圖5 基于不同優化算法的能源供應商24 h收益Fig.5 24 h income of energy suppliers based on different optimization algorithms

1)初期IES內部風電出力較大,可將多余電量轉換以彌補氣負荷需求,此時無須過多購買能源;同時鑒于初期歷史數據匱乏,不易采用競爭對手歷史數據預測其動作選擇概率,因此3類算法優化結果相似。

隨著博弈的進行,3類算法出現差異,以10 h為例,對角算法中電能、天然氣供應商投標價格分別為195.61美 元/MW、141.77美 元/MW,收 益 為309.48美元、359.33美元,比粒子群算法收益分別減少了5.41%、3.73%,比Nash-Q強化學習算法分別減少了10.13%、6.21%。由此可知,供應商仍有改變售能價格提升自身收益的空間,該解并非實際問題Nash均衡解。因為在不完全信息環境下參與主體不會將自身報價過程、運行成本、收益函數等信息公布;同時考慮參與主體非凸非線性屬性,使得實際交易為復雜優化決策問題。在此情況下對角算法并不直接適用,簡化處理后會產生建模殘差持續影響智能體策略選擇,在沒有人為修正的情況下無法形成持續優化閉環,只能獲得大致反映市場交易結果的優化解。

對12 h分析可知,粒子群算法中電能、天然氣供應商投標價格分別為171.39美元/MW、128.35美元/MW,收益分別為214.15美元、254.25美元。與其余2種算法以及自身10 h、11 h結果相比具有明顯差異,因為粒子群算法雖然對模型要求相對較低,但本質上是一種隨機搜索算法,在優化過程中初值與隨機性設置不當易陷入局部最優解;在未設置跳出機制情況下會逐漸收斂于局部最優解,與實際Nash均衡解產生差異。

2)分析所選3個連續時刻與全天收益可知,Nash-Q強化學習算法在每個時刻所得Nash均衡解相比其余2種算法更加精確;同時3個連續時刻所得電能供應商和天然氣供應商的總收益相較于對角算法、粒子群算法分別提升了11.12%、8.91%和11.30%、10.05%。

相比之下經由多智能體Nash-Q強化學習得到的供應商收益更高,其優勢在于不完全信息環境下可通過歷史數據預測對手動作選擇概率,進而調整自身策略;求解過程中對模型依賴程度較低,即便模型因簡化處理存在建模殘差,仍可通過在環境中反復探索與試錯方式更新自身策略,逐漸減少殘差對決策影響,形成持續優化閉環。強化學習算法也展現良好的記憶性和演化性,不會像其他2種算法一樣貪婪地追求靜態時間斷面上的最優操作,智能體會學習市場交易演化過程以獲得長遠收益。

4.4.2 計算量對比

在同等計算資源下對比3類方法在線應用環節計算量,以收斂累計時間、迭代次數以及平均計算時間3個指標表征計算量,附錄B表B7對比分析了在線應用環節的3個指標。

由表B7可知,在線應用環節3個指標下粒子群算法均處于最高,對角算法次之,Nash-Q強化學習算法最低。針對算例涉及的復雜優化決策問題,粒子群算法為保證解的有效性,須產生大量粒子,經反復迭代搜索才能找到最優解;對角算法求解過程中仍須固定一個智能體競價策略來尋找另一個智能體的最優競價策略,并經由多個智能體反復迭代。上述2種方法均須迭代計算才能求得最優解,同時不具有記憶特性,每次優化求解都是一次全新過程,無法利用歷史數據作為指導,致使在線應用求解速度較為緩慢。

相比之下Nash-Q強化學習算法具有記憶特性,預訓練后Q表已經具備了指導交易行為的功能,在線應用中可依據實際交易情形調用Q表尋優,無須迭代計算,明顯減少了計算量與計算時間。同時在線應用交易數據可持續優化Q表,不斷強化智能體實時決策性能,具有更高的實際應用價值。

5 結語

本文構建了“競價決策-市場出清”綜合能源市場交易框架,經由“離線訓練+在線應用”方式驗證了多智能體Nash-Q強化學習方法的有效性,最后經由算例分析得出如下結論。

1)基于Nash-Q強化學習方法構建的智能體可在不完全信息環境中通過反復探索與試錯方式求解綜合能源市場交易博弈問題。

2)多智能體Nash-Q強化學習方法與數學推導算法、啟發式算法相比,在求解精度和時間方面具有更高的實際應用價值。

隨著人工智能技術不斷發展,使用人工智能進行能源市場交易決策必將得到越來越多的重視。未來可在本文基礎上,進一步研究多智能體深度強化學習在綜合能源市場交易領域中的應用。