基于改進RetinaNet的自然環境中蝴蝶種類識別

謝娟英 魯銀圓 孔維軒 許升全

1(陜西師范大學計算機科學學院 西安 710119) 2(陜西師范大學生命科學學院 西安 710119)

蝴蝶是節肢動物門、昆蟲綱、鱗翅目、錘角亞目動物的統稱[1],在全世界有廣泛分布,約有18 000種[2].蝴蝶對環境敏感,有些蝴蝶幼蟲以植物為食,危害經濟作物,借助蝴蝶分布可研究區域生態環境保護和生物多樣性[3].本文借助2018年第3屆中國數據挖掘競賽——國際首次蝴蝶識別大賽[4]公開的蝴蝶圖像數據集[5],通過改進經典RetinaNet[6],實現自然環境中蝴蝶種類識別.

快速發現野外環境中蝴蝶位置,實現蝴蝶分類,已經引起計算機視覺領域研究者的關注.然而,現有蝴蝶分類研究主要基于蝴蝶標本照片.2011年,Wang等人[7]借助1 333張蝴蝶標本照,采用基于內容的圖像檢索技術,通過不同特征提取方法和特征權重設置,使用不同的相似性匹配算法進行消融實驗,驗證了蝴蝶形狀特征對分類更重要.2012年,Kang等人[8]使用包含7個種類的268張蝴蝶標本照,設計特征提取器,提取圖像中的分支長度相似性特征,設計3層神經網絡進行蝴蝶分類,得到85.6%的準確率.2014年,Kaya等人[9]基于包含14種蝴蝶的140張蝴蝶標本照數據,通過設計特征提取器,將顏色和紋理特征融合,使用3層神經網絡分類,得到92.85%的準確率.Kaya等人[10]還分別使用灰度共生矩陣和局部二值模式,采用極限學習機對包含19種蝴蝶的190張標本照進行分類,分別得到98.25%和96.45%的準確率.2014年,Kang等人[11]通過提取不同視角下的圖像分支長度相似性特征,利用3層神經網絡對含有15種蝴蝶的150張標本照進行分類,得到97.85%的準確率.2015年,Kaya等人[12]提出2種新的描述子提取局部二值模式,處理圖像中的紋理特征,對包含14種蝴蝶的140張蝴蝶標本照,利用3層神經網絡進行分類,得到95.71%的準確率.2017年,Zhou等人[13]對包含1 117種蝴蝶的4 464張標本照進行數據增強,借助CaffeNet網絡模型進行分類,得到95.8%的準確率.2019年,Lin等人[14]提出新的感知網絡ISP-CNN,用116 208張增強的蝴蝶標本圖像來訓練網絡,實現蝴蝶分類,驗證集準確率達到93.67%,測試集準確率達到92.13%.2020年,Lin等人[15]使用包含56種蝴蝶的24 836張標本照,提出一種帶跳層連接的卷積神經網絡進行蝴蝶種類識別,得到93.36%的準確率.

截止目前,基于自然環境中蝴蝶圖像的蝴蝶種類識別研究相對較少.原因是該類研究非常具有挑戰性.蝴蝶分類的依據是其翅膀的花紋、顏色和圖案,而野外自然環境中的蝴蝶照片,其翅膀往往被遮擋,使得分類依據的翅膀特征不完全可見.另外,該類數據的獲取也非常困難,不僅需要到蝴蝶的棲息地拍攝自然環境下的蝴蝶照片,而且照片中的蝴蝶類標需要非常專業的昆蟲學家才能給出.2018年的第3屆中國數據挖掘競賽——國際首次蝴蝶識別大賽[4]公布了一個自然環境下的蝴蝶標注數據集[5].Xie等人[16]使用深度學習目標檢測框架Faster R-CNN[17]和YOLO系列[18-19],為競賽實現了baseline,最佳mAP=76.1%.2018年,Kartika等人[20]使用包含10種蝴蝶的890張自然環境中蝴蝶圖像,通過掩膜技術過濾自然背景,保留圖像中自然狀態下的蝴蝶,構成實驗數據,通過提取局部二值模式的紋理特征和形狀特征,使用SVM分類,得到66.0%的準確率.2020年,Liang等人[21]通過網絡爬蟲技術采集網絡上的蝴蝶圖像,擴充競賽數據集[4-5],使用集成的YOLOv3[19]對蝴蝶進行自動識別,最佳mAP=79.8%. 2020年,Almryad等人[22]建立一個生態蝴蝶圖像數據集,剔除一些同時包含多個蝴蝶實例的圖像,并只保留樣本數目較多的10類蝴蝶,使用卷積神經網絡(VGG16[23],VGG19[23],ResNet50[24])進行分類,最高mAP=79.5%.2021年,Xie等人[25]為解決蝴蝶識別競賽數據集[4-5]中的蝴蝶類別間不平衡問題,提出一種新的劃分策略和數據平衡擴增策略,得到最佳mAP=79.71%.

自然環境下的蝴蝶識別本質上是一個目標檢測任務,需要首先檢測蝴蝶在圖像中的位置,然后進行分類.目前同時涉及蝴蝶位置檢測與分類的研究只有Xie和Liang的工作[16,21,25],3篇文獻均未達到較高精度.為此,本文將探索和提出更適合自然環境下蝴蝶識別任務的算法模型.RetinaNet模型的Focal Loss[6]有效解決了目標檢測中正負樣本不平衡問題,本文使用的自然環境中蝴蝶數據前景、背景類別極不平衡,且各類別的蝴蝶數量分布呈現極不平衡的長尾分布,因此,選擇RetinaNet為基礎模型.注意力機制[26-29]在計算機視覺領域能顯著提升檢測精度,本文根據蝴蝶數據特點,提出改進的注意力機制來改進RetinaNet模型,增加模型的蝴蝶檢測精度.自然環境中蝴蝶形態多變,本文將在注意力機制基礎上,引入可變形卷積[30-31]提升模型對形變的建模能力,使有效感受野能更好覆蓋前景,囊括更多語義信息輔助檢測,得到性能更優的蝴蝶自動檢測模型.同時,使用類激活圖[32-33]可視化實驗結果,分析提出模型的有效性,并采用相似性可視化探索影響模型性能的關鍵因素.

本文主要貢獻包括:1)對數據集進行了詳細分析,采用K-means確定合適的實驗參數;2)提出新的注意力機制,改進RetinaNet模型;3)引入可變形卷積,增加RetinaNet模型對蝴蝶形變的建模能力;4)將可變形卷積和注意力機制組合,探索自然環境中蝴蝶位置檢測和分類方案;5)可視化實驗結果,分析模型性能提升的原因和影響模型性能的關鍵因素.

1 實驗數據和參數

1.1 數據數量特征

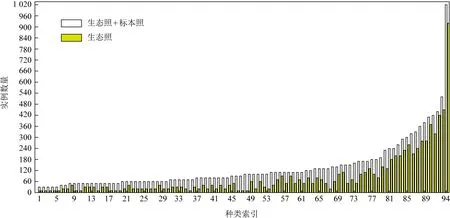

Xie等人[16]得出訓練集中包含測試集類別之外的模式照對最終模型的性能無益,因此本文訓練集只含有測試集對應的94種類別的生態照和模式照.對訓練集采用與文獻[16]相同的擴增方式進行擴增,擴增后的訓練集含12 070張圖像,命名為Butterfly_Data,按照4∶1劃分為訓練子集和驗證子集.測試集命名為Test_Butterfly_Data,含有94類687張蝴蝶自然生態環境下照片.Butterfly_Data實例分布如圖1所示:

Fig.1 The instance quantity distribution of Butterfly_Data圖1 Butterfly_Data數據集蝴蝶實例數分布

從圖1可以看出,本文實驗數據呈現典型的長尾狀分布,不同類別間分布不平衡,一些實例數量比較多的類中,生態照實例超過50%;大部分實例數目較少的類中,標本照的實例數多于生態照的實例數.每張標本照中只含一個實例,每張生態照中可能有多個實例.

整個數據集中實例數量特征如表1所示.表1的最小值列和最大值列數據顯示:在生態照、標本照及整個訓練集,均存在較大的類別不平衡.

Table 1 Image Quantity Distribution in Butterfly_Data

1.2 數據幾何特征

借鑒Kozlov[34]的做法,對Butterfly_Data的幾何特征進行統計,結果如圖2所示.

圖2(a)顯示Butterfly_Data數據集圖像寬大于高.圖2(b)顯示數據集圖像高寬比和寬高比以1.0近似對稱.圖2(c)顯示數據集實例寬、高分布類似,但寬大于高.圖2(d)顯示實例寬高比與高寬比關于1近似對稱.圖2(e)顯示,數據集中自然環境下的生態照實例與其所在圖像的面積比和標本照實例與其所在圖像的面積比有顯著差異,生態照實例明顯占比小,說明生態照圖像中有較多背景信息,標本照實例的面積占比幾乎覆蓋整張圖像.另外,圖2(e)還顯示,測試集實例面積占比與訓練集生態照的實例面積占比類似.

Fig. 2 The geometric distribution of Butterfly_Data圖2 Butterfly_Data數據幾何分布

1.3 實驗參數

為了保障檢測精度,RetinaNet[6]根據骨干網絡(Backbone)不同階段的特征圖下采樣比例,設置不同檢測尺寸,每個尺寸通過3種尺度(scale)和3種縱橫比(aspect ratio)組合,以特征圖中每個像素為中心,形成9個不同尺寸的Anchor boxes.然后計算密集Anchor boxes與Ground-truth boxes的交并比(intersection over union,IoU)值,通過設置閾值對Anchor boxes進行正負樣本劃分,作為先驗知識指導網絡訓練.然而,RetinaNet使用的COCO數據集[35]和本文的Butterfly_Data不同,因此,需要對Anchor boxes參數進行調整.

RetinaNet以輸入數據最短邊進行適配縮放.為緩解Butterfly_Data圖像縮放形變,同時避免輸入過大導致顯存溢出,根據圖2(b)顯示的Butterfly_Data圖像的寬高比均值(約為1.5),設定圖像最短邊不低于512像素,最長邊不超過768像素.在此基礎上,根據COCO數據集[35]的實例尺寸劃分方式分析Butterfly_Data的實例尺寸分布,結果如表2所示:

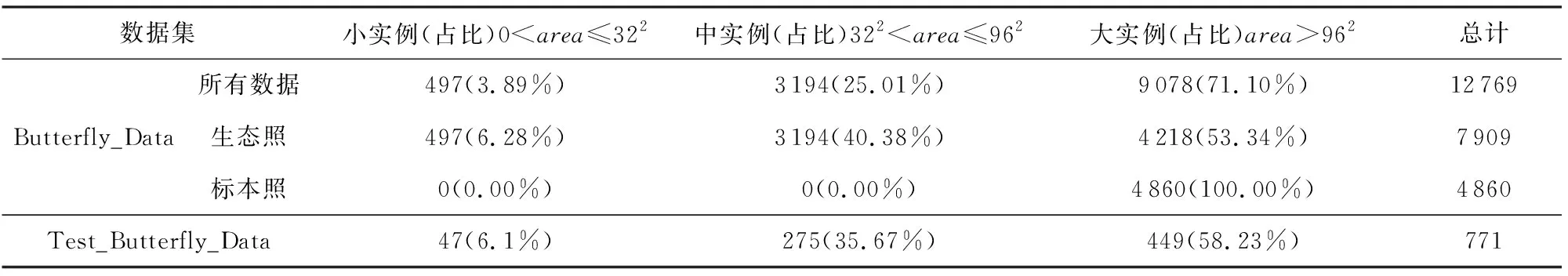

Table 2 The Instance Size Distribution of Butterfly_Data

表2顯示,Butterfly_Data的大實例和中等實例占比之和超過95%,小實例占比為3.89%.Butterfly_Data的大實例樣本超過一半((9078-4218)/9078=53.54%)源于標本照,中等實例和小實例均來自于生態照;Test_Butterfly_Data和Butterfly_Data的生態照實例分布類似.

對Butterfly_Data實例的高寬比進行K-means聚類,類簇數K與原始RetinaNet的縱橫比參數量保持一致,設置為3,聚類結果的簇中心設為Butterfly_Data的最佳縱橫比.根據Butterfly_Data的實例大小情況,將Anchor boxes中的scale范圍偏向小物體.Anchor boxes每個階段的尺寸設置和IoU閾值保留原始RetinNet設置.從而得到本文實驗參數,如表3所示:

Table 3 The Parameter Setting of Anchor Boxes

2 方 法

2.1 Backbone網絡

卷積神經網絡是目前計算機視覺領域的一種主要特征提取技術[23-24,36-45].ResNet[24]的殘差模塊,一定程度上解決了網絡退化問題,使網絡能夠有更深層次,從而提取到更抽象的特征.另外,還有不少ResNet的改進研究[40,46-48].RetinaNet[6]將ResNet作為Backbone.由于Butterfly_Data的生態圖像有較復雜的自然背景,因此,本文選用較深的ResNet[24]以及最新的ResNeSt[48]作為候選Backbone,通過消融實驗,選擇最佳Backbone.

2.2 注意力機制

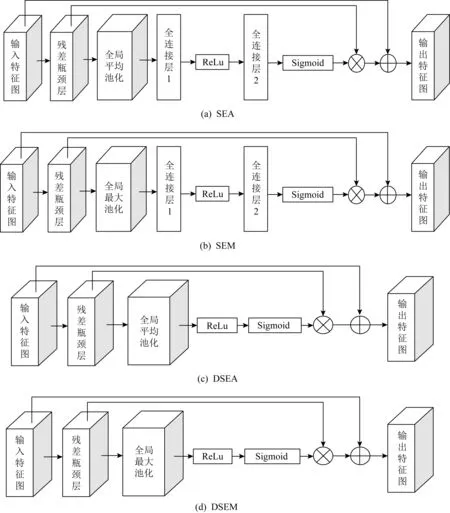

注意力機制是一種資源分配機制,可以發掘原有數據的關聯性,突出重要特征,被計算機視覺領域關注[26-29].SENet[26]是由Hu等人提出的一個網絡架構,是由多個Squeeze-and-Excitation塊堆疊而成(見圖3(a)),本文記為SEA(squeeze-and-excitation with global average pooling),是一種基于特征圖通道的注意力機制,通過Squeeze操作整合特征圖不同通道的全局信息,然后利用Excitation模塊為相應通道的特征加權,強化對任務有效的特征,弱化無效特征.本文Butterfly_Data生態圖像中,圖像大部分內容是自然背景,蝴蝶只占了小部分區域,若在Squeeze操作時,直接考慮特征圖全局信息,背景特征會對蝴蝶有效特征造成干擾,為此,引入最大池化替換Squeeze操作中的全局平均池化,緩解背景干擾問題(見圖3(b)),記為SEM(squeeze-and-excitation with global max pooling).此外,Squeeze-and-Excitation模塊類似編碼-解碼過程,經過Squeeze操作后的通道向量需要經過Reduction Ratio為16的2層全連接整合全局信息,全連接參數質量影響Squeeze-and-Excitation模塊的性能,但SENet并沒有對全連接參數質量進行有效約束,直接通過全局損失函數來進行梯度更新.針對此問題,本文提出2種硬注意力機制,分別命名為DSEA(direct squeeze-and-excitation with global average pooling)和DSEM(direct squeeze-and-excitation with global max pooling),將Squeeze操作后的通道向量直接經過ReLu整合,使用Sigmoid輸出對應通道的注意力向量(見圖3(c)~(d)).在RetinaNet的Backbone中分別引入提出的硬注意力機制DSEA和DSEM,提升RetinaNet在自然環境中蝴蝶種類識別的性能.實驗部分將通過消融實驗驗證提出的硬注意力機制DSEA和DSEM的性能.

Fig. 3 The modules of attention mechanism圖3 注意力機制模塊

2.3 可變形卷積神經網絡

在Butterfly_Data中,不同類蝴蝶甚至同一類蝴蝶可能分布在不同自然場景中,在自然環境下呈現多種不同形態,加上照片拍攝條件差異,以及蝴蝶對其生存環境的擬態性,使得蝴蝶位置檢測與分類非常困難.卷積神經網絡具有平移不變性,能夠對簡單規則形態的物體進行有效的特征提取,但對物體一些角度未知的幾何變換,特征提取性能會大打折扣[49].解決該問題的主要方案有2種:1)通過充足的數據增強提升模型泛化性,然而蝴蝶樣本的局限性,無法使模型泛化到一般場景中;2)借助具有幾何不變性的特征提取算法來提取特征,如SIFT(scale-invariant feature transform)[50],DPM(deformable part-based models)[51],STN(spatial transformer networks)[29].然而,方案2中前2種算法為手工設計特征,有局限性,不能滿足對復雜幾何變換的建模,STN體現了空間注意力機制思想,通過學習圖像全局仿射,扭曲特征圖實現圖像特征提取,但無法有效關注局部幾何變換.可變形卷積網絡(deformable convolutional networks, DCN)[30-31]在每個普通卷積采樣點引入偏移量,讓采樣點可以提取不規則的特征,關注物體局部形態變換.因此,將DCN思想引入RetinaNet的Backbone,增強模型提取特征的能力,達到具有競爭力的蝴蝶位置檢測與分類性能.

2.4 類激活映射

模型可視化[32-33,52-55]能直觀反映模型關注的區域,一方面可以驗證模型泛化性能,另一方面可以指導后續研究.類激活映射(class activation mapping, CAM)[55]相比其他可視化研究,能精確突出圖像哪些區域對模型推斷是重要的.但CAM在最后一層卷積特征輸出后,需要添加全局平均池化[56],再訓練微調一個全連接層,經過softmax求得每個類別得分,然后將全連接權重作為類別特征映射權重,在輸入圖像上得到對應類別的激活視圖.Selvaraju等人[32]提出的Grad-CAM不用修改網絡結構,直接通過反傳梯度獲得類別的特征映射權重.Chattopadhyay等人[33]進一步對Grad-CAM進行擴展,提出Grad-CAM++,適配圖像中有同類多目標的情況.本文將Test_Butterfly_Data的部分預測結果使用Grad-CAM++可視化.

2.5 方法框架

本文方法的整體框架如圖4所示,其中si(i∈{3,4,5,6,7})表示RetinaNet中第i階段的特征圖,K代表類別數(本文K=94),A代表特征圖中每個像素對應的Anchor boxes數量(本文A=9).從圖4可見,本文在RetinaNet模型框架的基礎上,分別采用4種不同的Backbone網絡結構進行實驗,并將網絡輸出結果進行類激活可視化.

Fig. 4 The framework of the methods in this paper圖4 本文方法整體框架圖

3 實驗結果與分析

通過3.1節實驗比較,選擇以ImageNet[57]預訓練的RetinaNet的ResNet50為Backbone,實驗代碼基于Detectron2[58].在訓練和測試階段,設置最短邊為512像素,Anchor機制中包含3個scales和3個aspect ratio.使用隨機梯度下降算法更新參數,初始學習率為0.001,每5輪學習率減半,動量項權重為0.9,權重衰減系數為0.000 2,訓練初期,熱身訓練迭代1 000次,學習率線性增大.實驗操作系統為Centos 7.8,使用單個GPU Nvidia GeForce RTX 2070 SUPER訓練模型,在損失函數和驗證子集性能變化不顯著時,停止模型訓練.

3.1 Backbone選擇實驗

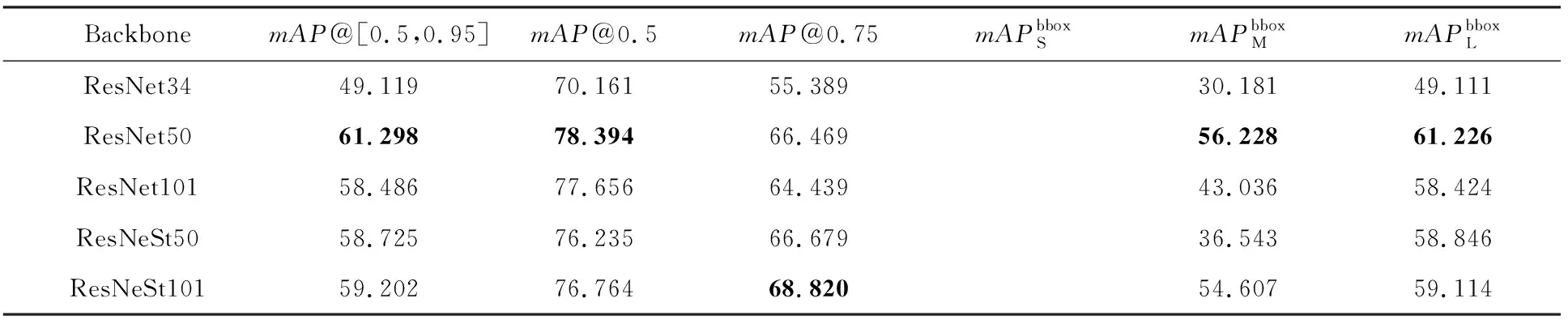

分別將ResNet34,ResNet50,ResNet101,ResNeSt50和ResNeSt101作為RetinaNet的Backbone,Anchor boxes參數設置為表3的RetinaNet配置,Test_Butterfly_Data在各模型的測試結果如表4所示.

表4實驗結果顯示,對野外環境下的蝴蝶識別任務,ResNet50作為Backbone時,RetinaNet取得了綜合最優的性能,除了mAP@0.75指標不是最優外,在其余各指標均取得最優值.因此,本文實驗選用ResNet50作為Backbone.

Table 4 The Results of Test_ Butterfly _Data with Different Backbone in RetinaNet

3.2 實驗參數配置驗證

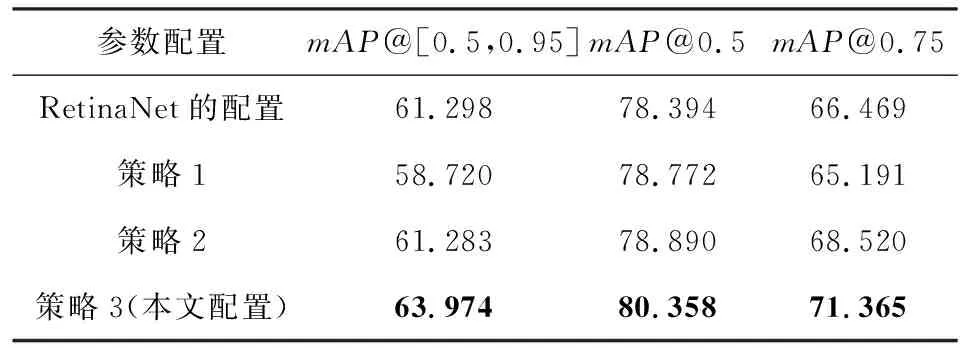

本節將測試表3根據Butterfly_Data中蝴蝶標本照和生態照的幾何特征差異,并鑒于生態照實例的幾何特征,調整原始RetinaNet的Anchor boxes參數,提高ground-truth boxes與anchors的匹配度,提升模型性能的實驗參數設置的合理性.具體策略是:1)將表3原始RetinaNet的Anchor boxes size減半,scale和aspect ratio保持表3的RetinaNet配置不變;2)將表3原始RetinaNet的Anchor boxes size減半,scale和aspect ratio保持表3中我們的配置;3)采用表3中我們的配置參數.表5為上述3種參數設置的消融實驗結果.

表5消融實驗結果顯示,策略1使RetinaNet模型性能僅在mAP@0.5指標有略微的提升,使用更嚴格的mAP@[0.5,0.95]和mAP@0.75評價指標時,原始RetinaNet的默認配置更有優勢,說明Anchor boxes size減半影響模型對Butterfly_Data中大實例的學習.策略2使模型的mAP@[0.5,0.95],mAP@0.5和mAP@0.75指標相比策略1均有提升,特別是在更嚴格的mAP@[0.5,0.95]和mAP@0.75評價指標上比策略1有大的提升,說明本文的scale和aspect ratio參數配置合理且彌補了Anchor boxes size減半帶來的性能退化.另外,策略2相比于原始RetinaNet模型,在mAP@[0.5,0.95]指標性能相當,但在mAP@0.5和mAP@0.75指標優于RetinaNet模型,特別是在mAP@0.75指標比原始RetinaNet有超過2%的提升.表5結果還顯示,策略3采用表3中我們的配置是最優的,模型在mAP@[0.5,0.95],mAP@0.5和mAP@0.75指標均比原始RetinaNet有較大提升.策略3的Anchor boxes size和原始RetinaNet相同,不同的是scale和aspect ratio參數配置,進一步說明本文設置的scale和aspect ratio參數非常合理.綜上關于表5的實驗結果分析可見,本文RetinaNet模型的參數設置(見表3)非常合理.

Table 5 Test Results of Test_ Butterfly _Data for Different RetinaNet

3.3 注意力機制測試

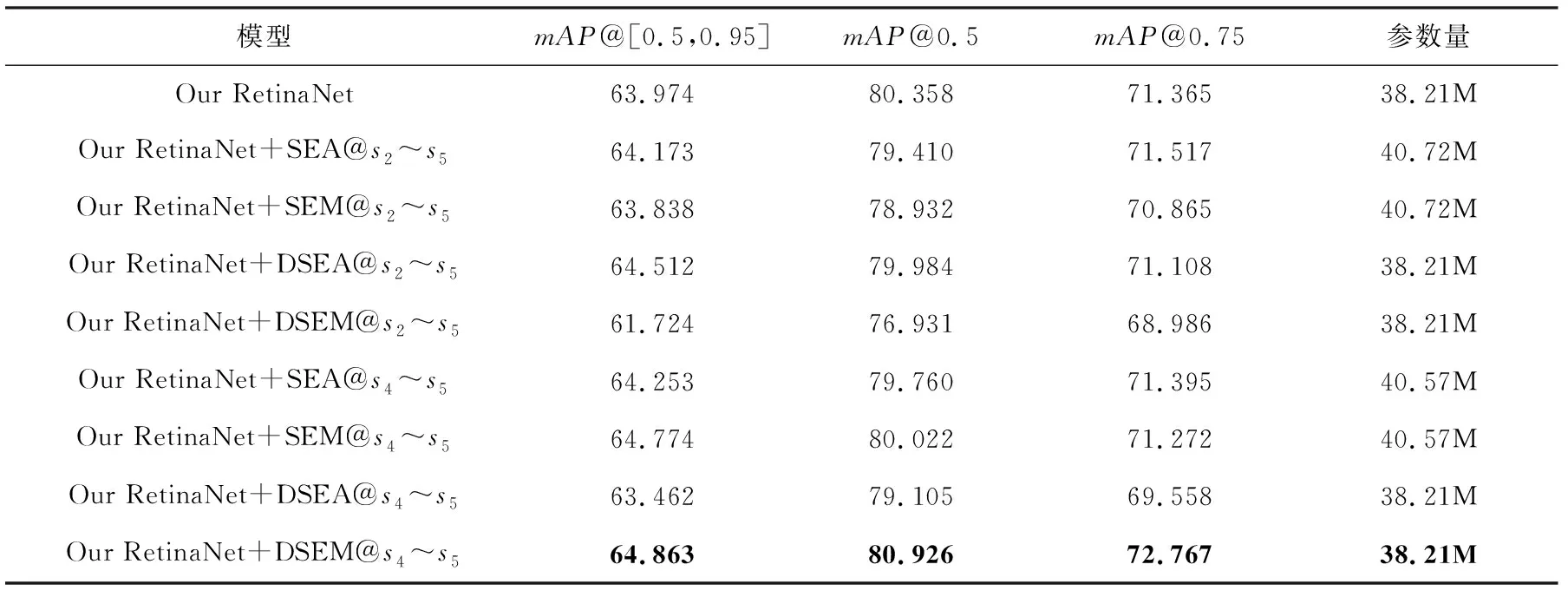

圖2(e)關于實驗數據Butterfly_Data的幾何分布顯示,自然環境中的蝴蝶圖像,蝴蝶實例占整張圖像面積的比例很小,注意力機制可以讓模型更關注實例區域,減小背景信息對目標檢測性能的影響.因此,2.2節在SENet[26]的SEA和SEM注意力機制模塊基礎上,提出2種更符合Butterfly_Data識別的注意力機制模塊DSEA(圖3(c))和DSEM(圖3(d)).本節以圖3的SEA,SEM,DSEA和DSEM注意力機制殘差塊代替ResNet50中的標準殘差塊,使用表3我們的參數配置進行消融實驗,實驗結果如表6所示:

Table 6 The Ablation Experimental Results by Introducing Different Attention Mechanisms in Different Stages of Our RetinaNet Backbone

表6的實驗結果顯示:在我們RetinaNet的Backbone的全階段s2~s5引入SEA或DSEA模塊比引入SEM和DSEM模塊能獲得更魯棒的性能,模型的整體評價指標mAP@[0.5,0.95]得到提升.DSEA模塊在沒有增加參數的情況下,使模型整體性能比引入SEA模塊高出0.528%,說明提出的硬注意力機制對Butterfly_Data的優越性,能非常有效地識別野外環境中的蝴蝶.

此外,淺層特征圖中,模型可能提取不到目標的高級特征,背景特征會有較大特征值,因此,將注意力機制模塊放在模型的后兩階段高層特征層s4~s5,以避免背景特征的干擾.表6后4行的實驗結果表明,在高層特征層,引入SEM和DSEM模塊的模型比引入SEA和DSEA模塊的模型性能更好,說明提出的SEM和DSEM模塊放在高層能學習到目標更高級的特征,且硬注意力機制DSEM比SEM學習的特征更好,在無參數增加的情況下,使模型的性能達到了最大的提升.

表6實驗結果分析可見,硬注意力機制DSEA和DSEM對不同層的特征抽象程度敏感,DSEA適用于包含淺層特征的情況,DSEM更適用于抽象高層特征.我們的RetinaNet在深層引入DESM能獲得非常好的性能,且需要的參數最少.

3.4 可變形卷積性能測試

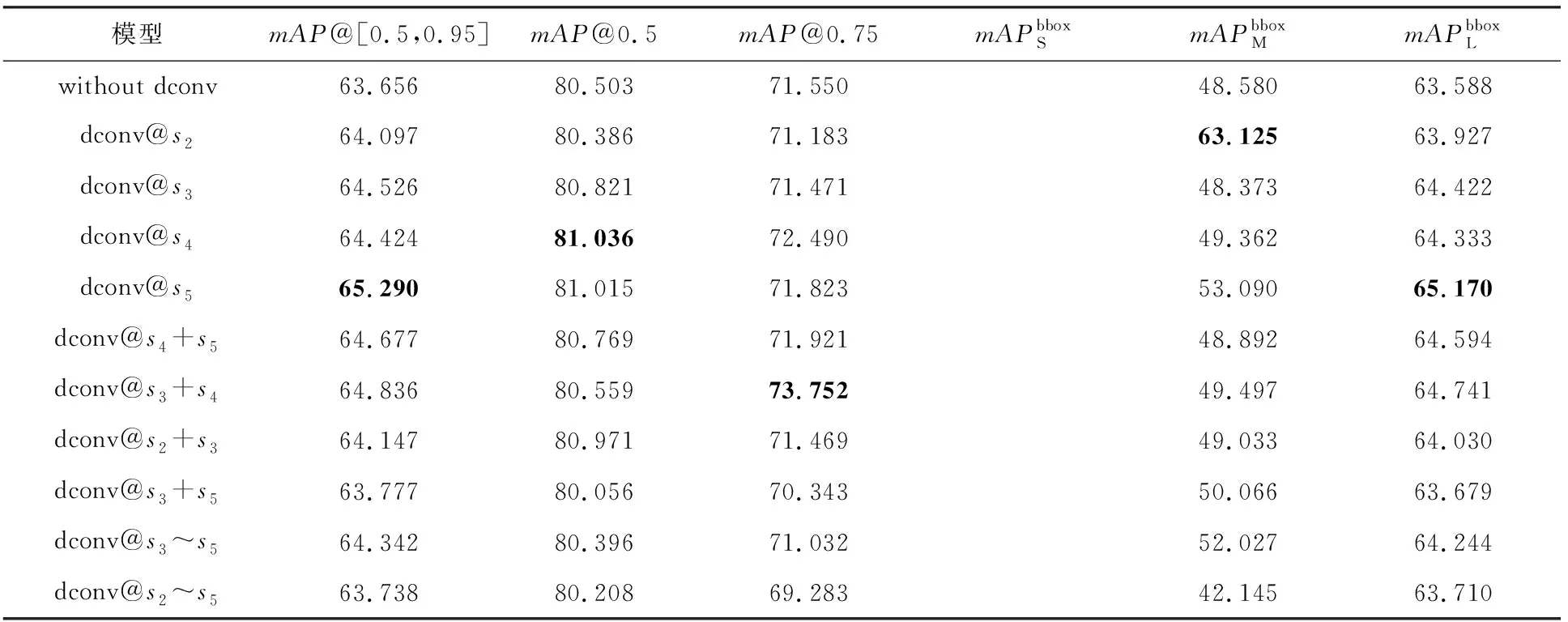

3.3節實驗測試表明在我們的RetinaNet中引入注意力機制,特別是引入提出的硬注意力機制DSEM使得模型的性能大幅提升,但注意力向量考慮了特征圖每個通道的全局特征,沒有考慮特征圖的局部空間信息,因此,本節使用可變形3×3卷積替換普通3×3卷積,以使模型能夠學習到蝴蝶復雜的形態特征.實驗使用我們的RetinaNet作為baseline,將可變形卷積殘差塊替換Backbone不同階段的普通卷積殘差塊,測試可變形卷積對模型性能的影響;并測試將連續兩階段普通卷積用可變形卷積替換對模型性能的影響;以及將不連續兩階段的普通卷積替換為可變性卷積的模型性能,甚至將Backbone第2~5階段的普通卷積全部替換為可變形卷積時的模型性能.消融實驗結果見表7.

表7實驗結果顯示:引入可變形卷積后,模型的性能得到提升,這是因為可變形卷積在特征提取時考慮了特征圖的局部空間特征.然而,在不同層引入可變形卷積的效果不同.在深層s5引入可變形卷積的綜合效果最佳;在連續2層引入可變形卷積,模型所獲得的性能提升介于分別在2個單層引入可變形卷積獲得的性能提升之間;在連續多層引入可變形卷積并沒有帶來模型性能的提升,特別是當s2~s5層全部引入可變形卷積,模型性能與使用普通卷積獲得的性能類似.由此可見,可變形卷積對自然環境中的蝴蝶識別不像對COCO數據集那么有效.分析原因可能是:1)自然環境中的蝴蝶識別是細粒度分類,不同類別蝴蝶形態差異小且類間樣本分布極不平衡,不足以訓練多階段的可變形卷積殘差模塊;2)自然環境中的蝴蝶圖像包含豐富的背景,可變形卷積在淺層特征中容易關注過多背景特征.

Table 7 The Ablation Experimental Results of Introducing DCN Module in Our RetinaNet

由此可見,可變形卷積不需要太多引入,只需要在高層引入可變性卷積即可較大幅度提升模型性能.

3.5 可變形卷積結合DSEM的實驗測試

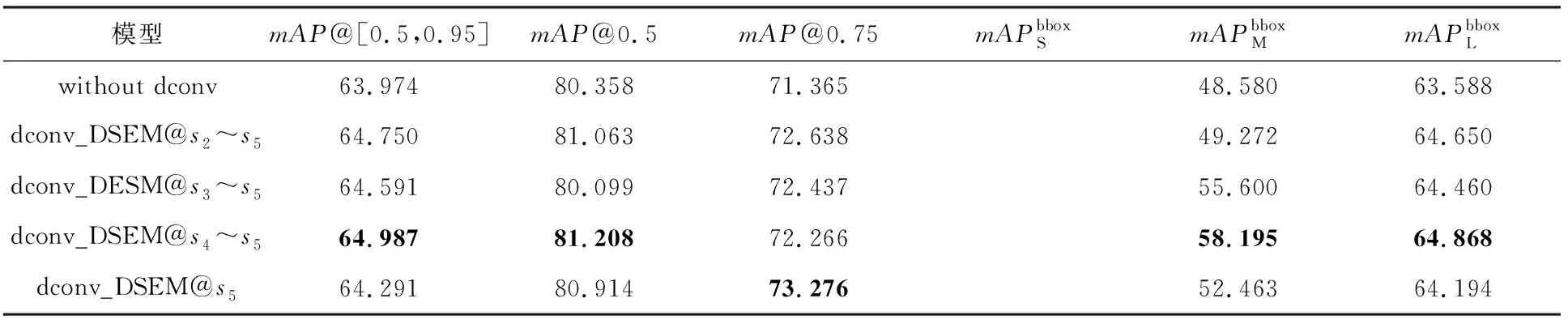

3.3節驗證了提出的DSEM模塊的優越性能,本節將DSEM添加到包含可變形卷積的我們的RetinaNet的Backbone,對可變形卷積殘差塊輸出的不同通道特征進行進一步篩選.用dconv_DSEM@si表示在Backbone第i階段引入帶有DSEM的可變形卷積殘差模塊,dconv_DSEM@si~sj代表在Backbone第i~j階段引入帶有DSEM的可變形卷積殘差模塊,其他階段均為普通卷積殘差模塊.消融實驗結果如表8所示:

Table 8 The Ablation Experimental Results by Introducing DCN with DSEM Module in Our RetinaNet

表8消融實驗結果顯示,在mAP@0.75這種更嚴格的評價指標下,將DSEM添加到s2~s5階段的可變形卷積,對可變形卷積殘差塊輸出的不同通道特征進行篩選,可使模型的性能大幅提升,優于沒有可變形卷積的RetinaNet模型,也優于在對應階段僅加入可變形卷積(表7實驗結果:69.283%)或者DSEM模塊(表6實驗結果:68.986%)的模型性能.根據表8的模型整體評價指標mAP@[0.5,0.95]可見,加入帶有DSEM的可變形卷積殘差模塊,不僅彌補了DSEM對特征層級敏感的不足,也增強了可變形卷積的魯棒性.對比表7的實驗結果可見,DSEM結合可變形卷積殘差模塊應用在Backbone的第5階段,模型的整體性能mAP@[0.5,0.95]=64.291%低于該階段僅用可變形卷積的效果(表7實驗結果:65.290%),說明在較高抽象特征層,使用可變形卷積能提取更有效的特征,若再經過通道特征篩選,可能造成有效特征丟失,但從較嚴格的評價指標mAP@0.75可以看出,加入帶有DSEM的可變形卷積殘差模塊,可以讓模型對預測框的回歸更好.

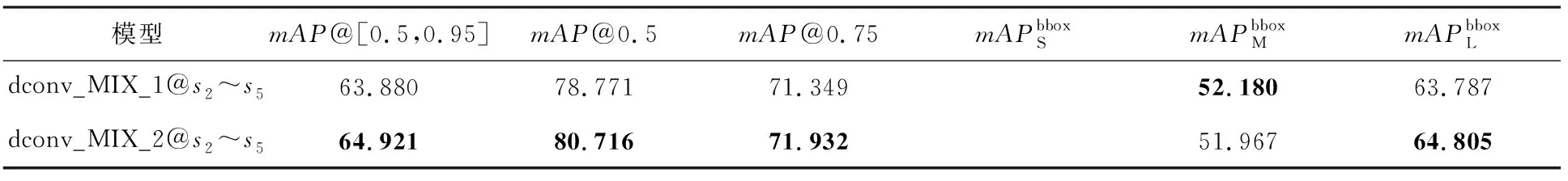

在此基礎上,組合DSEA和DSEM兩個硬注意力模塊,在Backbone網絡淺層(2~3階段)引入帶有DSEA的可變形卷積殘差模塊,深層(4~5階段)引入帶有DSEM的可變形卷積殘差模塊,該模型記為dconv_MIX_1@s2~s5;并與淺層(2~3層)只引入可變形卷積殘差模塊,深層(4~5層)引入帶有DSEM的可變形卷積殘差模塊的網絡模型進行對照,該模型記為dconv_MIX_2@s2~s5.消融實驗結果如表9所示.

表9實驗結果顯示,模型第2~3階段僅使用可變形卷積殘差模塊,4~5階段使用帶有DESM的可變形卷積的效果優于第2~3階段使用帶有DSEA的可變形卷積殘差模塊,4~5階段使用帶有DESM的可變形卷積模塊.

Table 9 The Ablation Experimental Results by Introducing DSEA+DSEM Module in Our RetinaNet

綜合3.2~3.5節的實驗結果可見,為實現自然環境中的蝴蝶識別,ResNet50是合適的網絡結構,根據Butterfly_Data的幾何特征,調整RetinNet的Anchor boxes參數可得到很好的蝴蝶識別模型,在此基礎上,引入注意力機制、可變形卷積及兩者的組合,可得到更優的預測模型.mAP@[0.5,0.95]整體評價指標最優為65.290%(表7),mAP@0.5指標最優為81.208%(表8),mAP@0.75指標最優為73.276%(表8).對比僅使用單一mAP@0.5作為評價指標的Xie等人[16]的最優結果76.1%、Liang等人[21]的最優結果79.8%和Xie等人[25]的最優結果79.71%,本文取得了該領域最好的實驗結果81.208%(表8),且采用了更全面的評價指標.

需要說明的是,由于不同評價指標設置的IoU閾值不同,使得各項指標未必在同一網絡結構同時取得最優值,IoU閾值設置越高,對應的mAP值則越低;不同指標還存在一定局限性;另外,不同網絡結構對同一數據集提取的特征會存在差異,直接或間接影響模型的各評價指標值.各項指標對比發現,模型dconv_DSEM@s4~s5(表8)是本文最佳的網絡結構,在野外環境的蝴蝶識別任務中取得了最好的性能.

3.6 實驗結果可視化分析

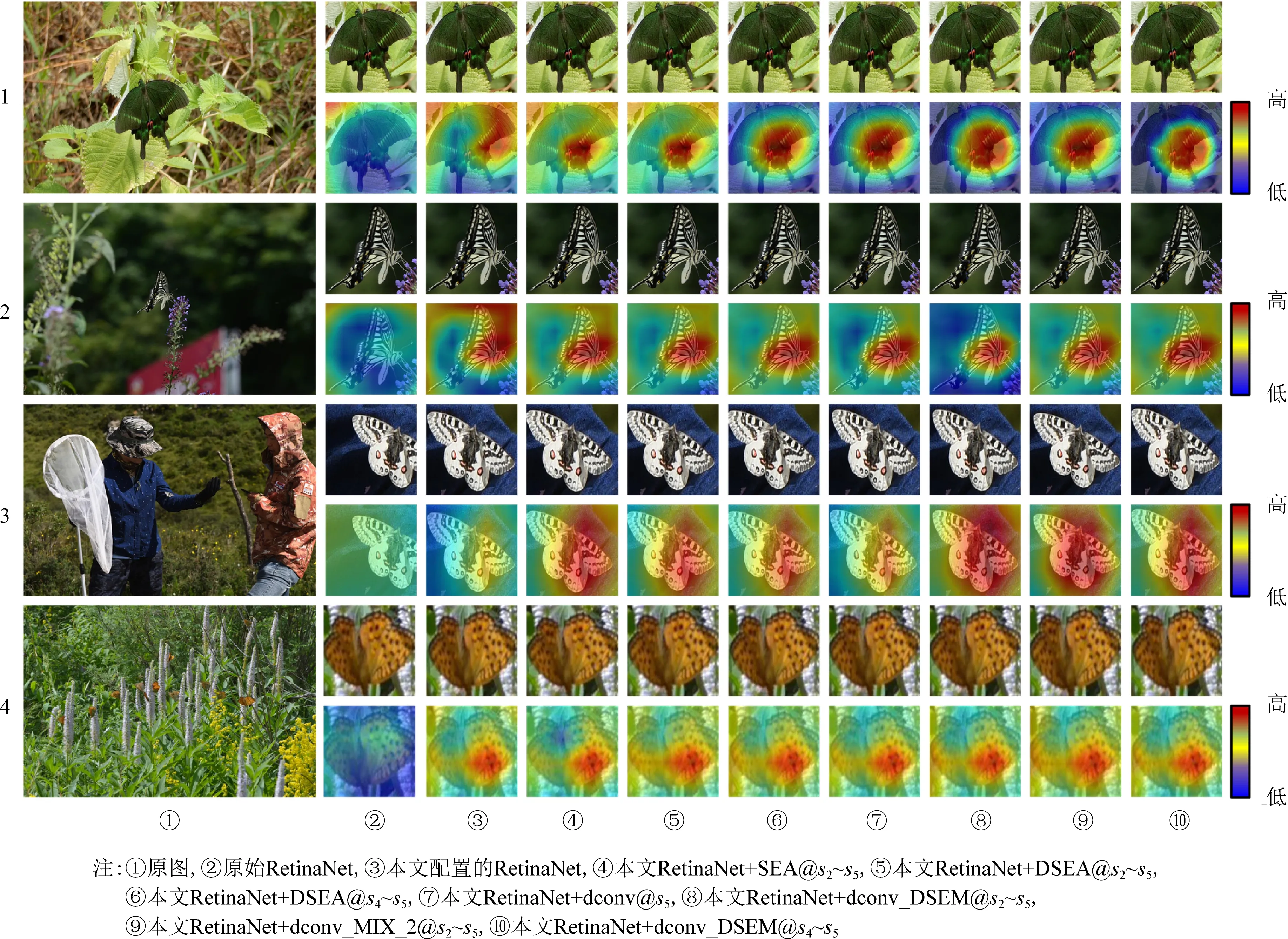

評價指標mAP只能反映模型的檢測與分類性能,不能解釋模型具體“看”到了什么.本節采用類激活圖方法,解釋模型“看”到的具體內容.圖5中②~⑩列分別展示了不同模型的預測結果和對應的類激活圖,1~4行4幅圖像均為測試集數據,其中1,2,3號圖像分別包含單個大、中、小蝴蝶實例,4號圖像包含多個小實例,可視化中取分類得分最高的預測結果.9種不同模型均檢測到了圖像中的實例.

圖5的實驗結果顯示,本文各模型,特別是模型⑧~⑩提取的特征更關注的是蝴蝶翅膀的特征,因此其性能更好.這與昆蟲學家進行蝴蝶分類的依據一致.

Fig. 5 CAM visualization of several predictive results of different models圖5 不同模型部分預測結果的類激活圖可視化

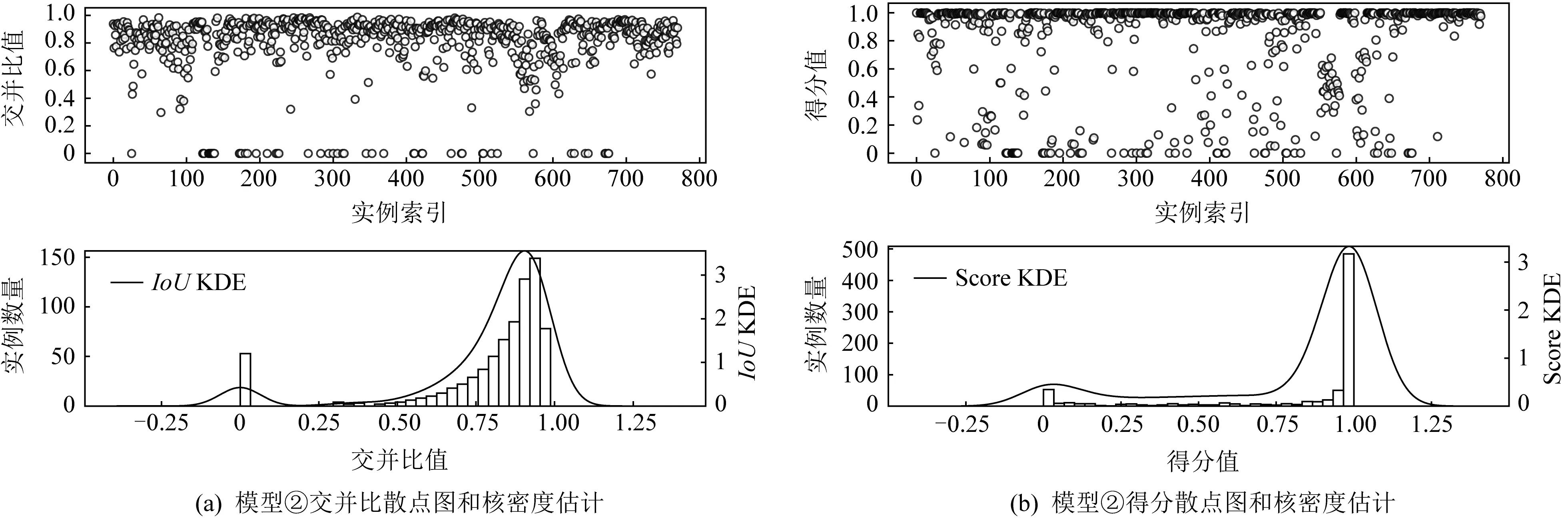

為進一步探究本文提出模型的性能提升原因,對圖5模型②的預測結果和圖5模型⑩的預測結果進行統計分析,統計結果如圖6所示.圖6中每幅圖上半部分為散點圖,下半部分為頻率直方圖和核密度估計曲線.圖6(a)~(b)展示了圖5模型②預測結果與測試集所有實例的交并比(IoU)和分類得分(Score)分布,圖6(c)~(d)對應圖5模型⑩.

圖6關于原始RetinaNet模型和本文提出的RetinaNet+dconv_DSEM@s4~s5模型預測結果的統計分析結果顯示:圖5模型⑩的IoU和分類得分均比原始RetinaNet好,尤其在分類得分方面,提出的圖5模型⑩有更突出的表現,這有利于模型后處理階段選擇與Ground-truth boxesIoU更高的預測框.

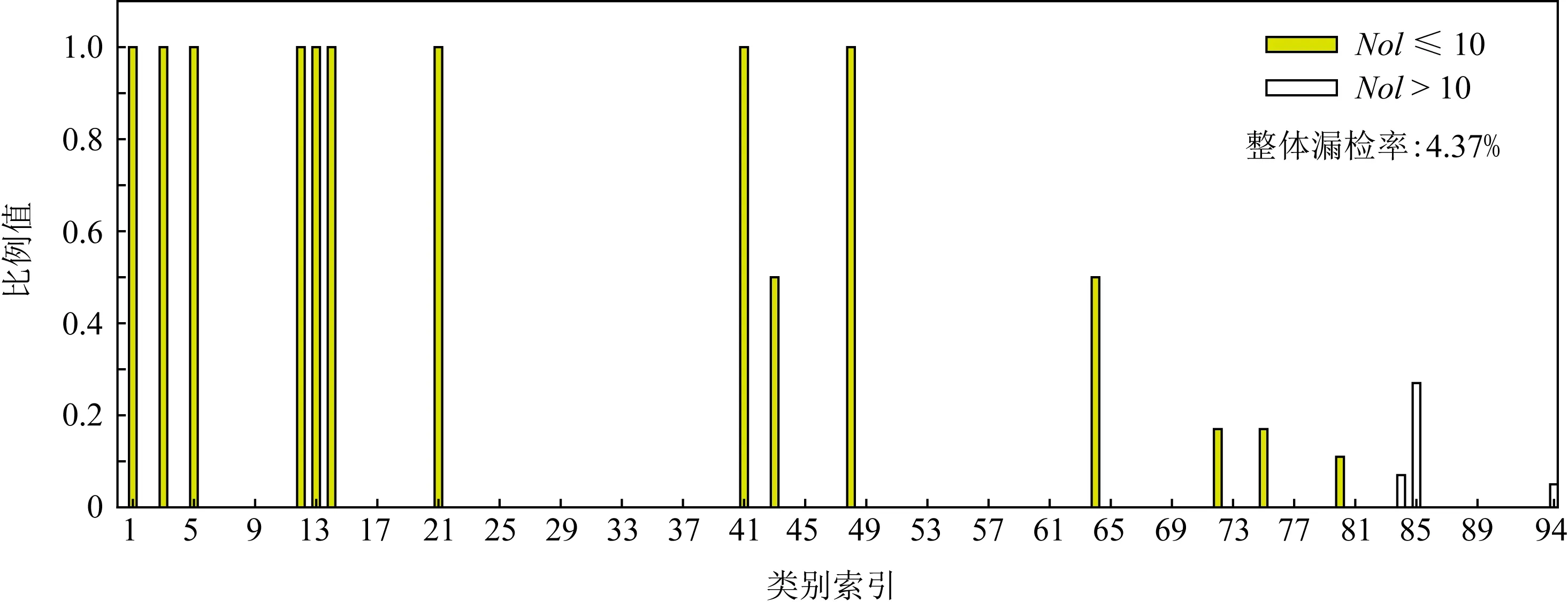

圖6統計結果中IoU和分類得分均為0的漏檢實例嚴重影響模型性能.使用圖5模型⑩的結果,分別統計漏檢實例在測試集對應類別的占比情況,結果如圖7所示,橫坐標是測試集各類別對應實例數量由小到大排序生成的類別索引,縱坐標為比例值,NoI代表實例數量(number of instance),定義不超過10個實例的類為少樣本類別,反之為多樣本類別,圖像的整體漏檢率表示所有漏檢實例數目占測試集所有實例數目的比例.

Fig. 6 Distributions of IoU and classification Score of Fig. 5’s models ② and ⑩圖6 圖5模型②、模型⑩的IoU和分類Score分布

Fig. 7 Ratio of each category missed detection instances in Test_Butterfly_Data of Fig. 5’s model ⑩圖7 圖5模型⑩對測試集的漏檢實例在測試集對應類別實例的占比

圖7結果顯示:在模型推斷過程中,測試集中少樣本類別的漏檢比例較大,這應該與數據集類別分布不平衡有關,模型對少樣本類別的特征學習不足,以至于分類錯誤,整體漏檢率為7.52%.下面通過實驗測試,驗證平衡數據集可提升本文提出模型的性能,降低漏檢率.

文獻[25]對競賽中的蝴蝶圖像重新劃分訓練集和測試集,對訓練集應用平衡擴增策略,得到類別分布平衡且標注良好的蝴蝶訓練數據集aug-eco-1,對應測試集見文獻[25]描述,實驗結果如表10所示.其中模型1和模型2均為RetinaNet網絡,不同之處在于模型1為表3的原始RetinaNet配置.模型2借助K-means確定針對訓練數據集aug-eco-1的RetinaNet模型的Anchor boxes aspect ratio和scale.模型3為本文提出的RetinaNet模型dconv_DSEM@s4~s5,Anchor boxes參數設置與模型2一致.

Table 10 Corresponding Test Results of Different RetinaNet Trained by aug-eco-1 from Ref [25]

表10結果顯示,采用類別分布平衡的自然環境中蝴蝶數據集aug-eco-1訓練提出模型,所得模型具有更強大的泛化性能,說明本文提出的模型加上分布均衡的訓練數據集,可以得到更強的自然環境下蝴蝶種類識別系統.

根據表10中模型3的結果,分別統計漏檢實例在測試集對應類別的占比情況,結果如圖8所示,圖中橫縱坐標及圖例信息與圖7一致.

圖8結果顯示:使用類別分布平衡的訓練集,訓練所得模型的少樣本類別漏檢率可以得到一定程度的緩解,整體漏檢率降至4.37%,但漏檢實例仍然集中在少樣本類別.

Fig. 8 Ratio of each class missed detection instances in corresponding test subset of model 3 in Table 10圖8 表10中模型3對應測試集的漏檢實例在測試集對應類別的實例占比

表10和圖8結果表明,使用類別分布平衡的訓練數據集訓練模型,所得模型的性能提升有限,說明數據集類別分布平衡與否會影響模型性能,但還不是影響模型性能的關鍵因素.

為進一步探索影響模型預測性能的關鍵因素,使用本文的Test_Butterfly_Data對訓練好的模型3進行測試,實驗結果如表11所示.

表11結果顯示,用Test_Butterfly_Data測試訓練好的模型3時,各項指標明顯增強,主要原因是Test_Butterfly_Data和訓練模型3的aug-eco-1數據集有部分數據重合,即訓練集中包含了部分測試集數據,因此模型3在Test_Butterfly_Data的表現遠超過表8結構完全一樣的dconv_DSEM@s4~s5模型.根據以上分析,可以猜想訓練集和測試集數據差異是影響模型性能的關鍵因素.下面通過模型預測結果可視化,驗證這一猜想.

Table 11 Test Results of Different Test Subsets Against Well-trained Model 3 in Table 10

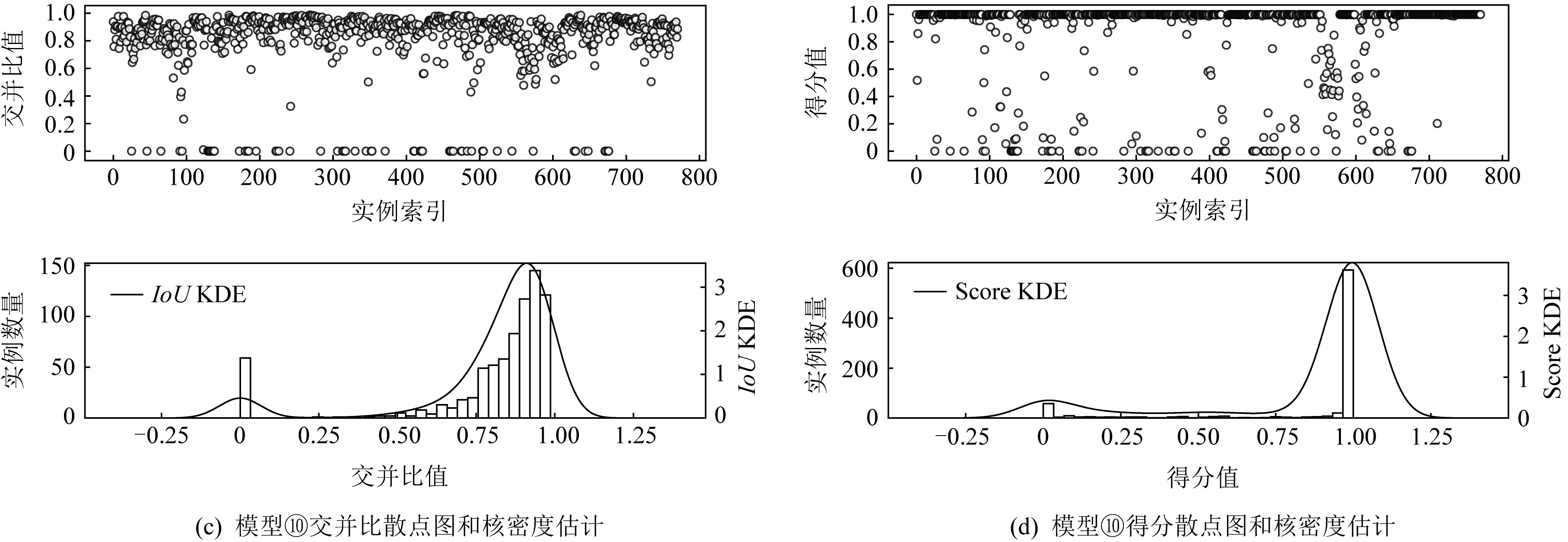

3.2~3.5節的消融實驗顯示本文提出的RetinaNet模型dconv@s5的綜合評價指標mAP@[0.5,0.95]表現最佳(65.290%).下面統計該模型預測結果中的正確檢測實例和漏檢實例及所在圖像,然后與訓練集中對應類別的實例及圖像分別計算結構相似性指數SSIM Index(structural similarity index)[59]和圖像均值感知Hash相似性MPHash(mean perceptual hashing)[60],將每個實例和圖像的最高相似性得分可視化,如圖9所示.其中,圖9(a)為測試集所有圖像的SSIM Index散點圖,橫坐標為圖像索引,縱坐標為相似度得分;圖9(b)為測試集所有實例的SSIM Index散點圖,橫坐標為實例索引,縱坐標為相似度得分;圖9(c)為測試集所有圖像的MPHash相似性散點圖,橫坐標為圖像索引,縱坐標為相似度得分;圖9(d)為測試集所有實例的MPHash相似性散點圖,橫坐標為實例索引,縱坐標為相似度得分.

Fig. 9 Plots of SSIM Index and MPHash圖9 結構相似性指數和均值感知Hash相似性散點圖

圖9(a)~(d)結果顯示,測試集中正確檢測樣本與訓練集樣本最大相似度均值普遍高于漏檢樣本與訓練集樣本的最大相似度均值,說明模型對與訓練集樣本相似性更高的數據推斷更準確.其中,圖9(a)~(b)均使用SSIM Index相似性,從亮度、對比度和結構3方面衡量2個對象的相似性,不同在于,圖9(a)是測試集圖像與訓練集圖像的相似性,考慮圖像的前景和背景,圖9(b)是測試集實例與訓練集實例的相似性,只考慮前景.圖9(a)相似性得分明顯高于圖9(b),說明圖像背景可以輔助檢測.

圖9(c)~(d)使用MPHash算法,從結構單方面度量相似度,圖9(c)是測試集圖像與訓練集圖像的結構相似性,考慮圖像的前景和背景,圖9(d)是測試集實例與訓練集實例的結構相似性,只考慮前景.圖9(c)和(d)的最大相似度均值顯示,正確檢測的樣本與訓練集樣本的結構相似性更近,說明正確檢測的樣本背景和前景均有較高的結構相似性;而圖9(c)的漏檢樣本與訓練集樣本的圖像相似性低于圖9(d)的漏檢樣本與訓練集樣本的實例相似性,說明漏檢樣本背景差異較大.

比較圖9(a)和圖9(c)中正確檢測樣本和漏檢樣本的最大相似度均值之差發現,圖9(c)使用MPHash算法的差異更明顯.這一現象在圖9(b)和(d)也存在.由此可見,圖像結構差異是導致漏檢的關鍵,同時,也驗證了上文猜想的正確性.

Fig. 10 MPHash visualization of instances圖10 實例樣本均值Hash可視化

圖10顯示了部分漏檢實例和正確檢測實例的MPHash變換圖像的可視化結果,為凸顯圖像結構細節,將原圖縮放至128×128像素得到對應的MPHash圖.圖10(a)為漏檢實例,圖10(b)為正確檢測實例,每幅圖中前2列為測試集實例和對應的MPHash變換圖像,后2列是與對應測試集實例類別相同且MPHash相似性最大的訓練集實例及其對應的MPHash變換圖像.圖10可視化結果顯示,測試集漏檢樣本與其在訓練集最大相似樣本的結構差異非常大,測試集中被正確檢測樣本與其在訓練集的相似性最大樣本的結構差異較小.這與圖9的可視化分析所得結論一致,再次說明了野外環境下的蝴蝶種類識別,樣本的結構相似性更重要.

4 總結和討論

本文提出了依據數據幾何結構特征配置Retina-Net網絡的Anchor boxes參數,實現自然環境下蝴蝶種類識別的有效參數配置策略.本文提出了2種硬注意力機制模塊DSEA和DSEM,并引入可變形卷積替代普通卷積的殘差塊,構建可變形卷積與DSEA,DSEM組合的改進RetinaNet模型,實現自然環境下的蝴蝶檢測與分類.大量消融實驗驗證了提出的模型對自然環境下蝴蝶識別任務的有效性.模型預測結果可視化顯示,模型在蝴蝶分類過程中更關注蝴蝶的翅膀特征,與專家辨識蝴蝶的方法相同;模型結果的可視化還發現,野外環境下的蝴蝶分類,樣本的結構相似性對模型性能影響更大.

然而,如何使模型自適應地依賴數據幾何特征設置Anchor boxes參數有待進一步研究;如何克服由于拍攝角度等不同帶來的同類樣本的巨大結構差異,從而導致的模型漏檢問題,是需要進一步探索和解決的挑戰性問題.