基于CSP改進用于擁擠情況的行人檢測算法

肖順亮,強贊霞,劉衛光

(中原工學院 計算機學院,河南 鄭州 451191)

0 引 言

行人檢測技術在日常生活中應用越來越廣泛,比如自動駕駛[1]、視頻監控[2]、機器人路徑規劃、行人再識別技術中都涉及到行人檢測問題。由于它具有極大的應用研究價值,越來越引起學術界和工業界的廣泛關注。近年來隨著神經網絡的迅速發展,從傳統的手工提取圖像特征到通過神經網絡提取圖像特征的轉變,行人檢測的效率和準確率在標準數據集上有了很大提高。然而,在實際場景中由于行人之間的相互遮擋、行人被其他障礙物遮擋,以及行人尺度的多變性等因素,當前的行人檢測算法常常會出現誤檢和漏檢的情況[3]。因此,在擁擠條件下的行人檢測技術仍面臨著挑戰,檢測的誤檢率需要進一步降低。

行人檢測可以看作是目標檢測中的一類被檢測對象,可以使用目前比較成功的目標檢測算法。常見的目標檢測算法可分成兩大類:一類是基于錨框(Anchor-base)的目標檢測算法,如以Faster-RCNN[4]為代表的two-stage檢測方法和以SSD[5]為代表的one-stage檢測方法。另一類是無錨框(Anchor-free)的目標檢測算法,如基于關鍵點檢測的CornerNet[6]目標檢測算法。以上兩類目標檢測算法都成功應用于行人檢測技術中,并取得了一定進展。

然而,在實際場景中由于行人自身尺度的多變性,單一尺度的行人檢測算法無法適應不同的尺度,達不到最優檢測效果[7],加上行人之間的遮擋和行人被其他障礙物遮擋等因素,目前的行人檢測算法在擁擠情況下的漏檢率有待進一步降低。為解決這一問題,該文在CSP[8]方法的基礎上,采用ResNet-50[9]網絡結構與特征金字塔網絡(feature pyramid networks,FPN)[10],將包含有較多位置信息的淺層特征層與包含較多語義信息的深層特征層相融合,最后用于預測的特征層既包含較多的行人位置信息也包含較多的行人語義信息。針對實際場景中行人尺度的多變性,該文采用多尺度預測方法,以適應更多的行人尺度變化。由于擁擠情形下,行人預測框之間的相交面積與相并面積的比值(intersection over union,IoU)相對比較大,采用標準的非極大值抑制(non-maximum suppression,NMS)處理方法會抑制掉部分有效預測結果。因此,該文使用DIoU(distance-IoU)[11]的NMS算法對預測結果進行處理,進而保留更多有效預測。所有實驗均在Cityperson[12]數據集上進行訓練和驗證,結果表明該算法在行人擁擠情況下,較其他算法在嚴重遮擋評價指標的漏檢率有所降低,同等實驗條件下與CSP算法相比,行人嚴重遮擋和無遮擋的漏檢率均有所降低。

1 相關工作

1.1 行人檢測

行人檢測是指在圖像或視頻中找到行人的位置以及確定行人的尺寸,常見的行人檢測方法有傳統的基于滑動窗口的檢測方法、當前基于預設錨框的檢測方法,以及基于關鍵點檢測的行人檢測方法。從有無預先設置錨框的角度,行人檢測方法可分為兩類:一類是基于錨框的行人檢測方法,另一類是無錨框的行人檢測方法。

1.2 Anchor-base檢測方法

基于Anchor-base檢測算法中,一個重要組成部分就是Anchor的設置,檢測之前要提前預設好Anchor的尺寸或者比例,檢測時根據預先設定好的Anchor進行回歸。Faster-RCNN通過預先設定好Anchor的寬高比,然后通過推薦網絡生成可能與目標匹配的錨框。Zhang等[12]調整了Faster-RCNN算法用于行人檢測;曾接賢[13]針對行人尺度較小情況下的誤檢問題,提出了融合多層特征的多尺度行人檢測算法;郭愛心[14]為提升中小尺度的行人檢測效果,提出了一種特征融合的多尺度行人檢測算法;劉丹[15]采用語義信息來監督網絡訓練,提出了具有魯棒性的行人檢測算法;Adaptive NMS[16]通過預測行人的密度,在檢測結果處理階段,根據行人的密度動態調整NMS的閾值,從而保留更多有效檢測框。以上基于Anchor的行人檢測算法,都需要預先設置好錨框,從而增加了算法的復雜度。

1.3 Anchor-free檢測方法

基于Anchor-free檢測算法省去了錨框尺寸的設定,檢測時直接回歸目標的位置和邊框,簡化了算法,提高了檢測速度。近年來有研究者提出基于關鍵點檢測的Anchor-free檢測算法,比如CornerNet通過預測目標左上角和右下角的坐標,進而確定目標在圖像中的位置。ExtremeNet[17]通過檢測目標上下、左右四個極值點的坐標,從而確定目標在圖像中的位置。TLL[18]提出了預測目標上下兩個頂點的坐標來確定目標的位置,這些無錨框的目標檢測算法在檢測速度上比基于錨框的目標檢測算法更快,其檢測效果與基于錨框的目標檢測算法相當,甚至在某些應用場景下其檢測效果超過基于錨框的目標檢測效果。

最近Liu Wei等人提出了基于Anchor-free思想的CSP行人檢測算法,把行人的中心點和身高作為高級語義信息,通過預測行人的中心點位置和身高,根據行人身高和寬高固定比例生成行人預測框,整個算法流程中擺脫了錨框的生成,以及預測框與真實框之間的IoU計算,減少了算法的計算量,同時也取得了較好的檢測效果。但CSP行人檢測算法對不同尺度的行人采用統一尺度檢測器,由于大目標和小目標行人的自身尺度差異,使檢測效果不能達到最優。在檢測結果的后續處理問題上,CSP行人檢測算法采用的是標準的非極大值抑制算法,閾值設定相對盲目,不能達到更有效的處理效果。張慶伍[19]采用特征融合和多尺度結合的Anchor-free行人檢測算法,在擁擠情況下產生了大量重復預測。針對以上問題,該文借鑒了FPN特征融合策略,采用多尺度預測方法,針對不同大小的行人采用不同的尺度預測分支進行預測,然后綜合所有尺度的預測結果,通過DIoU-NMS后處理抑制掉重復預測框,降低行人漏檢率,提高算法的性能。實際檢測中,為了減少行人實際中心點位置與預測中心點位置的偏差,在檢測頭部分添加了中心點偏移分支,通過縮小兩者差距使檢測更加準確。

2 算法設計

2.1 模型設計

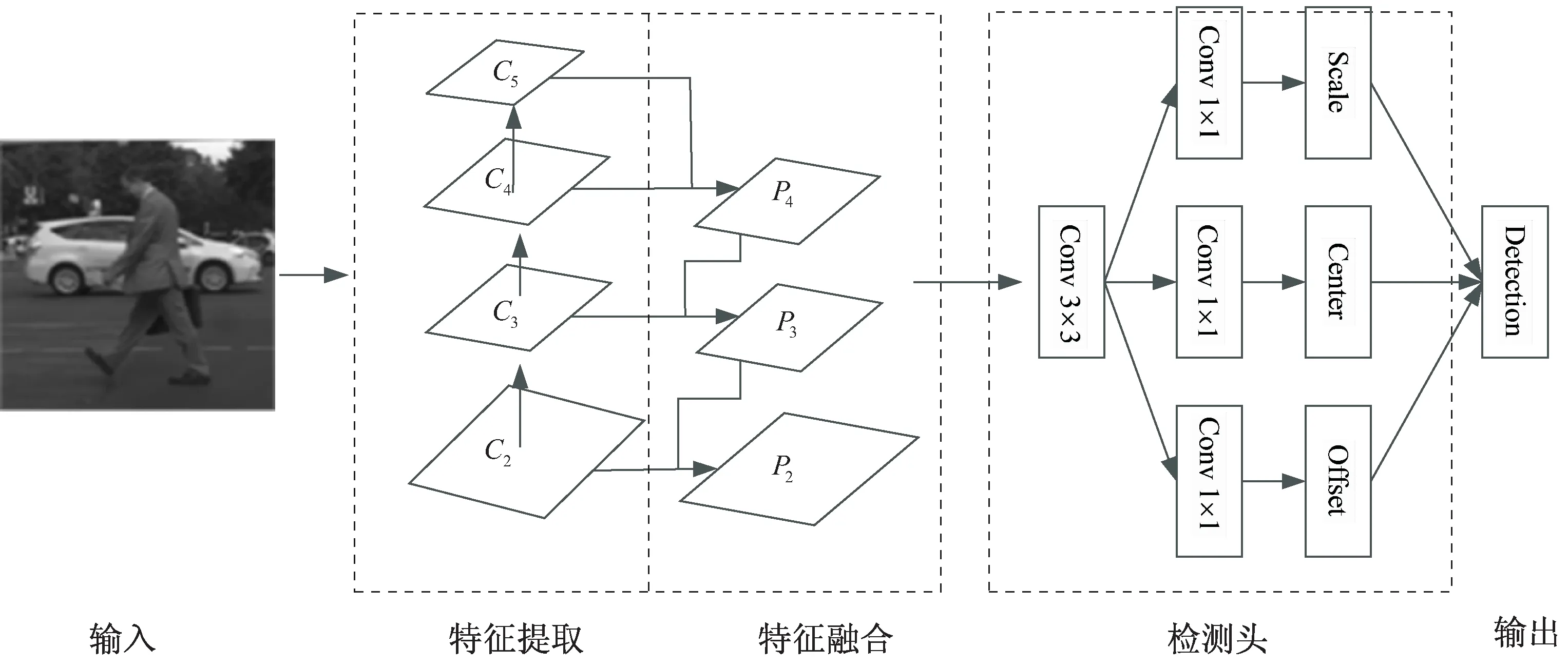

整個行人檢測模型結構一共包含四個部分:特征提取模塊、特征融合模塊、行人預測模塊和預測結果后處理模塊。特征提取模塊采用卷積神經網絡進行圖像特征提取操作,把圖像I作為輸入,每經過一次卷積會形成一個特征層,整個卷積過程中圖像特征層的變化如下:

φi=fi(φi-1)=fi(fi-1(…f2(f1(I))))

(1)

其中,φi表示第i層的輸出特征層,fi表示對第i層特征的卷積、池化、歸一化、激活等操作。每個特征層包含了目標的不同位置信息和語義信息,實際檢測中可以對不同特征層進行融合,N層的特征層可用一個集合表示為:

Φ={φ1,φ2,…,φN}

(2)

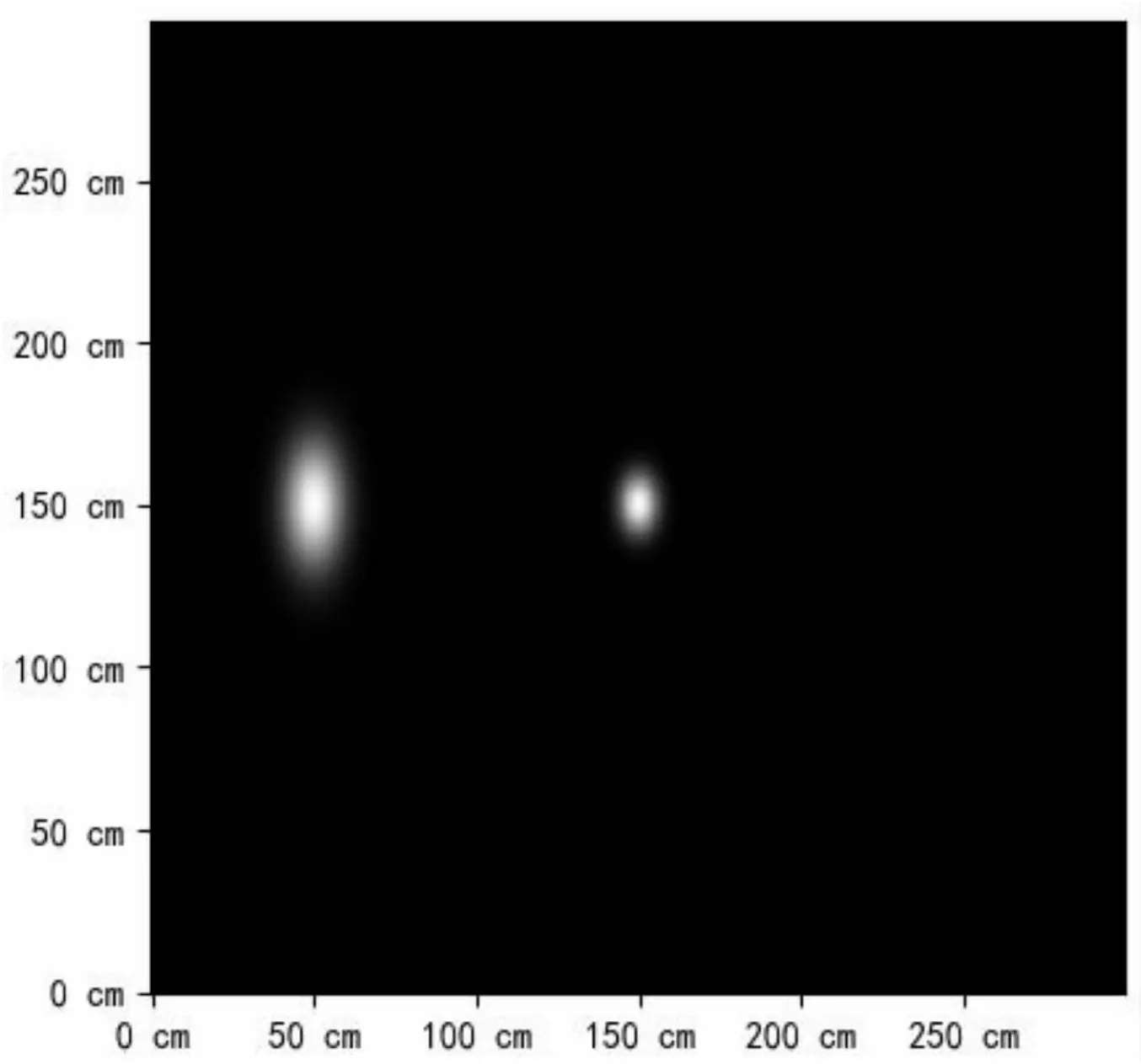

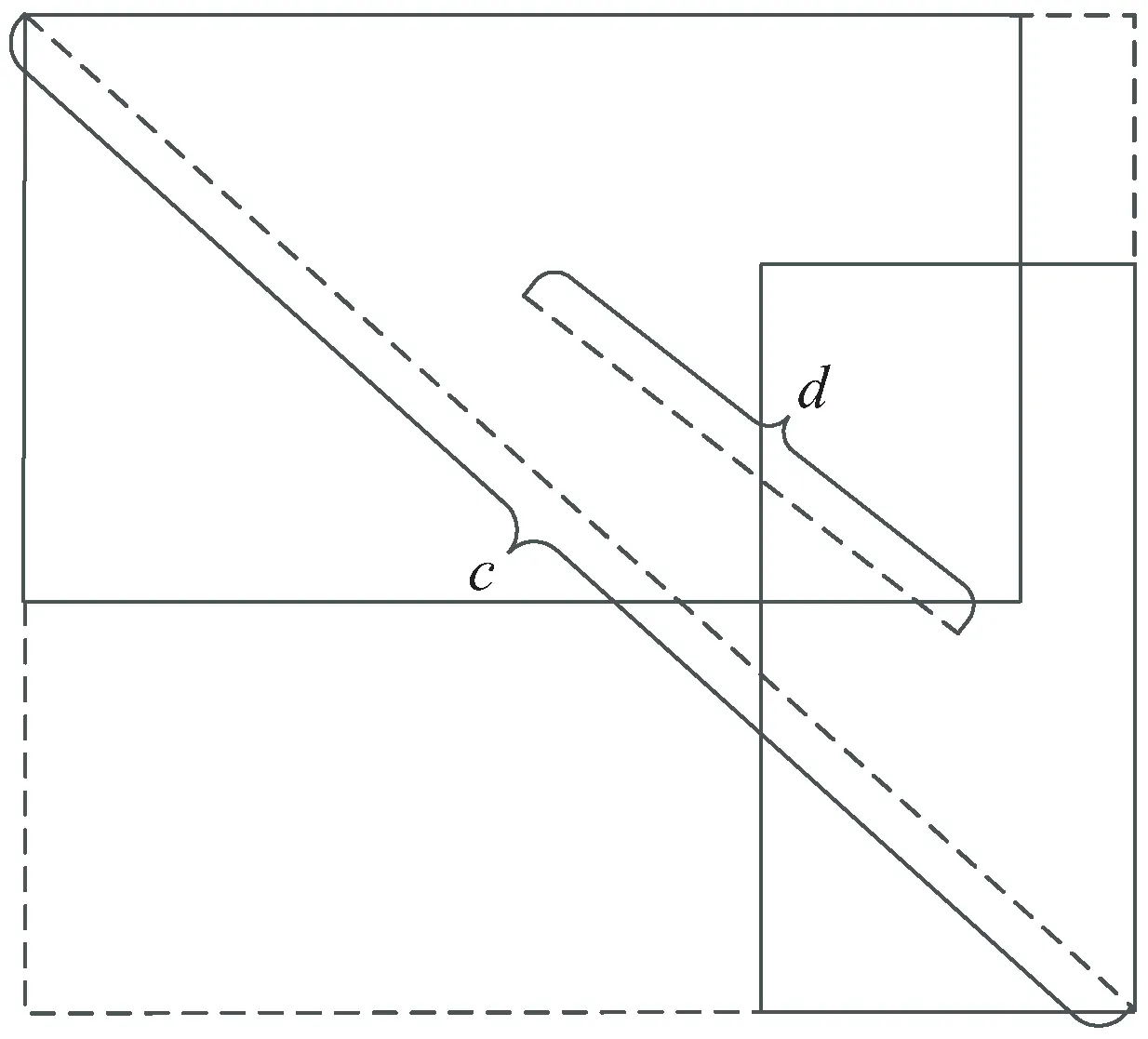

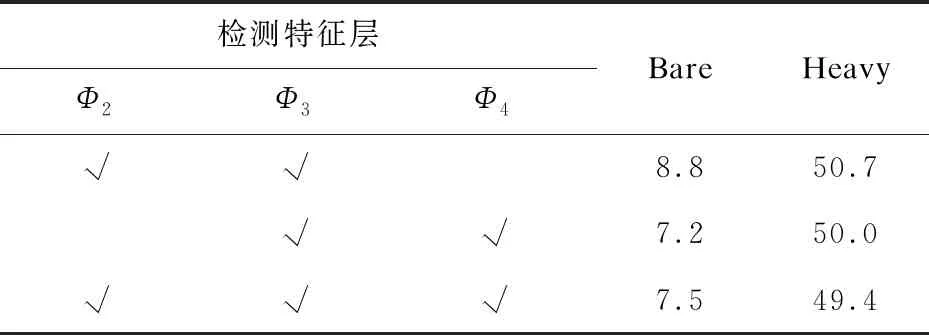

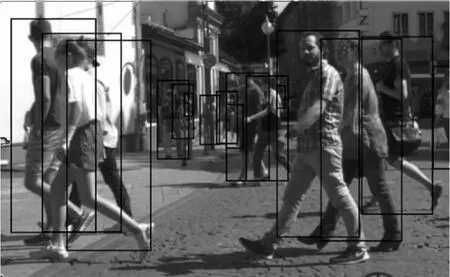

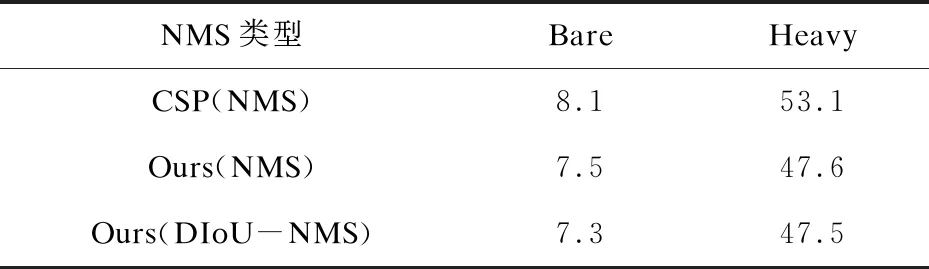

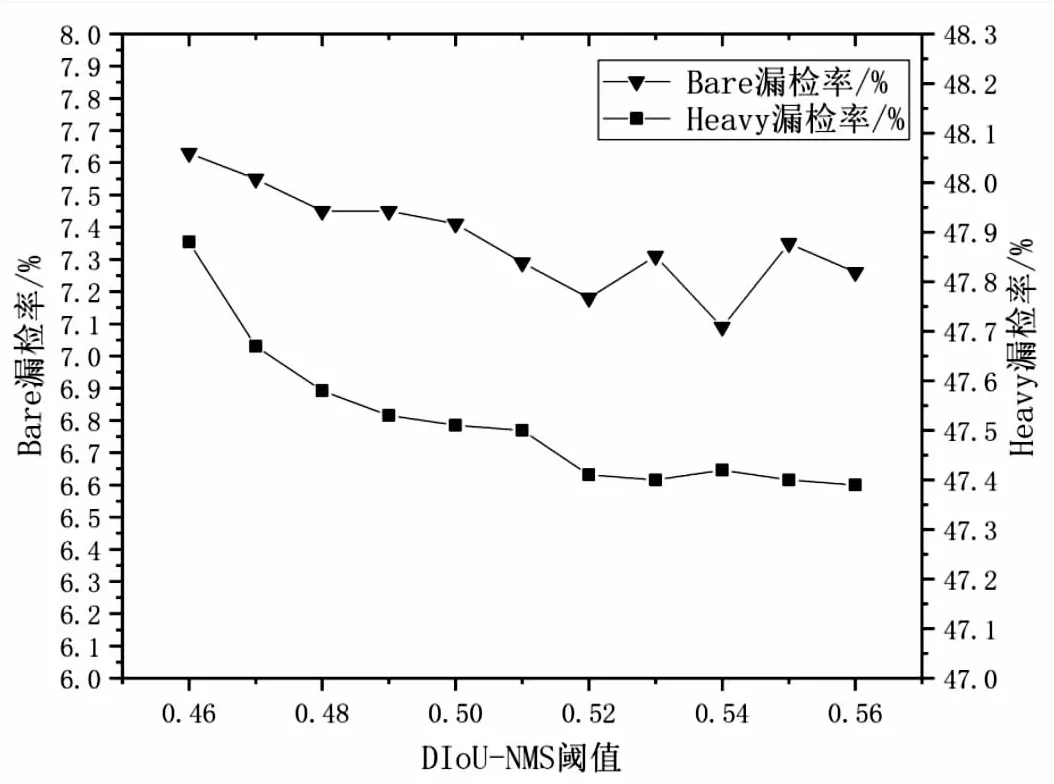

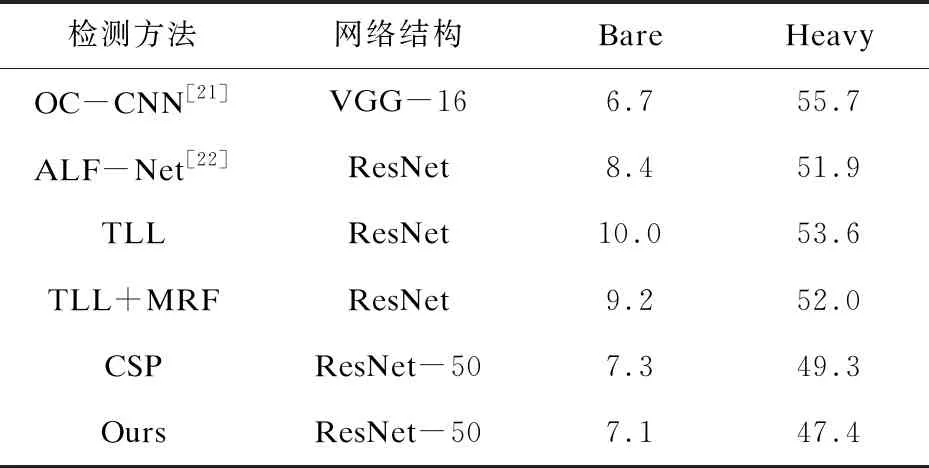

其中,Φ表示特征層集合。用Φdet表示最終用于檢測的特征層集合,則Φdet={φl,φl+1,…,φN},1 文中算法采用ResNet-50作為行人特征提取主干網絡,整個特征提取卷積層劃分為五個特征層,前四個特征層分別通過前一層下采樣操作得到當前特征層,最后一層特征層通過前一層空洞卷積操作得到當前特征層,最終得到五個特征層圖像尺寸分別為原圖像尺寸的1/4、1/16、1/64、1/256、1/256。特征融合模塊采用FPN特征融合策略,其特征融合過程為:使上層特征通過反卷積操作,把圖像的特征尺寸調整為下層特征尺寸大小,然后再與下層特征進行相加融合。融合后的特征層通過一個3×3的卷積核進行平滑操作,得到最終可以用于檢測的Φ2、Φ3、Φ4特征層。行人預測模塊通過三個1×1的卷積核,分別預測行人尺度(scale)、行人中心點(center)和中心點偏離(offset)。預測結果后處理模塊通過DIoU-NMS處理,去除同一個行人的重復預測框,得到最終的預測結果,整個行人檢測流程如圖1所示。 圖1 行人檢測流程 基于關鍵點的目標檢測算法通常標注的有目標角點、目標中心點、目標中軸線、目標四周的極值點等。文中算法采用的是行人的中心點和身高作為高級語義特征信息,把行人的中心點作為正樣本,標注為1,其他位置坐標作為負樣本,標注為0。由于Cityperson數據集標注的行人寬高比固定,因此,可根據行人高度預測結果自動計算出行人的寬度,再根據預測的行人中心點位置,進而可以預測行人在圖像中的位置。實驗中,輸入圖像由于下采樣操作,行人的中心點會變得不精確,為了減少中心點的模糊對網絡訓練造成困難,以行人中心點為中心,生成一個2維的高斯熱圖Mij,如圖2所示,其表達式為: 圖2 行人高斯熱圖 (3) (4) 其中,K表示一張圖像中行人的數量,(i,j)表示高斯熱圖的位置,(xk,yk,wk,hk)表示第k個目標的中心點坐標和寬高,(σw,σh)表示寬和高的協方差。從公式可以看出與目標中心點的距離越近,數值越大,當兩個高斯熱圖重疊時取兩者的最大值。 為了克服行人中心點的預測結果與實際中心點偏移問題,實驗中,在檢測頭部分增加中心點偏移預測分支,通過最小化行人預測中心點與實際中心點兩者誤差損失,提高算法檢測精度。行人中心點實際位置與標注的位置的偏移可以定義為: (5) 其中,r為下采樣比率。 文中算法總的損失函數包含三部分:行人中心點損失Lcenter、行人尺度損失Lscale、行人中心點偏移損失Loffset。由于輸入圖像中行人中心點相對于非行人中心點較少,從而造成正負樣本不均衡,不利于網絡模型的訓練。為解決這一問題,Lin T等人[20]提出了Focal Loss方法來解決正負樣本不平衡問題。為此,中心點分類損失函數定義為: (6) (7) (8) 其中,K表示一張圖像中行人的數量,W、H分別表示圖像的寬高,pij∈[0,1]表示預測坐標點(i,j)屬于行人中心點的概率,β,γ是兩個超參數,實驗中分別設置為β=4[6]、γ=2[20],Mij表示(i,j)坐標點的高斯熱圖。 使用L1損失函數計算行人尺度損失,其公式為: (9) 其中,pk,tk分別表示第k個目標的預測值與真實值。 使用SmoothL1損失函數計算偏移損失,其公式為: (10) 其中,pk,tk分別表示第k個目標的預測值與真實值。 綜上所述,總的損失函數L定義為: L=λcLcenter+λsLscale+λoLoffset (11) 其中,λc、λs、λo分別表示中心點損失、尺度損失和偏移損失的權重,實驗中分別取值為0.01、0.05、0.1。 標準NMS只考慮兩個檢測框的IoU,而忽略了兩個檢測框的相對位置,當兩個檢測框的IoU相同時,兩個檢測框可能檢測的是同一個行人,也可能是不同的行人。這種情況下,為進一步提升算法的檢測性能,該文采用DIoU-NMS對檢測結果進行后處理。DIoU-NMS綜合考慮了兩個檢測框中心點的歐氏距離(d)與同時包含兩個檢測框的最小框的對角線距離(c),如圖3所示。 圖3 DIoU建模 兩個檢測框的中心點歐氏距離的平方與同時包含兩個檢測框的最小框對角線距離平方的比值RDIoU為: (12) 其中,b1,b2分別表示兩個行人檢測框,c表示同時包含兩個行人檢測框的最小框對角線距離,ρ(·)表示歐氏距離,兩個檢測框中心點的歐氏距離d2即為ρ2(b1,b2)。 行人檢測框得分si的計算公式為: (13) 其中,M表示當前取出得分最高的預測框,Bi表示與M相交的第i個預測框,ε表示設定的閾值。 從公式(12)與公式(13)可以看出,當d2與c2的比值較小時,兩個預測框檢測的是同一個行人的可能性比較大,此時兩個預測框調整后的IoU依然較大,當調整后的IoU大于設定的閾值ε時,檢測框得分設置為0,從而抑制重復預測框。當d2與c2的比值較大時,兩個預測框預測的是不同行人的可能性比較大,此時兩個預測框調整后的IoU小于設定的閾值ε,檢測框的得分保持不變,從而保留更多有效預測結果。 為對文中提出的算法進行有效評估,訓練和驗證均在Cityperson數據集上進行。Cityperson數據集是在Cityscapes數據集的基礎上建立起來的,它包含了18個不同城市、多種氣候環境下的行人數據。數據集包含19 238個行人,平均每張圖片上有6.47個行人,行人姿態多樣、密度較高、背景環境復雜。Cityperson數據集可分為訓練集、驗證集,其中訓練集2 975張圖片,驗證集500張圖片。數據集中行人真實位置標注框的寬高比為0.41。文中實驗均在kaggle平臺上進行,實驗環境為Tesla P100 16 GB的GPU。由于數據集中圖片尺寸為1 024×1 024像素的高清圖片,考慮到實驗設備GPU內存限制,實驗中將圖片尺寸調整為640×1 280像素進行訓練,Batch size設置為2。驗證模型時,行人寬高比r設置為0.40。為有效評估算法性能,實驗中把在驗證集上的測試結果分為兩個指標,即嚴重遮擋(Heavy)和無遮擋(Bare),分別得到對應指標的漏檢率(%)。 輸入圖像隨著網絡逐層的卷積、池化、激活等操作,淺層特征層包含了較多位置相關的特征信息,但缺乏語義特征信息。而深層特征包含了較多語義特征信息,但隨著逐層的池化、下采樣操作丟失了目標的精確位置特征信息。為此,采用FPN特征融合模型,把淺層特征與深層特征結合起來,使用于檢測的特征層既具有豐富的位置特征信息又具有豐富的語義特征信息。 實際場景中行人的尺度是多樣的,為了對不同的行人尺度有更好的預測效果,文中采用多尺度預測方法,并探究不同尺度組合下的預測效果。實驗中Φ2檢測特征層的高斯熱圖為原圖像的1/16,Φ3、Φ4檢測特征層的高斯熱圖為原圖像的1/64。 從表1可以看出,Φ3、Φ4兩個檢測層組合時,在Bare情況下行人預測效果最佳。Φ2、Φ3、Φ4三個檢測層組合時,在Heavy情況下行人預測效果最佳。由于多尺度預測會對同一個行人產生多次預測,因此最終的預測結果中存在較多的重復預測,所以需要對預測結果進行后處理,以去除同一個行人的重復預測結果。圖4為Φ3、Φ4兩個預測層組合時的預測結果。 表1 不同特征層結合檢測對比 % 圖4 Φ3、Φ4特征層組合預測結果 卷積神經網絡通過逐層提取圖像中行人的特征,進而預測行人的中心點和身高,最終的預測結果再回歸到原圖像中,確定行人在原圖像中的真實位置。由于預測的結果中存在重復預測,所以需對預測結果進行非極大值處理,去除重復預測是算法中不可缺少的一個重要組成部分。標準的NMS只考慮了兩個預測框的相交面積與相并面積之間的關系,而忽略了兩個預測框中心點的歐氏距離。DIoU-NMS綜合考慮兩個預測框的中心點歐氏距離與同時包含兩個檢測框的最小矩形對角線距離,對標準NMS進行了優化。為證明文中算法的有效性,采用同等實驗條件下對CSP論文中的行人檢測算法進行復現,與文中改進后的行人檢測算法進行對比,結果證明文中提出的算法在各種遮擋情況下,行人漏檢率均有所降低。實驗結果如表2所示。 表2 同等實驗條件下文中算法與CSP算法對比,DIoU-NMS與NMS實驗對比 % 從表2可以看出,第一,同時使用標準NMS后處理方法,文中算法在Bare和Heavy兩個評價指標上均比CSP的漏檢率低;第二,使用DIoU-NMS后處理方法相比于標準NMS的后處理方法,在Bare和Heavy兩個評價指標上的漏檢率進一步降低。標準NMS閾值設置固定,而且盲目,在擁擠情況下會抑制掉部分有效的預測框。而DIoU-NMS在實際處理過程中會動態地調整預測框的IoU,從而可以減少錯誤抑制有效的檢測框。圖5為采用標準NMS處理結果,圖6為采用DIoU-NMS處理結果,從兩者的處理結果可以看出,前者會抑制掉部分有效預測結果,出現漏檢現象,而后者保留了更多有效預測結果。 圖5 標準NMS抑制效果 圖6 DIoU-NMS抑制效果 多尺度行人預測會對同一個行人產生重復預測,擁擠情形下行人之間的相互遮擋比較嚴重,而且產生的預測框較多,框與框之間的IoU數值大。從圖7可以看出,在一定范圍內隨著DIoU-NMS閾值的增大,嚴重遮擋(Heavy)的漏檢率先降低較快,后面保持平穩。對于無遮擋(Bare)來說,開始隨著閾值的增大,漏檢率逐漸降低,當閾值超過0.52之后,隨著閾值的增加,漏檢率不再降低,出現上下波動。因為在無遮擋情況下行人密度小,閾值設置較大時將保留更多的重復檢測。 圖7 Heavy與Bare情況下漏檢率隨 文中提出的行人檢測算法以行人中心點和身高作為高級語義特征信息,采用FPN特征融合策略,結合多尺度預測方法對不同尺度的行人進行預測,預測結果采用DIoU-NMS后處理方法抑制掉重復預測框,提高檢測效果。與其他行人檢測算法對比如表3所示。 從表3可以看出,文中提出的行人檢測算法在Heavy和Bare情況下,漏檢率較CSP算法均有所降低,在行人嚴重遮擋(Heavy)情況下的檢測效果較好,無遮擋(Bare)情況下漏檢率與其他行人檢測算法相比有所降低。因為原圖像在逐層卷積、池化過程中,擁擠場景下的行人位置信息丟失較多,采用FPN特征融合策略,將包含較多位置信息的淺層特征與包含較多語義信息的深層特征融合,使預測特征層具有更多的行人特征信息,再結合多尺度預測方法,在擁擠場景下取得了較好效果。 表3 行人檢測算法對比 % 實際場景中由于行人之間的相互遮擋,給行人檢測帶來了困難,檢測時常常會出現誤檢和漏檢的問題。為解決這一問題,該文基于CSP改進的擁擠情況下的行人檢測算法,利用ResNet-50作為主干網絡提取圖像特征,采用FPN特征融合策略進行特征融合,結合多尺度預測方法對不同尺度的行人進行預測,對預測結果采用非極大值抑制處理,在Cityperson數據集上進行訓練和驗證。預測結果后處理過程中采用DIoU-NMS算法相比較于標準NMS算法,能夠根據兩個行人預測框的中心點距離,動態調整交并比,保留更多不同行人的有效預測框。同等實驗條件下,該算法在擁擠場景下和無遮擋場景下行人漏檢率均有所降低。同時對不同的DIoU-NMS閾值,對嚴重遮擋和無遮擋的檢測效果進行了研究,實驗表明隨著閾值的增大,嚴重遮擋和無遮擋情況下的漏檢率均有所降低,當閾值大于0.52時無遮擋的漏檢率出現輕微波動,而嚴重遮擋保持平穩。實驗中發現該算法會對部分非行人錯誤地預測為行人,以及遠處遮擋的行人會出現漏檢現象,產生這些現象的原因是由于網絡提取的行人特征不夠充分。因此,下一步工作將探索更深層的網絡結構用于提取更多行人特征,來提高行人檢測效果,降低漏檢率和誤檢率。

2.2 數據標注

2.3 損失函數

2.4 DIoU-NMS

3 實 驗

3.1 數據集與訓練設置

3.2 FPN特征融合結合多尺度特征預測

3.3 預測結果后處理算法

3.4 閾值對嚴重遮擋和無遮擋的影響

3.5 行人檢測算法對比

4 結束語