基于空間正則化約束的支持向量相關濾波器目標跟蹤方法

李峰 張宏志 左旺孟

摘?要:基于支持向量相關濾波器(Support Correlation Filters,SCF)的目標跟蹤方法存在嚴重的樣本邊界不連續問題,因此模型判別能力受到嚴重限制。本文將空間正則化項引入到SCF中,提出了基于空間正則化約束的支持向量相關濾波器(Spatially Regularized SCF,SRSCF)模型。相比于SCF,SRSCF不僅可以借助更大的圖像區域進行模型學習,同時也能緩解樣本的邊界不連續問題對模型學習的負面影響,由此得到判別能力更強的模型。此外,本文提出了一種ADMM(Alternating Direction Method of Multiplier)算法求解SRSCF模型,其中每個子問題具有解析解。實驗結果表明,相較于SCF,SRSCF能夠有效地提升跟蹤精度,同時僅增加較少的計算開銷。

關鍵詞: 目標跟蹤;支持向量相關濾波器;空間正則化

文章編號: 2095-2163(2021)01-0147-05 中圖分類號:TP391.41 文獻標志碼:A

【Abstract】The existing support correlation Filters (SCF) methods suffer from unwanted boundary discontinuity problem of samples, resulting in the degraded CF models. To address this, this paper incorporates the spatial regularization term into the SCF method, and proposes the spatially regularized SCF (dubbed SRSCF) model. In comparison to SCF, SRSCF can leverage larger image regions during model learning, and also alleviate the negative impacts of boundary discontinuous samples on model training, thereby leading to more discriminative CF models. In addition, an ADMM algorithm is proposed to solve the proposed SRSCF model, in which each sub-problem has closed-form solution. Experimental results show that SRSCF can achieve better performance than the SCF models, and only need less additional computational overhead.

【Key words】object tracking; Support Correlation Filter; spatial regularization

0 引?言

近年來,相關濾波器(Correlation Filter,CF)方法憑借其良好的計算效率和穩定的性能在目標跟蹤領域取得了巨大的成功。基于CF的跟蹤方法旨在學習具有判別能力的二類分類器,通過與樣本進行循環卷積運算,以生成預先定義好的標簽響應圖。早期的CF方法,如MOSSE[1] , KCF[2] 等,將分類器學習表示為l2范數約束下的嶺回歸模型。由于SVM分類器在小樣本學習中擁有良好的性能,Rodriguez等人[3] 將SVM和CF模型相結合,提出最大邊界CF分類器。但由于該方法需要提前對樣本進行線下訓練,因此無法應用于在線的目標跟蹤任務。為了解決該問題,Zuo等人[4] 將SVM模型嵌入到CF跟蹤框架下,提出了支持向量CF模型—SCF。SCF不僅可以借助快速傅里葉變換加速模型學習,同時也能夠靈活地擴展到多通道、核空間中以提升模型的判別能力。

雖然SCF方法表現優異,但由于其采用標準的CF模型,因此存在嚴重的樣本邊界不連續問題。樣本的邊界不連續問題源于CF模型的循環樣本假設,即訓練樣本集合是單個基樣本通過循環移位得到。基于此,距離目標較遠的循環樣本會在邊界位置上存在像素不連續的現象,由此產生大量不真實的虛擬樣本,導致模型的判別能力受到影響。為解決該問題,MOSSE[1],KCF[2] 等方法在基樣本上點乘一個余弦形式的窗函數進行數據預處理,但無法完全消除邊界不連續的樣本;最近,空間正則化方法[5-6]被用于解決樣本的邊界不連續問題,并取得了優異的效果。其中,Galoogahi等人[6]將二值掩膜函數添加到CF模型上,可以令目標外部的模型系數恒為0,由此緩解邊界不連續樣本對模型學習的負面影響,最終帶來了領域優先的性能。然而,現有的空間正則化方法均基于嶺回歸函數形式的CF模型,

在基于SCF的跟蹤方法中缺乏相應的研究。因此,本文將二值掩膜函數形式的空間正則化項融入到SCF框架中,提出了基于空間正則化約束的支持向量相關濾波器模型—SRSCF,在保證跟蹤速度不明顯損失的前提下,提升SCF模型的判別能力。

1 支持向量相關濾波器方法的回顧

給定大小為M×N的訓練樣本x,其中x={x1,…,xD}共包含D個特征圖,而y∈RM×N表示標簽響應圖,則基于半監督學習的支持向量相關濾波器可以表示為:

其中,{w,b,y}表示待求解的模型參數;ξ為松弛變量;1為取值全為1的矩陣;C表示正則化超參數;運算符“”和“*”分別對應于逐位置的點乘和循環卷積運算。

不同于標準CF模型采用預先定義好的樣本標簽,SCF的標簽y僅包含一部分循環樣本的標定。給定目標和樣本xi的中心位置分別為pc和pi ,則樣本xi 在置信度圖中的取值的數學定義為:

其中,exp(·)?表示指數函數;γ表示歸一化常量參數;參數α和β控制標簽值的變化速度。

根據置信度圖m,樣本xi的標簽定義為:

其中,θl和θu分別表示閾值的最小值和最大值,Ωu表示樣本的標簽未知,需要通過學習得到。

在SCF[4] 中,采用了交替更新的迭代優化方法,分別求解SCF的各個子問題,由此保證了模型求解的效率。基于循環卷積運算的性質,公式(1)中樣本x與分類器w的循環卷積等價于將w與樣本x的各個循環移位樣本做內積運算,因此SCF存在訓練樣本的邊界不連續問題,這會嚴重影響CF模型的判別能力。

2 基于空間正則化約束的支持向量相關濾波器模型

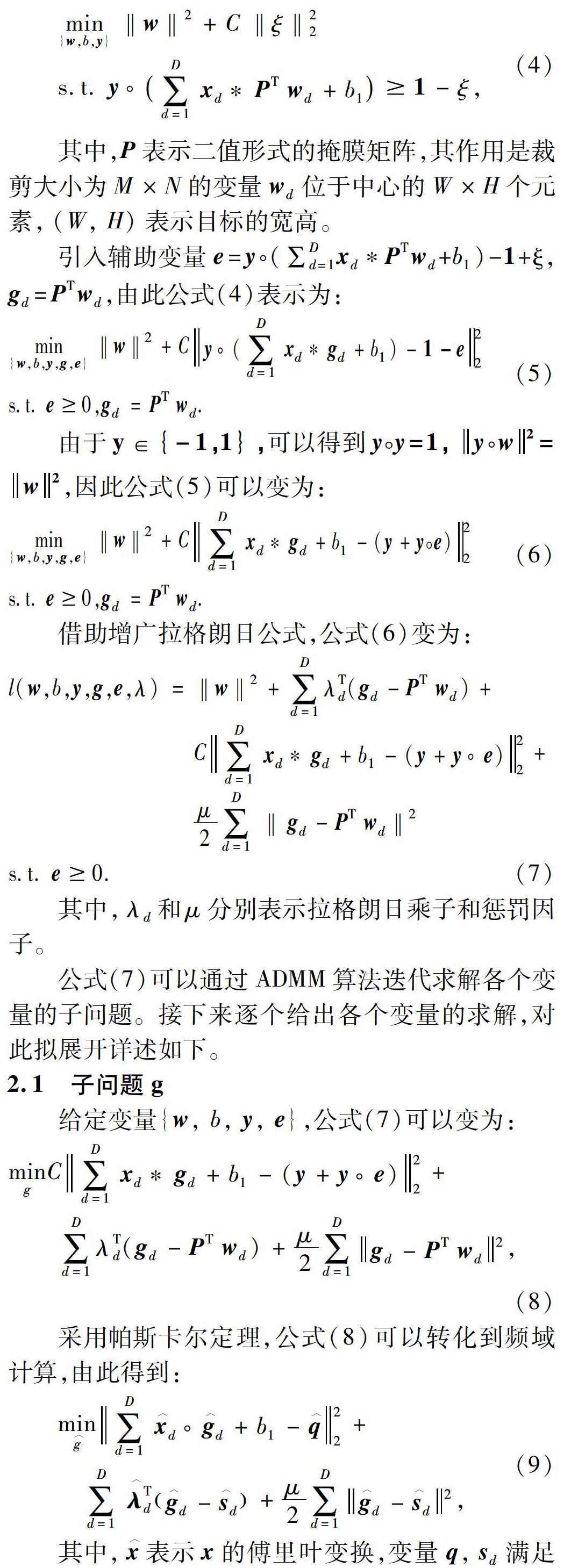

為緩解樣本的邊界不連續問題,Galoogahi等人[6] 將空間正則化項引入到CF模型中,通過將二值形式的掩膜函數添加到模型上,可以有效抑制樣本邊界不連續的問題。鑒于文獻[6]中研究得到的優秀屬性,本文將二值掩膜函數形式的約束項引入到SCF框架中,得到基于空間正則化約束的SCF模型(SRSCF)為:

其中,P表示二值形式的掩膜矩陣,其作用是裁剪大小為M×N的變量wd位于中心的W×H個元素,(W, H)表示目標的寬高。

其中,λd和μ分別表示拉格朗日乘子和懲罰因子。

公式(7)可以通過ADMM算法迭代求解各個變量的子問題。接下來逐個給出各個變量的求解,對此擬展開詳述如下。

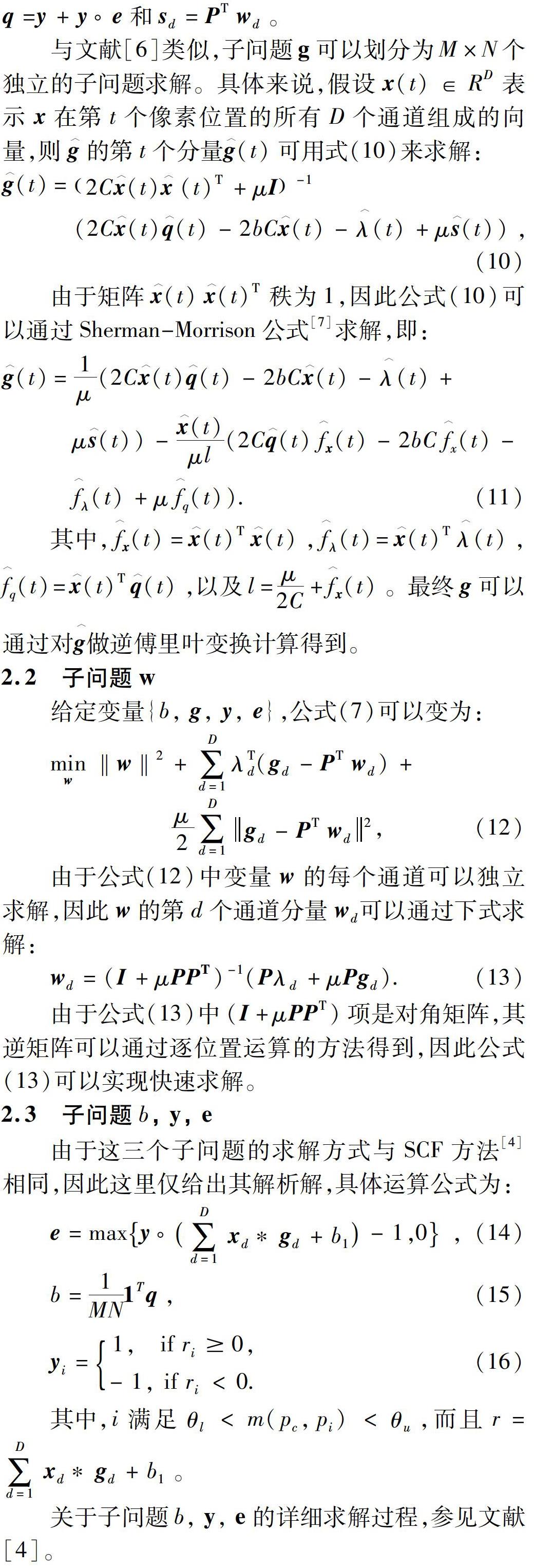

2.1 子問題g

給定變量{w, b, y, e},公式(7)可以變為:

采用帕斯卡爾定理,公式(8)可以轉化到頻域計算,由此得到:

與文獻[6]類似,子問題g可以劃分為M×N個獨立的子問題求解。具體來說,假設x(t)∈RD表示?x在第t個像素位置的所有D個通道組成的向量,則g︿的第t個分量g︿(t)可用式(10)來求解:

3 實驗結果

本小節采用OTB-2013和OTB-2015[8] 兩個數據集驗證本文方法的有效性。具體來說,首先將SRSCF與當前處于領先水平的跟蹤方法對比,然后分析SRSCF在各個視頻屬性下的跟蹤性能。

3.1 參數設置

仿照SCF[4],本文采用灰度、HOG和Color Names (CN)[9] 等3種特征進行特征提取,同時參數C,α,β,θl和θu分別設置為104,1,1.5,0.4和09。此外,拉格朗日乘子初始值λ(0)=1,參數μ=1.2, ADMM的最大迭代次數NI=4。借助空間正則化項,可以使用更大的圖像區域用于模型學習,同時避免過多背景對模型訓練的負面影響。基于此,仿照BACF[6],研究中裁剪邊長為5WH的正方形圖像區域學習模型。

3.2 與其他跟蹤方法的對比

本節將SRSCF與一些有代表性的跟蹤方法,即SRDCF[5],SCF[4], BACF[6], ECOhc[10],在OTB-2013和OTB-2015數據集上進行對比。表1給出了2個數據集上基于Mean OP的性能和FPS對比結果。可以看到,相比于基線算法SCF,SRSCF在OTB-2013和OTB-2015數據集上分別帶來14 %和115 %的提升,這2個數據集上性能提升差別較大的原因可歸結為SRSCF針對OTB-2013進行過較為精細的參數調整。SRSCF也超過了同樣使用二值掩膜函數的BACF方法,比后者分別有2.5 %和1.4 %的提升。此外,相比于SCF,SRSCF算法在2個數據集上的FPS分別下降了2.2和1.3,這說明SRSCF在保證更好性能的基礎上,僅增加較小的額外計算開銷。最后,上述方法在OTB-2013和OTB-2015上的AUC曲線如圖1所示。相比于SCF, SRSCF在2個數據集上分別有0.6 %和7.3 %的AUC分數提升。

3.3 不同視頻屬性下的性能對比

為測試SRSCF在不同視頻屬性下的性能,本文在OTB-2015數據集上進行實驗。所有方法在11種視頻屬性下的AUC分數如圖2所示。由圖2可以看到,在大多數視頻屬性下,SRSCF超過了除ECOhc以外的其他跟蹤方法,這也證明了本文方法的有效性。同時,圖3展示了4種有代表性的視頻屬性下AUC曲線的對比結果。由圖3可以看到, SRSCF在快速運動(Fast Motion)和遮擋(Occlusion)屬性上比SCF有更好的結果,這是由于通過空間正則化項,使得SRSCF可以使用更大的圖像區域進行模型訓練和跟蹤;此外,通過空間正則化項,CF模型的判別能力得到了提升,因此在運動模糊(motion blur)和平面外旋轉(out-of-plane rotation)屬性上性能也較SCF更好。

4 結束語

本文針對現有支持向量相關濾波器方法存在樣本邊界不連續問題的缺陷,提出了基于空間正則化約束的支持向量相關濾波器模型。通過添加二值函數形式的掩膜矩陣,提出的方法可以使得相關濾波器模型的系數僅集中于目標部分,由此抑制邊界不連續樣本對模型學習的負面影響。此外,本文提出了一種ADMM算法用于模型求解,可以保證每個子問題具有解析解。在OTB-2013和OTB-2015數據集的實驗表明,本文提出的方法相比于基線方法SCF有明顯的性能提升,同時僅帶來較小的額外計算開銷。

參考文獻

[1]BOLME D S, BEVERIDGE J R, DRAPER B, et al. Visual object tracking using adaptive correlation filters[C]//IEEE Conference on Computer Vision and Pattern Recognition. San Francisco, CA, USA: IEEE, 2010: 2544-2550.

[2]HENRIQUES J F, CASEIRO R, MARTINS P, et al. High-speed tracking with kernelized correlation filters[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 1: 125-141.

[3]RODRIGUEZ A, BODDETI V N, KUMAR B V, et al. Maximum margin correlation filter: A new approach for localization and classification[J]. IEEE Transactions on Image Processing, 2013, 22(2): 631-643.

[4]ZUO Wangmeng, WU Xiaohe, LIN Liang, et al. Learning support correlation filters for visual tracking[J].IEEE Transactions on Pattern Analysis and Machine Intelligence, 2019, 41(5): 1158-1172.

[5]DANELLJAN M, HGER G, KHAN F, et al. Learning spatially regularized correlation filters for visual tracking[C]//IEEE International Conference on Computer Vision. Santiago, Chile: IEEE, 2015: 4310-4318.

[6]GALOOGAHI H K, FAGG A, LUCEY S. Learning background-aware correlation filters for visual tracking[C]//IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA: IEEE, 2017: 1135-1143.

[7]PETERSEN K B, PEDERSEN M S. The matrix cookbook[EB/OL].[2012-11-15].http://matrixcookbook.com.

[8]WU Y, LIM J, YANG M H. Online object tracking: A benchmark[C]//IEEE Conference on Computer Vision and Pattern Recognition. Portland, OR, USA: IEEE, 2013: 2411-2418.

[9]DANELLJAN M, KHAN F S, FELSBERG M, et al. Adaptive color attributes for real-time visual tracking[C]//IEEE Conference on Computer Vision and Pattern Recognition. Columbus, OH, USA: IEEE, 2014: 1090-1097.

[10]DANELLJAN M, BHAT G, KHAN F S, et al. ECO: Efficient convolution operators for tracking[C]//IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA:IEEE, 2017: 21-26.