基于時空特征的生豬動作識別

蘇森,陳春雨,劉文龍,李誠

哈爾濱工程大學 信息與通信工程學院,黑龍江 哈爾濱 150001

近些年,我國的養殖業、畜牧業發展十分迅速,無論是從養殖質量還是養殖結構,都在轉型為現代畜牧業方向。行業共識已經發展為規模化,集約化。同時,高污染、高耗能的小規模散養方式逐漸褪去市場優勢,最終將成為歷史[1]。隨著每年生豬出欄總數不斷達到歷史新高,至2018 年底,我國生豬全年產量已突破7.2 億頭,與2000 年比較,增速為41%[2]。然而,隨著養殖產業向著更大規模發展,傳統人工監控、投料、飼養已經無法滿足養殖的高效性。現代的、科學的生豬養殖模式被逐步推廣。通過觀察了解圈養生豬的生活習慣,發現生豬的姿態、行為與其情緒以及健康狀況都有一定的聯系[3]。例如,當生豬出現長期趴臥、食欲不振、離群活動以及單獨休息等一些異常情況時,極大可能表明該生豬出現了病情[4]。在傳統的生豬養殖產業中,生豬病情主要靠飼養員自主觀察判斷。對于大規模的養殖場,這樣的工作不僅耗費大量的人力,而且十分依賴于飼養員的個人素質和知識儲備。即便如此,若想詳細地了解每一頭生豬的健康狀態,仍然是一件非常困難的事情。養殖無人化是未來的大勢所趨,對于生豬研究的最終目的是用機器代替人進行實時監控、預警甚至處理,因此對生豬行為動作的檢測很有研究價值。王傳哲等[5]通過可穿戴微慣性傳感器采集4 類動作對應的加速度、角速度和姿態角共6 000 組數據,使用BP 神經網絡對數據進行訓練與推理。張聰[6]建立生豬體態12 種特征數據集,使用決策樹支持向量機對特征進行分類。嵇楊培等[7]通過改進YOLOv2 神經網絡識別生豬進食、飲水行為。

1 動作識別網絡

目前,隨著計算機硬件發展,尤其是圖形處理器(graphics processing unit,GPU)等運算能力的提高,促進了深度學習的發展和應用。其中動作識別是一個熱門的研究方向[8]。最常見的動作識別方法應用是將給定的視頻通過卷積網絡分類為確定的類別。然而實際應用中視頻不僅存在多種類別的動作,還有復雜的干擾背景[9]。本文使用二維卷積神經網絡(2D-CNN)提取空間特征,三維卷積神經網絡(3D-CNN)提取時序特征,將空間特征、時序特征相融合,提出了一種分析生豬在視頻中位置和運動狀態的方法。

1.1 動作識別網絡結構

本文采取的網絡結構如圖1 所示。

圖1 本文提出的動作識別網絡結構

整體設計在目標檢測網絡YOLOv2 的基礎上,添加了1 路并行3D-CNN 支路提取時序特征信息,2D-CNN 提取空間位置信息。2 路特征融合時,使用通道注意力模塊,使2 路特征進行充分的關聯,最后通過一個卷積層得到邊界框預測、分類的輸出。

1.1.1 特征提取網絡

由于時間序列信息對豬的行為理解十分重要,故本文網路結構使用3D-CNN 來提取時空特征。其計算過程如圖2 所示。

圖2 3D-CNN 計算過程

采用連續視頻幀數據提取特征時,將多幀數據拼接為一個數據長方體,同時卷積核也具有3 個維度,三維卷積核在數據長方體中有3 個滑動的方向,利用這種結構和計算方式,多個相鄰幀的特征會映射到同一個輸出,從而獲得時序運動信息。并行3D 支路輸入的是視頻數據,如圖1所示。在本文中3D 支路輸入16 幀視頻序列,在計算量方面,3D-CNN 相對2D-CNN 計算量較大,訓練、推理耗時較長,所以本文3D-CNN 主干網絡為3D-MobileNet。

2D-CNN 解決空間定位問題,視頻序列最后一幀作為關鍵幀輸入2D 支路,2D-CNN 計算過程如圖3 所示。卷積核具有2 個維度,只在2 個方向上運動,可以提取二維圖像中目標的特征。本文使用的主干網絡為Darknet-19,能很好地平衡準確率和速率之間的關系。

圖3 2D-CNN 計算過程

1.1.2 通道注意力模塊

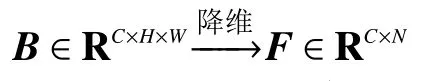

為了使2D 支路和3D 支路的輸出特征圖平滑地融合,本文將3D-CNN 輸出的特征圖壓縮一個維度,使其最后2 個維度和2D 支路輸出相等,然后沿著通道方向將2 路特征圖進行拼接。這2 路特征包含了位置空間信息和時序運動信息。但是這2 路特征沒有進行很好地聯系融合,故使用了通道注意力模塊,這種注意機制有利于合理融合來自不同來源的特征,顯著地提高了整體性能,通道注意力模塊結構如圖4 所示。

圖4 通道注意力模塊

圖中B∈RC×H×W。

式中:C為通道數,H為特征圖的高,W為特征圖的寬。

通過將特征圖B維度減少一維,變為矩陣F。然后對F與其轉置FT進行矩陣積的操作:

得到矩陣G,它表示了不同通道的特征聯系。G中每個元素表示每個通道特征向量化映射i和j之間的內積,具體表現形式為

對矩陣G進行softmax 操作生成矩陣M,其中每個元素Mij是評判第j個通道對第i個通道影響的程度,所以矩陣M代表通道之間的聯系程度:

使注意力模塊與原始特征圖相結合,將矩陣M與矩陣F進行矩陣乘法得到矩陣F′:

將矩陣F′增加一個維度與注意力模塊原始輸入特征圖B維度相等:

原始輸入特征圖B與F′′相結合,α為可學習的參數,初始值為零:

輸入特征圖O的每個通道的特征是所有通道的特征和原始特征的加權和。這樣的網絡結構涉及到了所有通道的特征圖,使2D 支路和3D 支路更加平滑且合理的融合,增強了特征識別的能力。

1.2 包圍框回歸和動作分類

本文采用了YOLOv2 目標檢測算法進行動作的分類和包圍框的回歸[10],該方法是2016 年Redmon 等[11]提出的YOLO 目標檢測算法的改進版本,算法在速度上大幅提升。該方法的缺點是小目標檢測能力相對較弱。本文所使用的數據集中只對某一欄生豬進行檢測,其體積相差不大,不存在小目標的情況,且監控視頻需要在嵌入式設備中實時檢測,所以本文使用的方法是基于YOLOv2 目標檢測算法進行設計。

包圍框回歸與YOLOv2 方法遵循相同準則,對于網絡輸出特征圖的每個網格,使用k-means算法在訓練集聚類出5 個先驗包圍框,使網絡最終輸出的特征大小為[5×(Nc+5)×7×7],其中N代表數據集有Nc個動作類別,此外還有包圍框4 個坐標和前景概率得分,根據所得這些參數對包圍框回歸與動作分類[12]。

包圍框回歸采用Smooth L1 損失函數,其對異常值敏感度較低,防止梯度爆炸。前景概率得分采用L2 損失函數,優點為收斂速度較快,加快了訓練的時間。分類概率使用Focalloss 損失函數解決類別不平衡問題:

式中:y′為預測值;y為真實值;1 和0 分別為正例和負例;γ、α為權重影響因子,表示正例或負例對權重的影響程度,用來平衡樣本不平衡的問題,需要預先設置參數。

樣本越容易檢出,則其貢獻的損失就越少,同時,較難檢測出的樣本對于權重更新的比重就會變大[13]。

2 實驗

2.1 生豬動作數據集

目前,關于生豬的動作姿態研究較少,相關公開數據集難以獲得,所以本文的數據集通過采集某生豬養殖場真實數據,并通過人工標注的方法進行制作。采集2 個群養欄共12 段監控視頻,總計1 456 f,圖片分辨率大小為320× 240。動作分為躺臥、站立和移動3 類。

2.2 生豬動作識別實驗

2.2.1 實驗環境和設置

本文訓練的設備參數如下:Ubuntu 18.04,顯卡為GTX1080,顯存8 G,CPU 為i7-8700K,內存16 GB。

在模型參數設置上,模型輸入圖片分辨率大小為224 ×224。權重更新方法采用具有動量的小批量隨機梯度下降算法,動量值為0.9,學習率初始值為0.000 1。由于數據集較小,在1 000、2 000、3 000 和4 000 代后,學習率每次衰減一倍。實驗代碼基于深度學習框架PyTorch,實現模型端到端的訓練。測試中,只檢測置信度大于0.25 的包圍框,使用非極大值抑制(non-maximum suppression,NMS)對包圍框進行處理,交并比(intersection over union,IOU)閾值為0.4。

2.2.2 數據集包圍框聚類

為了檢測出的包圍框和實際標注的包圍框有更大的IOU,訓練時加速收斂,對標注的包圍框尺寸進行k-means 聚類操作。對數據集包圍框的尺寸數據和聚類中心坐標數據進行可視化,如圖5所示。

圖5 生豬動作數據集檢測框聚類

數據點橫縱坐標是包圍框所占圖像像素的大小,從圖5 中可以看出,自制生豬動作數據集包圍框大部分分布在20 ×20 到70 ×120 之間,較小尺寸的包圍框所占比例也較小。

2.2.3 并行3D-CNN 有效性實驗

在連續輸入16 f 的情況下,對不同網絡組合結構的模型進行測試。評價標準為各個類別的平均準確率(AP0.5),下標代表檢測出的包圍框與真實標注值IOU 閾值為0.5。由于自制數據集數據量相對較少,容易產生過擬合現象,本次實驗中3D 支路迭代1 000 次后,3D 支路參數停止更新,只更新2D 支路的參數。

測試結果如表1 所示。只使用2D 網絡檢測指標比較低,這是因為沒有結合時序特征信息,單純使用3D 網絡;AP0.5明顯優于2D 網絡,說明3D 網絡在獲取時序動作特征時更具優勢,更加關注于運動的過程,但是時間序列中生豬的位置變動會導致定位能力下降;而在2D 和3D 網絡相結合時,將關鍵幀的空間位置信息和時間序列動作信息結合,檢測指標有一定的提升。對于本文數據集所涉及的躺臥、站立和移動3 種動作,其中移動動作具有更多的時序信息,所以(表1)使用3DCNN 后,移動動作AP0.5提高最多。

表1 不同網絡結構實驗結果

該實驗證明了在目標檢測網絡中,添加3DCNN 提取時序信息,有助于時空動作識別和定位。

2.2.4 通道注意力模塊實驗

2D 支路與3D 支路特征融合時,本文使用了通道融合注意力機制。如表2 所示,該實驗研究了通道注意力模塊對檢測結果的影響。結果表明通道注意力模塊對特征融合具有積極作用。

表2 通道注意力模塊對網絡的影響

2.2.5 不同序列采樣間隔實驗

模型輸入為不同采樣間隔的視頻序列,輸入跨度為16 f,序列保留最后一幀作為關鍵幀輸入2D 支路。實驗結果如表3 所示。

表3 視頻序列采樣間隔網絡實驗效果

采樣間隔為1 時,AP0.5優于連續輸入16 f,該實驗表明了對于本文所采用的生豬動作數據集中視頻幀之間存在冗余信息。

采樣間隔繼續增大到2 時,移動動作AP0.5開始下降,而靜止動作躺臥、站立的AP0.5基本保持不變或略有上升。這表明檢測靜態動作時,2D 圖像就可以提取足夠的特征信息;而對于動態動作,需要有足夠的時序信息。

采樣間隔繼續增大到3 時,3D 支路實際輸入的視頻序列只有5 f,這時各個動作的AP0.5都有下降,但是與表1 所得結果相比,仍然優于只使用2D 支路的網絡結構。

3 結論

本文針對生豬動態運動特征,采用了并聯一路3D 網絡和一個用于融合不同特征的注意力機制,提出了一種結合時空信息的動作識別與定位的方法。

1)本文通過實驗證明了3D 加2D 的特征提取網絡結構和通道注意力機制在生豬動作的時空定位任務上具有充分的有效性。

2)將深度學習技術運用到生豬的動作識別,有利于實際的應用。

3)本文算法適用于目標相對較大的場景,針對小目標檢測問題還有研究空間。

接下來還可以考慮使用FPN 結構優化小目標檢測能力,提高算法在不同場景下的泛化能力和魯棒性。另外3D 卷積參數量巨大,計算時間較長,因此對模型的壓縮剪枝也將成為未來研究的重點。