基于改進U-Net的建筑物集群識別研究

武宇,張俊,李屹旭,黃康鈺

(1.貴州大學礦業學院,貴陽 550025;2.貴州大學農學院,貴陽 550025)

0 引言

現代科學技術的日益發展,城市建筑物外觀設計也隨之趨于復雜,表觀信息豐富,致使傳統低分辨遙感影像已遠遠不能表達現代建筑物的精細特征。高空間分辨率衛星的升空使得利用高分影像對建筑物分割成為可能[1-2]。然而,盡管高分辨率遙感影像豐富的細節特征在一定程度上增大了目標地物的類內差異、減小了類間差異,但是“同物異譜,同譜異物”的現象卻變得更加普遍、明顯,同類地物在影像上的形態與特征可能大相徑庭,直接加大了類內混合像元及陰影等因素的影響。為此,一些學者曾引入一些模式識別算法,如最大似然分類法(maximum likelihood classification,MLC)和支持向量機(support vector machine,SVM),此后,一些學者提出了一種基于數學形態的合成核SVM算法[3-5],利用空間統計因素作為數據源,通過不同的合成核構造方式將空間信息和光譜信息融合,引入遙感圖像分類中。但是,這些算法僅利用圖像的光譜信息,忽略了其空間結構紋理的作用,因而在提高分類精度的過程中還存在局限性,常常會導致提取精度過低、邊界不完整等問題。另外,圖像中的噪聲如傳感器產生的熱噪聲、脈沖噪聲和數字化過程中出現的量化噪聲等,也會對圖像壓縮、邊緣檢測以及圖像分割過程造成嚴重影響[6]。

近年來,逐步興起的深度學習算法在計算機視覺領域中帶來的顯著效益引起了大量研究者的關注。深度學習算法以數據作為驅動,更加適用于目前遙感影像數據大量積累的情況,且由于其在圖像分割中的出色表現,很快被引入遙感影像地物提取中,并已取得了不錯的效果[7-8]。例如方旭等[9]證明利用改進的全卷積神經網絡(fully convolutional networks,FCN)可做出優良的結果,較SVM算法提升效果約10%;2012年,Krizhevsky等[10]提出了名為AlexNet的卷積神經網絡(convolutional neural networks,CNN)結構,并在ImageNet競賽中以領先第二名10%的成績獲得冠軍;Mou等[11]首次將循環神經網絡(recurrent neural network,RNN)應用在高光譜圖像分類中,較SVM達到了更高的精度;陳睿敏等[12]利用U-Net深度學習模型對紅外遙感影像進行地物分類,較傳統機器學習方法提升6%。

各類深度學習模型中,U-Net模型由于學習能力強、易于擴展、整體性能穩定、魯棒性強等特點而備受青睞[13-17]。但是,U-Net網絡模型最初被用于檢測醫學影像,而高分遙感影像不同于醫學影像,不僅具有光譜特性,還具有非常復雜的空間結構、紋理特征和上下文關系,如果簡單地采用U-Net模型,則很可能在最大池化采樣中丟失一些細節信息,尤其是圖像邊緣特征的損失,從而導致分類失真[18]。為此,本文提出首先采用域變換遞歸濾波(domain transform recursive filter,DTRF)對高分影像進行預處理,在一定程度上抑制噪聲并盡量保證影像邊緣信息,以此確保U-Net神經網絡對高分影像更正確的分割;同時,嘗試采用從訓練圖像和標簽中提取成對的補丁以增加訓練數據對U-Net編碼-解碼環節進行改進,這些補丁可望進一步加強正反向深度學習中建筑物高維特征的獲取,以此提高建筑物識別精度,為方便簡記該方法為DTRF-Unet。

1 基于DTRF-Unet方法對高分遙感影像建筑物的提取原理

1.1 DTRF濾波

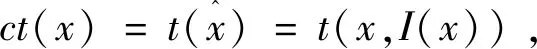

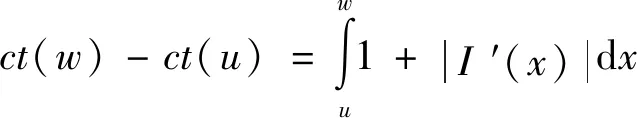

DTRF是一種實時的邊緣保留濾波,其在改善圖像分類的性能中非常有效,一維DTRF對信號經過平滑后可以很好地去除噪聲,而且主要邊緣信息也可以得到保留[19-21]。濾波過程可分為域變換和遞歸濾波兩步,DTRF過程如下:

|t(xi,I(xi))-t(xj,I(xj))|=‖(xi,I(xi))-(xj,I(xj))‖,

(1)

ct(x+h)-ct(x)=h+|I(x+h)-I(x)|。

(2)

其中得到的R中的相鄰樣本之間歐式距離必須等于R2間的距離,h在此處為信號上兩相鄰采樣間隔,為簡化計算,通常假設ct單調遞增,上式兩端同除以h且取極限趨向0得:

ct′(x)=1+|I′(x)|。

(3)

那么在Ω中的(u,w)兩點間的距離可表示為:

(4)

可見,曲線ct在1范數下的弧長被保留了下來,而所有點之間的測地距離可以通過式(4)計算。

在實際濾波過程中,為了控制濾波器的尺寸和模糊度,常常將域變換定義為應用近似距離變換,即對于給定的一維信號I,域變換被定義為:

(5)

式中:Ui為域變換信號;δr和δs分別為與值域標準差(控制濾波器模糊度)和與信號空域標準差(控制濾波窗口尺寸);n為像元個數,輸入信號通過遞歸濾波器進行處理,即

Ji=(1-ab)Ii+abJi-1,

(6)

式中:Ji為第i個像元的濾波輸出;a為反饋系數;b為變換域中兩個相鄰樣本的距離。當圖像接近邊緣時,b不斷增大,ab趨于0,迭代運算終止,從而達到邊緣保留的目的。

1.2 U-Net神經網絡

U-Net神經網絡模型由Ronneberger等于2015年首次提出[22-23],最初應用在醫學影像處理,因其形狀恰似“U”形而得名。U-Net是一種典型的編碼-解碼(encoder to decoder)結構,在encoder模塊使用卷積(conv)與最大池化(maxpooling)操作提取圖像的低級特征,在decoder模塊使用向上解碼(up-sampling)與conv恢復輸出圖像(feature map)的分辨率提取高維特征,在相對應的conv之間融合特征信息。up-sampling僅僅是將抽象高維特征恢復到模板的過程,解碼在將編碼壓縮數據恢復的時候,特征scale會發生變化,這時橫向連接的skip connection起到了補充信息的作用,在高層補充了語義的信息,在底層則細化了分割的輪廓等[24-25]。所以從特征中已經大致恢復了區域的分割信息,再加上原始特征的修正,可以提高最終的分割效果。

1.3 改進的U-Net神經網絡

U-Net架構對于復雜度并不高的基礎模型能夠達到很高的精度,且能在精度與復雜度之間達到平衡,但是遙感影像背景復雜,所包含的地物種類豐富,光譜范圍廣泛,直接采用U-Net網絡構架并不能有效地提取復雜的遙感影像的像元特征。鑒于U-Net網絡訓練過程中收斂速度快,為滿足包含多語義信息的高分遙感影像信息提取,本文使用上述U-Net網絡作為基本構架對其進行改進,具體過程如下:

1)該網絡結構與主流的圖像分割網絡一樣采用對稱的encoder to decoder結構,使用隨機位移矢量算法使訓練集產生彈性形變,增加訓練集特征。

2)U-Net網絡進行部分卷積優化,從訓練圖像和標簽中提取成對的補丁,以增加訓練數據集的大小,并使訓練更加穩健。

3)在訓練過程中每個小批包含16個補丁,在每一個時代的每一次迭代中,都會從圖像中的隨機位置提取出上千個小批量補丁。

4)采用的U-Net網絡的up-sampling依然有大量的通道,這使得網絡將上下文信息向恢復feature map的更高分辨率傳播。

5)設置初始學習率為0.005,并使用L2范數控制學習率的漸變曲率。

2 實驗及分析

DTRF-Unet網絡模型整體方案和訓練流程如圖1所示,該方案的實施主要分為數據預處理、模型訓練和結果分析3個模塊。為驗證本文方法的提取效果,分別采用U-Net和DTRF-Unet網絡模型分別對研究區遙感影像中的建筑物進行提取,并做對比分析。

圖1 實驗流程圖Fig.1 Flow chart of the experiment

2.1 實驗數據及數據集制作

實驗區定址于遼寧省盤錦市緊接渤海灣地區,平均海拔約30 m,中心經緯度分別為E121.16° ,N41.12°。實驗區的地貌主要類型是大面積沖海積平原和潮灘,地貌類型相對單一,地勢平坦,土地類型主要為建筑用地和耕地。選用2019年9月29日高分二號影像(圖2)。高分二號衛星搭載2臺高分辨率1 m全色、4 m多光譜相機,具有米級空間分辨率。首先對高分二號影像的全色波段和多光譜數據進行預處理,包括正射校正、數據融合和裁剪等操作[26]。因U-Net模型采用數據增強得方式可有效利用訓練數據,加之考慮到RTX2060顯卡計算能力和影像質量因素,故在較多建筑物的影像中心區域,選取尺寸為1 829像素×1 410像素作為驗證數據集,選取尺寸為954像素×936像素作為訓練集,選取尺寸為1 718像素×1 303像素作為測試集。最后對數據集進行人工標注,使之成為二通道數據,即建筑物標注為1,其他標注為0,與數據集共同輸入DTRF-Unet模型計算。

圖2 實驗樣本Fig.2 Experimental samples

為充分發揮深度學習的優勢,所以對訓練集采用面向對象分類的方法,充分利用遙感影像的空間信息、光譜、紋理、相鄰關系、形狀等特征進行分割分類,采用此方法標注影像得到地表真實地物(ground truth);然后對數據集進行數據增強,并根據數據集圖像的均值和方差對所有圖像進行歸一化,將數據集輸入集成了多尺度交叉訓練、多重損失計算、引入一階動量的隨機梯度下降(stochastic gradient descent+momentum,SGDM)優化的神經網絡模型U-Net中進行訓練。在訓練過程中,經數據預處理后每次選取的訓練樣本大小為256×256,訓練和驗證的數據集均包含與相應真實地物對應的標簽數據集;然后將訓練集圖像輸入到U-Net網絡中,進行充分訓練后得到優化的網絡模型,最后將測試圖像輸入訓練好的模型中,得到預測結果,根據濾波前后的訓練結果計算分析。

2.2 實驗結果與分析

經改進后的影像預處理的過程中需要首先使用DTRF濾波器進行處理,為此,需要確定濾波器的信號空域標準差δs和值域標準差δr兩個平滑參數,不同的平滑參數會導致不同的結果。經過如下過程確定合適的取值區間,上行δs設置為30,δr分別設置為0.2,0.4,0.6;下行設置δs為60,δr分別設置為0.2,0.4,0.6。圖3以圖2中紅框區域為例展示不同平滑參數的濾波效果,其中圖3(a)為原始數據。可以看出,在δs分別為30和60的情況下,當δr為0.6時圖像發生明顯的涂抹效應,當δs為60時會比δs為30時涂抹效應更嚴重。但是當濾波窗口非極大值時,濾波后圖像與輸入圖像鮮有差異,同時當超過某一范圍后,濾波結果將不會發生太大的變化。也就是說明當參數設置恰當時,DTRF濾波不僅可以有效去除圖像中的噪聲、細節紋理等信息,同時可以增強圖像中空間結構信息。

(a)原始數據 (b)δs=30,δr=0.2 (c)δs=30,δr=0.4 (d)δs=30,δr=0.6

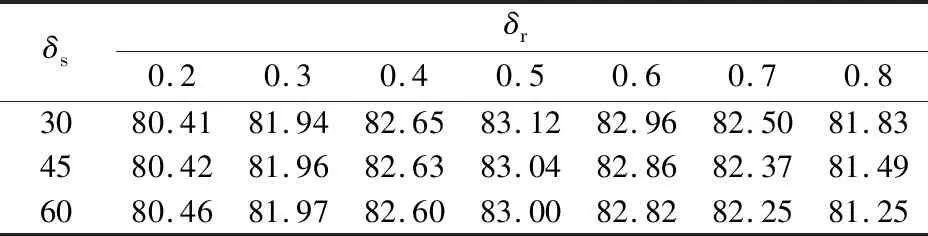

圖3已表明不同的δs和δr會帶來不同的數據處理精度,為此,進一步取在30~60區間按步長15遍歷δs值,δr按步長0.1遍歷區間0.2~0.8,分別計算精度(precision)、標準差(standard deviation,SD)、結構相似性(structural similarity,SSIM)和平均交并比(MIoU)4個指標來衡量提取質量(圖4)。

(a)SD (b)精度

SD可以反映出圖像像素值與均值的離散程度,SD值大小與圖像質量呈正相關;SSIM表現出處理前后數據的結構相似性,是基于圖像的亮度、對比度和結構3個要素來評定,值越大代表與原始數據相比保留細節越多,信息保留程度越高;MIoU也是在深度學習中衡量分割精度的重要指標,即在每個類別上計算交并比取均值,與分割精度同樣保持正相關性。整體分類精度最終結果列于表1。

表1 不同參數下DTRF-Unet整體分類精度Tab.1 Overall classification accuracy of DTRF-Unet under different parameters (%)

可以看出,當δr在0.6~0.8之間SD最小(圖4(a));當δr在0.5~0.6之間精度較高,最低處在δr為0.2處為80.41%(圖4(b));δr在0.2~0.6之間SSIM沒有發生明顯變化,δr為0.7~0.8時SSIM開始下滑,意味著逐漸與原圖像異質化(圖4(c));MIoU用于測量真實和預測之間的相關度,相關度越高,該值越高,一般來說大于0.5可以認為結果較好,圖4(d)中最低值在δr處于0.2時取到,但結果均大于0.67,在δr為0.4時取到極大值。綜合圖4可以看出:整體質量保持在δr為0.5時精度達到最高,δs對分類質量沒有明顯影響,基本處于同一等高線,經濾波后的整體分類精度近似保留兩位小數后均保持在80%以上,識別效果較好。根據表1可知在δs為30,δr為0.5時取得最佳精度83.12%,較濾波前U-Net分類精度的75.99%提高了7.13百分點,驗證了DTRF-Unet方法作為改進的U-Net深度學習網絡處理圖像的有效性。

圖5以圖2中黃色框區域為例對比改進前后的提取效果。樣本區選擇在城市群中,分為建筑物和其他類別兩類,深藍色為建筑物類,天藍色為其他類。利用原始U-Net深度學習方法對樣本數據進行提取,從圖5(a)提取建筑物的結果可以看出U-net在城市群處理過程中提取精度較高,建筑物輪廓較明顯,部分道路線也對城市集群有明顯的分割效果,且基本沒有細碎的噪聲斑塊,東北方向的林地也被正確地劃分到了其他類中,但是整體精度只有75.99%。最后對DTRF-Unet的21個結果匯總分析極化結果之間的差異如圖5所示,發現在樣本區的東北方向和中部偏南方向箭頭標注方向有明顯差異,圖5(b)較圖5(a)和圖5(c)更接近地面真實情況,圖5(b)將部分建筑用地誤判為其他類,與上文驗證精度相一致,但是在部分地區還是存在明顯的漏分錯分誤差,可能受到訓練樣本數據大小和影像陰影區域較大影響。圖5(b)通過選取適當的參數有效剔除了噪聲,使建筑物邊界更加平滑,預測結果得到進一步優化。

(a)U-Net (b)δs=30,δr=0.5 (c)δs=30,δr=0.2

3 結論

1)針對常規U-net神經網絡模型在高分影像最大池化采樣中,可能丟失一些細節信息,尤其是圖像邊緣特征的損失,從而導致建筑物提取不全或邊緣模糊問題,提出了一種基于常規U-Net的改進的智能建筑物識別提取方法,即DTRF-Unet模型。

2)該模型能很好地將低層高分辨率信息與高層抽象的語義信息融合減小建筑物細節特征損失,既增強了網絡的泛化表達能力,又提高了建筑物提取精度。通過與原始結果對比發現,該方法可以近似完整地將建筑物自動分割出來,具有高效性和可實施性。

3)在濾波預處理時,采用以一定步長遍歷某段區間,觀察濾波效果進而確定DTRF兩個平滑參數的方法雖然效率較低,但是在目前尚缺乏實質高效的自適應方法條件下,不失為一種有益嘗試,為此類研究提供一定參考。但是受計算能力限制,模型分割不夠細致,時間性能還有待提升,同時該實驗對于部分陰影區域的識別精度有待商榷,這將是下一步研究的重點內容。