雙視覺注意網絡的聯合圖像去霧和透射率估計

馮燕茹

(防災科技學院 信息工程學院,河北 三河065201)

1 引言

受空氣中懸浮顆粒(如霧,霾)的影響,捕獲的戶外圖像會出現對比度低,色彩飽和度差,顏色偏移等圖像退化問題,嚴重了影響了戶外計算機視覺技術,如目標檢測、目標識別、目標跟蹤的發揮,進而增大了戶外機器視覺任務的難度。因此,對霧天場景下獲取的退化圖像實施去霧處理具有重要的現實意義和應用場景[1-2]。

目前常用的圖像去霧方法主要分為兩類:一類為基于先驗的去霧算法,一類為基于神經網絡的去霧算法。基于先驗的去霧算法利用先驗信息估計大氣散射物理模型中的透射率和大氣光,從而求得清晰的去霧圖像[3-4]。如He及韓昊男等人利用暗通道先驗(Dark Channel Prior,DCP)在局部區域內計算透射率值[1,5]。Berman等人發現圖像中的像素點在RGB空間中可聚集成數百個顏色線,利用此非局部先驗(Non Local Prior,NLP)估計透射率[6]。Meng等人利用邊緣及紋理的約束先驗(Boundary Constraint and Contex?tual Regularization,BCCR)來計算透射率[7]。然而統計獲取的先驗信息無法適用于所有的霧天場景,導致算法魯棒性差,透射率估計存在誤差。

隨著深度學習的快速發展,基于神經網絡的圖像去霧算法廣受關注[8]。如Cai等人提出了Dehazenet網絡模型,學習霧圖與透射率之間的映射關系[9]。Li等人提出了端到端的All-in-One Dehazing Network(AODN)網絡模型直接從霧圖中估計清晰圖[10]。Qu等人提出了Enhanced Pix2pix Dehazing Network(EPDN)網絡模型,利用生成器估計去霧結果,使用辨別器監督EPDN模型的中間過程[11]。Liu等人提出了GridDeha?zeNet(Grid DN),它模仿傳統圖像處理算法,在網絡模型中加入預處理模塊及后期處理模塊來實施圖像去霧[12]。雖然上述網絡模型較基于先驗的去霧算法具有更好的魯棒性,但網絡的構建缺乏物理約束,未將大氣散射物理模型融入到網絡的構建中,限制了網絡的性能。Zhang等人提出了Densely Connected Pyramid Dehazing Net?work(DCPDN)模型,它利用生成器生成透射率和大氣光,再利用辨別器細化大氣散射模型估計的去霧結果[13]。隨后,Zhang等人提出的Joint Transmission Map Estimation and Dehazing Net?work(JTED)聯合網絡模型,將U型網絡估計的透射率視為霧濃度先驗,以引導后續網絡注意濃霧區域,有效實施去霧[14]。

雖然上述網絡模型的構建嵌入了大氣散射物理模型,但透射率估計與圖像去霧的相互關系并未深入探索。實際上,透射率的估計過程和圖像的去霧過程相互依賴,從透射率估計過程中獲得的霧濃度信息可用于圖像去霧。反之,去霧過程中獲得的無霧場景信息又可以進一步指導與場景深度相關的透射率估計。受注意機制的啟發,本文提出了雙視覺注意網絡模型,它包含兩個結構相同的單循環注意網絡層,分別為圖像去霧層及透射率估計層。對于每個單循環注意網絡又包含循環注意網絡和編碼解碼網絡。考慮到霧氣可以看成不同深度的霧層累積而成,對于圖像去霧層,可在真實透射率圖的監督下,利用循環注意網絡估計霧濃度注意圖,將其注入到后續的編碼解碼網絡以引導網絡感知霧的信息,準確實施去霧。同樣,對于透射率估計層,在真實無霧圖像的監督下,可利用循環注意網絡估計場景注意圖,注入到編碼解碼網絡,以引導網絡感知場景信息,準確估計透射率。其中,為了更深入地探索和挖掘透射率估計與圖像去霧過程中捕獲信息的相關性,在圖像去霧層及透射率估計層的循環注意網絡間實施信息交互,使得霧濃度注意圖和場景注意圖在信息互補的方式下生成。

綜上,本文的主要貢獻如下:(1)提出了雙視覺注意網絡模型,它包含圖像去霧層及透射率估計層。(2)在圖像去霧層中,循環注意網絡生成的霧濃度注意圖被注入到編碼解碼網絡中,引導該網絡感知霧濃度,實現去霧。在透射率估計層中,循環注意網絡生成的場景注意圖被注入到編碼解碼網絡中,引導該網絡感知場景,更好地估計透射率。(3)圖像去霧層的循環注意網絡及透射率估計層的循環注意網絡通過循環單元實現信息交互,在信息互補的方式下生成霧濃度注意圖和場景注意圖。實驗結果表明,本文算法較已有去霧算法具有更高的效率和精度。

2 雙視覺注意網絡的聯合圖像去霧和透射率估計

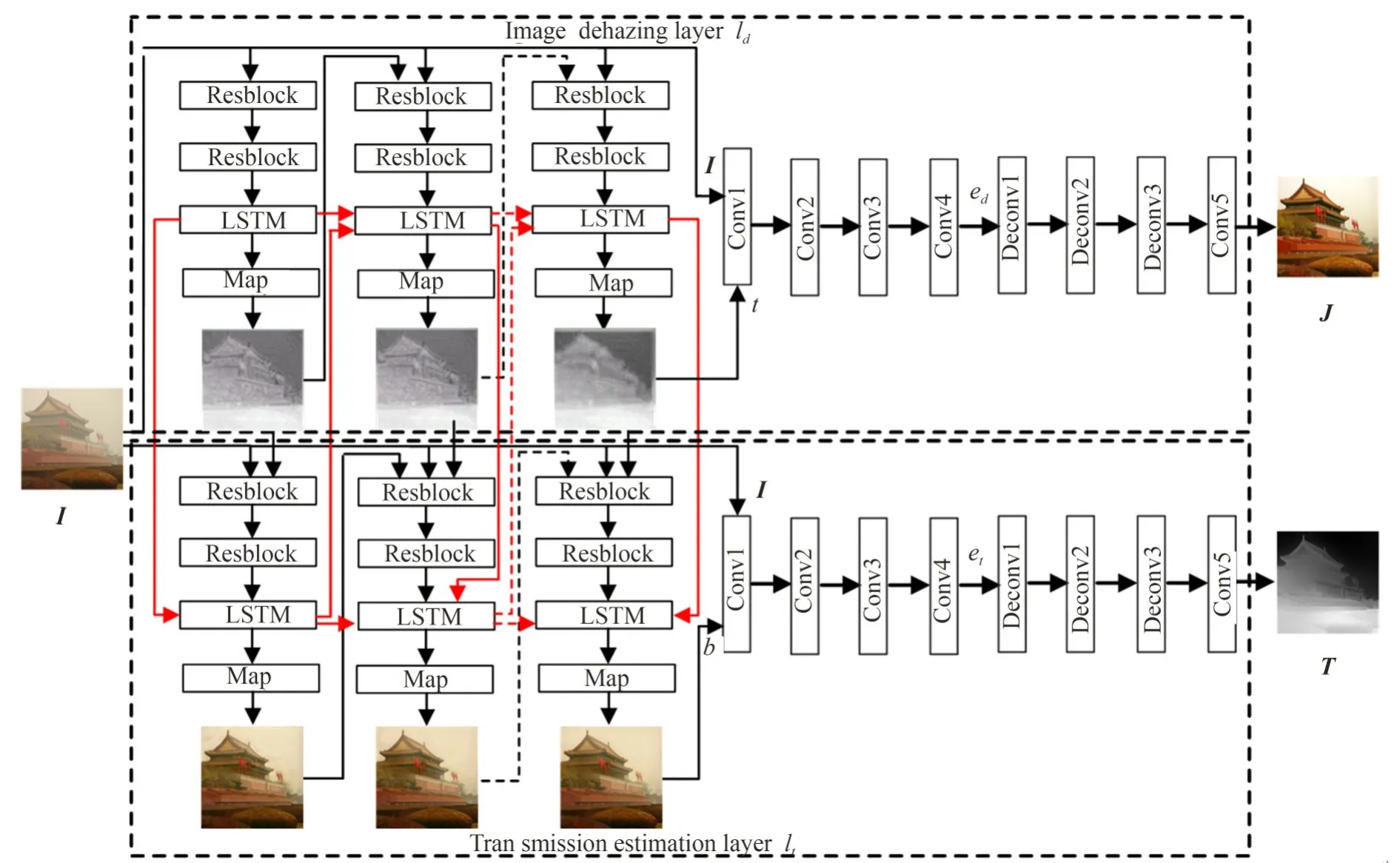

如圖1所示,雙視覺注意網絡包含兩層:用于估計透射率的lt層和用于預測去霧結果的ld層。lt層和ld層具有相同的網絡結構,即均包含循環注意網絡和編碼解碼網絡。其中,紅色和黑色的虛線均為省略循環操作中的連接(彩圖見期刊電子版)。循環注意網絡用于生成視覺注意圖,以引導后續的編碼解碼網絡預測相應的結果。這里,為了讓ld層能感知霧的濃度,采用透射率來監督ld層的循環注意網絡生成霧濃度注意圖,并引導后續的編碼解碼網絡實現去霧。相關操作如下:

圖1 雙視覺注意網絡結構Fig.1 Architecture of dual vision attention network

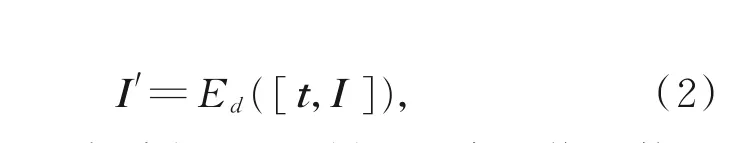

其中:H d和Ed分別為ld層的循環注意網絡函數和編碼解碼網絡函數;[]為級聯操作;I為初始霧圖;I′為去霧結果;t n與t n-1為第n及第n-1次循環時H d輸出;t為H d最終輸出的霧濃度注意圖。

另一方面,考慮到透射率與場景的深度相關,清晰的場景能為透射率的估計提供更準確的深度信息,利用清晰無霧圖像監督lt層的循環注意網絡產生場景注意圖,并將其注入后續的編碼解碼網絡,使其感知場景信息,估計透射率。操作如下:

其中:H t和Et分別為lt層的循環注意網絡函數和編碼解碼網絡函數;T′為透射率估計結果;b n與b n-1為第n次及第n-1次循環時H t的輸出;b為H t最終輸出的場景注意圖。

值得一提的是,公式(3)不同于公式(1),H t不但輸入了上次循環輸出的b n-1及初始霧圖I,還輸入了H d在第n次循環時輸出的t n。此設計充分挖掘了t n與b n的關聯性,利用霧濃度注意圖t n引導H t感知霧層的濃度,以有效估計背景注意圖b n。此外,更利用lt層及ld層中LSTM循環單元實現H t及H d的信息交互(見圖1中紅線),使得在估計場景注意圖的過程中能利用到霧濃度信息,在預測霧濃度注意圖的過程中能學習場景信息,從而形成高效的雙循環注意網絡。

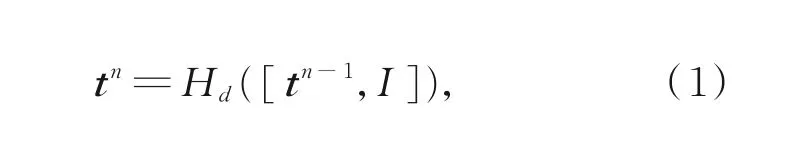

2.1 雙循環注意網絡

霧氣可以看成不同深度的霧層累積而成,因此采用循環網絡結構逐層提取霧的信息生產霧濃度注意圖及場景注意圖,不但符合物理假設,還能不斷校正上次循環時的估計誤差。

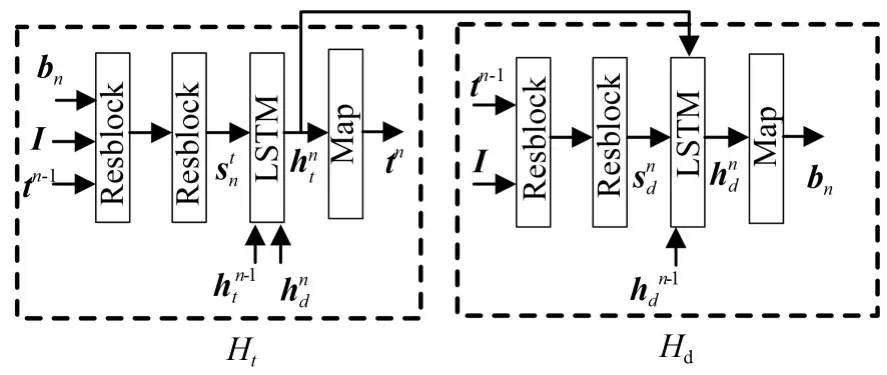

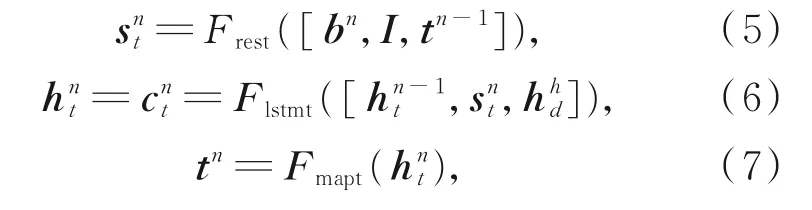

如圖2所示,lt和ld層中的H t和H d均有相同的網絡結構,并由以下模塊組成:2個稠密殘差模塊Resblock[15],1個LSTM循環單元[16]及1個映射層Map,每個Resblock包含2個核為3×3的卷積層。為了使H t和H d能利用彼此捕獲的信息幫助對方的循環網絡生成準確的注意圖,這里采用LSTM循環單元來實現雙循環注意網絡的隱藏信息交互。故公式(3)lt層中的循環注意網絡H t可進一步表示為:

圖2 雙循環注意網絡結構示意圖Fig.2 Architecture of dual recurrent attentive network

其中:Frest,Flstmt和Fmapt分別為H t中稠密殘差模塊函數,LSTM函數及映射層函數;s nt為第n次循環時,Frest函數的輸出;h nt和c nt為第n次循環時,H t中LSTM的隱藏狀態及記憶單元信息;t n第n次循環時Fmapt的輸出。從公式(6)可見,第n次循環時H d的隱藏狀態h hd與H t產生的h n-1t,s nt級聯,共同作為Flstmt的輸入。

與此類似,公式(1)ld層中的循環注意網絡H d可進一步表示為:

其中:Fresd,Flstmd和Fmapt分別為H d中稠密殘差模塊函數,LSTM函數及映射層函數;s nd為第n次循環時,Fresd函數的輸出;h nd和c nd為第n次循環時,H d中LSTM的隱藏狀態及記憶單元信息;b n第n次循環時Fmapd的輸出。同樣,采用第n次循環時H t的隱藏狀態h nt與H d產生的h n-1d,s nd級聯,共同作為Flstmd的輸入。

由此,H t和H d進行了信息交互,H t通過LSTM引入h d來補充學習估計背景注意圖b時所需的霧濃度信息,而H d通過LSTM引入h t來補充學習估計霧濃度注意圖t時所需的場景信息,從而形成信息充分挖掘和利用的雙循環注意網絡。

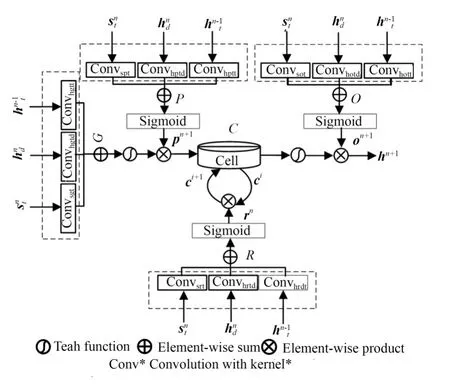

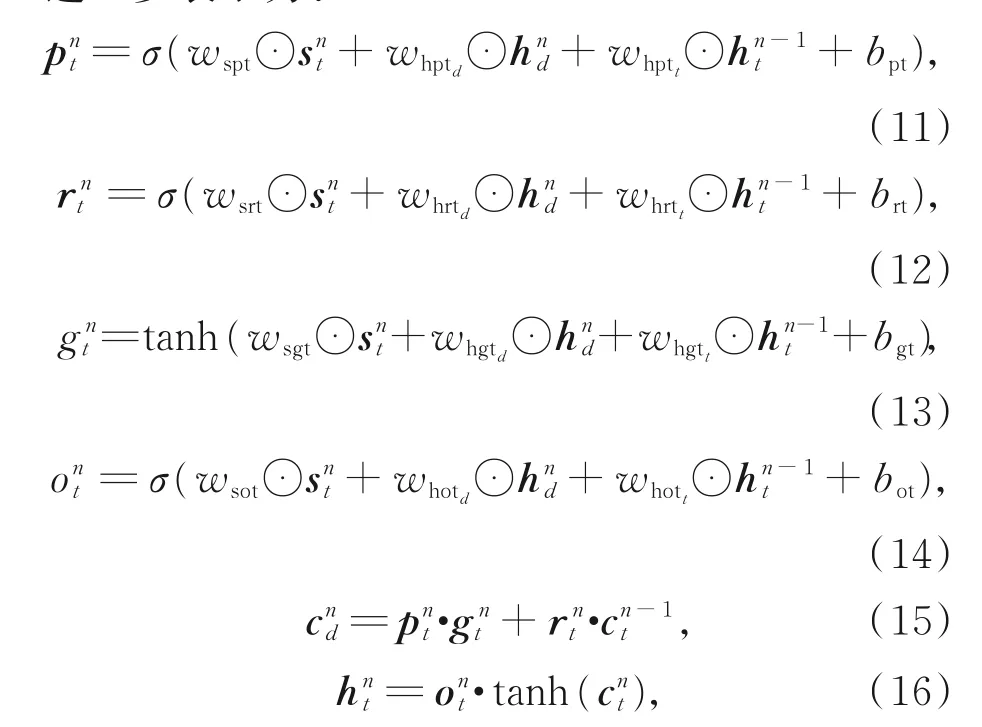

這里選用卷積LSTM循環單元來實現Flstmt及Flstmd。以Flstmt為例,其卷積LSTM如圖3所示,包含輸入門P,輸入門控制單元G,遺忘門控制單元R,輸出門控制單元O和記憶單元C,且P,O,G,R均利用3個卷積層來處理接收的特征。其中,輸入門P和輸入門控制單元G共同控制進入記憶單元的信息C;遺忘門控制單元R控制著記憶單元C中的信息被保留或被刪除;輸出門控制單元O控制從卷積LSTM中輸出信息。Flstmt可進一步表示為:

圖3 LSTM循環單元結構示意圖Fig.3 Architecture of LSTM recurrent unit.

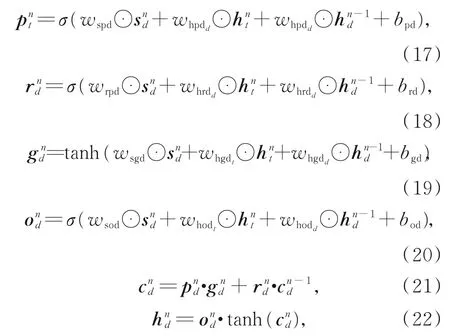

與此類似,Flstmd可進一步表示為:

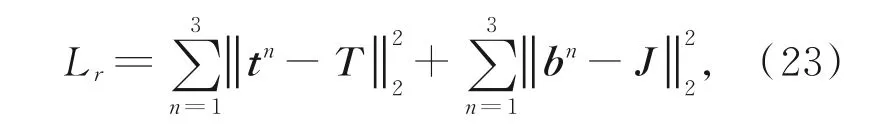

在訓練的過程中,使用真實無霧圖監督H t產生場景注意圖b,使用真實透射率監督H d產生霧濃度注意圖t。H t和H d均使用標準的L2損失函數,故雙循環網絡的損失函數L r定義如下:

其中:t n及b n為第n次循環時雙循環網絡輸出的霧濃度注意圖和場景注意圖;J為對應的真實無霧圖;T為真實透射率。如公式(23),實驗中設置雙循環注意網絡循環次數n為3。

2.2 編碼解碼網絡

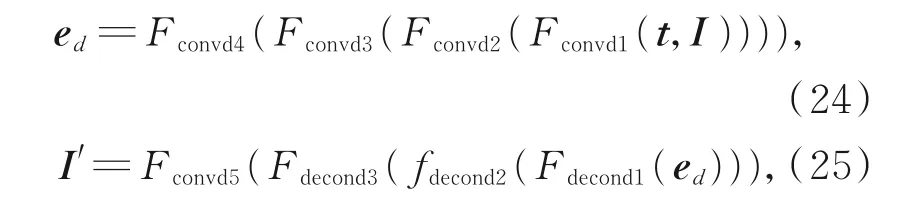

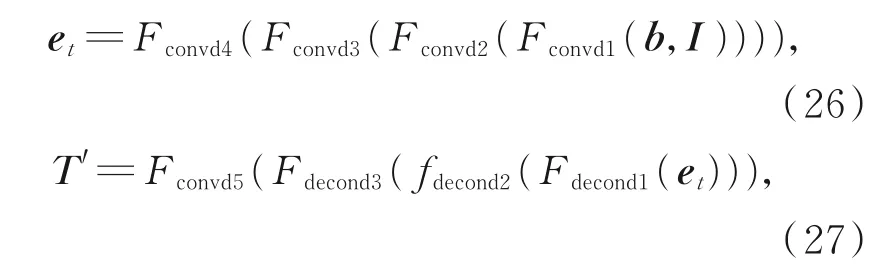

由雙循環注意網絡生成的霧濃度注意圖t及場景注意圖b被視為視覺注意先驗,分別注入后續的編碼解碼網絡,以便網絡感知霧的濃度及場景信息,更準確地預測去霧圖像及透射率。如圖1所示,ld層的編碼解碼網絡Ed及lt層的編碼解碼網絡E t具有相同的網絡結構,即編碼器包含4個核為3×3,步長分別為5,2,2,2的卷積層Conv,解碼器包含3個核為1×1,步長為2的反卷積層Deconv,以及1個核為3×3,步長為1的卷積層。故公式(2)中Ed函數可進一步表示為:

式 中:Fconvdx,x=1,2,...,4分 別 為ld層 編 碼 器 中4個 卷積函數;Fconvd5代表ld層解碼器中最后的卷積函數;Fconvdx,x=1,2,3代 表ld層 解 碼 器 中3個 反 卷 積 層函數;e d為ld層編碼器的輸出;I′為最終的去霧結果。

同理,公式(4)中Et函數可進一步表示為:

其 中:Fconvdx,x=1,2,...,4分 別 為lt層 編 碼 器 中4個 卷積函數;Fconvd5代表lt層解碼器中最后的卷積函數;Fconvdx,x=1,2,3代 表lt層 解 碼 器 中3個 反 卷 積 層函數;e t為lt層編碼器的輸出;T′為透射率估計結果。

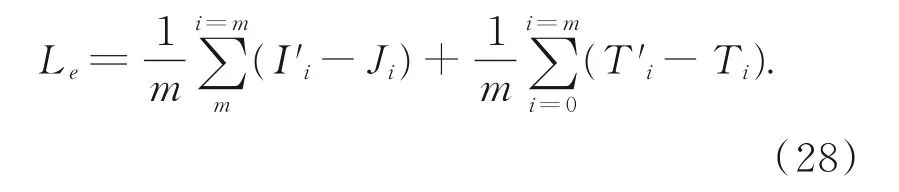

3 損失函數

模型的訓練通過最小化L2函數來計算網絡估計結果與真實結果間的差異。假設I′i和J i,i=1,2,...,m為一組合成霧圖和真實無霧圖。T′i和T i,i=1,2,...,m為一組合成圖像的透射率和真實透射率,則對應的損失函數為L e可表示為:

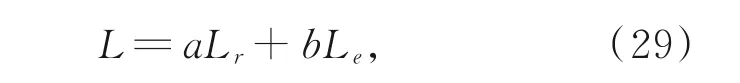

結合雙循環注意網絡的損失函數L r,雙視覺注意網絡的總損失函數L定義如下:

其中:a和b為L r和L e兩項的平衡系數,默認設置a=1,b=1。

4 實驗結果與分析

本文算法在NVIDIA RTX 2080 Ti GPU的硬件環境下,應用Pytorch深度學習框架搭建網絡實現。優化算法選用β1=0.999,ε=10-8的隨機梯度下降算法。為驗證本文算法的有效性,在合成霧圖及真實霧圖上對算法的性能進行驗證,并將本文算法與基于先驗的去霧算法和基于神經網絡的去霧算法相對比。

4.1 數據集

不同于已有的去霧網絡[17],本網絡模型的訓練集需要包含霧圖,清晰圖及透射率,故利用RESIDE數據集[18]和NYU-depth2數據集[19]創建包含室內和室外圖像的數據集。對于室內霧圖,從NYU-depth2中選取5000張圖,并在大氣光A∈[0.5,1],散射系數β={0.4,1.6}的范圍內合成數據集。對于室外圖像,從RESIDE數據集中選取5000張圖,并在A∈[0.8,1.0],β∈{0.04,0.06,0.08,0.1,0.12,0.16,0.2}范圍內合成相應的霧圖及透射率。其中,5000張室內圖像對和5000張室外圖像對構成訓練集。1000張室內圖像對和1000張室外圖像對構成測試集A。另一方面,包含500張室內圖像及500張室外圖像的公共測試集SOTS[17]也用來測試算法魯棒性。

4.2 模型參數分析

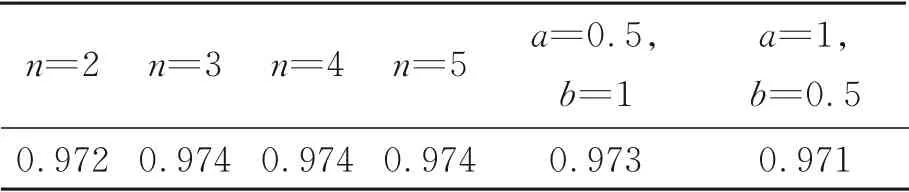

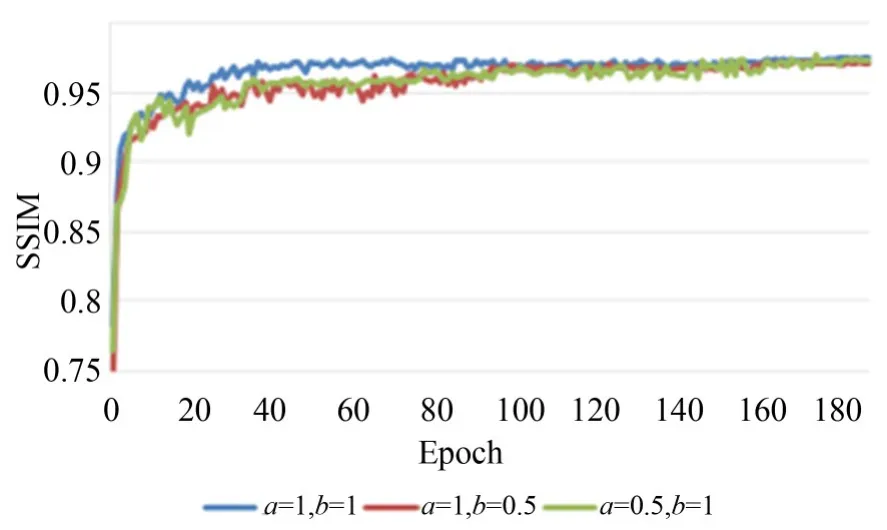

模型中雙循環注意網絡的循環次數n,總損失函數中平衡系數a和b的選取尤為重要,它將直接影響模型去霧的精度及收斂效率。此小節將討論n,a和b取值的合理性。首先,在保持a和b值為1的基礎上,設置循環次數n分別為2,3,4,5,對應模型在SOTS測試集上測得去霧結果的SSIM值如表1所示。從中可見,隨著n的增長,SSIM值逐漸提高,但在n為3時,模型的性能趨于穩定。為了平衡模型的去霧精度及計算成本,本文中循環次數n設置為3。在此基礎上,進一步分別設置a和b值為0.5,1和1,0.5,從表3可見,這兩種參數設置下的SSIM值均小于n為3,a和b均為1時模型的SSIM值0.974。圖4為a和b不同設置下對應的模型,在訓練0到180時期時,SOTS測試集上測得的SSIM曲線,從中可見當a=1,b=1,網絡模型在40時期時開始收斂,而當a=0.5,b=1和a=1,b=0.5時,模型分別在75時期和94時期開始收斂,故a=1,b=1時模型收斂更快。因此本文設置n為3,a和b均為1。

表1 不同參數設置的SSIM值對比Tab.1 Comparison of parameters setting with different values in terms of SSIM

圖4 不同參數設置時SSIM值對比Fig.4 Comparison of SSIM values with different settings of parameters.

4.3 透射率結果對比

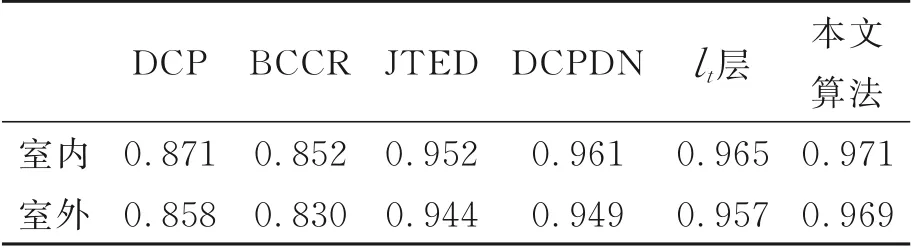

為驗證雙視覺注意網絡估計透射率的有效性,本文不但選用了DCP[5],BCCR[7],JTED[14],DCPDN[13]算法進行結果對比,還將雙視覺注意網絡的ld層去除,獲得僅有lt層的單視覺注意網絡模型進行性能對比。不同算法在測試集A的室內和室外圖像上估計透射率的平均SSIM值如表2所示,從中可見本文算法無論在室內圖像還是室外圖像上均具有最高的SSIM值,透射率估計的準確度較高。

表2 不同算法的透射率SSIM值對比Tab.2 Comparison of transmission map by different al?gorithms in terms of SSIM

4.4 合成圖像去霧結果對比

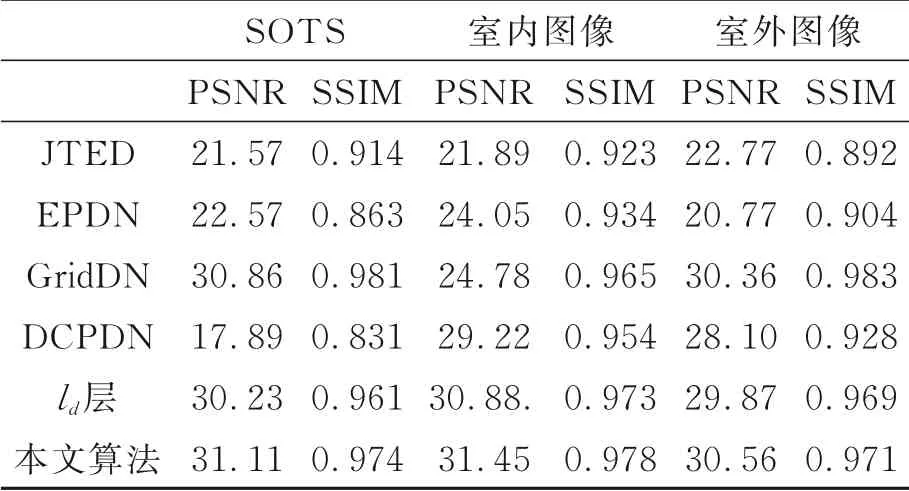

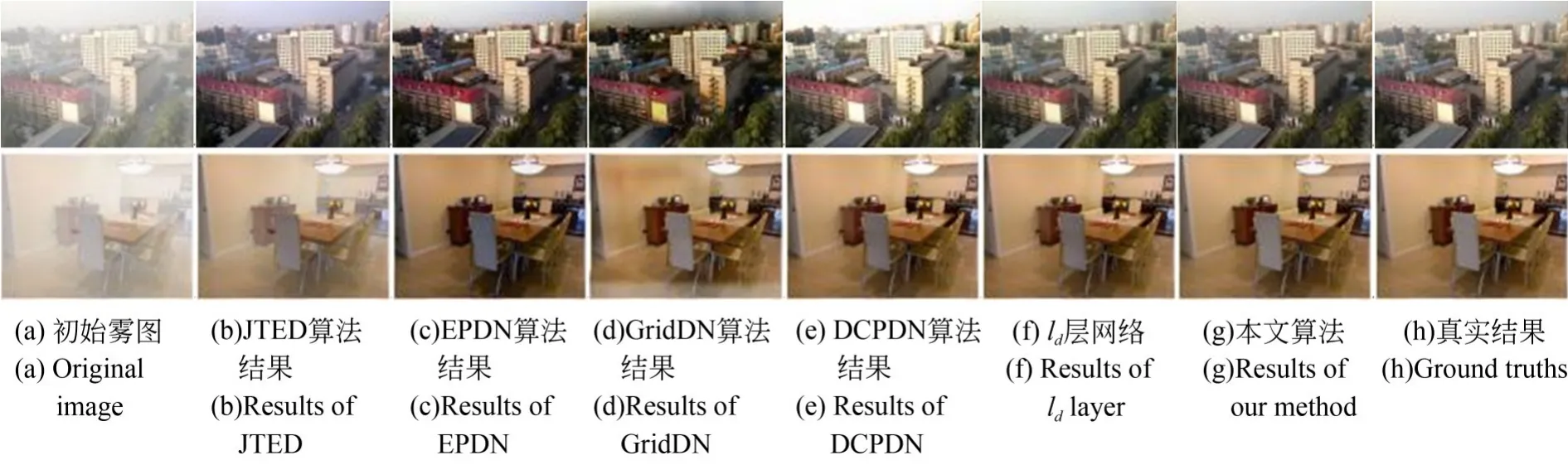

為驗證本文算法去霧的有效性,選用JT?ED[14],EPDN[11],GridDN[12],DCPDN[13]算法及ld層的單視覺注意網絡模型進行對比。視覺結果如圖5所示,從中可見,JTED的結果仍存在霧殘余,如圖5(b)的第2行中,桌椅區域仍存在去霧不徹底的現象。EPDN及Grid DN算法雖能有效去除霧氣,但部分區域存在顏色失真,如圖5(c)第2行的墻面及圖5(d)第1行的天空區域均出現了顏色較深的色塊。DCPDN算法的去霧結果亮度較高,導致圖5(e)第1行的天空區域顏色過白,與真實結果(圖5(h))的色調差異明顯。本文算法與ld層的單視覺注意網絡較其他去霧算法具有更好的去霧效果,但仔細觀察仍可發現,本文算法的去霧結果圖5(g)較ld層的單視覺注意網絡(圖5(f))更接近真實圖像(圖5(h)),例如圖5(f)第2行的椅背顏色略黑,而圖5(g)第2行的椅背顏色更接近真實圖像。表3進一步展示了各算法在不同測試集上的量化結果。從中可見,本文算法除在室外圖像測試集A及測試集SOTS上的平均SSIM值略低于Grid DN以外,其余情況均優于對比算法,由此證明,本文算法借助于信息交互的雙視覺注意網絡能有效實現去霧。

表3 不同算法去霧結果的SSIM值和PSNR值對比Tab.3 Comparison of dehazing methods by different al?gorithms in terms of SSIM and PSNR

圖5 合成圖去霧結果對比Fig.5 Comparison of dehazing results on synthetic images

4.5 真實圖像去霧結果對比

圖6給出了不同算法的真實圖像去霧結果。為更好地觀察色調及細節信息,圖6的第2行和第4行放大了圖6第1行和第3行的局部區域。從中可以看出,JTED[14]及EPDN[110]算法的去霧結果偏暗,如圖6(b)(c)的第2行細節放大圖的色調明顯暗于初始霧圖(圖6(a))的色調。Grid?DN[11]算法的去霧結果在部分區域出現了明顯的色彩失真,如圖6(d)第4行圖像中深色的水面和陸面。DCPDN算法[13]結果(圖6(e))存在亮度過大的問題,如圖6(e)第3行圖像的天空區域因亮度過大而轉變為白色。相比而言,ld層網絡和本文算法的去霧結果均能較好地去除真實圖像中的霧氣,但仔細觀察發現,ld層網絡的去霧結果(圖6(f))仍有霧殘余,如圖6(f)的第4行圖像,而本文算法的去霧結果(圖6(g))不但無霧殘余,還能最大程度上保留圖像原有的色調及細節信息。

4.6 用戶視覺評價

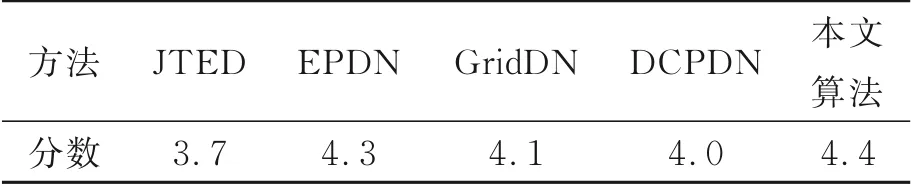

本節進一步采用用戶視覺信息作為評價指標對各算法的去霧結果進行判斷。選取不同年齡,不同性別,不同領域的用戶100人,對100張圖像的去霧結果進行評分,其中包含50張合成霧圖,50張真實霧圖。評價采用5分制,5分為去霧質量優,無失真;4分為去霧質量良好,有些許失真;3分為去霧質量一般,失真明顯;2分為去霧質量差,失真嚴重;1分為去霧質量很差,無法接受。

表4為用戶對各算法評價分數的平均值。從中可見,本文算法分值最高為4.4分,而在合成霧圖的去霧結果量化評價表3中,不占優勢的EP?DN算法,分值位于第二,4.3分。Grid DN,DCP?DN和JTED算法則位于第三,第四和第五。這主要是由于EPDN算法結果雖有失真,但具有較強的對比度,用戶視覺感受下霧殘余較少,主觀判斷失真不明顯,去霧質量好。而本文算法結果雖失真少,但去霧結果的色彩對比度不強,部分用戶給予的評分較EPDN算法低,因此綜合評分與EPDN算法結果差距不大。為此,在未來的研究中,可在本文算法中添加后期處理模塊,以進一步提高去霧結果的色彩對比度。

表4 用戶視覺評分Tab.4 User visual evaluation

4.7 運行時間對比

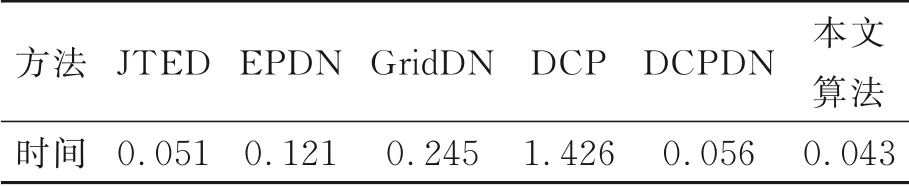

本節在SOTS數據集上比較本文算法與基于 深 度 學 習 去 霧 算 法JTED[14],EPDN[11],Grid?DN[12],DCPDN[13]和基于先驗去霧算法DCP[5]的平均運行時間。從表5可見,本文算法對單張霧天的平均處理時間僅為0.043 s,不但明顯優于DCP算法,還優于其他深度學習的算法,具有較高的運行效率。

表5 不同算法的平均運行時間對比Tab.5 Average running time of different methods(s)

5 結論

為充分探索和挖掘透射率的估計過程和圖像的去霧過程中捕獲信息的相關性,提高網絡的性能。本文提出了雙視覺注意網絡的聯合圖像去霧和透射率估計模型。模型包含圖像去霧層和透射率估計層,且每層網絡均包含注意循環網絡和編碼解碼網絡。在圖像去霧層,循環注意網絡在透射率的監督下生成霧濃度注意圖,以引導后續的編碼解碼網絡感知霧的濃度,實現圖像去霧。同樣,在透射率估計層,循環注意網絡在真實無霧圖的引導下生成場景注意圖,以引導編碼解碼網絡感知場景信息,生成透射率。值得一提的是,為了更準確,高效地生成霧濃度注意圖和場景注意圖,圖像去霧層及透射率估計層更利用其循環注意網絡的循環單元實現信息交互,從而形成相互協作的雙循環注意網絡,在信息互補的方式下生成注意圖。在合成圖及真實圖上的測試表明,本文算法采用的圖像去霧層與透射率估計層的信息交互方式能有效地提高網絡性能,在公共合成數據集上測得的算法精度及運行效率明顯優于已有算法,單張霧圖的平均處理時間僅為0.043 s,可用于圖像去霧的工程實踐中。