多注意力機制的藏漢機器翻譯方法研究

劉賽虎 珠杰

摘要:互聯互通時代了解和掌握不同語言的區域文化和信息十分重要,機器翻譯是目前廣泛應用的交流媒介。本文以藏漢機器翻譯為研究對象,利用Transformer框架和模型,研究了基于Transformer多注意力機制的藏漢機器翻譯方法。經過實驗,評估了多語料融合實驗、語料雙切分實驗對比效果,得到了BLEU值 32.6的實驗結果。

關鍵詞:藏漢;Transformer;機器翻譯;注意力機制;多語料

中圖分類號:TP399? ? ? 文獻標識碼:A

文章編號:1009-3044(2021)10-0004-04

Abstract: It is very important to understand and master regional culture and information in different languages in the age of interconnection. Machine translation is a widely used communication medium. This paper takes Tibetan-Chinese machine translation as the research object, and uses the Transformer framework and model to study the Tibetan-Chinese machine translation method based on Transformermechanism. Through experiments, the comparison effect of multi-corpus fusion experiment and corpus double-segmentation experiment was evaluated, and the experimental results of BLEU 32.6 were obtained.

Key words: Tibetan-Chinese; Transformer; machine translation; attention mechanism; multilingual corpus

機器翻譯(Machine Translation,MT)是借助機器的高計算能力,自動地將一種自然語言(源語言)翻譯為另外一種自然語言(目標語言)[1]。藏文機器翻譯技術經過了數十年的發展,已從傳統基于規則、統計等機器翻譯技術轉變成基于神經網絡架構的新技術,藏文機器翻譯技術發展可分為基于規則的藏文機器翻譯、基于統計的藏文機器翻譯、基于神經網絡的藏文機器翻譯3個階段。

早在21世紀初期就開始了藏文機器翻譯技術,以基于規則的方法中,才藏太[2]結合詞項信息和藏文語法規則,提出了以動詞為中心的二分語法分析技術,基于此技術開發的藏文機器翻譯系統具有詞典、公文、科技三個方面翻譯功能,其詞典量達18.6萬條,經評測分析,譯文的可讀性高達80%。

近年來基于統計方法的藏文機器翻譯技術也得到了一定的發展,臧景才等[3]基于短語統計模型利用翻譯訓練工具Moses實現了藏漢的在線翻譯系統。群諾等[4]提出了對基于中介語言詞語翻譯模型進行改進,融合基于中介語言的統計翻譯模型和直接翻譯模型到現有的訓練過程中,改善統計機器翻譯模型訓練過程的盲目性、低效性、冗余性和表面性等缺陷的方法。

目前主流的藏文機器翻譯技術集中在基于神經網絡的方法研究中,仁青東主等[5]采用50萬藏漢平行語料結合基于雙向RNN的LSTM(長短時記憶網絡)神經網絡模型開發出的藏漢機器翻譯技術取得了BLEU值31的效果;李亞超等[6]提出采用遷移學習解決藏漢語料稀缺問題的方法,并通過對比短語統計機器翻譯實驗得出該方法可提高3個BLEU值。目前尼瑪扎西團隊、東北大學“小牛翻譯在線開放平臺”以及騰訊公司等開發的藏漢機器翻譯系統均采用了基于神經網絡的方法。

2017年,Google發表論文《Attention Is All You Need》[7]正式提出了完全基于注意力機制的Transformer,并在兩項拉丁語系機器翻譯任務中取得了最高BLEU值41.8的成績,2019年,桑杰端珠[8]采用Transformer模型研究了稀缺資源條件下的藏漢機器翻譯回譯方法,通過93萬藏漢平行語料取得了BLEU值最高為27.6的效果。相較之下藏文機器翻譯效果提升還有很大的進步空間,因此本文從Transformer理論架構出發,利用多注意力機制,研究多種語料融合、兩種不同藏漢文切分方法下的藏漢機器翻譯效果。

1 Transformer機器翻譯模型

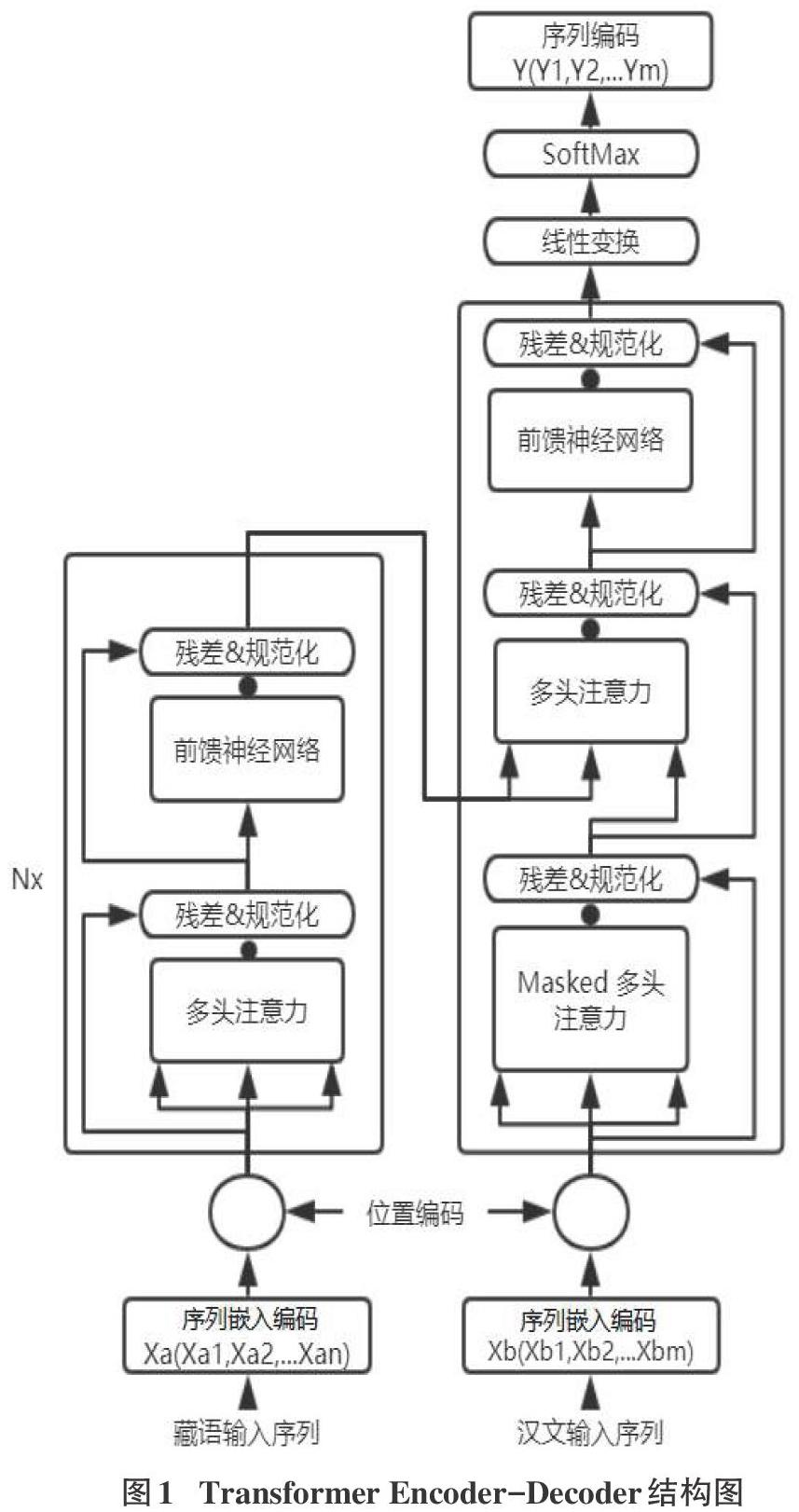

目前主流基于NMT任務的模型均采用Seq2Seq(編碼器-解碼器)[9]框架,在Seq2Seq下編碼器將表征輸入序列X=(X1,X2,…,Xn)映射到連續表征Z=(Z1,Z2,…,Zm),解碼器從連續表征Z生成輸出序列Y=(Y1,Y2,…,Ym)。Transformer框架的設計是通過注意力機制將序列上下文關聯,并行處理序列中的單詞。Transformer對比LSTM以及Fairseq不同之處是它完全基于注意力機制,沒有使用RNN或CNN進行序列對齊操作。完全基于注意力機制使得Transformer不僅可以做到訓練上并行化,并在實際翻譯效果上相較LSTM更勝一籌。

1.1 Transformer注意力模型

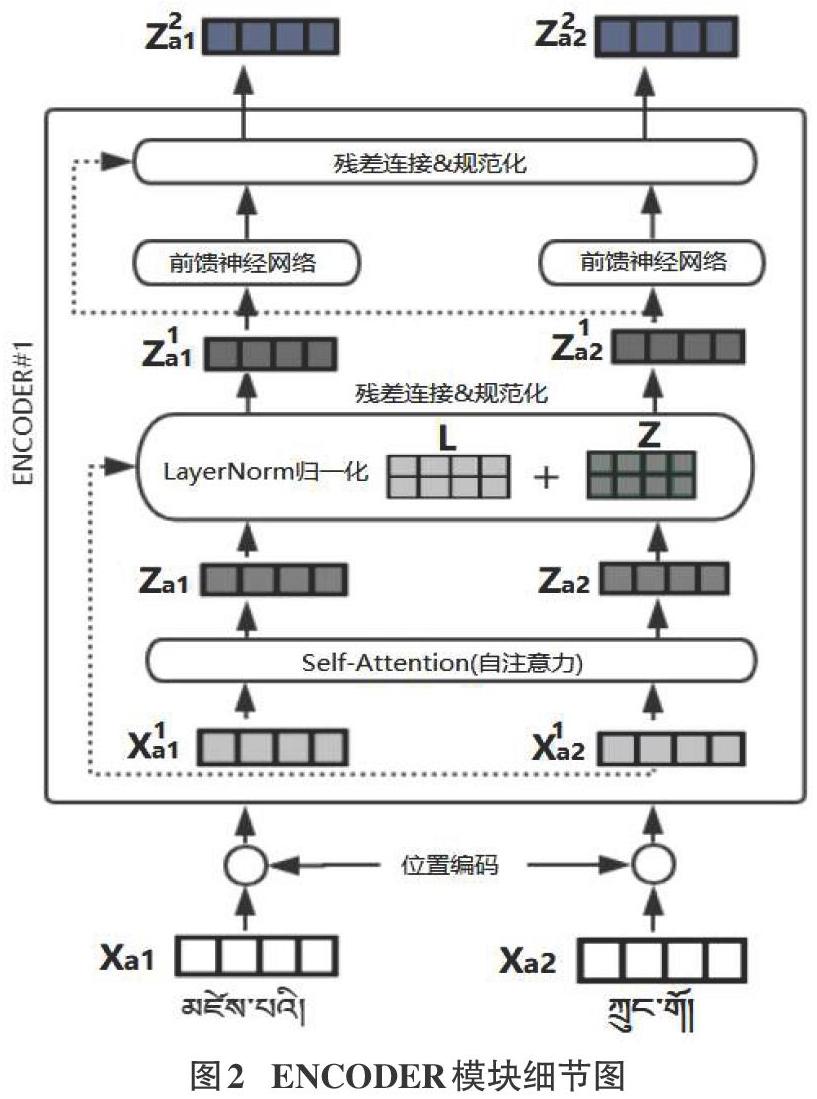

Transformer模型中采用了經典的Encoder-Decoder架構,結構相比于其它Attention更加復雜,初始Transformer采用了由6個Encoder、Decoder層堆疊在一起,單個Encoder和Decoder的內部結構如圖1所示。