基于ShuffleNet的人臉圖像質(zhì)量評估方法

李荔 瞿洪桂 孫家樂

(1.國家信息中心軟件評測中心 北京市 100000 2.北京中電興發(fā)科技有限公司 北京市 100095)

人臉識別是公共安全物聯(lián)網(wǎng)應(yīng)用最為廣泛的場景之一,識別效果的好壞取決于待識別人臉圖像質(zhì)量的高低。即,低質(zhì)量的人臉圖像會大大降低人臉識別的準(zhǔn)確率。在連續(xù)視頻幀中,人臉圖像的質(zhì)量會隨著光照、姿態(tài)、表情、運動等因素變化。如何使得圖像傳感器能夠正確評判連續(xù)視頻幀中人臉圖像質(zhì)量的高低,成為很多學(xué)者研究的內(nèi)容。針對姿態(tài)和非對稱光照對人臉的干擾,鄒[1]提出基于子區(qū)域直方圖距離的人臉對稱度評價,進(jìn)而評估人臉質(zhì)量的方法。黃[2]提出基于CNN 的人臉圖像亮度和清晰度的質(zhì)量評價方法,利用人臉識別匹配器的相似性分?jǐn)?shù)與人類視覺系統(tǒng)清晰度等級分類方法,結(jié)合傳統(tǒng)亮度分級方法,將人臉圖像分成9 類并建立相應(yīng)的數(shù)據(jù)標(biāo)簽,基于數(shù)據(jù)標(biāo)簽和數(shù)據(jù)集訓(xùn)練CNN 模型用于人臉質(zhì)量評估。在眾多的研究中也有學(xué)者探索利用遷移學(xué)習(xí)基于輕型網(wǎng)絡(luò)去實現(xiàn)人臉圖像質(zhì)量評估,如基于MobileNet 網(wǎng)絡(luò)進(jìn)行遷移學(xué)習(xí)實現(xiàn)圖像質(zhì)量分類評估[3]。物聯(lián)網(wǎng)信息系統(tǒng)中,數(shù)據(jù)采集過程中對圖像數(shù)據(jù)進(jìn)行過濾,可大大減少網(wǎng)絡(luò)傳輸壓力,節(jié)省存儲資源。故而,在視頻采集器中實現(xiàn)可靠的人臉圖像質(zhì)量評價尤為重要。本文致力于利用輕量型網(wǎng)絡(luò)ShuffleNet 實現(xiàn)人臉質(zhì)量評價在視頻采集器中的應(yīng)用。

1 常用的人臉圖像質(zhì)量評估方法

由于光照強度、光照方向、目標(biāo)距離、焦距、采樣率、曝光時間和增益、暗漏電流、分辨率等因素的影響,攝像機采集的圖片質(zhì)量或高或低。此外,作為一般圖像的特例,人臉圖像質(zhì)量還會受頭部姿態(tài)、面部表情、遮擋、妝容、飾物等因素的影響。

圖像質(zhì)量評估(Image Quality Assessment, IQA)可分為主觀評估和客觀評估兩種方法。主觀評估就是從人的主觀感知來評價圖像的質(zhì)量,首先給出原始參考圖像和失真圖像,讓標(biāo)注者給失真圖像評分,一般采用平均主觀得分(Mean Opinion Score, MOS)或平均主觀得分差異(Differential Mean Opinion Score, DMOS)表示。主觀評估費時費力,且評分受觀看距離、顯示設(shè)備、照明條件、觀測者的視覺能力、情緒等諸多因素影響,可操作性差。客觀評估使用數(shù)學(xué)模型給出量化值,操作簡單,已經(jīng)成為IQA 研究的重點。

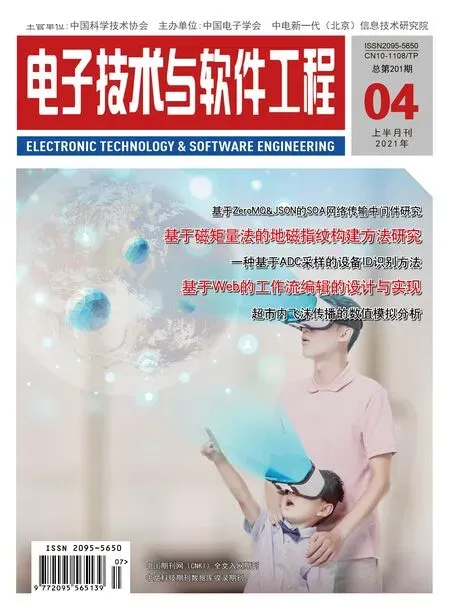

圖1:ShuffleNet 網(wǎng)絡(luò)結(jié)構(gòu)的基本單元

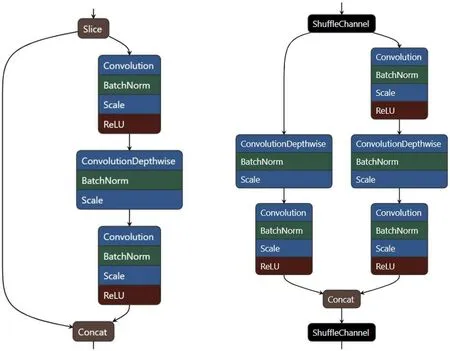

圖2:樣本標(biāo)注流程圖

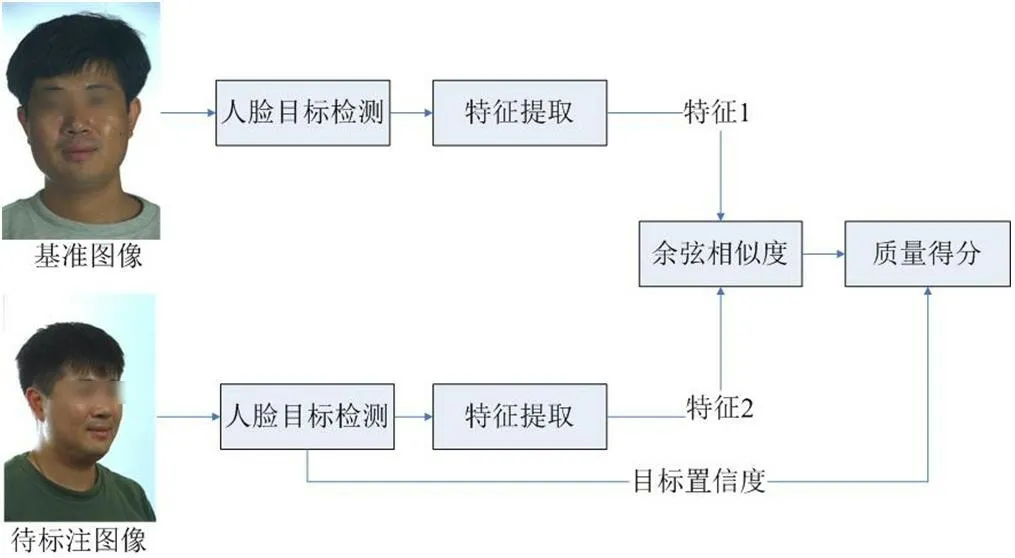

圖3:fa 子集圖像置信度

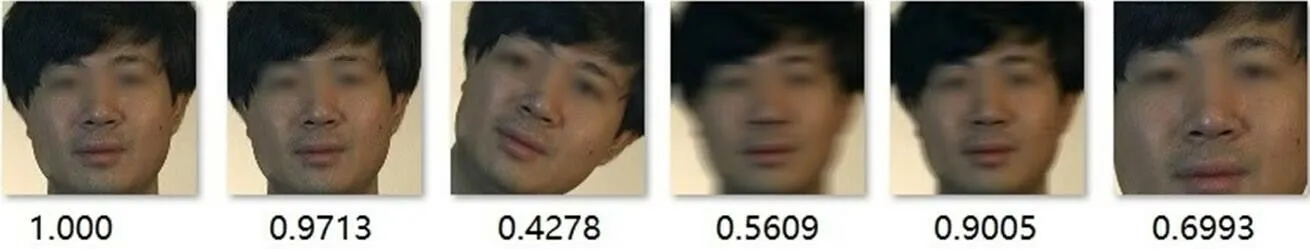

圖4:數(shù)據(jù)集中不同光照,姿態(tài)的人臉圖像標(biāo)注結(jié)果樣例

圖5:數(shù)據(jù)增強后標(biāo)注結(jié)果樣例

人臉圖像質(zhì)量評估作為圖像質(zhì)量評估的一個分支,既要考慮傳統(tǒng)圖像質(zhì)量評估中關(guān)注的因素,又要考慮人臉特有的因素。2009年,國際標(biāo)準(zhǔn)化組織制定了關(guān)于人臉圖像質(zhì)量的ISO/IEC 標(biāo)準(zhǔn),對多種參數(shù)做出了規(guī)定[4]。基于該標(biāo)準(zhǔn),出現(xiàn)了很多質(zhì)量評估方法。有基于多因素的人臉圖像質(zhì)量評估方法[5],該類方法對人臉圖像大小、位置、角度、對比度、明亮度、清晰度等分別進(jìn)行評價,再對每個評價結(jié)果選擇合適的權(quán)重,進(jìn)而得到整體質(zhì)量得分。該類方法中,如何確定每個評價結(jié)果的權(quán)重是一個難題。不同方法中選擇的評價因素也不同[6],各種影響因素很難全面考慮到。有學(xué)者提出基于全局特征人臉特征聚類對人臉質(zhì)量進(jìn)行標(biāo)注,并使用深度學(xué)習(xí)網(wǎng)絡(luò)對人臉圖像質(zhì)量進(jìn)行回歸的方法[7],也有學(xué)者提出基于特征聚類的分類方法[8]。這類方法考慮人臉圖像的全局質(zhì)量,能兼顧不同因素對人臉圖片質(zhì)量的影響。在評估測度上,除上述的分類輸出、回歸輸出,還有基于秩的評估方法[9]。

2 基于ShuffleNet的人臉圖像質(zhì)量評估方法

在基于深度學(xué)習(xí)的人臉質(zhì)量評估算法中,不同的網(wǎng)絡(luò)結(jié)構(gòu)被提出以應(yīng)用于人臉質(zhì)量評估[10]。但是大多網(wǎng)絡(luò)結(jié)構(gòu)復(fù)雜,性能有限。自ShuffleNet 提出以來,基于ShuffleNet 的網(wǎng)絡(luò)結(jié)構(gòu)被廣泛的應(yīng)用于人臉識別系統(tǒng)中[11-12]。

2.1 基于ShuffleNet的網(wǎng)絡(luò)結(jié)構(gòu)

ShuffleNet 是曠視科技最近提出的一種計算高效的CNN 模型,ShuffleNet 的核心是采用了兩種操作:pointwise group convolution和channel shuffle,這兩種操作在保持精度的同時大大降低了模型的計算量。目前最優(yōu)的網(wǎng)絡(luò)結(jié)構(gòu)是ShuffleNetV2。本文基于ShuffleNetV2 實現(xiàn)人臉圖像質(zhì)量分?jǐn)?shù)的回歸。

ShuffleNetV2 網(wǎng)絡(luò)的基本結(jié)構(gòu)是基于殘差網(wǎng)絡(luò)的殘差結(jié)構(gòu)。如圖1 所示。

網(wǎng)絡(luò)采用3 個基本單元構(gòu)成網(wǎng)絡(luò)結(jié)構(gòu)主體,兩個全連接層FC1 輸出維度為200,F(xiàn)C2 輸出1 維質(zhì)量分?jǐn)?shù),loss 層選用EuclideanLoss 對人臉圖像質(zhì)量分?jǐn)?shù)進(jìn)行回歸。

2.2 樣本質(zhì)量分?jǐn)?shù)標(biāo)注

基于人工進(jìn)行人臉圖像質(zhì)量標(biāo)注, 不僅工作量巨大,還易受主觀因素影響。標(biāo)注結(jié)果與人的視覺感受一致,但未必符合人臉識別系統(tǒng)的需要。本文使用基于人臉識別算法的樣本標(biāo)注方法,為人臉識別算法量身定做質(zhì)量評估方法。人臉檢測目標(biāo)分類置信度體現(xiàn)了目標(biāo)分類的正確概率,也是衡量人臉圖像質(zhì)量的一個參考指標(biāo)。本文采人臉檢測置信度對人臉圖像質(zhì)量分?jǐn)?shù)進(jìn)行微調(diào)。首先選定一張人臉位置合適,光照合適,正臉,無遮擋等質(zhì)量優(yōu)的圖片作為基準(zhǔn)圖像,圖片質(zhì)量分?jǐn)?shù)標(biāo)注為1,其他人臉圖像通過人臉識別算法提取特征,計算圖像特征與基準(zhǔn)圖像特征的余弦相似度作為圖像質(zhì)量分?jǐn)?shù),再利用人臉檢測置信度對最終質(zhì)量分?jǐn)?shù)進(jìn)行微調(diào)。

圖6:模型在監(jiān)控場景中的應(yīng)用效果

余弦相似度通過計算兩個向量的夾角的余弦值來度量它們之間的相似性。向量A,B 的余弦相似度similarity 的計算公式為:

similarity 取值為-1 到1:-1 意味著兩個向量指向的方向正好截然相反,1 表示它們的指向是完全相同的,0 通常表示它們之間是獨立的,而在這之間的值則表示中間的相似性或相異性。

其中confidence 是人臉目標(biāo)檢測的置信度。

樣本質(zhì)量分?jǐn)?shù)標(biāo)注流程如圖2 所示。

3 實驗與分析

3.1 訓(xùn)練樣本標(biāo)注

本文使用Color FERET 和CAS_PEAL_R1 數(shù)據(jù)集進(jìn)行實驗。Color FERET 數(shù)據(jù)集是由美國Feret 項目組收集的人臉數(shù)據(jù)庫,包含994 個類別共11338 張圖像,其中每個類別中的fa 子集是統(tǒng)一光照的正臉圖像,fb 子集是與fa 表情不同的統(tǒng)一光照正臉圖像,其它為包含15,22.5,45,67.5 頭部姿態(tài)水平旋轉(zhuǎn)的人臉圖像。CAS_PEAL_R1 是由中科院技術(shù)研究所收集的人臉數(shù)據(jù)庫,包含姿態(tài)變化,飾物變化,光照變化,背景變化,距離變化,時間跨度變化等7 種變化模式子庫。

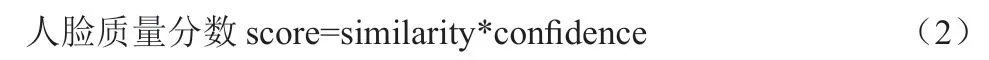

表1:模型在數(shù)據(jù)集合上的表現(xiàn)

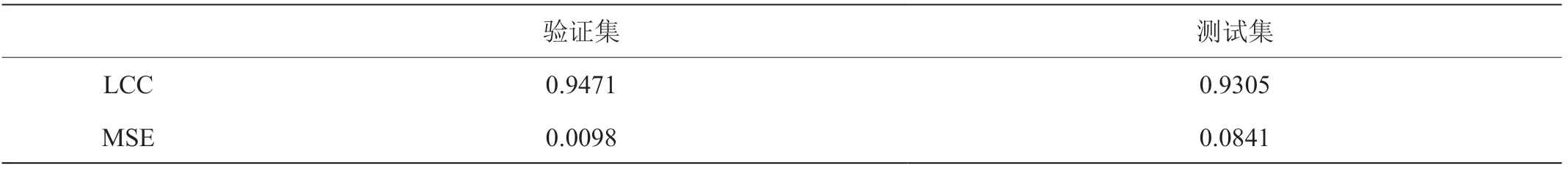

表2:測試集上模型標(biāo)注結(jié)果和推理結(jié)果對比

基準(zhǔn)圖片的選擇是訓(xùn)練樣本標(biāo)注的關(guān)鍵,Color FERET 數(shù)據(jù)集中fa 為正常表情,正常光照的人臉圖像,但部分目標(biāo)fa 子集包含多張圖片,為了更好的選擇基準(zhǔn)圖片,我們對每張人臉圖像進(jìn)行人臉檢測得到人臉目標(biāo)置信度,選擇fa 子集中人臉目標(biāo)置信度最高的圖像作為該目標(biāo)的基準(zhǔn)圖像。如圖3 所示。

本文所述實驗使用了基于Resnet 網(wǎng)絡(luò)的SSH 人臉檢測算法和基于Mobilefacenet 網(wǎng)絡(luò)的Arcface 深度特征提取算法。標(biāo)注結(jié)果樣例如圖4 所示。

3.2 數(shù)據(jù)增強

人臉圖像質(zhì)量受多種因素的影響,但實驗所用數(shù)據(jù)集包含的情況遠(yuǎn)遠(yuǎn)不足,需要對樣本進(jìn)行擴(kuò)充,以增加樣本的多樣性。擴(kuò)充方式包括:

(1)人臉檢測框水平和垂直方向偏移±2、±4、±8;

(2)圖像左右旋轉(zhuǎn)±10°、±20°、±30°;

(3)角度為45°的運動模糊;

(4)高斯模糊;

(5)人臉完整程度0.7、0.9、1.1 的裁剪。

在樣本擴(kuò)充中考慮到實際的監(jiān)控場景中,運動模糊是常見的一種影響因素[13],樣本中的圖像盡可能的貼近實際場景中可能出現(xiàn)的情況,能提高模型在實際應(yīng)用中的效果。如圖5 所示。

3.3 模型訓(xùn)練

將數(shù)據(jù)集分為訓(xùn)練、驗證、測試三個數(shù)據(jù)集,圖像歸一化到112*112 與模型的輸入一致。選用ShufflenetV2_0.5x,初始學(xué)習(xí)率設(shè)置為0.01,學(xué)習(xí)率更新策略為poly,power 設(shè)置為0.9,momentum 設(shè)置為0.9,迭代了30000 次,大約3 個epoch,模型達(dá)到收斂。

3.4 結(jié)果展示及評價

訓(xùn)練好的模型在劃分的測試集上進(jìn)行評測,評測指標(biāo)選用LCC (線性相關(guān)系數(shù))和MSE(均方誤差),既評測標(biāo)注質(zhì)量分?jǐn)?shù)與預(yù)測質(zhì)量分?jǐn)?shù)兩者的相關(guān)性又度量兩者的絕對差異。如表1 所示。

表2 列舉了測試集部分樣本標(biāo)注質(zhì)量分?jǐn)?shù)和預(yù)測質(zhì)量分?jǐn)?shù)的差異,通過對比可以看到兩者差異較小,模型很好的實現(xiàn)了質(zhì)量分?jǐn)?shù)的回歸。

模型在實際監(jiān)控場景中的效果圖如圖6 所示。

4 結(jié)論

本文提出了一種基于輕量級網(wǎng)絡(luò)ShuffleNet 人臉圖像質(zhì)量評估方法。主要有兩點:

(1)基于ShuffleNetV2 網(wǎng)絡(luò)結(jié)構(gòu)實現(xiàn)質(zhì)量分?jǐn)?shù)回歸網(wǎng)絡(luò),對標(biāo)準(zhǔn)的ShuffleNetV2 網(wǎng)絡(luò)進(jìn)行了剪裁,并使用ShufflenetV2_0.5x,減少了網(wǎng)絡(luò)推理階段的資源消耗,使網(wǎng)絡(luò)能夠部署在智能前端采集設(shè)備中,數(shù)據(jù)在前端被過濾,節(jié)省了物聯(lián)網(wǎng)平臺的網(wǎng)絡(luò)和存儲資源;

(2)提出了一種基于人臉目標(biāo)檢測置信度與人臉特征提取算法相結(jié)合的人臉圖像質(zhì)量樣本標(biāo)注方法,減少了因人工標(biāo)注樣本帶來的巨大工作量,提高了標(biāo)注精度,這種標(biāo)注方法兼顧不同因素對人臉圖像的影響,評價結(jié)果更全面,更貼合人臉識別系統(tǒng)最終的需求。

實驗證明,本文方法能夠針對不同因素引起的圖像質(zhì)量變化給予準(zhǔn)確的評估, 篩選出高質(zhì)量的人臉圖像。