改進(jìn)3DU-NET在CT影像分割中的應(yīng)用研究

李林靜 侯軍浩 吳建峰 楊小軍

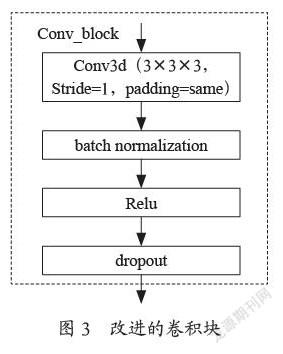

摘 ?要:對(duì)3D U-NET網(wǎng)絡(luò)結(jié)構(gòu)進(jìn)行改進(jìn),提出一種CT影像中結(jié)節(jié)的自動(dòng)分割方法。該項(xiàng)目在3D U-Net的基礎(chǔ)上對(duì)其進(jìn)行改進(jìn),改進(jìn)的內(nèi)容是卷積塊操作采用3×3×3,Stride=1,padding=same的卷積,每個(gè)卷積后面相繼增加Batch Normalization、Relu 和Dropout操作,池化被卷積操作代替,同時(shí)加入long skip connection長鏈接,實(shí)現(xiàn)淺層、低水平、粗粒度特征傳遞下去而不消失,提升網(wǎng)絡(luò)對(duì)形狀在10 mm以下但亮度高結(jié)節(jié)的輪廓表示能力,同時(shí)擴(kuò)大了感受野、加速了網(wǎng)絡(luò)的收斂。實(shí)現(xiàn)對(duì)CT影像的自動(dòng)、準(zhǔn)確描述。

關(guān)鍵詞:3D U-NET;CT影像;長鏈接;感受野;淺層;低水平;粗粒度特征

中圖分類號(hào):TP391.4 ? ? ? ?文獻(xiàn)標(biāo)識(shí)碼:A文章編號(hào):2096-4706(2021)21-0105-04

Abstract: The structure of 3D U-NET network is improved, and an automatic segmentation method of nodules in CT images is proposed. The project improves it on the basis of 3D U-NET. The improved content is that the convolution block operation adopts the convolution of 3×3×3, stripe=1 and padding=same. After each convolution, Batch Normalization, Relu and Dropout operations are added successively. Pooling is replaced by convolution operations. At the same time, long skip connection long links are added to realize the transmission of shallow layer, low level and coarse grained characteristics without disappearing, so as to improve the ability of the network to express the contour of nodules of shape less than 10 mm with high brightness, at the same time, it expands the receptive field and accelerates the convergence of the network. And then realize the automatic and accurate description of CT images.

Keywords: 3D U-NET; CT image; long link; receptive field; shallow layer; low level; coarse grained characteristic

0 ?引 ?言

隨著CT在肺癌早期篩查應(yīng)用的普及,篩查數(shù)量倍增。通常情況下,一名患者的CT影像在80幅~250幅之間,影像科醫(yī)生在醫(yī)用豎屏顯示器上調(diào)閱影像圖片,逐幅觀察。對(duì)于肺結(jié)節(jié),它的直徑約3 mm到30 mm的球狀陰影,有實(shí)性結(jié)節(jié)、肺內(nèi)混合磨玻璃密度結(jié)節(jié)和肺內(nèi)純磨玻璃密度結(jié)節(jié),實(shí)性結(jié)節(jié)肺內(nèi)亮度較高,容易觀察,肺磨玻璃結(jié)節(jié)表現(xiàn)為密度輕微增加,呈云霧狀,小于3 cm的局限性病變,其結(jié)節(jié)的密度不足以遮擋支氣管及血管的結(jié)構(gòu),形狀多變,容易和周圍的血管、氣管組織混淆,醫(yī)生識(shí)別難度加大,加上長時(shí)間高強(qiáng)度的閱片,醫(yī)生難免會(huì)產(chǎn)生視覺疲勞,不可避免地導(dǎo)致小結(jié)節(jié)的漏診和誤診。如何在大量圖像資料中準(zhǔn)確檢測出結(jié)節(jié)并早期定性,已成為臨床迫切需求。

1 ?項(xiàng)目介紹

隨著醫(yī)療大數(shù)據(jù)庫的建立及計(jì)算機(jī)硬件水平的發(fā)展,深度學(xué)習(xí)算法在醫(yī)療診斷領(lǐng)域優(yōu)勢明顯,為實(shí)現(xiàn)醫(yī)學(xué)影像的自動(dòng)智能診斷提供了新的契機(jī)。自Ronneberger等人于2015年提出U-Net網(wǎng)絡(luò)以來,U-Net就成為醫(yī)學(xué)圖像分割中最著名的框架,隨著U-Net的成功,在U-Net結(jié)構(gòu)上有很多類似的變體,均致力于進(jìn)一步提高分割性能。然而,由于U-Net網(wǎng)絡(luò)的輸入是二維,而醫(yī)學(xué)圖像往往是三維圖像,因此利用U-Net網(wǎng)絡(luò)進(jìn)行訓(xùn)練會(huì)丟失原始數(shù)據(jù)在空間上的信息,使得圖像分割精度始終達(dá)不到較高水準(zhǔn)。由Ahmed Abdulkadir等人于2017年提出的3D U-Net,因其優(yōu)異的性能被廣泛應(yīng)用于醫(yī)學(xué)圖像分割,而3D U-Net網(wǎng)絡(luò)由于模型參數(shù)數(shù)量龐大,難以訓(xùn)練且容易出現(xiàn)過擬合,因此發(fā)展受到限制。在肺結(jié)節(jié)診斷方面已有的深度學(xué)習(xí)算法憑借其準(zhǔn)確的訓(xùn)練模型,不僅能在短時(shí)間內(nèi)檢出結(jié)節(jié),而且能夠?qū)Y(jié)節(jié)良惡性進(jìn)行預(yù)判,但對(duì)小于10 mm的實(shí)心結(jié)節(jié)篩檢及預(yù)判結(jié)果目前尚無明確定論。因此,小于10 mm的實(shí)心結(jié)節(jié)的分割是醫(yī)學(xué)圖像處理中一項(xiàng)具有挑戰(zhàn)性的任務(wù)。本文在3D U-Net的基礎(chǔ)上,對(duì)網(wǎng)絡(luò)結(jié)構(gòu)進(jìn)行改進(jìn),提出一種實(shí)現(xiàn)對(duì)CT影像肺實(shí)質(zhì)中結(jié)節(jié)的自動(dòng)分割方法。包括以下步驟:

步驟1:去除CT影像中的噪聲,將圖像歸一化為(0,1);

步驟2:肺結(jié)節(jié)Mask圖像生成;

步驟3:構(gòu)造Patch區(qū)域(96,96,16)肺實(shí)質(zhì)CT圖像和Mask圖像3D訓(xùn)練集;

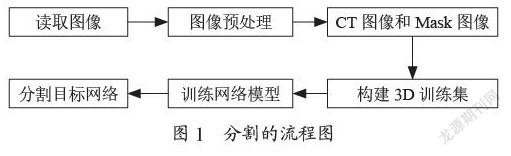

步驟4:建立改進(jìn)3D U-Net網(wǎng)絡(luò)模型,用3D訓(xùn)練樣本訓(xùn)練該網(wǎng)絡(luò);然后用訓(xùn)練的模型對(duì)測試3D樣本進(jìn)行預(yù)測,從而對(duì)目標(biāo)病灶區(qū)域?qū)崿F(xiàn)自動(dòng)分割,其流程如圖1所示。

2 ?網(wǎng)絡(luò)架構(gòu)設(shè)計(jì)

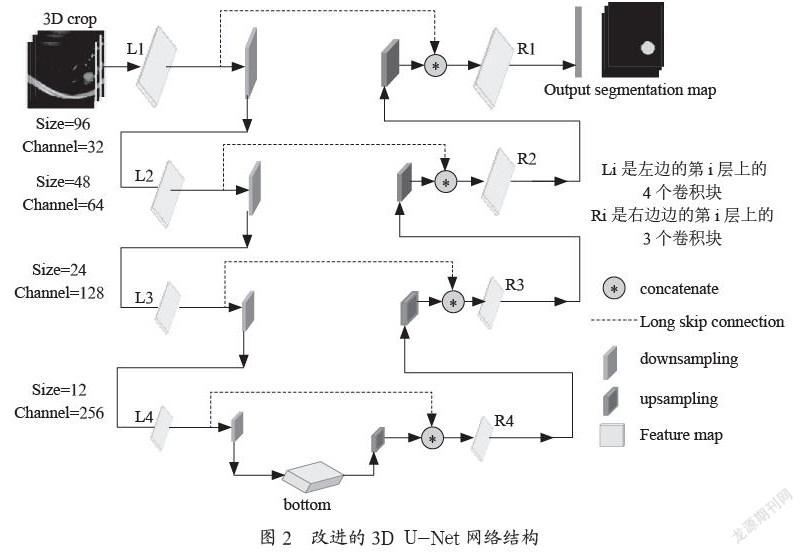

在醫(yī)學(xué)圖像分割領(lǐng)域,為了擴(kuò)大receptive field,減少訓(xùn)練參數(shù)和計(jì)算時(shí)間,讓網(wǎng)絡(luò)參數(shù)量減少使其計(jì)算量與U-Net網(wǎng)絡(luò)相當(dāng),同時(shí)保持三維圖像的空間語義信息使其性能又可以媲美3D U-Net網(wǎng)絡(luò),該項(xiàng)目在3D U-Net的基礎(chǔ)上對(duì)其進(jìn)行改進(jìn),改進(jìn)的網(wǎng)絡(luò)結(jié)構(gòu)示意圖如圖2所示。在圖2中,網(wǎng)絡(luò)的總深度為5,其U型結(jié)構(gòu)由壓縮路徑和擴(kuò)展路徑組成。在壓縮路徑上,左邊由L1、L2、L3、L4層卷積模塊和4個(gè)下采樣操作組成;在擴(kuò)展路徑上有同等數(shù)量上采樣操作和R1、R2、R3、R4層卷積塊組成。在壓縮路徑上,每層有4個(gè)卷積塊操作,卷積塊操作包括采用3×3×3卷積核,Stride=1,padding=same卷積操作,每個(gè)卷積操作后面相繼增加Batch Normalization、Relu 和Dropout操作。本文改進(jìn)的卷積塊如圖3所示。每層池化操作使用3×3×3卷積核,Stride=2,padding=same卷積操作替換,在每個(gè)下采樣操作中,通道數(shù)增加一倍,特征圖大小減半。在擴(kuò)展路徑上,每層有1個(gè)上采樣upsampling和3個(gè)卷積塊操作組成,upsampling采樣采用3×3×3卷積核,Stride=2,padding=same卷積操作替換,在每個(gè)上采樣操作中,通道數(shù)降低一半,特征圖大小放大1倍,卷積塊操作包括采用3×3×3卷積核,Stride=1,adding=same卷積操作,每個(gè)卷積操作后面相繼增加Batch Normalization、Relu 和Dropout操作。

同時(shí)加入來自壓縮路徑中相等分辨率層的長連接long skip connection為擴(kuò)展路徑提供了必要的高分辨率特征,實(shí)現(xiàn)shallow,low-level,coarse-grained特征(淺層、低水平、粗粒度)傳遞下去而不消失,提升網(wǎng)絡(luò)對(duì)形狀在3 cm以下但亮度高結(jié)節(jié)的輪廓表示能力,同時(shí)加速網(wǎng)絡(luò)的收斂。U型結(jié)構(gòu)的對(duì)等層次模塊如圖4所示。在最后一層,使用1×1×1卷積將輸出通道的數(shù)量減少到1,作為0-1分類。總的來說,網(wǎng)絡(luò)有39個(gè)卷積操作,4個(gè)downsampling下采樣,4個(gè)upsampling,L1卷積層的通道個(gè)數(shù)都為32,L2卷積層的通道個(gè)數(shù)都為64,L3卷積層的通道個(gè)數(shù)都為128,L4卷積層的通道個(gè)數(shù)都為256,bottom層的通道個(gè)數(shù)是512。

3 ?損失函數(shù)及評(píng)價(jià)指標(biāo)

3.1 ?損失函數(shù)

在本文的中,所使用的損失函數(shù)如公式(1)

在式(1)中pi是3D Crop的預(yù)測值,gi是3D Crop的ground truth。為了避免CT圖像中沒有肺結(jié)節(jié)的情況,在損失函數(shù)中加入平滑系數(shù)smooth=1e-5,這樣可以防止除數(shù)為0的情況。本文我們需要判斷預(yù)測區(qū)域是否出現(xiàn)肺結(jié)節(jié),可以看作一個(gè)二分類問題,對(duì)于二分類問題,ground truth分割圖只有0,1兩個(gè)值,因此在預(yù)測3D Crop和ground truth之間做點(diǎn)乘可以有效地將在預(yù)測分割圖中未在ground truth分割圖中激活的所有像素清零。對(duì)于激活的像素,主要是懲罰低置信度的預(yù)測,較高值會(huì)得到更好的Dice系數(shù)。

3.2 ?靈敏度sensitivity

本文從肺結(jié)節(jié)檢出靈敏度(sensitivity),平均分割精度和分割標(biāo)準(zhǔn)差來評(píng)價(jià)肺結(jié)節(jié)分割勾畫的精準(zhǔn)性能。假設(shè)正樣本為肺結(jié)節(jié),負(fù)樣本為正常肺內(nèi)組織。通常用1來表示正樣本,0來表示負(fù)樣本。對(duì)于是否分割出結(jié)節(jié)的模型,可以用混淆矩陣來表示預(yù)測值和真實(shí)值之間的關(guān)系,如下表1所示。從混淆矩陣中,通常衍生出靈敏度或查全率評(píng)價(jià)的指標(biāo)。

靈敏度定義為:Sensitivity=TP/TP+FN ? ?(2)

式(2)是預(yù)測肺結(jié)節(jié)真陽性個(gè)數(shù)除以真實(shí)肺結(jié)節(jié)的個(gè)數(shù),實(shí)現(xiàn)對(duì)肺結(jié)節(jié)檢出率。

4 ?項(xiàng)目實(shí)施內(nèi)容

該項(xiàng)目使用Luna2016數(shù)據(jù)集在配備有NVIDIA GTX 1080Ti GPU工作站上實(shí)現(xiàn)了所提出的方法,實(shí)施的具體內(nèi)容步驟包括:

步驟1:首先去除CT影像中的如骨頭的亮點(diǎn),CT床的金屬線等噪聲,將圖像歸一化為(0,1);

步驟2:接下來根據(jù)醫(yī)生提供的結(jié)節(jié)標(biāo)注信息,在圖像中找到相應(yīng)的肺結(jié)節(jié)位置,將醫(yī)生標(biāo)注的世界坐標(biāo)轉(zhuǎn)換化圖像坐標(biāo),坐標(biāo)轉(zhuǎn)化后,對(duì)CT三維圖像按z軸方向進(jìn)行展開,找到沿z軸方向上所有含結(jié)節(jié)區(qū)域二維切片,即我們訓(xùn)練時(shí)的標(biāo)簽Mask;為了豐富樣本,接著將厚度為2.5,1.5,1.25,2等大于1 mm情況的CT切片插值采樣后層厚變?yōu)闉?mm,在這里將CT圖像采用線性插值法,Mask圖像采用最近鄰插值法;

步驟3:通過對(duì)層厚為1 mm的CT切片進(jìn)行閾值化、聚類、腐蝕和和膨脹實(shí)現(xiàn)肺部ROI的提取。原CT影像是三維圖像,每個(gè)患者包含一系列胸腔的多個(gè)軸向切片,為了充分使用切片間的空間信息,將含有結(jié)節(jié)肺實(shí)質(zhì)CT圖像和Mask圖像取(96,96,16)大小Patch區(qū)域,實(shí)現(xiàn)3D數(shù)據(jù)集的構(gòu)建;

步驟4:最后建立基于改進(jìn)3D U-Net網(wǎng)絡(luò)模型,使用3D數(shù)據(jù)集中的訓(xùn)練樣本訓(xùn)練該網(wǎng)絡(luò)模型,然后用訓(xùn)練的模型對(duì)測試3D樣本進(jìn)行預(yù)測,從而對(duì)目標(biāo)病灶區(qū)域?qū)崿F(xiàn)自動(dòng)分割。

5 ?實(shí)驗(yàn)效果

在Ubuntu16系統(tǒng)下,使用TensorFlow調(diào)用GPU加速進(jìn)行卷積神經(jīng)網(wǎng)絡(luò)訓(xùn)練。Adam Optimizer用于優(yōu)化整個(gè)網(wǎng)絡(luò)權(quán)重,學(xué)習(xí)率固定為1e-3,batch_size=6,訓(xùn)練圖像和mask的大小為(96,96,16)。項(xiàng)目根據(jù)Luna2016數(shù)據(jù)集通過滑動(dòng)步驟和結(jié)節(jié)篩選進(jìn)行標(biāo)記,生成帶16 996個(gè)3D crop肺結(jié)節(jié)信息,整個(gè)數(shù)據(jù)集以8:2的比例隨機(jī)分成訓(xùn)練集和測試集,我們以13 595個(gè)肺結(jié)節(jié)作為訓(xùn)練集,3 401個(gè)肺結(jié)節(jié)作為測試集。采用Mean Dice、STD 、Sensitivity來評(píng)價(jià),其結(jié)果如表2所示。在表2中我們看到,改進(jìn)后的3D U-Net在Mean Dice=87.93%,標(biāo)準(zhǔn)差為9.52%,

Sensitivity=96.23%,與原模型相比,分割效果均有提升。

以5.63 mm實(shí)心高亮結(jié)節(jié)預(yù)測結(jié)果為例,如圖5所示,我們可以看到3D U-Net的預(yù)測結(jié)果=0.79改進(jìn)的3D U-Net的預(yù)測結(jié)果=0.91,改進(jìn)后模型在高亮小結(jié)節(jié)輪廓的表示能力優(yōu)于3D U-Net模型。

6 ?結(jié) ?論

該項(xiàng)目通過對(duì)3D U-Net網(wǎng)絡(luò)的改進(jìn)和融入long ?skip ?connection實(shí)現(xiàn)3D U-Net對(duì)小于10 mm結(jié)節(jié)的分割,不僅解決了梯度消失和梯度爆炸的問題,還提升了網(wǎng)絡(luò)對(duì)形狀直徑在10 mm以下但亮度高結(jié)節(jié)的輪廓表示能力。實(shí)現(xiàn)對(duì)CT影像肺部區(qū)域結(jié)節(jié)的自動(dòng)、準(zhǔn)確的描述。

參考文獻(xiàn):

[1] LIVNE M,RIEGER J,AYDIN O U,et al. A U-Net Deep Learning Framework for High Performance Vessel Segmentation in Patients With Cerebrovascular Disease [J]. Frontiers in Neuroscience,2019,13:97.DOI:10.3389/fnins.2019.00097.eCollection 2019.

[2] ?I?EK ?,ABDULKADIR A,LIENKAMP S.S , et al. 3D U-Net:Learning Dense Volumetric Segmentation from Sparse Annotation. In:Ourselin S.,Joskowicz L.,Sabuncu M.,Unal G.,Wells W.(eds)Medical Image Computing and Computer-Assisted Intervention – MICCAI 2016. MICCAI 2016. Lecture Notes in Computer Science,vol 9901. Springer,Cham. https://doi.org/10.1007/978-3-319-46723-8_49.

[3] 金征宇.人工智能醫(yī)學(xué)影像應(yīng)用:現(xiàn)實(shí)與挑戰(zhàn) [J].放射學(xué)實(shí)踐,2018,33(10):989-991.

[4] Roy A G ,Siddiqui S ,Plsterl S ,et al.‘Squeeze & Excite Guided Few-Shot Segmentation of Volumetric Images [J]. Medical Image Analysis,2020,59(1):234-238.

[5] 鄒應(yīng)誠.基于卷積神經(jīng)網(wǎng)絡(luò)的顱內(nèi)動(dòng)脈瘤檢測方法研究 [D].武漢:華中科技大學(xué),2019.

作者簡介:李林靜(1976.03—),女,漢族,四川遂寧人,副教授,碩士,研究方向:圖像理解。