基于遷移學(xué)習(xí)的名家畫作數(shù)字化識別與分類

鄧 旭,趙連軍,郇 靜

(山東理工大學(xué) 計算機(jī)科學(xué)與技術(shù)學(xué)院,山東 淄博 255000)

0 引 言

藝術(shù)家識別是指在沒有其它元數(shù)據(jù)的情況下,僅給定圖像的情況下識別作品的藝術(shù)家。這一領(lǐng)域的專家需要很長時間來學(xué)習(xí)各種藝術(shù)家的風(fēng)格,然后才能分析繪畫作品。此外,即使具有專業(yè)知識,藝術(shù)家的身份也很難確定,因為一個藝術(shù)家的風(fēng)格在不同的繪畫作品中有很大的差異。通過機(jī)器學(xué)習(xí),可以為專家提供基本估計,以減少必要的時間和精力,并使經(jīng)驗不足的人更容易識別藝術(shù)家身份。

在這項工作中,前人做了很多工作。Qian等主要是將自然圖像進(jìn)行油畫、粉筆畫等藝術(shù)風(fēng)格模擬,或者是針對油畫等西方畫進(jìn)行藝術(shù)風(fēng)格分析[1]。Wang等提出了復(fù)合特征的自適應(yīng)遴選及對水墨畫風(fēng)格描述的優(yōu)化,其還通過提取多種底層異構(gòu)視覺特征對國畫風(fēng)格進(jìn)行描述,對國畫作者進(jìn)行分類預(yù)測[2]。Saleh和Elgammal使用了GIST、Classemes和PiCoDes特征[3]。Misumi等利用SIFT特征對3種不同風(fēng)格的作品進(jìn)行分類[4]。Sahu等利用局部二元模式(local binary patterns)、顏色直方圖(color histograms)、HOG和GIST對作品美學(xué)評估分類[5]。

近年來,深度學(xué)習(xí)的卷積神經(jīng)網(wǎng)絡(luò)模型在圖像識別上取得了很大的進(jìn)步,例如在ImageNet上top-5分類的錯誤率僅有3.6%[6]。相比于淺層的特征提取,深度學(xué)習(xí)的深層網(wǎng)絡(luò)結(jié)構(gòu)可以逐層進(jìn)行特征提取,這些特征更容易被分類識別。

卷積神經(jīng)網(wǎng)絡(luò)(CNNs)能夠?qū)D像內(nèi)容和圖像風(fēng)格分開識別,并通過風(fēng)格遷移可以將一幅畫的藝術(shù)風(fēng)格遷移到另一幅畫上面[7,8]。Li等通過將VGG-F模型直接應(yīng)用于中國畫作風(fēng)格識別問題,取得了很好的成果[9]。

深度學(xué)習(xí)可提取圖像特征,應(yīng)用于字體手寫識別、人類圖像識別、目標(biāo)檢測等方面[10]。近年來,深度學(xué)習(xí)也被用于圖像細(xì)粒度分析與分類的研究,取得了很好的結(jié)果[11-14],通過遷移學(xué)習(xí)分類也有不錯的效果[15]。

卷積神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)目標(biāo)特征需要花費大量的機(jī)器運算時間,預(yù)訓(xùn)練后的卷積神經(jīng)網(wǎng)絡(luò)模型(PretrainedCNN)具有良好的可遷移性。遷移學(xué)習(xí)既可以確保較為理想的訓(xùn)練效果,又可以節(jié)省大量的訓(xùn)練時間。遷移學(xué)習(xí)近年來成為圖像識別領(lǐng)域的主要方法。

基于上述分析,針對藝術(shù)家識別,提出了一種基于 ImageNet 的ResNet-50遷移學(xué)習(xí)方法。ResNet-50能自動學(xué)習(xí)訓(xùn)練數(shù)據(jù)中的低層次信息,得到更詳細(xì)高層的特征數(shù)據(jù)。實驗結(jié)果表明,基于ImageNet的ResNet-50的遷移學(xué)習(xí)預(yù)訓(xùn)練模型在識別準(zhǔn)確率方面效果最優(yōu)。實驗還通過顯著圖[16]驗證了畫家藝術(shù)風(fēng)格分布在整幅畫作中,通過風(fēng)格遷移[7]驗證畫家的藝術(shù)風(fēng)格能被神經(jīng)網(wǎng)絡(luò)學(xué)習(xí),同時實驗基于DenseNet-201[17]的遷移學(xué)習(xí)進(jìn)行對比實驗。

1 基于深度學(xué)習(xí)畫家識別系統(tǒng)

1.1 深度殘差神經(jīng)網(wǎng)絡(luò)原理

深度神經(jīng)網(wǎng)絡(luò)層數(shù)的不斷增加,模型精度不斷得到提升,但當(dāng)網(wǎng)絡(luò)層級增加到一定以后,測試正確率和訓(xùn)練正確率迅速下降,這說明當(dāng)神經(jīng)網(wǎng)絡(luò)層數(shù)變多以后,深度神經(jīng)網(wǎng)絡(luò)難以訓(xùn)練。針對這個問題,深度殘差網(wǎng)絡(luò)提出了捷徑連接(shortcut connections)。

CNN隨著深度的增加會出現(xiàn)梯度消失問題,一般的卷積神經(jīng)網(wǎng)絡(luò)隱藏層直接會存在特征圖丟失、不完整問題。殘差網(wǎng)絡(luò)是CNN的一種特殊結(jié)構(gòu),ResNet引入了殘差網(wǎng)絡(luò)結(jié)構(gòu),通過這種殘差網(wǎng)絡(luò)結(jié)構(gòu),一般隨著深度的增加,識別效果會越好。

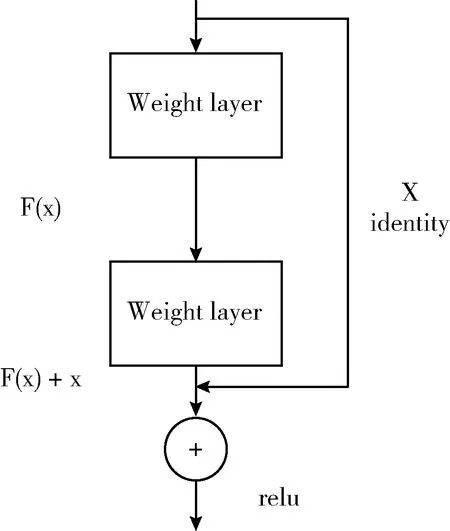

殘差網(wǎng)絡(luò)的基本結(jié)構(gòu)如圖1所示,在圖1的殘差網(wǎng)絡(luò)結(jié)構(gòu)中,通過捷徑連接的方式,直接把輸入傳到輸出,這條連接沒有權(quán)重,可以避免特征圖丟失問題。

圖1 殘差網(wǎng)絡(luò)基本結(jié)構(gòu)

1.2 深度學(xué)習(xí)模型

遷移學(xué)習(xí)的目的是為了將原領(lǐng)域?qū)W習(xí)的信息應(yīng)用推廣到新領(lǐng)域。本文為了驗證深度神經(jīng)網(wǎng)絡(luò)遷移學(xué)習(xí)有效,訓(xùn)練了2個神經(jīng)網(wǎng)絡(luò)進(jìn)行對比,分別是基于ImageNet遷移學(xué)習(xí)的ResNet-50和DenseNet-201這2個模型。

1.2.1 遷移學(xué)習(xí)的ResNet-50

基于ResNet-50結(jié)構(gòu)的遷移學(xué)習(xí)卷積神經(jīng)網(wǎng)絡(luò)見表1,遷移學(xué)習(xí)的卷積神經(jīng)網(wǎng)絡(luò)權(quán)重來自ImageNet數(shù)據(jù)集的預(yù)訓(xùn)練權(quán)重。其它與前一個神經(jīng)網(wǎng)絡(luò)一樣,將ResNet-50全連接的層替換為23維新的連接層,用來計算數(shù)據(jù)集中每個藝術(shù)家的得分。

表1 ResNet-50卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)

基于ImageNet的ResNet-50的遷移學(xué)習(xí)有效地減少了神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)特征時間,原因在于一些從文藝復(fù)興開始的藝術(shù)家,通常在繪畫時都會畫出栩栩如生的場景,這些場景描繪都能直接代表現(xiàn)實世界的畫面,這些圖畫和ImageNet數(shù)據(jù)集里面的圖面有相似之處。

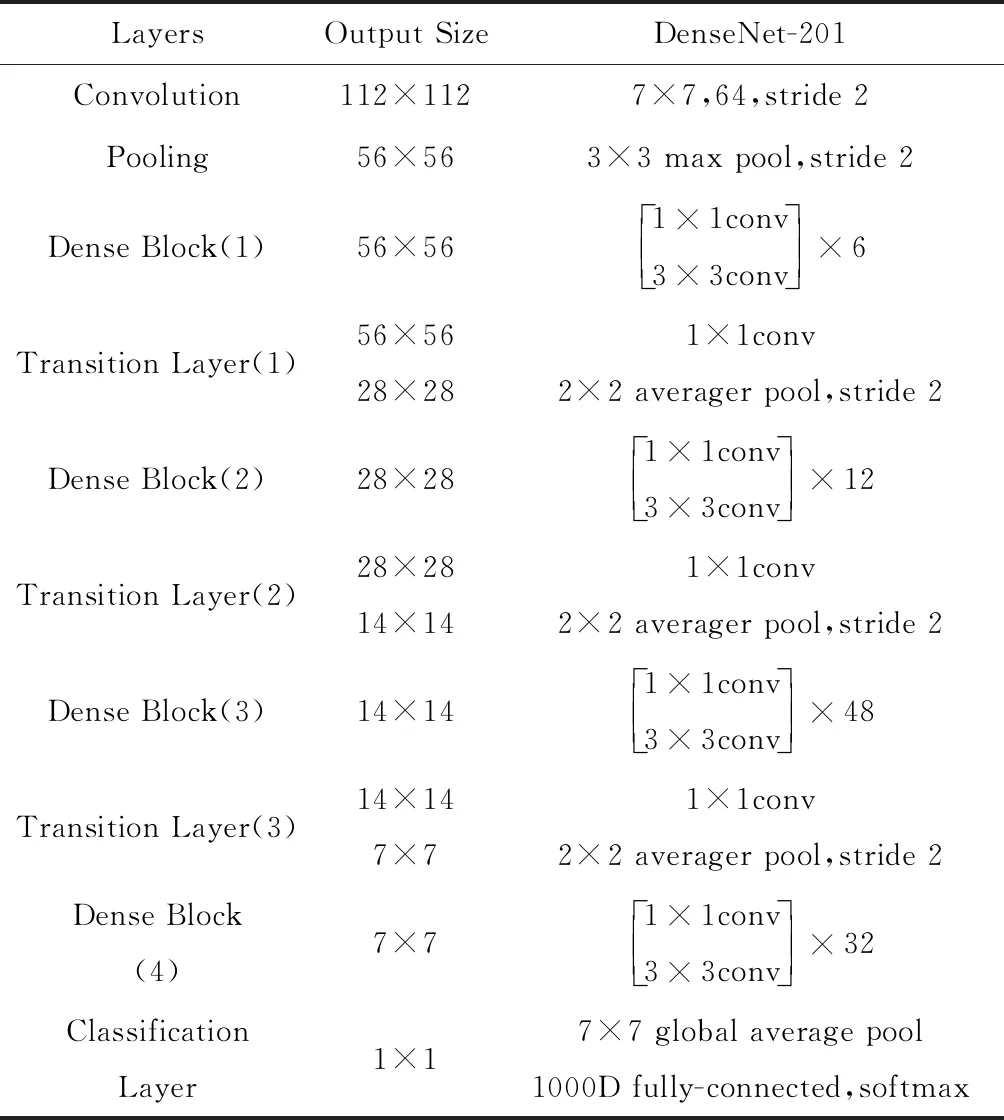

1.2.2 DenseNet-201

DenseNet采用的是一種更密集的連接方式,是一個密集卷積神經(jīng)網(wǎng)絡(luò),以前向傳播方式,將每一層與其余層密集連接。這樣做的目的是可以確保各層之間的信息流動達(dá)到最大,將所有層(特征圖大小匹配)直接連接在一起。DenseNet有著4個顯著特點:①緩解了梯度消失問題;②增強(qiáng)了特征在網(wǎng)絡(luò)間的傳播;③實現(xiàn)和加強(qiáng)了特征重用;④有效減少了參數(shù)數(shù)量。本文主要使用了DenseNet-201卷積神經(jīng)網(wǎng)絡(luò),具體見表2。

表2 DenseNet-201卷積神經(jīng)網(wǎng)絡(luò)模型結(jié)構(gòu)

1.3 分類方法

實驗訓(xùn)練了兩種不同的CNN模型來識別分類畫家。每個神經(jīng)網(wǎng)絡(luò)模型都是基于3×224×224RGB圖像輸入,輸出數(shù)據(jù)集的23個畫家得分。

對于兩個神經(jīng)網(wǎng)絡(luò)模型,使用SoftMax分類和交叉熵?fù)p失

(1)

式中:Li表示在訓(xùn)練集中第i作品的損失。f是神經(jīng)網(wǎng)絡(luò)計算分?jǐn)?shù)的方法,j表示23個可能的選擇中的一個。yi表示正確類型。這個損失函數(shù)能保證神經(jīng)網(wǎng)絡(luò)在訓(xùn)練集中能最大化正確畫家的分?jǐn)?shù)。

2 實驗與結(jié)果分析

2.1 實驗數(shù)據(jù)集與數(shù)據(jù)處理

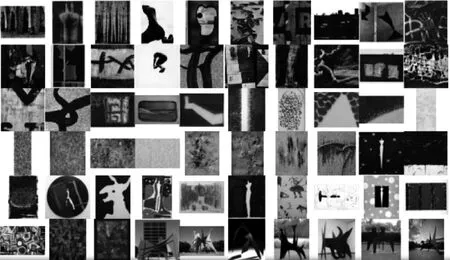

為了訓(xùn)練CNN模型識別畫家,使用WikiArt數(shù)據(jù)集,整個數(shù)據(jù)集包括2300位畫家的超過100 000幅作品,這些作品的時間和風(fēng)格跨越廣度非常廣,數(shù)據(jù)集有抽象派、寫實派、人物畫、風(fēng)景畫、水墨畫、油畫。

整個數(shù)據(jù)集中的絕大多數(shù)藝術(shù)家只有不到50幅繪畫作品,因此為了確保訓(xùn)練網(wǎng)絡(luò)有足夠的樣本量,實驗只使用數(shù)據(jù)集中有400幅或更多繪畫作品的藝術(shù)家。為了保證每位藝術(shù)家畫作數(shù)量平衡,這些畫家畫作只取400幅。因此,數(shù)據(jù)集來自23位藝術(shù)家的400幅作品組成(總共9200幅)。實驗將每個藝術(shù)家畫作按80-10-10的分割將此數(shù)據(jù)集分割為訓(xùn)練集驗證集和測試集。因此,數(shù)據(jù)集中每個藝術(shù)家320幅畫作作為訓(xùn)練集,40幅畫作作為驗證集,40幅畫作作為測試集。這個數(shù)據(jù)集比以前的工作中使用的數(shù)據(jù)集要大得多,圖2給出了數(shù)據(jù)集部分樣本。

圖2 WikiArt數(shù)據(jù)集

如圖2所示,數(shù)據(jù)集中的畫作有不同形狀和大小,所以在將圖像傳送到CNN之前會對其進(jìn)行修改。將圖像歸零并進(jìn)行標(biāo)準(zhǔn)化,在訓(xùn)練網(wǎng)絡(luò)的同時,隨機(jī)對繪畫的任意部分進(jìn)行裁剪,每個輸入圖像進(jìn)行224×224像素裁剪,這種隨機(jī)性增加了訓(xùn)練數(shù)據(jù)的多樣性,有助于避免過度擬合。在驗證和測試圖像時,實驗也是對圖像進(jìn)行隨機(jī)224×224像素裁剪,以確保結(jié)果的穩(wěn)定性和可重復(fù)性。實驗假設(shè)藝術(shù)家的風(fēng)格在圖像中無處不在,而不僅僅局限于特定的區(qū)域,所以繪畫作品的隨機(jī)裁剪可以包含足夠的信息供CNN確定風(fēng)格。

2.2 實驗設(shè)置與環(huán)境

模型訓(xùn)練與測試均是在PyTorch框架下完成的。實驗都是在云平臺完成,使用GTX1080TiGPU,16 G內(nèi)存和200 GB存儲空間。

實驗通過Adam update rule訓(xùn)練兩個模型。遷移學(xué)習(xí)的ResNet-50和DenseNet-201的神經(jīng)網(wǎng)絡(luò),使用默認(rèn) Adam 參數(shù),learning-rate=10-3,實驗可以觀察到訓(xùn)練和驗證數(shù)據(jù)集在整個訓(xùn)練階段的準(zhǔn)確性和損失,當(dāng)神經(jīng)網(wǎng)絡(luò)性能不再提升的時候,將learning-rate降低10倍,直到最后神經(jīng)網(wǎng)絡(luò)訓(xùn)練準(zhǔn)確率不再提高。

2.3 實驗?zāi)P蛯Ρ扰c分析

2.3.1 實驗結(jié)果對比

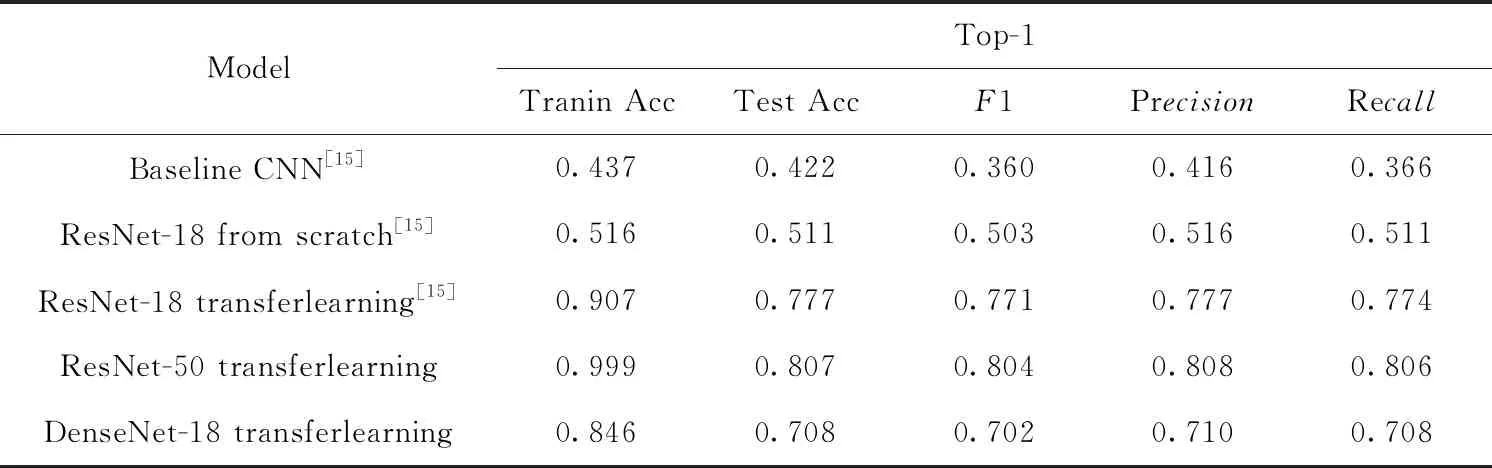

如表3所示,實驗對比了5個神經(jīng)網(wǎng)絡(luò)模型,可以看到top-1的Precision,Recall和F1準(zhǔn)確率。

實驗與文獻(xiàn)[15]進(jìn)行對比,后者展示了3個神經(jīng)網(wǎng)絡(luò)分類的準(zhǔn)確性。 Precision,Recall和的F1定義如下

(2)

表3 藝術(shù)家分類結(jié)果總結(jié)

(3)

(4)

其中,TruePositives和FalsePositives分別表示正樣本被正確識別和錯誤識別的個數(shù),TrueNegetives和FalseNege-tives則分別表示負(fù)樣本被正確識別和錯誤識別的個數(shù)。

表3比較了不同模型的CNN在關(guān)鍵指標(biāo)中的準(zhǔn)確性對比,基于遷移學(xué)習(xí)的ResNet-50的神經(jīng)網(wǎng)絡(luò)的性能優(yōu)于文獻(xiàn)[15]中的3種神經(jīng)網(wǎng)絡(luò)模型,同時優(yōu)于DenseNet-201模型,實驗結(jié)果表明并不是神經(jīng)網(wǎng)絡(luò)更深效果更好。

2.3.2 實驗結(jié)果分析

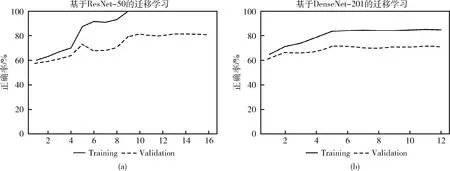

圖3表示兩個神經(jīng)網(wǎng)絡(luò)在訓(xùn)練中準(zhǔn)確率的變化,如圖3(a)所示實驗發(fā)現(xiàn)基于遷移學(xué)習(xí)的ResNet-50開始訓(xùn)練模型,訓(xùn)練集和有效集的兩個模型準(zhǔn)確率提升曲線相似。實驗分為4個階段,每個階段4次epochs訓(xùn)練,每個階段完成后學(xué)習(xí)率下降10倍,如圖3(a)所示第一階段訓(xùn)練集和有效集的準(zhǔn)確率都得到提高,其中第二階段準(zhǔn)確率提高并不明顯,第三階段準(zhǔn)確提高迅速,可見不同的學(xué)習(xí)率對神經(jīng)網(wǎng)絡(luò)模型有不同提高效果,第四階段表示神經(jīng)網(wǎng)絡(luò)已不再提高。

圖3 3種不同模型的準(zhǔn)確率

圖3(b)所示,DenseNet-201CNN模型初始準(zhǔn)確率非常高,后面準(zhǔn)確率提高的非常緩慢,多次訓(xùn)練后準(zhǔn)確率最高達(dá)到70%。DenseNet-201開始學(xué)習(xí)的模型第一階段明顯提升,將learning-rate縮小10倍時,第二階段對準(zhǔn)確率有一個曲線上升。第三階段沒有提升,而且準(zhǔn)確率相對較低,實驗驗證ResNet-50神經(jīng)網(wǎng)絡(luò)相對DenseNet-201神經(jīng)網(wǎng)絡(luò)在藝術(shù)家畫作識別上效果更好。

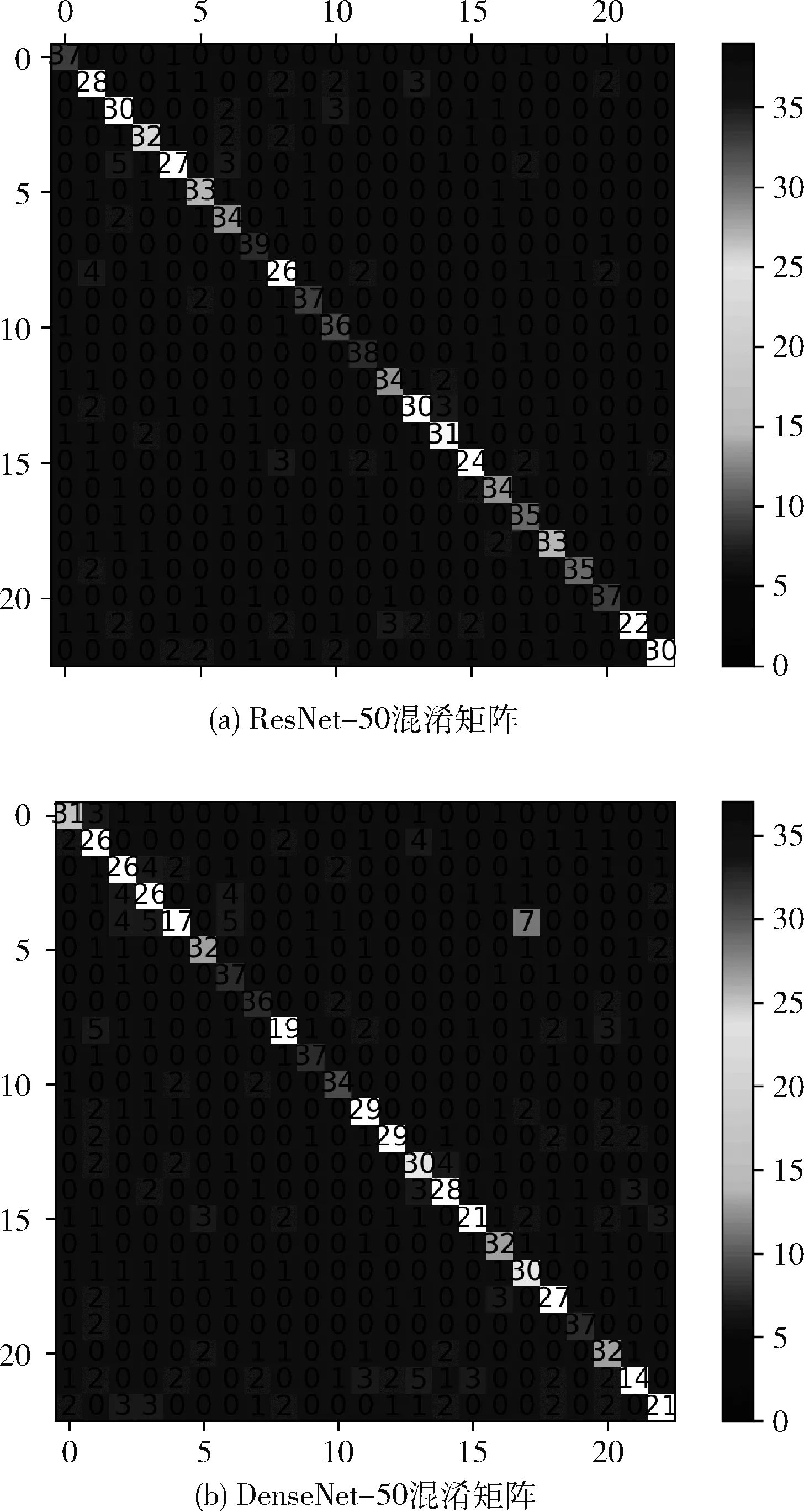

2.4 混淆矩陣

實驗考查了基于ResNet-50和DenseNet-201的遷移學(xué)習(xí)神經(jīng)網(wǎng)絡(luò)在正確分類方面遇到的困難。圖4顯示了兩個混淆矩陣,該矩陣是使用Torchnet for Pythorch計算的。每一列表示每個藝術(shù)家畫家預(yù)測分類,因為實驗數(shù)據(jù)集中有23個藝術(shù)家,為清晰起見,圖中省略了矩陣上的標(biāo)簽。理想情況下實驗希望盡可能多地預(yù)測集中在對角線上,這意味著神經(jīng)網(wǎng)絡(luò)正確地預(yù)測了正確的藝術(shù)家。

圖4 測試集上混亂矩陣對于top-1分類準(zhǔn)確率

測試集中每個藝術(shù)家有40幅畫,測試集中混淆矩陣中單元格最大值為40。可以看到,對大多數(shù)藝術(shù)家來說,對角線上的數(shù)值都是較大的,這表明大多數(shù)繪畫作品都被正確分類。倒數(shù)第二位藝術(shù)家Salvador_Dali是預(yù)測正確最少的,在ResNet-50測試數(shù)據(jù)集中,他40幅作品中只有22幅是正確預(yù)測。在DenseNet-50測試數(shù)據(jù)集中,他40幅作品中只有14幅是正確預(yù)測。Dali是一位具有非凡才能和想象力的藝術(shù)家,他的作品把怪異夢境般的形象與卓越的繪圖技術(shù)和受文藝復(fù)興大師影響的繪畫技巧令人驚奇地混合在一起,他的藝術(shù)風(fēng)格與其它藝術(shù)家的交叉重疊,所以他的畫作極易分辨錯誤,這表明具有多種風(fēng)格的藝術(shù)家畫作極易分類錯誤。

2.5 顯著圖

計算顯著性首先計算神經(jīng)網(wǎng)絡(luò)正確的類分?jǐn)?shù)相對于輸入圖像的梯度,然后在計算的梯度的RGB這3個信道上取最大值。用于計算顯著性圖M的方程如公式所示,其中w是相對于正確類的導(dǎo)數(shù),c是顏色通道Mij是圖像中的位置,h(i,j,c) 是與原始圖像中i,j,c相對應(yīng)的w的索引[14]

Mij=max|wh(i,j,c)|

(5)

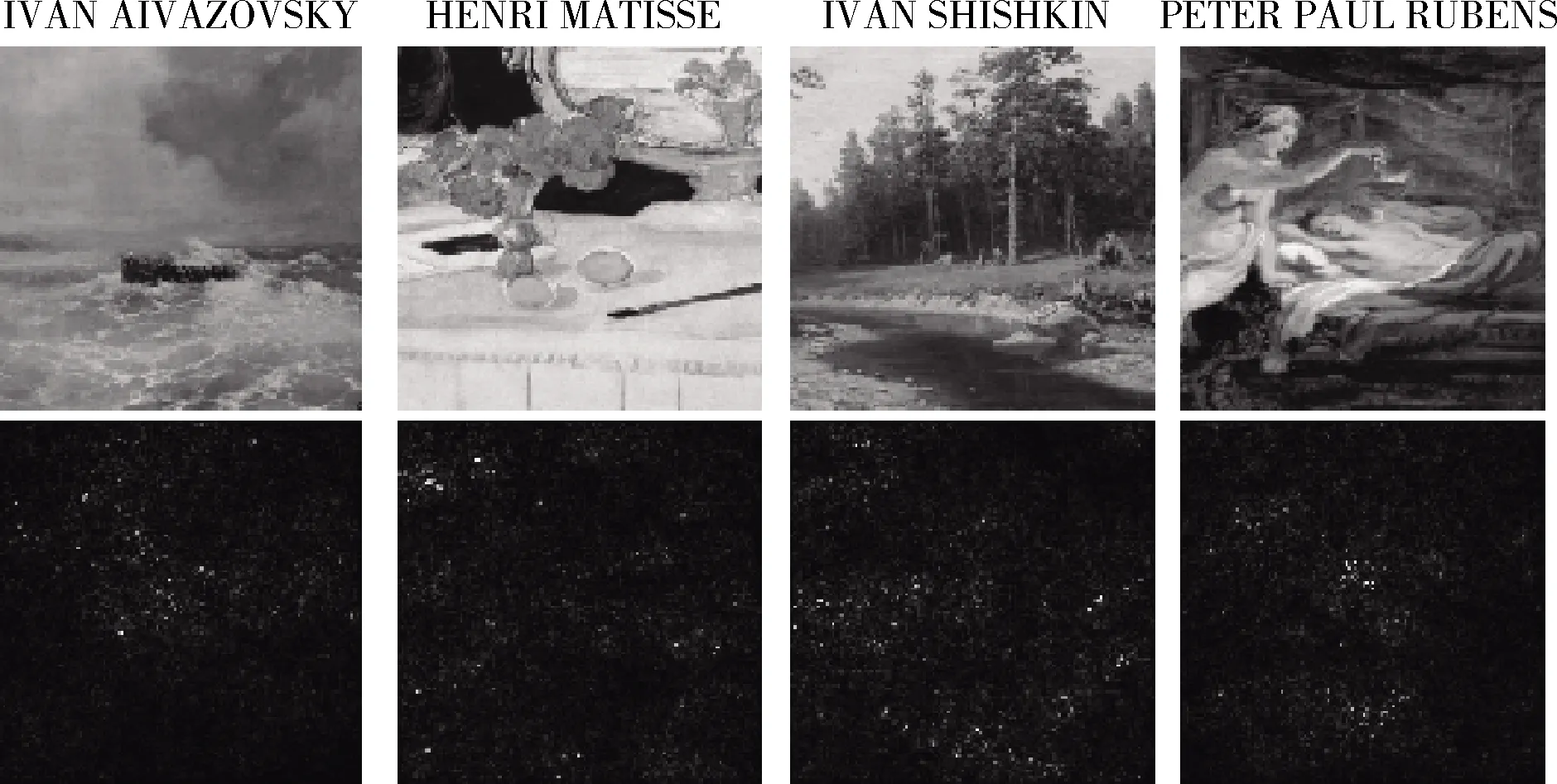

顯著圖能夠可視化圖像中的哪些像素對該圖像的預(yù)測分?jǐn)?shù)貢獻(xiàn)最大。實驗實現(xiàn)了藝術(shù)家識別的顯著圖,以確定繪畫的哪些部分對于預(yù)測藝術(shù)家有重大影響。

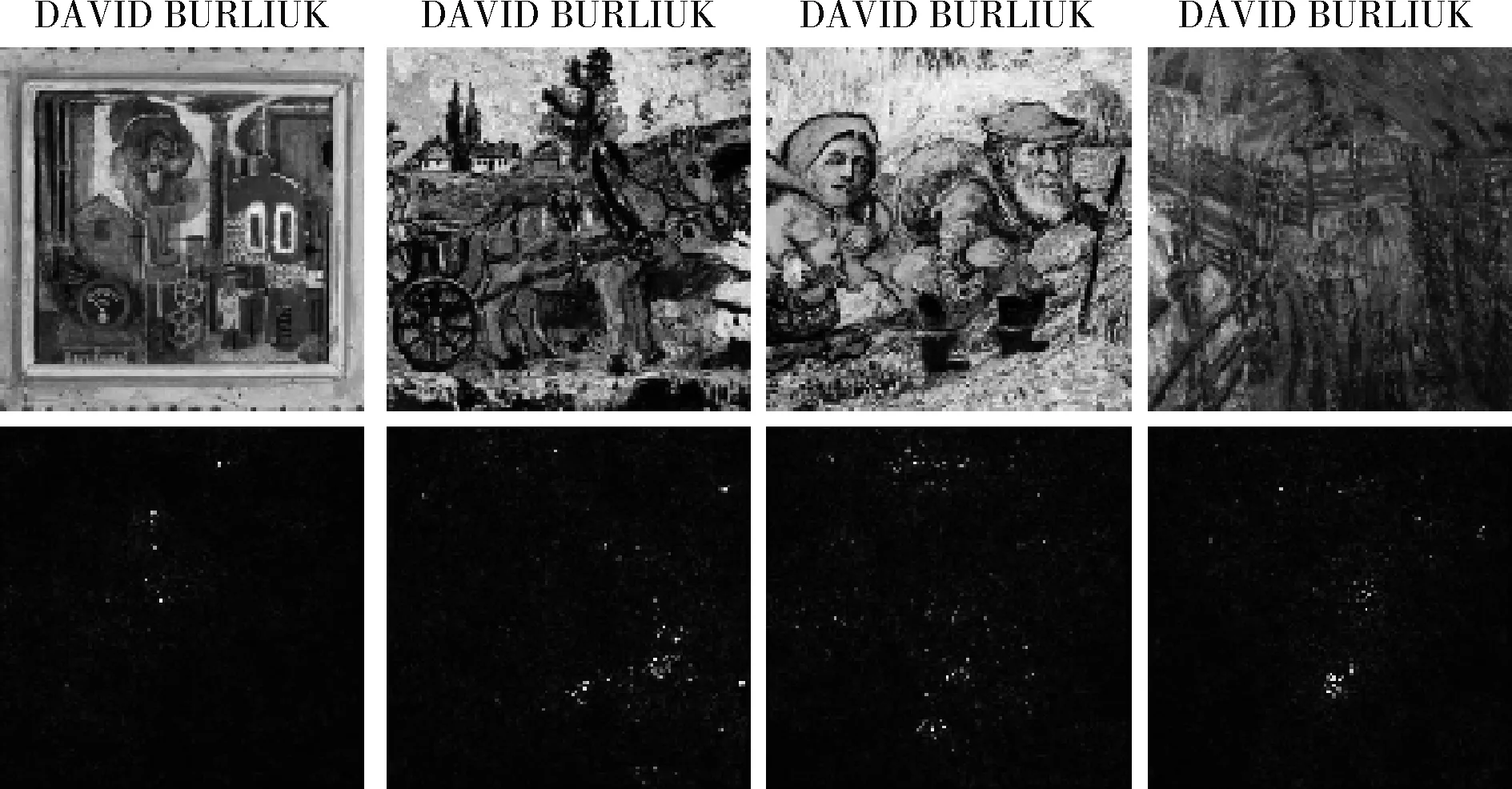

圖5展示了不同畫家作品的顯著圖,圖6展示了同一個畫家不同作品的顯著圖。在這些繪畫顯著圖中,畫作中物體或人并不是影響分類最明顯的地方,因為影響分類的像素分布整個畫作。實驗檢查了許多其它繪畫的顯著性地圖,發(fā)現(xiàn)在大多數(shù)繪畫中,影響預(yù)測的像素分布在整個圖像,而不是集中在其中的物體或人周圍。因為藝術(shù)家畫作風(fēng)格存在于整個圖畫中,表明預(yù)處理數(shù)據(jù)隨機(jī)切割圖像并不會影響繪畫的風(fēng)格,證明假設(shè)正確。

圖5 不同畫家畫作的顯著圖

圖6 同一個畫家不同畫作的顯著圖

2.6 風(fēng)格遷移

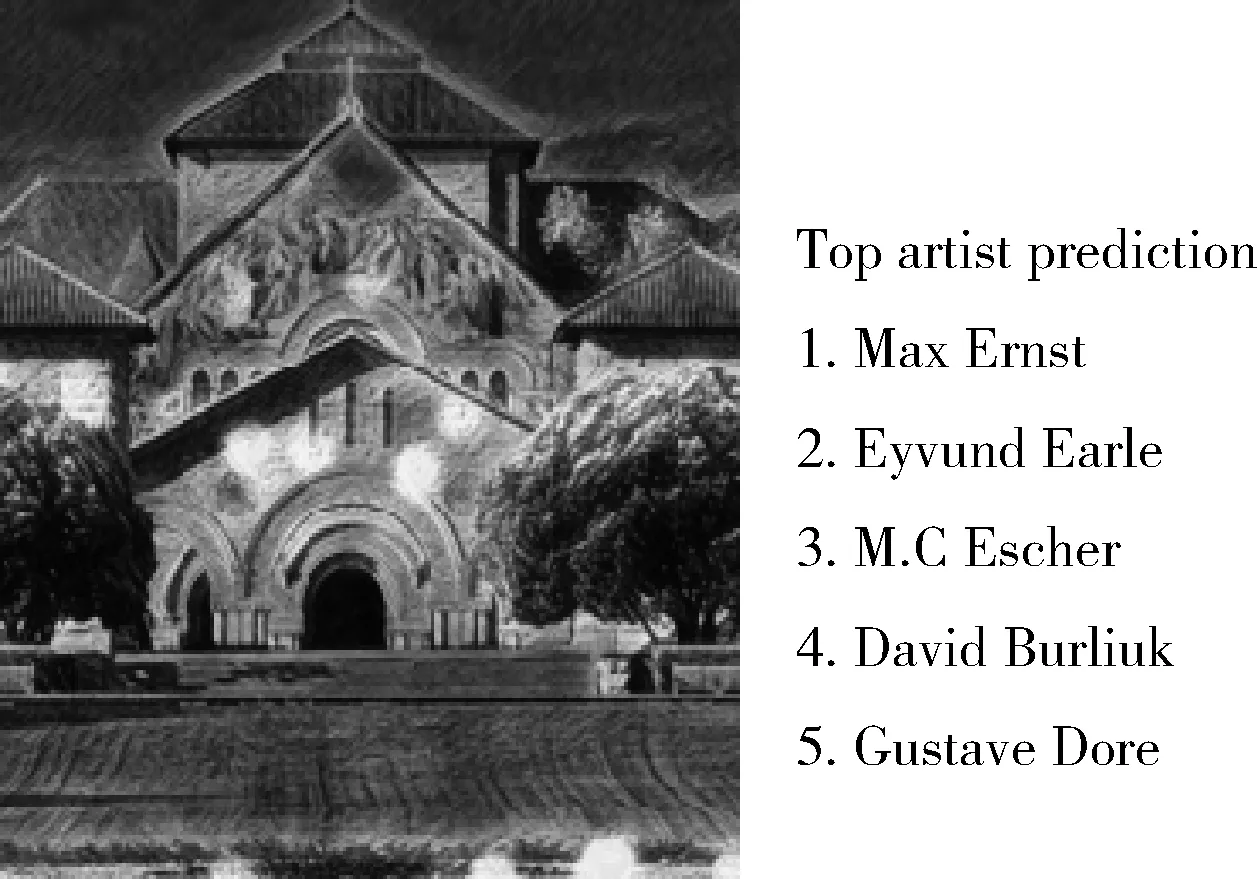

實驗將一個畫家藝術(shù)風(fēng)格遷移到另一個畫家畫作上,然后通過這幅畫作在神經(jīng)網(wǎng)絡(luò)中分類從而得出藝術(shù)家風(fēng)格能被神經(jīng)網(wǎng)絡(luò)識別。圖7使一座城堡的原畫經(jīng)過Max Ernet的風(fēng)格遷移,并且在基于遷移學(xué)習(xí)的ResNet-50模型顯示top 5預(yù)測。神經(jīng)網(wǎng)絡(luò)預(yù)測Max Ernst最可能是這幅畫的畫家,意味神經(jīng)網(wǎng)絡(luò)能獨自預(yù)測的繪畫風(fēng)格,而不是看重它的繪畫內(nèi)容,神經(jīng)網(wǎng)絡(luò)可以分開理解繪畫內(nèi)容和繪畫風(fēng)格。遷移學(xué)習(xí)的ResNet-50模型對遷移風(fēng)格圖像進(jìn)行了大量實驗,雖然神經(jīng)網(wǎng)絡(luò)并沒有每次為正確的藝術(shù)家產(chǎn)生最高的分?jǐn)?shù),但正確的藝術(shù)家通常在前5名,進(jìn)一步證實藝術(shù)家的風(fēng)格確實能被卷積神經(jīng)網(wǎng)絡(luò)理解。

圖7 基于Max Ernst風(fēng)格遷移的畫作畫家預(yù)測

3 結(jié)束語

本文提出了一種基于ImageNet預(yù)訓(xùn)練ResNet-50的遷移學(xué)習(xí)方法。通過遷移學(xué)習(xí)ResNet-50和DenseNet-201這2個神經(jīng)網(wǎng)絡(luò)對比,驗證基于遷移學(xué)習(xí)ResNet-50識別效果最好。實驗通過顯著圖驗證藝術(shù)家風(fēng)格存在于整幅畫作中,其次通過風(fēng)格遷移實驗驗證藝術(shù)家風(fēng)格能被神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)。雖然本文方法對藝術(shù)家識別取得一定效果,但如2.4節(jié)所說基于ImageNet預(yù)訓(xùn)練ResNet-50卷積神經(jīng)網(wǎng)絡(luò)在畫家具有多種風(fēng)格時,分類正確率一般,如何更加準(zhǔn)確識別具有多種藝術(shù)風(fēng)格的畫家是未來主要研究方向。