融合運動特征和深度學習的跌倒檢測算法

曹建榮,呂俊杰,武欣瑩,張 旭,楊紅娟

(1.山東建筑大學信息與電氣工程學院,濟南 250101;2.山東省智能建筑技術重點實驗室(山東建筑大學),濟南 250101)

(*通信作者電子郵箱junjielv123@163.com)

0 引言

跌倒是老人傷害死亡的首要因素,現階段對老人異常檢測的研究工作主要集中在跌倒檢測上。現有的跌倒檢測方式主要有基于可穿戴式、基于環境式、基于計算機視覺三種。可穿戴式跌倒檢測使用的傳感器類型有加速度傳感器、壓力傳感器、音頻傳感器等,這種方法由于外界噪聲的各種干擾和系統本身的穩定性等原因導致誤報警問題一直得不到很好解決;而且可穿戴式傳感器需要老人長期佩戴,舒適感差。基于環境式摔倒檢測系統需要預先把傳感器(紅外線、超聲波等非視覺傳感器)布置在人體活動環境里,不需要隨身攜帶,可以解決舒適感差的問題,但是價格昂貴、干擾較大[1-4]。計算機視覺的跌倒檢測則無需穿戴,不會影響人體活動,具有實時性好、成本更低、檢測準確度更高的特點。Foroughi 等[5]利用橢圓來近似表達人體,把橢圓的長短軸的標準差作為特征,并把人體的投影直方圖與頭部位置作為一個特征,然后使用深度學習方法對這些特征分類,再根據特征判斷出人體的狀態。Miaou 等[6]利用全景相機來采集視頻圖像,利用背景差分法來提取目標特征,利用最小外接矩形來包圍目標人體,并利用矩形的寬度高度判斷是否跌倒。Rougier等[7]利用人體形狀來做跌倒檢測,先利用混合高斯模型(Gaussian Mixture Model,GMM)算法進行目標檢測,再利用閾值法進行跌倒檢測。沈秉乾等[8]利用分級法進行人體檢測:第一級通過寬高比判斷是否為直立狀態;第二級通過支持向量機(Support Vector Machine,SVM)分類判斷是蹲下還是跌倒狀態。馬露等[9]提出一種改進的FSSD(Feature Fusion Single Shot Multibox Detector)跌倒檢測方法。Gammulle 等[10]將卷積神經網絡(Convolutional Neural Network,CNN)卷積層和全連接層學到的特征信息輸入長短期記憶(Long Short-Term Memory,LSTM)網絡中,接著學習這些空間特征的時序相關性,最終輸出人體行為識別數據。Nú?ez-Marcos 等[11]利用RGB計算光流信息,并利用VGG16對光流信息進行分類和跌倒檢測。申代友等[12]提取人體的多個關節點位置,根據多個連續幀之間人體關節點的運動變化特征判定老人是否發生跌倒行為。袁智等[13]提出了一種由兩路CNN 融合組成的雙流卷積神經網絡(Two-Stream CNN)的跌倒識別方法。

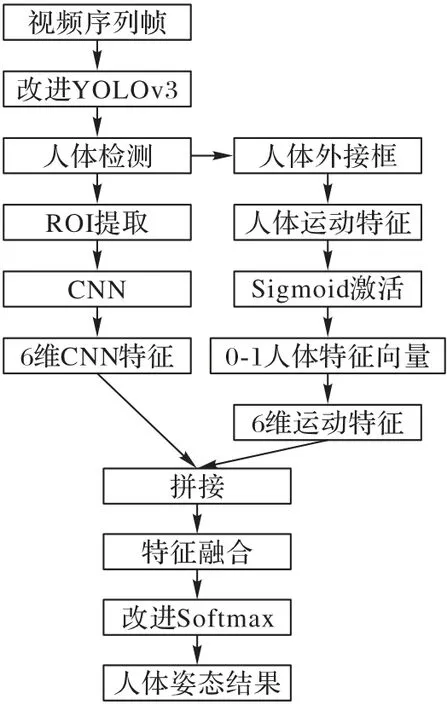

由以上可知,基于計算機視覺的檢測方法需要進行兩步:1)目標提取;2)對提取目標進行判斷。利用背景差分、高斯混合等前后景分離的方法對運動狀態目標進行提取具有一定的局限性,因為當人體運動緩慢或者人由運動狀態變為靜止后會造成目標丟失,而且當有其他非人類運動時會造成目標混淆,將非人體運動誤判為人體運動。利用閾值法或分級法進行人體跌倒判斷只利用了人體的運動信息而沒有利用圖像本身的內容特征,利用CNN 或SVM 分類進行跌倒判斷雖然利用了圖像本身的信息,但丟失了運動信息,在光照變化時會對準確性產生一定影響。針對上述問題,為了適應在視頻監控中的人體目標檢測,對YOLOv3 主干網絡進行裁剪,根據全局密集殘差網絡特征提取的優勢和人體跌倒視頻監控中運動目標分析的實際情況,提出了局部密集型殘差網絡結構,并將局部密集型殘差引入特征檢測主干網絡;然后分析了跌倒過程中人體運動目標在時間序列上的變化情況,提取了表示人體摔倒過程中的運動特征信息,接著針對視頻序列中的每一幀的運動圖像描述,設計了一個八層的CNN 自動提取運動圖像描述特征信息,利用全連接層具有特征融合的特性,將運動特征信息引入到圖像描述特征信息中進行融合。

1 人體目標檢測

1.1 二分K-means提取候選框

YOLOv3 中Grid cell 預測的三個初始候選錨框(anchor box)的維度(寬、高)通過K-means 聚類方法確定[14-16]。K-means 算法隨機選取K個質心作為初始質心的處理方式會使初始聚類中心選到同一個類別上,導致算法陷入局部最優狀態。傳統K-means 算法度量函數采用歐幾里得距離,M維空間中兩個向量X、Y之間的歐氏距離公式如下:

采用式(1)度量函數會影響模型對小框的預測結果,為此采用以下改良的度量函數:

其中:d表示候選框與真實框中心坐標之間的距離;RIOU表示候選框與真實框兩者之間面積的交集與并集的比值,即交并比(Intersection over Union,IOU)。

與K-means算法不同,二分K-means加入了用于度量聚類效果的誤差平方和(Sum of Squared Error,SSE)評價指標作為分類依據,能夠加速分類且收斂于全局最小點,減小分類誤差,故本文用二分K-means 算法對樣本目標框維度進行聚類,步驟如下:

步驟1 由式(4)初始化聚類中心C;由式(1)算出每個初始矩形框到初始聚類中心C的距離d;

其中:N是樣本候選矩形框的數目,hi是第i個候選矩形框的高度,wi是第i個候選矩形框的寬度。初始距離中心C由所有視頻幀樣本候選框的長寬求均值確定。

步驟2 將初始樣本候選框利用K-means 算法分成兩個簇。

步驟3 利用式(5)計算每個簇的誤差平方和(SSE),選取最大誤差平方和的那一簇利用K-means進行二分類。

其中:ki是第k個簇的第i個樣本,ck是第k個簇的聚類中心;表示第k個簇的聚類中心所表示的矩形框與第k個簇中第i個樣本所表示矩形框的面積比值。

步驟4 重復步驟3直到達到所需K個類。

圖1 是二分K-means 和K-means 算法的IOU 對比,橫坐標K表示樣本集需要分為幾類(簇),縱坐標表示IOU 變化。從圖1 中可以看出,K取不同值時,二分K-means 聚類所得的交并比要優于K-means聚類的交并比,利用二分K-means能夠更好地對目標維度進行聚類,獲得與真實框更加接近的IOU。

1.2 特征提取

1)YOLOv2 的主干網絡是darknet-19,由卷積層(19 層)和最大池化層(5 層)交替組成,網絡結構簡單,且算力資源消耗較少,但最大池化的加入使信息特征在前向傳遞時會逐層丟失,導致檢測精度下降。

2)Huang 等[17]在CVPR2017 上對殘差網絡ResNet 進行了改進,提出了一種具有密集連接的卷積神經網絡DenseNet,該論文獲得了當年的最佳論文。該方法將每一層與前面所有層進行通道連接,并作為下一層的輸入。由于連接了前面所有層的信息,因此可以減輕梯度消失現象,網絡結構變得越來越緊密,它的第n層輸出為:

其中:xn表示[x0,x1,…,xn-1]將0 到n-1 層輸出的特征圖進行級聯,Hn表示網絡非線性變換。這樣的全局密集型連接方式會造成信息的冗余,因此本文將全局密集連接改為局部密集連接,即將每一層的前面三層直接連接輸入層與損失層而非連接前面所有層的輸入層與損失層。

3)YOLOv3 主干網絡darknet-53 提取特征時,網絡結構較深,增加網絡深度即增加檢測時間,本文只檢測人體這一類目標,其檢測目標明確且類別少。

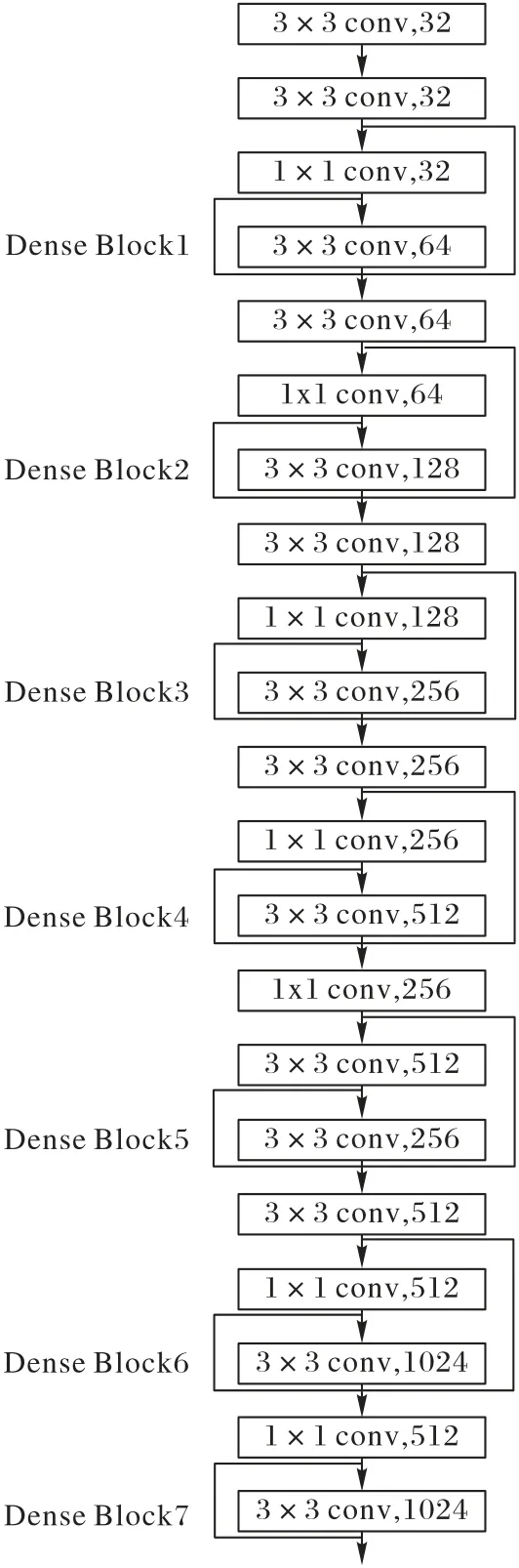

綜合以上三點,本文設計了如圖2 所示的人體目標檢測特征提取網絡。

圖2 人體目標檢測特征提取網絡Fig.2 Feature extraction network of human body object detection

圖2 所示網絡以darknet-19 為基礎,借鑒YOLOv3 網絡和DenseNet結構,在darknet-19主干網絡中引入局部密集型殘差結構,提出了darknet-21 主干網絡,實現了網絡多層特征的復用和融合,避免了全局DenseNet 引起的特征冗余,滿足人體特征提取的快速性和精確性。去掉darknet-19 中的最大池化層,用卷積層進行2 倍下采樣方法代替原最大池化層的下采樣,這樣能夠縮小特征圖尺度以提取細膩特征信息傳遞給后續卷積層。為了方便與檢測層相融合連接,去掉darknet-19最后一層卷積層,保留其余各卷積層;在darknet-19 的第2 層卷積層后添加兩層卷積層以構建一個局部密集型殘差模塊,由此構成由21 層卷積層順序連接的主干網絡。借鑒密集型殘差思想構建局部密集殘差模塊,通過恒等映射、局部跳躍連接其前層卷積輸出特征信息,將其直接傳遞給后面某層輸出,以進行信息融合。

2 運動目標特征分析

本文提出了基于幾何運動特征與CNN 融合的人體跌倒分類器,結合人體運動形態學先驗特征和CNN卷積特征進行室內人體跌倒檢測。

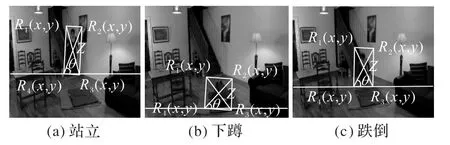

2.1 運動目標特征

視頻幀中根據人體跌倒過程中的傾斜方向不同可分為橫向跌倒和縱向跌倒兩種情況,圖3和圖4分別為人體橫向和縱向跌倒過程的運動特征示意圖,圖(a)、(b)、(c)分別表示跌倒過程中的三個狀態,圖中水平方向定義為X方向,垂直方向定義為Y方向,通過對跌倒過程中人體的不同姿態進行分析得到矩形寬高比、質心高度、軀干傾斜角三個運動狀態特征。

圖3 橫向(水平)跌倒運動特征示意圖Fig.3 Schematic diagram of horizontal fall motion features

圖4 縱向(垂直)跌倒運動特征示意圖Fig.4 Schematic diagram of vertical fall motion features

1)矩形寬高比。

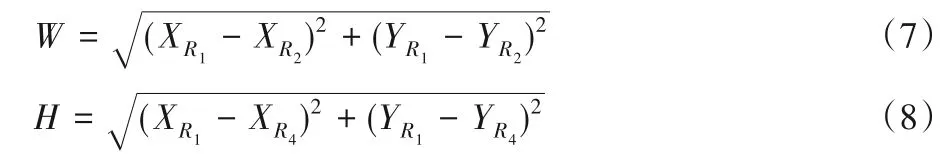

將目標框的四個頂點按順時針方向依次命名為R1(x,y),R2(x,y),R3(x,y),R4(x,y),利用四個頂點的坐標由歐氏距離公式可以計算出目標框的寬度W和高度H:

不同的照射數目,90%等劑量線所覆蓋PTV劑量分布狀況一樣,靶區劑量的分布受照射野數目的影響不大,90%體積的PTV接受最低劑量是50 Gy。靶區以外卷入正常組織的5野布野比9、7野布野多,其中9野布野最少,脊髓保護5野低于7、9野。

無論是橫向跌倒還是縱向跌倒,當視頻幀中的人體正常站立時,W<H;當人體由站立逐漸跌倒時,W的值會逐漸增大,H的值會逐漸減小,如圖3(c)所示,當人體橫向跌倒時,W>H;如圖4(c)所示,當人體縱向跌倒時,目標框寬度W小于等于目標框高度H。為了更好地描述不同傾斜方向導致跌倒過程中目標框寬度與高度的變化情況,本文用目標框寬度W與高度H的比值Q作為人體跌倒(橫向、縱向)判斷的一個特征:

2)人體質心高度。

當人體由站立狀態逐漸摔倒的過程中,人體的質心是逐漸變化的,將人體目標框的對角線進行連接,則交點即為人體的質心Z,如圖3、4 所示,找出R3(x,y)和R4(x,y)橫縱坐標的較大值,經過較大值在水平方向畫一下水平線L,將質心Z與水平線L的垂直距離記ZL,用ZL來描述人體質心的變化情況。當人體由站立狀態逐漸摔倒時,ZL的值會逐漸減小,因此,運動質心高ZL的變化可以作為人體跌倒判斷特征。

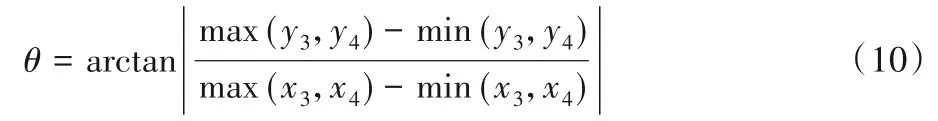

3)人體軀干傾斜角。

如圖3、4 所示,當人體處于不同的狀態時,人體軀干與視頻幀圖像水平方向會呈現不同的角度,對于目標框頂點R3(x,y)和R4(x,y),由幾何關系可以確定人體軀干傾斜角θ:

為了更好地說明以上三個特征的運動變化情況,從跌倒檢測公開數據集Le2i中分別提取橫向、縱向跌倒各90 幀片段進行分析,圖5(a)表示橫向跌倒各運動特征的變化情況,圖5(b)表示縱向跌倒各運動特征的變化情況,圖中橫軸對應視頻片段的視頻幀序列號,其中0~29幀表示站立,30~59幀表示下蹲,60~89 幀表示跌倒,縱軸分別代表對應視頻序列號的各個運動特征的值。

圖5 橫、縱向跌倒運動特征變化Fig.5 Changes of horizontal and vertical motion features

由圖5 可以看出,無論是橫向跌倒還是縱向跌倒,站立與跌倒動作之間人體矩形寬高比、人體質心高度、人體軀干傾斜角都具有很好的區分度,人體下蹲曲線處于站立、跌倒兩個動作之間,與站立、跌倒兩個動作有明顯的區別,因此下蹲與站立、下蹲與跌倒都能較好地進行區別。綜上分析,矩形寬高比、質心高度、軀干傾斜角三個運動狀態特征能夠表征人體運動姿態變化。

4)運動特征向量。

通過上述分析可知,人體軀干傾斜角θ、質心高度ZL和人體寬高比Q可作為人體運動狀態識別的特征,基于這三個特征構建人體運動狀態向量M=[θ,ZL,Q]。為了與CNN 特征提取后的特征進行更好的融合,將人體運動特征向量重復一次變為6 維特征M'=[θ,ZL,Q,θ,ZL,Q],為了避免特征融合后參數過擬合,利用Sigmoid 激活函數將特征向量變為0 到1之間的數值,變化后的特征向量為:

其中,σ為Sigmoid激活函數。

2.2 運動目標特征

1)網絡結構。

手工提取的人體運動特征能夠表示運動信息,CNN 能夠自動提取圖像的靜態特征,本文將人工提取的運動特征與CNN 特征進行融合,將兩種不同維度的特征映射到同一特征空間。圖6 所示為融合運動特征CNN 算法的流程:特征融合網絡首先利用CNN 從輸入視頻幀中提取圖像顏色、紋理、輪廓等特征進行全面學習;然后加入手工提取的人體運動特征,利用全連接層將這兩種維度的特征進行融合,在網絡參數反向傳播優化過程中,人工運動特征能夠優化CNN 參數的學習,在CNN 中融入運動特征成分,最終形成一個全面的特征表達,以便能夠更好地對目標行為進行描述。

CNN 網絡特征提取的具體過程為:將視頻幀輸入到CNN模型中,經過卷積層1,卷積層1 為64 個3×3 的卷積核,維度(3,3,3,64);接著進入到2×2 的池化層1,其維度為(1,2,2,1);之后進入第二個卷積層,卷積層2 為96 個3×3 的卷積核,維度為(3,3,64,960),再進入第二層池化,維度為(1,2,2,1);之后進入第三個卷積層,卷積層3 為256 個3×3 的卷積核,維度為(3,3,96,256);再進入第三層池化,維度為(1,2,2,1);之后進入第四個卷積層,卷積層4為64個3×3 的卷積核,維度為(3,3,256,64);再進入第四層池化,維度為(1,2,2,1);之后進入第五個卷積層,卷積層5 為32 個3×3 的卷積核,維度為(3,3,64,32);卷積層6 為32 個1×1 的卷積核,維度為(1,1,32,1),經過拉伸操作,進入CNN 全連接層1得到169維的CNN 特征向量,然后經過CNN 全連接層2得到6維的CNN 特征向量;將6 維的CNN 特征向量與經過Sigmoid 激活后的6 維人體運動特征進行拼接得到1 個12 維的向量;然后將12 維的特征向量經過一個具有3 個節點的全連接神經網絡進行特征融合,最后輸出分類預測結果。

圖6 融合運動特征CNN算法流程Fig.6 Flowchart of CNN algorithm fusing with motion features

2)代價函數。

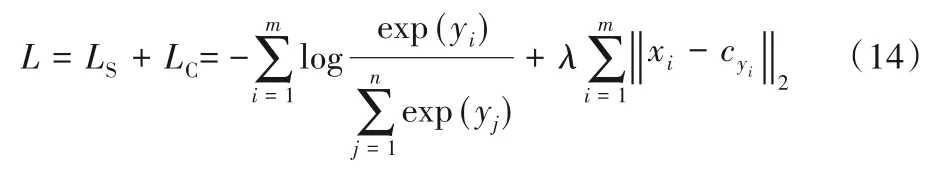

上述融合CNN 跌倒檢測模型輸出有3 個節點,分別代表站立、跌倒中、跌倒三個類別。交叉熵是分類問題中比較經典的代價函數,它刻畫了兩個概率分布之間的距離,但是原始神經網絡的輸出并不符合概率分布,因此為了使用交叉熵作為評價函數,本文將原始神經網絡輸出的最后一層加入Softmax函數,用Softmax 函數作為輸出結果的類別置信度,這樣就會生成符合概率分布的輸出結果。

式中:m為訓練中每次batch的大小,n為輸出類別數。

為了增加輸出不同類別之間的距離,對傳統代價函數進行了優化,定義了輸出類間代價函數:

式中:λ表示類間損失因子,xi表示全連接層輸出的第i個樣本,cyi表示所有同一類別yi的所有樣本的中心值。

綜上,本文定義的總目標優化函數L是:

3 實驗結果分析

本文訓練過程在GPU 服務器上完成,操作系統為Ubuntu16.04;硬件平臺CPU E5-2630 V4@2.2 GHz,兩個顯卡為GTX1080TI(11 GB×2),內存128 GB;軟件平臺采用OPENCV3.4.3、Python3.6.3、CUDA、cuDNN、Pycharm,使用TensorFlow深度學習框架進行訓練。

從公開數據集Le2i選取10 段人體跌倒的視頻,每段視頻包含約240 幀圖像(分辨率為320 × 240,視頻速率為每秒24幀),將白天光照充足下的視頻片段編號為1~5,將夜晚室內燈光干擾情況下的視頻片段編號為6~10,每段視頻均包含實驗者正常站立、下蹲和跌倒的三種姿態。首先將視頻幀送入改進的YOLOv3 模型中進行人體目標檢測;然后提取人體運動目標特征(軀干傾斜角、人體質心高度、矩形寬高比),將人體目標圖像與人體運動目標特征向量輸入到本文融合運動特征的網絡模型中輸出識別結果;最后對跌倒行為的識別結果視頻幀進行保存,作為跌倒檢測準確度的判斷標準。圖7 為融合運動特征CNN 檢測結果,可以看出,在不同光照影響下,人體從不同方向跌倒,本文算法都能較好地完成跌倒任務的檢測。

圖7 融合運動特征的CNN跌倒檢測結果Fig.7 Fall detection results of CNN fusing with motion features

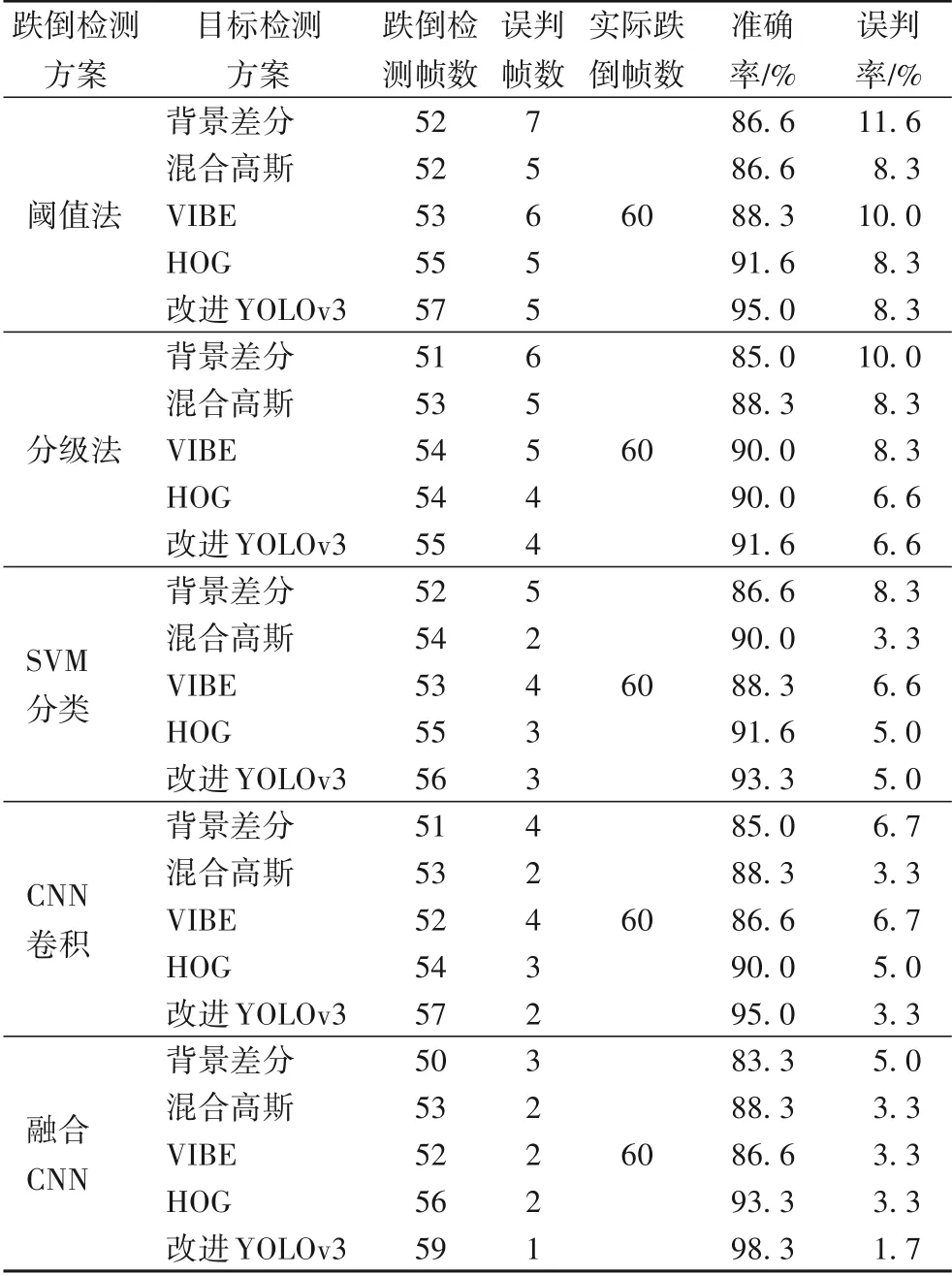

3.1 不同跌倒檢測方案對比實驗

為了檢測本文方案的準確性,設計對比檢測實驗,分析改進YOLOv3 進行人體檢測的優越性和融合人體運動特征神經網絡跌倒檢測方案的準確性。實驗結果如表1所示,分析表1的實驗數據可知,當人體在視頻中由運動變為靜止狀態時,背景差分、混合高斯、VIBE 方法對目標檢測產生丟失,會導致跌倒檢測幀數較低;HOG 檢測能夠檢測到靜止的人體,但基于方向梯度信息進行人工特征提取需要人工進行Gamma 校正,Gamma取值不具有普適性,因此HOG 平均跌倒檢測幀數雖然比前背景分類方法好,但是跌倒檢測幀數仍不理想。基于閾值的跌倒判斷方法只要滿足一個條件就判斷為跌倒,基于分級的跌倒判斷方法是對多個判斷條件進行靈敏度分級,按照靈敏度級別由高到低依次根據條件進行跌倒判斷,這兩種方法雖然判別簡單,但誤判率較高。SVM 與CNN 方法進行跌倒判斷的誤判率能夠較全面提取到圖像的特征信息,檢測效果優于分級法與閾值法,但是丟失了圖像人體運動信息。總體來說,基于融合運動特征CNN 方案的檢測準確率平均值達到98.3%,誤判率為1.7%,這種方案能夠滿足老人跌倒檢測的需要。

表1 不同跌倒檢測方案結果對比Tab.1 Comparison of results of different fall detection schemes

3.2 光照干擾對比實驗

由上述分析可知基于改進YOLOv3 人體檢測融合運動特征的CNN跌倒檢測具有較好的檢測效果。在實際環境中由于天氣或燈光等客觀原因會使攝像環境發生變化,為了驗證光照對檢測效果的影響,分別在正常光和干擾光條件下進行了5組對比實驗,結果如表2所示。其中光照條件為正常光是指白天室內正常天氣光照下錄制條件,燈光干擾條件是晚上室內打開白熾燈進行干擾的錄制條件。從實驗結果可知,加入燈光干擾后,跌倒檢測的準確率、誤判率并沒有很大的影響,在不穩定光照影響下,本文方法進行跌倒檢測并不會產生太大的誤差,不會對最終跌倒檢測的準確率和誤判率產生影響,說明本文跌倒檢測算法對光照干擾的影響具有較高的魯棒性。

表2 光照干擾對比實驗Tab.2 Comparison experiment of lighting interference

3.3 噪聲干擾實驗

上述實驗的跌倒檢測視頻幀只有跌倒過程一類運動,但是在實際監控視頻中往往會有其他的日常運動、類跌倒運動干擾跌倒檢測,這些日常活動和類跌倒運動對于跌倒檢測任務而言屬于噪聲運動。為了驗證本文算法在有噪聲運動下的準確率和誤判率,選取六種常見的噪聲運動:日常運動(行走、上樓、下樓),類跌倒運動(彎腰撿東西、坐下起立、蹲下起立)進行了相關實驗。

本文首先從Le2i數據集中選取一段120 幀的跌倒視頻序列;然后由3 名志愿者依次完成上述6 種噪聲運動,共得到18個噪聲運動視頻幀;分別從18 個噪聲運動視頻幀中選取有代表性的30 幀噪聲幀,將選取的18 種噪聲運動視頻幀分別與Le2i 選取的120 幀跌倒運動混合,共得到18 組帶有噪聲幀的混合數據,每組混合數據的總幀數是150幀。表3為未加入噪聲幀與加入噪聲干擾幀的對比實驗結果。由實驗結果可知,加入日常運動干擾噪聲幀后,準確率并沒有受到太大影響;但是誤判率增加,特別是對于混入上下樓梯、彎腰撿東西等噪聲尤為明顯,彎腰撿東西的三次實驗中有兩次誤判率達到5.4%;噪聲干擾檢測平均準確率為97.1%,誤判率為3.25%,相比無噪聲干擾的準確率與誤判率都有所下降,但檢測結果依然能夠滿足老人跌倒檢測的需要。

表3 噪聲干擾對比實驗Tab.3 Comparison experiment of noise interference

4 結語

本文提出了一種融合運動特征的CNN 跌倒檢測方法,首先利用改進的YOLOv3 進行人體目標提取,有效解決傳統前背景分離方法對視頻幀中靜止目標產生的目標追蹤消失、目標混淆等問題;接著分析了人體運動特征,并將人體運動特征融入CNN,與不同的跌倒檢測方案進行了對比實驗,并且在光照、混合日常運動干擾下進行了實驗。實驗結果表明,本文提出的融合人體運動特征的CNN 檢測方法對人體跌倒行為的判斷具有較高的準確率,且對光照影響、日常常見的噪聲干擾運動具有較高的魯棒性。

目前,本文實驗只是針對已經錄制好的視頻進行檢測,而且檢測背景環境比較簡單,在實際檢測中人體的運動狀態千變萬化更為復雜,下一步的工作是把本文的方法移植到NVIDIA 嵌入式板卡Jetson Nano中,分析其在實際情況下的檢測結果,并進行優化改進。