深度學習下的視覺SLAM 回環檢測及其算法

張 凱,陽 杰

(西安工程大學電子信息學院,西安710600)

1 引 言

隨著科學技術發展,機器人越來越受到關注。機器人給人們的生產生活帶來便利,比如餐廳機器人、掃地機器人等。同步定位與地圖構建(SLAM)在機器人的使用中發揮著重要的作用。現代計算性能不斷提升,傳感器越來越多樣化和精密化。SLAM 系統的傳感器大多使用攝像頭,比如RGBD 相機、雙目攝像頭、單目攝像頭等。系統又可分為傳感器數據、視覺里程計、建圖、后端優化、回環檢測等部分,通過視覺圖像信息感知周圍環境。回環檢測使機器人對曾經去過的位置能夠準確識別,解決了位姿漂移問題。后端優化的作用則是消除噪聲對建圖、位姿估計的影響,同時,以前端視覺里程計來計算姿態變化。在視覺SLAM 系統中,后端優化收斂會出現偏差,反映為建圖中的漂移。對此,可采用回環檢測模塊將累計誤差消除。深度學習的發展也為機器人更高層次的回環檢測提供可能。

2 深度學習與回環檢測方法

近年來,在計算機視覺領域中,深度學習方法廣受關注,發展飛速,對于圖像分割、圖像檢測、圖像分類等都有重要的促進。深度學習假設不同因子相互作用,分為多個層次,抽象程度不同。這一過程的結構通過每一層的規模、不同層數來反映。從機器學習中的分散表示,產生深度學習[1],它是從數據中自動通過學習獲取的。

傳統模式識別,是依據人為經驗設計,因此對于整個算法系統來說,人工特征選擇決定其運行質量。傳統研究的重點,就在于發掘好的特征提取算法,往往需要研究人員耗費較長的時間來研究特征提取算法[2-3]。而深度學習使用大量的訓練數據,多隱層的機器學習模型,變換逐層特征,形成新特征空間,從中提取高層次特征。深度學習使預測、分類的正確率有效提升。將深度學習應用于計算機視覺領域,對目標便可用多種方式來表示。若目標是一副圖像,用表示向量反映每個像素的灰度值,或用抽象的特定線條、邊緣等,準確獲得高層次的特征。

傳統的回環檢測方法分為兩種。一種是以視覺圖像為基礎,以場景識別的問題代替回環檢測問題,根據幀間相似性進行回環判斷。此法在21 世紀初被提出,目前是視覺SLAM 領域的研究重點。場景影像數據利用前端攝像頭獲取,圖像間的相似性計算通過計算機視覺方法,對回環進行判斷[4-5]。另一種是以視覺里程計為基礎,假設相機回歸之前位置,通過幾何關系來判斷是否構成回環。但這種方法存在偏移誤差,導致較低的判斷邏輯準確性。

圖像間的相似性如何計算,是基于視覺圖像方法的核心問題。目前常用的是標定人工設計的關鍵點,計算特征描述子相似度。回環檢測不管是局部特征提取,或者全局特征提取,都依據人為經驗[6]。這也決定了季節變換、光照變化等客觀環境因素都會降低準確率。對于實際場景劇烈變化的圖像,存在一系列問題,比如旋轉不變性較差、視覺單詞無法匹配等。

3 基于深度學習的回環檢測算法

3.1 基于VGG-19 圖像特征向量集構造

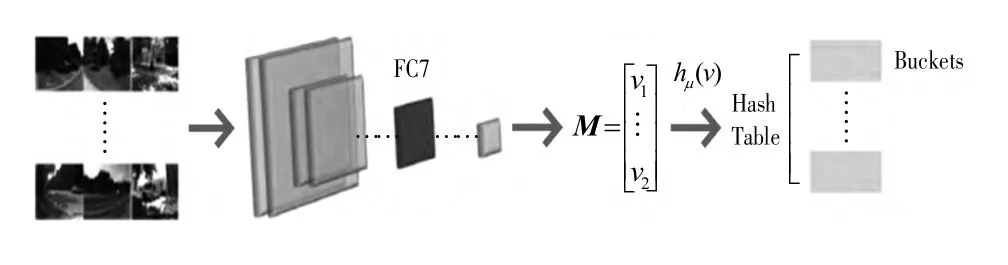

研究利用深度學習,提出視覺SLAM 的回環檢測算法。系統基于局部敏感哈希算法的快速回環檢測,以及基于卷積神經網絡VGG-19 的圖像特征向量集所構建,總體方案如圖1 所示。

圖1 系統總體方案

在出現角度、光照變化時,人工設計特征提取算法的準確率降低,因此使用VGG-19 提取圖像集的整體特征,同時構造對應特征向量矩陣。特征向量在高緯度時,對計算性能要求高,快速檢測回環無法實現[7]。故此采用降維聚類處理特征向量矩陣,應用基于余弦距離的LSH 算法,提高識別速度。

提取圖像特征提取時,使用算法不同,最終回環檢測的效果也會不同。卷積神經網絡VGG-19 的可操作性強,特征表述能力高,能夠有效滿足圖像特征提取的需求[8]。直接使用預訓練VGG-19 處理圖像任務能獲得較高增益。

圖像部分特征應用大卷積核會出現提取困難的問題。對于常見的大卷積核,VGG-19 使用小卷積核代替,為3×3。使用更多的小卷積核,有利于更準確地辨別特征,也會更加精確地描述圖像的細節特征。因此對圖像特征提取的網絡結構選用預訓練的卷積神經網絡VGG-19。

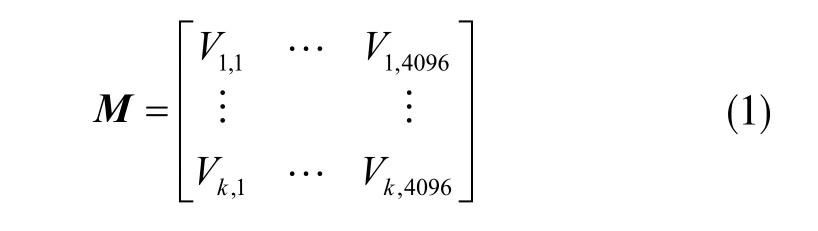

VGG-19 有3 個全連接層,5 個卷積層模塊。不同中間層的圖像特征效果如圖2。可見,FC7 層特征向量維度適中,可以較好地區分圖像。因此圖像特征表示選用FC7 層輸出向量。Conv1 層提取特征比較粗糙,而Conv3 層維度過高,又會影響后續的運算。VGG-19 的輸出結構變化,輸出結果為4096 維的圖像特征向量。為加快提取圖像特征,在此調整VGG-19 的BATCH。一次性輸入k 張圖像,向FC7 層前向傳播,直接輸出特征矩陣M:

圖2 VGG-19 不同中間層圖像特征效果

3.2 基于余弦距離的局部敏感哈希算法

與一般的哈希算法不同,局部敏感哈希是通過特定的Hash 函數,將高維空間內相似度高的數據,映射為同一個Hash 值,在聚類搜索、圖像和視頻檢索、網頁去重等場合多有應用。局部敏感哈希屬于最近鄰查詢算法,使高維空間數據向低維映射。

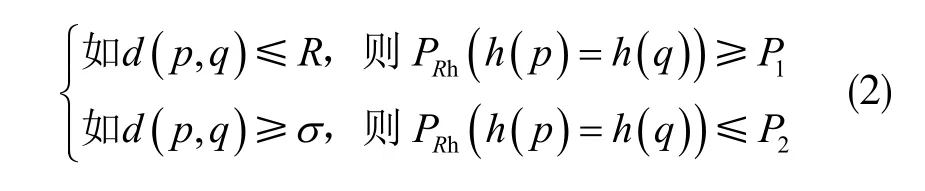

定義LSH 函數簇F= {h :M→S },在度量空間內M=(M,d)。定義距離閾值σ>1,R>1。p,q∈M,向量之間的度量表示為d(p,q)。概率表示為PRh。對于任意p,q,有:

如果P1>P2,稱F 是(R,σR,P1,P2)敏感的。不同的LSH 函數簇對應不同的度量方式。在回環檢測的情況下,應用以余弦距離為基礎的LSH 函數簇,可以使匹配所需的查詢時間明顯減少。LSH 函數hμ以余弦距離度量為基礎,表示為:

3.3 基于LSH 算法的回環檢測策略

若直接使用以余弦距離為基礎的LSH 函數構造Hash 表,會有聚類區分度不夠、待匹配向量查詢范圍窄等問題。增加False Negative 和False Positive出現機率。此時可使用“OR”和“AND”策略,調整P1和P2,以提高回環檢測的性能及算法聚類準確性。

“OR”策略是:只要有任意的hn(v1)=hn(v2){n=1,2,...,l}存在于函數簇F={h1,h2,...,hl}中,就會出現h(v1)=h(v2)。增加以后,有t 個Hash 表,使P1和P2成為1-(1-P1)t和1-(1-P2)t,False Negative 因此減少。

“AND”策略是:出現h(v1)=h(v2),只有h(v1)=h(v2){n=1,2,...,l}時,增加超平面,使P1和P2成為P1t和P2t,以減少False Positive 的情況。

3.4 算法時間復雜度分析

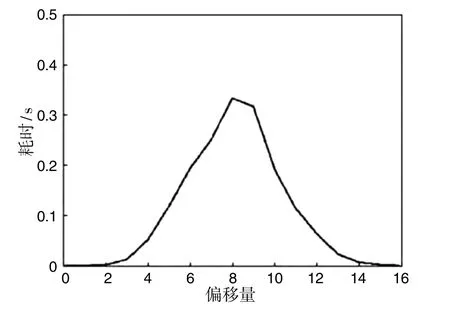

隨著超平面的增加,Hash 表的規模表現為線性增長態勢,如圖3 所示;隨著偏移量增加,匹配耗時顯示為正態分布狀態,如圖4 所示。

圖3 Hash 表規模變化趨勢

圖4 匹配耗時分布情況

圖中,所有特征向量間的余弦距離計算,單純應用暴力匹配方式,復雜度為O(n2)。特征向量矩陣的向量個數為n。構造Hash 表算法時間復雜度為O(l×n)。集合V 決定時間復雜度,近似為O(1),復雜度減少,超平面個數為l。

4 實驗結果與分析

4.1 實驗數據集

實驗使用的視覺SLAM 回環檢測數據集,選取的是牛津大學機器人團隊收集的City centre 與New college。在室外環境中,移動機器人通過攝像頭,采集的2474 與2146 張左右對圖像[9-10]。圖像尺寸640×480 像素,格式為jpg。研究人員可根據回環真值,對實驗結果進行比較。根據左右攝像頭采集的圖像,對數據集進行重新分割。右攝像頭采集的所有圖像,為New college right,1073 張。左攝像頭的為New college left,1073 張。數據集City centre 同樣以此分割,為右攝像頭的City centre right,1237 張,以及左攝像頭的City centre left,1237 張。

4.2 回環檢測準確性比較

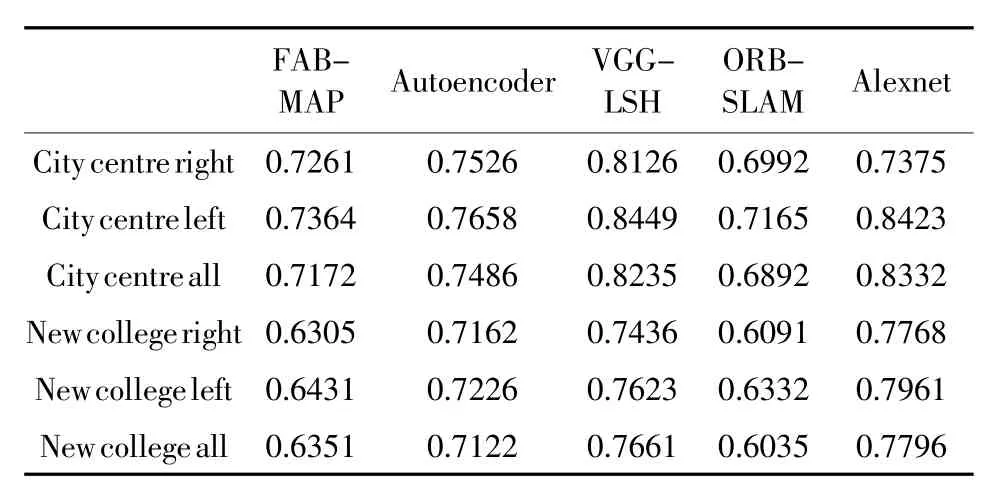

使用平均準確率,以及準確率-召回率曲線,評價算法的性能。在數據集City centre 與New college中,設定8 位偏移量,16 個超平面,效果最佳。偏移量、超平面數量逐漸減少,算法性能隨之下降。相比數據集New college,算法對于數據集City centre 的回環檢測性能更佳。其原因在于數據集City centre中的人和車輛更多,模型具有更高的識別能力。比較基于Autoencoder 的回環檢測,再基于Alexnet 的回環檢測比較平均準確率。相比傳統的人工設計特征提取算法,基于深度學習的Alexnet 與Autoencoder的平均準確率更高。因此,對于圖像場景的識別,基于深度學習的方法能力更強,受光照的影響更少。算法在數據集上的平均準確率比較結果歸納如表1。

表1 算法在各數據集上的平均準確率

4.3 時間性能比較

為達到機器人的同步定位與建圖,視覺SLAM 系統要求回環檢測模塊具有足夠強的實時性。實驗隨機抽取2000 張圖像,探討算法的時間性能。經比較,Alexnet 耗時為0.014 s;ORB-SLAM 為1.02 s;VGG-LSH 為0.012 s;Autoencoder 為0.12 s;FAB-MAP為1.75 s。再以VGG-19 為基礎,構造圖像特征矩陣,比較LSH 算法及暴力匹配降維后的耗時,在City centre all 中,LSH 算法匹配耗時0.87 s,暴力匹配耗時2.65 s;在New college all 中,LSH 算法匹配耗時0.84 s,暴力匹配耗時2.52 s。

可見,LSH 算法的加入,會使檢測回環的時間性能明顯提升。

5 結 束 語

深度學習方法相比傳統方法具有明顯優勢,在SLAM 領域中有較大的應用前景。目前,深度學習在視覺SLAM 系統中的應用尚處于初級階段。合理利用深度學習中的卷積神經網絡,能在計算機視覺領域中獲得優良的效果。將LSH 算法與卷積神經網絡相結合而建立的視覺SLAM 回環檢測算法,可有效減少天氣、光照等變化的影響,提升檢測的準確率,提高時間性能,滿足系統的實時性要求。