基于DNN與規(guī)則學(xué)習(xí)的機器翻譯算法研究

陶媛媛,陶 丹

(1.西安交通大學(xué)城市學(xué)院,西安 710000; 2.西安市曲江第一中學(xué),西安 710000)

0 引言

隨著翻譯需求的增加,信息技術(shù)與語言學(xué)理論以及人工智能研究中自然語言理解模型的蓬勃發(fā)展,使得機器翻譯逐漸受到了各領(lǐng)域?qū)I(yè)技術(shù)人員矚目[1-3]。Liu等[1]報道并系統(tǒng)地探索使用針對統(tǒng)計機器翻譯(SMT)的深度(多層)神經(jīng)網(wǎng)絡(luò)(DNN)學(xué)習(xí)新功能的可能性。為了解決深度信念網(wǎng)絡(luò)中特征學(xué)習(xí)的輸入原始特征太簡單,每個短語對的4個短語特征有限的問題,作者將一些簡單但有效的短語特征作為新的DNN特征學(xué)習(xí)的輸入特征進行了調(diào)整和擴展,并且這些特征已顯示出SMT的顯著改進,例如短語對相似性等。此外,在傳統(tǒng)SMT和神經(jīng)機器翻譯(NMT)中,學(xué)習(xí)源語言的連續(xù)空間表示法已經(jīng)引起了廣泛的關(guān)注。目前已經(jīng)提出了各種模型,主要是基于神經(jīng)網(wǎng)絡(luò)的模型來表示源句子,主要用作編碼器-解碼器框架中的編碼器部分。在解碼過程中僅對源句子的“相關(guān)”部分進行編碼,Devlin等[4]提出的神經(jīng)網(wǎng)絡(luò)聯(lián)合模型(NNJM),該模型擴展了n元語法目標語言模型,通過額外增加源句的固定長度窗口,實現(xiàn)統(tǒng)計機器翻譯的最新性能。實驗結(jié)果表明,與比較模型算法相比,基于深度神經(jīng)網(wǎng)絡(luò)與規(guī)則學(xué)習(xí)的統(tǒng)計機器翻譯模型具有更好的效果,更快的收斂速度和更高的可靠性。深度神經(jīng)網(wǎng)絡(luò)作為一種新的機器學(xué)習(xí)方法,可以自動學(xué)習(xí)抽象特征表示并在輸入和輸出信號之間建立復(fù)雜的映射關(guān)[5-6]。

本文提出了一種新的卷積架構(gòu),以動態(tài)編碼源語言中的相關(guān)信息。該模型涵蓋了整個源句子,可以在目標語言的信息指導(dǎo)下有效地找到并適當?shù)乜偨Y(jié)相關(guān)部分。利用解碼過程中的引導(dǎo)信號,經(jīng)過特殊設(shè)計的卷積體系結(jié)構(gòu)可以查明與預(yù)測目標單詞相關(guān)的源語句部分,并將其與整個源語句的上下文融合在一起以形成統(tǒng)一的表示形式。將之與目標詞一起饋入深度神經(jīng)網(wǎng)絡(luò)(DNN)。聯(lián)合模型的兩個變體tagCNN和inCNN,并在解碼過程中使用了不同的指導(dǎo)信號。聯(lián)合模型集成到最新的依存關(guān)系的字符串翻譯系統(tǒng)中用以評估其有效性,為統(tǒng)計機器翻譯研究提供了新的切入點。

1 方法論

1.1 聯(lián)合語言模型

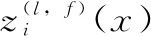

CNN編碼器的聯(lián)合模型在圖1中進行了說明,其中包括CNN編碼器,即tagCNN或inCNN,以表示源語句中的信息,以及基于NN的模型CNN編碼器的表示和目標句子中的歷史單詞作為輸入來預(yù)測下一個單詞。

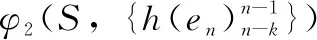

在聯(lián)合語言模型中,en表示目標詞的概率,給定前k個目標詞{en-k,…,en-1}和CNN編碼器對源句子S的表示為:

圖1 基于CNN編碼器的聯(lián)合LM的示意圖

例如圖1的示例中,翻譯的中文句子如下。

中文: 智利 舉行 國會 與 總統(tǒng) 選舉;

Pinyin: ZhiLi JuXing GuoHui Yu ZongTong XuanJu。

轉(zhuǎn)換成英語,在評估目標語言順序“holds parliament and presidential”時,以“holds parliament and”作為進行詞(假設(shè)為4-gram LM),而“presidential”的從屬源詞1為“zongtong”(由單詞對齊方式確定),tagCNN產(chǎn)生φ1(S,{4})(“ Zongongong”的索引為4),而inCNN產(chǎn)生φ2(S,{h(holds parliament and)})。之后,DNN組件將“ holds parliament and”和φ1或者φ2作為輸入,以給出下一個單詞的條件概率,例如p(“presidential”|φ1|2,{holds,parliment,and})。

1.2 卷積模型

1.2.1 通用CNN編碼器

從卷積編碼器的通用架構(gòu)開始[7-8],然后繼續(xù)將tagCNN和inCNN作為兩個擴展。

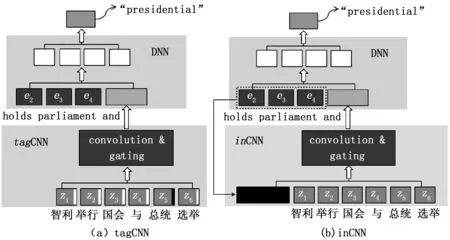

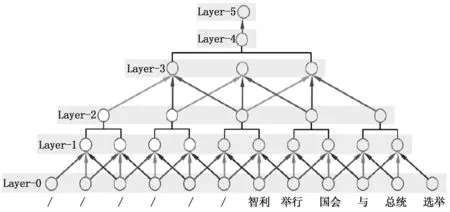

通用CNN編碼器的基本架構(gòu)如圖2所示,其固定架構(gòu)由如下6層組成。

第0層:輸入層,采用嵌入矢量形式的單詞。工作中將句子的最大長度設(shè)置為40個單詞。 對于短于此的句子,常在句子開頭放置零填充。

第1層:第0層之后的卷積層,窗口大小為3。引導(dǎo)信號被注入到該層中作為“引導(dǎo)版本”。

第2層:第1層之后的本地門控層,僅對大小為2的非相鄰窗口中的特征圖進行加權(quán)求和。

第3層:在第2層之后的卷積層,開始執(zhí)行另一個卷積,窗口大小為 3。

第4層:在第3層上對功能圖執(zhí)行全局選通。

第5層:完全連接的權(quán)重,將第4層的輸出映射到該層作為最終表示。

如圖2所示,第1層中的卷積在單詞的滑動窗口(寬度k1)上運行,并且窗口的類似定義會延續(xù)到更高的層。形式上,對于源句子輸入x={x1,…,xN}第L層上的f型特征映射的卷積單位為式(1):

(1)

圖2 CNN編碼器示意圖

1.2.2 門控

相關(guān)文獻中CNN采用簡單的卷積池策略[9],其中“融合”決策是基于要素圖的值。在本質(zhì)上而言,是一種軟模板匹配,適用于諸如分類的任務(wù),但對于保持卷積的合成功能作用不顯著,然而,上述功能對于句子建模至關(guān)重要。本文使用單獨的門控單元從卷積中釋放得分函數(shù)的占空比,并使其更加注重于句子的合成。

采用兩種類型的門控:(1)對于第2層,在第1層卷積的特征圖上采用不重疊窗口的局部門控,以表示段;(2)對于第4層卷積,采用全局選通融合所有片段以實現(xiàn)全局表示。 并發(fā)現(xiàn),這種選通策略可以顯著改善tagCNN和inCNN的池化性能。

1)本地門控:在第1層上,對于每個門控窗口,首先在第0層上找到其原始輸入(卷積之前),然后將它們合并為門控網(wǎng)絡(luò)的輸入。 例如,對于兩個窗口:第0層上的單詞(3,4,5)和單詞(4,5,6),使用由嵌入單詞(3,4,5,6)組成的串聯(lián)矢量作為輸入本地門控網(wǎng)絡(luò)的輸入以確定兩個窗口(在第1層上)的卷積結(jié)果的權(quán)重,而加權(quán)和是第2層的輸出。

(2)

1.2.3 CNN編碼器訓(xùn)練

CNN編碼器訓(xùn)練過程與神經(jīng)網(wǎng)絡(luò)語言模型的訓(xùn)練過程相同,除了使用并行語料庫而不是單語語料庫外,力求最大程度地提高訓(xùn)練樣本的對數(shù)似然性,并為平行語料庫中的每個目標單詞提供一個樣本[10]。優(yōu)化是通過常規(guī)的反向傳播來實現(xiàn)的,該實現(xiàn)是使用小批量的隨機梯度下降實現(xiàn)的。

1.2.4 inCNN

2 聯(lián)合模型解碼

本文的聯(lián)合模型純粹是詞匯化的,因此可以作為功能集成到任何SMT解碼器中[11-12]。對于分層SMT解碼器,采用了Devlin等人提出的集成方法。正如從用于執(zhí)行分層解碼的n-gram語言模型繼承的那樣,應(yīng)將每個組成部分中最左邊和最右邊的n-1個單詞存儲在狀態(tài)空間中。通過擴展狀態(tài)空間,以包括這些邊詞中每個詞的關(guān)聯(lián)源詞的索引。對于對齊的目標詞,將其對齊的源詞作為其關(guān)聯(lián)的源詞。對于未對齊的單詞,同樣使用Devlin等人采用的從屬關(guān)系啟發(fā)式方法。在本文中,將聯(lián)合模型集成到最新的依賴項到字符串機器翻譯解碼器中,作為案例研究來測試提出的方法的有效性。本節(jié)簡要描述依賴項到字符串的轉(zhuǎn)換模型與MT系統(tǒng)。

本文使用一般的對數(shù)線性框架。令d為將源依賴關(guān)系樹轉(zhuǎn)換為目標字符串e的推導(dǎo)。d的概率定義為式(2):

(2)

其中:φi是在導(dǎo)數(shù)上定義的特征,λi是相應(yīng)的權(quán)重。其中解碼器包含以下功能。

1)基準功能:

HDR規(guī)則的翻譯概率P(t|s)和P(s|t);HDR規(guī)則的詞法翻譯概率PLEX(t|s)和PLEX(s|t);偽翻譯規(guī)則懲罰exp(-1);目標詞懲罰exp(|e|);n元語法模型PLM(e)。

2)提出功能:

n-gram tagCNN聯(lián)合語言模型PLEX(e);CNN聯(lián)合語言模型PLEX(e)中的n-gram。

3 實際應(yīng)用

3.1 數(shù)據(jù)獲取與預(yù)處理

1)數(shù)據(jù)獲取:本文的培訓(xùn)數(shù)據(jù)是從LDC數(shù)據(jù)中提取的[13]。僅保留源對部分長度不超過40個單詞的句子對,該句子對覆蓋了90%以上的句子。雙語訓(xùn)練數(shù)據(jù)由221 k句子對組成,其中包含500萬個中文單詞和680萬個英文單詞。經(jīng)過長度限制過濾后,開發(fā)集為NIST MT03(795個句子),測試集為MT04(1499個句子)和MT05(917個句子)。

2)預(yù)處理:使用GIZA ++在語料庫上使用“增長-確定-最終和”平衡策略[14],在兩個方向上獲得單詞對齊。并采用SRI語言建模工具包在英語Gigaword語料庫(3.06億個單詞)的新華語部分上訓(xùn)練了經(jīng)過改進的Kneser-Ney平滑處理的4-gram語言模型。隨后使用Stanford Parser將中文句子解析為映射依賴樹。

4)指標:本文使用不區(qū)分大小寫的4-gram NIST BLEU3作為評估指標,在提出的模型和兩個基準之間進行帶有標志檢驗的統(tǒng)計學(xué)顯著性檢驗。

3.2 設(shè)置模型比較

將tagCNN和inCNN聯(lián)合語言模型用作依賴項到字符串基線系統(tǒng)(Dep2Str)的附加解碼功能,并將它們與具有11個源上下文詞的神經(jīng)網(wǎng)絡(luò)聯(lián)合模型進行比較。除了全局設(shè)置外,還使用具有默認配置的開源工具包。由于本文提出的tagCNN和inCNN模型是從源到目標和從左到右的(在目標側(cè)),因此,僅采用源到目標和從左到右的NNJM類型進行比較。以下將這種類型的NNJM稱為BBN-JM。盡管Devlin等人中的BBN-JM最初是在基于分層短語的SMT和字符串到依賴關(guān)系SMT中進行測試的,但它可以很容易地集成到Dep2Str中。

3.3 實驗結(jié)果與分析

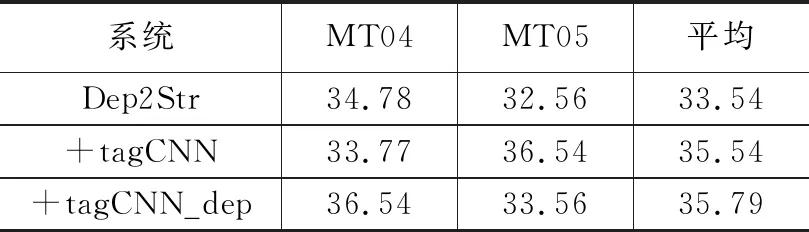

表1給出了不同模型的主要結(jié)果。在進行更詳細的比較之前,可獲得以下信息:

1)基線Dep2Str系統(tǒng)的BLEU比基于開源短語的系統(tǒng)Moses高0.5+。

2)與Dep2Str相比,BBN-JM的得分約為+0.92 BLEU。

從表1可以明顯看出,在相同設(shè)置下,tagCNN和inCNN在Dep2Str基線上的改善幅度為+1.28和+1.75 BLEU,在相同設(shè)置下,其BBN-JM分別優(yōu)于NIST MT04和MT05的平均值+0.36和+0.83 BLEU。這些表明tagCNN和inCNN可以在解碼中分別提供區(qū)分性信息。值得注意的是,inCNN似乎比單詞對齊(GIZA ++)建議的附屬單詞更具信息性。因此,推測這是由于以下兩個事實才成立的:

1)inCNN避免了在已經(jīng)學(xué)習(xí)的單詞對齊方式中錯誤和偽影響的傳播;

2)inCNN中的指導(dǎo)信號提供補充信息以評估翻譯。

此外,當將tagCNN和inCNN都用于解碼時,可以進一步在BBN-JM上的獲勝余量提高到+1.08 BLEU點。

通用CNN還能在BLEU上獲得類似于BBN-JM的增益,因為,通用CNN編碼整個句子,并且表示形式通常應(yīng)遠離聯(lián)合語言模型的最佳表示形式。因此,可能是由于CNN對該句子產(chǎn)生了相當有益的總結(jié),這彌補了其在分辨率和源詞相關(guān)部分上的某些損失。換言之,tagCNN和inCNN中的引導(dǎo)信號對于基于CNN的編碼器的功能至關(guān)重要,這可以從通用CNN,tagCNN和inCNN獲得的BLEU得分之間的差異中看出。對于有了來自已經(jīng)習(xí)得的單詞對齊的信號,tagCNN可以比其通用對應(yīng)詞獲得+0.25 BLEU,而對于inCNN,來自目標單詞的引導(dǎo)信號,其增益更顯著為+0.72 BLEU。

tagCNN可以進一步受益于在輸入中用源語言編碼的依賴關(guān)系結(jié)構(gòu)。依賴項首詞可用于進一步完善tagCNN模型。在tagCNN中,在輸入層中的單詞嵌入后附加一個標記位(0或1)作為它們是否隸屬源詞的標記。為了合并依賴頭信息,本文擴展了標記規(guī)則,為原始tagCNN的詞嵌入添加了另一個標記位(0或1),以指示它是否是附屬詞的依賴頭的一部分。例如,如果xi是相關(guān)源詞的嵌入,而xj是詞xi的依賴頭,則tagCNN的擴展輸入將包含,式(3):

xi(AFF,NON-HEAD)=[xiT,1,0]T

xj(NON-AFF,HEAD)= [xjT,0,1]T

(3)

若從屬源詞是句子的詞根,則由于詞根沒有依賴項頭,因此本文僅將0作為第二個標記位附加。從表2中可以看出,借助依賴項頭信息能夠在兩個測試集上將tagCNN平均提高+0.23 BLEU點。

表2 tagCNN模型的BLEU-4分數(shù)(%)

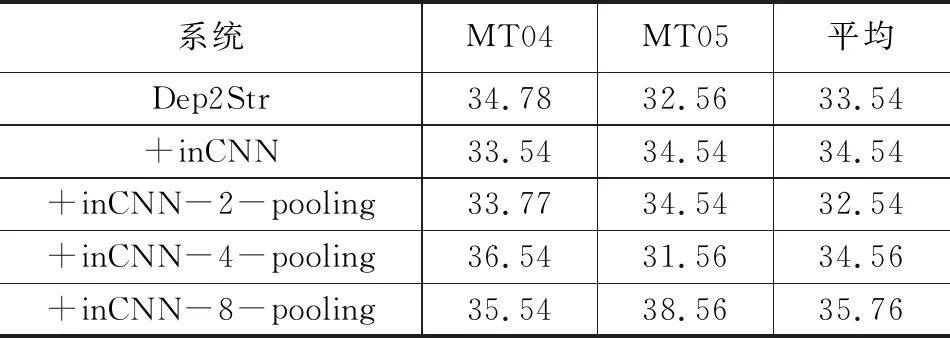

以inCNN模型的比較為例,研究了門控策略可在多大程度上改善最大池化的翻譯性能。 對于使用最大池的inCNN實施,本文用大小為2(簡稱2池)的最大池替換本地門(第2層),用k個最大池(“第4層”)替換全局門(“第4層”),其中k為{2; 4; 8},然后將k池輸出的平均值用作第5層的最終輸入。這樣可以確保第5層的輸入維與具有門控的架構(gòu)相同。從表3可以看出,門控策略可以比最大合并提高0.34,0.71 BLEU點的翻譯性能。此外還發(fā)現(xiàn)8池收益率性能要優(yōu)于2池。所以推測這是因為翻譯中有用的相關(guān)部分主要集中在源句子的幾個單詞上,可以通過較大的庫大小更好地提取這些單詞。

表3 使用門控策略和k個最大池實施的inCNN>模型的BLEU-4分數(shù)(%)

4 結(jié)束語

本文提出了卷積架構(gòu),以獲取整個源句的引導(dǎo)表示,該卷積架構(gòu)可用于增強n-gram目標語言模型。利用來自目標端的不同指導(dǎo)信號,并設(shè)計了tagCNN和inCNN,兩者都通過增強字符串對依賴關(guān)系的SMT進行了測試,其SMT比基線高+2.0 BLEU點。所提出的模型分別優(yōu)于NIST MT04和MT05的平均值+0.36,+0.83 BLEU,比傳統(tǒng)DNN機器翻譯平均提高了+1.08 BLEU點。該模型為統(tǒng)計機器翻譯方法研究提供了借鑒。