基于注意力機制的商家招牌分類研究

李 蘭,鄭雨薇,魏少瑋,胡克勇

(1.青島理工大學 信息與控制工程學院,山東 青島 266520;2.西安電子科技大學 人工智能學院,西安 710071)

0 概述

商家招牌作為商家標志,其識別和分類問題雖然耗費大量時間及人力,但是對于傳統營銷的網絡涉入、消費者的線上線下互動、商業信息的挖掘與電子商務數據庫的管理等實際應用場景有重要作用[6-8]。本文以在自然環境下拍攝的商家招牌圖像為研究對象,采用基于卷積神經網絡(Convolutional Neural Network,CNN)的深度學習算法對商家招牌進行分類,利用卷積塊注意力模塊(Convolutional Block Attention Module,CBAM)改進現有網絡結構,并聯合使用余弦間隔損失函數對其進行訓練。

1 相關工作

根據使用的監督信息不同,細粒度圖像分類可分為基于強監督的細粒度圖像分類與基于弱監督的細粒度圖像分類。其中,基于強監督的細粒度圖像分類方法主要利用如Part-RCNN[9]的目標檢測思想,先在圖像中檢測出目標的所在位置,再檢測出目標中有區分性區域的位置,接下來將目標圖像(即前景)以及具有區分性的目標區域塊同時發送至深度卷積網絡中進行分類。然而,基于強監督信息的細粒度圖像分類需依賴更多的人工標注信息,如目標物體的邊界框信息和關鍵點信息,且在實際應用中,這些標注信息的獲取耗時耗力,使得其應用受到限制。因此,研究人員開始關注基于弱監督信息的細粒度圖像分類方法,該方法僅需使用標簽信息,而無需額外的標注信息,且通常采用如AlexNet[10]、VGG[11]、GoogleNet[12]與ResNet[13]等常見的深度卷積網絡直接對圖像細粒度進行分類。由于上述分類網絡具有較強的特征表示能力,因此在常規圖像分類中能夠取得較好的效果。然而在細粒度分類中,不同類別之間的差異通常十分細微,直接將常規圖像分類網絡應用于細粒度圖像進行分類時,效果并不理想。在文獻[14]提出的Mask-CNN 中,借助全連接神經網絡學習一個部件分割模型。該網絡對圖像進行精確的部件定位預測并將其分割出來,且經過3 個子網絡處理后,級聯得到整幅圖像的特征表示,以增強特征的表達能力。文獻[15]提出一種SWFV-CNN 模型,該模型利用CNN 選擇性地挑選出對于某些模式敏感的濾波器,并將濾波器作為初始化權重,從而訓練一個對任務更具判別性的模型。

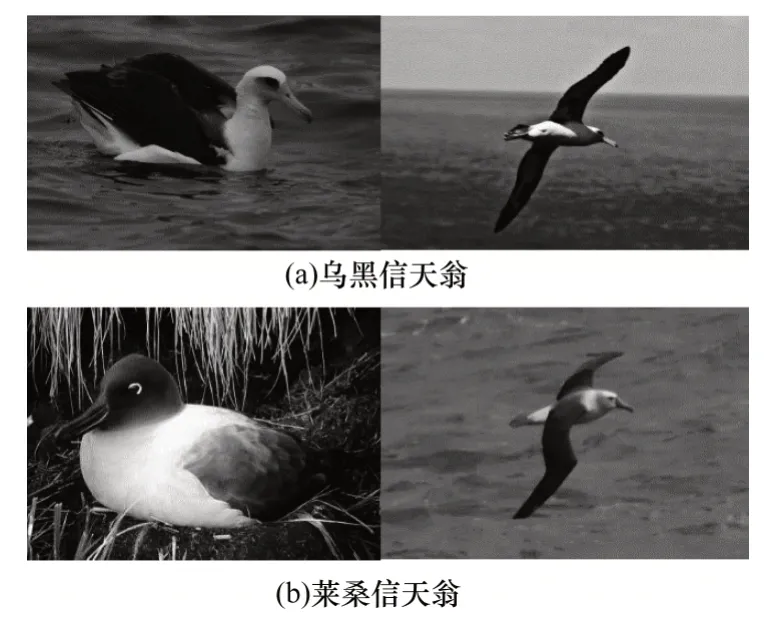

雖然基于弱監督信息的模型在細粒度圖像分類問題上已取得顯著效果,但是其特征表達能力仍需進一步增強。由于不同類別之間的差異更加細微,包含足夠區分度的信息往往只存在于很細微的局部區域中,如圖1 所示,因為烏黑信天翁和萊桑信天翁的區別僅在于鳥喙和腹部的顏色,所以在細粒度圖像分類問題中捕獲具有判別性的局部特征至關重要。

圖1 烏黑信天翁與萊桑信天翁對比Fig.1 Comparison between black albatross and lessonia albatross

現有研究通過引入一些不同的注意力機制模塊來學習更加具有判別性的局部特征。文獻[16]提出的雙線性CNN 模型較早引入了注意力機制思想,該模型利用2 個相同的CNN 分支關注不同區域的特征,通過向量外積的方式聚合2 個分支的特征,從而得到最終特征表示。然而這種方式需要同時訓練2 個CNN,且通過向量外積的方式匯聚特征信息會導致最終得到的特征向量維度呈指數級增長,因此造成模型參數量增大,且存在冗余的問題。文獻[17]提出利用殘差注意力網絡(Residual Attention Network,RAN)解決大規模圖像分類任務。該網絡采用一個編解碼結構的注意力模塊,利用注意力機制對特征圖進行精細化學習,使得網絡的表現性能良好,且對輸入的噪聲魯棒性更強。RAN通過編解碼方式對中間特征圖進行處理,直接得到一個三維注意圖。然而,本文使用的CBAM 不是直接計算三維注意圖,而是對三維注意圖進行解耦合,分別計算空間注意力(Spatial Attention)及通道注意力(Channel Attention),這種分離注意力機制生成過程相比三維注意圖具有更小的參數量和計算量。CBAM 分別學習特征圖的通道注意力和空間注意力,通過對學習到的注意力與原特征圖進行加權,可強調關鍵局部特征,抑制無關特征,極大地增強特征的表達能力。與CBAM 類似,文獻[18]提出注意力機制SE(Squeeze-and-Excitation)模塊,該模塊使用全局平均池化層計算通道注意力,忽略了空間注意力。然而,空間注意力對于特征定位起重要作用,且在本文可視化分析實驗中驗證了該結論。

2 基于注意力機制的分類網絡

2.1 ResNet50 網絡結構

由于CNN 具有強大的特征表達能力,因此在計算機視覺任務中應用較為廣泛。當網絡層數加深時,存在一個難以解決的梯度消失問題。本文采用文獻[14]提出的ResNet50 網絡模型作為基線模型,該模型通過使用跨層連接極大緩解了深度網絡訓練中的梯度消失問題。

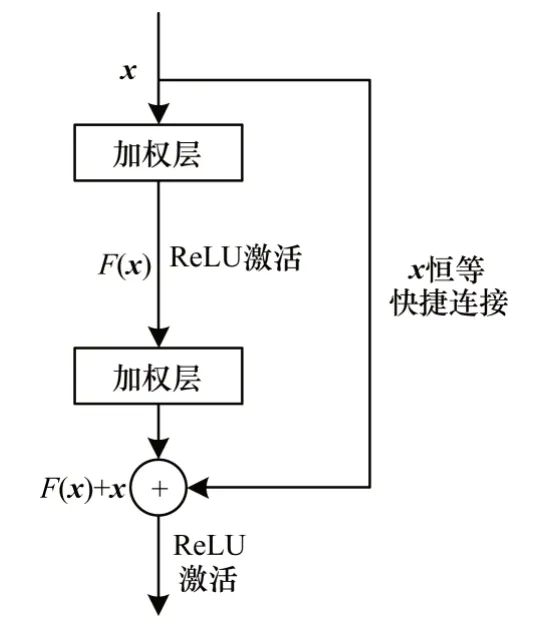

ResNet50 網絡采用一種重要的殘差模塊,其結構如圖2 所示。其中,殘差模塊的輸入為x,期望輸出的潛在映射為H(x),則殘差定義為F(x)=H(x)-x。如果利用網絡直接學習期望輸出的潛在映射H(x)存在困難,則ResNet 50 網絡不再學習一個完整的輸出,而是學習H(x)和恒等映射x之間的差值,即殘差F(x),最終僅需對H(x)和x的元素進行加法運算即可得到期望輸出。圖2 所示的x恒等快捷連接表示跨層連接,這是一條從輸入直接到輸出的通路,在輸出之前將x與經過學習的殘差值F(x)相加,可得到期望映射結果H(x)。由于跨層連接的存在,梯度在往前傳播時,后一層的梯度信號可以無損傳遞到前一層,文獻[13]已經通過實驗驗證了學習殘差而非直接學習映射的優勢所在。

圖2 殘差模塊Fig.2 Residual module

2.2 基于卷積塊注意力模塊的ResNet50 網絡

人類的知覺系統中存在有重要作用的注意力機制,這使得人類在日常生活中處理視覺信息時僅需關注有用信息,不必在某一時刻處理整個場景信息[19]。研究人員受到人類處理視覺信息注意力機制的啟發,提出多種應用于計算機視覺的注意力機制模型。為關注重要的局部細節區域,并過濾掉不重要的局部信息,本文采用CBAM。CBAM 和其他注意力機制有相同的出發點,即關注重要的特征信息,過濾掉不重要的特征信息[20]。然而,以往研究提出的模型均是在所有維度上應用殘差注意力網絡[17]或者只是在某一特定維度上使用注意力機制SE 模塊[18]。CBAM 是依次使用通道注意力模塊和空間注意力模塊得到特征圖,因此模型可分別在通道和空間上學到“是什么”與“在哪里”。針對圖像識別和分類問題,這種協調通道信息和空間信息的方式可以關注到圖像間更加細微的局部差異,放大局部特征的代表性。

營改增的實施使得稅法稅率等發生了改變。該背景下財務、銷售、采購等部門應相互配合,整理各類合同,使其保持規范,對合同中的各類價格是否含稅具備清晰地認知,既要了解稅率,又要明確發票類型,并厘清與規定不符的發票引發的賠償責任,優先選擇一般納稅人作為供應商,最大程度爭取進項稅抵扣。采購過程中因涉及到供應商優惠問題,存在普通發票的情況。現實情況很難達到如此力度的優惠,酒店仍需供應商提供專用發票。

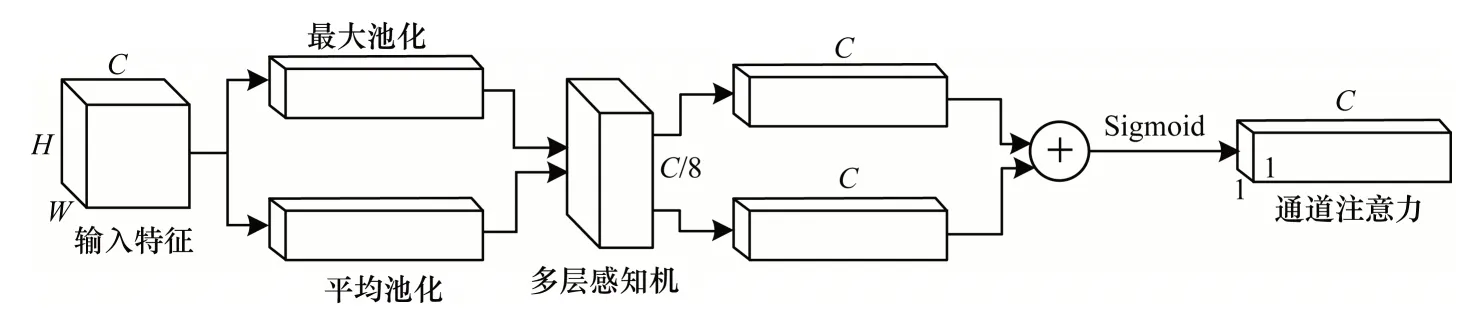

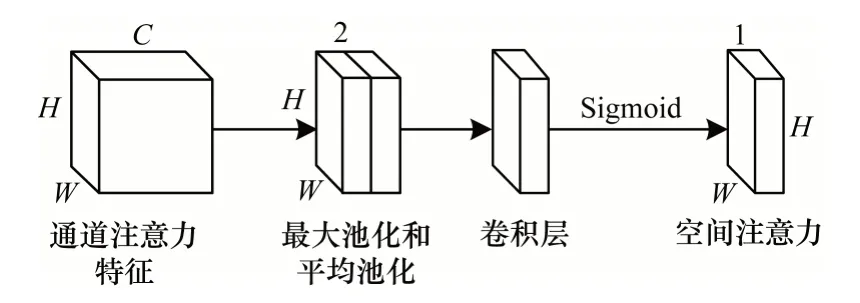

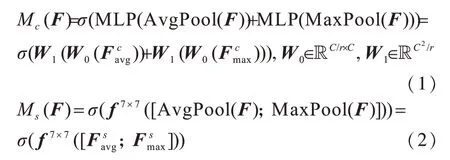

CBAM 的結構分為通道注意力模塊與空間注意力模塊,具體如圖3、圖4 所示,且其數學形式分別如式(1)、式(2)所示。

圖3 通道注意力模塊Fig.3 Channel attention module

圖4 空間注意力模塊Fig.4 Spatial attention module

由圖3 可知,通道注意力模塊先利用最大池化層和平均池化層分別匯聚空間信息,使特征圖變為2 個1×1×N的特征向量,再將2 個特征向量輸入包含一個隱藏層的多層感知機(共享參數)。接下來將2 個輸出的特征向量通過元素求和合并在一起,并經過Sigmoid 激活函數后得到最終通道注意力。通道注意力可以理解為通道的權重,且包含重要信息的通道權重大,包含不重要信息的通道權重小。將通道注意力特征向量以廣播的形式輸入到輸入圖像的每個通道上,即可得到需要輸出的通道注意力模塊特征圖。與SE 模塊利用全局平均池化學習通道注意力相比,CBAM 同時利用全局平均池化和全局最大池化學習通道注意力,且平均池化考慮特征圖中每個通道上的平均信息,而最大池化則考慮通道上的顯著性信息,通過將兩者相結合使得CBAM 學習到的特征更具有判別性。

空間注意力模塊是先在通道維度上使用最大池化和平均池化,然后將2 個匯集了通道信息的W×H×1 的特征圖串聯為一個W×H×2 的特征圖。再使用一個包含7×7×2×1 卷積核的卷積層進一步提取特征,此時的特征圖變為W×H×1。接下來經過Sigmoid 激活函數后得到空間注意力特征圖。空間注意力特征圖可以理解為一個通道上每個像素的權重,且包含重要信息的像素權重大,包含不重要信息的像素權重小。將空間注意力特征圖以廣播的形式輸入到開始輸入空間注意力模塊的特征圖上,即得到整個卷積注意力模塊的最終特征圖。由此可以看出,將通道注意力和空間注意力分開使用,可以從通道和空間2 個維度上關注到重要特征,并過濾掉不重要特征。CBAM 分別學習了通道注意力機制和空間注意力機制,通道注意力機制通過共享的全連接層實現,且由于池化層沒有引入可學習參數,從而大幅減小了使用注意力機制需要的參數量,使CBAM成為一個輕量級模塊,且其訓練過程更加高效。

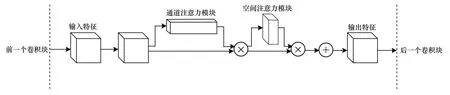

按照如圖5 所示的方式在每個殘差模塊中插入注意力機制,結果表明,采用在原來輸出的特征圖后先后插入通道注意力模塊與空間注意力模塊的方式效果最好。直觀解釋是,先使用通道注意力模塊強調了該特征是什么,然后使用空間注意力模塊強調了該特征位置在哪。此外,從圖5 可直觀看到,相比聯合計算通道注意力與空間注意力,本文使用的CBAM 分別計算通道注意力和空間注意力所需參數及計算量更小,可以忽略不計。因此,本文方法在達到良好效果的同時,并未造成參數量及計算量的增加。

圖5 殘差模塊中插入注意力機制流程Fig.5 Procedure of inserting the attention mechanism in the residual module

2.3 余弦間隔損失函數

在網絡的優化過程中,損失函數是不可忽略的部分。細粒度圖像分類屬于多分類問題,應用最廣泛的損失函數為Softmax 交叉熵損失函數。然而,傳統的Softmax 交叉熵損失函數僅關注于類間距離,忽略了類內方差,因此對于噪聲點和邊界點更敏感。

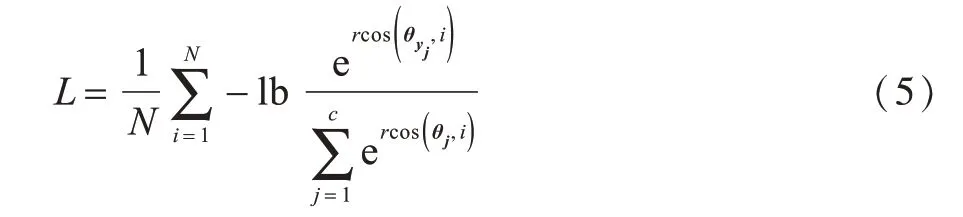

近年來,研究人員提出NSL(Normalized version of Softmax Loss)[21]、A-Softmax 損失函數[22]等基于Softmax 交叉熵損失的損失函數。其中,NSL 是對Softmax 交叉熵損失中的特征向量和權重向量進行正則化,而A-Softmax 是在NSL 的基礎上給特征向量和權重向量之間的夾角添加一個系數,從而達到增大類間間隔的目的。雖然上述損失函數的形式有所不同,但是它們的目的都是增大類間間隔、縮小類內方差。然而,這些損失函數仍存在不足之處,如它們可實現縮小類內方差,但其在增大類間間隔上仍達不到預期效果,不能實現更好的分類效果。此外,損失函數還存在優化困難的問題。因此,本文提出一種優化簡單且可充分增大類間間隔的余弦間隔損失函數。相比Softmax 交叉熵損失、NSL 和ASoftmax 損失函數,余弦間隔損失函數能更大程度地增大類間間距和縮小類內方差。傳統Softmax 交叉熵損失函數的數學描述如式(3)所示:

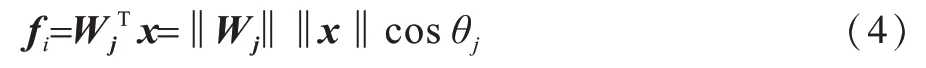

其中,給定輸入向量為xi,yi是其對應的標簽,N和C分別代表訓練樣本數和類別數。fi是最后一個分類層的輸出,表示為將偏置項設置為Bj=0,即可得到fj的表示形式,具體如式(4)所示:

其中,θj是Wj和x的夾角。

從式(4)可以看出,正則項和角度都對損失函數存在影響。文獻[21]從余弦的角度重新思考Softmax 交叉熵損失,為了只保留角度對損失函數的影響,通過L2 正則化將設置為,并將設置為,因為實驗證明對最終的評價指標沒有影響,所以損失函數可表示為:

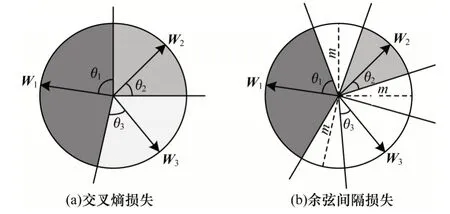

通過將權重以及特征進行L2 范數歸一化,使得每個樣本的特征被映射到一個超球面中,而r是該超球面的半徑。在這個超球面上,同一類的特征向量分布聚集在一起,不同類別的特征向量之間存在一定距離。假設一個數據集有三類特征,則這三類特征在超球面上的分布如圖6 所示。其中,θi表示特征向量x與權重向量Wi之間的夾角。

圖6 三類特征在2 種損失上的分布Fig.6 Distribution of three characteristics on two losses

從圖6 可以看出,決策邊界附近的特征點很容易被錯誤分類,因為類別與類別間的距離為0,這意味著邊界十分模糊,模型的容錯率較小。為增大類間間距、縮小類內方差,通過引入超參數余弦間隔m到式(5)中,得到本文提出的余弦間隔損失函數,具體的數學形式如式(6)所示:

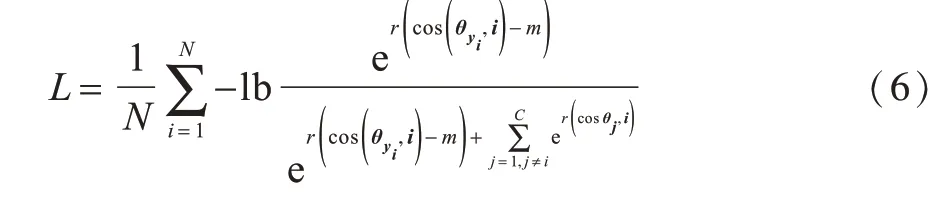

如圖6(b)所示,針對相同的三類別特征,余弦間隔損失函數將決策邊界由cosθ1-cosθ2=0、cosθ2-cosθ3=0、cosθ3-cosθ1=0 調整為cosθ1-cosθ2=m、cosθ2-cosθ3=m、cosθ3-cosθ1=m。原始的Softmax Loss 以及余弦形式的Softmax Loss 不同類別之間沒有間隔存在,而本文使用的余弦間隔損失則為不同類別之間引入一個余弦間隔m。本文為了更好地理解間隔項的作用,在經典的mnist 手寫數字體分類任務上采用不同的損失函數進行實驗。為方便在三維空間進行特征可視化,將倒數第二個全連接層的輸出單元個數設置為3,每個輸入圖片將得到一個三維特征向量。利用傳統的Softmax Loss 函數的優化準確率為97.3%,利用余弦間隔損失函數的優化準確率為99.1%。

在mnist手寫體數字分類上,本文對不同損失函數優化后得到的特征向量進行可視化,結果如圖7 所示。圖7(a)表示傳統的Softmax Loss 的特征分布,由此可以看出,雖然類間具有良好的間隔,但是類內的距離仍然很大。與此相比,圖7(b)不僅類間距離更大,且每個類簇也更加緊湊,這說明余弦間隔損失函數不僅顯著增大類間距離,而且還顯著減少類內距離,使得學習到的特征向量更加穩定且魯棒。

圖7 不同損失函數在特征空間中的特征分布Fig.7 Feature distribution of different loss functions in the feature space

3 實驗方法與結果

3.1 實驗數據集

實驗用到的數據集共包含3 725 張彩色圖像,圖像是從真實環境拍攝的照片中裁剪所得。經整理后,將圖像分為100 個類別,且2 725 張用于訓練,1 000 張用于測試。數據集樣本類別多樣且每類樣本數據多樣,具體如圖8 所示。

圖8 樣本類別及樣本數據Fig.8 Sample categories and sample data

3.2 實驗過程

將訓練集2 725 張圖像中的1/10 劃分出來用作驗證集,訓練結束后保留驗證集上準確率次高的模型,并用其在驗證集上繼續訓練網絡,微調網絡參數,觀察損失值和準確率。為防止過擬合,采用數據增強技術來擴充數據,具體使用的技術包括水平和豎直方向隨機移動、隨機放大、剪切變換、顏色抖動和隨機旋轉。在訓練過程中先把每張圖像縮放到256×256像素,然后隨機裁剪224×224 輸入到網絡中,且進行測試時,以中心裁剪224×224 的圖片作為輸入。本文對圖片進行[0,1]歸一化處理,采用ImageNet[23]預訓練權重,以Adam 為優化器,初始學習率設置為0.001,訓練100 個epoch,當驗證集準確率不再繼續增大時,將學習率衰減10 倍。實驗在Windows10系統、Spyder 編輯器與基于Keras 框架的NVIDIA GeForce MX150 GPU 上進行。

3.3 實驗結果分析

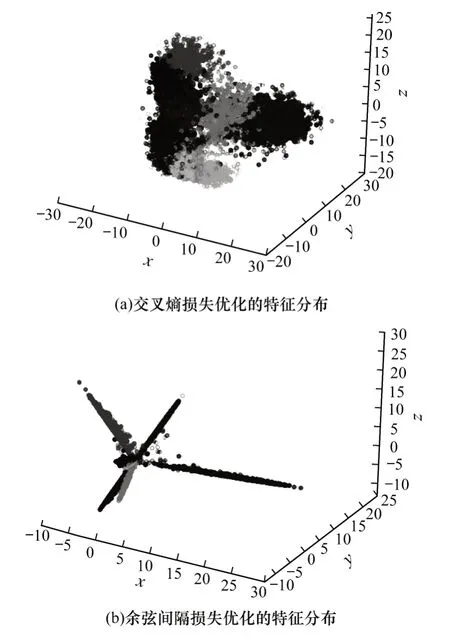

本文采用準確率(Accuracy)、精確率(Precision)、召回率(Recall)與F1 值4 種評價指標對結果進行評估,且其計算方法分別如式(7)~式(10)所示:

其中,TP 表示被正確預測的正例,TN 表示被正確預測的負例,FP 表示被錯誤預測的負例,FN 表示被錯誤預測的正例。

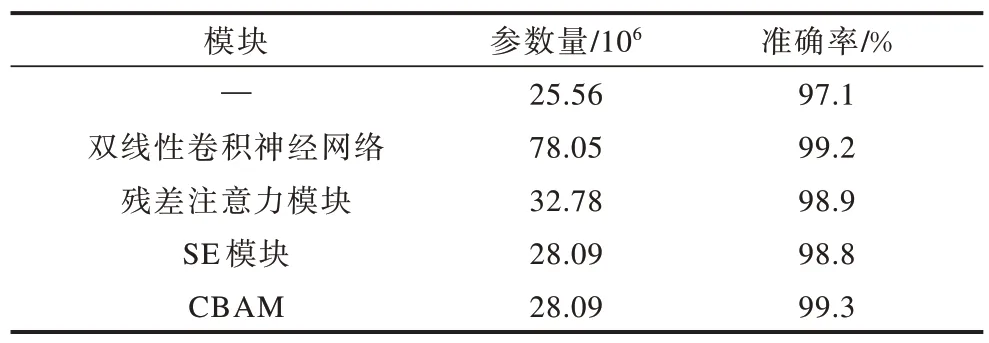

為分析每個模型的效果,本文在商家招牌數據集上分析并驗證ResNet50 模型中每個模塊的性能,結果如表1 所示。其中,最優結果加粗表示,“√”表示模型所選擇的不同模塊,“—”表示模型未選擇的模塊。

表1 不同模塊的結果對比Table 1 Comparison of results of different modules %

從表1 可以看出:與原始ResNet50 相比,當使用注意力機制CBAM 后,分類準確率提高1.4 個百分點,F1值提升0.8 個百分點,這是因為CBAM 引入的通道注意力機制極大增強了特征的判別性,起到特征選擇的作用,從而提高分類效果;對比表1 中的第一行和第二行可知,由于網絡在優化過程中不但增大類間間隔,而且減小類內方差,這說明相比傳統的交叉損失函數,基于間隔的余弦損失函數取得了更優性能;當本文將注意力機制和余弦間隔損失函數相結合時,相比原始的ResNet50,本文方法的準確率與F1 值分別提高了2.2 個百分點與2.0 個百分點,且分類性能達到最優。

3.4 對比實驗分析

實驗比較了以ResNet50 為基礎的雙線性卷積神經網絡模塊、殘差注意力模塊、SE 模塊與本文所提CBAM 等4 種不同注意力模型的性能,結果如表2 所示。從表2 可以看出,CBAM 在模型參數量和性能上均達到最優。

表2 4 種不同注意力機制模型的性能對比Table 2 Performance comparison of four different attention mechanism models

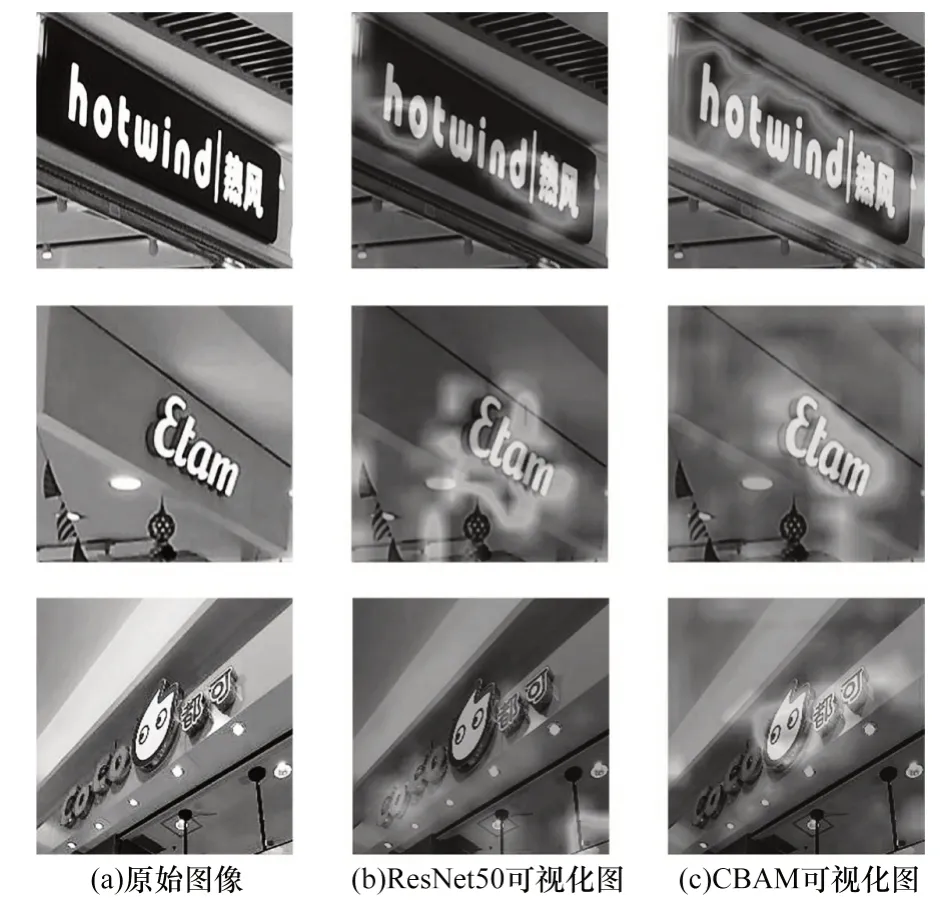

3.5 可視化實驗分析

為進一步分析注意力機制的效果,本文使用類別激活映射技術(Grad-CAM)對輸入的圖片進行注意力可視化。如圖9 所示,左邊的一列是原始的輸入圖像,中間一列是原始的ResNet50 可視化圖,最右邊的一列是使用CBAM 的可視化特征圖。通過對比(尤其是第二行和第三行)可以看出,通過引入CBAM 使得網絡更加關注在招牌字符以及圖像區域的特征,并忽略其他不相關的特征區域,從而增強特征的判別性,有效改善分類效果。

圖9 注意力機制可視化結果Fig.9 Results of attention mechanism visualization

4 結束語

針對商家招牌的分類問題,本文提出基于端到端深度學習的卷積神經網絡方法。該方法通過在原始ResNet50 網絡結構的基礎上插入注意力機制CBAM,構造一種新的余弦間隔損失函數,并利用數據增強技術對數據集進行擴充,使得模型準確率達到99.3%。實驗結果表明,與傳統方法相比,該方法省略了特征提取等步驟,不僅節省大量時間與人力,而且可在較短時間內達到較高的準確率。由于本文使用的數據集僅有3 725 張圖像,因此后續將采用二叉神經樹與循環學習率相結合的方法對ResNet50網絡結構進行改進,以適應更大規模的數據集。