基于RetinaNet模型的梨小食心蟲智能識別計數(shù)方法

陳恩會 褚姝頻 王煒 程大勇 李興東 趙銀娣

摘要:針對梨小食心蟲監(jiān)測調(diào)查中存在的人工分類計數(shù)費時、費力且誤差較大的問題,基于RetinaNet深度學(xué)習(xí)目標(biāo)檢測模型,構(gòu)建了一種普適性更廣的梨小食心蟲智能識別計數(shù)方法。試驗結(jié)果表明,RetinaNet目標(biāo)檢測模型對黏蟲板上梨小食心蟲的平均識別準(zhǔn)確率達95.93%,平均計數(shù)準(zhǔn)確率達95.62%,且該方法對拍攝條件要求低,普適性廣,優(yōu)于Faster R-CNN目標(biāo)檢測模型,完全可以在梨小食心蟲監(jiān)測調(diào)查中替代人工進行分類計數(shù)。

關(guān)鍵詞:RetinaNet模型;梨小食心蟲;目標(biāo)檢測;智能識別;計數(shù)

中圖分類號:TP391.4 文獻標(biāo)志碼: A

文章編號:1002-1302(2021)24-0205-04

收稿日期:2021-02-11

基金項目:徐州市重點研發(fā)計劃(編號:KC17055)。

作者簡介:陳恩會(1979—),男,江蘇邳州人,碩士,高級農(nóng)藝師,主要從事植物病蟲害智能識別與防治研究。E-mail:enhui201@qq.com。

通信作者:趙銀娣,博士,副教授,主要從事遙感數(shù)據(jù)處理、模式識別研究。E-mail:zhaoyd@cumt.edu.cn。

梨小食心蟲[Grapholita molesta (Busck)]別稱梨小蛀果蛾、東方果蠹蛾,屬鱗翅目小卷葉蛾科,是我國發(fā)生最為嚴重的果樹食心蟲之一,可危害桃、梨、蘋果、櫻桃、杏等多種果樹,造成植株折梢、蛀果等危害,嚴重影響果品質(zhì)量和產(chǎn)量[1]。為了掌握梨小食心蟲發(fā)生動態(tài),目前生產(chǎn)上主要采取性信息素誘捕的方法進行田間監(jiān)測,誘捕器以三角式、船型為主[2]。性信息素誘捕器內(nèi)捕獲的絕大多數(shù)都是梨小食心蟲,但也有少量的其他害蟲,在梨小食心蟲發(fā)生高峰期時,性信息素誘捕器中單張性黏蟲板上的總蟲量高達幾百頭,人工對這些害蟲進行分類計數(shù),費時、費力,而且誤差較大,難以滿足當(dāng)前生產(chǎn)實際需求。為解決這一問題,近年來許多學(xué)者做了大量的研究。陳梅香等研究設(shè)計了1種基于性誘的梨小食心蟲自動監(jiān)測裝置,該裝置對梨小食心蟲平均誘捕率達89.58%,并基于機器視覺的方法,構(gòu)建了害蟲自動識別計數(shù)系統(tǒng),平均識別計數(shù)準(zhǔn)確率達94.11%[3]。但由于該系統(tǒng)只能處理與之相配套的自動監(jiān)測裝置拍攝的黏蟲板圖像,應(yīng)用范圍受一定限制。本研究擬利用深度學(xué)習(xí)技術(shù),構(gòu)建一種普適性更廣的梨小食心蟲智能識別計數(shù)方法。

目前,基于深度學(xué)習(xí)模型的目標(biāo)檢測算法主要可以分成兩大類:第1類是二段式(Two-stage)檢測模型,如Fast R-CNN[4]、Faster R-CNN[5]、Mask R-CNN等,這類模型將目標(biāo)檢測問題劃分為2個階段,首先進行候選區(qū)域提取,然后再對候選區(qū)域分類,通常能取得較好的精度,但速度較慢。張銀松等對Faster R-CNN目標(biāo)檢測模型進行了改進,用于黏蟲板上微小昆蟲的識別,使用深度殘差網(wǎng)絡(luò)(ResNet-50)代替VGG16網(wǎng)絡(luò),用Soft-NMS算法代替?zhèn)鹘y(tǒng)的非極大值抑制(NMS)算法,改進后的模型對黏蟲板上昆蟲的識別準(zhǔn)確率提高了4.2%,計數(shù)的準(zhǔn)確率達90%以上[6]。陶震宇等為實現(xiàn)花生害蟲圖像的準(zhǔn)確分類,調(diào)整了Faster R-CNN目標(biāo)檢測模型中的ResNet-50網(wǎng)絡(luò)參數(shù),調(diào)整后的網(wǎng)絡(luò)模型對花生上9種常見害蟲的綜合識別率達90.7%[7]。第2類是一段式(One-stage)目標(biāo)檢測模型,如YOLO(You Only Look Once)[8]、SSD(Single Shot MultiBox Detector)[9]等,這類模型因為不需要進行候選區(qū)域提取,直接產(chǎn)生目標(biāo)的類別概率和位置坐標(biāo)值,經(jīng)過單次檢測即可得到最終的檢測結(jié)果,所以速度比二段式檢測模型快,但精度不夠高。佘顥等針對目前主流的目標(biāo)檢測算法在蟲害監(jiān)控系統(tǒng)中識別速度慢、準(zhǔn)確度低的問題,提出1種基于SSD模型的水稻害蟲識別方法,改進后的SSD模型對水稻5種常見害蟲的平均識別準(zhǔn)確率達79.3%,比未改進的Faster R-CNN VGG16網(wǎng)絡(luò)識別準(zhǔn)確率最高提升6.6%,識別速度最高提升8倍[10]。苗海委等研究提出1種基于SSD模型的儲糧害蟲圖像檢測算法,該算法針對黏蟲板圖像背景復(fù)雜、害蟲體積較小、姿態(tài)多樣的特點,改進了SSD 的目標(biāo)框回歸策略、損失函數(shù)和特征提取網(wǎng)絡(luò)結(jié)構(gòu),改進后的SSD模型算法可有效檢測黏蟲板上的害蟲,檢測平均正確率達到81.36%[11]。

Lin等認為,一段式模型檢測精度不高的原因主要是訓(xùn)練過程中正負樣本類別極度不平衡的問題[12],提出了一個新的損失函數(shù)(Focal Loss),該函數(shù)是1種改進了的交叉熵(Cross-entropy,簡稱CE)損失函數(shù),通過在原有的交叉熵損失函數(shù)中乘上使易檢測目標(biāo)對模型訓(xùn)練貢獻削弱的指數(shù)式,成功地解決了在目標(biāo)檢測時,正負樣本區(qū)域極不平衡而目標(biāo)檢測損失值易被大批量負樣本所左右的問題,并基于此設(shè)計了一個新的目標(biāo)檢測模型──RetinaNet。RetinaNet模型不僅擁有一段式目標(biāo)檢測模型的速度,也能達到二段式目標(biāo)檢測模型的準(zhǔn)確率,甚至超越了部分二段式的經(jīng)典網(wǎng)絡(luò),因此,本研究使用RetinaNet目標(biāo)檢測模型開展梨小食心蟲智能識別計數(shù)方法研究。

1 材料與方法

1.1 RetinaNet目標(biāo)檢測模型

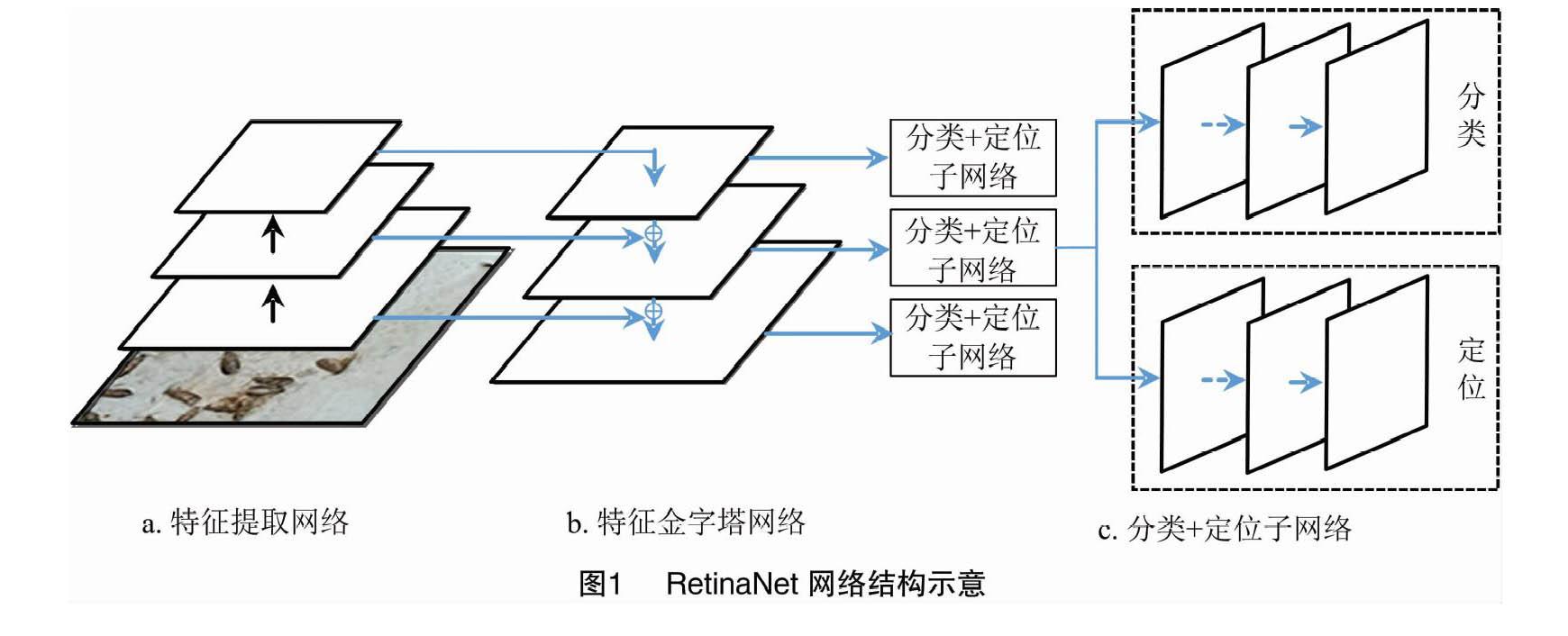

RetinaNet目標(biāo)檢測模型的網(wǎng)絡(luò)結(jié)構(gòu)主要由特征提取網(wǎng)絡(luò)、特征金字塔網(wǎng)絡(luò)、分類+定位子網(wǎng)絡(luò)構(gòu)成,其結(jié)構(gòu)示意見圖1。

考慮到梨小食心蟲數(shù)量多、體積小的特點,本研究中RetinaNet目標(biāo)檢測模型的特征提取網(wǎng)絡(luò)使用ResNet50深度殘差網(wǎng)絡(luò),ResNet50引入了殘差塊的設(shè)計,克服了由于網(wǎng)絡(luò)深度的增加而產(chǎn)生的學(xué)習(xí)率變低、準(zhǔn)確率無法有效提升的問題。

1.2 數(shù)據(jù)采集和預(yù)處理

數(shù)據(jù)圖像的采集來自徐州市銅山區(qū)和新沂市的桃園,先使用船型性信息素誘捕器誘集梨小食心蟲,等誘捕器內(nèi)的黏蟲板黏滿梨小食心蟲后,再把黏蟲板拆下來,采用人工方式,使用普通相機或手機在自然環(huán)境下進行田間拍照。由于深度學(xué)習(xí)需要大量的數(shù)據(jù)集,為了后期模型更好地訓(xùn)練,本研究對采集到的數(shù)據(jù)進行增加噪音、剪切、旋轉(zhuǎn)、改變色差、扭曲等操作,對數(shù)據(jù)進行增強,將試驗數(shù)據(jù)集擴充至7 900幅圖像,每幅圖像大小為600×600像素。

然后,使用開源的LabelImg圖像標(biāo)注工具,人工依次標(biāo)記每張圖像中梨小食心蟲的位置和類別,其他害蟲和雜物不做標(biāo)注,標(biāo)注情況見圖2。最后隨機選擇5 530幅圖像構(gòu)建訓(xùn)練集,1 580幅圖像作為驗證集,其他剩余圖像作為測試集。

1.3 模型訓(xùn)練環(huán)境

本試驗在Windows10操作系統(tǒng)上,采用Keras 2.0.3作為深度學(xué)習(xí)框架,以Tensorflow1.14為后端,使用圖形處理器(GPU)對訓(xùn)練過程進行加速,加速庫為CUDA10.0和cudnn7.4,所使用的硬件配置為i7-9700k處理器和NVIDIA GeForce RTX 2070S的顯卡。

2 結(jié)果與分析

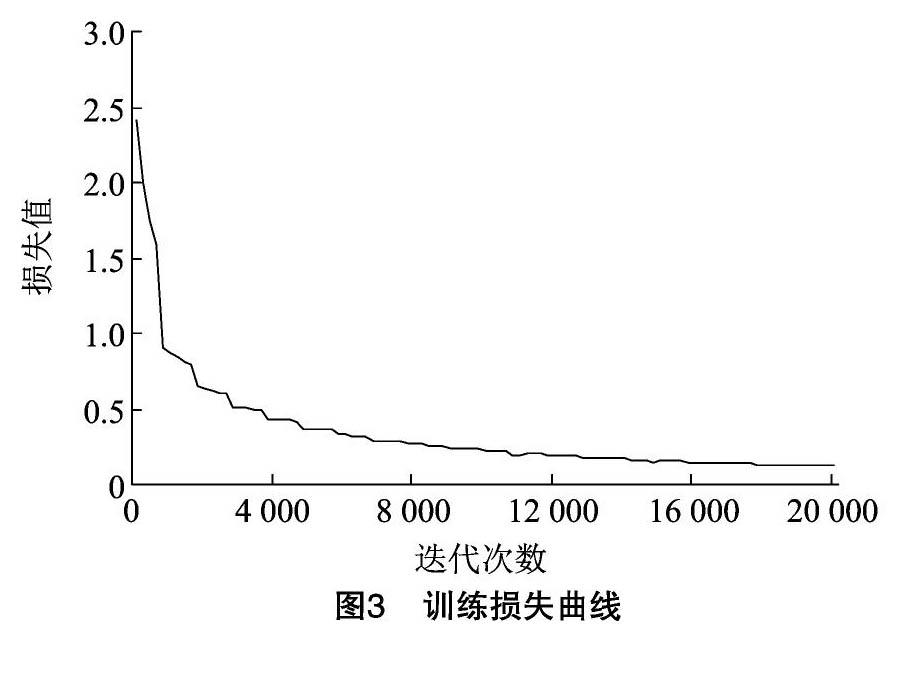

本試驗在RetinaNet目標(biāo)檢測模型的基礎(chǔ)上,設(shè)置訓(xùn)練參數(shù)如下:最大訓(xùn)練輪次為20 次,每輪迭代1 000次,學(xué)習(xí)率0.000 01。使用Keras深度學(xué)習(xí)框架,經(jīng)過約6 h完成模型的訓(xùn)練,模型訓(xùn)練的損失曲線見圖3。從圖3可以看出,模型訓(xùn)練迭代到 20 000 次時,損失值基本收斂。

梨小食心蟲目標(biāo)識別結(jié)果以檢測框的形式標(biāo)注在圖片上,其中包括目標(biāo)類別標(biāo)記和分類概率(P),本研究的計數(shù)方法為設(shè)定閾值N,當(dāng)P>N時,認為該目標(biāo)檢測準(zhǔn)確,此檢測框參與統(tǒng)計,當(dāng) P≤N 時,認為該目標(biāo)檢測不準(zhǔn)確,此檢測框不參與統(tǒng)計。經(jīng)過反復(fù)對比發(fā)現(xiàn),在本研究中當(dāng)閾值N設(shè)置為0.81時,檢測結(jié)果最接近實際情況。檢測結(jié)果見圖4和表1。Faster R-CNN模型對測試集中的梨小食心蟲平均識別準(zhǔn)確率為91.02%,平均計數(shù)準(zhǔn)確率為83.54%,在示例數(shù)據(jù)中識別出20頭梨小食心蟲,比人工計數(shù)少5頭。RetinaNet模型對測試集中的梨小食心蟲平均識別準(zhǔn)確率為95.93%,平均計數(shù)準(zhǔn)確率為95.62%,在示例數(shù)據(jù)中識別出26頭梨小食心蟲,比人工計數(shù)多1頭。從表1可以看出,RetinaNet模型的識別效果優(yōu)于Faster R-CNN模型。Faster R-CNN模型計數(shù)準(zhǔn)確率不高的原因主要在于漏檢,尤其是對圖像邊緣顯示不完整的梨小食心蟲的識別效果不好。RetinaNet模型很少出現(xiàn)漏檢的情況,計數(shù)準(zhǔn)確率也很高,但是存在一定概率的誤檢。

3 應(yīng)用效果

在實際應(yīng)用時,手機或照相機拍攝的整張梨小食心蟲黏蟲版的圖像尺寸較大,一般在2 000×2 000 像素以上,為了獲得最佳識別效果,本研究將原始大圖分割為若干個600×600像素的小圖,對于分割后高或?qū)挷蛔?00像素的部分,使用純白色填充至600像素,然后把小圖分別輸入RetinaNet模型進行檢測,檢測后拼接還原成大圖。實際應(yīng)用中RetinaNet模型對2張黏蟲板圖像中梨小食心蟲的檢測結(jié)果見圖5,其識別和計數(shù)的平均準(zhǔn)確率為97.2%,平均召回率為94.5%,詳細統(tǒng)計結(jié)果見表2。

4 結(jié)論

本研究探討了RetinaNet深度學(xué)習(xí)目標(biāo)檢測模型對普通相機或手機在自然條件下拍攝的黏蟲板上梨小食心蟲的識別計數(shù)效果,并將該模型的識別計數(shù)結(jié)果與Faster R-CNN模型進行了比較,試驗結(jié)果表明,RetinaNet模型對黏蟲板上梨小食心蟲的識別計數(shù)準(zhǔn)確率較高,而且該方法對拍攝條件要求低,普適性廣,完全可以在梨小食心蟲監(jiān)測調(diào)查過程中替代人工進行分類計數(shù)。當(dāng)然,RetinaNet模型在識別計數(shù)時仍然存在一定概率的誤檢和漏檢,后續(xù)研究將通過豐富樣本庫,適當(dāng)減少數(shù)據(jù)增強比例等方法對本模型進行改進。

參考文獻:

[1]范仁俊,劉中芳,陸俊姣,等. 我國梨小食心蟲綜合防治研究進展[J]. 應(yīng)用昆蟲學(xué)報,2013,50(6):1509-1513.

[2]王榮轅,劉廣勤,李佰峰,等. 性信息素誘捕器不同懸掛方式對梨小食心蟲誘殺效果[J]. 江蘇農(nóng)業(yè)科學(xué),2021,49(6):99-102.

[3]陳梅香,郭繼英,許建平,等. 梨小食心蟲自動監(jiān)測識別計數(shù)系統(tǒng)研制[J]. 環(huán)境昆蟲學(xué)報,2018,40(5):1164-1174.

[4]Girshick R. Fast R-CNN[C]//2015 IEEE International Conference on Computer Vision (ICCV). Santiago:IEEE,2015:1440-1448.

[5]Ren S Q,He K M,Girshick R,et al. Faster R-CNN:towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2017,39(6):1137-1149.

[6]張銀松,趙銀娣,袁慕策. 基于改進Faster-RCNN模型的粘蟲板圖像昆蟲識別與計數(shù)[J]. 中國農(nóng)業(yè)大學(xué)學(xué)報,2019,24(5):115-122.

[7]陶震宇,孫素芬,羅長壽. 基于Faster-RCNN的花生害蟲圖像識別研究[J]. 江蘇農(nóng)業(yè)科學(xué),2019,47(12):247-250.

[8]Redmon J,Divvala S,Girshick R,et al. You only look once:Unified,real-time object detection[C]//2016 IEEE Conference on Computer Vision and Pattern Recognition ( CVPR). Las Vegas:IEEE,2016:779-788.

[9]Liu W,Anguelov D,Erhan D,et al. SSD:Single shot multibox detector[C]//European Conference on Computer Vision. Berlin:Springer,2016:21-37.

[10]佘 顥,吳 伶,單魯泉. 基于SSD網(wǎng)絡(luò)模型改進的水稻害蟲識別方法[J]. 鄭州大學(xué)學(xué)報(理學(xué)版),2020,52(3):49-54.

[11]苗海委,周慧玲. 基于深度學(xué)習(xí)的粘蟲板儲糧害蟲圖像檢測算法的研究[J]. 中國糧油學(xué)報,2019,34(12):93-99.

[12]Lin T Y,Goyal P,Girshick R,et al. Focal Loss for Dense Object Detection[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2020,42(2):318-327.