基于卷積神經網絡的行人檢測技術的研究綜述

譚玉枚 余長庚

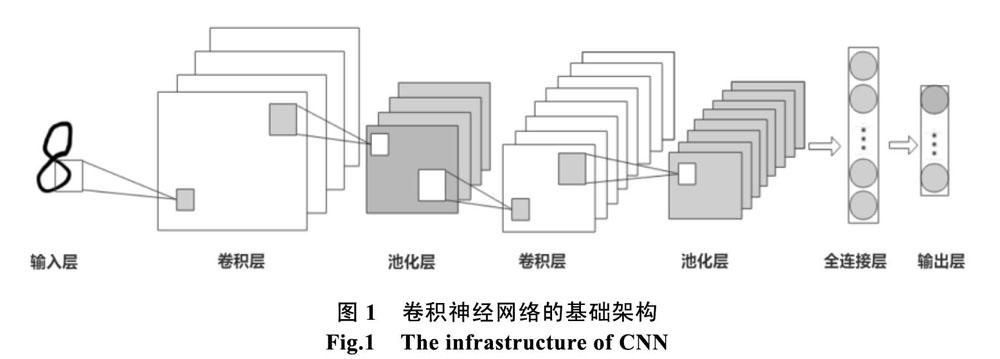

摘? 要: 隨著深度學習方法在行人檢測領域的深入應用,基于卷積神經網絡的行人檢測技術在特征學習、目標分類、邊框回歸等方面表現出的優勢已愈發突出。因此,本文從對傳統的行人檢測方法和基于卷積神經網絡的行人檢測技術進行優劣比較切入,概述了卷積神經網絡的基礎構架,以此引出對當前常用的基于卷積神經網絡的常見行人檢測技術及其優缺點,最后討論了現有基于卷積神經網絡算法實現行人檢測存在的不足和指出今后發展方向。

關鍵詞: 卷積神經網絡;行人檢測;目標分類;邊框回歸

中圖分類號: TP391. 41 ???文獻標識碼: A??? DOI:10.3969/j.issn.1003-6970.2020.07.006

本文著錄格式:譚玉枚,余長庚. 基于卷積神經網絡的行人檢測技術的研究綜述[J]. 軟件,2020,41(07):31-36+75

Review of Pedestrian Detection Based on Convolution Neural Network

TAN Yu-mei, YU Chang-geng

(College of Information and Communication Engineering, Hezhou University, hezhou 542899, China)

【Abstract】: With the in-depth application of deep learning in pedestrian detection, the advantages of pedestrian detection based on convolutional neural network have become more pronounced in the fields of feature learning, object classification, border regression and others. An overview of basic structure of convolutional neural network is done by comparing the advantages and disadvantages of the pedestrian detection based on the traditional method and convolutional neural network. On this basis, the paper introduces the common pedestrian detection technologies based on convolutional neural network and its advantages and disadvantages. At last, the present deficiencies existing in pedestrian detection based on CNN are briefly discussed and the future directions are pointed out.

【Key words】: Convolution neural network; Pedestrian detection; Target classification; Border regression

0? 引言

目前,在無人駕駛、智能視頻監控和機器人視覺感知[1]等應用背景下,計量機視覺研究領域中的行人檢測技術受到國內外學術界的廣泛關注和深入研究。傳統的行人檢測方法側重于在特征提取和分類方面提升檢測準確率。其中,具有代表性的方法有:HOG(histogram of oriented gradient)+SVM(support vector machine)[2]、Harr+Adaboost[3]、基于多特征融合的粒子濾波多目標跟蹤方法[4]等。該類方法把特征提取和分類訓練分離為兩個獨立過程,往往受限于特定環境條件(如小尺度變換處理等[5])、設定低階特征(如紋理特征等),并且不同的特征與分類器適用程度各異,導致特征表達能力不足、可分性較差、可移植性差。

為更好提升行人檢測技術的泛化性和魯棒性,Hinton在2006年提出了自下向上方式自動逐層學習數據高階特征的深度學習方法[6],引起了機器學習領域學者的廣泛關注。……