基于ResNet-BLSTM的端到端語音識別

胡章芳,徐 軒,付亞芹,夏志廣,馬蘇東

1.重慶郵電大學 光電工程學院,重慶 400065

2.重慶郵電大學 先進制造學院,重慶 400065

1 引言

自動語音識別(Automatic Speech Recognition,ASR)是一項復雜任務,系統基于嚴格設計的處理流程,包括輸入特征、聲學模型、語言模型和隱馬爾可夫模型(Hidden Markov Models,HMM)[1]。而 ASR 的長期目標是能夠在不同的環境下有效處理人們的講話,對于傳統的GMM-HMM混合模型而言相當有挑戰性。一個良好的聲學模型應該具備有效模擬語音信號中的各種聲學變化能力,從而獲得在不同講話和環境條件下的魯棒性。語音識別模型通常將特征提取和分類器作為兩個獨立的問題研究,先設計特征提取方法,然后基于提取的特征優化分類器性能。這種將兩者分割的方法有兩個缺點[2-3]:一是人工設計特征提取方法需要精心設計和大量實驗驗證;二是人工設計的特征對于當前的分類任務并不能保證是最優的。DNN及其變體能夠同時進行特征提取和分類任務。如文獻[4]表明,DNN 的低層能夠提取對說話人自適應的特征,DNN 的高層能夠提高不同類別的區分性,從而提升最終分類效果。這種特征規整與分類任務的聯合優化特性是DNN優于基于高斯混合模型(Gaussian Mixture Model,GMM)一個重要原因。

最近幾年,隨著深度學習技術的發展,卷積神經網絡(Convolutional Neural Network,CNN)和長短時記憶網絡(Long Short-Term Memory,LSTM)在語音識別技術中相較于傳統的語音識別技術方法,取得了較好的識別率。但其網絡結構輸入端的特征通常是梅爾頻率倒譜系數[5(]Mel Frequency Cepstral Coefficents,MFCC),該特征是基于人耳聽覺特性提出來的,它與頻率成非線性對應關系,但易造成高頻區域信息損失的問題,而且傳統語音特征為了計算量的考慮必須采用非常大的幀移,無疑造成了時域上的信息損失,在說話人語速較快的時候表現得更為突出。因此對語音識別任務來說,并不能保證其為最優特征。

進一步,文獻[6]為了解決這些問題,研究了從原始語音波形作為神經網絡的輸入,用神經網絡訓練的方法,提取到較于MFCC 更好的特征,該方法不需要任何人工干預處理,并且網絡的參數是由訓練數據和目標函數來確定。文獻[7]采用一層時域卷積作為特征提取器,結合卷積網絡、長短時記憶網絡(Convolution-LSTMDeep Neural Network,CLDNN)的混合神經網絡,首次將以原始語音波形為輸入的模型識別性能達到以MFCC 特征為輸入的模型識別性能。但是由于它們采用的卷積層數很少,一般只有1~2層,并且只把CNN視作一種特征提取器來使用,這樣的卷積網絡結構表達能力十分有限。為了解決這一問題,文獻[8]中采用多時間頻率分辨率卷積網絡與帶記憶模塊的前饋序列神經網絡(Feed-forward Sequential Memory Network,FSMN)相結合的模型,提升了語音識別性能和訓練速度。但采用更多的FSMN 層,會使得訓練出現梯度消失問題,導致訓練的不穩定性。

針對以上問題,本文提出了一種基于殘差網絡(ResNet)[9]與雙向長短時記憶網絡(BLSTM)[10]相結合的模型結構,提升端到端模型的識別率和系統魯棒性。采用殘差網絡,直接將整段語音的語譜圖作為輸入,相比其他以傳統語音特征作為輸入的語音識別模型速度更快。其次,從模型結構來看,本文的ResNet與傳統端到端系統中的CNN 做法不同,它借鑒了圖像識別中做法,通過將語音轉化成一張圖像作為輸入,再將時間和頻率作為圖像的兩個維度,然后通過一些卷積層和池化(pooling)層的組合,這樣大大增強了CNN的表達能力。其次在ResNet 后接BLSTM,通過該網絡能夠學習到語音信號的上下文信息,從而提升端到端模型的識別率。

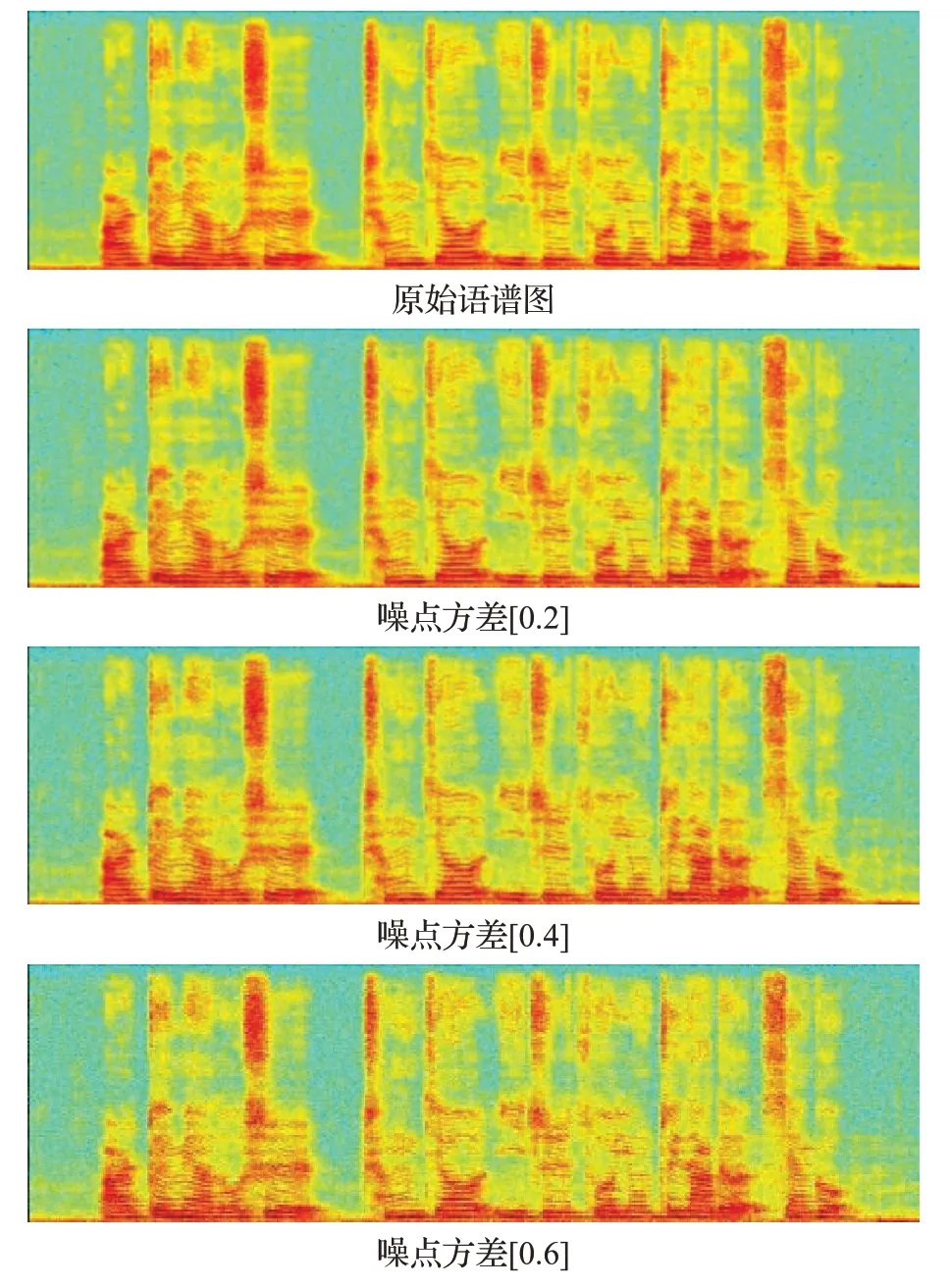

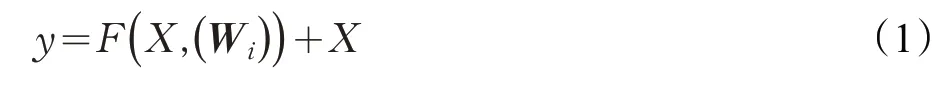

2 DCNN模型

CNN 作為語譜圖的特征提取器,完整的CNN 包括卷積層和池化層,在卷積網絡最后一層使用最大池化層(Max-pooling)對輸出的特征進行固定大小的采樣,由此在減少參數的同時保留了絕大部分特征信息,提升性能。由于CNNs擅長對輸入端的局部結構進行建模,并且卷積層對語譜圖進行卷積操作時,其卷積權重都是全共享的,相較于DNN網絡而言,可以大幅度提升訓練速度。DCNN模型如圖1所示。

圖1 DCNN模型

3 ResNet-BLSTM模型

單一堆疊的CNN 網絡隨著層數的增加,模型會發生梯度消失和網絡性能的退化問題。因此,本文在原有的CNN 中引入殘差模塊以及并行的卷積層,并接入BLSTM 層,提出了RseNet-BLSTM 模型。該模型由兩個模塊組成,RseNet 模塊和BLSTM 模塊。RseNet 能夠提取語譜圖當中的局部區域特征,然后由BLSTM 對特征進行上下文建模。

3.1 模型輸入

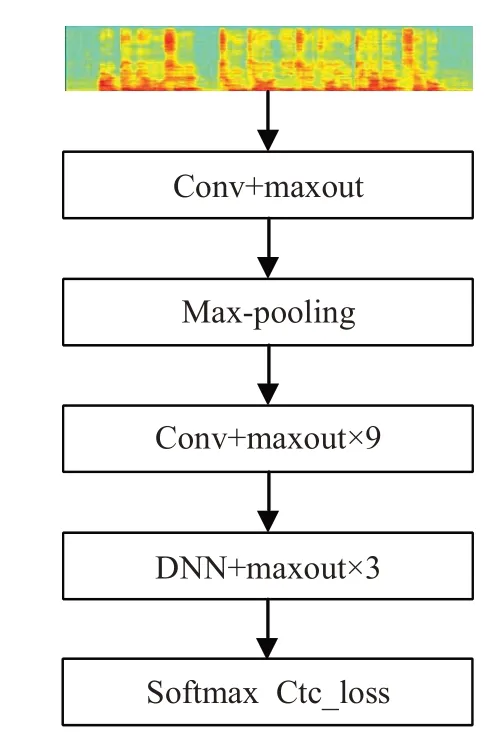

由于時域分析不能直觀反映語音信號的頻率特征,頻域分析又不能表示語音信號隨時間的變化關系,因而文獻[11]提出了語譜圖的分析方法,它結合了頻譜圖與時域波形圖的優點,能夠直觀地顯示語音信號頻譜隨時間的變化,是一種動態的頻譜。從語譜圖上能夠直觀地看見在任意給定的時間,不同的頻率成分顏色不同,則頻譜值不同。本文將原始語音信號轉換成大小為N×N三通道的語譜圖(Spectrogram),同時在原始語譜圖上增加三組不同方差[0.2,0.4,0.6]的高斯白噪聲點,用于提高模型的魯棒性。原始語譜圖和帶噪語譜圖如圖2所示。

圖2 原始語譜圖及帶噪語譜圖

3.2 ResNet模塊

3.2.1 殘差網絡

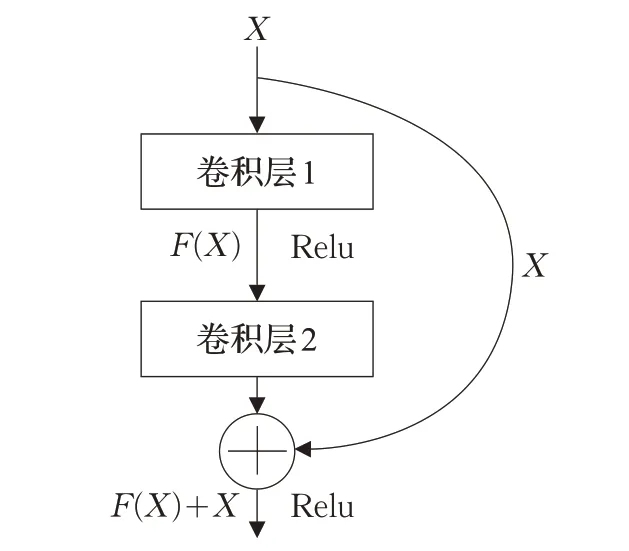

在堆疊的CNN 網絡中引入了殘差模塊,殘差模塊基本原理如圖3所示。

圖3 殘差網絡結構

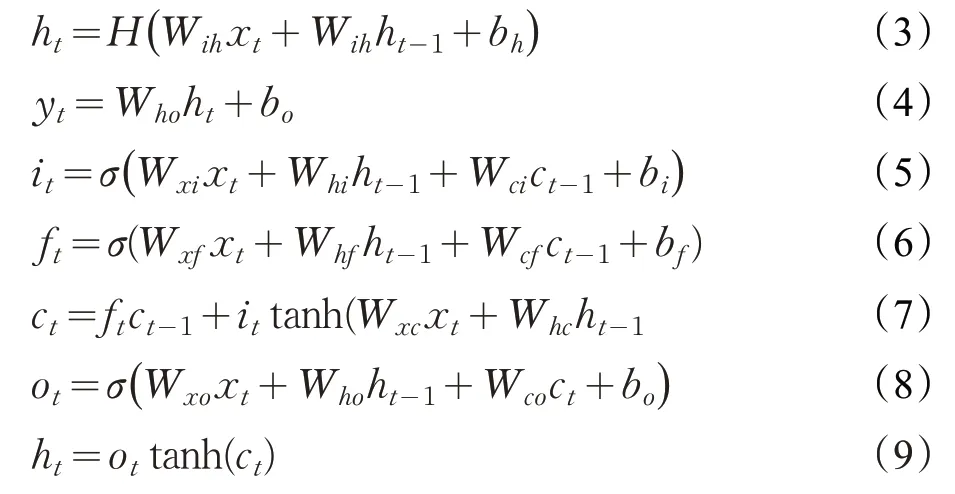

設輸入為X,輸出為y,權重矩陣為Wi,F(X,(Wi))表示為網絡的學習殘差函數,具體公式如下:

如果X的維度與學習殘差函數維度不同,為了實現輸入與輸出之間的加法,則利用捷徑線上的線性投影Ws矩陣完成。引入殘差模塊的前提是一個殘差模塊至少有兩層卷積網絡。

殘差模塊的引入,使得網絡在優化參數的過程相較于普通堆疊網絡更容易,并且隨著網絡層數的增加能夠獲得更加準確的識別率。

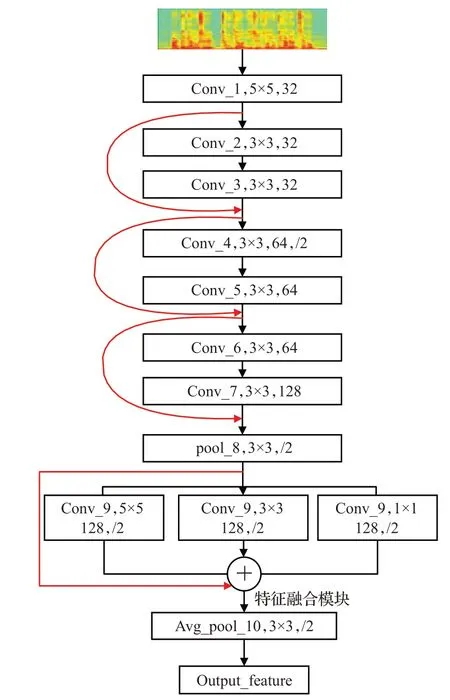

3.2.2 ResNet模塊設計

單一疊加的卷積神經網絡主要是由卷積層和池化層組成,卷積層越多,網絡深度越深。雖然深層的網絡能夠提取到更加豐富的特征,但由此也會導致模型復雜,以及計算量過大的問題。本文基于上述考慮,ResNet模塊設計結構如圖4所示。

圖4 ResNet模塊

ResNet模塊包括8層卷積層、2層池化層,以及一組并行卷積層。由于本文在設計卷積核尺寸時是從以下兩個方面考慮:(1)語譜圖包含語音信號的特點;(2)過大的卷積核,容易導致計算量增加,不利于增加網絡的深度。故本文選擇的卷積核尺寸分別有3×3和5×5及1×1。

圖4 中自上而下分別是語譜圖、殘差層、并行卷積層、最大池化層。殘差層的卷積核大小都是3×3,卷積核的數量依次遞增,分別為32、64、128,之后接一層池化層,其目的是為了減少參量,加快訓練速度。

同時為了解決語音說話人語速導致識別率低問題,提高模型的魯棒性,本文設計了并行的卷積組,該層每組卷積核數量均為128,但大小不一致,目的是為了提取到不同尺度的特征。最后將三組輸出與上一層的輸出進行特征融合。使得模型能夠適應說話人的語速。

由于語音信號大部分信息都反映在能量譜中,因此在最后一層使用最大池化層,保留語譜圖中的紋理特征。

3.3 BLSTM模塊

3.3.1 BLSTM網絡

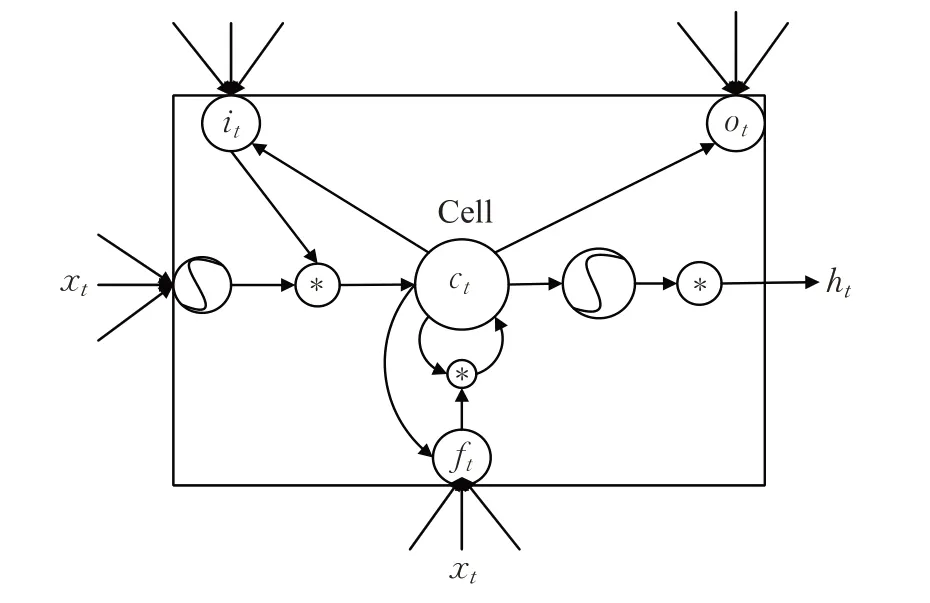

由于語音信號普遍具有長時間的特性,而DNN 在處理語音信號時,經常使用固定語音幀作為輸入,不能利用前后語音幀之間的信息。而LSTM[12]能夠很好地解決上述問題。圖5為基本的LSTM結構。

圖5 LSTM網絡結構

其中xt為輸入,ht表示為當前t時刻的狀態,yt為網絡模型最終輸出。LSTM推導公式如下:

其中,i、o、f、c分別代表結構中的輸入門、輸出門、遺忘門和當前記憶單元;σ(?)表示為sigmoid 激活函數;w·x為輸入層連接的權值矩陣,w·c為與記憶單元連接的權值矩陣。最終得出LSTM的輸出。

BLSTM對每一個訓練序列分別作用一個向前和向后的LSTM 網絡,并且連接著同一個輸出層,這樣使得網絡能夠充分學習到序列的上下文信息。

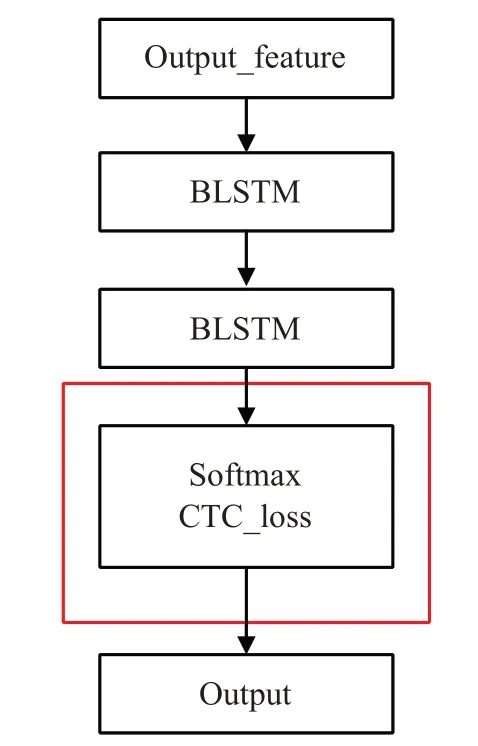

3.3.2 BLSTM模塊設計

語音信號是序列信號,而且序列之間的信息是相互關聯的,因此該模塊選擇BLSTM,每個BLSTM 層的單元大小設置為128,最后用softmax層得到每個字符的最大概率。由于BLSTM在訓練過程中耗時[13-14],且訓練困難,所以本文在該模塊只選擇兩層BLSTM。該模塊如圖6所示。

圖6 BLSTM模塊

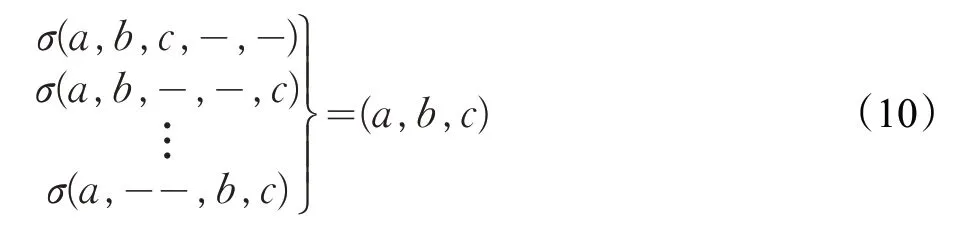

3.3.3 CTC算法

語音識別是一種序列到序列映射的任務,其中X={X1,X2,…,Xt}為輸入序列,Y={Y1,Y2,…,YL}為目標序列。在語音識別中,X是聲信號,Y是字符序列。為了訓練聲學模型,必須使每個輸入對應的輸出概率P(Y|X)最大化。在給定一個輸入序列的情況下,提供一個輸出序列分布的一種方法,該方法將潛在變量序列O={O1,O2,…,Ot}的多到一映射引入作為最終預測的較短序列。某個序列Y的概率定義為所有映射到該序列的潛在序列的概率之和。文獻[15]使用了一種連接時序分類(CTC)的方法,通過對每個時間步長的網絡輸出用softmax 函數來指定潛在序列上的分布,它提供了在該時間步從輸出到標簽字符表中每個字符的概率Pr(Ot|X)。并且在標簽文本中引入了一個額外的空輸出類“blank”,用于表示在特定的時間步長內不輸出字符的概率。每個時間段內可能存在的序列有多條路徑,在計算過程中,首先合并重復的連續非空白標簽,然后刪除空白標簽,其中“blank”類用“ - ”代替,σ(?)表示為輸入到輸出的映射函數,公式如下所示:

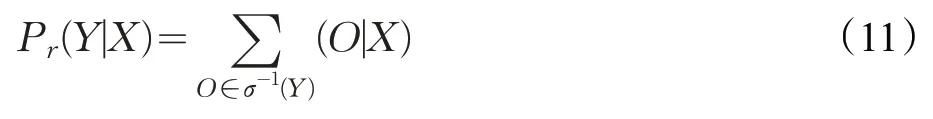

因此最終輸出序列的概率Pr為每條可能出現的路徑概率σ總和:

CTC采用一種類似于HMM[13]模型中的向前的動態規劃算法,能夠有效地計算上述式子。為了使用CTC去預測輸出序列,使用了最好的路徑解碼算法,在給定網絡輸出的情況下,每一幀的輸出是獨立的。因此在每個時間步長中,通過得到每一幀的輸出標簽概率,就能得到概率最大的可能序列。然后將σ(?)函數應用到該序列中,得到預測序列:

其中,Π*是輸出序列最可能的路徑概率,其形式為Π*=arg maxΠPr(Y|X),因為CTC 能夠對于語音信號直接映射到標簽,無需依賴語音音頻和對應標簽序列的一一對齊,因此本文采用CTC對語音信號到中文字符建模。

4 實驗步驟

4.1 實驗數據

本文采用的語音數據為開源語音數據集Aishell-1[16],此數據集都是在真實環境下錄音,包括多名來自中國不同地區的不同發音的參與者共同錄制。環境都是在安靜的室內,一共使用三種不同的設備錄音:高保真麥克風(44.1 kHz,16 bit);Android系統;手機(16 kHz,16 bit);iOS系統手機(16 kHz,16 bit)。本文使用的是采樣率為16 kHz的語音,時長為178 h。其中驗證集為10 h,測試集為5 h。本文將分別在驗證集和測試集上驗證模型的性能。

4.2 模型訓練和優化

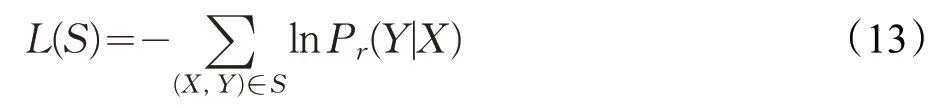

在優化模型的過程中,本文使用的初始學習率為0.01,優化器為Adam,并使用退化學習率的機制,即每循環M次,學習率自動下降0.95。初始權重值設定范圍為[-0.1,0.1],初始偏置值為0.1。同時在訓練過程中,為了防止發生過擬合,本文使用dropout 方法,每層網絡的dropout初始值設定為0.95。并且在計算損失值的過程中,使用L2 正則化去改善擬合。損失函數使用CTC_Loss,具體公式如下:

其中S為訓練集,Pr(Y|X)為上文給定X輸出Y序列的概率。

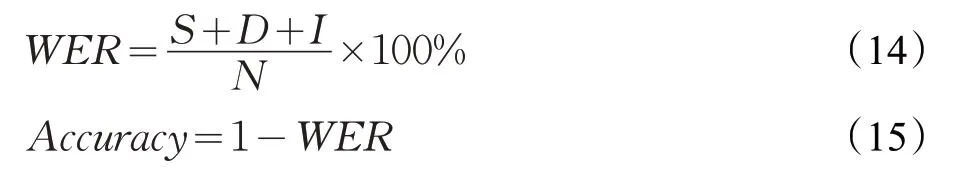

4.3 評估指標參數

本實驗使用的評估指標為字錯誤率(WER),目的是為了檢測識結果的準確性,具體公式如下:

其中,S為替換,D為刪除,I為插入,N為原始語音相應文本的字詞總數。

4.4 實驗平臺

本文實驗均在Ubantu16.04(64 bit)系統上運行。其中深度學習神經網絡框架訓練和測試軟件均為Tensorflow;運行內存為16 GB,GPU設備為4臺GXT1080ti。

5 實驗結果分析

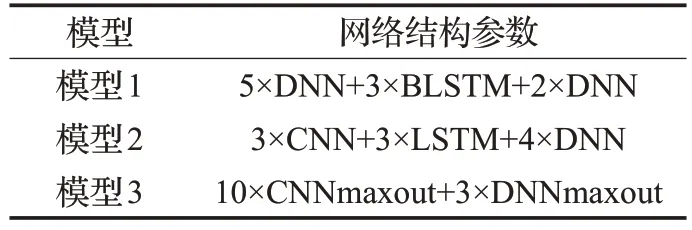

5.1 實驗對比模型參數

為了驗證本文模型的有效性,對比了以下三種端到端識別模型:(1)DNN+BLSTM+CTC 模型[17];(2)CNN+LSTM+DNN+CTC[18]模型;(3)CNNmaxout+DNNmaxout+CTC[11]模型。具體模型結構參數見表1。

表1 模型1-3網絡結構參數

其中模型1中的MFCC特征參數為26維,輸入為前后9 幀加當前幀,一共494 維參數。模型2 的特征為濾波器組特征(Filter bank,Fbank),是將MFCC 最后一步的離散余弦變換去掉而得到的語音特征,其與MFCC特征相比,保留了更多的原始語音數據。模型3和本文模型的輸入均為語譜圖。

5.2 模型性能探究

5.2.1 模型性能比較

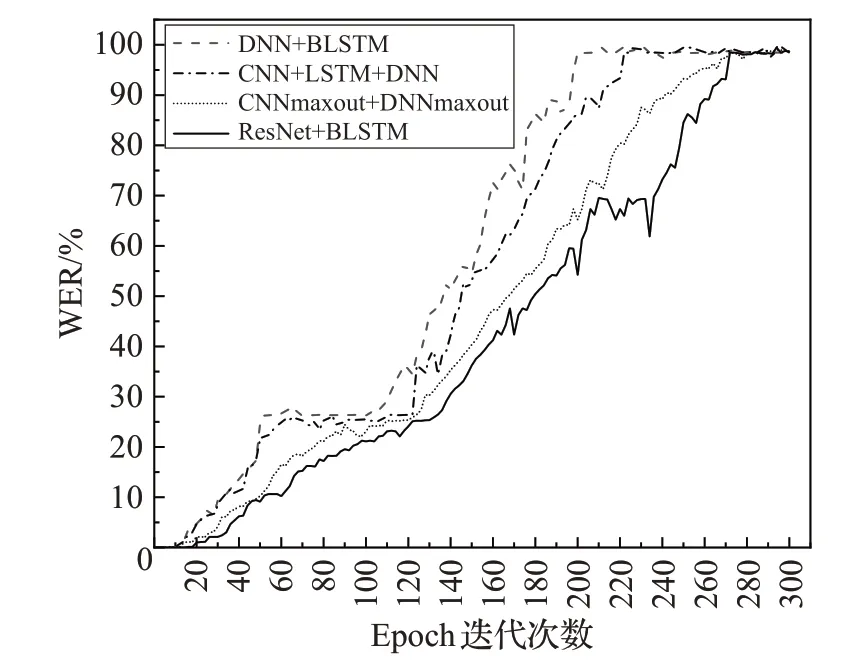

為了探究不同模型的性能,本文先分別在訓練集上訓練4種模型,保存4種模型的7次迭代次數,然后在驗證集做驗證,找出其最優的迭代次數,最后在測試集上做性能測試。圖7為各模型在訓練集上的效果。

圖7 訓練集Epoch迭代次數

從圖7 中可以得出,模型1 和模型2 分別在迭代至200次左右時,模型性能能夠達到最佳。而采用語譜圖作為輸入的模型3和本文模型需要迭代至260次左右才能到達最優性能。這是因為模型3 和本文模型都是通過卷積神經網絡學習語譜圖的特征信息,因此都需要較大的迭代次數。隨著迭代次數的增加,各模型對訓練數據趨于擬合狀態。本實驗共保留迭代次數為150、175、200、225、250、275、300用于驗證集測試。

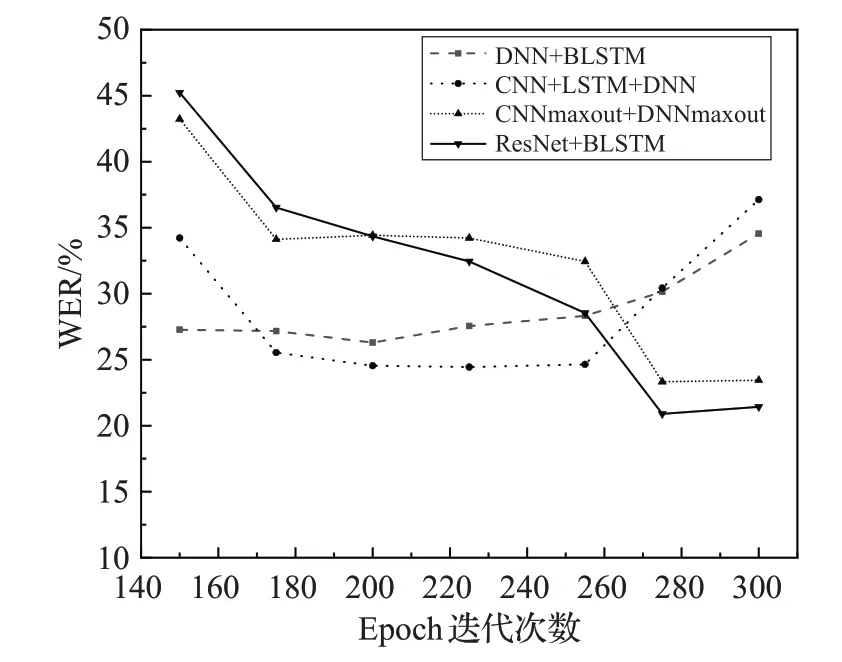

為了找出各模型最佳效果的迭代次數,本文設置了第二組實驗,在驗證集上測試出最優效果,如圖8所示,模型1和2在迭代次數為200、225時效果最優,模型3和本文模型在迭代次數為275時效果最優。

圖8 驗證集性能表現

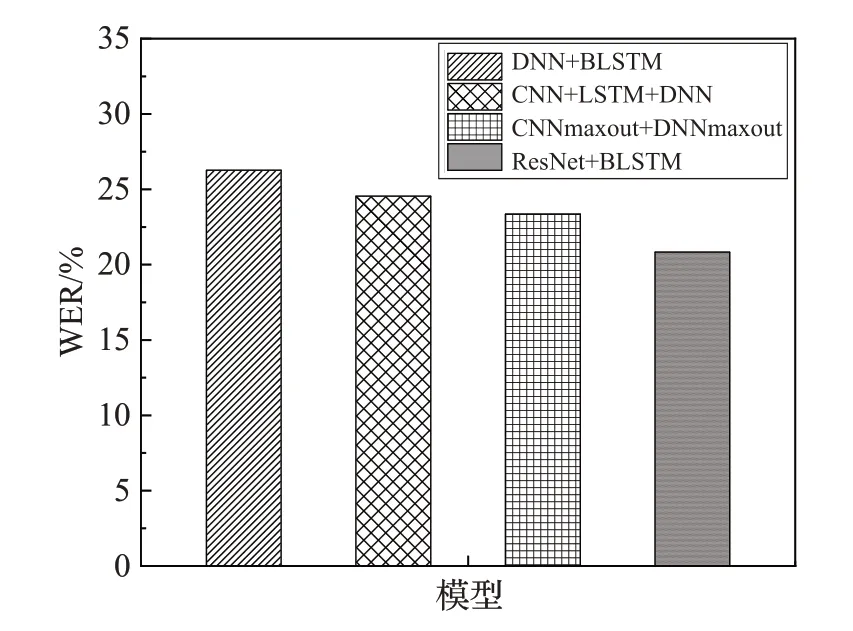

最后設置一組實驗將在驗證集上得到的各模型最好的迭代次數用于測試集上做比較,如圖9所示。

圖9 測試集性能表現

由于本模型使用了殘差結構和并行卷積層,性能和魯棒性均優于其他模型。從表2中可以看到,和其他模型相比較,本文模型WER 分別下降了5.43%、3.71%、2.52%。

表2 各模型的表現結果

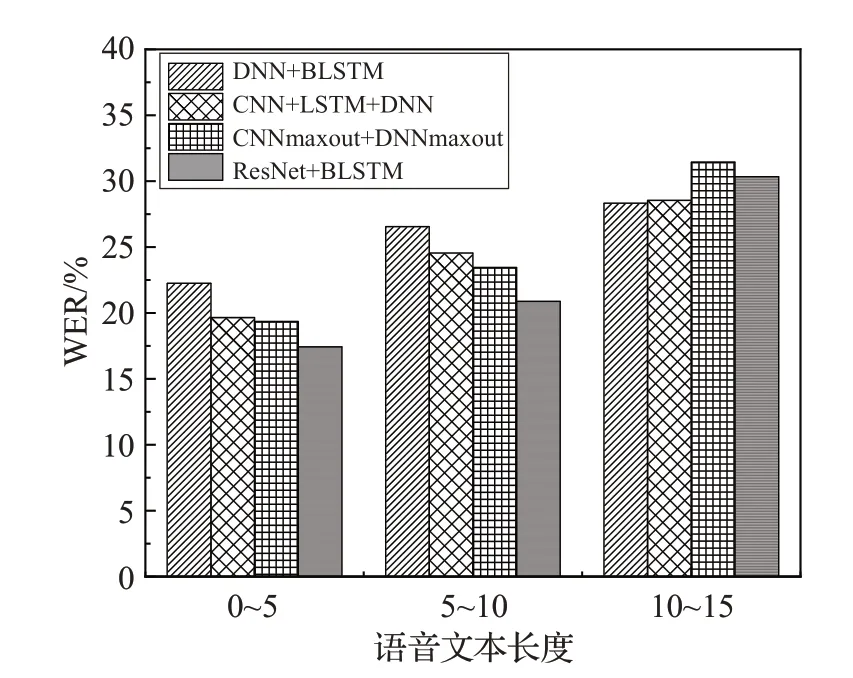

5.2.2 語音文本字數長度

由于語音識別性能也易受到語音文本字數長度的影響,比如一段語音的字數過長,易導致識別效果下降。因此本文設置一組實驗,探究各模型對于不同長度語音字數的識別效果。在本實驗中,測試集文本長度有三組,分別為[0~5]、[5~10]、[10~15]。測試結果為平均值,實驗結果如圖10所示。

圖10 語音字數長度對WER的影響

從圖10中可以得出,本文提出的模型在[0~5]、[5~10]語音字數長度范圍內,表現出優于其他模型的性能;而在[10~15]范圍內時,識別性能有所下降。產生上述的原因可能是由于本文使用的輸入是語譜圖,因此在限定語譜圖大小的情況下,本文模型不利于連續的長語音片段識別。解決的方法:擴展語譜圖大小,以及設置更深的卷積層提取特征信息。

6 結束語

本文提出了一種用于端到端語音識別模型:由ResNet 和BLSTM 構成,并以語譜圖作為輸入。該模型相較于另外幾類端到端模型,本文提出的模型總體性能均優于其他模型。但該模型的缺點是不易訓練連續的長語音。此后,下一步工作會在該模型做進一步的優化,以及在帶噪聲的語音集下進行訓練和測試。