基于多分辨率時(shí)頻特征融合的聲學(xué)場(chǎng)景分類

姚 琨,楊吉斌,張雄偉,鄭昌艷,孫 蒙

(陸軍工程大學(xué),江蘇南京210007)

0 引 言

智能系統(tǒng)要想充分利用聲音信息,不僅要識(shí)別語(yǔ)音[1]和音樂(lè)[2]等單一的聲音信號(hào),還要充分利用周圍環(huán)境中的聲音信息,聲學(xué)場(chǎng)景分類(Acoustic Scenes Classification, ASC)的目的就是利用周圍環(huán)境中的聲音信息對(duì)預(yù)先定義的有限場(chǎng)景類型進(jìn)行分類。近幾年,ASC已經(jīng)成為聲學(xué)場(chǎng)景和事件的分類和檢測(cè)(Detection and Classification of Acoustic Scenes and Events, DCASE)挑戰(zhàn)賽中最熱門的任務(wù)之一[3-6],在智能穿戴設(shè)備的自動(dòng)模式調(diào)整等方面有著廣泛的應(yīng)用前景。

ASC的目的是通過(guò)選擇一個(gè)語(yǔ)義標(biāo)簽來(lái)描述音頻流表達(dá)的聲學(xué)環(huán)境,是機(jī)器學(xué)習(xí)中典型的單標(biāo)簽分類任務(wù)。與一般的音頻分類任務(wù)類似,ASC任務(wù)的關(guān)鍵就在于模型設(shè)計(jì)和音頻信號(hào)特征選取兩個(gè)方面。

在特征選取方面,多采用音頻信號(hào)的二維時(shí)頻表示,時(shí)間軸以幀為單位構(gòu)造長(zhǎng)幀,頻率軸為幀信號(hào)短時(shí)傅里葉變換的降維表示。其中最為典型的有梅爾頻率倒譜系數(shù)(Mel-Frequency Cepstral Coefficients, MFCC)[7]、對(duì)數(shù)梅爾子帶能量(Log Mel-band energies, LME)等特征。它們都是對(duì)音頻信號(hào)譜包絡(luò)的整體描述,同時(shí)經(jīng)梅爾濾波器處理過(guò)后符合人的聽(tīng)覺(jué)感受,具有較好的區(qū)分度和魯棒性。

文獻(xiàn)[8]對(duì)場(chǎng)景音頻信號(hào)的聲譜圖進(jìn)行非負(fù)矩陣分解(Non-negative Matrix Factorization, NMF),輸出一組激活函數(shù)。這組激活函數(shù)對(duì)基函數(shù)的貢獻(xiàn)進(jìn)行編碼,從而對(duì)聲學(xué)場(chǎng)景的屬性進(jìn)行建模。

在分類模型方面,由于 ASC是語(yǔ)音識(shí)別和音樂(lè)識(shí)別的拓展研究,在這些任務(wù)中廣泛使用的模型[9-10]也被應(yīng)用到ASC任務(wù)中,如隱馬爾可夫模型(Hidden Markov Model, HMM)、高斯混合模型(Gaussian Mixed Model, GMM)和支持向量機(jī)(Support Vector Machine, SVM)。近年來(lái),由于深度神經(jīng)網(wǎng)絡(luò)對(duì)非線性問(wèn)題強(qiáng)大的表征能力,在語(yǔ)音和圖像方面取得巨大的成功,人們開(kāi)始把深度學(xué)習(xí)的方法應(yīng)用到了 ASC任務(wù)中來(lái),包括深度神經(jīng)網(wǎng)絡(luò)(Deep Neural Network, DNN)、卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Network, CNN)、循環(huán)神經(jīng)網(wǎng)絡(luò)(Recurrent Neural Network, RNN)等。

Eghbal-Zadeh等[11]提出了兩種方案并且包攬DCASE 2016中ASC任務(wù)的前兩名。第一種方案是用音頻信號(hào)左聲道、右聲道、兩聲道的均值和差值4種MFCC特征分別訓(xùn)練身份認(rèn)證矢量(Identity Vector,i-vector),最后以分類得分的均值作為結(jié)果輸出。第二種方案是在第一種方案的基礎(chǔ)上,融合以聲譜圖為特征的CNN網(wǎng)絡(luò)。Zheng等[12]在對(duì)音頻信號(hào)進(jìn)行短時(shí)傅里葉變換時(shí),通過(guò)改變滑動(dòng)窗的寬度、FFT的點(diǎn)數(shù)、窗的重疊量、降維的尺度等提取不同的聲譜圖特征,并融合常數(shù)Q變換(Constant Q Transform, CQT)特征訓(xùn)練CNN模型。Han等[13]以LME為基礎(chǔ),從左右聲道、左右聲道和或差的音頻中提取LME及單聲道諧波和沖擊響應(yīng)特征等,分別訓(xùn)練視覺(jué)幾何組(Visual Geometry Group, VGG)結(jié)構(gòu)的模型,最后取所有模型分類精度的均值作為最終輸出。

雖然以上方案都取得了較好的分類效果,但還存在以下幾個(gè)問(wèn)題:

(1) 聲譜圖特征的維度過(guò)高,需要以更深層的網(wǎng)絡(luò)以及更大的數(shù)據(jù)量作為支撐,極大地耗費(fèi)計(jì)算資源,且含有大量的冗余信息,類別間的區(qū)分度也不夠高。

(2) 單一的低維度特征對(duì)音頻信號(hào)的表征能力有限,現(xiàn)有的特征融合方法可解釋性較差。

(3) 分類模型不具針對(duì)性,將在圖像任務(wù)中表現(xiàn)較好的模型(如VGG等)進(jìn)行簡(jiǎn)單的移植,并不能考慮到ASC任務(wù)中輸入聲音特征的時(shí)頻結(jié)構(gòu)。

為解決以上問(wèn)題,本文以 CNN為基本識(shí)別模型,在時(shí)頻特征基礎(chǔ)上進(jìn)行了包絡(luò)/結(jié)構(gòu)特征融合、適應(yīng)時(shí)頻結(jié)構(gòu)特征的多分辨率模型設(shè)計(jì)等融合處理。模型方面,本文基于CNN模型提出一種適應(yīng)聲音時(shí)頻結(jié)構(gòu)的多分辨率卷積池化方案,并構(gòu)造多分辨率卷積神經(jīng)網(wǎng)絡(luò)(Multi-resolution Convolutional Neural Network, MCNN)模型;特征選擇方面,采用低級(jí)包絡(luò)特征LME輔以高級(jí)結(jié)構(gòu)特征NMF,在特征表征能力增強(qiáng)的同時(shí),數(shù)據(jù)量及冗余信息增加較少,從而在模型和特征兩方面共同完成對(duì)時(shí)頻特征的融合。在DCASE2017和DCASE2018數(shù)據(jù)集上進(jìn)行實(shí)驗(yàn),結(jié)果驗(yàn)證了本文提出方案的有效性。

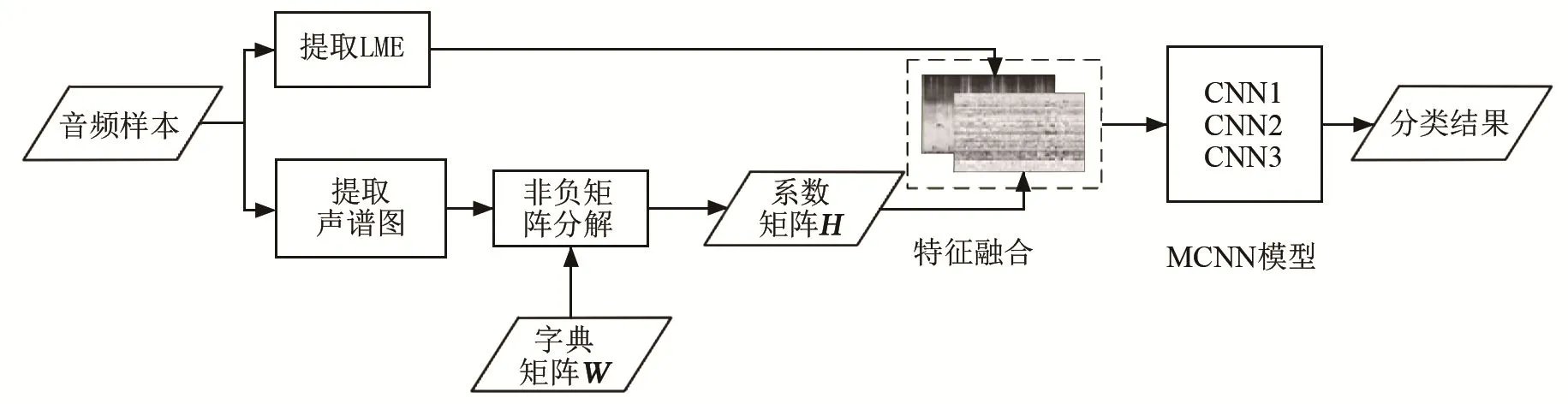

1 方案框架

本文采用特征提取-模型分類的實(shí)現(xiàn)框架。聲音特征提取和模型分類系統(tǒng)的流程框圖如圖1所示。特征提取部分分為兩個(gè)分支,分別提取 LME特征和NMF特征。提取NMF特征時(shí),首先提取音頻樣本的聲譜圖特征,然后利用由所有訓(xùn)練集樣本訓(xùn)練得到的字典矩陣W,對(duì)提取到的聲譜圖特征進(jìn)行NMF,得到系數(shù)矩陣H作為NMF特征。特征融合部分,借鑒圖像任務(wù)中 RGB三通道的方法,把二維的LME和NMF特征堆疊為三維特征。最后把得到的三維特征送入MCNN模型得到分類結(jié)果。實(shí)驗(yàn)證明,對(duì)于這兩類特征,本文的融合方法要優(yōu)于簡(jiǎn)單拼接和模型結(jié)果融合的方法。

圖1 聲音特征提取和模型分類系統(tǒng)的流程框圖Fig.1 Block diagram of voice feature extraction and model classification system

2 MCNN模型

2.1 適應(yīng)聲音時(shí)頻結(jié)構(gòu)的CNN框架

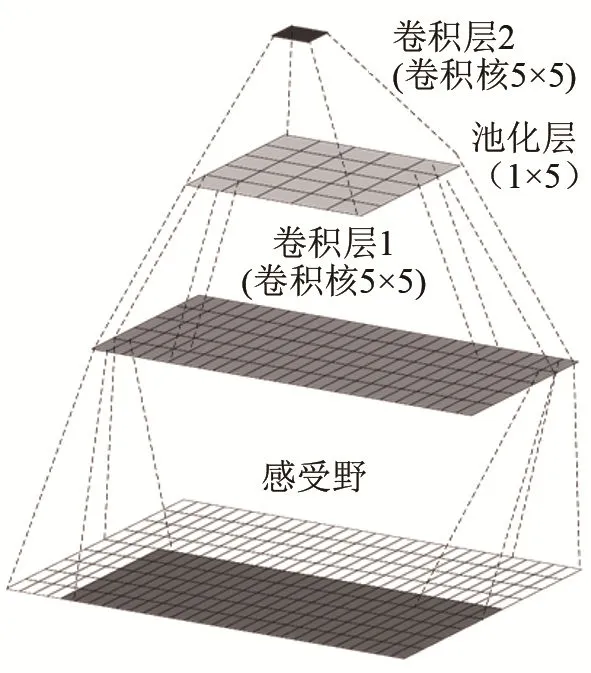

對(duì)聲音信號(hào)進(jìn)行短時(shí)處理后,其前后相鄰幀的頻譜分布高度相關(guān),而頻率軸上在經(jīng)過(guò)后續(xù)提取手工特征時(shí)的降維處理后,彼此相對(duì)獨(dú)立。針對(duì)這一特點(diǎn),基于 CNN框架,提出一種適應(yīng)聲音時(shí)頻結(jié)構(gòu)的池化策略,即池化操作時(shí)只沿著時(shí)間軸進(jìn)行(頻率軸采樣因子為1),并且在經(jīng)過(guò)兩次池化后,特征在時(shí)間軸上維度變?yōu)?而頻率軸維度保持不變。依此方法,可以設(shè)計(jì)出適應(yīng)聲音時(shí)頻結(jié)構(gòu)的CNN模型。

圖2為本文模型第二層卷積的卷積核在輸入特征圖上的感受野示意圖,深色部分為實(shí)際特征圖,白色為“補(bǔ)0”部分。由圖2可知,CNN提取到的高級(jí)特征是由輸入特征圖感受野上的數(shù)據(jù)經(jīng)過(guò)卷積層加權(quán)求和及池化層采樣得到的,卷積核在輸入特征圖上感受野的范圍取決于卷積核和池化窗的大小及形狀。采用帶狀的感受野,可以更好地適應(yīng)輸入特征圖的時(shí)頻結(jié)構(gòu)。

圖2 時(shí)頻感受野示意圖Fig.2 Schematic diagram of time-frequency sensing field

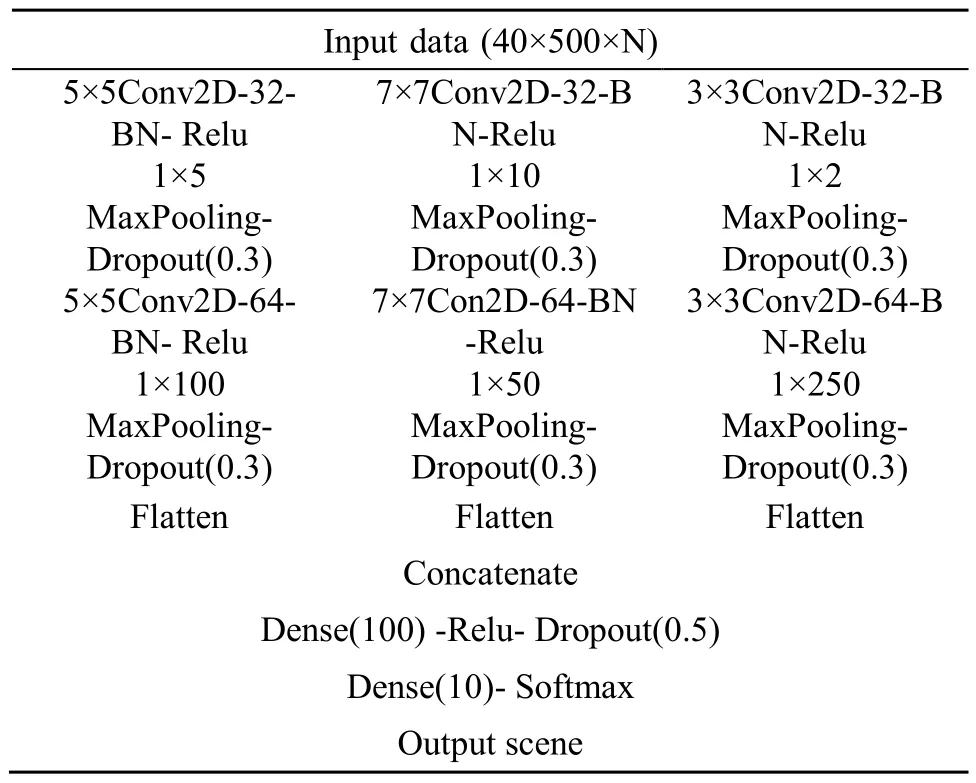

2.2 MCNN

改變卷積核和池化窗的大小會(huì)影響 CNN提取到的高級(jí)特征,從而直接影響到分類結(jié)果。采用不同大小的卷積核和池化窗可以捕捉到更全面的信息,小的卷積核和池化窗對(duì)應(yīng)輸入特征小的感受野,從而可以捕捉到特征圖上的細(xì)節(jié)信息,大的卷積核和池化窗則相反,二者互為補(bǔ)充。

為此,我們?cè)?CNN中采用不同尺寸的卷積核和池化窗組合,力求同時(shí)捕捉細(xì)節(jié)和宏觀信息。由于第二層卷積輸出的高級(jí)特征來(lái)自于不同的子模型,每個(gè)子模型輸出特征由同一輸入特征圖上不同大小的感受野提取得到,所以稱之為多分辨率卷積神經(jīng)網(wǎng)絡(luò)(MCNN),模型結(jié)構(gòu)和參數(shù)如表1所示。其中,在輸入層分別采用了5×5卷積+1×5池化、7×7卷積+1×10池化、3×3卷積+1×2池化操作,在中間層分別采用了5×5卷積+1×100池化、7×7卷積+1×50池化、3×3卷積+1×250池化。這些參數(shù)都是經(jīng)過(guò)組合實(shí)驗(yàn)優(yōu)選出來(lái)的結(jié)果。

表1 MCNN模型結(jié)構(gòu)Table 1 MCNN model structure

3 特征選取

LME特征能反映聲譜圖幀內(nèi)各頻帶的局部統(tǒng)計(jì)特性,對(duì)ASC任務(wù)中的音頻樣本有較好的低維表征能力,在近年來(lái)的ASC任務(wù)中使用最為廣泛[13-14]。因此本文對(duì)特征的研究以LME為基礎(chǔ),針對(duì)LME特征的不足,提出LME與NMF特征的融合思路。

3.1 LME特征

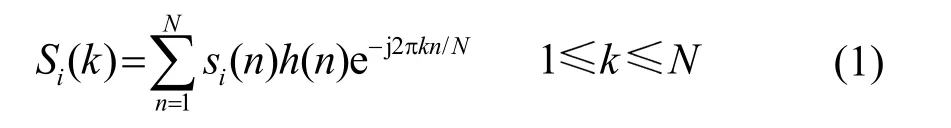

把音頻信號(hào)分幀、加窗后,對(duì)每幀信號(hào)進(jìn)行離散傅里葉變換,可得:

其中:si(n)為第i幀時(shí)域信號(hào),h(n)為長(zhǎng)度為N的短時(shí)窗系數(shù),N是離散傅里葉變換的長(zhǎng)度。

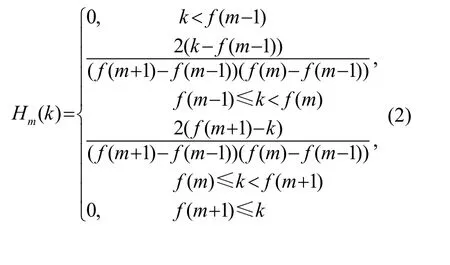

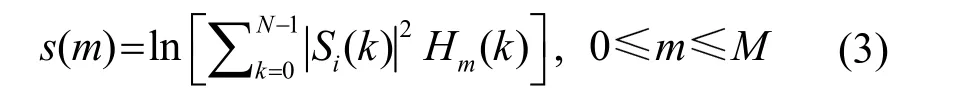

計(jì)算每個(gè)濾波器輸出的對(duì)數(shù)能量:

最后構(gòu)成的特征圖橫軸為時(shí)間軸,縱軸為各個(gè)濾波器下輸出的對(duì)數(shù)能量,維度等于濾波器個(gè)數(shù)。

3.2 NMF特征

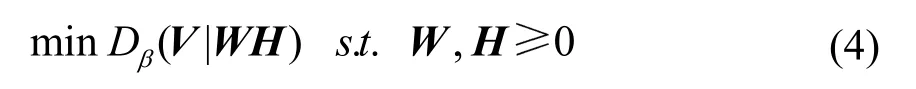

NMF是一種無(wú)監(jiān)督的矩陣分解方法,它使分解后的所有分量均為非負(fù)值,并且同時(shí)實(shí)現(xiàn)非線性的維數(shù)約減。給定一個(gè)非負(fù)矩陣V,它的目標(biāo)就是分解得到一個(gè)非負(fù)的字典矩陣W和一個(gè)系數(shù)矩陣H,即求解如下優(yōu)化問(wèn)題:

其中,Dβ表示分離方式。本文中,我們把β設(shè)為2,則Dβ為歐氏距離。利用NMF得到的系數(shù)矩陣,作為NMF特征使用。

3.3 融合特征

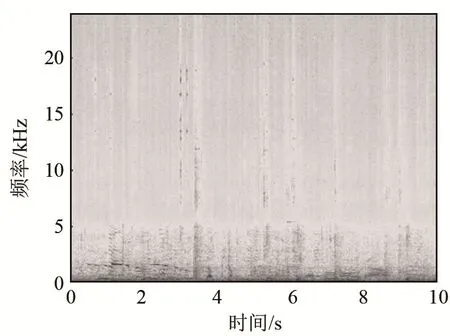

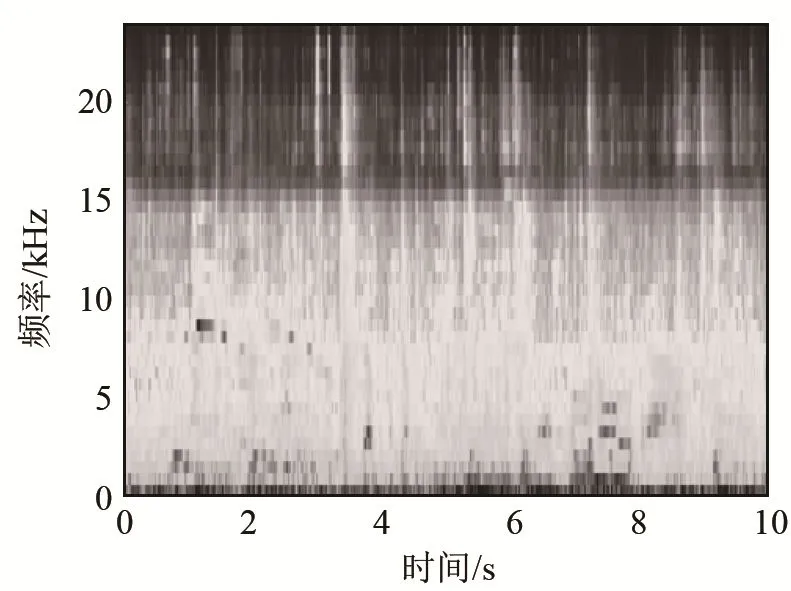

LME特征每一維都對(duì)應(yīng)相應(yīng)Mel濾波器輸出的對(duì)數(shù)能量,在較好地表征音頻信號(hào)的同時(shí),降低了對(duì)應(yīng)聲譜圖的維數(shù),去除了大量冗余信息,減輕了計(jì)算復(fù)雜度。但是,使用Mel濾波器對(duì)聲譜圖進(jìn)行平滑處理使得諧波結(jié)構(gòu)(如圖 3 中的機(jī)場(chǎng)音頻樣本聲譜圖的低頻部分)這樣的細(xì)節(jié)不再顯著。圖 4為該樣本經(jīng)過(guò)40維Mel濾波器組后的輸出圖像。從圖4可以看出,原本低頻部分存在的明顯的諧波結(jié)構(gòu)已經(jīng)完全無(wú)法觀察到。實(shí)際上,Mel濾波器組對(duì)其相應(yīng)頻帶內(nèi)頻譜幅度進(jìn)行了加權(quán)求和,從而實(shí)現(xiàn)降維處理,這就導(dǎo)致不同的頻譜可能對(duì)應(yīng)相同的濾波器輸出,造成不同類別音頻信號(hào)的 LME特征在某些子區(qū)域上很可能相似或相同。

圖3 機(jī)場(chǎng)音頻樣本聲譜圖Fig.3 Spectrogram of airport audio sample

圖4 LME特征圖Fig.4 LME feature map

有效彌補(bǔ) LME特征中丟失的細(xì)節(jié),可以將聲譜圖上的典型諧波結(jié)構(gòu)作為細(xì)節(jié)信息補(bǔ)充上去,以增加原始LME特征的區(qū)分度。為此,提出一種為細(xì)節(jié)特征與整體效果特征相融合的辦法,對(duì)聲譜圖進(jìn)行非負(fù)矩陣分解,之后將系數(shù)矩陣作為細(xì)節(jié)特征和LME特征相融合,在較少增加數(shù)據(jù)量和冗余信息的同時(shí)使得提取的特征具有更強(qiáng)的魯棒性。

NMF特征采用乘性更新規(guī)則來(lái)優(yōu)化提取。特征提取過(guò)程如下:

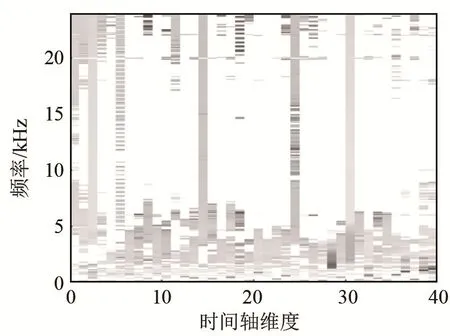

(1) 把聲譜圖矩陣作為待分解矩陣(1 025×500),將所有訓(xùn)練集樣本的聲譜圖擴(kuò)展成1 025×500N的二維矩陣,其中N為訓(xùn)練集的樣本數(shù)。采用NMF,提取時(shí)間軸上的基,分解得到大小為1 025×40的字典矩陣W,如圖5所示。圖5橫軸上的每一維(時(shí)間軸上的每一維)對(duì)應(yīng)為字典的一個(gè)基。

圖5 字典矩陣WFig.5 Dictionary matrix W

(2) 固定由步驟(1)得到的字典矩陣W,對(duì)每個(gè)樣本的聲譜圖矩陣作NMF,得到40×500的非負(fù)矩陣系數(shù)H,如圖6所示。這個(gè)矩陣H作為樣本特征的一部分使用。

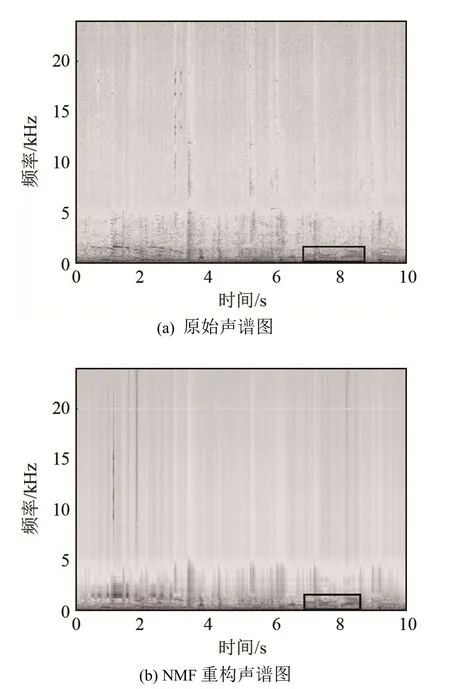

NMF分解得到的系數(shù)矩陣H保持了聲譜的低頻細(xì)節(jié)結(jié)構(gòu)。圖7為原始聲譜圖和NMF重構(gòu)的聲譜圖。對(duì)比圖 7(a)、7(b)可以看出,重構(gòu)聲譜圖在高頻部分存在一定的失真,而低頻部分的譜細(xì)節(jié)還原較好。從矩形框中的部分可以看出,聲譜圖低頻段的諧波結(jié)構(gòu)基本沒(méi)有失真。因此,利用系數(shù)矩陣H,可以構(gòu)造表征細(xì)節(jié)的低維特征。

圖6 系數(shù)矩陣HFig.6 Coefficient matrix H

圖7 原始聲譜圖和NMF重構(gòu)聲譜圖Fig.7 Original spectrogram and NMF reconstructed spectrogram

4 實(shí)驗(yàn)結(jié)果與分析

采用對(duì)比實(shí)驗(yàn)的方法,分別驗(yàn)證所提出的LME+NMF融合特征和MCNN模型對(duì)ASC任務(wù)的有效性,并對(duì)實(shí)驗(yàn)結(jié)果進(jìn)行分析比較。

4.1 實(shí)驗(yàn)數(shù)據(jù)

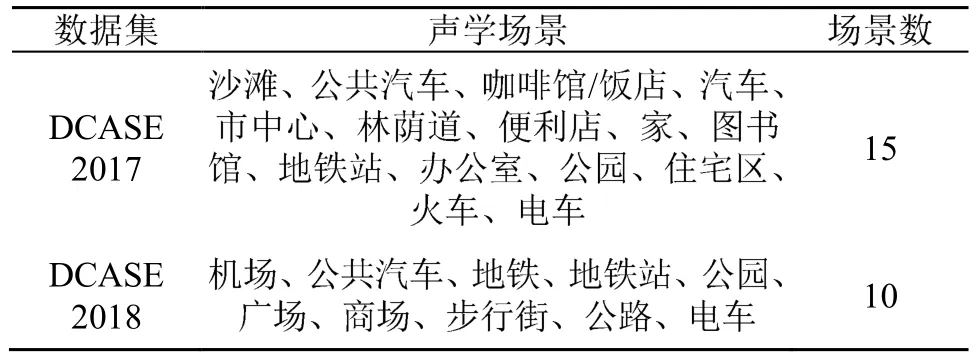

表2給出了DCASE2017和DCASE2018數(shù)據(jù)集包含的聲學(xué)場(chǎng)景類別及場(chǎng)景數(shù)。

在DCASE2017的ASC任務(wù)中,開(kāi)發(fā)集提供了包括15個(gè)真實(shí)聲學(xué)場(chǎng)景的4 680個(gè)音頻樣本。每個(gè)場(chǎng)景的樣本都記錄于不同的地點(diǎn),每個(gè)地點(diǎn)記錄18~25 個(gè)樣本,所有樣本都是采樣率為44.1 kHz、持續(xù)時(shí)間為10 s的雙聲道音頻[15],分配在4個(gè)折疊當(dāng)中。折疊為樣本的構(gòu)成方式,用來(lái)做交叉驗(yàn)證。以4折交叉驗(yàn)證為例,每次取1/4作測(cè)試,剩余3/4做訓(xùn)練。用4次結(jié)果的均值來(lái)衡量模型的性能好壞。

在DCASE2018的ASC任務(wù)中,開(kāi)發(fā)集提供了包括10個(gè)真實(shí)聲學(xué)場(chǎng)景的8 640個(gè)音頻樣本。這些樣本記錄于6個(gè)歐洲城市的不同地點(diǎn),每個(gè)地點(diǎn)記錄30~36個(gè)樣本,所有樣本都是采樣率為48 kHz、持續(xù)時(shí)間為10 s的雙聲道音頻[4],全部分配在一個(gè)折疊當(dāng)中。

表2 實(shí)驗(yàn)使用的聲學(xué)場(chǎng)景數(shù)據(jù)集Table 2 Acoustic Scene Datasets in the Experiments

4.2 基線系統(tǒng)

DCASE2017的基線系統(tǒng)是一個(gè)多層感知機(jī)模型,包含兩層隱藏單元為 50的全連接層,隱層和輸出層激活函數(shù)分別為Relu和Softmax,損失函數(shù)為交叉熵,學(xué)習(xí)率為0.001,優(yōu)化器為Adam[16]。輸入樣本為單聲道40維、500幀(10 s)的LME特征圖,每幀長(zhǎng)40 ms且有50%重疊。

DCASE2018的基線系統(tǒng)是一個(gè)包含兩層卷積和兩層全連接的CNN模型,卷積核大小為7×7,步長(zhǎng)為 1,padding方式為 same,池化方式為最大池化,同時(shí)采用批量標(biāo)準(zhǔn)化和dropout,其余參數(shù)設(shè)置和DCASE2017基線系統(tǒng)相同。

4.3 結(jié)果分析

4.3.1 MCNN模型效果

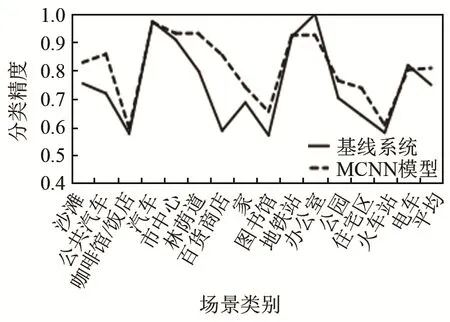

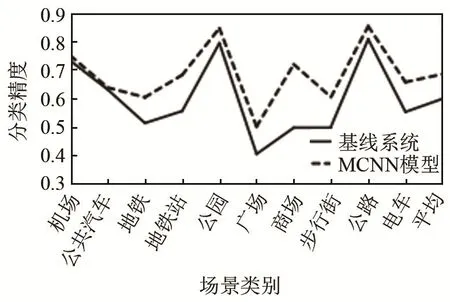

為驗(yàn)證MCNN模型的效果,用MCNN模型分別與2017年和2018年的基線系統(tǒng)進(jìn)行對(duì)比。實(shí)驗(yàn)中除模型外其余設(shè)置全部和基線系統(tǒng)相同,結(jié)果如圖8和圖9所示。

從圖 8和圖 9可以看出,MCNN模型在DCASE2017和DCASE2018數(shù)據(jù)集上都有較好的表現(xiàn),在大多數(shù)聲學(xué)場(chǎng)景類別上分類精度都有明顯提高,在少數(shù)幾個(gè)聲學(xué)場(chǎng)景類別上和基線系統(tǒng)表現(xiàn)類似,平均分類精度都得到了明顯提升,分別提升了5.9%和8.6%。

圖8 MCNN模型與基線系統(tǒng)在DCASE2017數(shù)據(jù)集上的分類精度對(duì)比Fig.8 Comparison of classification accuracy between MCNN model and baseline system on DCASE2017 dataset

圖9 MCNN模型與基線系統(tǒng)在DCASE2018數(shù)據(jù)集上的分類精度對(duì)比Fig.9 Comparison of classification accuracy between MCNN model and baseline system on DCASE2018 dataset

圖10為基線系統(tǒng)和MCNN模型在DCASE2018數(shù)據(jù)集上的損失(Loss)曲線,可以看到,MCNN模型的損失曲線整體都位于基線系統(tǒng)損失曲線下方,說(shuō)明模型在收斂效果方面要優(yōu)于基線系統(tǒng)。

圖10 MCNN模型與基線系統(tǒng)在DCASE2018數(shù)據(jù)集的損失曲線Fig.10 Loss curves of MCNN model and baseline system on DCASE2018 dataset

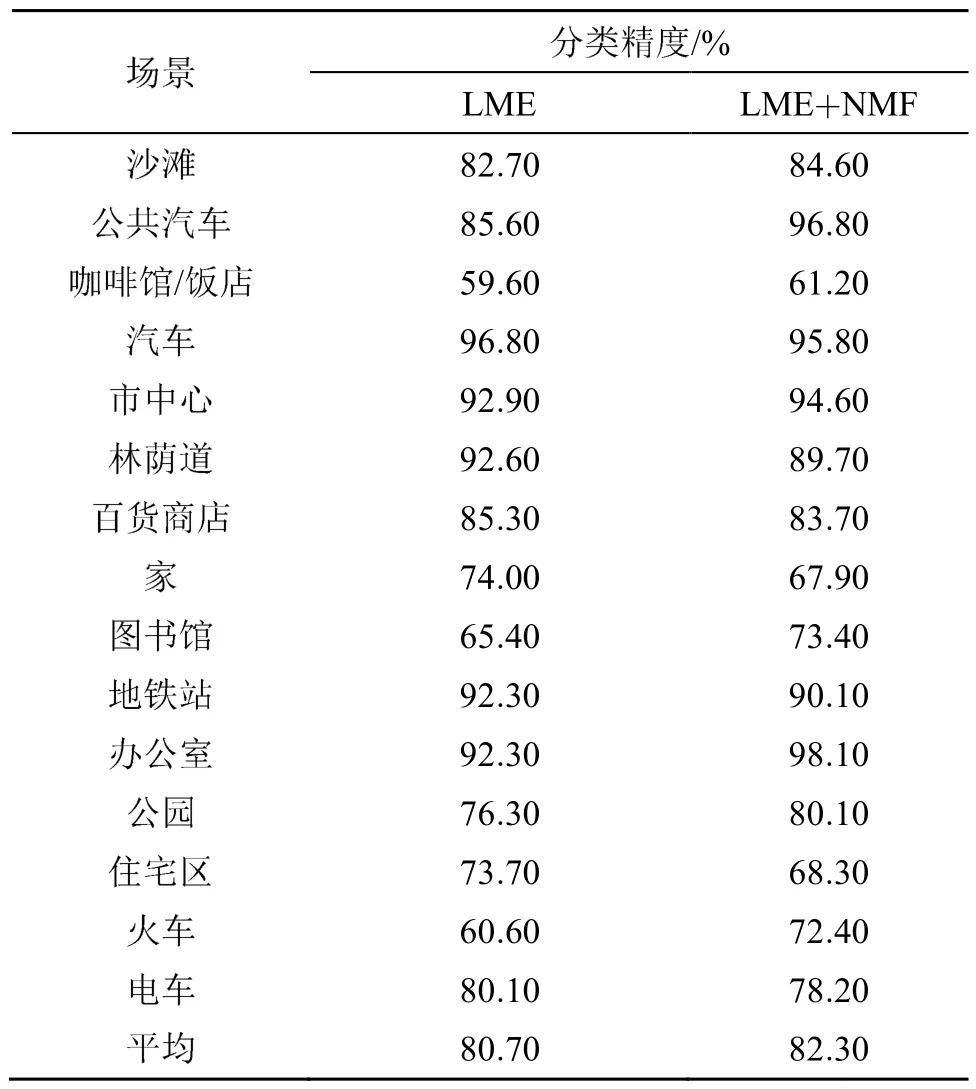

4.3.2 融合特征效果

為驗(yàn)證融合NMF特征和LME特征對(duì)分類效果的影響,在MCNN模型下分別使用40×500的LME特征和 40×500×2的融合特征進(jìn)行對(duì)比實(shí)驗(yàn),同樣采用DCASE2017和DCASE2018數(shù)據(jù)集。

對(duì)比實(shí)驗(yàn)結(jié)果如表3和表4所示。可以看出,在DCASE2017數(shù)據(jù)集上,融合特征在15個(gè)類別中的 8個(gè)類別上相對(duì) LME特征精度有所提高;在DCASE2018數(shù)據(jù)集上,融合特征在10個(gè)類別中的7個(gè)類別上相對(duì)LME特征精度有所提高,且平均分類精度分別提高了1.6%和1.7%。相比于基線系統(tǒng),本文提出方案的平均分類精度分別提高了 7.5%和10.3%,用DCASE2017測(cè)試集數(shù)據(jù)進(jìn)行測(cè)試,基線系統(tǒng)精度為61%,本文提出方案的精度為68.1%,提高了7.1%。

表3 DCASE2017數(shù)據(jù)集上的分類結(jié)果Table 3 Classification results on DCASE2017 dataset

表4 DCASE2018數(shù)據(jù)集上的分類結(jié)果Table 4 Classification results on DCASE2018 dataset

5 結(jié) 論

本文針對(duì)聲學(xué)場(chǎng)景分類任務(wù),提出一種低維度的特征融合機(jī)制,融合了低層次的 LME特征和高層次的NMF特征,得到一種既包含整體包絡(luò)信息又包括細(xì)節(jié)諧波結(jié)構(gòu)信息的特征;提出適應(yīng)于聲音時(shí)頻結(jié)構(gòu)的多分辨率特征融合的 MCNN模型,使得模型可以從特征圖中學(xué)習(xí)到更全面的信息。在DCASE2017和DCASE2018數(shù)據(jù)集上的實(shí)驗(yàn)結(jié)果表明,分類精度得到了顯著提升,驗(yàn)證了本文所提方法的有效性。