融合情感符號的自注意力BLSTM情感分析

劉臣 方結 郝宇辰

摘 要:利用深度學習方法進行情感分析時,將文本作為一個整體進行編碼,缺乏對表情符號與情感詞的有效關注。而傳統基于詞典的方法則過分依賴于情感詞典與判斷規則的質量,不能充分考慮文本深層語義關系。針對該問題,構建融合表情符號與情感詞的自注意力模型。通過BLSTM訓練得到情感符號,并與文本特征向量融合,同時引入結構化自注意力機制識別文本中不同情感符號的情感信息。在NLPCC2014和微博公開語料數據集上的實驗表明,相較傳統情感分析方法,該模型可有效提高情感分類準確率。

關鍵詞:情感分析;情感符號;注意力機制;雙向長短期記憶網絡

DOI:10. 11907/rjdk. 191707

中圖分類號:TP301 ? 文獻標識碼:A??????????????? 文章編號:1672-7800(2020)003-0039-05

Self-attention BLSTM Emotion Analysis with Emotion Symbols

LIU Chen, FANG Jie, HAO Yu-chen

(School of Management, University of Shanghai For Science and Technology,Shanghai 200093,China)

Abstract: In current emotion analysis tasks, deep learning usually encodes the text as a whole and lacks effective attention to emoticons and emotion words. The traditional dictionary-based approach relies too much on the quality of affective dictionaries and judgment rules and fails to fully consider the deep semantic relationship of texts. In this paper, a self-attention model integrating emoticons and emoticons is constructed, and emoticons and text features are obtained through BLSTM learning for fusion. At the same time, the self-attention mechanism is introduced to recognize the emotional information of different emotive symbols in the text. Experiments on NLPCCW 2014 and the Weibo public corpus data set show that compared with previous methods of emotion analysis, the model in this paper can effectively improve the accuracy of emotion classification.

Key Words: emotional analysis;emoticons;attention mechanism; bidirectional long short-term memory network

0 引言

情感分析,也稱為觀點挖掘,其目的是對特定文本進行分析處理,挖掘其中蘊含的情感色彩[1]。作為自然語言處理(NLP)的重要分支,情感分析受到越來越多的關注。隨著互聯網行業的發展、微博社交平臺的推廣,網絡中產生了大量短文本信息數據。分析微博內容是否包含用戶主觀情感、包含哪種極性的情感,對研究微博信息傳播機制與動態、突發事件趨勢預測,甚至股票市場預測均有重要意義[2-3]。

現有微博情感分析方法主要可分為3種:基于情感詞典的方法、傳統機器學習方法與深度學習方法。基于情感詞典的方法首先構建微博情感分析知識庫,包括情感詞典、短語詞典、表情符號詞典、句法依存關系規則庫[1],然后利用知識庫對微博情感進行聚合計算[4]。基于特征分類的機器學習方法首先進行特征工程,構建微博情感分類特征集;然后利用有監督的機器學習方法對情感博情緒進行分類[5]。其使用的特征集包括n-gram特征、詞性特征、句法依存關系特征、TF-IDF特征。常用于微博情感分析的機器學習方法包括樸素貝葉斯方法、支持向量機、條件隨機場,以及集成學習方法等[6]。首先基于深度學習的方法對微博文本進行分詞,將詞匯表示為詞向量的形式;然后構建深度神經網絡模型抽取微博文本語義,構建微博情感表征向量;最后進行情感分類。常用深度學習模型包括循環神經網絡、卷積神經網絡等。文獻[7]利用雙向長短期記憶網絡模型針對微博用戶負面情緒進行分析,將其分為憤怒、 悲傷和恐懼3種;文獻[8]利用卷積神經網絡模型進行微博情感傾向性分析;文獻[9]將不同特征信息結合形成不同的網絡輸入,構建多通道卷積神經網絡用于微博情感分類。為提高模型情感語義抽取能力,研究者在深度學習模型中引入了多種更復雜的機制,例如注意力機制、深度記憶網絡等。

注意力機制最早用于處理圖像信息,Mnih等[10]根據人腦會集中關注自己感興趣的事物的特點,通過計算注意力概率分布,對關鍵性輸入進行突出表達,從而提高了圖像分類效果。此外,注意力機制在文本分類和機器翻譯等領域[11-12]也得到了廣泛應用。張浩宇等[13]構建了自注意力網絡模型,Pavlopoulos [14]在用戶評論任務中首次運用深層注意力機制,取得了非常好的效果。

在目前微博情感分析任務中,文本過短、對表情符號與情感詞的作用體現不夠,文本信息特征體現不足。為了解決以上問題,本文提出一種融合情感符號與文本信息的BLSTM神經網絡模型,將文本信息和情感符號信息同時作為輸入,通過BLSTM學習得到情感符號,與文本特征表示進行融合,引入結構化自注意力機制識別文本中不同情感符號的情感信息。

1 雙向LSTM模型

長短期記憶(Long-Short Term Memory,LSTM)屬于循環神經網絡(RNN)的變種。依賴于其獨特機制,LSTM能處理間隔距離長的文本特征信息,在自然語言處理中獲得了廣泛應用[15]。

LSTM模型是由t時刻的輸入詞[xt]、細胞狀態[Ct]、臨時細胞狀態[ct],隱層狀態[ht]、遺忘門[ft]、記憶門[it]、輸出門[Ot]組成。通過遺忘細胞狀態中的信息、記憶新信息使對后續時刻計算有用的信息得以傳遞,而無用的信息被丟棄,并在每個時間步均會輸出隱層狀態[ht],其中遺忘、記憶與輸出由通過上個時刻的隱層狀態[ht-1]和當前輸入[xt]計算的遺忘門[ft]、記憶門[it]、輸出門[Ot]控制。

遺忘門待遺忘的信息有:

記憶門應記憶的信息有:

當前時刻細胞狀態為:

輸出門與當前時刻隱層狀態為:

最終,可以得到長度相同的隱層狀態序列[h0,h1,?,hn-1}]。

傳統LSTM只能按次序讀取文本,考慮微博上下文信息,本文使用能夠雙向提取特征的BLSTM模型。在每一個時間序列前后配置一個正向LSTM,由[x1]讀取到[xt],以及一個反向LSTM,由[xt]讀取到[x1],連接在同一個輸出層,從而獲取時間點過去、未來完整的上下文信息。

2 注意力機制

注意力機制最開始用于圖像處理任務, 目的是從眾多畫面中找到對當前目標更關鍵的信息[16]。該方法借鑒了人類視覺注意力,即人類視覺掃描一個物體時,往往著重關注物體某個特定區域,而忽視一些次要信息,從大量信息中篩選出高價值的信息[17]。近年來,注意力機制在多個領域得到廣泛運用。2014 年,Mnih等[5] 在圖像分類任務上引入注意力機制,捕捉一幅圖像的重要特征,獲得了非常好的效果;隨后,Bahdanau 等[7]將注意力機制應用于NLP 領域,在機器翻譯任務上引入注意力模型,使翻譯和對齊同時進行;張仰森等[18]在文本上使用雙重注意力機制,成功提取到對文檔比較重要的詞或句子,提高了文本分類效果。

令[w=[w1,?,wn]]表示輸入序列,[h=[h1,?,hn]]=[gx] 為隱含層輸出。[g]可用RNN、CNN或其它神經網絡結構實現,用以對輸入數據進行序列編碼。注意力機制的思想是在特征提取時,對隱層輸出序列的不同部分賦予不同程度的重要性權重。該權重是注意力機制的核心,表示為:

其中,[q]稱為查詢向量,當[q]來自[h]時稱為自注意力,[f]為[q]和[hi]的匹配函數,可以使用多種實現方式[19]。

3 模型

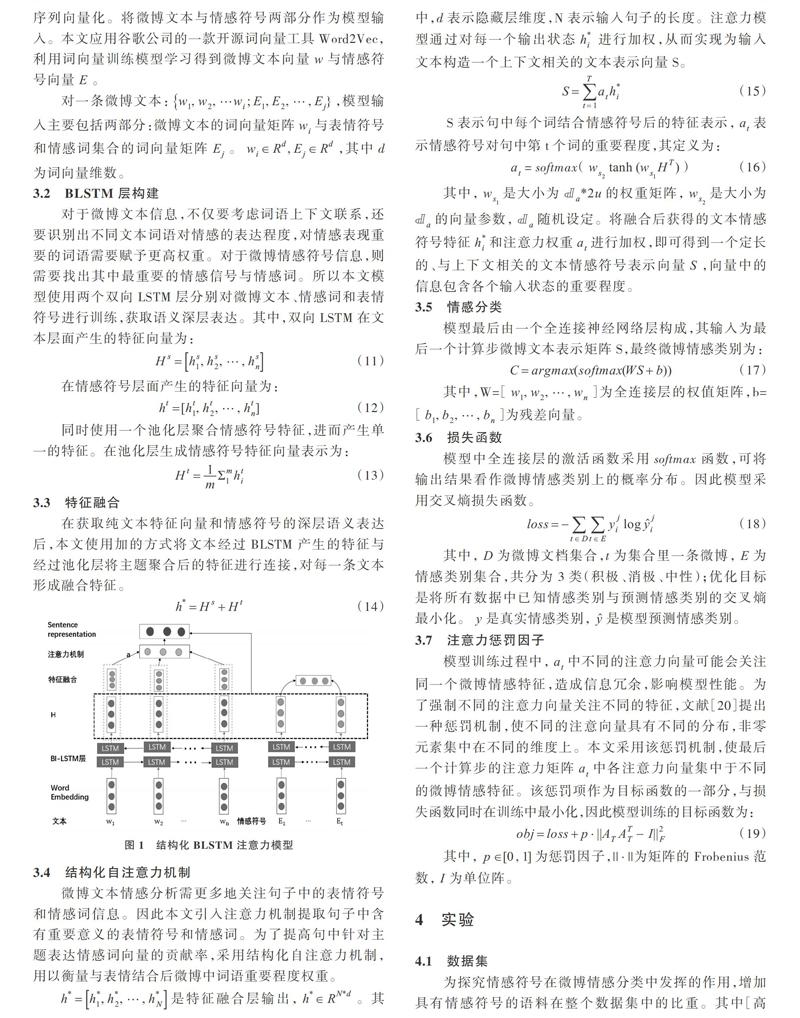

本文融合情感符號和結構化自注意力編碼機制, 提出一種結構化BLSTM網絡模型,該模型將BLSTM網絡的長期上下文信息存儲機制與結構化自注意力編碼抽取句子多方面信息的能力結合起來。

模型使用文本和情感符號信息作為輸入,通過BLSTM學習得到情感符號矩陣與文本特征表示進行融合,引入自注意力模型提取句子中含有重要意義的表情符號與情感詞構成新的文本表示向量。模型整體架構如圖1所示。

3.1 詞向量輸入層

深度學習方法進行情感分析的第一步是將文本句子序列向量化。將微博文本與情感符號兩部分作為模型輸入。本文應用谷歌公司的一款開源詞向量工具Word2Vec,利用詞向量訓練模型學習得到微博文本向量[w]與情感符號向量[E]。

對一條微博文本:,模型輸入主要包括兩部分:微博文本的詞向量矩陣[wi]與表情符號和情感詞集合的詞向量矩陣[Ej]。其中d為詞向量維數。

3.2 BLSTM層構建

對于微博文本信息,不僅要考慮詞語上下文聯系,還要識別出不同文本詞語對情感的表達程度,對情感表現重要的詞語需要賦予更高權重。對于微博情感符號信息,則需要找出其中最重要的情感信號與情感詞。所以本文模型使用兩個雙向LSTM 層分別對微博文本、情感詞和表情符號進行訓練,獲取語義深層表達。其中,雙向LSTM在文本層面產生的特征向量為:

在情感符號層面產生的特征向量為:

同時使用一個池化層聚合情感符號特征,進而產生單一的特征。在池化層生成情感符號特征向量表示為:

3.3 特征融合

在獲取純文本特征向量和情感符號的深層語義表達后,本文使用加的方式將文本經過BLSTM產生的特征與經過池化層將主題聚合后的特征進行連接,對每一條文本形成融合特征。

3.4 結構化自注意力機制

微博文本情感分析需更多地關注句子中的表情符號和情感詞信息。因此本文引入注意力機制提取句子中含有重要意義的表情符號和情感詞。為了提高句中針對主題表達情感詞向量的貢獻率,采用結構化自注意力機制,用以衡量與表情結合后微博中詞語重要程度權重。

是特征融合層輸出,。其中,d 表示隱藏層維度,N 表示輸入句子的長度。注意力模型通過對每一個輸出狀態[h*i] 進行加權,從而實現為輸入文本構造一個上下文相關的文本表示向量S。

?S?表示句中每個詞結合情感符號后的特征表示,[at]表示情感符號對句中第t個詞的重要程度,其定義為:

其中,[ws1]是大小為[?a*2u]的權重矩陣,[ws2]是大小為[?a]的向量參數,[?a]隨機設定。將融合后獲得的文本情感符號特征[h*i]和注意力權重[at]進行加權,即可得到一個定長的、與上下文相關的文本情感符號表示向量[S],向量中的信息包含各個輸入狀態的重要程度。

3.5 情感分類

模型最后由一個全連接神經網絡層構成,其輸入為最后一個計算步微博文本表示矩陣S,最終微博情感類別為:

其中,W=[[w1,w2,?,wn]]為全連接層的權值矩陣,b=[[b1,b2,?,bn]]為殘差向量。

3.6 損失函數

模型中全連接層的激活函數采用softmax函數,可將輸出結果看作微博情感類別上的概率分布。因此模型采用交叉熵損失函數。

其中,[D]為微博文檔集合,t為集合里一條微博,[E]為情感類別集合,共分為3類(積極、消極、中性);優化目標是將所有數據中已知情感類別與預測情感類別的交叉熵最小化。[y]是真實情感類別,[y]是模型預測情感類別。

3.7 注意力懲罰因子

模型訓練過程中,[at]中不同的注意力向量可能會關注同一個微博情感特征,造成信息冗余,影響模型性能。為了強制不同的注意力向量關注不同的特征,文獻[20]提出一種懲罰機制,使不同的注意向量具有不同的分布,非零元素集中在不同的維度上。本文采用該懲罰機制,使最后一個計算步的注意力矩陣[at]中各注意力向量集中于不同的微博情感特征。該懲罰項作為目標函數的一部分,與損失函數同時在訓練中最小化,因此模型訓練的目標函數為:

其中,[p∈[0,1]]為懲罰因子,為矩陣的Frobenius范數,[I]為單位陣。

4 實驗

4.1 數據集

為探究情感符號在微博情感分類中發揮的作用,增加具有情感符號的語料在整個數據集中的比重。其中[高興]等歸納為消極類。本文將 NLPCC2014提供的中文評測數據集中所有包含情感符號的微博抽取出來,組成另一個語料,同時在微博平臺爬取10 000條微博數據構建一個含有大量情感符號的微博語料,本部分以該語料作為實驗數據進行分析,實驗數據如表1所示。

4.2 實驗設置

先對數據進行預處理,去除微博文本中的鏈接、微博用戶名及部分標點符號。對3個數據集采用10折交叉驗證進行實驗,對于未包含表情符號與情感詞的微博,采用均勻分布的U([-ε,ε])進行隨機初始化。

本文實驗采用已預訓練的Word2vec詞向量進行初始化,文本中詞向量維度、情感符號詞向量維度和經過BLSTM 輸出的特征連接后的維度均為300。注意力權重的維度和文本中的長度一致。實驗中每 60 個樣本1個 batch,共迭代40個epoch,Adam學習率為0.001,代價函數懲罰項為0.001。Dropout 設置為0.5,LSTM設置為64層,BLSTM為128層。

4.3 實驗對比

為探究情感符號在微博情感分類中的作用,將本文提出的模型Att-BLSTM-text-emoij與以下5種模型在3個不同數據集上進行實驗。

(1)情感詞典。該模型按規則進行匹配[3]。

(2)SVM。該模型使用傳統機器學習算法支持向量機進行情感分類[21]。

(3)BLSTM。該模型將純文本作為模型唯一輸入,使用BLSTM對詞向量進行訓練。該模型包括一個前向LSTM和一個反向LSTM,將兩者輸出序列合并作為文本序列的表征向量,同樣利用全連接層進行分類[22]。

(4)BLSTM-text-emoji,即文本+表情符號輸入的BLSTM情感分析網絡模型。該模型考慮表情符號的特征信息,利用BLSTM模型訓練提取文本深層語義信息。其優化目標及訓練方法與本文模型相同。

(5)Att-BLSTM。在BiLSTM的基礎之上加入注意力機制,使隱含層的不同輸出在最終的句子表達中發揮不同作用[23]。

4.4 實驗結果分析

本文選取 NLPCC2014數據集與爬取的微博數據集的訓練樣本作為模型訓練集進行模型訓練和交叉校驗,采用其測試樣例進行測試,使用準確率作為情感分析的評估標準。結果如表2、圖2所示。由表2實驗結果可知,本文提出的融合情感符號特征的自注意力模型比其它4種模型效果更好,具有更高的準確率。

圖2中,橫坐標為模型序號,縱坐標表示準確率。在傳統情感分析方法中,SVM的準確率普遍優于構建情感詞典模型,準確率有很大提升。而深度學習方法比傳統方法(SVM、情感詞典)效果更好。

對比使用深度學習方法的4組實驗結果,相對于模型3僅使用文本特征作為情感特征的輸入,模型4、6使用情感符號與文本作為情感特征的輸入,豐富了文本特征信息,取得了更好效果。模型5引入注意力機制,從實驗結果來看,模型準確捕捉到了對文本分類更重要的特征,相對于模型3提升效果顯著,但相對于結合情感符號模型4在微博文本分析中并沒有絕對優勢,原因可能在于微博短文本內容有限,不能充分表達情感信息。因此本文提出的模型6引入情感符號特征信息作為補充。綜合以上數據集實驗結果分析可知,本文提出的Att-BLSTM-text-emoji模型優于單獨使用文本詞向量與注意力機制的模型。

由此可知,在情感分類任務上,引入情感符號特征和結構化注意力機制對情感分類準確率具有正面作用,可有效提高情感分類效果。

4.5 可視化注意力機制

本部分隨機抽取數據集中3條微博驗證本文自注意力模型的有效性。

圖3展示的是融合情感符號的自注意力模型分類結果。注意力向量α權重用顏色深度表示,權重越大顏色越深。文本(a)表示的情感符號是“[開心]”,模型注意力更多地體現在“好看”、“漂亮”等積極層面信息。

而文本(b)表示的情感符號是“[難過]”。模型更多地關注“費電”、“偏僻”等負面信息。

5 結語

本文提出了一種融合文本信息與情感符號特征的自注意力情感分析方法。將微博情感符號和文本作為模型輸入,通過雙向LSTM模型訓練得到上下文深層語義特征并進行融合,豐富了純文本情感信息;同時引入結構化自注意力機制,提取文本中對情感分類具有重要意義的特征信息。在3個數據集上的實驗表明,相比于傳統情感分類研究方法,本文提出的模型準確率更高,模型泛化性更強。

由于中文語義結構歧義性與復雜程度,模型對于文本語義特征提取的能力還有待提高。該模型還可進一步拓展,利用多分類方法進行細粒度更高的微博情緒分析。此外,微博中包含的情緒可能超過一種,下一步工作將考慮多個情感符號相互關系對語義信息的影響,利用基于深度學習的多標記分類方法進行微博情緒分析。

參考文獻:

[1]宋祖康,閻瑞霞,辜麗瓊.? 基于機器學習與情感詞典的文本主題概括及情感分析[J].? 軟件導刊, 2019, 18(4): 4-8.

[2]PENG H, CAMBRIA E, HUSSAIN A. A review of sentiment analysis research in Chinese language[J]. Cognitive Computation,2017,9 (4):1-13.

[3]擁措,史曉東,尼瑪扎西. 短文本情感分析的研究現狀——從社交媒體到資源稀缺語言[J]. 計算機科學,2018,45(S1):46-49+68.

[4]TANG D Y, QIN B, LIU T. Document modeling with gated recurrent neural network for sentiment classification[C]. Proceedings of Conference on Empirical Methods in Natural Language Processing, 2015: 1422-1432.

[5]MNIH V,HEESS N,GRAVES A,et al. Recurrent models of visual attention[C]. Proceedings of the 27th International Conference on Advances in Neural Information Processing Systems,2014:2204-2212.

[6]周才東,曾碧卿,王盛玉,等.? 結合注意力與卷積神經網絡的中文摘要研究[J]. 計算機工程與應用,2019, 55(8): 132-137.

[7]BAHDANAU D,CHO K, BENGIO Y. Neural machine translation by jointly learning to align and translate[C]. Proceedings of International Conference on Learning Representations, 2015:1-15.

[8]張浩宇,張鵬飛,李真真,等. 基于自注意力機制的閱讀理解模型[J]. 中文信息學報,2018,32(12):125-131.

[9]PAVLOPOULOS J,MALAKASIOTIS P,ANDROUTSOPOULOS I.Deeper attention to abusive user content moderation [C]. Proceedings of Conference on Empirical Methods in Natural Language Processing, 2017: 1136-1146.

[10]PANG Bo, LEE L, VAITHYANATHAN S. Thumbs up?: sentiment classification using machine learning techniques [C]. ACL Conference on Empirical Methods in Natural Language Processing,2002: 76-86.

[11]PONTIKI M,GALANIS D,PAVLOPOULOS J, et al. Semeval-2014 task4: aspect based sentiment analysis [C]. The 8th International Workshop on Semantic Evaluation. 2014: 27-35.

[12]ROSENTHAL S, FARRA N, NAKOV P. SemEval-2017 task4: sentiment analysis in Twitter [C].? Proceedings of SemEval,2017:1-5.

[13]KIRITCHENKO S,ZHU X D,CHERRY C,et al. NRC-Canada-2014: detecting aspects and sentiment in customer reviews [C]. Proceedings of the 8th International Workshop on Semantic Evaluation, 2014: 437-442.

[14]劉思葉,田原,馮雨寧,等. 游客微博主題情感分析方法比較研究[J]. 北京大學學報:自然科學版,2018,54(4):687-692.

[15]TAI K S, SOCHER R, MANNING S D. Improved semantic representations from tree-structured long short-term memory networks[C].? Procedings of the 53rd Annual Meeting of the Association for Computational Linguistics and the 7th International Joint Conference on Natural Language Processing, 2015:1556-1566.

[16]TANG D Y, QIN B, FENG X C,et al. Effective LSTMs for target-dependent sentiment classification [C].? Proceedings of the 26th International Conference on Computational Linguistics,2016: 3298-3307.

[17]KIRITCHENKO S,ZHU X D,CHERRY C,et al. NRC-Canada-2014: detecting aspects and sentiment in customer reviews [C].? Proceedings of the 8th International Workshop on Semantic Evaluation, 2014: 437-442.

[18]張仰森,鄭佳,黃改娟,等. 基于雙重注意力模型的微博情感分析方法[J]. 清華大學學報:自然科學版,2018,58(2):122-130.

[19]VASWANI A, SHAZEER N, PARMAR N et al. Attention is all you need [C]. Long Beach:Proceedings of the Conference and Workshop on Neural Information Processing Systems (NIPS),2017.

[20]LUONG M-T, PHAM H, MANNING C D. Effective approaches to attention-based neural machine translation[C]. Lisbon:Proceedings of the Conference on Empirical Methods in Natural Language Processing, 2015.

[21]韓開旭,任偉建. 基于改進Fisher核函數的支持向量機在推特數據庫情感分析中的應用[J]. 自動化技術與應用,2015,34(11):30-36.

[22]HOCHEREITER S,SCHMIDHUBER J. Long short-term memory[J].? Neural Computation, 2012, 9(8): 1735-1780.

[23]QIU Y Y, LI H Z, LI S et al. Revisiting correlations between intrinsic and extrinsic evaluations of word embeddings[C]. Changsha: Proceedings of the Chinese Computational Linguistics and Natural Language Processing Based on Naturally Annotated Big Data, 2018.

(責任編輯:江 艷)

收稿日期:2019-05-21

基金項目:國家自然科學基金項目(7177411,71303157)

作者簡介:劉臣(1981-),男,上海理工大學管理學院副教授、碩士生導師,研究方向為互聯網用戶行為、Web數據挖掘;方結(1996-),男,上海理工大學管理學院碩士研究生,研究方向為自然語言處理、情感分析;郝宇辰(1995-),男,上海理工大學管理學院碩士研究生,研究方向為機器學習。