基于深度學習的高分辨率遙感圖像建筑物識別

宋廷強,李繼旭,張信耶

1.青島科技大學 信息科學技術學院,山東 青島266100

2.珠海歐比特宇航科技股份有限公司 人工智能研究院,廣東 珠海519000

1 引言

遙感圖像分割技術在城市規劃、精準農業、土地測繪覆蓋與監測[1]、自動道路檢測[2]、環境保護、氣候變化和植被覆蓋等領域發揮著關鍵作用。遙感圖像的語義分割旨在將每個像素分類為給定的類別,它是理解和推斷對象以及場景中空間對象之間關系的重要任務[3]。

常規的圖像分割方法主要基于光譜統計特征,如最小距離、最大似然和K 均值聚類[4-5]。雖然這些方法取得了良好的效果,但隨著遙感圖像分辨率的提高,分割和識別精度已不能滿足需求。近年來深度卷積神經網絡是深度學習應用到遙感圖像和其他圖像分割等方面的重大成果。翁飄等人提出了一種改進的全卷積神經網絡的分割方法,從而融入更多的局部信息[6]。根據建立的數據集訓練優化后的FCN,能夠對一些光照不均勻、背景復雜的裂縫圖像進行較好的分割,然而,這類方法對圖像小目標識別效果差一些。劉辰等人提出了一種基于改進卷積神經網絡的醫學圖像分割方法,其中卷積神經網絡由編碼、雙向卷積長短記憶網絡(BDCLSTM)和解碼部分組成[7]。這類方法能夠充分挖掘單視圖下切片序列間的相關信息,從而提高分割精度,然而,也存在過度分割問題。王振等人提出了一種基于改進全卷積神經網絡玉米葉片病斑分割方法,編碼網絡結構是在傳統VGG16 網絡的基礎上進行改進,解碼網絡主要是對編碼網絡中的下采樣層進行反卷積操作[8]。通過對解碼網絡不斷地進行訓練,可以恢復編碼網絡輸出特征圖的分辨率,得到更為精確的分割效果,但也同樣存在過度使用低級特征的問題。Yang 等人提出了一種基于HSPCNN的自適應圖像區域分割方法,適合執行圖像多區域分割,然而,對于具有正態分布密度的圖像,難以通過非交互方法獲得期望的分割結果[9]。在經典卷積神經網絡CNN[10]中,由像素點及其相鄰像素組成的圖像塊輸入到網絡中以提取特征,用于每個像素的分類[11]。但這種方法在批處理操作中引入了大量冗余計算,并導致大量內存消耗和低分區效率。Long等人提出FCN[12],它可以接受任何大小的圖像作為輸入,通過卷積層提取特征,然后進行反卷積上采樣,并輸出具有相同大小的分割圖像,具有準確的目標對象邊緣并分配標簽。目前,FCN模型已被廣泛應用于圖像分割[13]。另外,由于在卷積和池化過程中,圖像分辨率降低,因此最后一層產生的分割結果通常分辨率比較低。許多后續的圖像分割模型進一步擴展了FCN 的思想,代表模型有U_Net[14]、SegNet[15]和DeepLabv3[16]。在DeepLabv3 中,金字塔池化模塊用于提取多個尺度的特征圖。其他先進的方法包括處理不同尺度信息,類似于在判別特征[17]網絡中學習;細化殘差塊[18],可以跨不同渠道聚合信息;細化特征圖,提高各階段的識別能力。最大融合策略,結合深層和淺層信息,避免由于FCN 中的下采樣而丟失詳細信息;并使用多線程控制網絡訓練策略[19]。

注意機制是提取輸入信號最有用信息的有效工具[20-21]。通過使用過濾器功能(例如softmax或Sigmoid)和順序技術可以實現注意力機制。注意機制最近已廣泛用于圖像字幕[22]、圖像分類[23]、視覺問答[24]、圖像識別[25]及其他領域。在這些應用中,他們使用過濾器功能來激活收集的頂部信息,以按通道或在空間上對激活進行加權,并引入反饋連接。例如,Wang等人使用軟掩膜結構來生成注意力機制[26]的特征,其中注意力是使用圖像分割來捕獲視覺關注焦點區域。Hu等人設計了一個擠壓和激勵模塊來重新校準通道[27]功能。Wang等人建立了一個熵控制模塊來選擇低特征圖進行語義分割[28]。Li等人引入了一個全球關注的上采樣模塊,以指導語義細分中低級和高級功能的集成[29]。研究表明注意力機制可以增強目標所具有的某些神經元,并改善其性能。因此,在設計遙感影像建筑物提取網絡時,構建了一個注意機制模塊,將低級和高級特征進行語義分割,避免了對低級特征的過度使用。

由于遙感圖像分辨率的提高,高分辨率遙感圖像包含大量的信息,這擴展了遙感圖像的應用范圍,并且所識別的感興趣區域對象的尺寸較小。現有的深度學習神經網絡SegNet 直接應用于遙感影像分割,存在小物體分割效果差和過度分割問題。基于SegNet網絡和遙感圖像數據屬性,提出了一種新的高分辨率圖像分割方法,本文的方法為:(1)增加增強型空洞金字塔模塊A-ASPP,A-ASPP結構中的平行擴張卷積采用不同的擴張因子,得到更密集的采樣,收集更高層次的局部信息,提高小物體的分割性能;(2)增加注意力融合模塊,增強有用的低級特征信息并消除噪聲以避免過度使用低級特征,避免過度分割及進一步提高分割精度。

2 研究方法

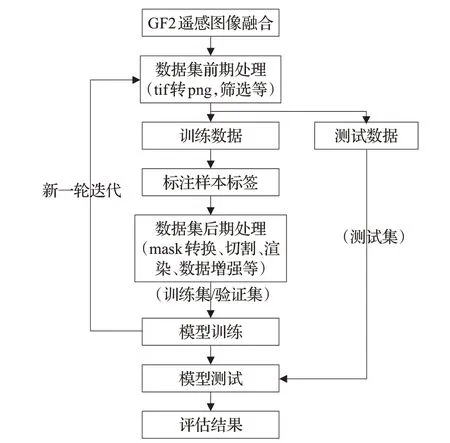

高分辨率遙感影像分割技術流程如圖1 所示。初始化的模型經過訓練、調整模型的權重,使模型能夠從大量數據中學到遙感影像目標特征,模型核心是數據集制作與網絡結構設計。

圖1 高分辨率影像語義分割技術流程圖

2.1 空洞卷積

在經典網絡CNN 中,卷積核可以通過池化操作獲得更大的感受野。遙感圖像分割的輸入和輸出大小是相同的。因此,池化后尺寸較小的圖像需要通過反卷積操作擴展回原始尺寸。但是,如果下采樣過程中池化太大,則反卷積過程中圖像信息的丟失將會增多。擴張卷積可以通過控制擴張率獲得不同大小的感受野。假設在二維情況下,對于每個位置i,相應的輸出是y 并且特征的權重是w,輸入特征層x 的卷積被計算為:

其中,k 是卷積核的大小,r 是擴張速率。

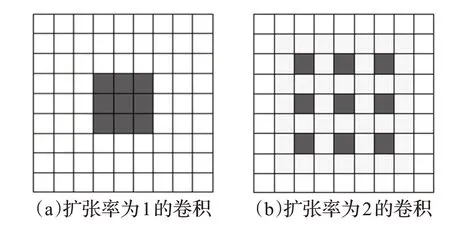

在擴展卷積中,卷積核由擴張因子擴展,并沿著相鄰權重之間的空間維度放置r-1 個零,以創建稀疏濾波器。檢查擴張卷積以輸入傳統卷積的特征x。不同擴展速率的卷積如圖2所示。

圖2 內核大小為3×3且擴張率不同的卷積

圖2(a)顯示了一個標準的3×3卷積,一種特殊形式的擴張卷積率=1,每次覆蓋一個3×3 尺寸的視野;圖2(b)中顯示了一個速率=2的3×3擴張卷積。卷積核的大小仍為3×3,但卷積核的計算視野增加到7×7,而實際參數仍為3×3。感受野的大小可以表示為:

因此,通過調整稀疏卷積中的膨脹率,可以擴展感受野而無需添加額外的參數。

2.2 原始SegNet體系結構

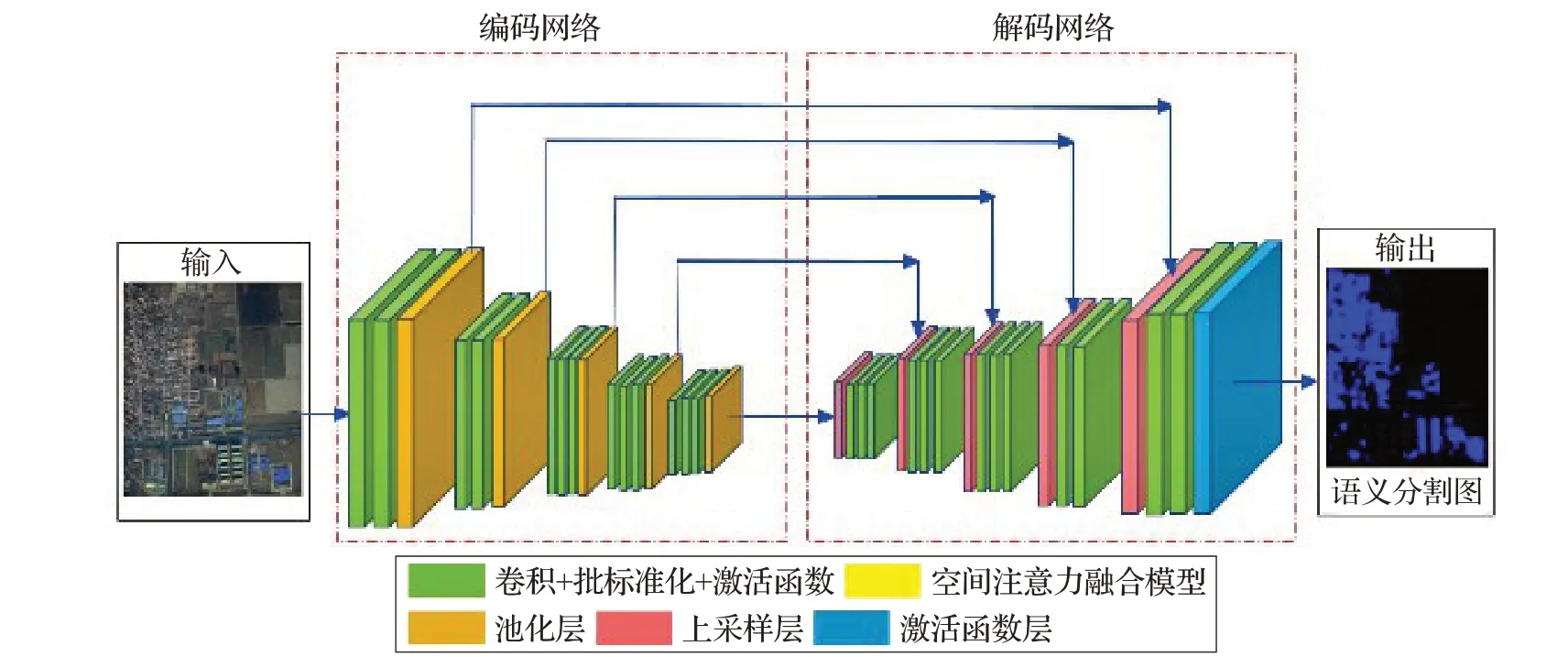

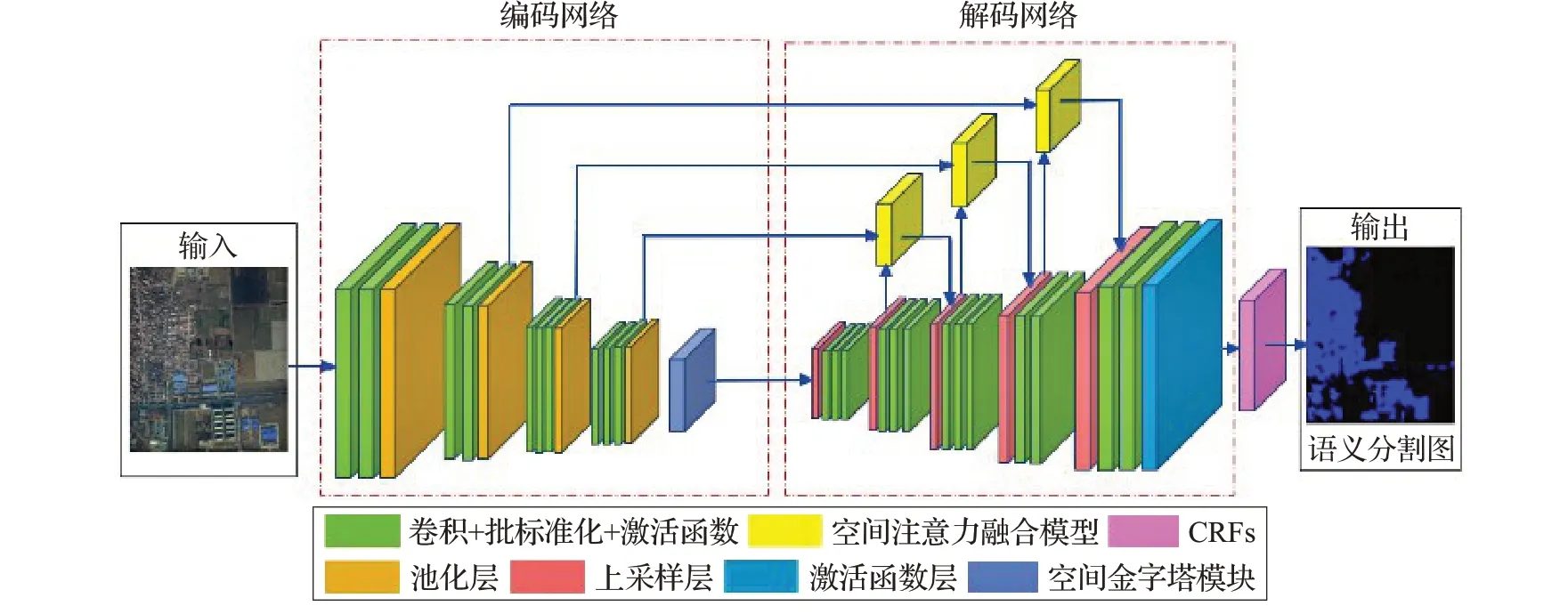

深度卷積神經網絡的語義分割模型SegNet 原始架構主要由兩部分組成,架構如圖3所示。第一部分是編碼網絡,包括卷積層、批標準化、激活函數和池化層,用于提取輸入數據的多尺度特征。第二部分是解碼網絡,包括卷積層、批標準化、上采樣和激活函數,旨在恢復特征圖的空間分辨率并使用這些特征圖提取目標物。解碼網絡利用編碼器下采樣時保存的相應特征層的最大池化索引信息將低分辨率的特征圖映射到高空間分辨率的特征圖,實現低維向量到高維向量的重構。

2.3 AA-SegNet體系結構

基于SegNet 結構改進的AA-SegNet 網絡模型主要結構由三部分組成,架構如圖4所示。第一部分是編碼網絡。結構改變為在編碼器末端,加入增強型空洞金字塔池化模塊A-ASPP,A-ASPP結構中的平行擴張卷積采用不同的擴張因子,得到更密集的采樣,收集更高層次的局部信息,提高小物體的分割性能旨在精準提取小目標。

圖3 SegNet網絡模型體系結構

圖4 AA-SegNet網絡模型體系結構

圖5 A-ASPP網絡基礎模塊結構

第二部分是解碼網絡,解碼網絡進行非線性上采樣,結構改變為編碼網絡卷積層與上采樣之間建立空間注意力融合模塊,空間注意力融合模塊用于引導低級特征圖,來幫助高級特征恢復像素定位細節,減少識別圖像過度分割。

第三部分是后期處理模塊CRFs(Conditional Random Fields),CRFs[30]有助于在給定網絡識別結果和原始圖像的RGB特征時,估計模型識別結果的后驗分布.通過對用戶定義的能量函數的最小化來實現,類似于雙邊濾波器(bilateral filter)的效果。另外,CRFs也對小分割區域進行懲罰。

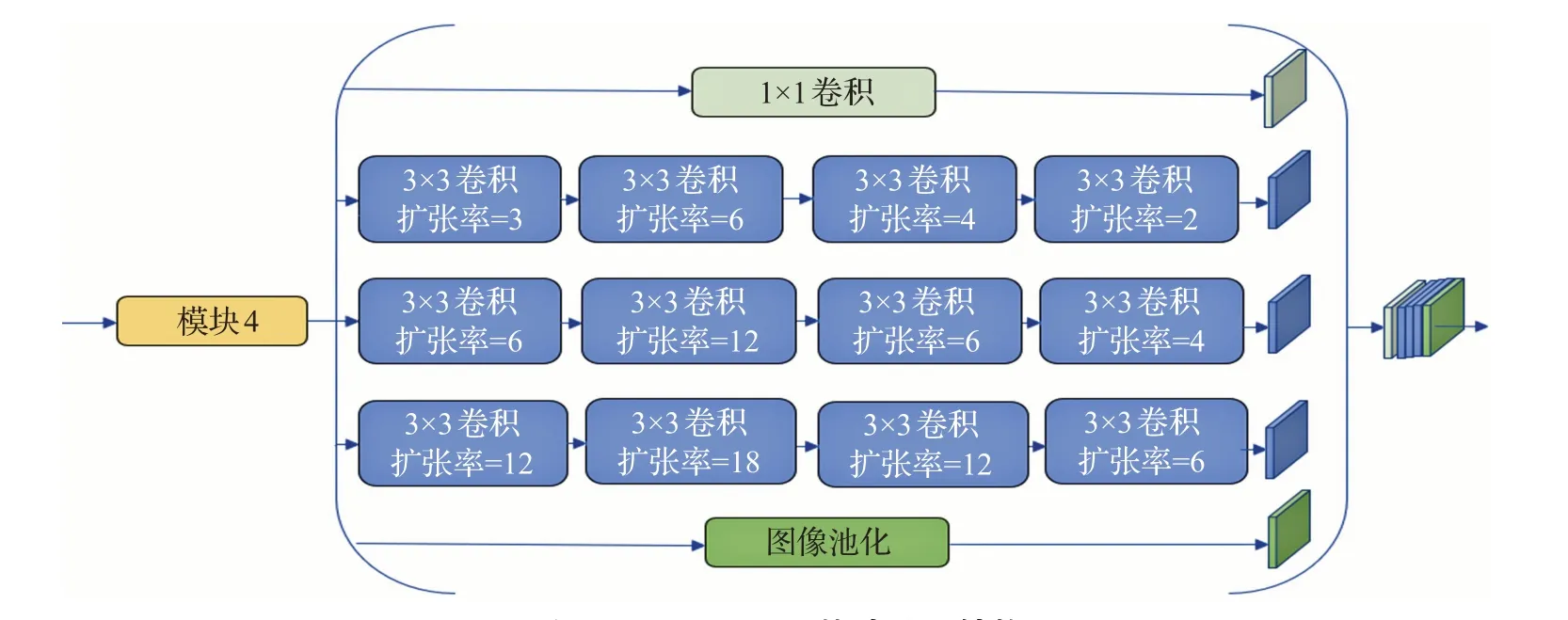

2.4 A-ASPP模塊

正如文獻[16]中指出的,上下文信息對于檢測目標對象很重要。上下文信息(例如道路、汽車或其他建筑物)有助于識別物體。圖5展示了所提出的增強型空洞空間金字塔池化(A-ASPP)模塊。A-ASPP 模塊具有三個平行的擴張卷積分支,每個分支由四個不同的擴張速率擴張卷積層組成。A-ASPP 層旨在使計算更加集中,增強小物體特征的學習,從而覆蓋大背景,計算更強的特征,逐步增加擴張因子;然后將擴張因子減少到聚集由擴張因子增加而散射的局部特征。

擴張卷積對于分割任務很重要,雖然它在分辨率和背景上下文方面很有用,但它對高分辨率圖像中的小對象分割效果并不完善。普通網絡應用擴張卷積會導致兩個問題:(1)太大的擴張因子導致稀疏卷積核,并且丟失了大量的計算信息。(2)相鄰空間的一致性變弱,并且在上采樣層丟失局部信息。

首先,為了解決稀疏卷積引起的稀疏性問題,需要更加集中的計算,并且需要增加擴張因子。從小擴展計算到大擴展,這使得計算和采樣更密集,從而允許獲得更詳細的上下文信息。因此,A-ASPP 網絡結構使用逐漸擴展結構。為了解決第二個問題,采用降低膨脹系數。如果在擴張因子增加結構后附加具有減少的膨脹系數的結構,可以再次連接相鄰單元的信息金字塔。因次,減少結構逐漸恢復相鄰單元之間的一致性并提取更高層中的局部結構。

A-ASPP 的結構顯示在圖5 部分。A-ASPP 結構使用擴張因子先擴大然后減少以保持信息獲取多尺度的優勢,提高學習能力。首先,擴張因子逐漸擴大,使感受野更加密集,從而使卷積網絡獲得更詳細的背景信息。然后通過減少擴展因子,聚合局部信息來增強小物體的特征提取。

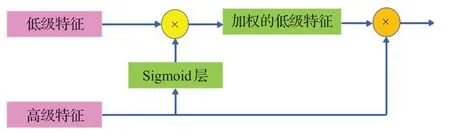

2.5 空間注意力融合模塊

公共編碼器、解碼器[31-32]網絡主要使用不同尺度的特征映射來幫助解碼器逐漸恢復對象細節信息。U-Net的跳躍連接是通過重用功能映射將編碼器路徑恢復對象詳細信息的常用方法。但是,這種方法將會過度使用低級特征并導致影像過度分割。注意力機制能夠使用更高級別的視覺信息來加權較低級別的信息。受到注意力機制的啟發,空間注意力融合模塊被設計用于增強有用的低級特征信息并消除噪聲以避免過度使用低級特征。

在空間注意力融合模塊,首先,高級特征由Sigmoid層激活,激活的輸出歸一化為[0,1],并用做低級特征的映射。然后,將高低特征輸出乘以低級特征以獲得加權的低級特征。最后,添加高級特征和加權低級信息作為最后模塊的輸入,以逐漸恢復對象細節信息。空間注意力融合模塊的體系結構如圖6所示。

圖6 空間注意力融合模塊

訓練啟動后,原始圖像進入神經網絡的輸入端,在神經網絡中使用卷積操作進行特征抽取,卷積操作中,卷積過濾器尺寸為3×3×64,步長為1,零填充,激活函數為relu。由于網絡較為龐大,在每個卷積層之后增加一個BatchNormalization 進行歸一化操作,防止過擬合和梯度爆炸。利用Maxpool 對輸入的原始圖像進行五次下采樣;池化操作中,過濾器尺寸均為2×2;在編碼器最后加入增強型的空洞金字塔池化,來進行多尺度信息聚合。在解碼器部分,加入3 個空間注意力融合模塊,注意力機制模塊由編碼器中的卷積和解碼器中的上采樣層連接,采集高級和低級特征后,然后傳到上采樣階段,完成信息融合。

3 實驗

在本章中,對所提AA-SegNet 網絡模型進行訓練、測試與優化,所有網絡都在GPU 上基于Tensorflow+Kears框架進行訓練和測試。

3.1 訓練過程

3.1.1 數據集

本實驗所用數據源為高分二號,數據為2019年7月中國山東省濰坊市的高分辨率遙感影像。圖像的空間分辨率為亞米級,光譜可見光頻端(R、G、B)。實驗樣本集包括訓練樣本、測試樣本。從遙感影像中分別截10幅5 000×5 000 像素大小的影像切片(7 幅作為訓練樣本,3幅作為測試樣本)。

3.1.2 數據集處理

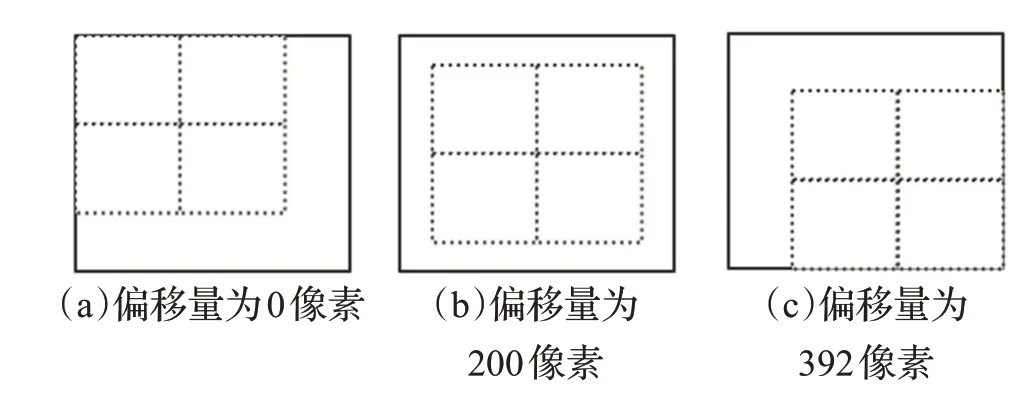

數據集處理包括:數據集前期處理、數據集后期處理。數據集前期處理:首先,將GF2 遙感圖像經過多光譜和全色數據融合后的tif格式數據,轉換為網絡模型常用的png 格式;然后,篩選出適合網絡模型訓練的訓練數據、測試數據。數據集后期處理包括數據標注、生成掩碼、樣本切割、降采樣、數據增強五個階段。鑒于GPU的內存有限并獲取更多的訓練樣本,平均大小為5 000×5 000 的圖像被切割成尺寸為512×512。為了增加樣本量,可以從不同的偏移量開始切割(見圖7),每幅大圖可以生成81×3 個樣本,要對原圖和標簽圖進行相同的切割。

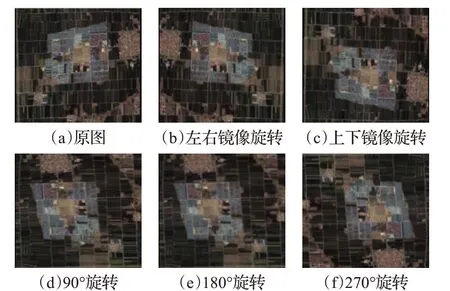

圖7 以不同的偏移量切割生成多批樣本

由于高分辨率遙感影像地物紋理信息太多,會影響網絡模型的判斷,降低分割準確度。因此將尺寸512×512 樣本降采樣為256×256。為豐富圖像訓練集,更好提取訓練特征,泛化模型(防止過擬合),對圖像塊旋轉、扭曲、增加噪聲等方式進行圖像增強。具體地,對于原圖進行90°、180°、270°翻轉、上下和左右鏡像操作,生成另外5份數據,加上原有數據,數據量增加為原來的6倍(對標簽進行相同操作),如圖8 所示。通過以上操作,新的訓練集包含46 267 幅256×256 的子圖像。為評估所提網絡模型在不同數據集合上的訓練效果,數據集分為數據集1(8 867 幅,256×256)、數據集2(18 700 幅,256×256),數據集3(18 700幅,512×512)。

圖8 數據增強實例

3.1.3 實施細節

對AA-SegNet網絡模型,選擇18%作為驗證集,82%作為訓練集。在30 輪(epoch)的訓練中,每一個epoch訓練結束,會在驗證集上計算一次損失和精度,并保存一次模型,最終選取在驗證集上表現最好的模型。AASegNet網絡模型測試時,需將測試圖輸入已訓練好的模型,從輸出得到mask圖,觀察渲染后的效果。為確保更好的訓練結果,根據訓練收斂速度手動調整學習率,最終約為0.001。

3.1.4 評估

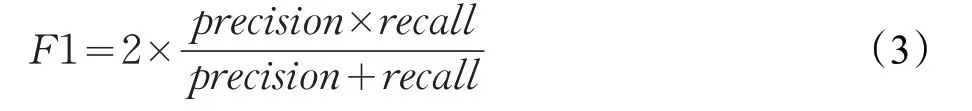

本研究中使用了基于像素評估標準,能夠提取建筑物內部像素的數量并提供嚴格的評估。在基于像素的評估中,使用總體精度(OA)、F1 分數和聯合平均交叉得分(MIOU)來評估定量性能[33]。 F1 分數計算方法如式(3)所示:

式中,precision=tp/(tp+fp),recall=tp/(tp+fn),其中,tp、fp 和fn 分別表示真正值、假正值和假負值,precision、recall 分別表示精確度、召回率,這些值可以通過每個圖塊基于像素的混淆矩陣來計算。IOU 是預測區域和地面真實值區域在其聯合上相交的平均值,如式(4)所示。MIOU通過取IOU平均可得到:

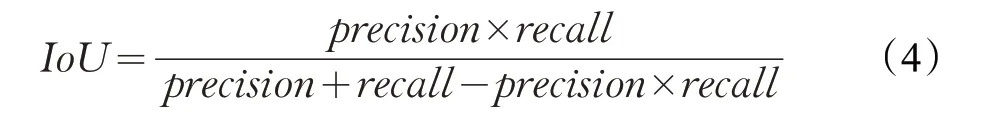

表1 步幅為16的A-ASPP的不同參數結果

3.2 提取結果

首先以AA-SegNet 網絡為核心架構,選擇A-ASPP模塊空洞率但不更改參數的原始模型,因為參數變化太多,則每個變化率都對應于少量的卷積層,這不利于提取更多抽象特征。如表1所示,選擇四種不同的擴展速率要好于原始參數基本版本,連續增加和連續減少擴張率的效果明顯優于基本實驗(A-ASPP、兩層、三層、四層、五層),根據表1中MOIU分數以及識別準確率可以得出,先增加后減少擴張率的MIOU和總體精度分數最高。最后,根據選擇的變化次數和增加,減少擴張速率的方法,設計了增強型A-ASPP 結構的網絡參數,在本次研究中,最優的模型結構參數為(變化率1,變化率2,變化率3,邊化率4)=((1),(3,6,4,2),(6,12,6,4),(12,18,12,6))。

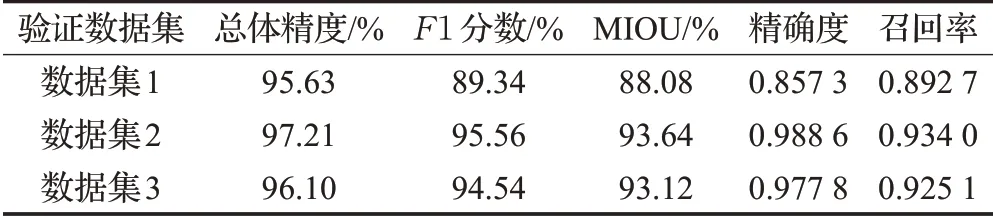

經過5 000 次網絡模型訓練,得到最穩定的結果如表2所示。本實驗采用了三個數據集,本網絡模型達到了比較高的分數(OA、F1、MIOU、precision 和recall),這表明AA-SegNet網絡在提取建筑物方面表現良好。

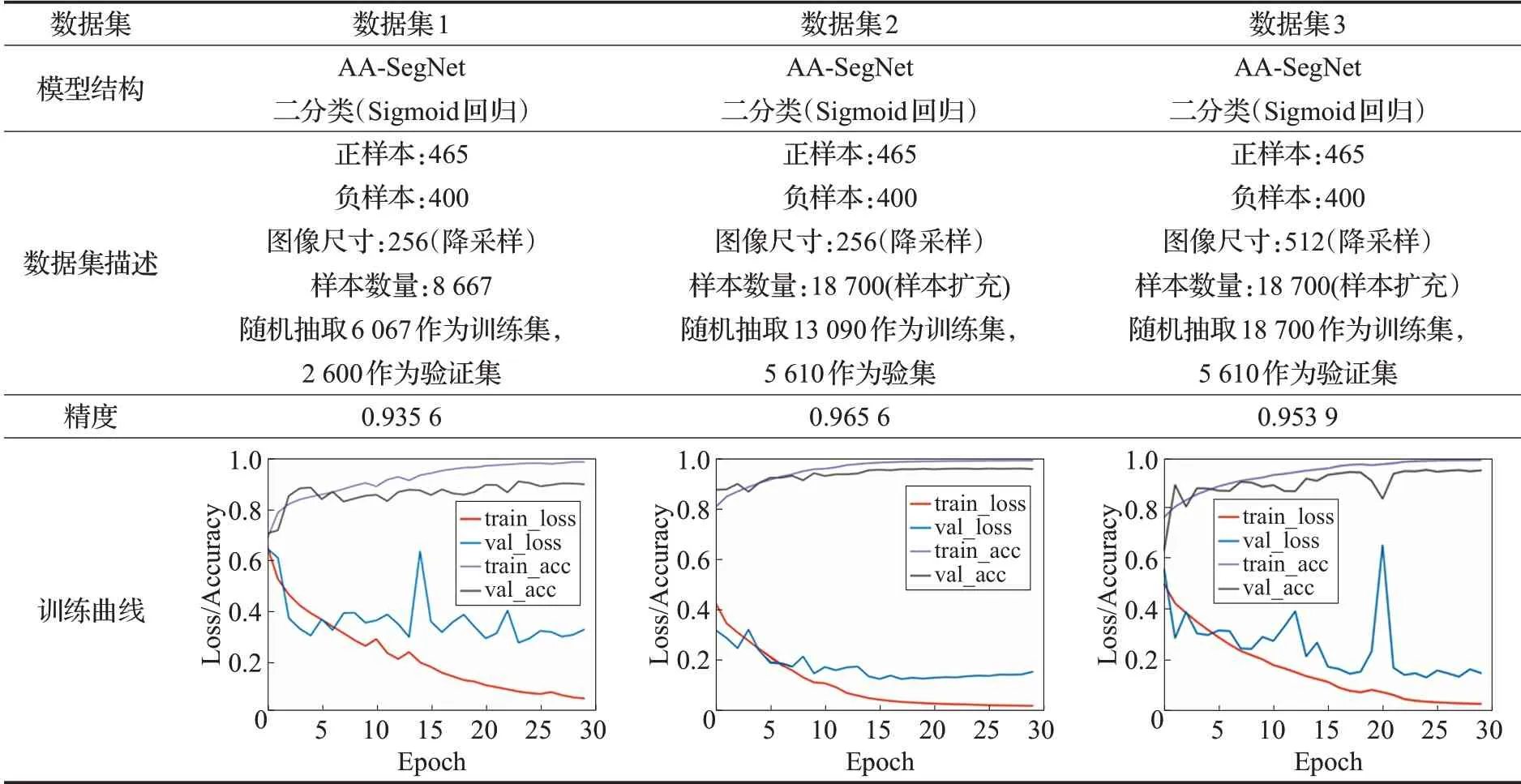

AA-SegNet 網絡基于數據集2,不同階段的訓練結果(見表3),在數據集使用樣本擴充后,可提高訓練精度、增加泛化能力。根據表3 給出的訓練結果,可以看出使用512尺寸進行訓練會增加不穩定因素,因為遙感影像建筑用地存在”同物異譜”現象,會影響模型訓練時收斂。

表2 基于像素的網絡模型評估結果

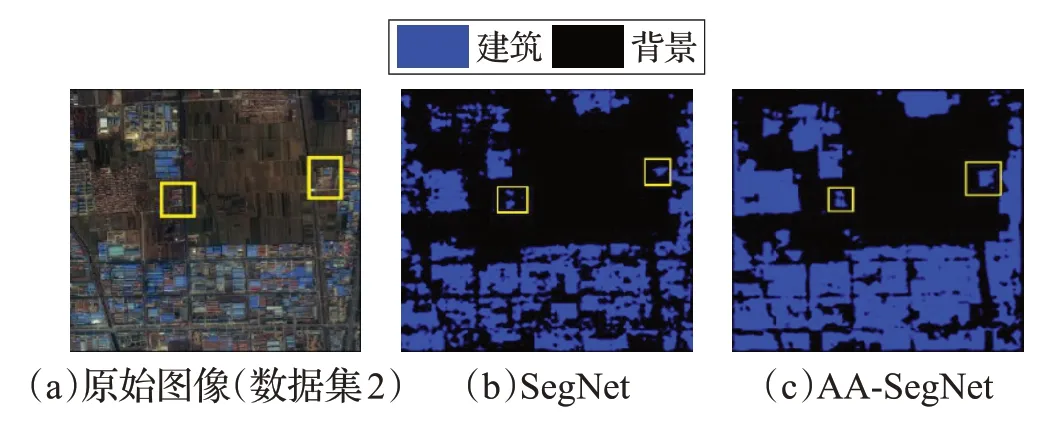

在未加注意力機制和增強型AA-ASPP 模塊之前,SegNet網絡識別結果存在許多空洞、碎片以及小目標識別差,加入空間注意融合模塊之后,由于空間注意力融合模塊,加強了低級特征的和高級特征的融合,能夠避免結果被過度分割,并且可減少分割區域噪點。圖9給出了AA-SegNet、SegNet 網絡模型識別結果,參見圖9(b)、(c)中黃色框標識。

圖9 SegNet、AA-SegNet網絡模型建筑識別結果

表3 AA-SegNet網絡模型訓練結果

圖10 AA-SegNet、SegNet、DeepLabv3、U-Net網絡預測建筑結果

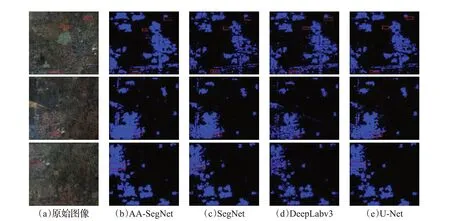

3.3 與相關網絡比較

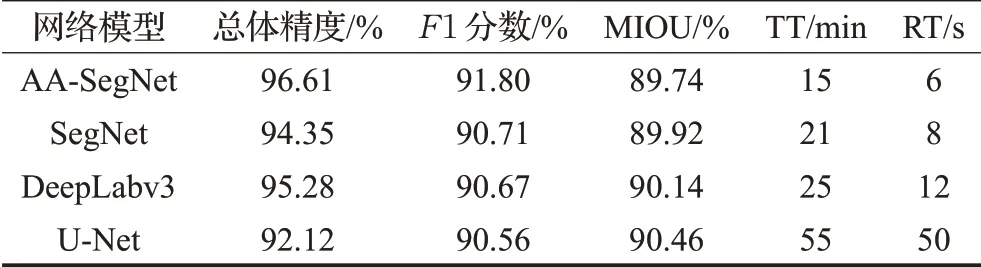

對比其他深度學習算法模型,將相同的數據集應用于SegNet、DeepLabv3、U-Net 和改進的AA-SegNet 網絡進行實驗。SegNet 網絡的解碼器是使用上采樣與卷積的過程,過度使用低級特征進行目標提取,會導致分割影像結果出現過度分割、小目標識別差現象。U_Net網絡采用通道維度拼接融合方式,來增加特征的描述信息,存在過度使用低級特征的問題。DeepLabv3網絡編碼器采用空洞卷積生成任意維度的特征,并采用空間金字塔池化策略,在級聯解碼器進而恢復邊界細節信息,也過度融合了低級特征。由于SegNet、DeepLabv3、UNet 缺乏注意力機制融合模塊、增強型空間金字塔池化模塊,一些低級特征被過度使用,導致識別圖像結果建筑物過度分割并且小目標識別效果差,分割結果建筑物出現碎片化,參見圖10(c)、(d)、(e)紅框標示部分。在圖10(c)中的紅框標示中,AA-SegNet 網絡結果明顯改善,說明空間注意力機制可以改善性能,降低碎片化,A-ASPP 精準提取小目標。為定量比較所提出的AASegNet 網絡,在表4(測試集,包括4 張尺寸為5 000×5 000圖像)中分別給出了OA、F1 得分、訓練時間TT和識別時間RT,可以看出,AA-SegNet 網絡OA 得分明顯優于SegNet、DeepLabv3和U-net網絡,其網絡訓練時間和識別時間都優于DeepLabv3 和U-net 網絡(TT:15<21<25<55,RT:6<8<12<50),具有比較高的效率。總的來說,盡管存在很少一部分錯誤的建筑分類,見圖11(b)和(d)紅色框標示部分,但總體來說,AA-SegNet網絡從高分辨率遙感影像中能夠實現更好的建筑用地提取效果。

表4 相同數據集上對比相關網絡測試結果

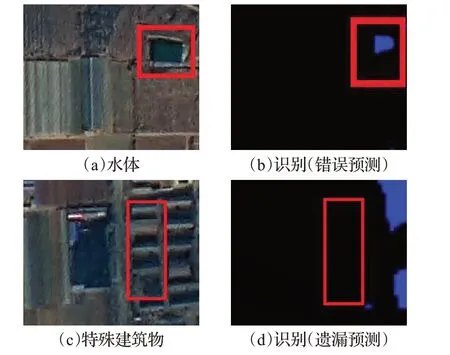

圖11 某些因素導致建筑物提取中錯誤檢測和漏檢

4 討論

AA-SegNet 優越性的主要性能是通過組合增強型空間金字塔池化和空間注意力融合模塊,合理利用不同級別的特征,提高小目標識別。另外,公共編碼器-解碼器[31-32]網絡主要使用跳躍連接來幫助解碼器逐漸恢復對象細節。然而,通過跳躍連接將這些特征映射與更高級別的特征映射融合可以增加最終結果的模糊性,這將導致過度使用低級特征并導致過度分割。注意力機制可以使用更高級別的視覺信息來加權較低級別的信息以抑制背景和噪聲。因此,基于注意力機制的空間注意力融合模塊可以更好地指導低級特征圖,以幫助高級特征恢復影像的細節并減少過度分割。

但是,高分二號遙感影像建筑用地提取準確性可能會受到某些因素的影響,如圖11所示。

復雜的背景。雖然水,裸露和稀疏植被在一些測試樣本中占少數,但由于與前景物體(建筑物用地)色調相似,它們也被監測為建筑物用地,見圖11(a)、(b)紅色方框。復雜背景可能會導致精度低于召回,參見表2中數據集1 的評估結果。錯誤分類可能是所提AA-SegNet網絡的主要限制。

特殊建筑物。一些訓練樣本中,一些建筑物屋頂的特征(如顏色、紋理和材料),與大多數建筑物完全不同。另外,一些樹木覆蓋的建筑物的形狀無法準確檢測出來,一些模糊的和不規則的邊界難以分類。因此,很難檢測出這類建筑物,見圖11(c)、(d)紅色方框。

為削弱上述因素的影像,需要更加完善的深度學習網絡來提高特殊建筑用地提取的效率和準確率。另外,預處理方法在區分建筑用地與復雜背景方面也起著重要作用。例如,使用歸一化植被指數(NDVI)或歸一化差異水指數(NDWI)[34-35]來增強邊緣,則可能不會將水體誤判斷為建筑物。此外,目前關于多模態遙感數據融合技術[36]也可能提高建筑用地的準確性。預處理[37]方法和數據融合技術在將來的研究中進一步解決。

5 結論

本文提出的基于深度學習SegNet 結構改進的AASegNet網絡模型,能夠較好地解決高分辨率遙感影像中小物體分類效果差和過度分割問題。該網絡使用增強型空間金字塔池化模塊進行小目標提取,空間注意力融合模塊用于指導低特征圖,以幫助高特征圖恢復圖像的細節,減少過度分割。與深度學習方法SegNet、Deep-Labv3 和U-Net 進行比較,AA-SegNet 網絡在圖像識別率、OA、MIOU、F1 得分、TT和RT(基于像素)方面有更好的表現,展示了在識別遙感圖像建筑性能方面的有效性和可行性。