基于時空顯著性建模的空中飛行器跟蹤方法

張偉俊,鐘勝,王建輝

1. 華中科技大學(xué) 人工智能與自動化學(xué)院,武漢 430074 2. 華中科技大學(xué) 多譜信息處理技術(shù)國家級重點實驗室,武漢 430074

隨著機器計算能力的提升、人工智能與航空電子技術(shù)的日漸成熟,小型無人機逐漸步入應(yīng)用,在攝影攝像、智能監(jiān)控、地質(zhì)勘探、農(nóng)業(yè)自動化、災(zāi)害防范與救助等領(lǐng)域廣泛使用,具有很高的商業(yè)與社會價值[1-2]。另一方面,由于無人機具有體積小、監(jiān)測難度大的特點,其普及應(yīng)用帶來了較大的安全隱患,近年來無人機在機場附近違法飛行導(dǎo)致擾航的事件時有發(fā)生。此外,無人機也常被不法份子用于搬運違規(guī)物品、非法拍攝等。在機場、邊防、監(jiān)獄、軍事要地、以及其他涉及安全與機密的場所,使用技術(shù)手段對非法進入的無人機進行跟蹤、監(jiān)測、打擊或者捕獲的需求與日俱增[3]。

與基于雷達、射頻、音頻等技術(shù)的反無人機方案[4]相比,基于視頻技術(shù)的方案具有可視化程度高、定位準確的特點,可實現(xiàn)檢測、跟蹤、識別、取證等功能的有機結(jié)合,并且為激光毀傷、干擾、捕獲等后續(xù)手段提供準確的位置信息。視覺跟蹤技術(shù)[5]作為其中的重要模塊,其算法準確度與魯棒性很大程度上影響了反無人機方案的成功率,因此提高針對無人機目標的視覺跟蹤技術(shù),具有重要的實用價值[6]。

與此同時,近年來安全與軍事領(lǐng)域趨向于智能化,視覺目標跟蹤技術(shù)在其中的應(yīng)用受到各個國家的重視。使用跟蹤算法輔助導(dǎo)彈的精確制導(dǎo),實現(xiàn)對空中戰(zhàn)爭目標的精準打擊,是一項非常重要的應(yīng)用需求[7-8]。通過視覺跟蹤技術(shù)與雷達等其他探測設(shè)備的配合實現(xiàn)更精確的偵查預(yù)警,可以有效提高軍隊的戰(zhàn)斗能力。

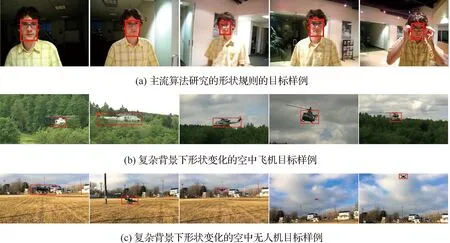

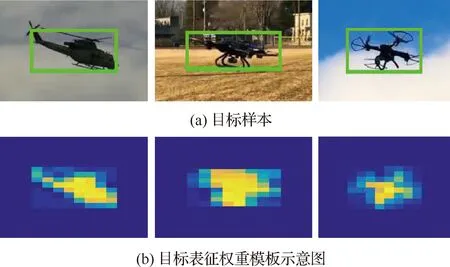

目前主流跟蹤算法[9-12]研究的目標大多數(shù)形狀規(guī)則方正、在跟蹤過程中與成像器角度比較固定,不存在明顯形變。相比之下,空中飛行器由于成像姿態(tài)、角度與距離變化導(dǎo)致目標形狀、大小、寬高比持續(xù)變化,同時存在復(fù)雜背景干擾的問題,跟蹤難度更大,兩者的典型例子對比如圖1 所示。

圖1 主流算法跟蹤目標與空中飛行器目標對比Fig.1 Comparison of target tracked by mainstream algorithms and airborne targets

現(xiàn)有跟蹤方法由于目標表征模型不夠精確,容易受上述變化影響,隨著誤差累積定位到目標局部或者擴大區(qū)域,逐漸偏離目標,在長期跟蹤任務(wù)中無法保證足夠的精度與魯棒性。

空中飛行器類的目標由于與背景完全獨立,表觀特性通常與背景區(qū)域具有一定的反差,這一特點可通過視覺顯著性機制來建模表達。針對此類形狀變化較為突出的獨立物體,我們研究如何在視覺跟蹤場景中構(gòu)建合理的目標顯著性模型,用于提高跟蹤器在目標尺度、形狀變化、復(fù)雜背景等因素影響下的算法魯棒性。

視覺顯著性檢測通過模擬人眼的視覺注意機制,在圖像中選取優(yōu)先處理區(qū)域,提供給其他較上層的算法使用,經(jīng)典代表性方法包括基于空間域的方法、基于頻譜域的方法、基于圖論的方法等[13]。近年來提出的基于距離測度的方法[14-15]使用背景先驗和距離度量來估計像素點的顯著性,在數(shù)據(jù)集上取得了不錯的效果。此外,針對視頻序列中的顯著性檢測,一些研究者提出對于時間域的信息進行有效利用,建立時空(Spatio-temporal)注意力計算模型[16]。

在目標跟蹤算法中引入顯著性模型,可以模擬人眼視覺注意機制的作用,為采樣、特征選擇、目標定位等提供先驗知識,從而提高跟蹤效率和準確率。一些研究者提出適用于跟蹤場景的顯著區(qū)域判斷方法,選擇局部顯著區(qū)域子塊分別進行跟蹤,再使用這些子塊的跟蹤結(jié)果來進行目標的定位[17-18]。另外一個常見的研究思路是對目標搜索區(qū)域進行顯著圖的計算,利用顯著圖完成目標的定位[19]。Choi等則采取多核多特征的策略,構(gòu)造了一組基于顯著性特征的相關(guān)濾波器,再對所有濾波器預(yù)測結(jié)果進行融合得到最終跟蹤結(jié)果[20]。

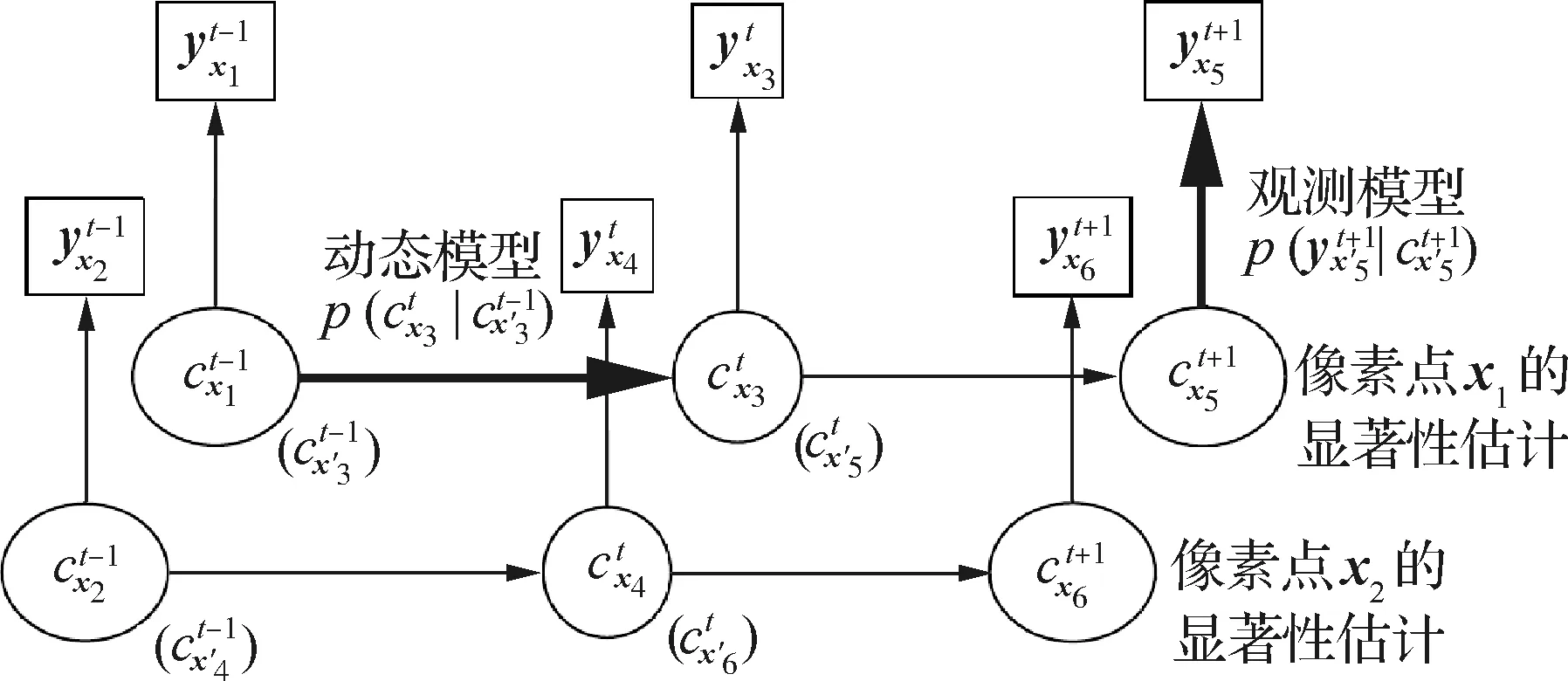

有別于上述目標跟蹤文獻普遍使用單幀圖像進行顯著性估計的做法,由于跟蹤場景中圖像觀測隨時間遞增,而且?guī)g存在運動關(guān)聯(lián),本文提出一種新穎的時空顯著性計算模型,對時間域上的關(guān)聯(lián)信息以及當前幀空間域圖像觀測信息進行集成利用。此外,模型的構(gòu)建利用了目標跟蹤任務(wù)場景提供的背景先驗知識。因此,在本文模型中,目標鄰域的顯著性估計與目標跟蹤形成迭代交互的2個聯(lián)合子問題。

其中,目標跟蹤算法給出了上一幀的目標定位信息,為圖像顯著性估算提供背景區(qū)域粗略位置、表觀特性等方面的先驗知識,用于指導(dǎo)顯著性檢測模型的構(gòu)建。顯著性模型通過構(gòu)建像素級貝葉斯概率推斷框架,集成時間域上的關(guān)聯(lián)信息以及當前幀空間域圖像觀測信息。通過對跟蹤場景先驗知識以及多幀圖像觀測信息的融合利用,該方法能夠在背景復(fù)雜的情況下,對目標鄰域得到魯棒的顯著性估計結(jié)果。

反過來,計算得到的顯著圖用于模擬人眼系統(tǒng)注意機制,為目標跟蹤算法提供特征采樣方面的先驗知識。具體的,以基于矩形模板目標表征的算法為基礎(chǔ),在顯著圖的指導(dǎo)下選取有效視覺特征,構(gòu)建更為精確的目標表征模型。在空中飛行目標跟蹤過程中,所構(gòu)建的目標表征使得算法能夠有效區(qū)分目標與背景區(qū)域,及時調(diào)整目標的寬高比與尺度估計,更為精確地定位不同背景干擾下的飛行目標,在長期跟蹤過程中保持穩(wěn)定準確的目標位置與尺度估計。

1 目標鄰域的時空顯著性估計

1.1 時空顯著性建模

圖2 時空聯(lián)合顯著性估計問題的貝葉斯網(wǎng)絡(luò)表示Fig.2 Bayesian network representation of spatio-temporal saliency estimation problem

(1)

式中:x′表示t時刻的像素點位置x在t-1時刻對應(yīng)的位置。記像素位置x在第t幀的后向光流場為Mt(x),則像素位置x的在第t-1幀在對應(yīng)的位置為

x′=x+Mt(x)

(2)

(3)

背景先驗理論[21]用于背景區(qū)域已知的情況下在自然圖像中進行顯著物體檢測,在目標較大且處于圖像中央的情況下,假設(shè)圖像的邊界為背景區(qū)域。本文提出在目標跟蹤場景中對背景先驗進行應(yīng)用,背景區(qū)域的先驗知識由目標跟蹤模塊提供,如圖3所示。

圖3 目標位置與提供的背景先驗示意圖Fig.3 Demonstration of target position and background prior provided

1.2 基于顏色統(tǒng)計模型的觀測量

目標跟蹤算法中,為區(qū)分目標和背景像素,常見的做法是使用統(tǒng)計建模方法,對目標與背景建立基于顏色特征的表觀模型。生成式模型致力于對目標/背景顏色空間的分布分別建立模型進行數(shù)據(jù)擬合,判別式模型則通過訓(xùn)練分類器,比如使用直方圖分類器來對兩者進行區(qū)分[22-23]。一方面,由于目標和背景像素在顏色空間具有多模分布的特點,而且模式個數(shù)不確定,生成式模型通常難以進行十分有效的數(shù)據(jù)擬合,另一方面,兩者在顏色空間通常呈現(xiàn)線性不可分的特點,也給判別式模型分類器的訓(xùn)練帶來了難度。

相對于目標而言,背景在顏色空間的分布通常具有更多的較為確定的規(guī)律性,且其模式分布與方位明顯呈現(xiàn)較大的相關(guān)性。從圖3中的典型目標跟蹤場景可以看到,目標上下左右4個方位的背景區(qū)域分別具有各自的簡單模式分布。相比于對整個背景區(qū)域進行統(tǒng)計建模,按照不同方位分別進行統(tǒng)計建模的方法更為合理準確。因此,本文提出對背景先驗的一種應(yīng)用方式,通過統(tǒng)計各方位背景區(qū)域在顏色空間的分布,計算搜索區(qū)域每個像素點與各個方位背景區(qū)域在顏色空間上的距離,以此進行距離觀測量的計算。

(4)

(5)

1.3 基于最小障礙距離的觀測量

1.2節(jié)假設(shè)和背景區(qū)域在顏色上差異越大的像素,屬于顯著區(qū)域的概率也越高。類似地,在像素位置空間,和背景區(qū)域距離越遠的像素,其顯著性程度越高。由于我們以上一幀目標位置為中心選取背景區(qū)域,如果直接在像素位置空間上計算背景距離,則距離最大的點為上一幀目標中心,這導(dǎo)致在目標快速運動的情況下會出現(xiàn)較大的估計誤差。因此,為了對位置空間的距離信息進行利用,綜合地考慮位置和灰度兩方面的信息,在位置-灰度聯(lián)合空間上定義距離測度,以確保在目標和背景顏色特征相似、以及目標運動速度較快的情況下均能夠給出魯棒的顯著性估計結(jié)果。

理論上,需要定義搜索區(qū)域Ωt中每個像素點到背景區(qū)域的距離測度。假定基于該區(qū)域的二維單通道圖像來進行計算,應(yīng)用背景先驗將區(qū)域邊緣像素取作背景種子點,區(qū)域中一條從某像素點到背景種子點的路徑記為π=〈π(0),π(1),…,π(k)〉,其中π(i)和π(i+1)是圖像區(qū)域Ωt中相互鄰接的2個像素,使用4鄰域的像素鄰接定義。

D(x)=minπ∈ΠS,x(π)

(6)

式中:ΠS,x為連接S和x之間的所有路徑,式(6)對所有可能的路徑進行尋優(yōu),找到路徑消耗最短的路徑,以其路徑消耗衡量該像素點離背景區(qū)域S的距離。兩個像素位置x1和x2之間的路徑消耗函數(shù)可采用不同的方式進行定義,應(yīng)滿足性質(zhì)(x1→x2)=(x2→x1)≥0。距離測度的定義取決路徑消耗函數(shù)(π)的定義,最終取決于不同的應(yīng)用。

一種經(jīng)典的定義是使用測地距離[21](Geodesic Distance),可以對像素位置和灰度2個空間的距離進行綜合的衡量。這種方法累加了路徑上所有相鄰像素點的灰度差作為路徑消耗,其定義為

(7)

式中:I(·)為相應(yīng)像素位置中的圖像灰度值。文獻[15]使用最小障礙距離作為一種新的距離測度來配合背景先驗進行顯著性檢測,其路徑消耗定義為

(8)

圖4 基于顏色與基于距離的目標似然概率估計 結(jié)果對比Fig.4 Comparison between results of color-based and saliency-based target likelihood estimation

2 基于顯著性信息指導(dǎo)的目標跟蹤

2.1 最大間隔分類器模型

采用基于檢測器的目標跟蹤框架,其核心思想是在歷史跟蹤圖像上采集正負目標樣本訓(xùn)練分類器,在當前幀通過一定的預(yù)測搜索策略產(chǎn)生大量的候選樣本,使用之前訓(xùn)練的分類器對這些樣本是目標物體的概率進行估計,選取最佳樣本作為跟蹤輸出結(jié)果。

具體選擇結(jié)構(gòu)化輸出支持向量機[24]作為分類器。在訓(xùn)練階段,采用最大間隔分類思想,尋找使得正負樣本特征向量之間間隔最大的分類平面,得到分類器參數(shù)。在檢測階段,樣本的分類標簽通過特征向量與分類器參數(shù)線性運算得到。

具體的,在第t幀的時候,在圖像It中采集大量候選樣本形成集合Qt,從中選擇一個作為的目標矩形框pt,以使得目標函數(shù)最大化:

pt=argmaxp∈Qt〈hIt,p,θt-1〉

(9)

式中:〈·〉表示向量內(nèi)積操作;θt-1為第t-1幀使用歷史數(shù)據(jù)訓(xùn)練得到的分類器模型參數(shù),表示支持向量機分類平面的法向量;hI,p為對圖像I中的矩形窗口p提取的特征描述符構(gòu)成的目標表征向量。n個描述符根據(jù)在矩形窗口中的位置排列, 按順序堆疊成列向量對目標物體進行結(jié)構(gòu)化表征,記為

(10)

2.2 基于顯著性的目標表征

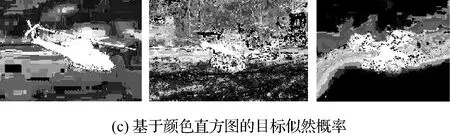

以基于矩形模板的目標表征模型為基礎(chǔ),采用8×8的特征網(wǎng)格對目標進行結(jié)構(gòu)化表示。網(wǎng)格點的每個特征描述符包含8方向的梯度直方圖,以及各通道維數(shù)為8的RGB顏色直方圖,構(gòu)成32維度向量。在主流目標跟蹤方法的目標表征過程中,由于不具備關(guān)于目標輪廓方面的知識,對于矩形框內(nèi)所有位置的特征描述符同等對待。

在本文的模型中,由第1節(jié)計算得到的顯著性概率圖可用于模擬人眼系統(tǒng)注意機制,為目標跟蹤算法提供特征選擇方面的先驗知識,以構(gòu)造更為精確的目標表征模型。使用特征描述符所在網(wǎng)格點鄰域的平均顯著性概率對其進行加權(quán),即

(11)

(12)

式中:Ωx為像素位置x的鄰域像素點集合。圖5給出了一些典型的目標樣本以及對應(yīng)的目標表征權(quán)重模板{αxk}。從圖中可以看出,權(quán)重模板的使用抑制了矩形模板中非顯著區(qū)域的特征描述符,使得目標表征模型更為精確,能夠有效消除背景中疑似物體的干擾。

圖5 基于顯著性的目標表征示意圖Fig.5 Demonstration of saliency-based target representation

2.3 多方向多尺度搜索策略

空中飛行器目標在跟蹤過程中由于姿態(tài)角度變化,存在的一個典型挑戰(zhàn)性因素是如圖1(b)和圖1(c)所示的目標寬高比變化。現(xiàn)有的基于檢測的跟蹤方法在尺度估計方面,一類典型的做法是采用固定大小的目標模板[10-11],另一類使用固定寬高比的模板,使用一個參數(shù)s表示模板的尺度大小,對該參數(shù)進行估計[12]或者同時在多個尺度上檢測目標[25]。這些做法顯然都無法滿足對空中飛行器進行魯棒準確跟蹤的需求。

不同于上述方法使用固定寬高比的做法,本文使用sx和sy兩個尺度縮放參數(shù)分別標記x和y方向的尺度變化,在每一幀進行多方向的多尺度檢測。為了避免同時改變2個方向尺度縮放參數(shù)帶來的計算成本大幅增加,提出一種對2個方向的尺度變化進行分步估計的做法。具體的,首先在不改變目標寬度的情況下,在y方向使用多個尺度縮放因子Sy={0.99,1,1.01}進行多尺度并行檢測,使用式(9)中目標函數(shù)得分最大的N個樣本投票決定sy,然后在固定目標高度的情況下,對x方向同樣使用多個尺度縮放因子進行多尺度并行檢測,使用式(9)選取最優(yōu)樣本作為算法輸出結(jié)果。由于大多數(shù)實際應(yīng)用中目標尺度變化較為緩慢,同時出于計算成本的考慮,本文在實驗與實際應(yīng)用中均使用3個尺度的縮放因子。

3 實驗結(jié)果與分析

3.1 實驗概述

本文實驗分為2個部分:第1部分基于課題應(yīng)用背景,使用提出的算法對空中飛行器進行跟蹤,與其他主流方法進行性能比較和分析,并且對本方法進行消融實驗分析。第2部分為驗證本文算法模型具有一定的通用價值,在最常見的通用物體跟蹤數(shù)據(jù)集OTB-100[9]上進行性能評估,與相關(guān)性程度較高的的主流算法進行重點比較。

本文算法在配備了Intel Core i7處理器、8 GB內(nèi)存的個人計算機上運行,使用C++實現(xiàn),平均運行幀率為15 fps。對于實驗比較的其他主流先進方法,第1部分實驗結(jié)果使用原作者提供的代碼和默認參數(shù),在本課題應(yīng)用提供的數(shù)據(jù)集上進行跟蹤實驗獲得,第2部分的實驗使用公開的通用物體跟蹤數(shù)據(jù)集OTB-100,直接采用原作者提供的實驗結(jié)果。

3.2 空中飛行器數(shù)據(jù)集實驗

本節(jié)實驗基于安防等實際應(yīng)用背景,驗證本文算法在常見空中飛行器(飛機、無人機)跟蹤任務(wù)中相對于其他方法的巨大優(yōu)勢。與主流跟蹤數(shù)據(jù)集中的常見目標相比,空中飛行器跟蹤場景具有目標形狀、大小、寬高比持續(xù)變化、存在復(fù)雜背景干擾等突出的難點問題。由于目前尚無結(jié)合該應(yīng)用背景的數(shù)據(jù)集可用,與項目合作單位采集構(gòu)建了飛行器跟蹤數(shù)據(jù)集,包含不同天空與地面背景下的10個無人機序列和20個飛機序列,部分序列來自LaSOT數(shù)據(jù)庫[26]。遵循主流目標跟蹤數(shù)據(jù)集的通行做法,視頻每一幀中的被跟蹤目標使用外接矩形框的方式進行了人工標注,以方便對算法跟蹤性能進行評估比較。

在本實驗中,選取了16個代表性的方法進行比較,具體可分為4類:① 與本文方法同樣基于最大間隔分類器的判別式模型算法Struck[24]和MEEM[11];② 經(jīng)典的相關(guān)濾波類的算法CSK[27]、KCF[10]、SAMF[28]、Staple[23]、SRDCF[29];③ 近兩年提出的基于手工特征的相關(guān)濾波改進算法fDSST[12]、Staple_CA[30]、CSRDCF[31]、ECO_HC[32]以及MCCT_H[33];④ 近年來興起的基于深度學(xué)習與卷積神經(jīng)網(wǎng)絡(luò)特征的CFNet[34]、VITAL[35]、TRACA[36]與ASRCF[37]方法。這些方法尤其是后兩類覆蓋了目前最先進的主流目標跟蹤方法。

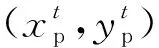

遵循主流數(shù)據(jù)集的評估方法,基于中心位置誤差和重疊率指標進行統(tǒng)計,通過精度圖和成功率圖顯示比較各算法的跟蹤性能。本實驗采用一次通過估計(One Pass Evaluation,OPE)的方式給出跟蹤算法的精度圖與成功率圖,即從視頻開頭使用標注的基線矩形框進行初始化,對算法在整個視頻跟蹤過程中的性能指標進行統(tǒng)計,通過考察算法的長期跟蹤能力評估其實用價值。

中心位置誤差(Center Location Error, CLE)是被廣泛使用的一個評價標準,具體指跟蹤所得的目標中心位置與基準中心位置之間的歐氏距離,單位為像素,即

(13)

圖6(a)顯示了參與測評的算法在數(shù)據(jù)集上的精度圖,橫坐標為中心位置誤差閾值,縱坐標為精度(Precision),表示中心位置誤差小于該閾值的視頻幀數(shù)比例。使用SCLE為20的精度指標衡量算法在數(shù)據(jù)集上的綜合性能,對其進行排序,顯示在算法名稱前面。

從圖6(a)中可看出,本文方法在數(shù)據(jù)集上成功跟蹤的幀數(shù)比例為40.9%,高于其他使用手工特征的高效算法,其中性能表現(xiàn)最好的ECO_HC和MCCT_H跟蹤成功幀數(shù)比例分別為38.6%和36.6%。總體上,本文方法與包括VITAL、CFNet、ASRCF在內(nèi)的基于深度學(xué)習的最新跟蹤器均取得了較好的跟蹤精度。本文方法跟蹤精度低于非實時的VITAL跟蹤器,略低于CFNet方法,略高于ASRCF方法。

重疊率(Overlap)是另一個常見的算法評價標準, 具體定義為

(14)

圖6 在飛行目標跟蹤數(shù)據(jù)集上的實驗結(jié)果Fig.6 Experimental results of airborne visual tracking dataset

圖6(b)顯示了各個算法在數(shù)據(jù)集上的成功率圖,橫坐標為不同閾值的重疊率,縱坐標為成功率(Success Rate),表示重疊率大于某個閾值的幀數(shù)比例。成功率曲線的曲線下方面積(Area Under Curve,AUC)被用作算法之間排序度量的指標,顯示在算法名稱前面。在成功率圖上排名靠前的為本文方法與基于深度學(xué)習的VITAL、ASRCF以及CFNet方法,與精度圖顯示的結(jié)論一致。不同的是,本文方法與VITAL分居前兩名,AUC值基本持平,明顯高于其他方法,說明本文方法受益于提出的時空顯著性估計以及多方向多尺度搜索策略,在目標尺度估計方面具有明顯的優(yōu)勢。

3.3 典型飛行器序列跟蹤結(jié)果

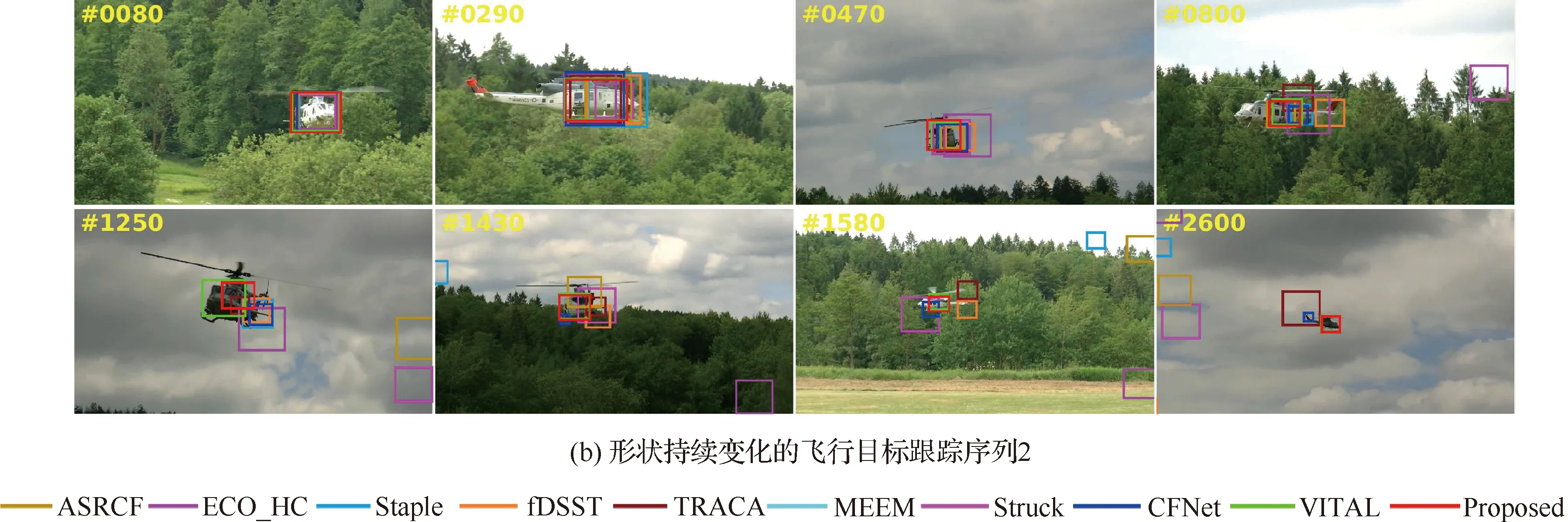

從3.2節(jié)使用的空中飛行器跟蹤數(shù)據(jù)集里面,選取了一些典型的序列進行展示分析,以比較跟蹤器在常見挑戰(zhàn)性因素影響下的魯棒性。所比較的方法包括本文方法,3.2節(jié)實驗中性能靠前的基于深度學(xué)習的VITAL、CFNet、TRACA和ASRCF方法,以及其他兩類方法中的代表性算法Struck、MEEM、fDSST、Staple和ECO_HC方法。

圖7~圖9顯示了本文方法和上述9個主流方法在這些典型序列上的跟蹤結(jié)果,使用不同顏色的矩形框?qū)Ω鞲櫰鞯妮敵鼋Y(jié)果進行標識。為了比較詳盡地展示跟蹤過程,對每個圖像序列按照時間順序從前到后截取了多幅圖像進行分析,圖像的幀號在左上角使用黃色的數(shù)字顯示。

1) 較為簡單的飛行器序列跟蹤效果

圖7(a)顯示了一個比較簡單的無人機跟蹤序列,目標在跟蹤過程中姿態(tài)、形狀、尺度均無明顯變化。但是由于受到路面標記和無人機影子的干擾影響,較傳統(tǒng)的Struck、fDSST、MEEM算法先后偏離到背景區(qū)域,Staple算法存在較大的尺度估計誤差導(dǎo)致后期丟失目標。

圖7(b)同樣是相對簡單的跟蹤序列,背景簡單干凈,飛機在飛行過程中姿態(tài)變化不大,僅存在成像距離引起的尺度變化,大多數(shù)跟蹤器都能夠比較準確地定位目標位置。其中,Struck和MEEM方法在第1 500幀之后估計的目標尺度過小在后續(xù)跟蹤過程中出現(xiàn)不同程度的偏移。相比之下,深度學(xué)習類的方法與本文方法能夠很好地適應(yīng)飛行目標的尺度變化,得到準確的位置與尺度估計。

圖7 較為簡單的飛行目標跟蹤效果圖Fig.7 Demonstration of tracking results of simple airborne sequences

圖7(c)和圖7(d)中的序列由于目標存在平面內(nèi)或平面外的旋轉(zhuǎn),導(dǎo)致形狀、寬高比發(fā)生變化,對跟蹤器的魯棒性提出了一定的要求。Staple、MEEM和fDSST方法在這兩個序列均中途丟失目標;TRACA方法隨著目標形狀變化逐漸偏離到背景區(qū)域;Struck方法在2個序列中都成功定位到目標物體上,但是尺度估計沒有及時調(diào)整,出現(xiàn)尺度過大或者過小的情況;CFNet和VITAL在序列圖7(d)中后期丟失目標,在序列圖7(c)上具有很好的跟蹤效果;ASRCF和ECO_HC在序列圖7(c)由于尺度估計偏差逐漸偏離目標,導(dǎo)致中途丟失,在序列圖7(d)中后期同樣出現(xiàn)明顯的尺度估計偏差;本文方法則在兩個序列上均具有很好的跟蹤精度和魯棒性。

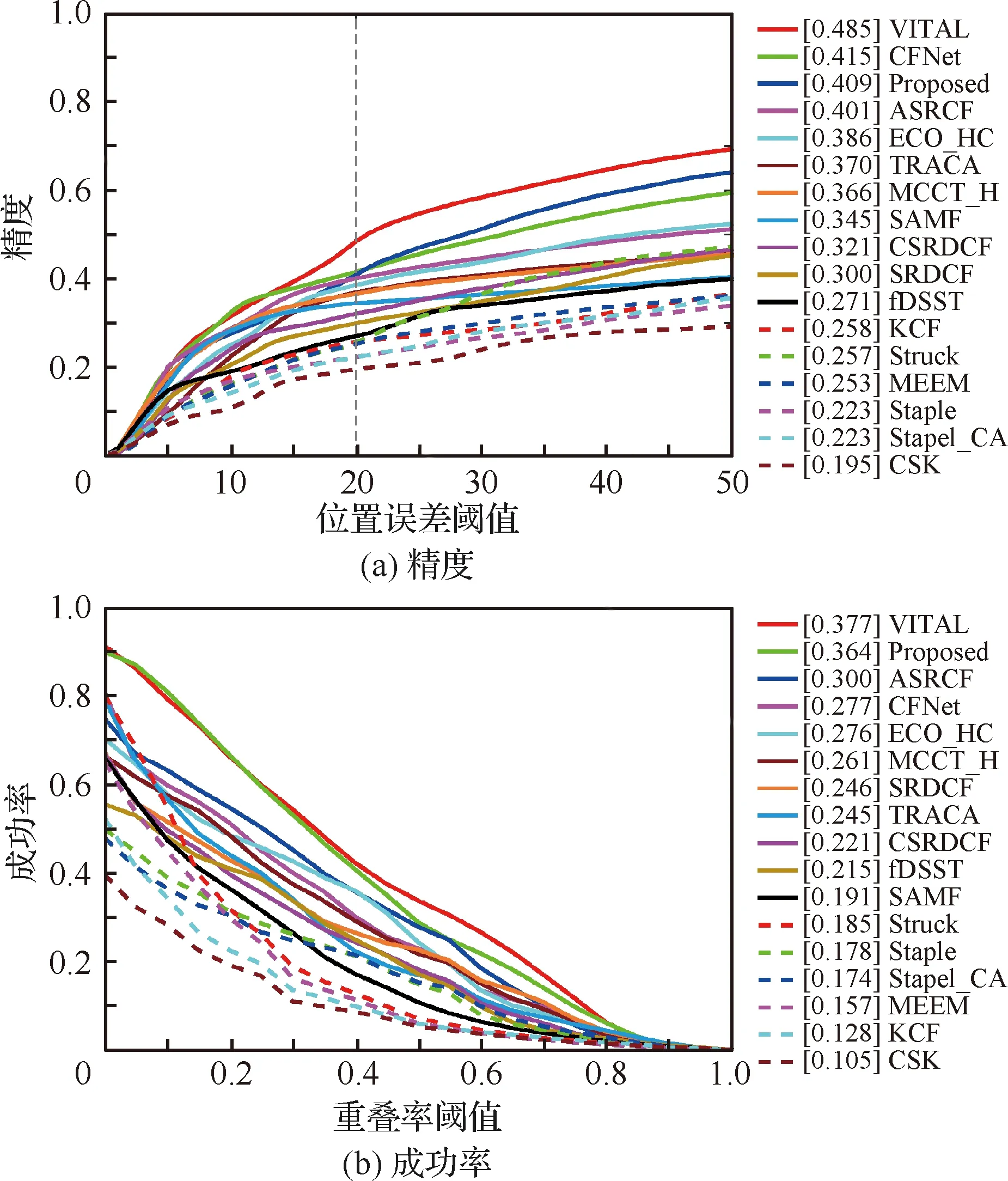

2) 復(fù)雜背景下的飛行器序列跟蹤效果

圖8顯示了2個典型的復(fù)雜背景干擾下的無人機序列,無人機目標在飛行過程中經(jīng)過草地、樹木、建筑物、天空、云層等典型背景,而且存在不同程度的尺度變化,具有很高的跟蹤難度。由于序列較長且跟蹤過程中背景變化較多,對每個序列均摘取了跟蹤過程中的8個畫面進行展示分析。

在序列圖8(a)第200幀的時候參與測試的跟蹤器都能準確地定位目標位置,到500幀的時候,ASRCF、fDSST、Staple和MEEM方法均跟蹤失敗,Struck和TRACA也在后續(xù)跟蹤過程中由于尺度估計過大,在目標框中包含了大量的背景區(qū)域,算法建立的目標模型受到背景信息污染,逐漸偏移到背景區(qū)域。ECO_HC在650幀左右、1 340幀左右均出現(xiàn)丟失現(xiàn)象,在其他幀存在尺度估計偏大的問題。CFNet在650幀之后完全丟失目標,而VITAL和本文算法則在后續(xù)背景切換和尺度變化的干擾下,完成整個序列2 000多幀圖像的穩(wěn)定跟蹤。

序列圖8(b)顯示了類似的跟蹤效果。在第50幀的時候所有的跟蹤器均能準確定位目標,而在后續(xù)的目標快速移動與尺度變小過程中,尺度估計不準確的ASRCF、Staple、fDSST、Struck和MEEM跟蹤器先后偏移到背景區(qū)域,逐漸丟失目標。本文方法與ECO_HC、VITAL、CFNet、TRACA均對總共2 000多幀圖像完成了飛行器目標的長時間穩(wěn)定跟蹤,在后期本文算法的尺度估計明顯比其他方法更為準確。

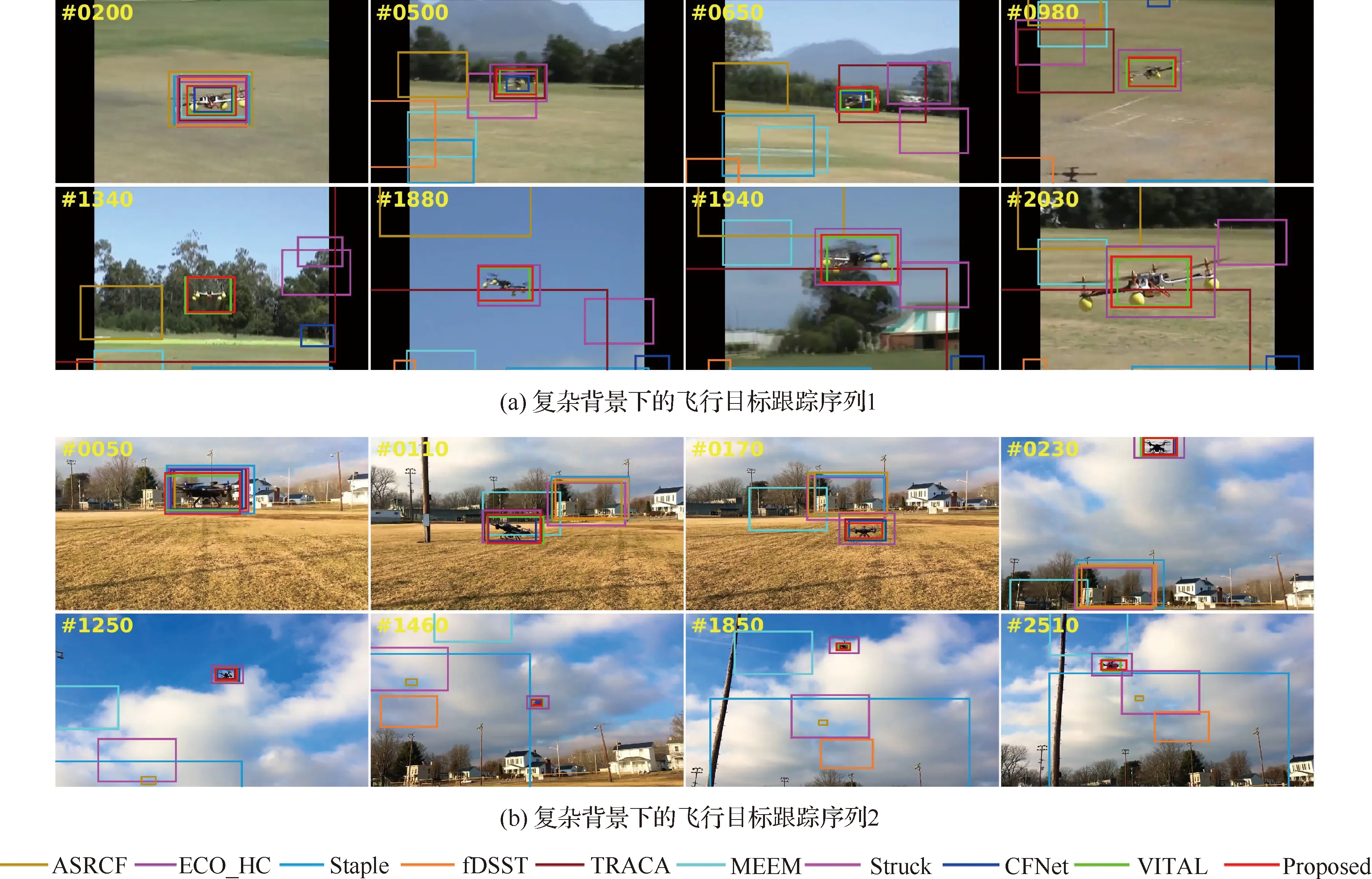

3) 形狀持續(xù)變化的飛行器序列跟蹤效果

不同于傳統(tǒng)視頻監(jiān)控場景中的行人/車輛等目標成像視角固定,形狀與寬高比沒有顯著變化,尺度變化緩慢,飛行器目標在跟蹤過程中存在視角變化、距離變化、目標翻轉(zhuǎn)運動等引起的目標形狀、尺度、寬高比持續(xù)變化,對于跟蹤算法在定位與尺度估計上的精度都具有較高的要求。圖9展示了此類飛行器跟蹤序列中的2個例子,每個序列均展示了跟蹤過程中的8個畫面。從圖中可以看到,對于這兩個高難度的跟蹤序列,本文方法總體上能夠很好地適應(yīng)目標形狀與寬高比變化,雖然在序列圖9(b)第800幀存在目標尺度估計不夠準確的問題,但是仍然取得了比其他所有跟蹤器更加準確的跟蹤結(jié)果,而且受益于時空顯著性模型提供的目標定位信息,在目標的后續(xù)變化中仍然能夠及時調(diào)整,保持對目標的準確定位,具有非常突出的魯棒性。

總體上,本文方法和VITAL在目標定位和尺度估計上均具有較高的精度,其他基于深度學(xué)習的方法目標定位方面表現(xiàn)較優(yōu),但是在目標的尺度估計方面精度不足。相比之下,VITAL方法運行幀率低于1 fps,遠小于本文方法,暫時不具備在實際需求場景中應(yīng)用的潛力。本文方法與CFNet、ASRCF、TRACA等深度學(xué)習方法相比,不僅具有尺度估計更加準確的優(yōu)勢,而且由于沒有使用卷積神經(jīng)網(wǎng)絡(luò)特征,不依賴于使用高性能GPU設(shè)備進行特征計算來達到實時跟蹤效果,可以用于一些不配備高性能GPU的場景,具有更廣泛的應(yīng)用范圍。

圖8 復(fù)雜背景下的飛行目標跟蹤效果圖Fig.8 Demonstration of tracking results of airborne sequences with background clutter

圖9 形狀持續(xù)變化的飛行目標跟蹤效果圖Fig.9 Demonstration of tracking results of airborne targets undergoing continuous deformation

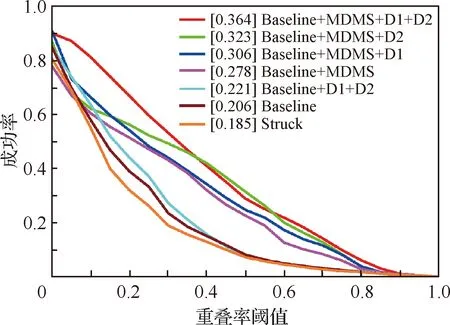

3.4 消融實驗

為論證方法主要思想對最終性能的影響,針對使用到的不同觀測以及多方向多尺度搜索策略,在飛行目標跟蹤數(shù)據(jù)集上對本文方法進行消融實驗分析,在圖10中顯示了實驗結(jié)果的成功率。本文方法各模塊標識如下:① Baseline表示本文提出的基準方法,使用最大間隔分類器配合2.2節(jié)提到的特征,不使用多方向多尺度搜索策略,不使用顯著圖進行特征選擇;② MDMS(Multi-Direction Multi-Scale)表示2.3節(jié)提出的多方向多尺度搜索策略;③ D1表示應(yīng)用顯著圖進行特征選擇,使用1.2節(jié)提出的觀測量;④ D2表示應(yīng)用顯著圖進行特征選擇,使用1.3節(jié)提出的觀測量。本文最終采納的方案即Baseline+MDMS+D1+D2。此外,Struck是使用最大間隔分類器的經(jīng)典基準方法[24],使用Haar特征進行目標表征,用于和Baseline對比。

圖10 在飛行目標跟蹤數(shù)據(jù)集上的消融分析Fig.10 Ablation analysis on airborne tracking dataset

圖10中的實驗結(jié)果顯示了若干重要的結(jié)論:① 在單獨消去D1、D2和MDMS模塊的情況下,本文方法性能出現(xiàn)不同程度的下降,成功率圖的AUC分數(shù)分別減小4.1%、5.8%和14.3%;② 在Baseline上直接增加顯著性模型,成功率圖的AUC從20.6%提升到22.1%,變化不明顯,而在Baseline+MDMS上,顯著性的加入使得AUC從27.8%提升到36.4%,表明MDMS對于顯著性的準確估計具有積極的影響,在本文方法中發(fā)揮十分重要的作用;③ 在Baseline+MDMS上,D1和D2的組合使用相比于單獨使用帶來了更為明顯的性能提升,說明兩者提供的信息具有一定的互補性。上述結(jié)果表明,本文方法各模塊之間具有密切的聯(lián)系,且對方法的性能提升均具有實質(zhì)性的貢獻。

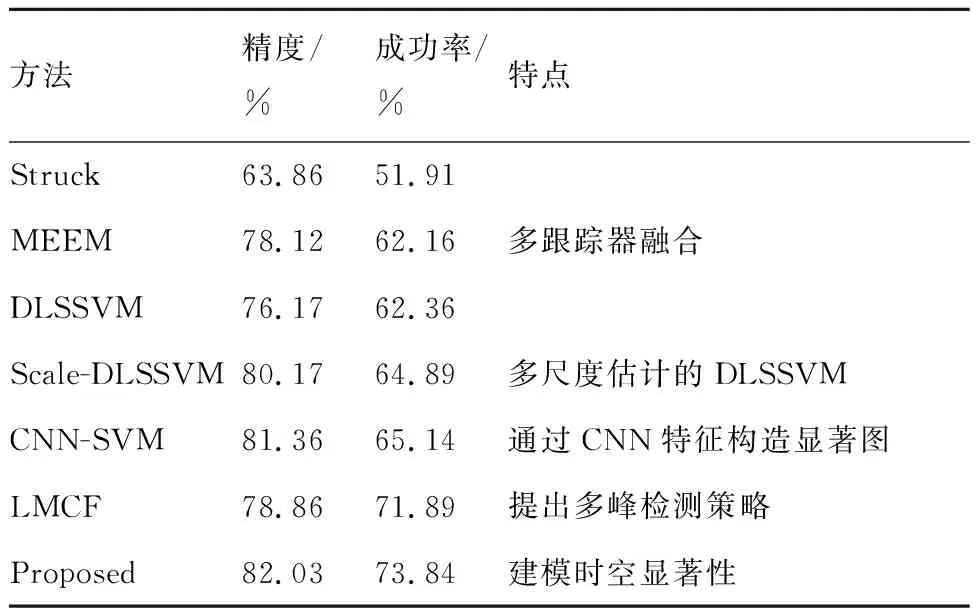

3.5 通用物體跟蹤性能

為了驗證本文的建模方法具有一定的通用價值,在目標跟蹤領(lǐng)域最常用的OTB-100測試數(shù)據(jù)集[9]上與主流的方法進行比較分析。參與比較的相關(guān)濾波類的代表性方法有DSST[12]、KCF[10]、Staple[23]、SRDCF[29]、ECO_HC[32]以及MCCT_H[33],深度學(xué)習類的代表性方法有CFNet[34]、ACFN[38]、TRACA[36]與ASRCF[37]方法。其中,ACFN具有和本文方法類似的出發(fā)點,對目標鄰域的顯著性進行了建模和估計。其他參與比較的Struck[24]、CNN-SVM[19]、LMCF[39]、MEEM[11]、DLSSVM/Scale-DLSSVM[25]方法與本文方法一樣,采用了最大間隔分類器作為基準分類模型,是本節(jié)實驗比較的重點。

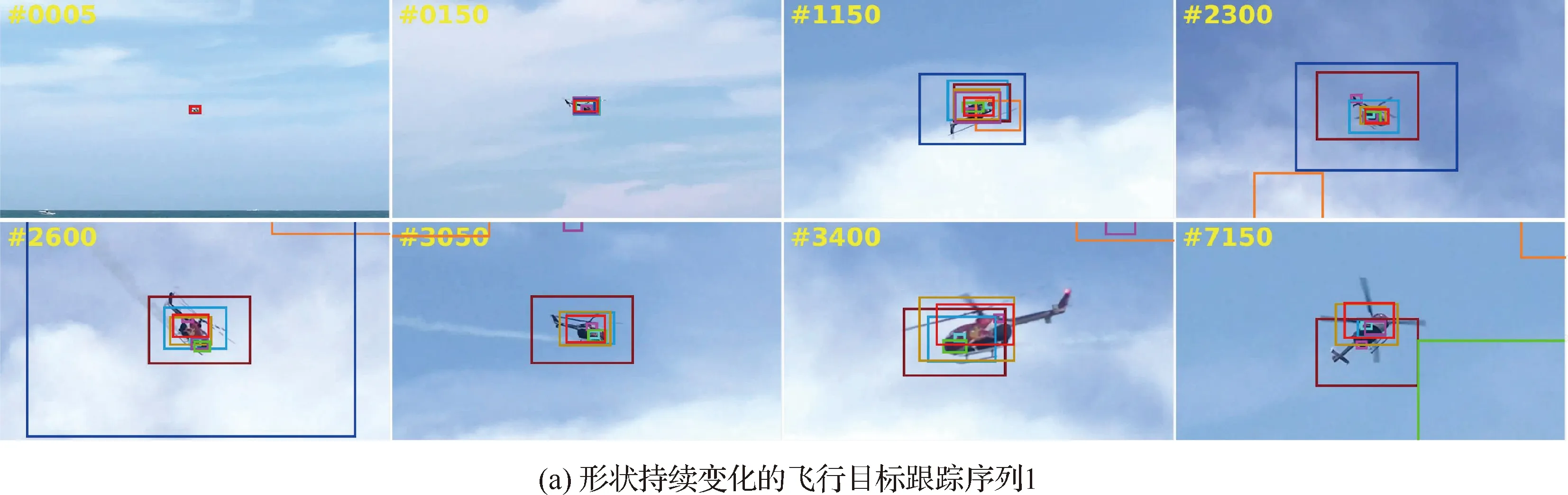

與3.2節(jié)的實驗類似,使用一次通過測試,即從視頻開頭使用真值進行初始化,對跟蹤過程中的每一幀使用式(13)和式(14)分別計算中心位置誤差和重疊率指標,再分別進行統(tǒng)計比較。圖11(a)顯示了參與測評的算法在OTB-100上的精度圖,橫坐標為中心位置誤差閾值,縱坐標為相應(yīng)的距離精度,算法名稱前面的中括號里顯示了中心位置誤差為20的距離精度,用來對算法進行排序。圖11(b)顯示了各個算法在數(shù)據(jù)集上的成功率圖,橫坐標為不同閾值的重疊率,縱坐標為成功率,成功率圖曲線的AUC被用作算法之間排序度量的指標。

從圖11中可以看到,雖然本文模型針對形狀寬高比變化的空中飛行器提出,但是在通用物體跟蹤任務(wù)上也有不錯的性能表現(xiàn),在精度圖與成功率圖上性能指標均優(yōu)于包括TRACA、CFNet、ACFN、LMCF等在內(nèi)的主流跟蹤方法中的代表性方法。本文方法在成功率圖上的AUC為60.5%,相比于基準方法Struck的46.2%提升了14.3%,典型精度則從63.9%提升到了82.0%。

圖11 OTB-100測試數(shù)據(jù)集上的實驗結(jié)果Fig.11 Experimental results of OTB-100 test dataset

表1給出了已知的使用最大間隔分類器方法的主流跟蹤方法,第2列給出了算法的典型精度(中心位置誤差小于20像素的幀數(shù)百分比),第3列給出了典型成功率(重疊率大于0.5的幀數(shù)百分比),并列出了每個方法的特點。

表1 使用最大間隔分類器的跟蹤方法性能對比

其中,CNN-SVM方法通過CNN特征反向投影構(gòu)造顯著圖,用于指導(dǎo)目標表征模型的構(gòu)建,取得了同類方法里面的次優(yōu)精度,但是成功率僅為65.14%,與本文方法的73.84%有較大的差距。提出多峰檢測策略的LMCF方法取得了同類方法里的次優(yōu)成功率,但是成功率與精度均明顯低于本方法。Scale-DLSSVM在DLSSVM基礎(chǔ)上加入多尺度估計,以犧牲運行效率為代價提升了算法對目標尺度變化的適應(yīng)能力,精度與成功率均有明顯提升,但是與本文方法相比仍然有一定差距。以上結(jié)果說明,本文方法在跟蹤精度與魯棒性上均優(yōu)于其他同類方法,估計的顯著圖以及提出的目標表征模型十分有效地提升了方法對目標尺度與形狀變化的魯棒性。

4 結(jié) 論

1) 本文提出一種新穎的時空顯著性估計模型。通過對跟蹤場景中的多幀圖像觀測數(shù)據(jù)以及背景先驗信息進行利用,估計的顯著圖對背景噪聲干擾具有很強的魯棒性,能夠指導(dǎo)空中飛行器跟蹤算法構(gòu)建精確目標表征模型,有效提升方法模型的魯棒性。

2) 提出的多方向多尺度目標搜索策略使得跟蹤算法在保證實時性的同時,更好地利用視覺表征信息,實現(xiàn)對目標寬高比變化的自適應(yīng)調(diào)整。

3) 提出的方法能夠克服空中飛行器跟蹤過程中背景復(fù)雜、目標形狀、寬高比變化等因素的干擾,跟蹤精度與魯棒性優(yōu)于大多數(shù)最先進的主流方法,并且在精度/魯棒性/平臺要求/運行速度上具有顯著的綜合優(yōu)勢,具有很高的實用價值。

4) 方法在其他類型物體的跟蹤任務(wù)上跟蹤精度與魯棒性均優(yōu)于其他同類方法,提出的思想方法與建模技術(shù)具有一定的普適性。