基于生成對抗網絡的紅外圖像電力設備超分辨算法研究

嚴利雄,劉曉華,李 茗,司馬朝進,劉志鵬

(國網湖北省電力有限公司檢修公司,湖北 武漢 430000)

1 介 紹

單圖像超分辨(SISR)問題指從對應的低分辨圖像恢復出高分辨的圖像[1]。深度學習和卷積神經網絡的發展,極大地促進了單圖像超分辨任務的進步[2-5]。然而,由于單圖像超分辨算法中輸入圖像的固有信息缺失,如低分辨率圖像中缺少對應高分辨圖像中的各種紋理信息,在超分辨倍數超過4時,會出現模糊的現象。最近的相關工作中,引入了感知損失、對抗損失,在較大上采樣倍數情況下,能夠實現較高的生成圖像視覺質量。但是這些方法可能產生虛假或者人工的紋理。

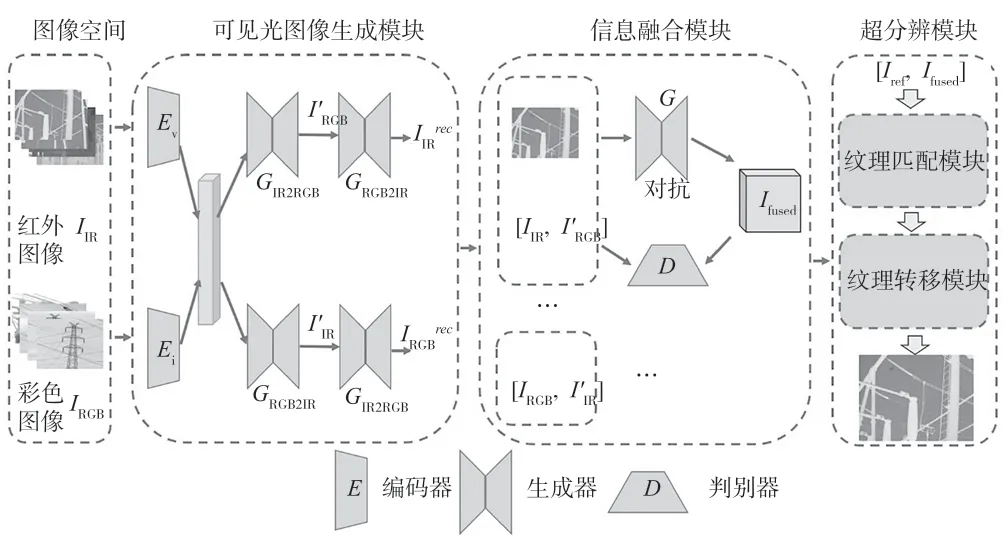

由于紅外圖像和可見光圖像之間的巨大模態差異,如果直接將適用于可見光圖像數據集上的超分辨算法用于電力設備紅外圖像,忽視電力設備紅外圖像和自然圖像之間固有的模態差異,將導致不能取得滿意的性能。因此,本文首先使用生成對抗網絡,生成紅外圖像對應的可見光圖像,然后基于可見光圖像的紋理信息能夠彌補低分辨紅外圖像的信息缺失,對紅外圖像進行增強,最后使用紋理匹配和轉移進行超分辨。

本文和現有的單圖像超分辨算法不同,探索了用于紅外圖像電力設備的基于參考圖片的超分辨算法,利用了來自高分辨參考圖像的紋理細節,補償在低分辨圖像中丟失的細節,生成更加詳細更加逼真的紋理。參考圖片來自不同的源域,如視頻幀、相冊、網絡爬蟲等。現有的基于參考的超分辨算法使用內在的參考或者外部圖像來增強紋理細節,取得了較好的視覺質量。但這些方法假定參考圖像和輸入低分辨圖像有著相同的內容,并且是對齊的圖像對。如果參考圖片和輸入圖片內容不一致或者圖片不對齊,這些方法的性能會急劇下降,甚至低于單圖像超分辨算法。與這些方法不同,本文不需要與輸入圖片內容相似或者對齊的參考圖像,只需將已知參考圖片的局部相似紋理信息轉移到低分辨圖片,進行超分辨。理想情況下,在給定良好的參考圖片時,本文提出的方法性能應當強于單圖像超分辨算法;在給出的參考圖像質量不佳或者缺少參考圖片時,本方法性能應當與單圖像超分辨算法性能相當。本文首先在特征空間中進行局部紋理匹配,隨后將匹配到的紋理通過深度模型轉移到輸出結果。紋理轉移模型學習低分辨圖像和參考紋理之間的復雜相似性,然后使用相似的紋理并抑制不同的紋理。

為了表明本文提出的方法有效性,并進行公平比較,本文還提出了一個電力設備紅外圖像數據集。本文的主要貢獻有如下3點。

(1)本文提出了一個新的信息融合模塊,利用可見光圖像的紋理信息來增強紅外圖像。

(2)本文提出了一個端到端的深度模型,用基于參考的超分辨算法解決電力設備紅外圖像超分辨問題,打破了單圖像超分辨算法的性能瓶頸(缺乏紋理信息),不需要圖像的對齊,通過多尺度神經紋理傳輸模塊來恢復紋理細節。

(3)本文構建了一個用于紅外圖像電力設備超分辨算法研究的數據集,在這個數據集上的廣泛實驗表明了本文方法的有效性。

2 相關工作

2.1 基于深度學習的單圖像超分辨算法

隨著深度學習在各項視覺任務上的快速發展,基于深度學習的單圖像超分辨算法[2-3]在視覺質量或者峰值信噪比(PSNR)、結構相似度(SSIM)中皆優于非深度學習方法,因此本文僅僅關注基于深度學習的方法。

Dong等人將卷積神經網絡引入超分辨算法[2],訓練了三層全卷積網絡,以減少生成圖像和原始高分辨圖像之間的均方誤差(MSE),展示了深度學習在超分辨中的有效性。Wang等人[3]將稀疏編碼和深度網絡用于超分辨算法,取得了巨大的改進。為了加快超分辨算法收斂過程,近年來,最先進的性能(PSNR指標)都是通過深度學習模型實現的[4-5]。

這些方法旨在盡量減少超分辨圖像和高分辨圖像之間的均方誤差(MSE),與人類評估(感知質量)并不是完全一致。因此,與感知相關的約束被引入到超分辨算法中,以實現更好的視覺質量。本文提出的方法也使用了感知損失與對抗損失,以更直觀地恢復合理的高分辨圖像。

2.2 基于參考的圖像超分辨算法

與使用單張低分辨圖像作為輸入的單圖像超分辨算法不同,基于參考的超分辨算法引入了其他圖像來幫助超分辨過程。參考圖像通常需要具有與低分辨圖像相似的紋理或者內容信息。參考圖像可以從視頻中的相鄰幀中選擇,或者來自網絡檢索的圖像。此外,還有一種使用輸入圖像自身的領域信息作為參考的方法,不使用外部參考圖像,因此更接近單圖像超分辨算法。這些方法主要構建從低分辨到高分辨的塊的修改的映射,并在像素級別或淺層模型融合高分辨修補步驟,因此不能對低分辨圖像之間的復雜依賴關系和從高分辨修補程序中提取的詳細信息進行建模。更通用的基于參考的算法是從網絡檢索類似的圖像,并進行全局檢索和局部匹配。但他們的方法基于如下假設:參考圖像與低分辨圖像完全對齊。使用光流來對齊輸入圖像和參考圖像,但光流在匹配長距離對應時性能受到限制,無法處理嚴重未對齊的參照圖像。本文提出了采用局部紋理匹配的思路,能夠處理長距離依賴。與現有的基于模板的超分辨方法一樣,本文也將模板圖像的紋理融合到最終輸出,但不是在圖像空間進行融合,而是通過深度模型在多尺度特征空間中進行融合,從而能夠將參考圖像中的相似紋理信息轉移到高分辨圖像上。

3 方 法

本文的核心目標是解決紅外圖像電力設備的超分辨問題。在實際中我們發現,紅外圖像對應的可見光圖像中的紋理信息,對于紅外圖像的超分辨具有重要意義,能夠彌補低分辨率電力設備紅外圖像的信息缺失,因此本文首先使用循環生成對抗網絡,為每一張電力設備紅外圖像生成對應的可見光圖像。隨后將生成的可見光圖像和給定的低分辨率紅外圖像進行融合,得到增強的帶有豐富紋理的融合圖像。最后通過一個基于參考的超分辨網絡,通過局部紋理匹配和轉移,進一步的彌補低分辨紅外圖像中缺失的紋理細節,主要的思想是通過在特征空間中尋找參考模板和低分辨輸入匹配的紋理特征,并以一種多尺度的方式轉移到超分辨圖像中。本文的總體網絡結構如圖1所示,分為三個部分,分別是低分辨可見光圖像的生成、紅外圖像與自然圖像的融合以及局部紋理匹配和遷移。

圖1 總體網絡結構圖

3.1 可見光圖像生成模塊

實際應用中,電力設備的低分辨率紅外圖像中缺少紋理信息,為了減少的紋理信息對生成高分辨率圖像的影響,并且易于收斂,本文使用變分自編碼器(VAE)進行風格分離,旨在將紅外域圖像和可見光圖像都映射到同一潛在向量中,這一潛在向量是風格無關的。隨后經過兩個生成對抗網絡來進行特定域的圖像生成。這個網絡將可見光圖像IRGB或者紅外光圖像IIR轉換到對應的可見光IRGB'或者對應的紅外光IIR'。

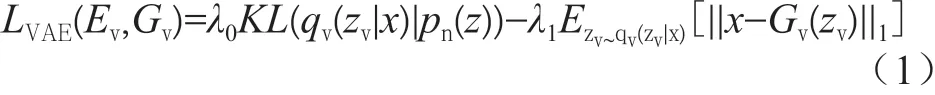

特定域圖像生成結構包括兩個編碼器-解碼器結構,分別對應可見光和紅外圖像模態的生成。變分自編碼器的損失函數LVAE定義如下,其中KL是Kullback-Leibler散度,第二項中的||·||1代表L1損失:

隨后兩種生成對抗網絡被用來從風格無關的潛在向量z中生成特定域的圖片,生成器希望生成的圖片與原始域盡可能相似,而鑒別器則要求生成的圖片與真實的存在差異,對抗損失如下,其中超參數λ2用來控制GAN的效果,生成器試圖最小化損失函數,鑒別器試圖最大化損失函數:

循環一致性損失用來規范無監督的圖像到圖像的轉換問題,因此,本文的循環一致性損失定義如下,其中第一項保證再次生成的圖像與原始域圖像相似,超參數用來控制不同損失項的權重:

總的損失函數是這些損失的加權和,本文采用默認權重為1,因此,損失函數為:

通過聯合優化這些損失,能夠得到一個用于將給低分辨率紅外圖像轉化為低分辨率可見光圖像的子網絡。

3.2 信息融合模塊

有許多方法可以將低分辨率紅外圖像和生成的低分辨率可將光圖像進行融合。例如,將所有圖片統一到紅外域中,統一到可見光域中,或多光譜域中(將給定域和對應的生成域的圖片拼接為4維的向量)。其中前兩個域是同一電力設備在不同成像過程中兩種形式,存在內在聯系,極有可能相互重建;但如果將圖像同一到紅外域或者可將光域中,不可避免的造成了信息丟失,而簡單的多光譜域中存在冗余。為此,本文從一個新的角度提出了一種新的融合策略,能夠同時保持紅外域圖像的熱輻射信息和可見圖像的豐富紋理信息,在降低冗余同時挖掘深層次的信息。

本文將紅外和可見圖像融合問題表示為對抗性問題,主要的結構圖如圖1所示。首先,將電力設備紅外圖像和可見光圖像拼接,輸入到生成器中,生成器生成對應的融合圖像,可見光圖像和融合圖像輸入到鑒別器中,鑒別器鑒別圖像是來自可見光,還是來自融合后的圖像,直到鑒別器不能鑒定真假,訓練完成。融合模塊的損失函數分為生成器的損失函數和鑒別器的損失函數,其中生成器的損失函數包括兩個部分:

其中,第一項是生成器和鑒別器的對抗損失,其中第二項代表內容損失,λ用來平衡對抗損失和內容損失。由于紅外圖像的熱輻射信息由像素亮度決定,可見光圖像的紋理信息由梯度決定,本文強制融合的圖像和紅外圖像有著相同的亮度,和可見光圖像有著相同的梯度。內容損失如下:

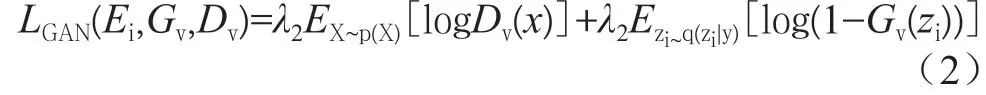

其中,H和W代表輸入圖像的高和寬,||·||F代表矩陣Frobenius范數。內容損失的第一項旨在于保持紅外圖像的熱輻射信息,第二項旨在于保持可見光圖像的梯度信息。由于本文的損失函數設計,如果沒有鑒別器,融合模塊傾向于保留紅外圖像的熱輻射信息和紅外圖像的梯度信息,但信息不足,因為梯度信息不能夠完全代表可見光圖像中的紋理信息。因此,本文設計一個新的判別損失在紅外圖像基礎上調整融合圖像,從而使融合圖像包含更多紋理信息,判別損失如下:

其中,Iv代表生成的可見光圖像,b代表紅外圖像的標簽,D(Iv)代表對Iv的鑒別結果。基于可見光圖像中提取的特征,鑒別器將融合圖像和可見光圖像分開。使用最小二乘損失函數,使生成對抗網絡訓練更加穩定且收斂速度加快。

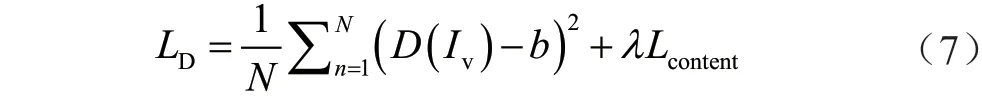

3.3 紋理匹配與轉移模塊

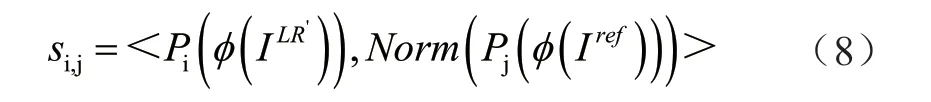

本文首先在特征空間中尋找模板圖像和輸入圖片的相匹配的紋理信息,具體的結構如圖2所示。紋理匹配過程在高分辨坐標系中完成,以便于直接將匹配到的紋理信息轉移到超分辨的結果。和自參考的策略相似,使用雙立方插值將低分辨融合圖像采樣到高分辨輸出大小,同時使用連續上采樣和下采樣的方式將參考圖像變得模糊。與之前的估計全局轉移信息或者基于光流的方法不同,本文采用局部匹配的方法,對于參考圖像的全局結構沒有限制。由于低分辨率圖像和參考圖像在顏色、光照上有差距,本文在特征空間中進行相似度匹配,使用內積度量特征之間的相似性:

其中,si,j是指的是第i-th低分辨塊和j-th參考圖像之間的相似性。<·>代表內積。為了選擇出最佳的匹配,參考圖像的特征被歸一化。為了計算效率,相似性計算以互相關的方式實現。

圖2 紋理匹配和轉移模塊

本文提出的紋理轉移模塊,旨在與將多層次匹配到的紋理特征轉移到生成模型中,具體結構如圖2所示。對于每個尺度,將紋理匹配模塊匹配到的紋理特征與當前網絡特征拼接起來,作為下一級網絡的輸入。本文使用殘差結構和跳躍連接來構建生成網絡。

出于如下3點考慮:(1)保留低分辨輸入圖像的空間結構;(2)提高超分辨圖像的視覺質量;(3)充分利用參考圖像的豐富紋理細節,紋理匹配與轉移模塊的損失包括如下3個部分:重構損失Lrec,感知損失Lper,紋理損失Ltex。其中重構損失是許多超分辨算法采用的損失,通常用均方誤差或者L1損失來度量,本文采用L1損失:

其中,V,C分別代表特征譜的大小和通道數量,||·||F代表Frobenius范數。

傳統的單圖像超分辨算法僅僅致力于降低生成的高分辨圖像和實際的高分辨圖像的差異,而本文提出的方法還考慮到生成的超分辨圖像和參考圖片之間的差異。具體來說,本文要求生成的超分辨圖像和匹配后的紋理信息在特征空間中相似,對應的紋理損失如下:

其中,Gr代表格拉姆矩陣,參數λ1是對尺度的歸一化因子,S1是由前面的紋理匹配計算出來的最佳匹配的權重。

4 實 驗

本節將展示實驗設置、實現細節、和其他方法對比以及消去實驗。

4.1 實驗設置

數據集。由于本文的目標是實現電力設備紅外圖像的超分辨,但是目前沒有公開統一的用于超分辨的電力設備的紅外圖像數據庫,因此本文選擇自行構建數據集。使用兩個對齊的攝像機(一個可見光和一個紅外攝像機)收集了5 000對電力設備圖像,隨機劃分3 500對圖像作為訓練集,剩余1 500對圖像作為驗證集。收集的圖像是高清的,在訓練時首先通過雙立方下采樣(4倍)作為低分辨率的輸入。

評估指標。采用峰值信噪(Peak Signal to Noise Ratio,PSNR)和結構相似性指數(Structure Similarity Image Measure,SSIM)通常用來評價圖像間的結構相似性。因此,本文同時選取這兩個指標PSNR和SSIM對超分辨結果進行評價。

4.2 實現細節

網絡結構。本文使用預訓練的VGG-19網絡進行可將光圖像生成,信息融合,與紋理匹配和轉移,總體結構如圖1所示。可見光圖像生成模塊,信息融合模塊的輸入尺寸(可見光圖像和紅外圖像)被調整為224×224大小。

訓練策略。本文的3個部分:可將光圖像生成模塊、信息融合模塊、紋理匹配與轉移模塊,能夠以損失函數疊加的方式聯合訓練,但是為了訓練的收斂速度考慮,首先將3個模塊單獨訓練,最后再進行統一的微調。本文在一個NVIDIA TITAN XP上進行實驗,批次設置為32,學習率設置為1e-5,迭代次數設置為96 000,并且在前3 000次迭代中采用warm up策略,在40 000和70 000次迭代時降低學習率到1/10,使用Adam優化器進行優化。

4.3 結果對比

為了驗證本文提出方法的有效性,本文和現有的單圖像超分辨算法和基于參考的超分辨算法進行對比,單圖像超分辨算法包括SRCNN、SelfEx、SCN、DRCN、LapSRN、MDSR、ENet、SRGAN及MDSR等,這些算法在PSNR中取得了最先進的性能,而ENet和SRGAN取得了最好的視覺質量。對比方法總還包括了兩種基于參考點超分辨算法,即Landmark和最近提出的CrossNet。

為了公平比較,這些方法都是使用同樣的網絡進行預訓練,然后在本文提出的數據集的訓練集進行訓練,在驗證集上進行。表1展示了所有的方法在提出的數據集上的結果,前9個是單圖像超分辨算法的結果,后3個是基于參考的超分辨算法的結果。實驗結果顯示,本文提出的方法在電力設備紅外圖像超分辨數據集上的性能,超過了之前的方法,驗證了本文提出的方法的有效性。

4.4 消去實驗

本文的方法分為三個模塊:可見光圖像生成模塊、信息融合模塊、紋理匹配和轉移模塊。使用最基本的生成對抗網絡作為本文的基準,表2展示了消去實驗的結果,在基準上增加信息融合模塊,PSNR由21.12大幅度提升到25.14,SSIM由0.687提升到0.720;再繼續增加紋理匹配和轉移模塊,PSNR提升至27.12,SSIM提升至0.793,消去實驗證明了本文提出的信息融合模塊和紋理匹配和轉移模塊有效性。

表1 在本文提出數據集上的結果對比

表2 在提出的數據集上的消去實驗

5 結 論

本文提出了一種新的針對紅外圖像電力設備的超分辨算法,并進行了實驗驗證。結果證明,本文的方法在紅外圖像電力設備超分辨問題上,優于之前的單圖像超分辨算法和基于參考的超分辨算法。