基于BERT模型的餐飲電商在線評論情感挖掘

摘 要:以本地美團網(wǎng)美食類店鋪為例,爬取在線大量數(shù)據(jù),按目標格式注入Google的BERT模型(Bidirectional Encoding Representations from Transformers.),并構(gòu)建研究對象所適用的數(shù)據(jù)模型,對潛在評論情感極性能夠準確預(yù)測,對正向情感評價最高可達98%準確率,98%召回率,F(xiàn)1-Score最高達0.98。特別地也分析了其負向F1-Score的成因,并提出利用F1-Score構(gòu)建平臺分流與展現(xiàn)推廣付費的思路。

關(guān)鍵詞:BERT;F1 score;情感極性;在線評論;預(yù)測模型

一、引言

“在線用戶評論”,作為運營數(shù)據(jù)來源的主要渠道,為電商運營決策和平臺分配流量提供了直接的依據(jù)。很多大型的電商平臺都設(shè)計了相應(yīng)的評論板塊,有的側(cè)重于追加評論,主要體現(xiàn)用戶的事后真實體驗評價,而有的側(cè)重于事中評價。情感極性一般分為正面、負面和中性。用戶通過分值與文本做出相應(yīng)的評論并不能反映出真實的情感極性。例如,“這頓餐看起來很不錯,大氣上檔次,但是貴了……”,到底用戶的情感是正面還是負面呢?很難做出有效判斷,這就需要對文本做出挖掘。用戶的情感極性對商品用戶推薦、平臺流量分配權(quán)重、商戶業(yè)務(wù)改進至關(guān)重要。

二、文獻綜述

業(yè)界與學(xué)術(shù)界都對文本情感分析(NLP)做出了大量的探索實踐與理論積累,相關(guān)的情感分析研究方法有分別基于詞典、機器學(xué)習、詞典+機器學(xué)習、弱標注、深度學(xué)習等方法。有文獻綜述提到,“Hamouda等提出建立一個包含表情符號的情感詞匯庫進行情感識別;Pang等將機器學(xué)習算法用于情感分類任務(wù);還有利用挖掘評論數(shù)據(jù)中反映情感語義的弱標注信息,以及分別基于卷積神經(jīng)網(wǎng)絡(luò)的、長短期記憶、深度信念網(wǎng)絡(luò)等分類模型的深度學(xué)習”。隨著研究發(fā)現(xiàn),深度學(xué)習(神經(jīng)網(wǎng)絡(luò)模型)成為了主流方向,其最大特點是采用了詞向量的嵌入技術(shù)——Word2Vec方法,但是對同一句子中有情感極性矛盾,或同一個詞在不同位置導(dǎo)致歧義的多個情感詞則無能為力, 這時“多頭注意力機制(Multi-head Attention Mechanism)”的引入能夠很好地解決類似問題。Yin(2015)提出基于注意力機制的卷積神經(jīng)網(wǎng)絡(luò),Wang(2016)提出結(jié)合注意力機制的LSTM網(wǎng)絡(luò),梁斌(2017)提出多注意力卷積神經(jīng)網(wǎng)絡(luò)MATT,但是缺乏對中文領(lǐng)域的分析。Devlin,Jacob(2018)等人提出了BERT模型,在tensor2tensor庫基礎(chǔ)上,利用MLM與NLP機制進行雙向預(yù)訓(xùn)練,生成上游模型,在此模型上進行下游的自定義任務(wù),能夠滿足中文和英文等文本挖掘,其性能指標遠勝OpenAI GPT和ELMo(兩種順序的LTSM),其在SQuAD測試中排名第一(Nov,2018)。劉玉林(2018)等通過建立電商食品領(lǐng)域級情感詞典,在算法上引入NLP中2元語法加強情感結(jié)果判斷,建立情感指數(shù),結(jié)合真實在線數(shù)據(jù)進行實證,得出優(yōu)化方向,但是沒有展示其準確率和F1分值。

本文將爬取雍和會在美團網(wǎng)站在線評論數(shù)據(jù),注入BERT模型,構(gòu)建其店鋪的情感極性評價模型,并計算其準確率和F1分值。該模型可以用來指導(dǎo)店鋪提升客戶滿意度,也可以幫助平臺分配流量和用戶推薦,具有現(xiàn)實意義。

三、研究方法

STEP1:爬取美團網(wǎng)福州地區(qū)美食類好評排名Top2的“雍和會海鮮姿造(三坊七巷店)”上萬條評論數(shù)據(jù)。

STEP2:利用Pandas包清洗數(shù)據(jù)。

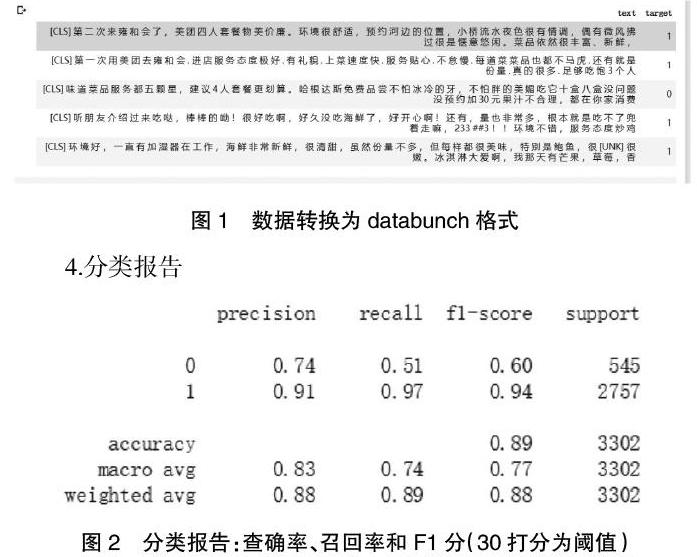

STEP3:將原始數(shù)據(jù)按比例拆分為訓(xùn)練數(shù)據(jù)集(10564條)、測試數(shù)據(jù)集(3302條)和驗證數(shù)據(jù)集(2641條),并將打分等級劃分為兩種極性,超過閾值為1,否則為0;增加sentiment標簽,刪除star標簽。

STEP4:利用FastAI包初始化BERT模型(Chinese版本)。

STEP5:將上述訓(xùn)練數(shù)據(jù)集、測試數(shù)據(jù)集和驗證數(shù)據(jù)集按需要裝入在DataFrame,DataBunch。數(shù)據(jù)會在前后加上標簽【CLS】和【SEP】,用以區(qū)分句子,從而符合模型格式。

STEP6:利用Learner的lr_find()函數(shù),采用CrossEntropyLoss()交叉熵損失函數(shù)作為參數(shù),進行“學(xué)習”,并畫出學(xué)習曲線,生成下游任務(wù)的最終模型。

STEP7:按照指定學(xué)習率,計算一周期,得出其相關(guān)準確率與耗時。

STEP8:評估模型——預(yù)測相關(guān)文本,進行指標評價,并展示【precision,recall,f1-score】和含混矩陣。

STEP9:設(shè)計對比實驗組。

四、實證分析

1.數(shù)據(jù)來源

爬取“雍和會”美團在線評論數(shù)據(jù),提取評價與打分等信息,并進行清洗。清洗后的在線評論數(shù)據(jù)規(guī)模,從22336降至16507個數(shù)據(jù)。

2.清洗:sentiment是根據(jù)star分值經(jīng)過相應(yīng)條件轉(zhuǎn)化為0或1.條件:若star分值大于30為1,反則為0。這里正面評價1較多。

3.數(shù)據(jù)轉(zhuǎn)換為目標格式

4.分類報告

5.對比組

按照上述方法,隨機打開美團首頁,選取福州地區(qū)美食類綜合排名第4名(廣告位)“旺巴蜀小郡肝火鍋串串香(東二環(huán)泰禾店)”,其綜合分數(shù)為3.7分,顯示評論數(shù)1600條,但實際爬去后顯示評價數(shù)5000多條,清洗后也有3500多條。再按選取福州地區(qū)綜合排名第12名“V-ONE|西雅圖海鮮自助輕姿造(王府井店)”,其綜合分數(shù)為4分,顯示評論數(shù)1888條,清洗后也有1000多條。爬取數(shù)據(jù)、清洗、建模、評估,相同條件下(30分為閾值,學(xué)習率為2e-5)進行挖掘。

五、結(jié)論與建議

通過實驗發(fā)現(xiàn):BERT模型能夠較準確地區(qū)分正負面情感極性,這個案例中,其店鋪排名第2名,F(xiàn)1-score可平均達到0.77,這個數(shù)值并不太出色,但如果只觀測正面情感評價,F(xiàn)1-score可最高達到0.98,這是由于選取當?shù)睾迷u率最高的美食類店鋪,造成數(shù)據(jù)偏向正向情感,而負向情感偏向較少。見下表。

綜合分數(shù)反映消費者滿意程度,(1)第2名與第4名相比,明顯第四名口碑差距較大,因此在負向f1分反而較大,正向相對很小;(2)第2名與第12名相比,口碑相差不大,總體前者口碑優(yōu)于后者,但從模型指標看,前者平均f1比后者少0.02,但是正向f1分具有明顯增量0.11,主要由于負f1分拖累0.15,因此整體不如后者平均f1指標;同時,雖然前者平均f1分少于后者,但是前者的準確率明顯由于后者0.09個單位。(3)第4名與第12名相比,只有負向f1分高于后者,這說明其差評較易發(fā)生。但是由于其是付費展現(xiàn),因此超出后者8個位置。(4)第12名的平均f1分最高。

總的來說,BERT模型能有效抽取情感極性,但是由于樣本來源于真實就餐環(huán)境,口碑較好店鋪正評價較多于負評價,會導(dǎo)致正向f1分偏高,而負向f1分偏低;口碑較差店鋪負評價多于正評價,會導(dǎo)致反向f1偏高,正向f1偏低;中等口碑介于兩者之間,但是其平均f1分為最高。模型在適當情況下,或許可以獲得高出0.79的f1分。因此不能完全依賴此指標孤立評價模型。反而,該模型的評價指標體系可以用來指導(dǎo)店鋪運營、平臺流量分配于商品推薦。作為平臺可以利用正向f1分將更多流量分配給這樣的店鋪,也可以向負向f1分較高的用戶收取較高的推廣費用。

參考文獻:

[1]朱曉霞,宋嘉欣,張曉緹.基于主題挖掘技術(shù)的文本情感分析綜述[J/OL].情報理論與實踐:1-13[2019-10-28].http://kns.cnki.net/kcms/detail/11.1762.G3.20190715.0941.004.html.

[2]洪巍,李敏.文本情感分析方法研究綜述[J].計算機工程與科學(xué),2019,41(04):750-757.

[3]梁斌,劉全,徐進,周倩,章鵬.基于多注意力卷積神經(jīng)網(wǎng)絡(luò)的特定目標情感分析[J].計算機研究與發(fā)展,2017,54(08):1724-1735.

[4]Devlin,Jacob et al.“BERT:Pre-training of Deep Bidirectional Transformers for Language Understanding.”NAACL-HLT (2019).

[5]Wenpeng,Yin et al.[J].ABCNN:Attention-Based Convolutional Neural Network for Modeling Sentence Pairs,Transactions of the Association for Computational Linguistics,2016,Vol.4,pp.566-567.

[6]Wang Yequan,Huang Minlie,Zhao Li,et al.“Attentionbased LSTM for aspect-level sentiment classification”[C].Proc of the 2016 Conf on Empirical Methods in Natural Language Processing.Stroudsburg,PA:ACL,2016:606-615.

[7]劉玉林,菅利榮.基于文本情感分析的電商在線評論數(shù)據(jù)挖掘[J].統(tǒng)計與信息論壇,2018,33(12):119-124.

作者簡介:魏一丁(1985- ),男,漢族,河南安陽人,碩士,講師,研究方向:跨境電商與數(shù)據(jù)挖掘