基于美學評判的文本生成圖像優化

徐天宇,王智

(清華大學 計算機科學與技術系,深圳518055)

基于給定文本生成對應圖像是計算機視覺領域一項經典且富有挑戰性的任務,顧名思義,即給出一句描述確定內容的文本(可描述某件物體或某個場景環境),通過一定架構的模型生成與文本內容相對應的圖像,使其盡可能做到逼近現實,能夠迷惑人眼的識別或一些模型的判斷。該任務需要在理解文本含義的基礎上,根據文本的內容構建出合理的像素分布,形成一幅完整的、真實的圖片。因為給出的文本所包含的信息量在通常情況下都遠少于其所對應生成的圖像(文本通常只對圖像中主體部分大致進行了描述,圖像則還包含主體所處背景、圖像全局特征等額外信息),所以一句給定的文本可能會對應許多符合其描述的圖像結果,這是文本生成圖像任務的難點所在[1]。在如今生活、制造等多方面邁向智能化發展的時期,文本生成圖像這一任務在實際生產生活當中具有非常廣的應用價值和潛力,比如應用于平面廣告設計領域,可以為廣告制作團隊生成廣告用的配圖,從而不必再專門雇用插畫制作人員;家具、日用品生產領域,可以通過給出一段產品描述,利用模型批量生成大量的產品概念圖,從而給設計者提供了可供選擇的樣例空間,降低設計環節的工作量。

如今,基于給定文本生成圖像任務的實現都是基于從大量的圖像數據中學習并模擬其數據的分布形式來生成盡可能接近真實的圖像,尤其在對抗生成網絡(Generative Adversarial Networks,GAN)[2]的火熱發展下,借助其來實現文本生成圖像的任務已經成為了主流選擇,目前也有許多生成效果優秀的模型被提出。在這一研究方面,研究者所關注的重點是如何能夠提高生成模型生成圖片的真實性、清晰度、多樣性、解析度等問題,這些將直接影響生成模型的質量和性能,并關系到生成模型能否有效投入到實際應用當中。

然而如果考慮到實際應用,圖像好看,或者有足夠的美觀度也是一項重要的需求。比如為平面廣告設計配圖,對圖像的要求不僅是清晰、真實,還應該擁有較高的美觀度,從而能夠吸引人的眼球,提高廣告的關注度。可以說,如果能夠實現提高此類模型生成圖片的美觀度,則在實際應用場景中將會給用戶帶來更加良好的使用體驗,從而提高此類應用的質量。遺憾的是,現在對文本生成圖像GAN的研究很少關注生成圖像的美觀質量,現有文獻中也并未發現有將美學評判與圖像生成相結合的研究,這成為了本文研究的動機。

由此引出另一個問題:如何評判一幅圖像的美觀度。圖像的美觀度評判實際上是一項帶有主觀性質的任務,每個人因不同的閱歷、審美觀甚至所處環境、情感狀態等多方面因素的影響,對同一幅圖像有可能會給出完全不同的評價。然而,面對互聯網空間與日俱增的圖片數量,借助人力對其進行美觀度的評價是不切實際的。因此,研究借助計算機進行自動化圖像美觀度評判成為了計算機視覺領域另一項研究課題,至今也有許多研究者提出了實現原理各異且效果優良的美觀度評判模型。借助這些模型,可以對目標圖像進行分類或評分,給出盡可能接近符合多數人評價標準的評判結果。

借此,本文致力于研究從美觀度的角度對文本生成圖像GAN的生成結果進行優化的方法。本文的貢獻和創新點如下:

1)從實際應用的角度出發,將生成結果美觀度加入評價文本生成圖像GAN模型生成結果的評價指標,以目前受到較高認可度的文本生成圖像GAN模型——StackGAN++[3]為基礎,從美觀度的角度對其生成結果進行評估,以觀察其生成結果的美觀度質量。

2)將美觀度評判模型融入該GAN的生成模型當中,通過增添美學損失的方式改造生成模型,從而在模型訓練過程中加入美學控制因素,引導模型生成美觀度更高的結果。本文提出的改進方法使得模型生成圖像的總體美學質量(以IS(Inception Score)為評價指標[4])提高了2.68%,其生成圖像結果整體的美觀度指標提高了3.17%。

1 相關工作

1.1 美觀度評判模型

隨著網絡空間中圖片數量的急速增長,在圖片檢索領域為了能夠更好地為用戶甄選返回圖像的質量、給用戶返回更高質量的搜索結果,對圖片按美學質量進行分類的需求逐漸增加。圖片所附帶的數據標簽(如喜歡該圖的人的數量、圖片內容等)可以作為美觀度評價的一類較為有效的標準,但大部分的圖片并不存在類似這樣的標簽,雖然如今有許多研究已能夠做到給圖片準確高效地進行標簽標注[5],然而即使每幅圖片均被標注了足夠用以進行評判的標簽,圖片龐大的數量又使得人工評判工作量巨大,因此需要能夠對圖片進行美觀度評判的模型,由計算機來完成這一任務。

受到心理學、神經科學等領域中對人類美學感知的研究成果啟發,計算機視覺領域的研究者們通過模擬、復現人類處理接收到的圖像視覺信息的過程,設計實現了一系列自動評判圖片美學質量的模型[6]。圖像美觀度評判模型一般遵循一個固定的流程:首先對輸入圖像進行特征提取,然后借助提取的特征,利用訓練好的分類或回歸算法獲得相應的結果。

特征提取則是其中非常重要的一環,因為特征信息是對圖像美學質量的概括,其決定了美觀度評判模型的精確度。選取得當的特征既能提高模型評判的精確度,又能減少不必要的計算量,因為不同特征對于圖像美學質量的貢獻度是不同的[7]。早期的研究中,研究者們通常選擇以繪畫、攝影所用的美學規則理論和人的直觀感受為依據,自主設計所要提取的特征,比如清晰度、色調、三分規則等。這類方法的好處是直觀、易于理解,但缺點在于所設計的特征通常不能很全面地描述圖像美學信息,而且設計特征對于研究者的工程能力和相關領域知識了解程度都有較高的要求。而隨著深度學習領域的不斷發展,將卷積神經網絡(Convolitional Neural Networks,CNN)應用于圖像處理這一方式展現出了卓越的效果。借助CNN能夠從大量的圖像數據中學習到有力的圖像特征表示,其所包含的信息量遠超人工特征設計所設定的特征[8],從而使得CNN處理圖像的方式在圖像處理領域得到廣泛應用,并逐漸成為主流選擇的方法。深度學習方法應用于圖像美觀度評判的特征提取環節,主要有2種方式:第1種是借助已有的深度學習圖像處理模型,利用其中間層特征作為評判依據,采用傳統的分類或回歸方法進行美觀度評判;第2種是對已有的模型進行改造,使得其能夠從圖像數據中學習到新的隱藏的美學特征,并借此對圖像的美觀度作出評判。

本文采用的是Kong等[9]設計的美觀度評判模型。該模型隨AADB(Aesthetics and Attributes Database)數據集一同提出,其基于AlexNet[8]改造得來,通過提取圖片的內容特征以及自定義的屬性標簽特征來幫助判斷圖像的美觀度。此外,該模型吸收了Siamese網絡[10]的結構,實現了接收兩幅一組的圖像作為輸入并給出它們之間相對評分的功能,同時提出了2種對圖像進行成對采樣的訓練方式來輔助增加結果的精確度。實驗結果表明該模型在AVA(Aesthetic Visual Analysis)數據集上的判別準確率達到77.33%,超過了當時已有的許多模型的表現。作者并未對該模型進行命名,為方便說明,下文中統一用“AADB模型”對其進行代指。

1.2 文本生成圖像GAN

GAN的提出是機器學習領域一項重大的突破,其為生成模型的訓練提供了一種對抗訓練的思路。相比于傳統的生成模型如變分自編碼器、玻爾茲曼機,GAN優勢有:其訓練只需借助反向傳播而不需要馬爾可夫鏈、能夠產生全新的樣本以及更加真實清晰的結果、簡化任務設計思路等,因此,其成為了現今機器學習領域十分火熱的研究課題。

GAN的結構一般可分為兩部分:生成器部分,負責接收一段隨機噪聲作為輸入來生成一定的結果;判別器部分,負責接收訓練數據或生成器生成的數據作為輸入,判斷輸入是來自哪一方。生成器的最終目標是生成能夠徹底欺騙判別器的數據,即判別器無法區分輸入數據來自真實數據分布還是生成器擬合的數據分布;而判別器的最終目標是有效區分其輸入來源,識別出來自生成器的輸入。GAN的訓練正是基于這種博弈的過程,令生成器和判別器二者之間進行對抗,交替更新參數,當模型最終達到納什均衡時,生成器即學習到了訓練數據的數據分布,產生相應的結果。

雖然GAN擁有良好的表現力和極大的發展潛力,但其本身還存在一些缺點,比如訓練困難、無監督使得生成結果缺少限制、模式崩潰、梯度消失等問題。后續許多研究者對GAN從結構[11]、訓練方法[12]或實現方法[13]上進行了改進,逐漸提高了GAN訓練的穩定性和生成效果。此外,CGAN(Conditional GAN)[14]將條件信息與生成器和判別器的原始輸入拼接形成新的輸入,用以限制GAN生成和判別的表現,使得GAN生成結果的穩定性得到提高。

利用GAN來實現文本生成圖像任務也是基于CGAN的思想,以文本-圖像組合為訓練數據,文本作為輸入數據的一部分,在生成器中與隨機噪聲拼接作為生成器的整體輸入,在判別器中則用于形成不同的判斷組合——真實圖片與對應文本、真實圖片與不匹配文本、生成器生成圖片與任意文本并進行鑒別。文本數據通常會借助其他編碼模型將純文字信息轉化為一定維數的文本嵌入向量,用以投入模型的訓練計算當中。最先利用GAN實現文本生成圖像任務的是Reed等[15]提出的GAN-INT-CLS模型,其吸收了CGAN和DCGAN(Deep Convolutional GAN)[11]的思想,同時提出改進判別器接收的文本-圖像組合輸入(新增真實圖像與不匹配文本的組合)以及通過插值的方式創造新的文本編碼向量兩種方法來提高生成結果的質量和豐富度,生成了64×64大小的圖像。隨后該領域的一項重要突破是Zhang等[16]提出的StackGAN模型,該模型通過使用2個生成器的方式生成圖像,首次實現了只借助給定文本的條件下生成256×256大小的圖像。該模型中,第1個生成器接收隨機噪聲與文本向量的拼接來生成64×64大小的中間結果,第2個生成器則使用該中間結果與文本向量作為輸入,這種方式可以實現利用文本信息對中間結果進行修正和細節補充,來獲得質量更高的256×256大小圖像的結果。

在StackGAN的理論基礎上,Zhang等[3]提出了StackGAN++模型。該模型使用3個生成器-判別器組以類似樹狀的方式連接,其中3個生成器分別對應生成64×64、128×128、256×256大小的圖像,第1個生成器以文本向量和隨機噪聲的拼接為輸出,之后每一個生成器接收前一個生成器生成的圖像結果與文本向量作為輸入,生成下一階段的圖像結果;每一個判別器接收對應階段的生成器的輸出與文本向量進行判別,計算條件生成損失。此外,Zhang等[3]引入了無條件生成損失,即計算在不使用文本信息的情況下生成圖片的損失,與條件生成損失相結合,引導模型的訓練,最終進一步提高了生成圖片的質量。本文即選用了該模型進行基于美學評判的優化改進研究。

此后文本生成圖像GAN的研究多在類似StackGAN++的多階段生成模式基礎上,通過加入各種輔助信息來幫助生成器生成更好的結果,如AttnGAN(Attentional GAN)[17]引入了注意力機制,分析對比生成圖像與對應文本之間的特征相似度,并利用對比結果輔助生成器的訓練;Cha等[18]則通過引入感知損失的方式,從圖像特征層面進行對比來輔助生成器更好地學習到訓練數據的分布。

2 Stack GAN++的美學質量分析

在提出基于美學評估的對StackGAN++模型的優化方法之前,需要了解該模型目前生成結果的美學質量如何。本節將利用AADB模型對其進行初步測量。

本節實驗使用的StackGAN++模型是基于Caltech-UCSD Birds 200鳥類圖像數據庫2011版訓練的鳥類圖像生成模型,其測試數據集中包含2 933張圖像,每張圖像對應10條文本說明,其中文本數據需經過 char-CNN-RNN 模型編碼。Zhang等[3]給出了其模型源碼的github地址(https://github.com/hanzhanggit/StackGAN-v2)。

本文實驗運行于Ubuntu 16.04操作系統,使用GeForce GTX 1080 Ti顯卡進行訓練。軟件環境方面,本實驗利用Adaconda2搭建python2.7虛擬環境,并需要安裝Pytorch1.0以及caffe1.0(分別對應StackGAN++以及AADB模型運行所需)。

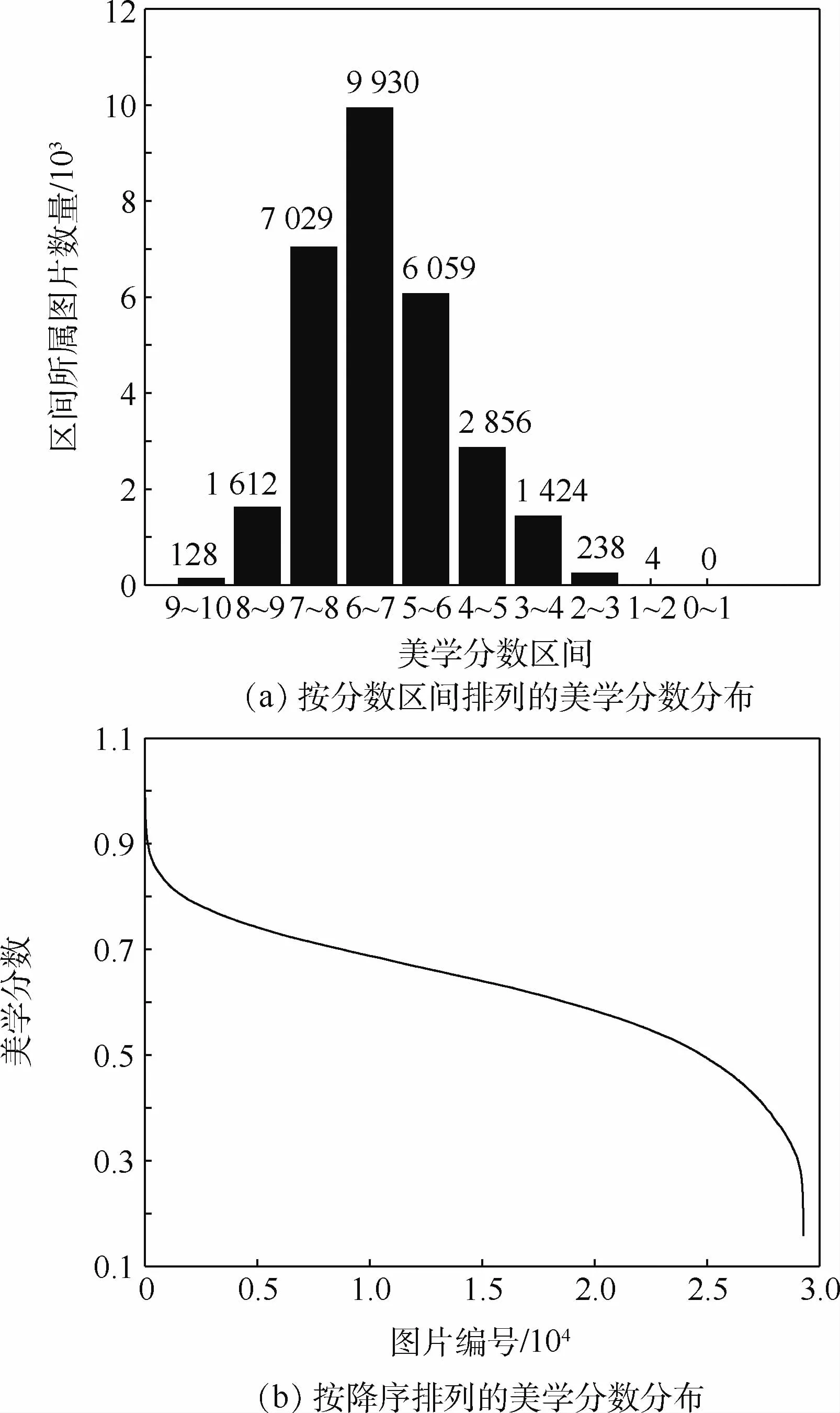

2.1 測試數據集生成結果的美觀度分布

首先針對測試數據集所產生的樣本進行美觀度評判,觀察其分布狀況。理論情況下,訓練數據集中包含了29 330條語句對應的嵌入向量,經由生成模型后獲得29 330張圖像結果,實際運行中由于StackGAN++模型所采用的批處理訓練策略,最終生成圖像數量為29 280張,但從整體數量的規模來看并不影響對于其整體美觀度評價的判斷。利用AADB模型獲得生成圖像的美學分數,其分布如圖1所示。

由AADB模型計算得出的美學分數集中于[0,1]區間,在特殊情況下會超過1。為了便于標注美學分數的分布區間,在繪制區間分布柱狀圖時,將由AADB模型獲取的美學分數(超過1的截斷至0.999 9)乘以10,這種表示方法也符合實際生活中人工評判時的常用取值范圍選擇;在展示降序分布時則直接采用模型輸出的結果范圍來標注分數坐標軸。圖1(a)表明,原始StackGAN++在測試數據集上生成圖像的美學分數集中在5~8的區間段內,占總體的78.6%,其中6~7區間段內的圖像數量最多,占整體結果數量的33.9%。而圖1(b)表明,在5~8區間段內,圖像的美學分數變化呈現出均勻平緩的變化趨勢,并沒有出現在某一節點大幅變動的情況。

29 280 張生成結果的平均美學分數為0.628 28。根據AADB模型作者給出的評判標準,一張圖片的分數超過0.6則可以認為是一張好圖片,低于0.4則認為是一張差圖片,在兩者之間認為是一張一般性質圖片,而本文出于后續實驗樣本劃分的考慮,將好圖片的下限標準提高至0.65,差圖片的上限標準提高至0.5。由此來看,模型的平均結果處于一般質量的區間,說明原模型的整體生成結果從美觀度的角度來講仍然存在可以提升的空間。本文從全部生成結果中選擇美學分數最高以及最低的圖片各10張的結果,交由真人進行主觀評判,其結果均與美學分數表現出對應關系,即認為最高分數的10張圖片擁有較高的美觀度,而最低分數的10張圖片則評價一般或交叉表明AADB模型給出的美學分數對圖像美觀度的評價能較好地符合人的直觀感受。

圖1 StackGAN++在測試數據集上的美學分數分布Fig.1 Distributions of aesthetic score of images generated by Stack GAN++using test dataset

2.2 固定文本批量生成圖像結果的美觀度分布

如果想要達成提高生成模型美觀度質量的目標,一個簡單的想法是,可以對同一條語句,一次性批量生成大量的圖片,按美觀度模型給出的分數進行降序排序,從中選出分數最高圖像作為輸出結果,或以分數排序最靠前(分數最高)的一定數量的圖像作為輸出結果,再交由模型使用者自行判斷選擇最終的結果。這種方法雖然存在嚴重的效率問題,但易于實現且非常直觀。其中的問題在于確定生成圖像的數量,因為隨著生成圖像數量的增加,其多樣性也會隨之增加。也更容易出現更多美觀度高的圖像結果,但進行美觀度評判以及排序選擇的時間消耗也會隨之增加,因此若選擇此種做法作為優化方法,需要在生成結果質量以及模型運行效率之間尋求一個平衡點。

圖2 原模型輸入同一文本在不同生成數量情況下的美學分數分布Fig.2 Disrtributions of aesthetic score of images generated by the same text in original model with different generating quantities

基于以上考慮,除對測試集整體進行美觀度評判以外,還從中選擇一批(實驗設定為24)數量的文本輸入數據,針對每一條文本數據生成不同數量的圖片來觀察其美學分數的分布。選擇100、200、350、500、750、1 000共6種生成數量,針對選定的文本數據生成對應數量的圖像,利用AADB模型計算生成結果的美學分數。圖2展示了其中一條文本的結果。結果表明,美學分數在各個區間的分布狀況是相近的,基本不受一次性生成數量的影響。6組結果都表現出生成圖像的美學分數集中于5~7的區間內的分布狀況,且隨著生成數量的增加,高分圖像的出現頻率也越來越高。表1展示了6組分布結果中最高分數圖像的分數與分數前10高圖像的平均分數,表明了一次性生成數量越多,即使是處于高分分段的圖像其整體的質量也會得到提高,也驗證了本節第一段所述的情況。但面對最高分數的情況,因生成模型會以隨機噪聲作為輸入來生成圖像,這導致了其對生成結果的不可控性,所以生成結果會出現一定的擾動,使得最高分圖像的分數與生成數量之間并不存在確定的正相關關聯性。

表1 不同生成數量情況下最高分數與前10平均分數Table 1 Highest aesthetic score and average of top 10 aesthetic scor e when generating different quantities of images

3 基于美學評判的圖像生成優化

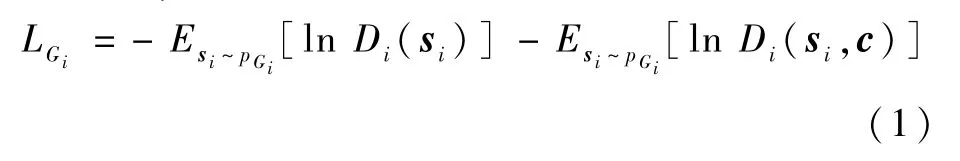

原始的Stack GAN++模型采用了3組生成器-判別器組合,以類似樹狀的方式進行連接,每一個生成器生成不同尺寸的圖像,并作為下一個生成器輸入數據的一部分。其中每一個生成器的損失LGi(i=1,2,3)計算式為

式中:pGi為生成器Gi學習到的數據分布;si為生成器Gi生成的結果;c為文本向量;Di為與生成器Gi對應的判別器,其接收單個輸入si或雙輸入si和c,輸出相應的判別結果;E[·]表示期望函數。

該損失計算方式由兩部分組成,前一部分計算生成器不利用文本向量生成圖像的損失,即無條件損失,該部分用以監督生成器生成更加真實的、使判別器認為來自于真實數據分布的數據;后一部分計算生成器利用了文本向量生成圖像的損失,即條件損失,該部分用來監督生成器生成符合輸入文本描述的圖像,即保證文本與圖像之間的一致性。在StackGAN++的理論描述中,Zhang等[3]認為每一個生成器生成的圖像雖然大小不同,但都是基于同一條文本生成的,所以它們彼此之間應該保持相似的色彩和基本結構,并提出了色彩一致性損失用來保證3個生成器生成圖像之間擁有較高的色彩一致性。但經過實驗作者發現在基于文本生成的模式下,色彩一致性所起到的作用十分微弱,因為其對生成結果的約束力要遠遠小于文本-圖像一致性的約束,即式(1)中的Esi~pGi[ln Di(si,c)]。式(2)為生成器的總體損失(下文稱為對抗損失)計算公式,用于訓練過程中的梯度計算。

受到Johnson等[19]提出的感知損失的啟發,本文將AADB模型與StackGAN++的生成器結合,用于在生成模型訓練過程中提供輔助訓練信息,達成從美學角度來優化生成模型的目的。具體地,在式(2)的基礎上,加入一項新定義的損失——美學損失Laes,其計算式為

式中:Aes函數表示使用AADB模型計算生成結果s3的美學分數。2.1節中,AADB模型計算得出的美學分數存在超過1的情況,因此在計算美學損失時,會對模型返回的美學分數進行判斷,如果其超過了1,則將其截斷至0.999 9。該損失實際計算了最后一階段生成器G3生成結果的美學分數與1之間的歐幾里得距離,最小化該損失即最小化生成結果美學分數與1之間的差距,代表了生成結果美學質量的提升。最后,加入了美學損失后新的生成器損失計算公式為

式中:β為美學損失的權重,用來控制其在總體損失中所占的比例,β越大則美學損失所占的比例越大。β為0時,模型即還原為StackGAN++。

由于美學損失的作用是引導生成器生成美觀度更高的圖像,而對抗損失則是控制整個訓練過程以及生成結果的關鍵,保證了生成器能夠生成符合文本描述的真實圖像,這是文本生成圖像模型最基本的目的,因此β值的選擇應當在保證在訓練過程中美學損失起到的調控作用不會壓過對抗損失的前提下對生成結果的美觀度產生影響。

4 實驗與性能評估

選取不同的美學損失權重β進行訓練,以IS作為訓練獲得模型的質量的衡量指標,在保證IS與原模型相比不降低的前提下,觀察其生成結果的美觀度分布情況。IS是借助Inception Model[20]計算得出的用來衡量GAN圖像生成效果的最常用指標之一,通常情況下其數值越大代表GAN生成的圖像具有更高的多樣性和真實性,進而代表生成圖像的總體質量更好。在文本生成圖像GAN領域,IS被廣泛用來進行不同GAN之間的效果對比。

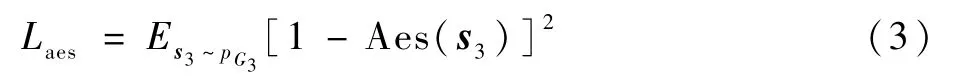

本節所使用的環境與第2節對StackGAN++本身進行美學質量分析的實驗環境相同,故此處不再贅述。模型訓練過程采用批訓練策略,每個批包含24條文本嵌入向量,每一個時期(epoch)中包含368個批的訓練過程,下文將一個批完成一次訓練的過程稱為一步(step)。訓練過程包含600個時期,并于每2000步的時間節點保存一次模型參數,以便于訓練完成后根據保存時模型的表現選取效果最好的模型。本文提出的優化方法的實現流程如圖3所示。

圖3 基于美學評判的文本生成圖像優化方法實現流程Fig.3 Procedure of text-to-image synthesis optimization based on aesthetic assessment

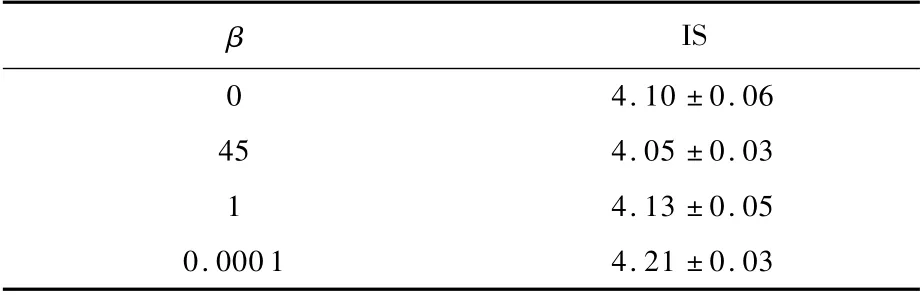

本文選取β=45,0,0.000 1,分別進行了訓練。選擇45是因為,觀察StackGAN++訓練時生成器的對抗損失發現對抗損失與美學損失的比值在50左右。因此,當β=45時,對抗損失與經權重放大的美學損失在數值上比較接近;1與0.000 1是基于經驗的選擇,取β=1時美學損失與對抗損失平權,而β=0.000 1則是參考了Cha等[18]提出的感知損失的權重選取。訓練完成后,對應每個β取值各形成了一組于不同時間節點保存的模型,分別從中選取IS分數最高的模型作為對應取值下的結果模型。在對選定的模型進行美學質量評判之前,需要先考察它們所生成的圖片的總體質量,以確保在引入了美學損失后沒有出現模型生成圖像質量下降的情況。表2展示了3種取值對應模型與原模型的IS數據,其中β為0即代表未引入美學損失的原始Stack GAN++模型。

通過對比,當β=0.000 1時,模型在IS上取得最高的數值,并且超過了原始模型的IS,表明美學損失的引入還起到了提高模型生成效果的正面效應。這是可以理解的,因為當生成器生成了一幅效果很差的圖像,例如模糊不清或主體扭曲變形,此時美觀度評判模型將會給出較低的分數,使得美學損失增大并導致生成器總損失增大。此外,當β=45時,模型的IS分數降低,表現為生成器生成圖像的質量有所下降。對β=45時獲得的模型所生成的圖像進行人工評判的結果也反映出這時生成圖像出現了更多的模糊、失真等不良結果。因此,β=45的情況已無繼續討論的價值,此后美學層面的實驗和數據統計也不再考慮此種情況。當β=1時,模型的IS與原模型相比十分接近,還需通過美學分數的分布對比來確定在此情況下美學損失是否起到了優化的作用。

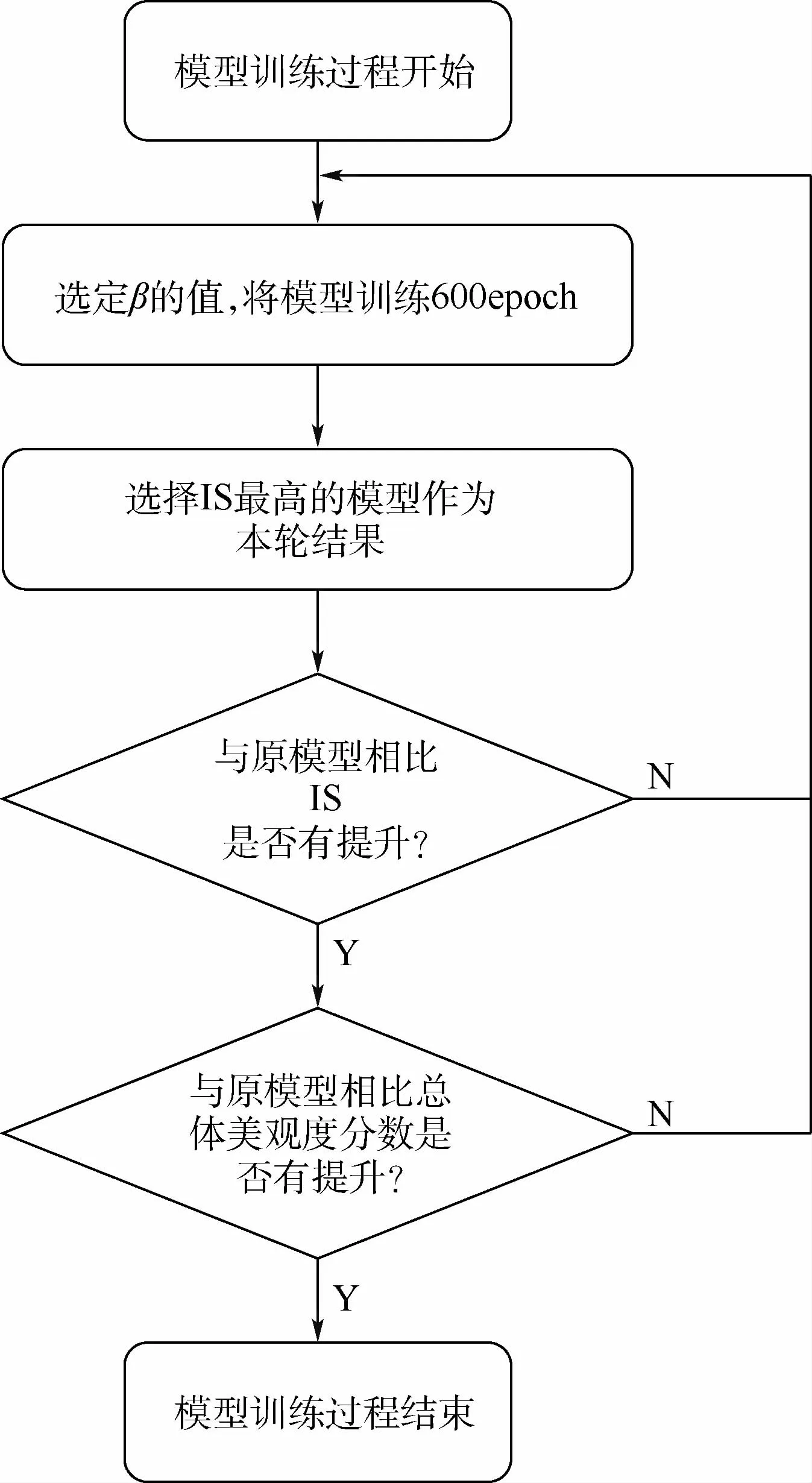

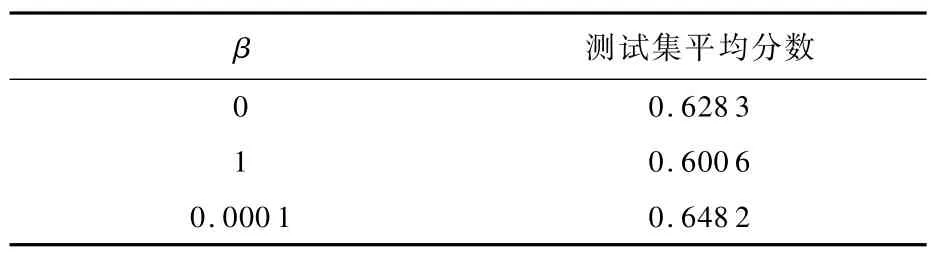

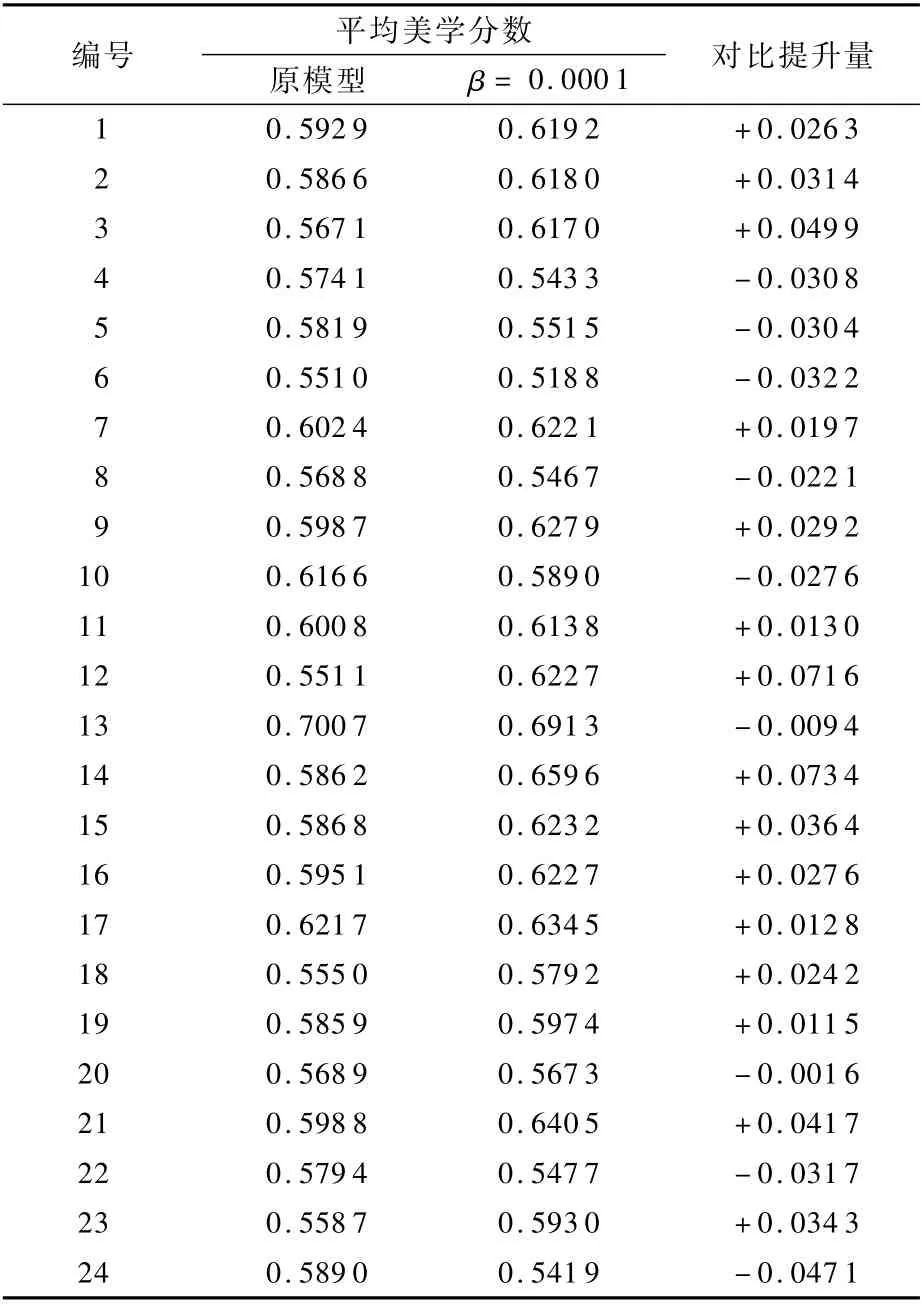

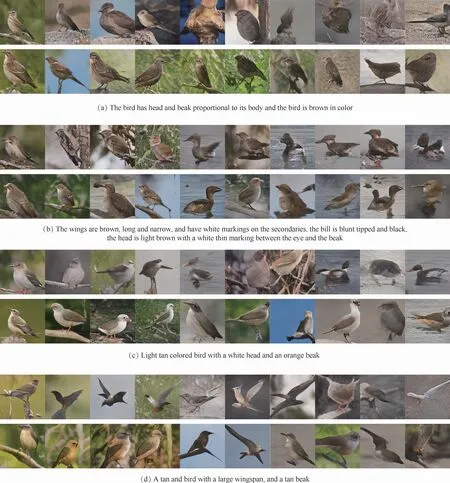

為了驗證美學損失是否對生成模型結果的美學質量起到了優化作用,接下來計算了使用β=1,0.000 1這2種情況的模型在測試數據集上生成的29 280張圖像的美學分數分布情況;同時針對一個批的24條文本嵌入向量,每條文本生成1 000張圖像,計算其美學分數的分布,數據結果如圖4所示(這里選出一條文本生成的1 000張圖像的美學分數分布進行展示)。表3展示了2種β取值下模型在測試數據集上的生成結果的美學分數,同時一并列出了原模型在測試數據集上生成結果的美學分數作為對比。從表中可知,當β=0.0001時,由測試數據集生成的圖像其平均美學分數與原模型相比提高了3.17%;表4給出了原模型與β=0.000 1優化模型分別生成的24組針對同一條文本的1 000幅圖像平均美學分數對比情況,也可以發現大部分文本生成結果的美學分數與原模型的生成結果相比有所提高。同時由圖4所示的美學分數分布情況也能看出,此時高分段圖像的數量增加,較低分段圖像的數量減少,表明美學損失起到了調控生成結果美觀度的作用。圖5展示了原模型與β=0.000 1的優化模型使用4條文本對應生成的1 000張圖像中等距抽取10張圖像的結果(每個分圖第1行為原模型,第2行為優化模型,每個模型對每條文本均生成1 000張圖像),每行圖像從左到右按美學分數從高到低的順序排列,從中可以直觀感受到,經過美學優化的生成模型所生成的圖像結果在色彩對比度、整體色調、背景虛化簡單化等方面均有一定優勢,反映了其美觀評價相比原模型有所提升。

表2 不同β取值對應模型的ISTable 2 IS of models using differentβ

圖4 不同β取值情況下測試數據生成結果與選定一條文本的生成結果美學分數分布Fig.4 Distributions of aesthetic scores of images generated by models with differentβusing texts from test dataset and chosen text

表3 不同β取值對應模型的美學分數對比Table 3 Comparison of aesthetic scor es of models using differentβ

表4 原模型與優化模型使用24條文本生成1 000張圖像的平均美學分數對比Table 4 Comparison of average aesthetic score of 1 000 images generated by original models and optimized models using 24 different texts

圖5 從原模型與優化模型對4條文本各生成的1 000幅圖像中等距抽取圖像對比Fig.5 Comparison of systematic sampling results of images generated by original model and optimized model using 4 chosen texts(1000 images for each text and each model)

5 結 論

本文提出了一種基于美學評判的文本生成圖像GAN的優化方法,利用美觀度評判模型獲得生成器生成圖像的美學分數,計算該生成圖像的美學損失,與模型本身的對抗損失以適當的權重關系相結合,作為該生成器新的損失并重新訓練模型,最后對獲得的新模型生成的圖像進行了美學質量的統計與和原模型的對比。實驗所得結論如下:

1)經過本文方法獲得的生成模型,其生成結果的美觀度與原模型相比得到了提升,同時IS分數也有所提高,表明美學損失能夠起到提高生成模型質量的作用。

2)該方法同時也存在一定的局限性:首先,利用本文方法選取的美學損失權重只適用于本文實驗所用的鳥類數據集,而如果需要在其他數據集上應用本文方法,除了原始模型需要更換以外,權重的選取也需要全部從頭開始,這也與文本生成圖像類GAN和美學模型本身的性質有關;其次,權重選取尚未找到一個公式化的方法,都是借助經驗來試探性的選擇。

未來的工作將分為2個部分,一是基于文中的實驗繼續調整美學損失的權重,尋找最佳的參數以使得生成結果能進一步提高;二是尋找其他美學損失的計算方式,以使得美學因素能夠取得更好的訓練調控效果。

致謝感謝耀萃基金數據智能創新聯合實驗室(InfleXion Lab)提供的幫助!