基于擴展的Haar-Like特征和LBP特征的人臉壓縮跟蹤算法*

曹 潔, 唐瑞萍, 李 偉

(1.蘭州理工大學 計算機與通信學院,甘肅 蘭州 730050;2.甘肅省制造業信息化工程研究中心,甘肅 蘭州 730050;3.蘭州理工大學 電氣工程與信息工程學院,甘肅 蘭州 730050)

0 引 言

目標跟蹤是視頻分析、安全監控、人機交互和許多其他計算機視覺應用中的一個基本問題。由于人臉外觀模型通常容易受到遮擋、光照變化、形變和背景干擾等因素的影響,保持實時跟蹤精度的人臉目標跟蹤仍然是一個具有挑戰性的問題。Zhang K[1]將壓縮感知理論[2]應用到目標跟蹤中,提出實時壓縮跟蹤(compressive tracking,CT)算法,但算法對遮擋、光照變化敏感,提取特征單一,無法充分表征目標信息等。朱秋平[3]在特征提取矩陣生成中,生成 2種互補的特征提取矩陣,使得特征呈現多樣化,并對不同特征進行不同更新,以此來提高跟蹤的魯棒性。曹義親[4]通過提取并使用兩類互補的紋理特征和灰度均值特征進行跟蹤來提高目標特征在各種情況下的穩定性。王松林[5]在壓縮跟蹤算法的基礎上引入了特征加權分類,但特征權值在第一幀就已經確定,無法做到實時更新以適應外觀變化。雖然眾多學者針對壓縮跟蹤算法進行了不少改進[6~10],仍然存在遮擋、光照變化等干擾條件下跟蹤效果不理想的情況。

基于上述分析,提出基于擴展的Haar-Like特征和LBP特征的壓縮跟蹤算法,并將此算法應用于人臉這一特定目標的跟蹤研究中。

1 壓縮跟蹤原理

壓縮跟蹤[5]采用了一個非常稀疏的隨機測量矩陣R將高維向量X(m維)映射為低維向量V(n維),表示為v=Rx,其中,R為一個n×m維的隨機測量矩陣,n?m。

其矩陣元素定義如下

(1)

式中p為rij取某值的概率,而s取值在2~4中隨機選取。

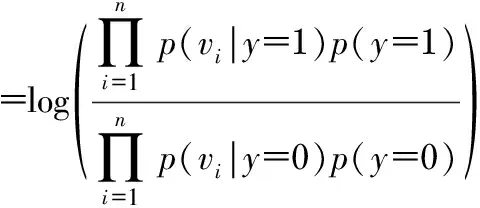

假設v中的各元素vi分布獨立,利用樸素貝葉斯分類器來建模

(2)

式中p(vi|y=1)和p(vi|y=0)符合高斯分布,y∈{0,1}為二值變量,表示樣本的正負,當y=0時為負樣本,當y=1時為正樣本,假設2個類的先驗概率p(y=1)=p(y=0)。可以看出,所有特征在正負類中分布概率密度比值的對數相加構成了貝葉斯分類器,貝葉斯分類器的更新對應特征在正負類中分布的更新[11]。Diacois P和Freedman D證明:高維隨機向量的隨機投影幾乎都服從高斯分布。

最終,選取H(v)值最大的區域作為新一幀的目標區域。在確定區域后,重新進行降維獲取正、負樣本,并通過下式更新系數

(3)

式中λ為學習因子且λ>0,影響更新的速度,λ越小則說明分類器更新的速度越快。

2 擴展的Haar-Like特征和LBP特征的人臉壓縮跟蹤

CT在某些復雜的環境中易受目標漂移的影響而失去目標,為了避免遮擋、光照變化及背景的干擾,本文擴展了原有的Haar-Like特征來適應環境的變化,提高了跟蹤的性能。在計算機視覺和圖像處理中,LBP是一種有效的紋理描述算子。紋理反映了圖像灰度模式的空間分布,包含了圖像的表面信息及其與周圍環境的關系,更好地兼顧了圖像的宏觀信息與微觀結構,具有旋轉不變性和灰度不變性等顯著的優點,能夠更有效地獲取需要的結構特點,從而得到具有較強鑒別能力的人臉圖像特征。

2.1 擴展的Haar-Like特征空間

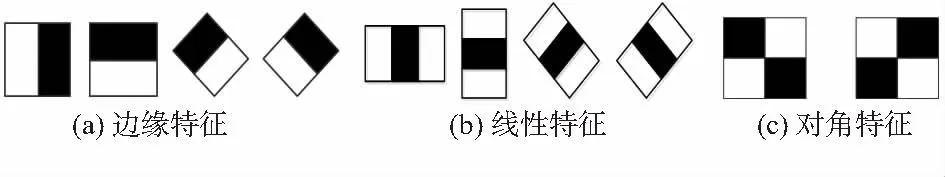

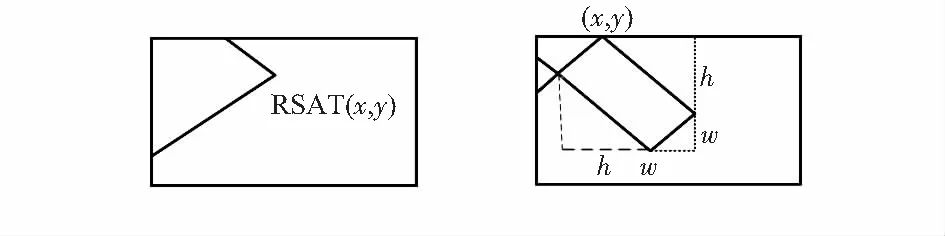

在CT[5]中將不同大小的矩形濾波器與原始圖像進行卷積,并提取了不同大小的矩形圖像塊。圖1為CT的簡單的Haar-Like特征,其特征值是由積分圖像來計算的。由于提取的Haar-Like特征太過簡單而無法有效地處理遮擋、光照變化、物體形變和背景干擾的影響,因此,本文采用擴展的Haar-Like特征。

圖1 CT中的Haar-Like特征

1)擴展的Haar-Like特征類型

Haar-Like的特征值為白色和黑色矩形區域的像素和之差。Lienhart R[12]擴展了Haar-Like特征來描述目標外觀模型(見圖2),主要是由45°旋轉特征的有效集合擴展得到。

圖2 擴展的Haar-Like特征

2) 快速特征計算

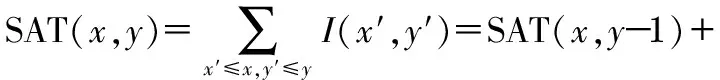

為了降低計算Haar-Like特征的計算開銷和提高跟蹤系統的實時性,引入了2種積分圖像來快速計算特征。對于豎直的矩形,SAT(x,y)被定義為從左上角(0,0)到右下角(x,y)的像素總和

SAT(x-1,y)+I(x,y)-SAT(x-1,y-1)

(4)

對于任何45°旋轉矩形的積分Rect(x,y,w,h,45°),同樣可以由如圖3右圖所示的4個點計算得到

RSum(Rect)=RSAT(x+w,y+w)-RSAT(x,y)+

RSAT(x-h,y+h)-RSAT(x+w-h,y+w+h)

(5)

圖3 45°旋轉矩形塊的積分

2.2 LBP特征空間

對于一幅灰度圖中某個局部區域內的任意像素f(xc,yc),以gc為中心圖像的灰度值,g0,…,gp-1為周圍P個像素點的灰度值,則紋理T由鄰域內中心像素點與周圍像素點灰度值的聯合分布構成

T=t(gc,g0,…,gp-1)

(6)

將鄰域內P個點的灰度值減去中心像素點的值,則有

T=t(gc,g0-gc,…,gp-1-gc)

(7)

當中心像素的灰度值較大或者較小時,周圍像素點與其差值的取值范圍就會明顯減小,從而損失一些信息。但允許損失少量的信息能使得局部紋理的描述對于灰度圖像灰度范圍內的平移具有不變性。t(gc)只是描述了整體圖像的亮度分布情況,而其不參與描述局部紋理特征,不予考慮。同樣對于均勻光照的不敏感性,有

T≈t(s(g0-gc),…,s(gp-1-gc))

(8)

其中

(9)

為每個s(gp-gc)分配一個權值2p,并計算可以得到一個唯一的LBP編碼,并將此編碼作為該中心像素的局部紋理特征

(10)

在傳統的實時任務中,通常使用的是統計數據,即LBP統計直方圖。一個輸入圖像的所有像素LBP代碼被收集到一個直方圖中,作為紋理描述符

(11)

2.3 擴展的Haar-Like特征和LBP特征的融合

將所有擴展的Haar-Like特征連接起來生成一個高維的特征向量空間xexhaar={x1,x2,…,xn},連接所有的LBP特征來生成圖像X的高維特征向量空間x′LBP={x′1,x′2,…,x′n}。然后利用擴展的Haar-Like特征來進行粗跟蹤,進一步應用LBP特征進行精細跟蹤以搜索人臉目標最佳位置。

算法流程如下:

1)初始化相關參數并手動設定第一幀中被跟蹤目標的中心位置及尺度。

2)粗采樣一組圖像塊,采樣范圍為Dγ1={p|‖It(p)-It-1‖<γ1},其中,It-1是在(t-1)幀中人臉目標的跟蹤位置,并提取低維特征。

3)計算積分圖,45°旋轉積分圖和當前幀的積分直方圖。

4)提取擴展的Haar-Like特征。利用擴展的Haar-Like特征計算式(3)得到最大的分類器響應值H1(v)并確定粗跟蹤的跟蹤位置I′t。

5)精采樣一組圖像塊,采樣范圍為Dγ2={p|‖It(p)-I′t‖<γ2},并提取低維特征。

6)提取LBP特征,利用LBP特征進行精跟蹤確定最佳位置It。

7)采樣2組圖像塊,采樣范圍分別為Dα={p|‖l(x)-I0‖<α}和Dβ={p|β<‖l(x)-I0‖<γ,α<β<γ}。

8)通過這2組圖像提取特征,并根據式(5)更新分類器系數。

3 實驗結果與分析

3.1 實驗設置

為了驗證本文算法性能,將本文算法與CT 和STC算法對4個包含遮擋、光照變化、快速移動等干擾因素的標準測試序列進行對比。測試設備配置為2.4 GHz主頻i5雙核處理器,4GB內存,Windows 10操作系統,開發環境為MATLAB與C++的混合編譯環境,版本為MATLAB 2014a。

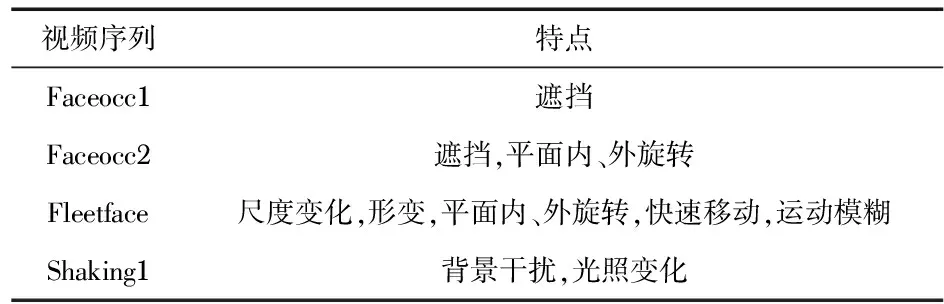

數據集和參數設置:本次實驗選擇4個公開的標準測試序列來評估本文的算法。為了更好地評估和分析跟蹤算法的性能,這些序列被分為不同的屬性,如表1所示。在實驗過程中,正樣本采樣半徑α=4,采樣負樣本的內半徑β=8,而其對應的外半徑γ=20,實驗設置了粗采樣的搜索半徑為γ1=25,精采樣的搜索半徑為γ2=4。分類器的學習參數被設置為γ=0.85。

表1 各視頻序列的特點

評價指標:中心位置誤差(center location error,CLE)、中心距離精度(distance precision,DP)是度量跟蹤算法性能的重要指標。本實驗采用這兩項指標來評價跟蹤算法的魯棒性。其中,CLE是跟蹤目標位置與實際位置的歐氏距離,單位為像素;DP為CLE 小于20的幀數占總幀數的比值。

3.2 定性結果分析

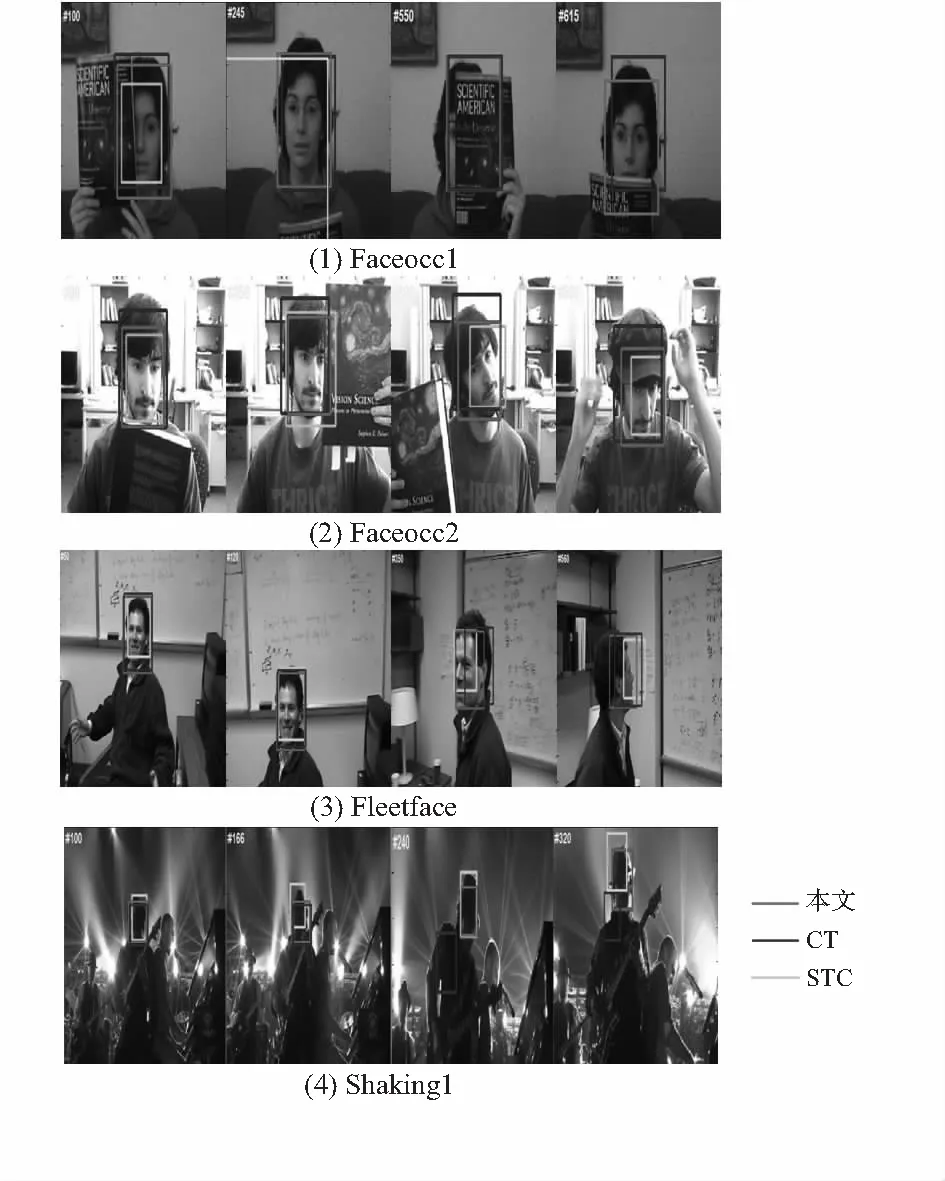

選取的4組視頻序列分別用STC算法、CT算法及本文算法進行跟蹤測試,跟蹤效果對比圖如圖4所示。

圖4 各視頻序列跟蹤結果

Faceocc1視頻序列中,前170幀人臉目標出現了短時的部分遮擋,各視頻序列跟蹤效果差不多,170幀以后人臉目標出現較長時間遮擋,STC視頻序列逐漸出現了目標漂移,由于過度的尺度調節,導致跟蹤框逐漸變大,340幀以后,由于尺度變化太大,跟蹤框已經完全消失在圖片外。CT算法在經過多次的遮擋干擾后,也逐漸產生了目標漂移。而本文算法由于采用了由粗到精的采樣策略,利用LBP特征精確描述人臉特征,使得人臉目標基本出現在跟蹤框范圍內,跟蹤效果較為穩定。

Faceocc2視頻序列中,STC算法根據人臉目標的旋轉產生了尺度變化,導致跟蹤框時大時小,并未能有效地跟蹤到完整的人臉目標。CT算法在人臉旋轉過程中出現了目標漂移。而本文算法則可以實時地跟蹤并完全標注出人臉目標。

Fleetface視頻序列中,前200幀視頻序列3種算法跟蹤效果良好,200幀以后,由于視頻序列產生了快速移動、旋轉,并產生了運動模糊,導致人臉目標開始出現漂移。300幀以后,由于視頻序列的快速旋轉,STC和CT算法均產生了明顯的人臉目標漂移,500幀以后,STC算法甚至已基本丟失目標。而相較于前兩種算法,本文算法相對較為穩定。

Shaking1視頻序列前150幀中,3種算法跟蹤效果均比較穩定,150幀以后,由于光照變化及目標的大幅度晃動,導致CT算法逐漸產生目標漂移,240幀時,STC的跟蹤框產生了部分偏移,而CT算法已完全丟失目標。在整個跟蹤過程中,本文算法都比較穩定地跟蹤到了人臉目標。

3.3 定量結果分析

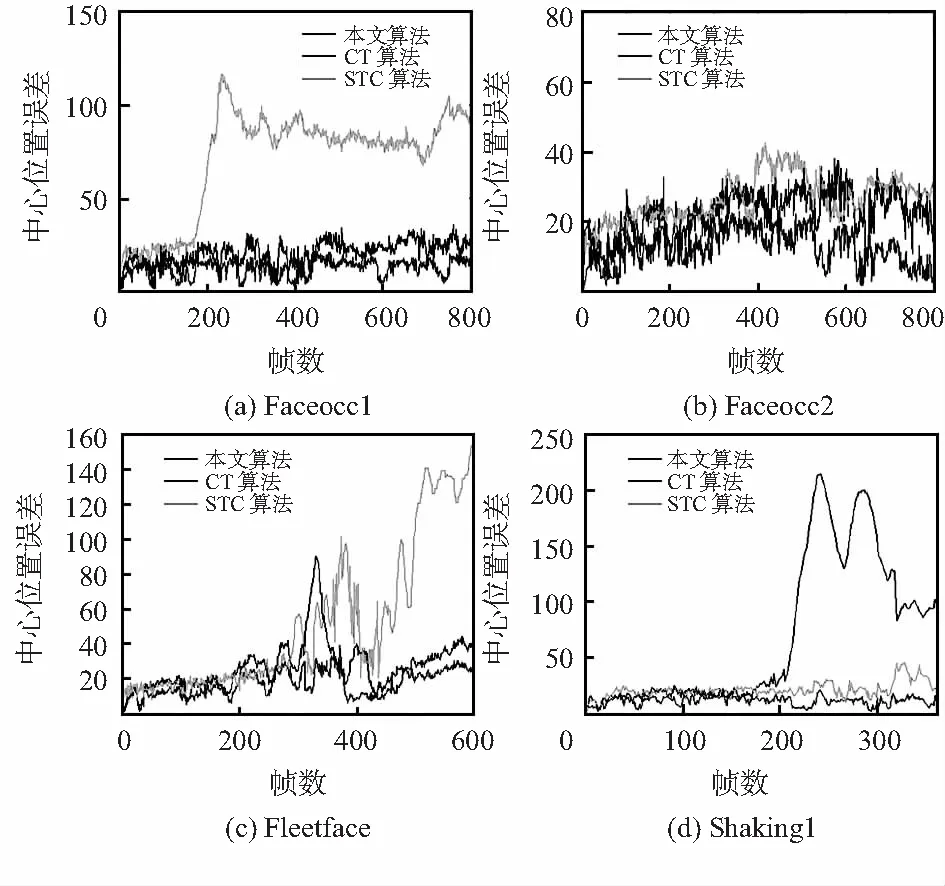

分別對STC算法、CT算法及本文算法的人臉目標跟蹤結果定量計算出中心位置誤差、中心距離精度這兩項評價指標,并繪制出跟蹤過程中的實時曲線如圖5。

圖5 各視頻序列跟蹤中心位置誤差

圖5為對本文所進行對比的三種算法針對不同視頻序列的定量分析結果。實驗數據表明,不論是從中心位置誤差還是中心距離精度方面對比,本文算法的性能都更加優越。本文算法取得了最低的中心位置誤差和最高的中心距離精度。綜上所述,本文算法整體跟蹤效果優于其他兩種算法。

4 結 論

實驗表明:本文算法在跟蹤難點如遮擋、光照變化、旋轉、形變及背景干擾等情況下跟蹤性能良好,具有較強的魯棒性。為了實現一個更加魯棒且精確的人臉跟蹤系統,仍然需要在嚴重遮擋和目標快速移動等干擾情況下進行進一步的研究。