基于深度級聯神經網絡的自動駕駛運動規劃模型

白麗贇 胡學敏 宋昇 童秀遲 張若晗

摘 要:針對基于規則的運動規劃算法需要預先定義規則和基于深度學習的方法沒有利用時間特征的問題,提出一種基于深度級聯神經網絡的運動規劃模型。該模型將卷積神經網絡(CNN)和長短期記憶網絡(LSTM)這兩種經典的深度學習模型進行融合并構成一種新的級聯神經網絡,分別提取輸入圖像的空間和時間特征,并用以擬合輸入序列圖像與輸出運動參數之間的非線性關系,從而完成從輸入序列圖像到運動參數的端到端的規劃。實驗利用模擬駕駛環境的數據進行訓練和測試,結果顯示所提模型在鄉村路、高速路、隧道和山路四種道路中均方根誤差(RMSE)不超過0.017,且預測結果的穩定度優于未使用級聯網絡的算法一個數量級。結果表明,所提模型能有效地學習人類的駕駛行為,并且能夠克服累積誤差的影響,適應多種不同場景下的路況,具有較好的魯棒性。

關鍵詞: 自動駕駛;運動規劃;深度級聯神經網絡;卷積神經網絡;長短期記憶模型

中圖分類號:TP391.4

文獻標志碼:A

Abstract:? To address the problems that rule-based motion planning algorithmsunder constraints need pre-definition of rulesand temporal features are not considered in deep learning-based methods, a motion planning model based on deep cascading neural networks was proposed. In this model, the two classical deep learning models, Convolutional Neural Network (CNN) and Long Short-Term Memory (LSTM) network, were combined to build a novel cascaded neural network, the spatial and temporal features of the input images were extracted respectively, and the nonlinear relationship between the input sequential images and the output motion parameters were fit to achieve the end-to-end planning from the input sequential images to the output motion parameters. In experiments, the data of simulated environment were used for training and testing. Results show that the Root Mean Squared Error (RMSE) of the proposed model in four scenes including country road, freeway, tunnel and mountain road is less than 0.017, and the stability of the prediction results of the proposed model is better than that of the algorithm without using cascading neural network by an order of magnitude. Experimental results show that the proposed model can effectively learn human driving behaviors, eliminate the effect of cumulative errors and adapt to different scenes of a variety of road conditions with good robustness.

Key words:? autonomous driving; motion planning; deep cascaded neural network; Convolutional Neural Network (CNN); Long Short-Term Memory (LSTM) model

0 引言

隨著社會經濟的飛速發展,機動車輛的大量增長給交通環境帶來了巨大的壓力,造成安全事故頻發。自動駕駛技術能夠突破駕駛員的限制,為解決駕駛的安全、交通擁擠等問題提供契機。運動規劃作為自動駕駛的核心環節,是連接車輛的環境感知與操縱控制的基礎和橋梁。其目的是在考慮當前狀態、感知數據以及交通規則等多種約束條件下,為自動駕駛車輛提供安全到達目的地的運動參數或可行路徑,其技術除了可用于無人車以外,還可用于無人機[1]、移動機器人[2]等自主無人系統,因此具有重要的研究意義和商業價值。

目前,自動駕駛領域應用較為廣泛的傳統運動規劃算法包括啟發式搜索算法[3-5]、快速搜索隨機樹算法[6]和基于離散優化算法[7]。基于規則的傳統運動規劃算法在無人車和智能機器人等領域取得了成功的應用。然而,這類方法需要根據預先定義的規則來建立相關數學模型,在規劃之內的場景能夠取得較好的規劃效果,而對于規則之外的場景卻難以適應。此外,這類算法不能直接對感知的數據進行處理,而需要對數據進行預處理,并抽象出模型可以接受的環境表達,而這些預處理的過程相當耗費時間,導致系統規劃反應時間過長,尤其是在緊急情況下存在較高的安全隱患。

近年來,深度學習的發展使得機器學習有了革命性的突破,其中應用較為廣泛的兩個模型是卷積神經網絡(Convolutional Neural Network, CNN)[8]和長短期記憶(Long Short-Term Memory, LSTM)網絡[9]。CNN能有效提取輸入圖像的空間特征[10],LSTM可以提取連續輸入圖像的時間特征[11]。而運動規劃的本質,是從感知的序列數據到運動參數的映射。因此,將深度神經網絡引入運動規劃領域,能夠實現從感知數據到運動參數的規劃。目前已有一些基于深度神經網絡的方法取得了較好的成果。NVIDIA公司[12]提出了一種基于CNN的端對端的運動規劃算法,將道路線檢測、路徑規劃和控制等子步驟通過CNN同時完成。該方法能有效地將駕駛圖像特征映射為方向盤轉角,但是沒有考慮前后幀的時間特征。Chen等[13]在深度神經網絡的基礎上提出了13個可用于自動駕駛的場景描述指標,通過精確地學習這些指標的值后,可完成轉向角的控制。該方法在沒有車輛的道路的數據集中取得良好表現,但同樣沒有利用連續幀的信息,在路況復雜的情況下駕駛行為不穩定。Sallab等[14]使用深度強化學習提出了一種自動駕駛框架,它包含了用于信息集成的遞歸神經網絡,使汽車能夠處理部分可觀察的場景。然而該方法需要通過在環境中試錯來訓練模型,訓練時間長,且難以將模型遷移到實際環境中。此外,這些方法只利用單個前向攝像機獲取駕駛信息,沒有考慮周圍的信息,容易造成累積誤差的問題。

針對基于傳統的運動規劃算法存在的需要預先定義規則、預處理復雜,以及基于深度學習方法中沒有利用連續幀之間的時間特征、模型訓練時間長、沒考慮累積誤差等問題,本文提出一種基于深度級聯神經網絡(Deep CNN, DCNN)的自動駕駛運動規劃模型。該模型利用CNN和LSTM構成深度級聯神經網絡,分別提取駕駛場景序列圖像中的空間和時間特征,并與車輛的方向盤轉角建立映射關系,從而實現直接從感知圖像到運動參數的端到端的運動規劃;并且,為了解決累計誤差的問題,訓練時使用左、中、右三個攝像機采集的前向視頻構成數據集,解決在線測試時累計誤差的自動修正問題。該模型采用深度學習的方法解決自動駕駛運動規劃的問題,讓規劃算法具備學習能力,能夠應對多種復雜的道路場景,并且不需要預處理過程,實現端到端的運動規劃。本文方法既解決了自動駕駛中復雜道路場景的時空特征表達問題,也為端到端的運動規劃提供新的方法。

1 基于深度級聯神經網絡的運動規劃模型

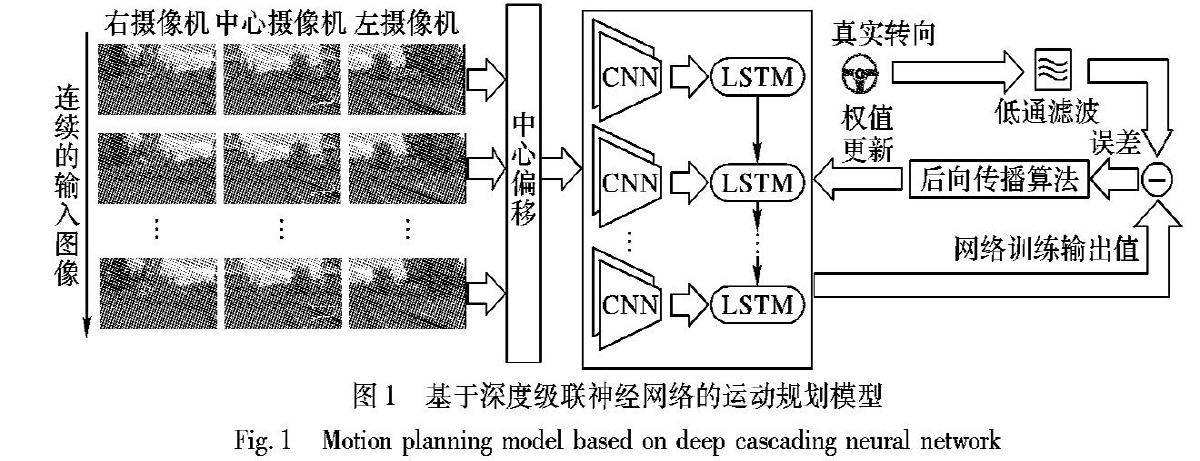

本文提出的基于DCNN的運動規劃模型如圖1所示,模型輸入為前向車載相機的序列圖像,經過網絡后輸出為當前預測的方向盤轉角。深度級聯神經網絡由CNN層和LSTM層組成。其中,CNN層對每一幀圖像提取空間特征,然后輸入到LSTM層提取連續幀圖像的時間特征,最后模型輸出得到方向盤轉向角的預測結果。該過程可用式(1)來描述:

在訓練階段,將左、中、右三個攝像機采集的序列圖像數據集作為輸入,模型預測輸出方向盤轉角。此外,利用輸入圖像對應的真實方向盤轉向角,即數據標簽,與預測的轉向角之間的誤差計算損失函數,經過反向傳播算法對CNN和LSTM網絡中的權值進行更新。為了消除數據采集中的誤差影響,本文對人工采集的真實方向盤轉角進行低通濾波處理。在測試階段,僅將中心攝像機采集的視頻作為輸入,用訓練好的模型預測當前輸入下的方向盤轉角,實現從輸入圖像到運動參數端到端的運動規劃。

1.1 CNN層網絡設計

近年來,CNN被廣泛應用于大規模的圖像識別任務中。由于其使用了局部連接和權值共享的方式,在處理二維圖像時,特別是在識別位移、縮放以及其他形式的扭曲不變性應用上有著良好的魯棒性。自動駕駛場景復雜,車載相機獲取的圖像中目標種類較多,有效提取這些圖像特征是一個較為困難的任務。

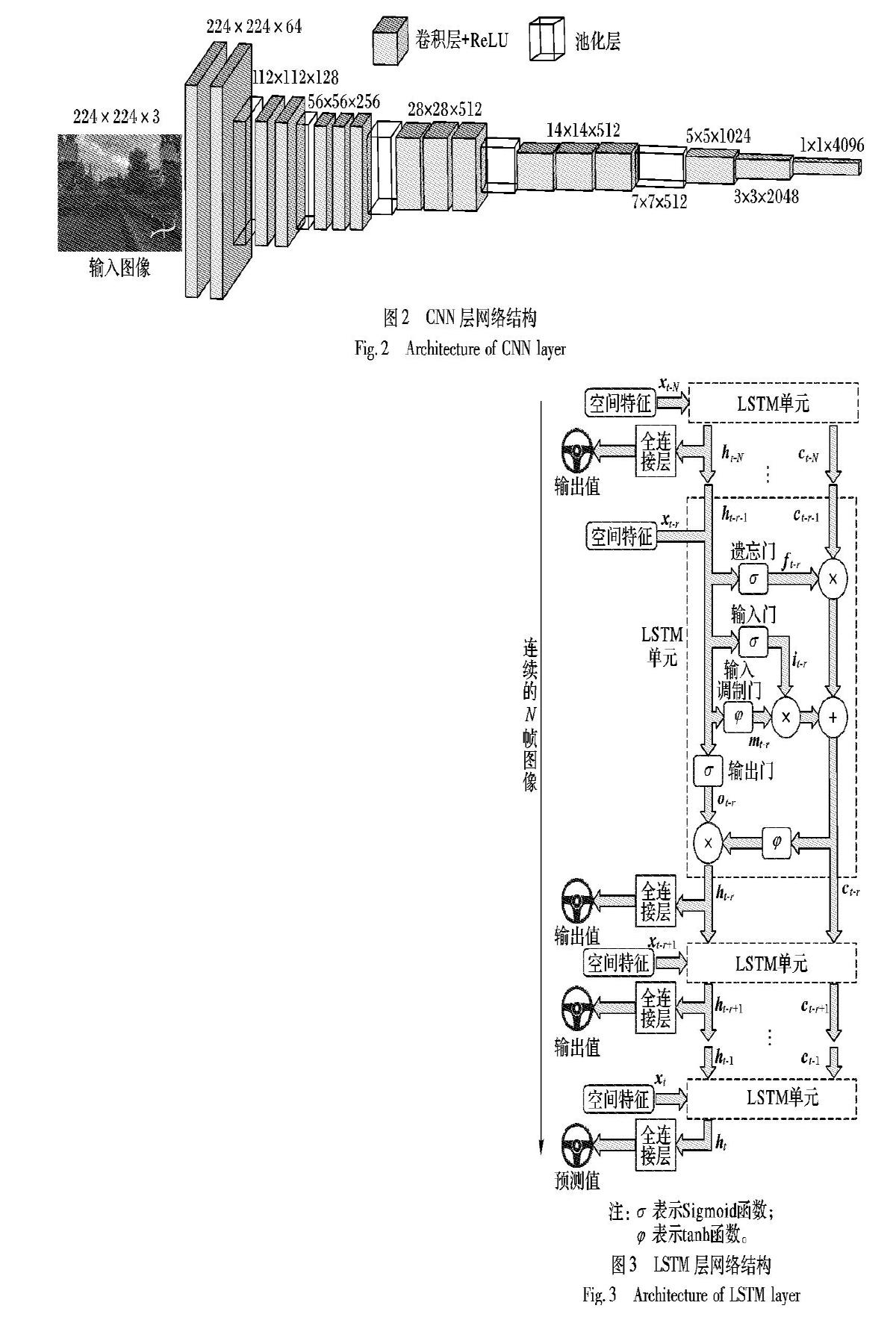

VGG-Net(Visual Geometry Group Net)[15]是牛津大學計算機視覺組和Google DeepMind公司的研究員在2014年提出的一種CNN,采用ImageNet數據集進行訓練,并廣泛用于目標檢測等圖像識別領域。而自動駕駛場景中建筑物、車輛、行人等目標已經包含在該數據集中,因此本文選擇VGG-Net作為CNN的網絡結構基礎,依據級聯網絡的設計進行改進,并利用駕駛場景數據集對網絡權值進行微調,以此減少訓練時間。此外,考慮到運動規劃對實時性的要求,本文實驗中采用VGG-16作為本文CNN層的基礎模型,并進行改進。改進的VGG網絡結構如圖2所示,將224×224的三通道圖像作為輸入,在經過5個卷積層與5個池化層之后,通過三個卷積層輸出得到1×1×4096的特征矢量。其中,所有的卷積層使用3×3的卷積核,同時使用修正線性單元(Rectified Linear Unit, ReLU)作為激活函數。前5個卷積層的滑動步長為1個像素,卷積層的空間填充固定為1個像素,用來保持卷積后圖像的長寬尺寸與卷積前一致。池化層采用尺寸為2×2最大池化方法,步長為2。

CNN中,卷積層和池化層一般用于提取圖像特征,而全連接層一般作為分類器用于對目標進行分類。由于本文提出的深度級聯網絡中,CNN的目的是提取駕駛場景圖像的空間特征,不需要進行分類,因此本文去掉了原始VGG-16中的最后3個全連接層,用3個3×3、滑動步長為2的卷積層代替原始VGG-16網絡中的全連接層。相對于較大的卷積核,較小卷積核需要訓練總的參數數量更少,更有利于訓練時的收斂,減少訓練時程序占用的計算資源。

1.2 LSTM層網絡設計

LSTM是一種經典的循環神經網絡,可以學習長期依賴信息。由于其加入了門控和LSTM細胞狀態等機制,其網絡的權重可隨時間尺度動態地改變,因此可以提取長期時間的序列特征。圖3中虛線矩形框中LSTM單元描述了LSTM單元的內部結構,其中,其中:Wxi與b分別表示對應門控單元的權值與偏差;xt-r表示LSTM單元的輸入;ht-r與ht-r-1分別表示當前LSTM單元的輸出與上一個單元的輸出;ct-r與 ct-r-1分別表示當前細胞狀態與上一個單元的細胞狀態; ft-r表示遺忘門;it-r表示輸入門;ot-r表示輸出門;mt-r表示輸入調制門;“⊙”為點乘。在LSTM單元中設置了四個控制門,每一個控制門都是由多層感知機與激活函數構成的。在LSTM中,首先由遺忘門讀取xr和hr-1,在決定丟棄的信息后輸出fr。下一步決定讓多少信息加入到細胞狀態,這個過程分為sigmoid層決定需要更新的信息ir和一個tanh層生成備選的用來更新的內容mr兩部分組成,這兩部分聯合起來對細胞狀態進行更新。在更新細胞狀態時,把fr與舊狀態點乘后加上ir⊙mr完成細胞狀態更新。最后確定輸出信息,由一個sigmoid層來確定細胞狀態的輸出部分,并把細胞狀態通過tanh進行處理并將它和sigmoid門的輸出相乘,得到最終輸出的信息。由于運動規劃的輸入視頻圖像在時間上是相關的,因此LSTM適合于提取視頻中時間前后幀的關聯信息。

本文中LSTM網絡設計如圖3所示。對于每一幀圖像,CNN網絡輸出一個特征向量x,對于連續n幀圖像輸出n個特征矢量。本文設計的CNN層的輸出為1×1×4096的向量,在這里作為空間特征向量輸入到LSTM單元中,經過LSTM層和全連接層后輸出轉向角的預測。對于當前時刻t,其輸出的值由特征向量xt與上一個LSTM單元的輸出 ht-1和狀態ct-1決定,在經過全連接層與輸出節點,即得到當前方向盤轉角的預測值。在LSTM網絡中,LSTM單元中的權值是共享的,即對應于不同時刻的駕駛圖像,其對應的LSTM單元中的四個控制門的權值是一樣的。在如圖3所示的網絡結構中,LSTM單元是同一個LSTM單元在復用,在上一時刻LSTM單元的輸出值與細胞狀態會傳入下一時刻的單元中。

1.3 網絡輸出與目標函數設計

車輛的方向盤轉向角度是一種連續的變量,因此轉向角的預測問題可以看作是神經網絡的回歸問題。由于本文的預測的運動參數只有轉向角,所以設計的深度級聯神經網絡的輸出節點數量為1。此外,為設計目標函數訓練深度級聯神經網絡,本文采用轉向角的預測值與真實值之間的歐氏距離作為損失函數,如式(8)所示:

其中:L表示損失函數; pg表示對應的方向盤轉角真實值,由人工采集獲取;s為模型的輸入圖像;M為神經網絡模型。為防止網絡訓練的過擬合問題,本文采用L2正則化的方法。因此,本文設計的目標函數更新方法如式(9)所示:

1.4 網絡的訓練與測試

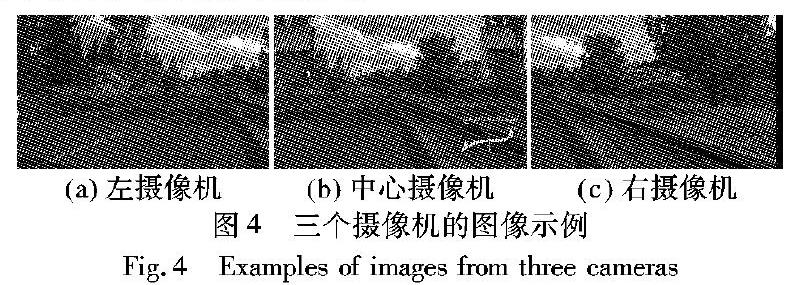

本文提出的基于DCNN的運動規劃方法,利用事先采集的訓練樣本進行模型訓練,然后利用訓練好的模型對測試樣本進行離線測試。但是由于離線測試中存在累積誤差的問題,如果不加以修正,難以直接用于在線測試。為了解決該問題,在采集訓練數據時設置了3個攝像機,分別是左攝像機、中心攝像機和右攝像機。中心攝像機的主光軸與車身豎直方向平行,左、右兩個攝像機的主光軸設置與中心攝像機有一定的夾角(本文中夾角設置均為25°)。三個攝像機采集的圖像如圖4所示。左、右兩個攝像機能夠顯示車輛從當前車道中心的不同位移,以及與道路方向的偏航角度。從左、右攝像機分別獲得兩種不同位移的圖像,通過對最近的攝像機圖像進行視點變換,模擬攝像機與各偏航角之間的附加位移,并將轉換后的圖像樣本的轉向角標簽作相應的角度調整,作為補充訓練數據集。左、右攝像機與中心攝像機采集的樣本數據及標簽一起構成訓練數據集。通過補充數據集中樣本的訓練,自動駕駛車輛能夠在航向角偏離正常航線時及時自動修正方向,不讓誤差形成累積效應。

在訓練階段,使用包含多種場景的駕駛數據的訓練集對網絡進行訓練,使用反向傳播算法在每一次迭代中更新網絡的權值。本文使用隨機梯度下降算法來計算每一次更新的權值。由于訓練集樣本較多,隨著迭代次數的增加,網絡參數逐漸向最優參數逼近。本文中,迭代總次數設置為200000,初始學習率為0.0015,batchsize的大小為4。

本文測試分為離線測試和在線測試。離線測試中,測試數據采用未經訓練的路段駕駛視頻流輸入到網絡中,記錄每幀對應的輸出,并與真實數據作對比,從對比的結果中判斷網絡輸出的結果是否能作為準確的規劃結果;在線測試主要是驗證累積誤差的修正問題,讓算法在模擬器中運行,驗證自動駕駛車輛是否能安全行駛。

2 實驗與結果分析

為保證測試的安全性,本文實驗在模擬器的環境下開展。歐洲卡車模擬器2是目前經典的一種駕駛模擬器,其逼真的模擬場景、大范圍的地圖和多路況和天氣的模擬,很適合作為自動駕駛的模擬器。本文使用Europilot框架進行數據采集,通過模擬方向盤、油門和剎車踏板采集人工駕駛的方向盤轉角數據作為訓練樣本的標注信息。

在實驗中,人類操作該模擬器以30 幀/秒的幀率進行三個攝像機的圖像采集,每幀圖像的像素尺寸為1853×1012,輸入網絡時將圖像縮小為224×224。為保證駕駛場景的多樣性,實驗采集了約8h的駕駛數據,包括4種不同的道路,分別是鄉村路、高速路、隧道和山路。由于本文方法沒有考慮交通標志信息,因此沒有將城市道路作為實驗路段。實驗中每種道路取一段路作為測試集,其他數據均作為訓練集,使用訓練集中的數據對本文提出的DCNN模型進行訓練,再使用測試集的數據對網絡的輸出進行測試。由于模仿學習是學習人類的駕駛行為,因此評判模型預測的準確性就以人類專家的駕駛數據作為標準。將測試結果與人類駕駛的數據進行對比,采用均方根誤差(Root Mean Squared Error, RMSE)來衡量模型的性能,公式如下所示:

穩定性也是衡量自動駕駛模型好壞的一個重要的指標,駕駛的穩定性影響著舒適度和安全性。由于均方誤差的大小可以是從零到無窮大,只是針對每幀預測準確性作評估,無法衡量駕駛的平穩性,因此本文使用式(11)作為駕駛穩定性的衡量標準:

其中:ST為穩定度指標。對于弧度不同的彎道,穩定度指標有著較大的變換范圍,因此該指標只能衡量同一場景下不同模型的穩定度,而不能對不同場景下的情況作出評判。

本文實驗的軟件環境為Ubuntu 16.04,深度神經網絡框架采用Caffe[16],硬件環境CPU為Core i7-7700K (Quad-core 4.2GHz)、GPU為 NVIDA GTX 1080Ti、內存為32GB。實驗同時測試了未使用LSTM的原始VGG-16和NVIDIA訓練的神經網絡[12]作為對比。實驗的結果如圖5~7,以及表1~2所示。根據實驗結果,可得到如下結論:

1)深度級聯網絡模型中的空間特征提取層基于改進的VGG設計,能夠有效提取不同復雜場景的圖像特征,因此對于不同的場景能夠作出準確的預測。從圖5中可以觀察DCNN的預測曲線與真實曲線比較相近,4個場景的RMSE均不超過0.017,大約為轉向角輸出值范圍的1%。圖7為同一時刻三種方法與真實數據的對比,可以看出相對于原始的VGG網絡與

文獻[12]方法所采用的網絡,由于使用了LSTM,改進的網絡預測更為準確。從表1可知在四個場景中原始的VGG和文獻[12]方法的均方根誤差均高于DCNN方法,而且4種場景的均方根誤差都在同一水平。

2)本文方法預測的轉向角具有較好的穩定性。在4個場景中,預測轉向的穩定度與真實轉向的穩定度相差不大,而且遠好于原始的VGG方法與文獻[12]方法。與人類專家的駕駛穩定度相比,DCNN的穩定度與人類專家相近,而原始的VGG和文獻[12]方法的穩定度指標高于人類專家一個數量級,相差比較大。這是因為人工采集的數據由于手的抖動和輸入設備等問題,存在一些噪聲。而本文方法中利用了濾波器對輸入數據進行平滑,且增加了LSTM層,使得網絡能夠將時間上前后相鄰的幾幀圖像聯系在一起,輸出更加平滑的預測值。

3)本文方法能有效地修正行駛中的累積誤差。本文在訓練網絡時除了前向中心攝像機的圖像,還增加了左、右兩個攝像機的采集的圖像作為訓練樣本來訓練模型,使模型能夠在偏離正確航向時修正方向,不讓誤差累積起來。圖6為一段連續在線測試的圖像。從圖6的右后視鏡中可以看出,第1幀中車輛有稍微向右偏離當前車道,但是模型能夠自動修正誤差,從第8幀開始回到當前車道中央。

4)本文設計的深度級聯神經網絡算法采用了GPU加速,因此在處理速度上相對于傳統的單線程算法具有一定速度上的優勢。視頻流從輸入神經網絡到輸出預測值大約需要0.05s,即每秒鐘約20次規劃。而人類的反應時間大約為0.2s[17],要遠大于本文方法預測的時間,因此本文方法能夠滿足在自動駕駛中運動規劃的實時性要求。

3 結語

本文提出了一種深度級聯神經網絡,并利用該網絡實現從輸入圖像到運動參數的端到端的自動駕駛運動規劃。該方法中,利用前向車載相機的序列圖像作為輸入,使用提出的深度級聯神經網絡對自動駕駛的運動參數做回歸,實現對方向盤轉向角的預測。深度級聯網絡融合了CNN和LSTM兩種經典的深度模型,使模型不僅能夠提取駕駛場景的空間特征,還提取了連續圖像的時間特征,實現對輸出結果的準確預測;并且,訓練時額外利用了左、右兩個攝像機采集的數據作為補充數據集,解決了在線測試時的累計誤差修正問題。實驗結果表明,通過大量數據的訓練,該網絡能夠有效、實時地針對不同場景的駕駛轉向角作出預測,能夠適應復雜的動態場景。由于該方法沒有考慮交通信息以及全局路徑信息,只能從網絡的輸入得到規劃的結果,因此無法應用于城市道路。未來的工作將集中在如何將全局路徑信息和交通信息融合于模型,讓模型能夠適應更復雜的城市道路。

參考文獻(References)

[1] 余翔, 王新民, 李儼. 無人直升機路徑規劃算法研究[J]. 計算機應用, 2006, 26(2): 494-495. (YU X, WANG X M, LI Y. Study of a path planning algorithm for unmanned helicopter[J]. Journal of Computer Applications, 2006, 26(2): 494-495.)

[2] 張超超, 房建東. 基于定向加權A*算法的自主移動機器人路徑規劃[J]. 計算機應用, 2017, 37(S2): 77-81. (ZAHNG C C, FANG J D. Path planning of autonomous mobile robot based on directional weighted A* algorithm[J]. Journal of Computer Applications, 2017, 37(S2): 77-81.)

[3] BRANDES U. A faster algorithm for betweenness centrality[J]. Journal of Mathematical Sociology, 2001, 25(2): 163-177.

[4] HART P E, NILSSON N J, RAPHAEL B. A formal basis for the heuristic determination of minimum cost paths[J]. IEEE Transactions on Systems Science and Cybernetics, 1968, 4(2): 100-107.

[5] STENTZ A. Optimal and efficient path planning for partially-known environments[C]// Proceedings of the 1994 IEEE International Conference on Robotics and Automation. Piscataway: IEEE, 1994: 3310-3317.

[6] KARAMAN S, WALTER M R, PEREZ A, et al. Anytime motion planning using the RRT*[C]// Proceedings of the 2011 IEEE International Conference on Robotics and Automation. Piscataway: IEEE, 2011: 1478-1483.

[7] HU X, CHEN L, TANG B, et al. Dynamic path planning for autonomous driving on various roads with avoidance of static and moving obstacles[J]. Mechanical Systems and Signal Processing, 2018, 100: 482-500.

[8] LECUN Y L, BOTTOU L, BENGIO Y, et al. Gradient-based learning applied to document recognition[J]. Proceedings of the IEEE, 1998, 86(11): 2278-2324.

[9] HOCHREITER S, SCHMIDHUBER J. Long short-term memory[J]. Neural Computation, 1997, 9(8): 1735-1780.

[10] 胡學敏, 易重輝, 陳欽, 等. 基于運動顯著圖的人群異常行為檢測[J]. 計算機應用, 2018, 38(4): 1164-1169. (HU X M, YI C H, CHEN Q, et al. Abnormal crowd behavior detection based on motion saliency map[J]. Journal of Computer Applications, 2018, 38(4): 1164-1169.)

[11] WOJNA Z, GORBAN A N, LEE D, et al. Attention-based extraction of structured information from street view imagery[C]// Proceedings of the 14th IAPR International Conference on Document Analysis and Recognition. Piscataway: IEEE, 2017: 844-850.

[12] BOJARSKI M, del TESTA D, DWORAKOWSKI D, et al. End to end learning for self-driving cars[EB/OL]. (2016-04-25) [2019-02-23]. https://arxiv. org/pdf/1604.07316.pdf.

[13] CHEN C Y, SEFF A, KORNHASUER A, et al. Deep driving: learning affordance for direct perception in autonomous driving[C]// Proceedings of the IEEE 2015 International Conference on Computer Vision. Piscataway: IEEE, 2015: 2722-2730.

[14] SALLAB A E L, ABDOU M, PEROT E, et al. Deep reinforcement learning framework for autonomous driving[EB/OL]. [2019-01-10]. https://arxiv.org/abs/1704.02532.

[15] SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition [EB/OL]. [2019-01-20]. https://arxiv.org/pdf/1409.1556.pdf.

[16] JIA Y, SHELHAMER E, DONAHUE J, et al. Caffe: convolutional architecture for fast feature embedding[C]// Proceedings of the 22nd ACM Conference on Multimedia. New York: ACM, 2014: 675-678.

[17] THORPE S, FIZE D, MARLOT C. Speed of processing in the human visual system[J]. Nature, 1996, 381(6582): 520-522.