基于新型間諜技術的半監督自訓練正例無標記學習

李婷婷 呂佳 范偉亞

摘 要:正例無標記(PU)學習中的間諜技術極易受噪聲和離群點干擾,導致劃分的可靠正例不純,且在初始正例中隨機選擇間諜樣本的機制極易造成劃分可靠負例時效率低下,針對這些問題提出一種結合新型間諜技術和半監督自訓練的PU學習框架。首先,該框架對初始有標記樣本進行聚類并選取離聚類中心較近的樣本來取代間諜樣本,這些樣本能有效地映射出無標記樣本的分布結構,從而更好地輔助選取可靠負例;然后對間諜技術劃分后的可靠正例進行自訓練提純,采用二次訓練的方式取回被誤分為正例樣本的可靠負例。該框架有效地解決了傳統間諜技術在PU學習中分類效率易受數據分布干擾以及隨機間諜樣本影響的問題。通過9個標準數據集上的仿真實驗結果表明,所提框架的平均分類準確率和F-值均高于基本PU學習算法(Basic_PU)、基于間諜技術的PU學習算法(SPY)、基于樸素貝葉斯的自訓練PU學習算法(NBST)和基于迭代剪枝的PU學習算法(Pruning)。

關鍵詞:正例無標記學習;間諜技術;半監督自訓練;聚類;可靠負例;可靠正例

中圖分類號:TP181

文獻標志碼:A

Abstract: Spy technology in Positive and Unlabeled (PU) learning is easily susceptible to noise and outliers, which leads to the impurity of reliable positive instances, and the mechanism of selecting spy instances in the initial positive instances randomly tends to cause inefficiency in dividing reliable negative instances. To solve these problems, a PU learning framework combining new spy technology and semi-supervised self-training was proposed. Firstly, the initial labeled instances were clustered and the instances closer to the cluster center were selected to replace the spy instances. These instances were able to map the distribution structure of unlabeled instances effectively, so as to better assist to the selection of reliable negative instances. Then, the reliable positive instances divided by spy technology were purified by self-training, and the reliable negative instances which were divided as positive instances mistakenly were corrected by secondary training. The proposed framework can solve the problem of PU learning that the classification efficiency of traditional spy technology is susceptible to data distribution and random spy instances. The experiments on nine standard data sets show that the average classification accuracy and F-measure of the proposed framework are higher? than those of Basic PU-learning algorithm (Basic_PU), PU-learning algorithm based on spy technology (SPY), Self-Training PU learning algorithm based on Naive Bayes (NBST) and Iterative pruning based PU learning (Pruning) algorithm.

Key words: Positive and Unlabeled (PU) learning; spy technology; semi-supervised self-training; clustering; reliable negative instance; reliable positive instance

0 引言

正例無標記(Positive and Unlabeled, PU)學習是指訓練集在僅含正例樣本和無標記樣本的情況下訓練分類器的過程[1-2]。從正例樣本和無標記樣本中學習分類器是實際應用中一類重要的分類問題,常見于在用戶提供的大量數據中檢索相似樣本、網絡評論中的欺騙性意見檢測以及醫療行業中疾病基因預測等領域[3-4]。

PU學習的特點是初始有標記樣本中沒有已標注的負例樣本,常見的監督學習或者半監督學習方法在這樣的場景中往往失效[5]。近年來已有學者展開了相應的研究,即通過找出無標記樣本中的可靠負例來擴充初始有標記樣本集,進而在重新初始化后的標記樣本集上訓練分類器對無標記樣本進行分類,但該方法得出的可靠負例往往包含較多被誤分為負例的正例樣本[6]。對此,Villatoro-Tello等[7]通過選出無標記樣本集中分布較好的負例樣本迭代添加到初始已標記樣本集中的訓練分類器,降低了算法對已標記樣本中噪聲的敏感性,有效地選出了無標記樣本中的可靠負例,并成功地將該方法運用于文本分類領域。Han等[8]進一步研究發現,在選出無標記樣本中可靠負例的同時,也可以對應選出無標記樣本中的可靠正例,由此提出了一種基于聚類提取可靠正負例樣本的方法,并用加權極值學習機對分類器進行訓練。實驗結果表明,該方法能夠有效地對僅含正樣本和無標記樣本的不確定數據流進行分類。以上方法都是在重新初始化后的已標記樣本集上訓練分類器,但重新初始化后的已標記樣本集中正例樣本是絕對可靠的,而負例樣本則是相對可靠的,初始化強烈傾向于正例樣本,這在一定程度上影響了算法的分類效果。

第10期

李婷婷等:基于新型間諜技術的半監督自訓練正例無標記學習

計算機應用 第39卷

為了解決PU學習中重新初始化后的標記樣本強烈傾向于正例的問題,Zeng等[9]采用一種能平衡傾向性的間諜技術來重新初始化標記樣本,該技術通過將初始正例中部分樣本看作間諜樣本發送到無標記樣本中,通過間諜樣本推斷出無標記樣本中未知正例的行為,同時有效地選出了可靠負例。文獻[10]將間諜技術應用于移動互聯網流量數據的用戶行為分析上,提出了基于二分網絡特征的PU學習方法用于用戶行為分類和預測,利用實際的QQ流量數據和移動視頻流量數據驗證了該方法的有效性。類似地,文獻[11]描述了現實獲取的數據只包含少量已知的被攻擊的統一資源定位符(Uniform Resource Locator, URL)和大量未標記實例,文中將此形式化為PU問題。

通過將間諜技術與成本敏感策略相結合,提出一種基于間諜技術的PU學習算法(PU learning algorithm based on spy technology, SPY),用于檢測潛在URL攻擊。實驗結果表明,該方法能夠有效地發現潛在的URL攻擊。張璞等[12]提出了一種基于間諜技術的PU學習的建議語句分類方法,該方法為了降低特征維度、緩解數據稀疏性,在自編碼神經網絡特征空間中使用間諜技術劃分可靠反例無標注樣例進行分類。由此可見,嵌入間諜技術的PU學習方法有效地平衡了初始正負例樣本,使其在分類過程中具有更好的泛化性,從而更好地對無標記樣本進行分類。

然而,傳統間諜技術極易受噪聲和離群點干擾,分類過程中很少考慮到劃分結果的純凈度問題,且隨機選擇間諜樣本的機制也給分類結果帶來一定的不穩定性。本文鑒于半監督自訓練方法可以迭代選取高質量無標記樣本對分類器進行更新,更新后的分類器能產生更精準的分類效果,從而提出了間諜技術結合半監督自訓練的PU學習方法(PU learning method combining spy technology and semi-supervised Self-Training, SPYST),

SPYST通過將間諜技術的分類結果用半監督自訓練方法進行二次提純取得了更有效的分類效果,但SPYST尚未解決間諜樣本選擇的隨機性帶來的分類誤差。因此,在SPYST的基礎上從數據的空間結構出發,將初始正例的空間結構展露出來,然后挑選更具代表性的間諜樣本,進一步提出了改進間諜技術后結合半監督自訓練的PU學習方法(Improved SPYST, ISPYST)。

本文的主要工作為:

1)對PU學習中間諜技術展開研究,結合自訓練方法對間諜技術的粗糙分類結果進行二次提純。現有的國內外文獻對間諜技術的研究主要集中于將該技術應用于文本分類、網絡意見檢測等方面,極少對間諜技術分類結果的純凈度進行研究。

2) 間諜技術中間諜樣本的隨機選取給分類結果帶來一定的不穩定性,本文通過對初始正例的空間結構進行研究,選取了離聚類中心較近的樣本作為間諜樣本,這些樣本更具代表性,能更好地反映無標記樣本中未知正例的行為方式。

1 相關工作

1.1 PU學習

PU學習是指在僅包含少量正例樣本和無標記樣本中進行分類的一種特殊半監督學習,常見的PU學習過程是把無標記樣本全部看作負類結合初始正例構造分類器再對無標記樣本進行分類,找出無標記樣本中隱藏的可靠負例,進而將可靠負例加入初始正例樣本重新初始化有標記樣本集。分類過程如圖1所示,其中P表示初始正例樣本,U表示無標記樣本,C表示分類器,RN表示可靠負例,P′表示劃分出的正例樣本,N′表示劃分出的負例樣本。但該方法獲得的標記樣本中正例樣本是絕對可靠的,所包含的樣本信息也絕對準確;而標記樣本中負例樣本卻只是相對可靠,所包含的樣本信息的無法達到絕對真實。所以,重新初始化后的標記樣本更傾向于正例樣本,在后續的分類過程中更利于無標記樣本中未知正例的劃分,這就造成的分類結果的不平衡性。

1.2 基于間諜技術的PU學習

間諜技術是基于解決常見PU學習中重新初始化后標記樣本強烈傾向于正例樣本而提出,該方法能有效地平衡初始化后標記樣本的傾向性問題,同時輔助識別無標記樣本中的可靠負例。間諜技術是指通過從初始有標記樣本中隨機選出部分正例發送到無標記樣本集,這些選出的正例樣本被稱之為間諜樣本,它與無標記樣本中的未知正例樣本的行為是一致的,從而能夠可靠地對未知正例樣本行為進行評估。混合間諜樣本的無標記樣本集在分類算法訓練完成后,根據間諜樣本的后驗概率設置閾值θ,當無標記樣本屬于正類的概率小于θ時,該樣本被視為可靠負例,其余樣本則被視為可靠正例[11]2599-2600。通過間諜技術劃分數據類別的詳細算法過程如下。

1.3 半監督自訓練學習

半監督自訓練是指在無標記樣本中選取高質量樣本給初始標記樣本學習,底層分類器被重新訓練,直至無標記樣本被全部劃分。半監督自訓練算法在循環迭代的過程中,不斷更新分類器劃分無標記樣本,使得無標記樣本每一次都能在分類器狀態最好的情況下被提純,確保了無標記樣本的分類準確率[13-15]。半監督自訓練算法的一般流程如下:

輸入 初始有標記樣本集L,初始無標記樣本集U,底層分類器C,迭代次數f,用于選擇下一次迭代的無標記樣本個數H,選擇度量M,選擇函數E(Uf,H,C,M),最大迭代次數Maxlteration。

2 本文算法

2.1 SPYST

2.1.1 算法思想

在初始數據集分布較好且無噪聲或離群點干擾的環境中使用間諜技術識別可靠負例和可靠正例能取得令人滿意的效果,然而,大多數真實的數據集都含有噪聲或離群點,這樣的數據集通過傳統間諜技術分類變得不再可靠。原因是:間諜樣本中離群點的后驗概率Pr(C1|st)可能比大多數甚至所有的實際的負例樣本要小得多。在這種情況下,通過間諜樣本的概率值Pr(C1|st)來確定閾值θ,就無法在召回間諜樣本的同時對無標記樣本進行有效分類,導致了選出的可靠正例往往不純,可靠負例過少甚至沒有。圖3表示在噪聲干擾的環境中的分類結果,其中C1代表在分類過程中被當作正類的樣本集,C-1代表在分類過程中被當作負類的樣本集。由圖3可知,在有噪聲或離群點的環境中通過間諜技術選出可靠負例時效率不高,得出的可靠正例包含較多被誤分為正類的負例樣本。所以,在數據分布較差的環境中用間諜技術進行PU學習的方法變得不盡人意。

因此,本文提出了一種結合間諜技術與半監督自訓練的PU學習方法SPYST。SPYST在間諜技術對無標記樣本首次分類完成后,將RP看作新的無標記樣本U′,并對新的無標記樣本進行自訓練提純,此處選用穩定性較強的樸素貝葉斯作為分類器。SPYST首先對新的無標記樣本做樸素貝葉斯分類,然后將分類置信度從高到低排序,選出置信度較高的無標記樣本及其相應的類標簽添加到初始正例樣本與RN的合集中,這主要是因為高置信度樣本攜帶更多有效分布信息,利于分類器的重新訓練。循環迭代上述過程直至新的無標記樣本被全部劃分完成。這也就達到了對間諜技術的粗糙分類結果進行精細化提純的目的,從而得出了分類效率更高的PU學習框架。SPYST整體學習框架如圖4所示,其中P表示初始正例樣本,U表示無標記樣本,S表示選出的間諜樣本,C表示樸素貝葉斯分類器,RN表示可靠負例,RP表示可靠正例,topf表示選出的前f個高置信度樣本。

2.2.1 算法思想

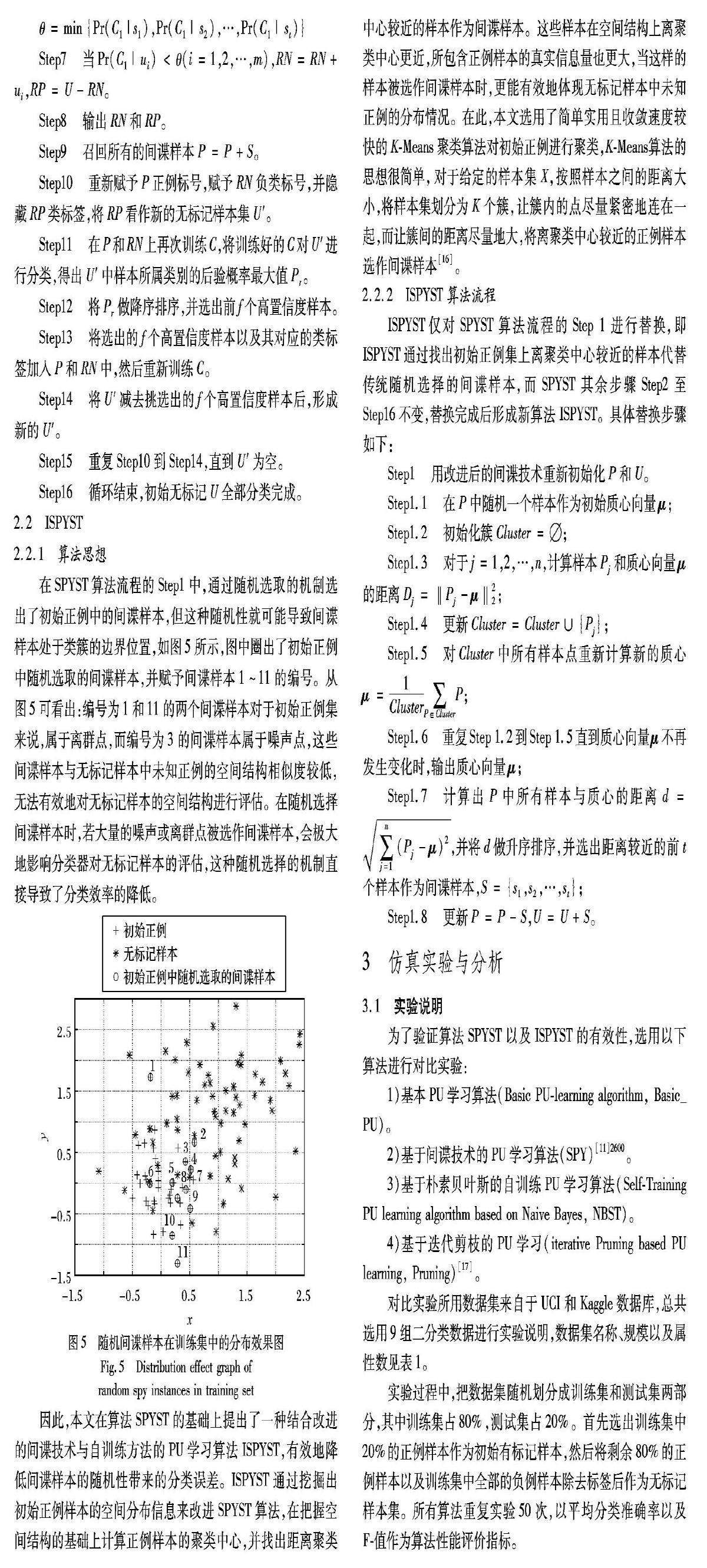

在SPYST算法流程的Step1中,通過隨機選取的機制選出了初始正例中的間諜樣本,但這種隨機性就可能導致間諜樣本處于類簇的邊界位置,如圖5所示,圖中圈出了初始正例中隨機選取的間諜樣本,并賦予間諜樣本1~11的編號。

從圖5可看出:編號為1和11的兩個間諜樣本對于初始正例集來說,屬于離群點,而編號為3的間諜樣本屬于噪聲點,這些間諜樣本與無標記樣本中未知正例的空間結構相似度較低,無法有效地對無標記樣本的空間結構進行評估。在隨機選擇間諜樣本時,若大量的噪聲或離群點被選作間諜樣本,會極大地影響分類器對無標記樣本的評估,這種隨機選擇的機制直接導致了分類效率的降低。

因此,本文在算法SPYST的基礎上提出了一種結合改進的間諜技術與自訓練方法的PU學習算法ISPYST,有效地降低間諜樣本的隨機性帶來的分類誤差。ISPYST通過挖掘出初始正例樣本的空間分布信息來改進SPYST算法,在把握空間結構的基礎上計算正例樣本的聚類中心,并找出距離聚類中心較近的樣本作為間諜樣本。這些樣本在空間結構上離聚類中心更近,所包含正例樣本的真實信息量也更大,當這樣的樣本被選作間諜樣本時,更能有效地體現無標記樣本中未知正例的分布情況。在此,本文選用了簡單實用且收斂速度較快的K-Means聚類算法對初始正例進行聚類,K-Means算法的思想很簡單,對于給定的樣本集X,按照樣本之間的距離大小,將樣本集劃分為K個簇,讓簇內的點盡量緊密地連在一起,而讓簇間的距離盡量地大,將離聚類中心較近的正例樣本選作間諜樣本[16]。

2.2.2 ISPYST算法流程

ISPYST僅對SPYST算法流程的Step 1進行替換,即ISPYST通過找出初始正例集上離聚類中心較近的樣本代替傳統隨機選擇的間諜樣本,而SPYST其余步驟Step2至Step16不變,替換完成后形成新算法ISPYST。具體替換步驟如下:

3 仿真實驗與分析

3.1 實驗說明

為了驗證算法SPYST以及ISPYST的有效性,選用以下算法進行對比實驗:

1)基本PU學習算法(Basic PU-learning algorithm, Basic_PU)。

2)基于間諜技術的PU學習算法(SPY)[11]2600。

3)基于樸素貝葉斯的自訓練PU學習算法(Self-Training PU learning algorithm based on Naive Bayes, NBST)。

4)基于迭代剪枝的PU學習(iterative Pruning based PU learning, Pruning)[17]。

對比實驗所用數據集來自于UCI和Kaggle數據庫,總共選用9組二分類數據進行實驗說明,數據集名稱、規模以及屬性數見表1。

實驗過程中,把數據集隨機劃分成訓練集和測試集兩部分,其中訓練集占80%,測試集占20%。首先選出訓練集中20%的正例樣本作為初始有標記樣本,然后將剩余80%的正例樣本以及訓練集中全部的負例樣本除去標簽后作為無標記樣本集。所有算法重復實驗50次,以平均分類準確率以及F-值作為算法性能評價指標。

3.2 實驗結果及分析

為了證明本文算法較傳統間諜技術的分類性能有所提升,設置了如表2 所示的實驗。表2顯示了當初始有標記樣本占全部正例樣本的20%,且間諜樣本占初始正例的15%時,本文算法與傳統間諜技術的分類效果提升率。

由表2可知,改進后的算法SPYST對比傳統的間諜技術在進行PU學習的過程中整體上具有更好的分類性能。傳統的間諜技術在數據集Somerville Happiness Survey和Vertebral Column上分類效果極其異常,說明SPY根本無法在這樣的數據集上做PU分類。通過分析得知這兩組數據集初始分布不均勻,且其中包含大量噪聲和離群點,而SPY對噪聲和離群點異常敏感,且SPY在初始正例過少的情況下極難捕捉有效信息,導致了該方法分類效率低下。本文所提算法SPYST通過對SPY的分類結果做深度自訓練,不斷迭代提純可靠正例,從而取得了更高的分類效率。由于SPYST采用隨機選取間諜樣本的機制,導致分類結果存在一定的不穩定性,針對這一問題,本文提出了改進后的算法ISPYST,該方法基于初始正例的空間結構選取最具代表性的正例作間諜樣本,有效地減小了隨機性帶來的分類誤差,從而提高了分類效率。從表2可以看出,ISPYST的分類效果在SPYST的基礎上整體得到了進一步的提升。而在數據集Banknote authentication上,算法ISPYST的分類提升率相對低于算法SPYST,這是因為該數據集的數據分布過于集中,導致選出的間諜樣本結構極其相似,所含的樣本信息不能很好地對無標記樣本中的未知正例進行評估。因此,算法ISPYST在空間分布過于密集的數據集上還存在一定的局限性。為了進一步驗證本文所提算法SPYST與ISPYST的有效性,表3給出了當初始有標記樣本占全部正例樣本的20%,且間諜樣本占初始正例的15%時,本文算法與4組對比算法的實驗結果。

從表3可看出,當初始有標記樣本占全部正例樣本的20%時,本文所提算法SPYST與ISPYST整體性能均優于對比算法。在數據集Somerville Happiness Survey、Balance Scale、Vertebral Column以及Habermans Survival上有較好的體現,這主要是因為這四個數據集初始分布太差,對比算法易受噪聲干擾,無法有效地利用少量初始正例中的有用信息,導致分類誤判率過高;而SPYST通過對間諜技術的分類結果進行再次的精細化提純,得出了更好的分類效果;ISPYST在SPYST的基礎上對初始正例樣本的空間結構做深入剖析,選出更具代表性的間諜樣本,使得SPYST的分類效果得以進一步提升。在數據集Breast Cancer Wisconsin Prognostic(wdbc)和Electrical Grid Stability Simulated上,本文算法和對比算法分類效果整體相差不大,這是因為這兩組數據集原始分布較為均勻,沒有噪聲和離群點的干擾,本文算法在這樣的數據集上進行分類時,提升效果不明顯。

為了說明初始正例樣本占比對各個算法的影響,圖6通過逐步提高初始正例樣本的占比進行分類實驗,得出不同算法在初始樣本數量不同情況下的準確率。從圖6可看出,本文所提算法SPYST與ISPYST分類準確率整體上高于對比算法,尤其是在Wholesale customers、Somerville Happiness Survey、Vertebral Column、Habermans Survival、 pima以及Banknote authentication這6個數據集上,本文算法在初始正例占比極小的情況下相對于對比算法有較好的分類性能。這是因為SPYST對間諜技術的粗糙分類結果進行自訓練加工,能得到更高的分類準確率。此外,ISPYST將少量初始正例的空間結構清晰地展示出來,選出了最能體現無標記樣本中未知正例行為的樣本作為間諜樣本,解決了傳統間諜技術隨機選擇間諜樣本所帶來的分類誤差。而隨著初始正例占比的不斷增加,本文所提算法的分類優勢逐漸減弱,在數據集Breast Cancer Wisconsin Origina、Electrical Grid Stability Simulated、 pima以及Habermans Survival上表現得尤為明顯,這主要是因為在初始正例足夠多的情況下,樣本包含的有用信息更全面,所有算法都能有效地捕捉樣本信息,從而達到較好的分類效果。SPYST與ISPYST傾向于在初始正例極其缺失的情況下做PU學習,當初始正例較多的情況下,本文所提算法并不占優勢,甚至可能處于劣勢。在數據集Banknote authentication上,改進后的算法ISPYST比SPYST分類效果差,這是因為該數據集的原始數據分布過于密集,在找出離聚類中心較近的樣本作間諜樣本時,間諜樣本相互之間的區分度并不明顯,導致間諜樣本無法有效地提取無標記樣本中正例樣本的信息。算法ISPYST在空間分布過于密集的數據集上進行PU學習時會出現過擬合現象,降低了算法的分類性能。

4 結語

針對PU學習方法在初始正例過少的環境中難以有效地獲取樣本空間結構信息,且傳統間諜技術易受噪聲和離群點干擾,導致劃分可靠負例時效率不高、得出的可靠正例不純等問題,提出了兩種學習框架,即間諜技術結合自訓練的PU學習方法(SPYST)以及改進間諜技術后結合自訓練的PU學習方法(ISPYST)。SPYST通過對間諜技術的分類結果進行二次訓練,選取高置信度樣本加入已標記樣本集迭代自訓練,解決了部分樣本被誤標記的問題;ISPYST在SPYST的基礎上利用初始正例空間結構所包含的潛在信息,選出距離簇中心較近的樣本作為間諜樣本,這些間諜樣本更能體現正例的行為特征,從而有效地劃分出可靠正例與可靠負例。在9組標準數據集上的對比實驗證實了本文所提算法在僅含少量初始正例的環境中也能捕獲全面的數據分布信息,進而得出更好的分類效果。但本文算法在數據分布過于密集的數據集上還存在一定的局限性,因此,在后續工作中,將討論如何通過挖掘數據集原始分布特征來獲取有用信息,從而選出可靠負例來擴充初始有標記樣本集,進而提高PU學習的分類性能。

參考文獻(References)

[1] du PLESSIS M C, NIU G, SUGIYAMA M. Class-prior estimation for learning from positive and unlabeled data[J]. Machine Learning, 2017, 106(4): 463-492.

[2] SANSONE E, de NATALE F G B, ZHOU Z. Efficient training for positive unlabeled learning[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 38(7): 99-113.

[3] NIKDELFAZ O, JALILI S. Disease genes prediction by HMM based PU-learning using gene expression profiles[J]. Journal of Biomedical Informatics, 2018, 81: 102-111.

[4] FREY N C, WANG J, BELLIDO G I V, et al. Prediction of synthesis of 2D metal carbides and nitrides (MXenes) and their precursors with positive and unlabeled machine learning [J]. ACS Nano, 2019, 13(3): 3031-3041.

[5] 甘洪嘯. 基于PU學習和貝葉斯網的不確定數據分類研究[D]. 咸陽: 西北農林科技大學, 2017: 1-61. (GAN H X. Research on uncertain data classification based on PU learning and Bayesian network[D]. Xianyang: Northwest A & F University, 2017: 1-61.)

[6] WU Z, CAO J, WANG Y, et al. hPSD: a hybrid PU-learning-based spammer detection model for product reviews[J]. IEEE Transactions on Cybernetics, 2018(99): 1-12.

[7] VILLATORO-TELLO E, ANGUIANO E, MONTES-Y-GMEZ M, et al. Enhancing semi-supevised text classification using document summaries[C]// Proceedings of the 2016 Ibero-American Conference on Artificial Intelligence, LNCS 10022. Berlin: Springer, 2016: 115-126.

[8] HAN D, LI S, WEI F, et al. Two birds with one stone: classifying positive and unlabeled examples on uncertain data streams[J]. Neurocomputing, 2018, 277: 149-160.

[9] ZENG X, LIAO Y, LIU Y, et al. Prediction and validation of disease genes using HeteSim scores[J]. IEEE/ACM Transactions on Computational Biology and Bioinformatics, 2017, 14(3): 687-695.

[10] YU K, LIU Y, QIN L, et al. Positive and unlabeled learning for user behavior analysis based on mobile Internet traffic data[J]. IEEE Access, 2018, 6: 37568-37580.

[11] ZHANG Y, LI L, ZHOU J, et al. POSTER: a PU learning based system for potential malicious URL detection[C]// Proceedings of the 2017 ACM SIGSAC Conference on Computer and Communications Security. New York: ACM, 2017: 2599-2601.

[12] 張璞, 劉暢, 李逍. 基于PU學習的建議語句分類方法[J]. 計算機應用, 2019, 39(3): 639-643. (ZHANG P, LIU C, LI X. Suggestion sentence classification method based on PU learning[J]. Journal of Computer Applications, 2019, 39(3): 639-643.)

[13] JUN N L, QING S Z. Semi-Supervised self-training method based on an optimum-path forest[J]. IEEE Access, 2019, 7(1): 2169-3536.

[14] TANHA J, van SOMEREN M, AFSARMANESH H. Semi-supervised self-training for decision tree classifiers[J]. International Journal of Machine Learning & Cybernetics, 2017, 8(1): 355-370.

[15] 羅云松, 呂佳. 結合密度峰值優化模糊聚類的自訓練方法[J]. 重慶師范大學學報(自然科學版), 2019, 36(2): 96-102. (LUO Y S, LYU J. Self-training algorithm combined with density peak optimization fuzzy clustering[J]. Journal of Chongqing Normal University (Natural Science Edition), 2019, 36(2): 96-102.)

[16] CAP M, PREZ A, LOZANO J A. An efficient approximation to the K-means clustering for massive data[J]. Knowledge-Based Systems, 2017, 117: 56-69.

[17] FUSILIER D H, MONTES-Y-GMEZ M, ROSSO P, et al. Detecting positive and negative deceptive opinions using PU-learning[J]. Information Processing & Management, 2015, 51(4): 433-443.