CNN 實現的運動想象腦電分類及人-機器人交互*

程時偉,周桃春,唐智川,范 菁,孫凌云,朱安杰

1(浙江工業大學 計算機科學與技術學院,浙江 杭州 310023)

2(浙江工業大學 設計藝術學院,浙江 杭州 310023)

3(計算機輔助設計與圖形學國家重點實驗室(浙江大學),浙江 杭州 310058)

腦機接口(brain computer interface,簡稱 BCI)通過采集與提取大腦產生的腦電圖信號(electroencephalogram,簡稱EEG)來識別人的意圖,基于EEG 信號完成大腦與外部設備的信息傳遞與控制任務,進而恢復甚至增強人的身體運動和感知、認知能力[1].近年來,BCI 的相關研究得到了快速發展,但是,由于EEG 信號具有非平穩、非線性、低信噪比等特點[2],在預處理、特征提取、多模式分類等方面尚有諸多難題有待解決,從而導致可實際應用的BCI 系統較少.

通常,EEG 數據的處理和分析方法主要包括3 個步驟:(1)對EEG 數據進行預處理;(2)對預處理后的EEG數據進行特征提取;(3)最后對提取的特征向量進行分類.這類方法的主要局限在于,需要依靠研究人員的先驗知識進行復雜的數據預處理和特征提取,但在預處理過程中容易剔除可能隱含著有用特征的數據,而在特征提取過程中又容易忽略不同通道腦電信號間的關聯特性[2],這些都會降低分類結果的準確性和可靠性.而卷積神經網絡(convolutional neural network,簡稱CNN)融合了無監督學習和有監督學習的優點,對高維特征向量具有較強的分類能力,能從原始數據中學習到有利于分類的特征,減少了人為因素對特征選擇造成的主觀性和不完備性.

因此,為了針對EEG 信號進行便捷、精確的特征提取和分類,本文設計運動想象實驗,在大幅減少腦電電極數量(傳統方法需要64 個或更多電極,本文只采用14 個電極)、同時增加運動想象分類任務(傳統方法多數只支持2 或3 分類,本文支持左手、右手、腳和靜息態的4 分類)的情況下,提取被試用戶的EEG 數據,并采用CNN方法進行數據的特征學習與分類,結果表明,本文方法比已有運動想象分類算法具有更高的識別率.進而,基于本文方法設計與開發了一個基于BCI 的人-機器人交互系統,實驗結果表明,該原型系統能快速且準確地判斷出用戶的運動想象指令,控制機器人完成相應的動作,進一步驗證了本文方法的實用性.

1 相關工作

近年來,國內外學者提出的EEG 信號特征提取方法主要包括3 類:(1)基于時域分析的方法,如采用均值、方差、概率密度函數等[1];(2)基于頻域分析的方法,如Pfurtscheller[3,4]提出的基于mu 節律的頻域分析方法并應用在運動想象任務中、Zhou 等人[4]將小波包分解(wavelet packet decomposition,簡稱WPT)和獨立成分分析(independent component analysis,簡稱ICA)應用在運動想象數據特征提取中;(3)基于空域分析的方法,如Samek等人[5]提出將共空間模式(common spatial pattern,簡稱CSP)應用在腦機接口中.另一方面,也可采用機器學習的方法,如孫會文等人[6]使用支持向量機(support vector machine,簡稱SVM)方法對經過希爾伯特黃變換(Hilbert-Huang transform,簡稱HHT)的EEG 數據進行分類;張毅等人[7]使用自回歸模型(autoregressive model,簡稱AR)對特征提取后的EEG 信號進行分類;劉伯強等人[8]使用神經網絡的反向傳播(back propagation,簡稱BP)算法進行EEG 數據分類.

CNN 是一種帶有卷積結構的深度神經網絡,卷積結構可以利用空間結構關系,減少需要學習的參數數量,從而提高反向傳播算法的訓練效率,不僅可以防止過擬合,還能降低神經網絡的復雜度[9].LeCun 等人[10]采用神經網絡誤差反向傳播算法進行手寫數字的識別,在網絡結構設計中加入下采樣與權值共享,大幅減少了神經網絡的參數量.此外,為了盡量保證數據的平移、尺度、畸變不變性,LeCun 等人[11]設計了局部感受野和共享權重,提出用于字符識別的卷積神經網絡LeNet-5,在銀行的手寫數字識別系統中取得了較好的結果.近年來,CNN 也被應用于EEG 信號的特征提取和分析.例如,Hubert 等人[12]基于CNN 對腦電事件相關電位(event-related potential,簡稱ERP)中的 P300 成分進行分類識別,實現字符拼寫,并在 BCI 競賽的公共數據集(http://www.bbci.de/competition/iii/)上進行實驗,結果表明,其識別率最高可以達到95.5%;蔡邦宇[13]使用CNN 模型對視覺誘發電位(visual evoked potential,簡稱VEP)進行時域和空域特征分析,結果表明,平均受試者工作特征(receiver operating characteristic,簡稱ROC)曲線面積比SVM 方法提高了4.4%;唐智川等人[14]基于CNN 對左手和腳的運動想象腦電信號進行分類識別,平均識別率為88.75%±3.42%,并將其應用到基于BCI 的外骨骼應用原型系統中;王衛星等人[15]基于CNN 進行左、右手二分類動作和單手的3 分類動作識別,識別精度比原有方法分別提高了4%和8%.

上述相關研究驗證了CNN 方法在腦電信號處理中應用的可行性,但鮮有研究能在有效減少腦電電極數目的同時,還能對4 個及以上的運動想象分類問題進行精確的識別,并最終設計與開發出相應的BCI 原型應用系統,實現精確的人-機器人實時交互.

2 基于CNN 的腦電信號分類方法

2.1 腦電信號采集

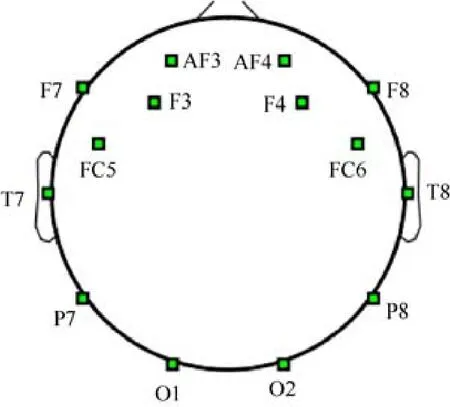

腦電信號的采集采用10-20 國際標準導聯放置[1],將鼻根和枕外粗隆相連接,在冠狀位把鼻根、外耳孔和枕狀粗隆相連接,中點為頭頂(即Cz).通過Cz 將兩個連線各分為2 個10%和4 個20%的距離.本文采用Emotiv System 公司(http://www.pstnet.com/eprime.cfm)的Emotiv EPOC 腦電儀,其包含14 個電極(如圖1 所示),采樣頻率為128Hz.

Fig.1 Electrodes configuration of Emotiv EPOC圖1 Emotiv EPOC 腦電儀的電極位置分布

2.2 腦電實驗范式

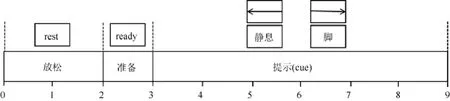

在實驗過程中采用如圖2 所示的實驗范式[16].

本文招募了7 名被試用戶(5 男2 女,年齡在24 歲~27 歲之間)進行實驗,實驗對象均是右利手,并且均是第1次參加本文中的腦電實驗.每個被試用戶需要完成560 次基于提示的實驗,每次實驗持續9s 時間,前2s 屏幕顯示“rest”字,用戶休息放松,之后在屏幕中央出現一個“十”字,提示被試用戶實驗即將開始;從4s~8s,屏幕上的“十”字變為隨機產生的想象左手、想象右手、想象腳和靜息狀態的提示.為了保持提示呈現后同步獲得相應的腦電信號,實驗范式程序采用Eprime 實現,在每次實驗開始時,向腦電儀發送一個marker 標記信號,并在實驗結束后進行離線數據分析時,根據marker 來分割相關腦電數據.此外,為了防止被試用戶產生疲勞,影響運動想象腦電實驗的效果,被試用戶每進行20 次實驗后就休息3 分鐘.此外,為了防止被試用戶在運動想象過程中產生實際的肢體動作,影響腦電數據質量,在正式實驗之前對被試用戶進行了運動想象訓練,并在正式實驗過程中剔除了產生實際肢體動作的實驗數據.

Fig.2 MI experimental paradigm圖2 運動想象實驗范式

2.3 卷積神經網絡結構

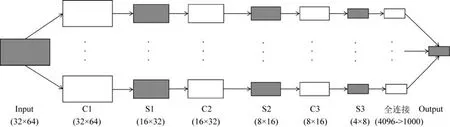

本文設計的用于運動想象腦電數據處理的卷積神經網絡如圖3 所示,包括1 個輸入層(input 層)、3 個卷積層(C1、C2、C3 層)、3 個池化層(S1、S2、S3 層)和1 個輸出層(output 層).

Fig.3 CNN structure for MI EEG data analysis圖3 用于運動想象腦電數據分析的卷積神經網絡結構

2.3.1 卷積層構造

卷積層主要進行特征提取,采用線性濾波器和非線性激活函數.具體地,對輸入數據應用多個濾波器,并用一個輸入參數進行多個類型的特征提取.基于上一層的輸入,采用以下公式來提取下一層的特征:

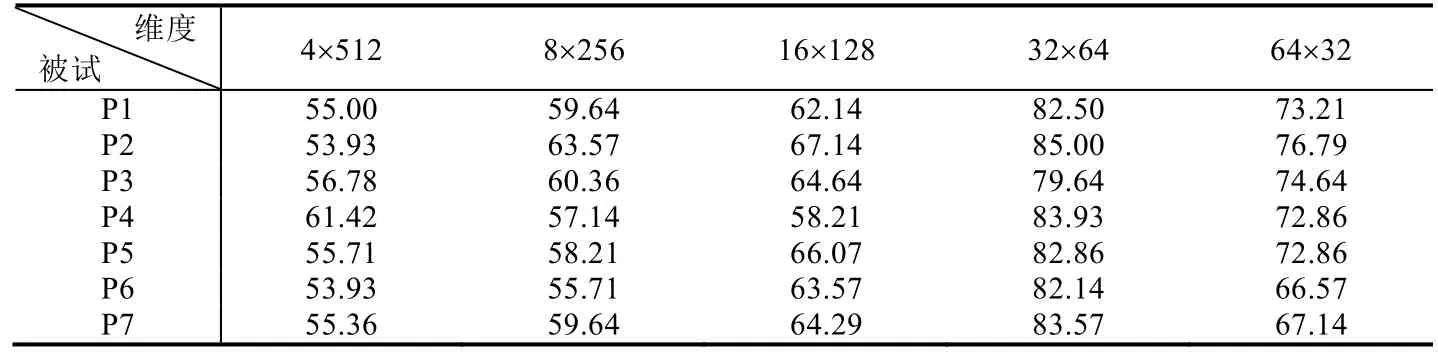

在本文中,輸入數據為F3、F4、FC5 和FC6 通道的腦電數據,數據維度為4×512.通常,CNN 模型處理腦電數據的輸入數據格式為通道數×時間點,本文初期研究通過上述數據格式進行神經網絡構建與優化,但效果不佳,見表1,平均分類識別率只能達到50%左右.為此,本文作了進一步改進,考慮到卷積神經網絡對圖像數據分析具有較好的識別效果,并在處理塊狀數據時具有更大優勢,所以本文對運動想象數據也采用類似圖像的分塊處理.表1 所示,對不同的數據輸入維度進行實驗,結果表明,在4 種分類狀態下,32×64 的分塊輸入方式的平均分類識別率最高.因此,本文將原輸入數據的維度設置為32×64.

進一步地,建立起本文的卷積層結構:C1 層,輸入3 個通道,輸入維度為32×64,輸出32 個通道;C2 層,輸入32個通道,輸入維度為16×32,輸出64 個通道;C3 層,輸入64 個通道,輸入維度為8×16,輸出128 個通道.在卷積層中,步長為1,為了保證數據是完整、有效的信息,使用寬卷積,所以,卷積層的輸出維度不變,并使用dropout 防止數據的過擬合,同時采用ReLu 代替傳統神經網絡中的tanh 和sigmod 函數,加快網絡訓練速度.

Table 1 Average accuracy of classification under different input dimensions (%)表1 不同腦電輸入維度的平均分類識別率對比(%)

2.3.2 池化層構造

池化層(pooling layer)也稱為子采樣層(subsample layer),用于縮減數據的規模,同時保持特征的局部不變性.實現子采樣的方法有很多種,最常見的是最大值合并、平均值合并及隨機合并.本文使用平均值合并進行子采樣,公式如下:

在本文中,池化層的輸入是同一網絡層中卷積層的輸出:S1 層,輸入維度為32×64,輸出維度為16×32;S2 層,輸入維度為16×32,輸出維度為8×16;S3 層,輸入維度為8×16,輸出維度為4×8.在上述池化層中,步長為2,子采樣為2×2,所以,輸出的兩個維度同時減半.為了保證數據的完整、有效性,使用寬卷積,同時采用ReLu加快網絡訓練速度.

2.3.3 全連接層構造

將經過多層卷積和池化的運動想象EEG 二維數據的特征圖拼接為一維特征作為全連接網絡的輸入.全連接層l的輸出可通過對輸入加權求和并通過激活函數的響應得到,公式如下:

3 實驗結果與分析

3.1 CNN參數設置

參數設置對CNN 模型的效果影響很大.下面對本文CNN 模型的參數設置進行詳細闡述.

(1)批大小(batchsize):在深度學習中,一般采用隨機梯度下降(stochastic gradient descent,簡稱SGD),即每次在訓練集中獲取batchsize 個樣本進行訓練.當數據集和計算量不大時,batchsize 采用全數據集,其有兩個優點:第一,由全數據集確定的方向能夠更好地代表樣本總體,從而更準確地朝向極值所在的方向;第二,全數據集可以使用彈性傳播(resilient propagation,簡稱Rprop)算法[17],基于梯度符號并且有針對性的單獨更新各權值,解決了多批次模型訓練中,各批次訓練權重的梯度值差別較大,選取一個全局的學習速率困難的問題.但是,對于較大的數據集合,上述優點卻變成了缺點:第一,隨著數據集和計算量的增大以及內存的限制,一次載入所有數據的可行性較低;第二,如果以Rprop 方式迭代,由于各個batch 之間的采樣差異性,各批次梯度修正值將相互抵消,無法實現修正效果,所以需要采用均方根傳播(root mean square propagation,簡稱RMSProp)算法[18].考慮內存的利用率和訓練完一次全數據集的迭代次數[19],結合實驗經驗,本文的batch size 取值為8,即每次取8 個樣本進行訓練.

(2)學習速率:運用梯度下降算法進行優化,在權重更新時,學習速率就是梯度項前的系數.根據Bengio[20]對梯度訓練的總結,如果學習速率太小,則收斂過慢;如果學習速率太大,則會導致代價函數震蕩.本文基于Bengio提出的方法,對學習速率賦一個缺省值,取0.01,結果發現,代價函數產生震蕩,所以對學習速率進行調整,設為0.001,最終提高了識別率.

(3)權重和偏置:根據LeCun 等人[21]提出的權重和偏置參數調試建議,初始化時使用截斷正態分布,加入輕微噪聲,打破對稱性,防止零梯度問題,本文中設置正態分布標準差為0.1.

(4)dropout:這是指在深度學習網絡的訓練過程中,對于神經網絡單元,按照一定概率將其暫時從網絡中丟棄.Hintion 提出dropout 方法[22],在訓練模型時隨機地讓某些隱含節點的權重不工作,這些節點暫時可以認為不是網絡結構的一部分,但是它們的權重得以保留下來(暫時不更新),下次樣本輸入時可能重新工作.由于本文的數據樣本相對較少,為了防止在訓練模型時出現過擬合,采用dropout 方法.本文在訓練時卷積層和池化層的dropout 采用0.8,全連接層的dropout 采用0.5;在測試時,dropout 都為1,更新所有權重.實驗發現,在同樣迭代次數下,采用dropout 測試樣本的錯誤率明顯低于沒采用dropout 的測試樣本.

3.2 實驗結果與分析

實驗采集了7 個被試用戶(用P1~P7 表示)的腦電數據,每個被試采集560 次數據,為了得到可靠穩定的模型,通過交叉驗證(cross-validation)方法分離出50%的訓練樣本和50%的測試樣本.權重使用截斷正態分布,標準差為0.1,學習率為0.001.訓練時卷積層和池化層的dropout 采用0.8,全連接層的dropout 采用0.5,在測試時,dropout都為1,腦電數據的輸入層維度為32×64.

分類問題需要對分類結果進行評價,評價指標一般包括識別率(accuracy)、精確率(precision)、召回率(recall rate)和F-score,通過這些評價指標對分類模型的效果進行評估[14].4 個評價指標的定義分別如下.

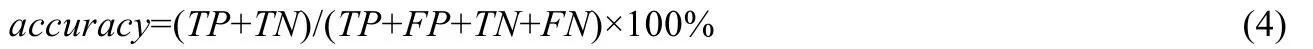

(1)識別率:對于總的測試數據集,通過訓練數據訓練的最優分類器對測試數據正確分類的樣本數與總樣本數之比:

其中,TP為真陽性,TN為真陰性,FP為假陽性,FN為假陰性.

(2)精確率:測試數據集中分類為真實正例樣本數與分類為正例樣本數之比:

(3)召回率:分類為真實正例的樣本數與所有真實正例的樣本數之比:

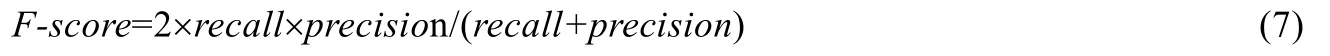

(4)F-score:這是識別率的延伸,結合了精確率和召回率,具體計算如下:

本文從網絡層數和時間序列兩個方面對實驗結果進行分析,具體闡述如下.

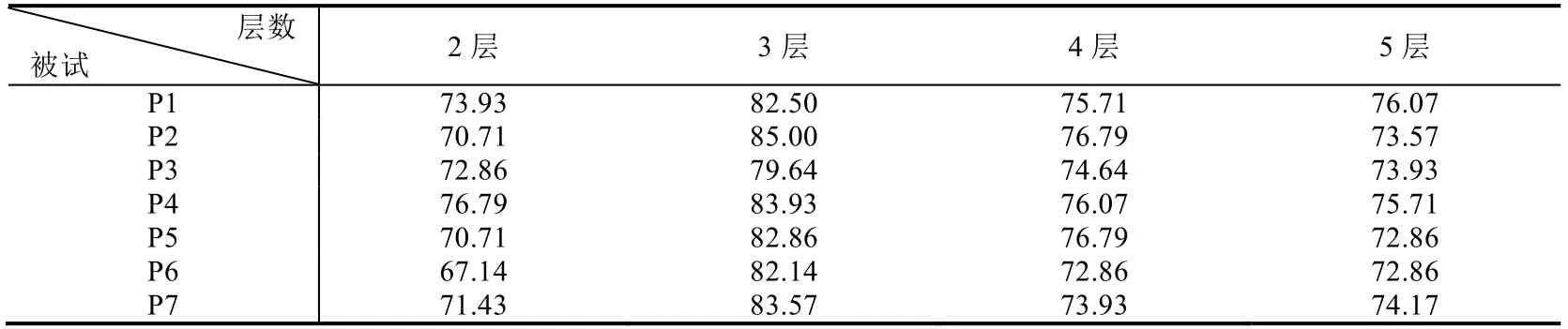

(1)基于網絡結構層數的結果分析

針對每個被試用戶,分別構建不同層數的卷積神經網絡,從而找到最好分類效果的卷積神經網絡結構.受篇幅限制,這里沒有列出所有不同層數的分類結果.表2 是在相同條件下(4 種分類),分別構建2~5 層卷積和池化結構的訓練測試結果.可見,3 層的實驗結果比其他層數的平均分類識別率更高,因此本文采用3 層卷積和池化網絡結構.

Table 2 Average accuracy of classification with different convolution and pooling layers (%)表2 不同卷積層和池化層CNN 模型的平均分類識別率對比(%)

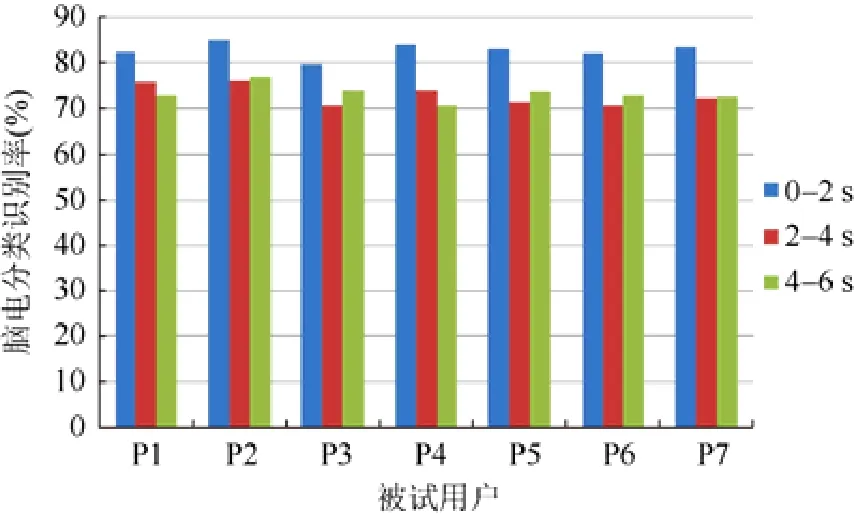

(2)基于時間序列的結果分析

將運動想象的腦電實驗數據按時間段劃分,每段時長2s,作為輸入數據.圖4 顯示了在0~6s 的3 個時間段中,被試用戶的平均分類識別率.

Fig.4 Classification results analysis based on temporal sequence圖4 基于時間序列的分類結果分析

從圖4 可以看出,前2s(第0~第2s)腦電數據的平均分類識別率達到最高,而最后4s(第2s~第6s)腦電的數據平均分類識別率較低,說明在實驗開始時,被試用戶專注于運動想象實驗,但是隨著時間的推移,被試用戶精神集中度降低,影響了腦電數據的質量,最終導致識別率降低.

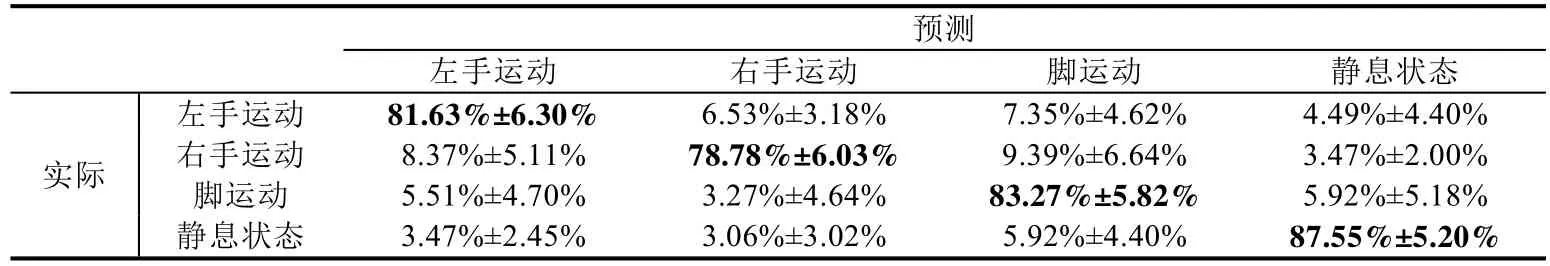

因此,根據上述分析結果,選擇原始輸入數據維度為32×64,卷積和池化3 層網絡,選擇運動想象開始后0~2s的腦電數據進行分類預測.相關分類結果見表3,對角線單元格內數值表示所有被試想象左手、右手、腳運動和靜息狀態時,其EEG 信號被正確識別為相應類別的平均識別率(precision)和標準差.另外,非對角線單元格內的數值表示EEG 信號被錯誤識別為其他類別的平均識別率和標準差.

Table 3 Confusion matrix of EEG classification results表3 腦電分類平均預測結果的混淆矩陣

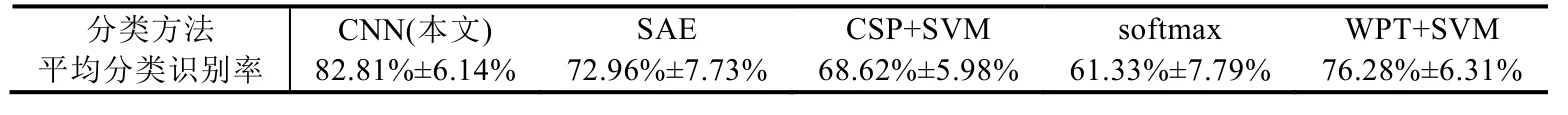

此外,為了進一步驗證本文方法的先進性,使用相同的實驗數據,采用4 種已有方法(SAE、CSP+SVM、softmax 和WPT+SVM)與本文方法進行對比.這4 種方法都需要先對腦電數據進行預處理,包括去除眼電偽跡、濾波等,再經過特征提取,最后用分類器進行分類.與已有方法相比,本文基于CNN 方法的平均分類識別率最高,結果見表4.

Table 4 Average accuracy of classification with different approaches表4 各種分類方法的平均識別率對比

4 應用實例

4.1 原型系統框架設計

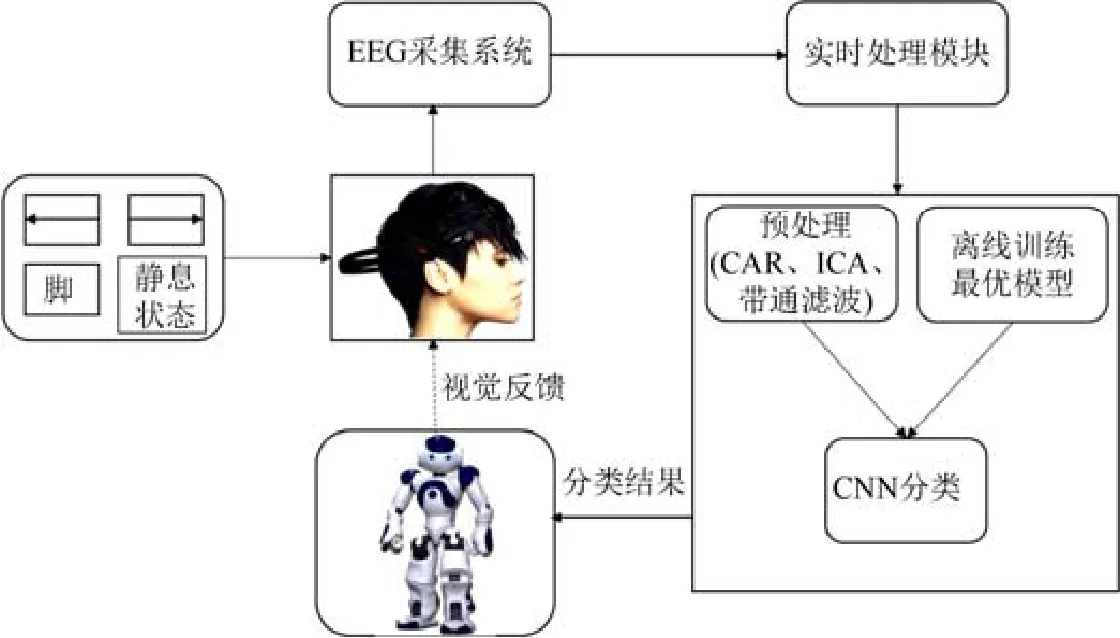

本文基于運動想象的人-機器人交互應用場景如圖5 所示,被試用戶要求坐在屏幕前,左、右手和身體保持自然的放松姿勢,并且佩戴好Emotiv 腦電儀,固定好電極位置(參考電極為P3 和P4,采樣頻率為128Hz),確保能夠正常采集腦電信號.本文使用NAO(https://www.softbankrobotics.com/emea/en/robots/nao)仿人機器人,放在被試用戶正前方位置.

每個被試用戶需要完成560 次基于方向箭頭和文字等視覺提示(cue)的實驗,其中,想象左手運動、右手運動、腳運動和靜息狀態(不作任何運動想象)各140 次,每次實驗之間有3s 的時間間隔,每完成20 次實驗之后休息5 分鐘,防止被試用戶過于疲勞影響實驗結果.如圖6 所示,在單次運動想象結束后,采用本文前述訓練出來的分類模型進行實時分類,NAO 機器人根據分類結果產生相應的動作.例如,用戶進行左手運動想象,如果分類算法正確識別為左手運動,NAO 機器人則抬起左手.類似地,右手的運動想象對應于NAO 機器人抬起右手;腳的運動想象對應于NAO 機器人向前走動;靜息態對應于NAO 機器人保持靜止,且播放語音“你現在很安靜”.此外,為了防止被試用戶在運動想象過程中產生實際的肢體動作,影響腦電數據質量,與第2.2 節的處理方法一樣,對被試用戶進行了訓練,并剔除了無效數據.

Fig.6 The mapping bettwen MI classification results and robot actions圖6 運動想象分類結果與機器人交互動作的映射關系

該系統的框架如圖7 所示,被試用戶根據屏幕上隨機出現的向左、向右箭頭,以及“腳”和“靜息”的文字開始進行運動想象.當被試用戶開始進行運動想象時,Emotiv 開始采集腦電數據,通過TCP/IP 協議將獲取的腦電數據發送給系統主機進行預處理,然后利用前文訓練的分類模型對腦電數據進行分類,再將分類結果轉換為控制命令,并通過TCP/IP 發送給NAO 機器人,驅動機器人的電機和揚聲器等組件完成相應的操作.同時,在屏幕上給出分類結果的視覺反饋(如“向左”這樣的文字).

Fig.7 Framework of the prototype system圖7 原型系統框架

4.2 原型系統開發與實驗

4.2.1 系統功能

原型系統主要包括腦電數據采集、腦電數據分析和機器人控制這3 個主要功能模塊,采用Python 編程語言實現.(1)腦電數據采集模塊:主要采集和分發系統所需的腦電數據,基于 socket 實現,開發工具包采用pycharm;(2)數據分析模塊:主要進行原始數據的預處理、數據訓練以及分類模型的求解和存儲,其中的數值分析采用Python 的科學計算工具包numpy,并采用了keras 和Tensorflow 框架進行分類算法的開發;(3)機器人控制模塊:主要接收數據分析模塊輸出的分類結果,并對NAO 機器人進行相應的控制,具體開發采用NAO 的pynaoqi-python SDK 開發包.此外,系統圖形用戶界面的開發基于Python GUI 的Tkiner 編程工具,它可以良好地運行在絕大多數平臺上,實現跨平臺的效果.

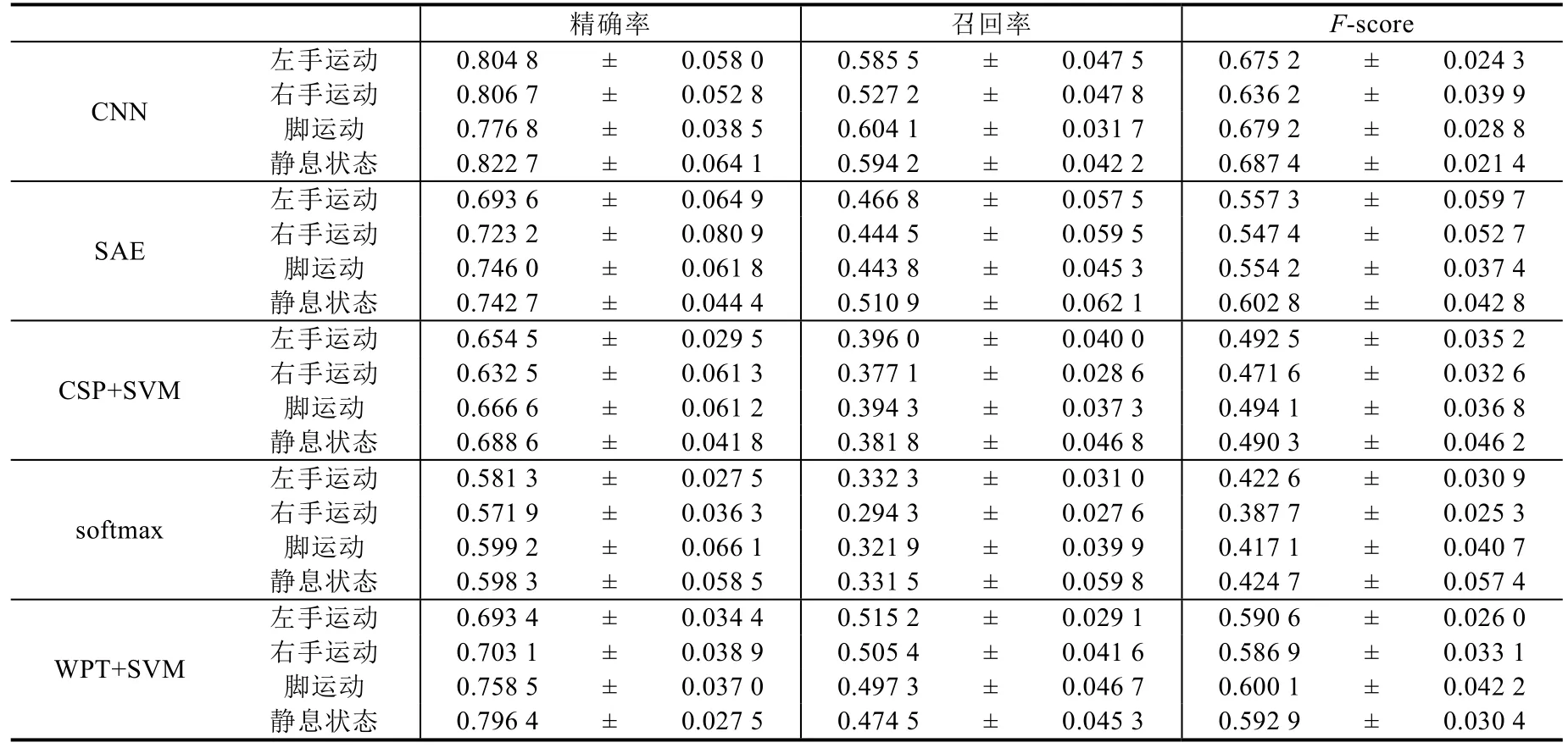

4.2.2 實驗結果分析

在用戶與機器人的交互過程中,針對4 類運動想象的精確率、召回率和F-score 這3 個評估指標進行分析和對比,見表5.采用分類方法×運動想象類別的方差分析(ANOVA)評估兩者對分類結果的影響.置信水平為95%.ANOVA 結果顯示,分類方法對分類結果具有顯著影響(p<0.05),而運動想象的類別則對分類結果不具有顯著影響(p>0.05).進一步地,采用Tukey Post Hoc 檢驗對分類方法進行兩兩比較,本文基于CNN 模型分類方法的3 個指標(精確率、召回率和F-score)與其他4 種方法相比均具有顯著差異性(p<0.05),且本文3 個指標的值更大,因此,本文方法具有更好的指標性能,進一步驗證了其在實際交互應用中的有效性和先進性.

4.2.3 討 論

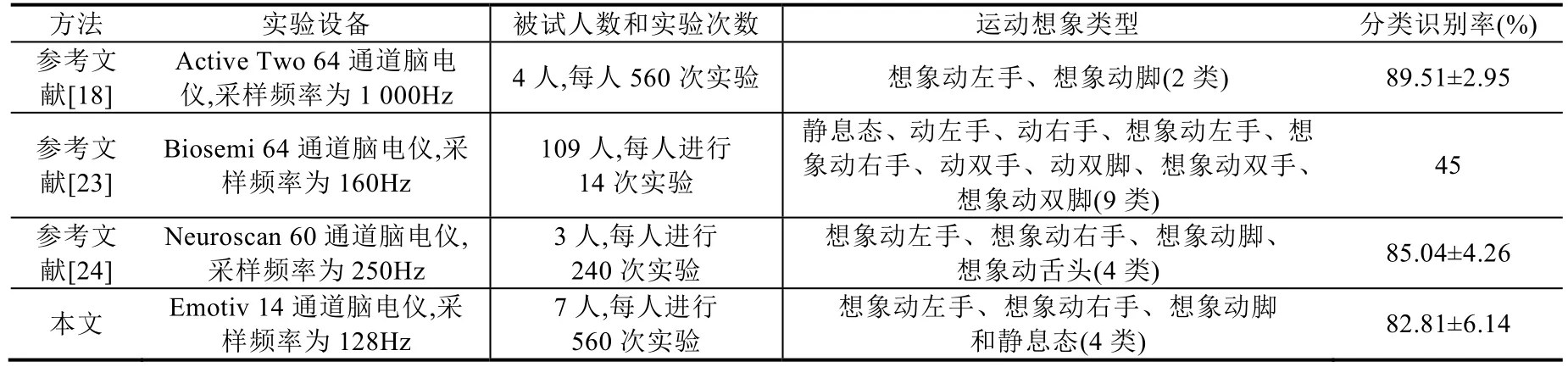

如表6 所示,進一步將本文方法與已有文獻的方法進行了對比(由于已有文獻沒有進行與機器人交互等應用的在線測試,故此處只取本文第3 節的結果進行對比).分析發現,參考文獻[18]采用了64 通道、1 000Hz 采樣頻率的Active Two 腦電儀采集腦電信號,并使用CNN 對想象左手和想象腳進行分類,最終所有被試用戶的平均識別率(accuracy)達到89.51%±2.95%;參考文獻[24]采用60 通道、采樣頻率為250Hz 的Neuroscan 腦電儀,使用CNN 方法對4 類運動想象信號進行分類,最終分類識別率達到85.04%±4.26%.雖然這兩項研究比本文的平均識別率稍高,但腦電信號采集通道數目是本文的4 倍左右(本文通道數只有14 通道),而本文實驗操作方便且設備價格便宜.此外,參考文獻[18]的分類數目只有2 類,而本文有4 類.類似地,參考文獻[23]采用了64 通道、160Hz采樣頻率的Biosemi 腦電儀,使用CNN 對9 類運動想象進行分類,但效果不佳,平均分類識別率只有45%.

基于上述分析,從肢體障礙患者使用的便攜性、運動想象分類數目、分類識別率、設備價格和實驗過程復雜度等方面進行了綜合考慮,分析結果表明,本文方法具有更好的實用性和可行性.

Table 5 Precision,recall rate and F-score of MI classification with different approaches across all subjects表5 所有被試用戶在不同方法下運動想象分類的精確率、召回率和F-score

Table 6 Comparison between proposed approach of this paper and others表6 本文方法與已有文獻的對比

進一步地,與其他分類方法(SAE、CSP+SVM、softmax 和WPT+SVM)相比較,本文采用的CNN 方法雖然在識別率上具有一定的優勢,但也存在一些不足:(1)由于CNN 網絡的復雜性以及需要調用較多的參數,需要使用較大的數據集進行訓練,否則容易導致過擬合,因此本文對每個被試用戶進行了560 次實驗,而這容易導致被試用戶產生疲勞,從而會影響實驗效果.(2)計算成本較高,因為模型訓練需要耗費較多時間、調參過程較復雜等.所以,本文方法在實際應用中還應該進一步提高模型訓練效率,簡化計算過程,改善用戶體驗感受.

5 結論與展望

本文將CNN 用于運動想象腦電信號的分類識別,相關實驗結果表明了本文方法能夠從原始腦電數據中自動學習特征,并能對4 種運動想象狀態進行較精確的分類,平均分類識別率達到了82.81%.

此外,本文也存在一定的局限性,下一步將從以下幾個方面繼續開展研究:(1)完善腦電實驗范式,采集更復雜的腦電數據,將CNN 模型用于識別更復雜的腦電信號;(2)進一步優化CNN 的網絡結構,調整合適參數,并結合其他深度學習方法,如深度置信網絡(deep belief network,簡稱DBN)來進一步提高分類識別率;(3)面對實際應用中日益涌現的海量、復雜腦電數據,考慮使用spark 架構實現分布式處理,進一步提高腦機交互應用的實時性.