基于深度學(xué)習(xí)的開放存取資源分類研究

邱 盼

(貴州財(cái)經(jīng)大學(xué),貴陽(yáng) 550000)

1 引言

隨著開放存取資源運(yùn)動(dòng)的迅速發(fā)展,開放存取資源逐漸成為建設(shè)數(shù)字圖書館不可或缺的數(shù)據(jù)源。其開放獲取模式也為研究者提供了獲取學(xué)術(shù)論文的新途徑,有效促進(jìn)了學(xué)術(shù)資源的共享。為了促進(jìn)科學(xué)信息的廣泛傳播,學(xué)術(shù)信息的交流與發(fā)布,提高科學(xué)研究的程度,確保科學(xué)信息的長(zhǎng)期保存。

近年來(lái),深度學(xué)習(xí)作為機(jī)器學(xué)習(xí)的另一個(gè)分支,得到了廣泛的研究和應(yīng)用。 它通過使用由復(fù)雜結(jié)構(gòu)或多個(gè)隱藏層感知器組成的多個(gè)處理層來(lái)替換具有高級(jí)數(shù)據(jù)抽象的手冊(cè)。在文本分類任務(wù)中,基于文本分布式詞向量表示的深度學(xué)習(xí)方法,卷積神經(jīng)網(wǎng)絡(luò),循環(huán)神經(jīng)網(wǎng)絡(luò)等深度學(xué)習(xí)模型對(duì)文本進(jìn)行分類可以獲得更高的準(zhǔn)確率。

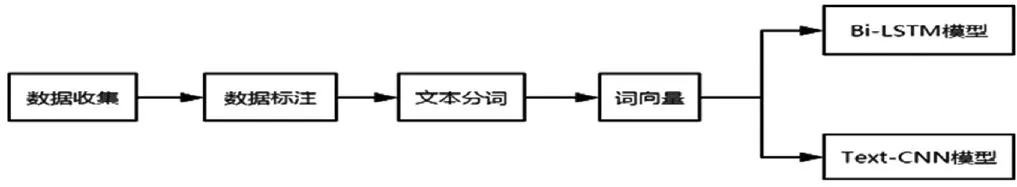

本文將重點(diǎn)介紹基于深度學(xué)習(xí)的開放存取資源分類過程和Bi-LSTM 模型和Text-CNN 模型。

2 開放存取資源文本分類實(shí)現(xiàn)

圖1

2.1 數(shù)據(jù)收集

現(xiàn)在的開放存取資源有多個(gè)平臺(tái),本文選擇Worldlib 獲取數(shù)據(jù),worldlib 國(guó)外文獻(xiàn)整合平臺(tái)整合了國(guó)外各種開放數(shù)據(jù),文獻(xiàn)數(shù)量近千萬(wàn)篇,以英語(yǔ)為主,學(xué)科覆蓋范圍為全學(xué)科。本文采用python 爬蟲來(lái)獲取開放存取資源。Python 爬蟲相對(duì)Java,C++是比較簡(jiǎn)單易上手的。

2.2 數(shù)據(jù)標(biāo)注

數(shù)據(jù)標(biāo)注意味著人們判斷和標(biāo)注數(shù)據(jù)集內(nèi)的每一條數(shù)據(jù)根據(jù)數(shù)據(jù)分類規(guī)則,找到預(yù)測(cè)的目的目標(biāo)y。標(biāo)注的主要原因是基于深度學(xué)習(xí)的訓(xùn)練和測(cè)試過程需要使用帶安全標(biāo)注的數(shù)據(jù)。在訓(xùn)練過程中,需要將訓(xùn)練集的數(shù)據(jù)和數(shù)據(jù)類別作為學(xué)習(xí)材料,供計(jì)算機(jī)學(xué)習(xí)、處理和構(gòu)造神經(jīng)網(wǎng)絡(luò)模型中的意義。測(cè)試過程相當(dāng)于測(cè)試,數(shù)據(jù)分類是測(cè)試的答案,為了研究計(jì)算機(jī)的影響進(jìn)行深度研究,需要輸入電腦不帶安全標(biāo)注的數(shù)據(jù)時(shí),計(jì)算機(jī)自動(dòng)輸出數(shù)據(jù)的分類結(jié)果,計(jì)算機(jī)的輸出結(jié)果與答案相比,可以計(jì)算學(xué)習(xí)模型的準(zhǔn)確性,因此,數(shù)據(jù)集的所有數(shù)據(jù)必須在類別標(biāo)注中。一般來(lái)說(shuō),數(shù)據(jù)標(biāo)注越準(zhǔn)確,數(shù)據(jù)量越大,訓(xùn)練模型越好。

2.3 文本分詞

在開放存取資源文本分類之前,我們要先開始對(duì)資源進(jìn)行預(yù)處理,一般主要包含文本分詞和進(jìn)行大量的詞向量訓(xùn)練。本研究為了更好地進(jìn)行分詞,提升分詞的準(zhǔn)確性,構(gòu)建了開放存取資源語(yǔ)料庫(kù)。由于本文的開放存取資源主要是英文,因此對(duì)于英文的數(shù)據(jù)預(yù)處理要做的工作主要是按照關(guān)鍵字分詞。

2.4 詞向量

自然語(yǔ)言模型訓(xùn)練的產(chǎn)物,我們通常叫做詞向量,而詞匯由固定長(zhǎng)度的向量來(lái)表示,通過大量收集的相關(guān)詞匯訓(xùn)練,最終形成一個(gè)詞向量空間,而在空間中的每個(gè)點(diǎn)則代表一個(gè)詞匯。計(jì)算機(jī)通過大量的對(duì)開放存取資源的詞向量訓(xùn)練,可以對(duì)資源進(jìn)行分類識(shí)別,最終達(dá)到文本的可計(jì)算性。在對(duì)開放存取資源進(jìn)行模型訓(xùn)練時(shí),如果沒有指定與之相對(duì)應(yīng)的詞向量,自然語(yǔ)言模型則會(huì)選擇對(duì)開放存取資源詞匯進(jìn)行相對(duì)的詞向量訓(xùn)練,這是屬于隨機(jī)初始化的word2evc 向量,這個(gè)詞向量方法在深度學(xué)習(xí)領(lǐng)域中是常用的,在其他領(lǐng)域中也可以運(yùn)用的到。

3 深度學(xué)習(xí)文本分類模型

目前常用的文本分類模型有很多種,特征提取的好壞直接影響到分類的效果,因此基于傳統(tǒng)分類模型的文本分類方法的工作重點(diǎn)主要集中在特征提取和選擇上,常用方法有 TF-IDF、詞頻、文檔頻次、N-Gram、互信息等。

隨著深度學(xué)習(xí)的不斷發(fā)展,學(xué)者們將文本分類的研究重點(diǎn)轉(zhuǎn)向了基于人工神經(jīng)網(wǎng)絡(luò)的分類模型。人工神經(jīng)網(wǎng)絡(luò)是模擬生物神經(jīng)網(wǎng)絡(luò)進(jìn)行信息處理的數(shù)學(xué)模型。人工神經(jīng)網(wǎng)絡(luò)由多個(gè)連接權(quán)值可調(diào)的神經(jīng)元組成。其參數(shù)學(xué)習(xí)基于BP 算法,具有較強(qiáng)的非線性映射能力。神經(jīng)網(wǎng)絡(luò)處理文本分類的優(yōu)點(diǎn)之一,而不必花大量的時(shí)間在特征提取和選擇,將分布式說(shuō)這個(gè)詞作為特征輸入到網(wǎng)絡(luò),神經(jīng)網(wǎng)絡(luò)可以自動(dòng)提取文本分類的有價(jià)值的信息,這些信息通常是通過卷積,點(diǎn),非線性函數(shù),矩陣乘法操作等,和高度的信息編碼并不容易解釋。

隨著深度學(xué)習(xí)研究范圍的擴(kuò)大,在很多領(lǐng)域中我們會(huì)發(fā)現(xiàn),在常見的圖像、音頻處理方面,我們也會(huì)經(jīng)常運(yùn)用到深度學(xué)習(xí)方面的知識(shí)。由于本研究是針對(duì)開放存取資源進(jìn)行的研究,屬于自然語(yǔ)言處理領(lǐng)域,因此,本文通過對(duì)自然語(yǔ)言處理相關(guān)的神經(jīng)網(wǎng)絡(luò)模型進(jìn)行研究,選取Bi-LSTM 模型和Text-CNN 模型作為處理開放存取資源的深度學(xué)習(xí)模型。

3.1 Bi-LSTM 模型

(1)embedding 層

利戴工業(yè)技術(shù)服務(wù)(上海)有限公司客戶項(xiàng)目經(jīng)理趙慶山先生也以“智能工廠的整體解決方案”為題,介紹了工業(yè)服務(wù)體系在智能制造發(fā)展過程中扮演的角色及地位,同時(shí)也分享了其在上汽大眾動(dòng)力總成有限公司等典型項(xiàng)目案例。這些項(xiàng)目不僅包括了加工設(shè)備的安裝調(diào)試和維護(hù)保養(yǎng),同時(shí)也涉及了智能制造的落地,為推動(dòng)企業(yè)轉(zhuǎn)型升級(jí)發(fā)揮了積極作用。

該層,作為神經(jīng)網(wǎng)絡(luò)的第一層,它用作尋找輸入數(shù)據(jù)中的所有詞匯,并根據(jù)詞匯找到與其對(duì)應(yīng)的詞向量,是用來(lái)將輸入數(shù)據(jù)中的所有詞語(yǔ)找到其對(duì)應(yīng)的詞向量,最后再將所有得到的詞向量構(gòu)造形成一個(gè)相應(yīng)的矩陣。在這一層中,不需要添加訓(xùn)練過的詞向量,并且詞向量在該層是隨機(jī)初始化的。

(2)bidirectional 層

在該層,通常采用雙向傳播的64個(gè)LSTM 神經(jīng)單元進(jìn)行文本分類訓(xùn)練。

(3)dropout 層

可以有效的防止過擬合。過擬合是學(xué)習(xí)過程中把樣本數(shù)據(jù)中的所有特征都記錄了下來(lái)。因此,在這個(gè)學(xué)習(xí)過程中,計(jì)算機(jī)學(xué)習(xí)了大量的局部特征,而這個(gè)特征會(huì)對(duì)測(cè)試集在測(cè)試時(shí)造成一定的干擾,造成干擾后,會(huì)降低測(cè)試集的精度,這種局部特征在測(cè)試集進(jìn)行預(yù)測(cè)時(shí)造成干擾,從而使測(cè)試集準(zhǔn)確率下降,誤差可以用于判斷測(cè)試集是否過擬合,測(cè)試集內(nèi)的誤差不斷減少,促使測(cè)試集外誤差逐漸減小在逐漸變大。

(4)dense 層

改成在整個(gè)神經(jīng)網(wǎng)絡(luò)中起到了重要作用,主要負(fù)責(zé)的是分類的工作,這個(gè)過程是對(duì)數(shù)據(jù)集中的每條數(shù)據(jù)進(jìn)行標(biāo)記,在dense 層,也加入了sigmoid 激活函數(shù),該函數(shù)的主要作用是對(duì)數(shù)據(jù)的某一分類的類別概率進(jìn)行預(yù)測(cè)該,并完成分類任務(wù)。

3.2 Text-CNN 模型

(1)輸入層

Text-CNN 模型的輸入層需要輸入一個(gè)定長(zhǎng)的文本序列,我們需要通過分析語(yǔ)料集樣本的長(zhǎng)度指定一個(gè)輸入序列的長(zhǎng)度L,比L 短的樣本序列需要填充(自己定義填充符),比L 長(zhǎng)的序列需要截取。最終輸入層輸入的是文本序列中各個(gè)詞匯對(duì)應(yīng)的分布式表示,即詞向量。

(2)卷積層

在NLP 領(lǐng)域一般卷積核只進(jìn)行一維的滑動(dòng),即卷積核的寬度與詞向量的維度等寬,卷積核只進(jìn)行一維的滑動(dòng)。在Text-CNN 模型中一般使用多個(gè)不同尺寸的卷積核。卷積核的高度,即窗口值,可以理解為N-gram 模型中的N,即利用的局部詞序的長(zhǎng)度,窗口值也是一個(gè)超參數(shù),需要在任務(wù)中嘗試,一般選取2-8之間的值。

(3)池化層

在Text-CNN 模型的池化層中使用了Max-pool(最大值池化),即減少模型的參數(shù),又保證了在不定長(zhǎng)的卷基層的輸出上獲得一個(gè)定長(zhǎng)的全連接層的輸入。

(4)全連接層

全連接層的作用就是分類器,原始的Text-CNN 模型使用了只有一層隱藏層的全連接網(wǎng)絡(luò),相當(dāng)于把卷積與池化層提取的特征輸入到一個(gè)LR 分類器中進(jìn)行分類。

4 結(jié)束語(yǔ)

現(xiàn)如今,開放存取資源的發(fā)展越來(lái)越快,我們也發(fā)現(xiàn)學(xué)者發(fā)表的學(xué)術(shù)論文的也呈很大的比例增長(zhǎng),學(xué)術(shù)研究學(xué)者對(duì)學(xué)術(shù)論文的需求也逐漸增多。在此研究背景下,本文就是對(duì)開放存取資源進(jìn)行分類,并方便學(xué)術(shù)研究學(xué)者檢索和研究。本文主要介紹了基于深度學(xué)習(xí)的文本分類過程和幾類經(jīng)典的文本分類網(wǎng)絡(luò)模型,本文研究選取Bi-LSTM 模型和Text-CNN 模型作為處理開放存取資源的深度學(xué)習(xí)模型。