基于級聯網絡的行人檢測方法

陳光喜 王佳鑫 黃勇 詹益俊 詹寶瑩

摘 要:針對復雜環境下行人檢測不能同時滿足高召回率與高效率檢測的問題,提出一種基于卷積神經網絡(CNN)的行人檢測方法。首先,采用CNN中的單步檢測升級版網絡YOLOv2初步檢測行人;然后,設計一個網絡與YOLOv2網絡級聯。設計的網絡具有目標分類和邊界框回歸的功能,對YOLOv2初步檢測出的行人位置進行再分類與回歸,以此降低誤檢,提高召回率;最后,采用非極大值抑制(NMS)處理的方法去除冗余的邊界框。實驗結果顯示,在數據集INRIA和Caltech上,所提方法與原始YOLOv2相比,召回率提高6.93.3個百分點,準確率提高6.85.1個百分點,同時速度上達到了14.712.711.6幀/s,實現了實時檢測。與現有的流行的行人檢測方法相比,所提方法具有更好的整體性能。

關鍵詞:行人檢測;卷積神經網絡;級聯網絡;分類回歸;實時檢測

中圖分類號: TP391.413; TP18

文獻標志碼:A

Abstract: In complex environment, existing pedestrian detection methods can not be very good to achieve high recall rate and efficient detection. To solve this problem, a pedestrian detection method based on Convolutional Neural Network (CNN) was proposed. Firstly, pedestrian locations in input images were initially detected with single step detection upgrade network (YOLOv2) derived from CNN. Secondly, a network with target classification and bounding box regression was designed to cascade with YOLOv2 network, which made reclassification and regression of pedestrian location initially detected by YOLOv2, to reduce error detections and increase recall rate. Finally, a Non-Maximum Suppression (NMS) method was used to remove redundant bounding boxes. The experimental results show that, in INRIA and Caltech dataset, the proposed method increases recall rate by 6.93.3 percentage points, and the accuracy is increased by 6.85.1 percentage points compared with original YOLOv2. It also reached a speed of 14.712.711.6FPS (Frames Per Second) to realize real-time detection. Compared with the existing six popular pedestrian detection methods, the proposed method has better overall performance.

Key words: pedestrian detection; Convolutional Neural Network (CNN); cascade network; classification and regression; real-time detection

0 引言

隨著智慧城市建設在國際國內如火如荼地展開,針對智能監控等相關計算機視覺的技術需求也日益增加。行人檢測作為計算機視覺領域的基礎任務,引起了國內外計算機視覺領域專家學者的特別關注[1]。傳統的行人檢測方法是利用人工設計的特征提取器,通過提取方向梯度直方圖(Histogram of Oriented Gradients, HOG)、局部二值模式(Local Binary Pattern, LBP)等特征來訓練分類器,實現對行人的檢測,但人工設計的行人特征很難適應行人行為的大幅度變化。

本質上說,行人檢測只是一種特殊的通用目標檢測,因而可以借鑒通用目標檢測的方法來實現。目前主流的通用目標檢測方法主要分為兩種:一種是two-stage;另一種是one-stage。two-stage方法主要使用更快、更富有特征層次的卷積神經網絡(Faster and Rich feature Convolutional Neural NetworkFaster Regions with Convolutional Neural Network feature, Faster R-CNN這個Faster R-CNN的英文全稱是否應該為“Faster Regions with Convolutional Neural Network feature”,其他作者寫的是這個英文全稱)[2]、快速且豐富的特征層次結構網絡(Fast and Rich feature CNNFast Regions with Convolutional Neural Network feature, Fast R-CNN)[3],而one-stage的方法有統一的實時對象檢測(You Only Look Once, YOLO)[4]、YOLO升級版(YOLOv2)[5]、單發多框檢測器(Single Shot multibox Detector, SSD)[6]。與two-stage的方法相比,one-stage的方法檢測速度更快,但在檢測質量上稍低。實時檢測是目前智能產品市場的主流需求,YOLOv2在實時性檢測方面表現突出,速度更快,但是直接使用YOLOv2檢測行人時,因為在INRIA[7]和Caltech[8]中行人的像素比較低,YOLOv2檢測效果較差,行人位置也不夠準確。此外,在高重疊度(Intersection Over Union, IOU)閾值條件下,YOLOv2的效果也不甚理想。

最新的CNN(Convolutional Neural Network)方法如超網絡(HyperNet)[9]大量使用了特征融合來提高小目標的檢測質量,而特征空間網絡(Feature Pyramid Network請補充FPN的英文全稱, FPN)[10]則利用多層特征預測來提高檢測質量。行人檢測方法也可以融合CNN特征與傳統行人特征,如Mao等[11]提出邊緣特征,分割特征對行人檢測很有效,他們設計了超學習網絡(Hyperlearn)進行特征融合,提高了小目標行人的檢測質量。特征融合的優點在于低層的特征語義信息比較少,但是目標位置準確;高層的特征語義信息比較豐富,但是目標位置比較粗略,同時融入了上下文語義特征,利用了高層低層特征易于檢測,但是這些方法的主干網絡非常深,或者采用多特種融合的方法導致網絡參數過于龐大,導致了檢測速度非常慢,影響了在實際檢測中的應用性。

分階段檢測方法的優點是單個網絡階段計算量不大,計算效率高。如多任務級聯卷積網絡(Multi-Task Cascaded Convolutional Network, MTCNN此處的MTCNN,是否應該為MTCCN,因為大寫字符中有兩個C,而不是CNN?請明確。回復:是MTCNN)[12]檢測人臉采用了一種級聯網絡,分3個階段:第一個階段提取人臉候選框,第二個階段定位人臉,第三個階段精確人臉位置,此方法檢測速度快,檢測質量高。本文參考了MTCNN方法設計了一個行人級聯網絡,根據深層特征與淺層特征融合的思想改進了YOLOv2。首先使用YOLOv2對行人進行檢測,在檢測時使其輸出預測的坐標;然后利用行人在水平方向上比較密集這一特點設計網絡Person用于級聯YOLOv2,這個網絡主要具備兩個作用:1)用于對YOLOv2檢測出的行人再次判斷是否為行人;2)對YOLOv2檢測出的行人的位置進行回歸。第二個網絡是一個回歸網絡,其網絡層數淺,且檢測速度快。本文的創新之處在于級聯網絡方法,結合了深層特征網絡與淺層特征網絡的優點,能夠完成實時檢測任務。

1 本文方法

本文方法首先使用了YOLOv2的算法。YOLOv2的計算流程公式為:y=fn(σn-1)=fn(fn-1(…f1(x)),x為原圖。可以看出YOLOv2的每一層參數必須訓練恰當,才能得到合適的檢測效果。YOLOv2網絡有19層,訓練的行人為小目標時,網絡難以訓練。

直接采用YOLOv2檢測時,較深的網絡得到抽象的特征,淺層的網絡得到圖像的細節。上述公式采用的是高級抽象特征作檢測,只能檢測出行人的大致位置,或者會誤檢出一些行人,而不能檢測出行人的具體位置。本文的主要思路是,采用級聯方法,根據淺層網絡提出人的細節特征這一特點設計了一個淺層網絡,精確定位人的位置,但由于網絡較淺,學習到的特征不足以用于定位行人,即輸入原圖無法得到行人位置,但是可用于候選框位置小范圍的修正,因此結合了淺層網絡與深層網絡的特點,用淺層網絡再次回歸深層網絡預測的結果。

檢測網絡提取特征的過程公式為D=F4(F3-1這個下標對嗎?下標是否應該為3?請明確(…F1(x)),x為原圖,經過4層網絡提取特征訓練,級聯網絡檢測公式為Df=F4(F3-1(…F1(y)),y為YOLO的檢測結果,因此結合了深層網絡與淺層網絡的特點能夠得出高質量的檢測效果,且由于是分階段檢測,沒有集中在同一個網絡,網絡的計算量沒有增大,檢測速度快。與此相對的是,FPN等網絡是在一個網絡中結合了深層、淺層特征,計算量加大,不利于網絡訓練。

本文改進的YOLOv2方法首先是在YOLOv2上作了大量的對比,分析在行人檢測場景中使用YOLOv2產生的效果,通過改變其判斷行人的threshold(閾值)來調整檢測性能。此外,對于如何在降低threshold的同時保持準確率不變,如何在提高行人定位準確性的同時提高召回率,如何保證檢測速度盡可能地快,這三個問題上提出了相應的解決方案。

1)針對準確率不理想的問題,設計新的網絡架構,此網絡具有再次判斷行人類別的功能,作一個二分類預測,即人和背景,同時在網絡中通過使用正負樣本的方法來提高準確率。

2)針對召回率較低的問題,設計一個具有邊界框回歸功能的網絡架構,通過回歸原始YOLOv2的預測框,提高行人預測框定位的準確性,檢測到的行人正確定位的數量就會增加,行人召回率隨之提升。

3)針對實時檢測必須保證檢測速度這一問題,這就要求設計的網絡層數比較淺。網絡層數越淺,檢測速度越快。

綜合這三個問題的解決方案,在以行人為目標的基礎上,設計一個網絡Person。此網絡具有分類與回歸的功能,網絡層數很淺,僅有4層。分析行人的真實框縱橫比,選取合適的卷積核,再對上一步YOLOv2測試的三種閾值下的預測框分別傳入Person網絡中作分析對比,得出threshold為0.01時的效果最優,最后再與其他行人檢測算法進行對比分析。

1.1 YOLOv2初步檢測

為了提高檢測速度,采用YOLOv2初步檢測行人。YOLOv2是目前最快的通用目標檢測網絡,能夠在檢測速度和檢測質量上進行權衡。

1.1.1 置信度計算

YOLOv2檢測時是整圖輸入的,首先將圖片分成S×S個網格,按式(1)計算每一個網格置信度。首先判斷網格中是否包含目標,見式(2),如果包含目標Pr(Object)=1,再判斷該目標是否為人的概率Pr(Person|Object),最后乘以定位的準確性IOU,即IOU為預測框與真實框的交并比。預測框與真實框的交集見式(3):

其中:AO(Area of Overlap)為面積的重疊,表示預測框的面積與真實框的面積的交集;AU(Area of Union請補充AO、AU的英文全稱)為面積的并集,表示預測框的面積與真實框的面積的并集。

1.1.2 YOLOv2網絡結構

采用官方的YOLOv2檢測網絡結構,輸入任意尺寸圖片,重設大小到416×416(寬×高),經各層卷積池化后,圖片大小改為13×13,并將輸出類別修改為2類,即行人與背景。在訓練網絡時,需要預設錨點數量及位置。隨著迭代次數不斷增加,從網絡學習到行人特征,預測框參數不斷調整,最終接近真實框。YOLOv2結構如圖1所示。

1.2 Person網絡精確檢測

原始YOLOv2并不是專為行人檢測所設計的網絡,檢測行人的召回率和準確率均不高。為提高行人分類的準確率及行人預測的召回率,設計了Person網絡。Person網絡的主要功能是對YOLOv2的預測坐標及類別進行微調,使預測更加精準。

1.2.1 Person網絡結構

Person網絡是一個具有目標分類和位置回歸兩種功能的網絡,采用4個卷積層、3個Max-pooling層、1個全連接(Full Connection, FC)層如表1。全連接層包含2個分支:一個用于Softmax分類,另一個用于邊界框回歸。Person網絡的輸入是像素為30×90的行人樣本圖,行人的檢測框都是高比寬長的矩形框且寬高比接近1∶3,因此選取的卷積核寬高比也為1∶3,采用兩個2×6、兩個1×3的卷積核。非線性激活層采用PReLU(Parametric Rectified Linear Unit請補充PReLU的英文全稱)[13],提高網絡收斂速度。參考全卷積網絡(Fully Convolutional Network, FCN)分割網絡思想,采用了不同卷積層之間的特征融合,將Conv3、Conv4的特征通過雙線性插值算法重設為相同大小并進行拼接,這種不同層之間的特征融合可以提高網絡的檢測性能。例如,原始行人像素為30×90,經過4次池化3次池化,行人像素值變為3×6。檢測這種3×6的圖像發現其效果不佳,而采用不同層的特征拼接且聯合了不同層的語義特征,網絡對于不同大小的行人具有很高的檢測能力。,因此最終網絡結構添加了兩個上采樣層以及一個用于降維的卷積層。網絡結構示意圖如圖12所示。YOLOv2預測出的行人框,輸出結果作為級聯網絡的最終預測框。

1.2.2 代價函數

Person網絡代價函數包含兩個部分:第一個部分是分類,第二個部分是邊界框回歸。

1)分類損失采用交叉熵:

2)邊界框回歸損失采用歐氏距離:

1.2.3 Person算法設計

在訓練階段,簡單樣本、困難樣本不平衡的比率對訓練結果產生較大影響。簡單樣本是指樣本行人比較清晰且容易被網絡檢測,而另一種樣本行人較為模糊,網絡學習這種模糊樣本較為困難,稱為困難樣本。如果不作樣本平衡,困難樣本對網絡學習過程中產生的權值影響小,隨著網絡訓練,困難樣本可能會被當成背景進而被忽視。Person網絡設計階段為了提升網絡分類的準確率,采用平衡樣本算法。在全連接層的loss階段,對一個batch的樣本進行快速排序。選擇loss較高的70%的樣本作為困難樣本進行前傳,剩下30%的樣本作為簡單樣本回到原數據集。通過這種方式,在每個batch訓練時會減少簡單樣本產生,以此來平衡樣本,提高分類的準確性。

1.3 本文總體算法

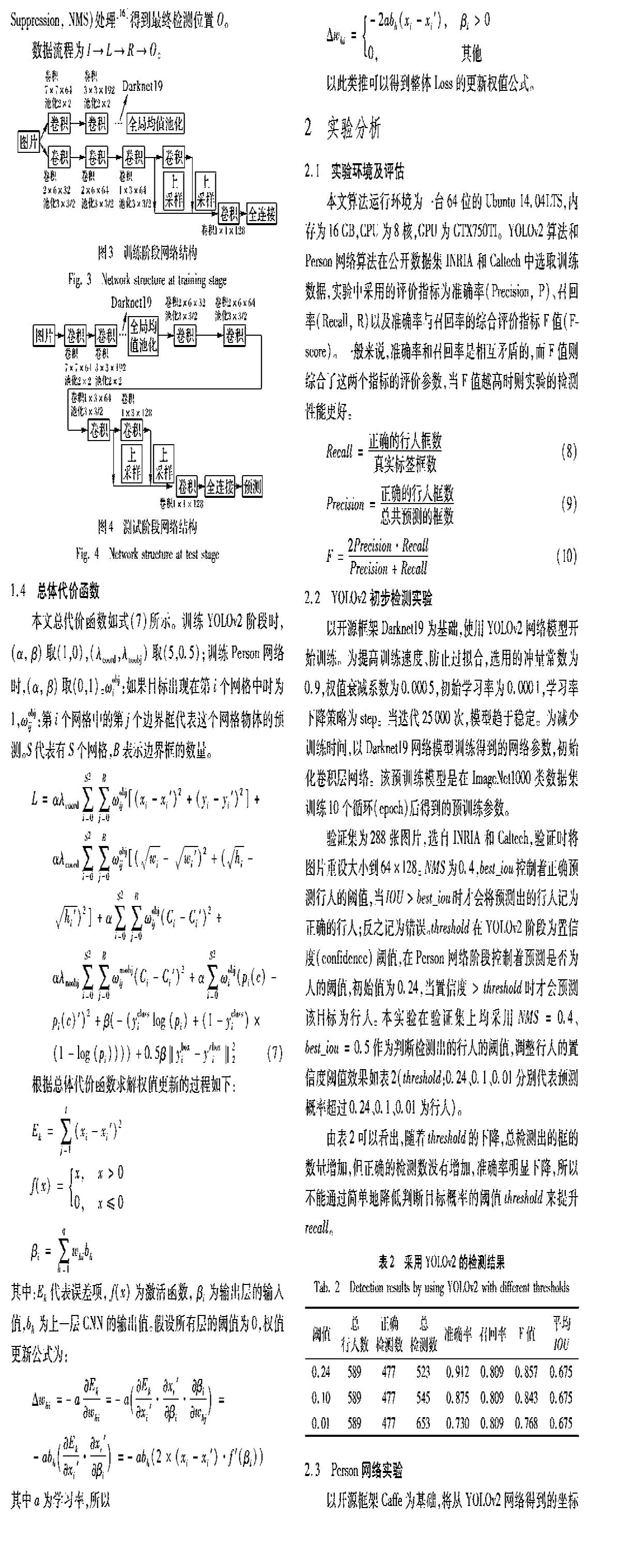

本文第一步采用的是卷積神經網絡[14-15]中YOLOv2對行人進行初步檢測。為了盡可能多地檢測出復雜環境下的行人,降低置信度閾值,在INRIA和Caltech上,總檢測框的數量從523個提高到653個,但是誤檢率也隨之提升。這一問題利用Person網絡的分類功能得到解決:第一步再次判斷目標是否為行人,去除YOLOv2降低閾值后的背景框;第二步采用Person網絡的回歸功能,對YOLOv2檢測出的位置進行回歸,提高定位的準確性。Person網絡結構如圖2所示。圖3是本文方法的訓練階段網絡,級聯了YOLOv2算法和Person網絡,訓練時分階段訓練。傳統CNN網絡沒有結合相鄰通道特征,對小目標的檢測效果不佳,Person網絡引入了通道特征拼接的方法,提升了小目標的檢測性能。從結構圖可看出本文方法是一個多階段訓練的網絡。圖4是本文方法的檢測階段,首先圖片經過深層網絡YOLOv2預測出行人的位置,在經過Person網絡回歸行人的位置使最終的檢測框比單個的CNN網絡更加準確,傳統網絡沒有邊界框再次回歸的功能。

1.4 總體代價函數

本文總代價函數如式(7)所示。訓練YOLOv2階段時,(α, β)取(1,0),(λcoord,λnoobj)取(5,0.5);訓練Person網絡時,(α, β)取(0,1)。ωobji:如果目標出現在第i個網格中時為1,ωobjij:第i個網格中的第j個邊界框代表這個網格物體的預測。S代表有S個網格,B表示邊界框的數量。

2 實驗分析

2.1 實驗環境及評估

本文算法運行環境為一臺64位的Ubuntu 14.04LTS,內存為16GB,CPU為8核,GPU為GTX750TI。YOLOv2算法和Person網絡算法在公開數據集INRIA和Caltech中選取訓練數據,實驗中采用的評價指標為準確率(Precision, P)、召回率(Recall, R)以及準確率與召回率的綜合評價指標F值(F-score)。一般來說,準確率和召回率是相互矛盾的,而F值則綜合了這兩個指標的評價參數,當F值越高時則實驗的檢測性能更好。

2.2 YOLOv2初步檢測實驗

以開源框架Darknet19為基礎,使用YOLOv2網絡模型開始訓練。為提高訓練速度、防止過擬合,選用的沖量常數為0.9,權值衰減系數為0.0005,初始學習率為0.0001,學習率下降策略為step。當迭代25000次,模型趨于穩定。為減少訓練時間,以Darknet19網絡模型訓練得到的網絡參數,初始化卷積層網絡。該預訓練模型是在ImageNet1000類數據集訓練10個循環(epoch)后得到的預訓練參數。

驗證集為288張圖片,選自INRIA和Caltech,驗證時將圖片重設大小到64×128。NMS為0.4,best_iou控制著正確預測行人的閾值,當IOU>best_iou時才會將預測出的行人記為正確的行人;反之記為錯誤。threshold控制著預測是否為人的概率的閾值threshold在YOLOv2階段為置信度(confidence)閾值,在Person網絡階段控制著預測是否為人的閾值,初始值為0.24,當Pr(Person)置信度置信度>threshold時才會預測該目標為行人。本實驗在驗證集上均采用NMS=0.4、best_iou=0.5、threshold=0.6這個threshold=0.6刪除作為判斷檢測出的行人的閾值,調整行人的置信度閾值效果如表2(threshold:0.24、0.1、0.01分別代表預測概率超過0.24、0.1、0.01為行人)。

由表2可以看出,隨著threshold的下降,總檢測出的框的數量增加,但正確的檢測數沒有增加,準確率明顯下降,所以不能通過簡單地降低判斷目標概率的閾值threshold來提升recall。

2.3 Person網絡實驗

以開源框架Caffe為基礎,將從YOLOv2網絡得到的坐標作為輸入值,輸入Person網絡進行分類與邊界框回歸,輸入固定尺寸width×height為30×90。當沖量為0.9,權值衰減為0.004,初始學習率為0.001,學習率下降策略為step,且當迭代訓練達到1000000次時,模型達到飽和。訓練時樣本是從原始真實行人框上隨機截取的,按截取的圖片與真實行人框的IOU,將截取的圖片分為正樣本、部分樣本和負樣本。負樣本是IOU<0.5的樣本,正樣本是IOU>0.8的樣本,其他樣本為部分樣本,正樣本、部分樣本、負樣本比例為1∶1∶3。實驗結果如表3所示,threshold:0.24、0.1、0.01是YOLOv2檢測行人的閾值。對比表2與表3可知,使用級聯方法可以得到比YOLOv2更高的召回率、準確率,以及定位的準確性更為精準。表4展示卷積核不同寬高比下的Person網絡效果,從中可以得出選取為1∶3的卷積核時,F值最高,且檢測效果最為突出。

對比圖5(a),圖5(b)出現虛框(誤檢的行人框),通過Person網絡,對YOLOv2檢測出的標記框再次判斷是否為行人并將虛框去除。對比圖5(a),圖5(c)檢測出的行人數量有所增加,且檢測出標記框的位置更為精準。本實驗將YOLOv2閾值設為0.01時,將YOLOv2的坐標傳進Person網絡能夠得到比較高的召回率、準確率以及高質量的定位,因此取YOLOv2 threshold為0.01情況下初步預測行人,Person網絡threshold取0.6再次預測行人的數據作為本實驗的最終檢測數據。

2.4 不同算法行人檢測性能分析

目前最常用的傳統行人檢測方法是基于滑動窗口策略,具有代表性的工作是Felzenszwalb等[17]提出的形變部位模型(Deformable Part Model, DPM)。在一定程度上,這個方法能消除部分遮擋的影響。其次,提取候選框集的描述特征過程,Dollár等[18]提出積分通道特征(Integral Channel Feature, ICF),利用積分圖技術對圖像的各個特征通道進行快速計算,在文獻[19]中進一步提出了聚合通道特征(Aggregate Channel Feature, ACF)。這些方法對嚴格依賴于手動提取的特征檢測的魯棒性差。基于深度學習——卷積神經網絡算法的目標檢測,典型的代表性的工作是R-CNN系列的結合區域候選框(Region Proposal)和CNN分類的目標檢測框架。文獻[17]中針對行人檢測對Faster R-CNN作出改進,提出了區域候選框網絡(Region Proposal Network, RPN)與隨機提升森林(Boosted Forest, BF)中文名稱和英文名稱不匹配,鑒于縮寫為BF,所以請調整中文名稱吧,“隨機森林”要改為“**森林”,要與英文名稱匹配結合的思想(RPN+BF)用于行人檢測,此方法能有效地降低行人檢測的誤檢率。SSD是一種one-stage算法,沒有候選框預選的過程,并且適應不同尺度的特征圖,可以用于行人檢測。Hyperlearn是關于行人檢測的研究方法,提出了傳統方法與CNN方法特征融合的思想,其優點是利于小目標的行人檢測,缺點是對大目標的行人適應為較差。

表5為各種算法的參數指標:準確率、召回率、F值、檢測時間的對比數據。從實驗數據可以看出,本文算法對于行人檢測任務的準確率略低于RPN+BF方法此處有疑問,本文算法的準確率為0.97,而RPN+BF方法為0.969,是高于RPN+BF方法?是數字錯了,還是描述錯了?請作相應調整,高于ACF、DPM、Hyperlearn算法;算法表現出來的檢測速度遠遠高于RPN+BF、DPM、Hyperlearn算法,略低于ACF,但是,本文采用的算法是CNN算法,可以端到端地執行,且它的召回率最為顯著。由于本文算法在第一階段利用YOLOv2檢測行人,相比two-stage算法,YOLOv2沒有候選框提取這一步驟,直接采取錨點進行預測,候選框提取的時間較長,所以YOLOv2這類one-stage算法檢測速度普遍快,但因為沒有采用候選框提取,產生的預測結果一般沒有two-stage算法準確。YOLOv2是one-stage算法,其特征是圖片越小,其檢測速度越快,檢測質量越低;圖片越大,其檢測速度越慢,檢測質量越高。行人在圖片中是小目標,利用級聯的Person網絡分類和回歸過程,對行人進行篩選并回歸行人的位置,從而使得召回率和準確率比原始YOLOv2高,本文方法速度比RPN+BF、DPM、Hyperlearn均快,能夠達到14.712.711.6幀/s(Frames Per Second, FPS)的檢測速度,速度達到實時檢測的目標,因此,可以認為本文算法的綜合性能最佳。

3 結語

針對復雜環境下行人檢測不能同時滿足高召回率與高效率檢測的問題,本文提出了一種改進的級聯網絡——原始YOLOv2+Person網絡的行人檢測方案。結合了深層CNN網絡與淺層CNN網絡的優點,進而得到更準確的行人分類和行人預測框。與原始YOLOv2相比,本文方法的行人預測的準確率、召回率均有所提升,與ACF、RPN+BF、DPM、SSD相比,召回率、F值提升較為顯著。本文主要工作在于將原始YOLOv2檢測器改進為二階段檢測器,在速度與精度上達到了均衡且可以在GPU上進行并行計算,減少計算開銷。如何進一步提高檢測質量將是下一步研究的方向。

參考文獻 (References)

[1] 蘇松志,李紹滋,陳淑媛,等.行人檢測技術綜述[J].電子學報,2012,40(4):814-820.(SU S Z, LI S Z, CHEN S Y, et al. A survey on pedestrian detection [J]. Acta Electronica Sinica, 2012, 40(4):814-820.)

[2] REN S, HE K, GIRSHICK R, et al. Faster R-CNN: towards real-time object detection with region proposal networks [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6):1137-1149.

[3] GIRSHICK R. Fast R-CNN[C]// Proceedings of the 2015 IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE, 2015: 1440-1448.

[4] REDMON J, DIVVALA S, GIRSHICK R, et al. You Only Look Once: unified, real-time object detection [C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2016:779-788.

[5] REDMON J, FARHADI A. YOLO9000: better, faster, stronger [C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2017: 6517-6525.

[6] LIU W, ANGUELOV D, ERHAN D, et al. SSD: Single Shot multibox Detector[C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2016: 21-37.

[7] DALAL N, TRIGGS B. Histograms of oriented gradients for human detection[C]// Proceedings of the 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2005:886-893.

[8] DOLLAR P, WOJEK C, SCHIELE B, et al. Pedestrian detection: a benchmark [C]// Proceedings of the 2009 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2009: 304-311.

[9] KONG T, YAO A, CHEN Y, et al. HyperNet: towards accurate region proposal generation and joint object detection [C]// Proceedings of the 2016 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society,2016: 845-853.

[10] LIN T Y, DOLLAR P, GIRSHICK R, et al. Feature pyramid networks for object detection[C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2017: 936-944.

[11] MAO J, XIAO T, JIANG Y, et al. What can help pedestrian detection? [C]// Proceedings of the 2017 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2017:6034-6043.

[12] ZHANG K, ZHANG Z, LI Z, et al. Joint face detection and alignment using multitask cascaded convolutional networks [J]. IEEE Signal Processing Letters, 2016, 23(10):1499-1503.

[13] HE K, ZHANG X, REN S, et al. Delving deep into rectifiers: surpassing human-level performance on ImageNet classification [C]// ICCV 2015: Proceedings of the 2015 IEEE International Conference on Computer Vision. Piscataway, NJ: IEEE, 2015: 1026-1034.

[14] SZEGEDY C, TOSHEV A, ERHAN D. Deep neural networks for object detection [J]. Advances in Neural Information Processing Systems, 2013, 26(1):2553-2561.

[15] TOM D, MONTI F, BAROFFIO L, et al. Deep convolutional neural networks for pedestrian detection [J]. Signal Processing: Image Communication, 2016, 47(1):482-489.

[16] ROTHE R, GUILLAUMIN M, VAN GOOL L. Non-maximum suppression for object detection by passing messages between windows[C]//Proceedings of the 2014 Asian Conference on Computer Vision. Berlin: Springer, 2014: 290-306.

[17] FELZENSZWALB P, MCALLESTER D, RAMANAN D. A dis-criminatively trained, multiscale, deformable part model [C]// Proceedings of the 2008 IEEE Conference on Computer Vision and Pattern Recognition. Washington, DC: IEEE Computer Society, 2008: 1-8.

[18] DOLLAR P, APPEL R, BELONGIE S, et al. Fast feature pyramids for object detection [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 36(8):1532-1545.

[19] ZHANG L, LIN L, LIANG X, et al. Is Faster R-CNN doing well for pedestrian detection?[C]// ECCV 2016: Proceedings of the 14th European Conference on Computer Vision. Berlin: Springer, 2016: 443-457.