Adam優化的CNN超分辨率重建*

趙小強,宋昭漾

1.蘭州理工大學 電氣工程與信息工程學院,蘭州 730050

2.甘肅省工業過程先進控制重點實驗室,蘭州 730050

3.蘭州理工大學 國家級電氣與控制工程實驗教學中心,蘭州 730050

1 引言

在生活的許多場景中,人們用成像設備獲得的圖像在某些細節方面表現得都不是特別好。為了更好地獲得圖像細節信息,圖像超分辨率重建(superresolution,SR)技術引起研究者的廣泛關注。它是一種通過使用計算機將一幅低分辨率圖像(low resolution,LR)或圖像序列進行恢復得到高分辨率圖像(high resolution,HR)的圖像處理技術。通過恢復得到的高分辨率圖像具有更豐富的細節信息,這些細節信息在實際應用中會起到非常重要的作用。在1984年,超分辨率重建技術首次被Tsai等[1]提出。由于圖像超分辨率重建技術在生活中應用非常廣泛并且技術要求也越來越高,使得圖像超分辨率重建技術得到快速發展。目前圖像超分辨率重建技術主要分為3種方法:基于插值、基于重建和基于學習的方法[2]。

基于插值的方法有最近鄰插值、雙線性插值和雙立方插值方法。最近鄰插值方法是用最臨近的點的像素值表示目的像素值,該方法的特點是插值速度快,但是縮放圖像質量差,并且圖像容易失真。雙線性插值方法具有低通濾波器的特點,使用雙線性插值方法得到的重建圖像質量比較好而且圖像較平滑,得到重建圖像的速度也較快,但是使用雙線性插值方法使圖像的高頻分量受損。使用雙立方插值方法得到的圖像質量較好,但是計算量很大,計算速度也比較慢。目前,雙立方插值方法一般用于圖像的預處理工作。雖然基于插值的方法在一定程度提高了圖像細節信息的清晰度,但是存在較嚴重的震蕩和過平滑問題。研究人員為了解決震蕩和過平滑問題,提出了基于重建的方法。基于重建的方法是對圖像建立觀測模型,結合不同的先驗條件進行高分辨率圖像的求解。基于重建的方法包括凸集投影(projection onto convex sets,POCS)方法[3]和最大后驗概率(maximum a posterior,MAP)方法[4]。凸集投影方法是一種采用迭代的方法,其方法思想比較簡單,加入先驗知識也比較容易,但是該方法計算過于復雜,收斂速度也比較慢。最大后驗概率方法是將低分辨率圖像序列的配準問題基于概率進行優化求解,估計出高分辨率圖像。最大后驗概率方法使用比較靈活,可以加入對具體問題的具體約束,但是使用最大后驗概率方法容易造成圖像平滑和重要細節的缺失問題。基于重建的方法需要充分的先驗知識,隨著放大因子的增大,即使增加低分辨率圖像,也很難對圖像高頻信息進行重建,甚至會造成圖像平滑問題。基于學習的方法是對圖像進行特征提取、非線性映射和圖像重建得到高分辨率圖像。基于學習的方法包括流行學習、稀疏表示和深度學習方法。Chang等[5]將流行學習中的局部線性嵌入法應用到圖像超分辨率重建中,減少了訓練集的數量,但是容易產生欠擬合和過擬合問題。Yang等[6]將稀疏表示模型(sparse coding for super-resolution,SCSR)應用到圖像超分辨率重建,這種方法雖然高效,但是忽略了整體框架優化,很難得到最優的參數。

近年來,深度學習[7-9]在圖像處理領域中表現出巨大潛力,引起了研究者的廣泛關注。Wang等[10]將稀疏編碼與深度學習結合應用于圖像重建;Dong等[11]提出了基于卷積神經網絡的超分辨率重建(superresolution convolution neural network,SRCNN)方法;在SRCNN[11]算法中,將重建過程中的圖像塊提取、非線性映射和圖像重建3個操作統一到一個3層的卷積神經網絡中,實現了從低分辨率圖像到高分辨率圖像端到端的學習,使得圖像重建性能得到了很大的提高。但是僅僅用3層網絡學到的圖像特征信息有限,沒有充分利用圖像區域之間信息的關聯性,導致在不同放大倍數的條件下圖像重建的效果差別很大。

為了解決單幀圖像在不同放大倍數的條件下進行超分辨率重建能得到良好的效果,提出了一種Adam優化的卷積神經網絡(CNN)超分辨率重建方法。該方法首先使用ISODATA聚類算法對訓練的圖像集進行分類處理,減少卷積神經網絡參數的復雜度;然后在Adam優化的卷積神經網絡中對輸入圖像進行特征提取和非線性映射得到特征映射圖;最后在Adam優化的卷積神經網絡中對特征映射圖進行反卷積重建得到多尺度放大的重建圖像。

2 卷積神經網絡

卷積神經網絡是人工神經網絡的一種。1984年Fukushima首次提出的神經認知機就是最原始的卷積神經網絡,Fukushima將其運用在手寫數字識別上面。隨著研究人員對卷積神經網絡的深入研究和不斷完善,卷積神經網絡被成功應用在圖像處理、模式識別等領域。卷積神經網絡是一個具有多層的神經網絡,主要包括數據輸入層、卷積計算層、池化層和全連接層。數據輸入層的作用是對原始數據進行預處理,包括去均值、歸一化、PCA/白化操作等;卷積計算層對輸入數據進行卷積操作,實現特征提取;池化層用于壓縮數據、壓縮參數數量和減小過擬合;全連接層對所有特征都進行不同權重連接,實現輸出。卷積神經網絡的每一層都包含多個二維平面,而每個二維平面都由多個獨立的神經元組成。卷積神經網絡的卷積計算層由多個特征映射平面組成,映射平面上所有神經元的權值相等,由于映射平面上的神經元共享權值,因此減少了網絡參數的個數,降低了網絡參數的復雜度。卷積神經網絡的每一個卷積計算層通常后面連接池化層,這種結構對輸入圖像具有很好的畸變容忍能力,對平移、比例縮放、傾斜或者其他形式的形變具有高度不變性。圖像重建的卷積神經網絡模型如圖1所示,最左邊是卷積神經網絡的輸入層,然后卷積層對輸入層的特征圖進行卷積計算,接著對卷積層的特征圖進行池化操作。卷積層和池化層的組合可以在隱藏層中出現很多次,在圖1的模型中只出現兩次。最后池化層的特征圖通過全連接層實現重建,得到重建圖像。

3 Adam優化的CNN超分辨率重建

3.1 采用ISODATA聚類算法對訓練的圖像集進行分類處理

在圖像超分辨率重建過程中,采用傳統的K-means聚類算法[12]對訓練的圖像集進行分類處理可以提升訓練效果和減少訓練時間。在K-means聚類算法中,k的值需要預先人為確定,在整個算法使用過程中k的值也無法更改,并且當訓練高維度的數據集時,很難準確估計k值的大小。

本文采用ISODATA聚類算法代替K-means聚類算法,ISODATA聚類算法可以把某個樣本數量過少的類別去除,把某個樣本數量過多、分散程度較大的類別分為兩個子類別。ISODATA聚類算法基本步驟如下:(1)選擇初始聚類中心和參數指標,將N個樣本按照指標分配到各個聚類中心;(2)計算各類樣本的距離指標函數;(3)按照給定的要求,將前一次獲得的聚類集進行分裂和合并處理,從而獲得新的聚類中心;(4)重新進行迭代計算,計算各項指標,判斷聚類結果是否符合要求。經過多次迭代后,若結果收斂,則運算結束。ISODATA聚類算法的流程圖如圖2所示,其中K表示預期聚類的數目,NC表示當前形成的聚類數目。

在卷積神經網絡的訓練中,使用ISODATA聚類算法對訓練的圖像集進行分類處理,將近似的圖像分成一類,減少卷積神經網絡模型的參數規模,從而能夠在一定程度上減少卷積神經網絡的訓練時間,提高卷積神經網絡的訓練效率。

3.2 特征提取與非線性映射

本文采用將合適的低分辨率圖像輸入到卷積神經網絡的方法進行特征提取和非線性映射。在卷積神經網絡中每個神經元的作用就是相當于只關注圖像某一個特征的濾波器,所有神經元組合在一起的作用就是相當于對整幅圖像進行特征提取。卷積神經網絡對圖像特征提取是從輸入的圖像中提取圖像塊并把每一個圖像塊表示成高維向量,這些向量組成第一層的特征映射圖[13]。設這一層的操作為F1,輸入圖像為Y,則該層操作運算表示為:

其中,W1為濾波器,W1的大小為c×f1×f1×n1,c為YCbCr色彩空間中圖像的通道數,f1為濾波器的大小,n1為濾波器的數量,B1為偏差,“*”表示卷積操作,a服從均勻分布a~U(l,u)。這個卷積層的含義為運用大小為c×f1×f1×n1的濾波器W1作用在輸入的低分辨率圖像上,對輸入的低分辨率圖像進行特征提取,得到n1維特征映射圖。

同樣,非線性映射則是通過卷積神經網絡將第一層的n1維向量映射到第二層的n2維向量中,得到n2維特征映射圖。設這一層的操作為F2,輸入圖像為F1(Y),則該層操作運算表示為:

其中,W2是大小為n1×f2×f2×n2的濾波器,B2是n2維的偏差。這個卷積層的含義為運用大小為n1×f2×f2×n2的濾波器W2作用在第一層的特征映射圖上,進行非線性映射,得到n2維特征映射圖。

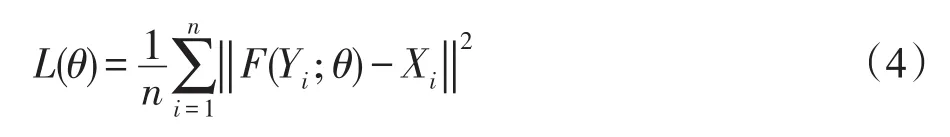

3.3 反卷積重建

本文通過設計一個反卷積操作實現圖像多尺度重建,該操作能夠對獲得的特征映射圖進行多尺度放大[14]。反卷積[15](deconvolution)又被稱為轉置卷積(transposed convolution),因為卷積層的前向傳播過程就是反卷積層的反向傳播過程,卷積層的反向傳播過程就是反卷積層的前向傳播過程。在圖像反卷積操作過程中,當步長s大于1時,反卷積可以看作是上采樣操作,并且整個網絡的復雜度也會降低s2,但是步長也不能過大,因為步長過大圖像的重建質量就會嚴重下降。在圖像反卷積重建過程中,對于有重疊區域的圖像塊采用平均化操作得到最終圖像。平均化操作可視為在特征映射圖上采用均值濾波器。設這一層的操作為F3,輸入圖像為F2(Y)。本文設計的反卷積操作的表達形式為:

其中,W3是大小為n2×f3×f3×c的濾波器,B3是c維的偏差,“?”表示反卷積操作,σ為采樣因子。步長根據采樣因子的大小進行相應的調整,且步長始終大于1。

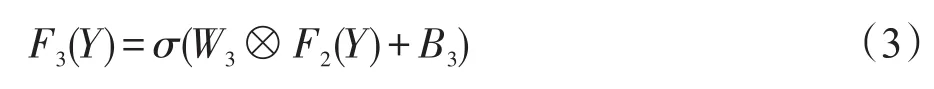

3.4 Adam優化CNN網絡

對于CNN網絡的參數,本文通過構建均方誤差函數作為損失函數,最小化F(Y;θ)與原始圖像X的誤差來估計網絡參數θ={W1,W2,W3,B1,B2,B3}。均方誤差函數表達形式為:

其中,n代表訓練圖像的數量。

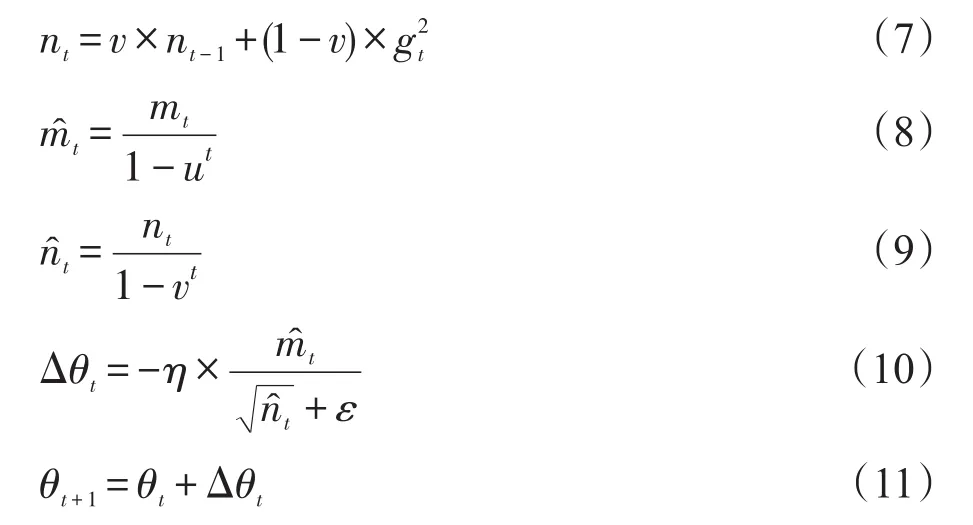

為了優化CNN網絡,更新網絡參數θ,本文采用Adam優化算法[16]代替隨機梯度下降(stochastic gradient descent,SGD)算法來最小化損失函數。隨機梯度下降算法保持單一的學習率(alpha)更新所有的權重,學習率在網絡訓練過程中并不會改變。而Adam優化算法通過計算梯度的一階矩估計和二階矩估計為不同的參數設計獨立的自適應性學習率。Adam算法有很高的計算效率和較低的內存需求,并且Adam算法梯度的對角縮放(diagonal rescaling)具有不變性。更新網絡參數過程表示為:

其中,gt是均方誤差函數L(θ)對θ的梯度,mt是對梯度的一階矩估計,nt是對梯度的二階矩估計,m?t是對mt的偏差修正,n?t是對nt的偏差修正,矩估計的指數衰減速率u為0.9,v為0.99,步長η為0.001,數值穩定的小常數ε為10-8,Δθt是計算的θt更新值,θt+1為t+1時刻的θ值,即將θt和 Δθt的值求和應用到θt+1。Adam優化算法首先對參數向量、一階矩向量和二階矩向量進行初始化。然后循環迭代地更新各個部分,使參數θ收斂。即時間步t加1,更新偏差的一階矩估計和二階矩估計,接著計算一階矩估計的偏差修正和二階矩估計的偏差修正,再更新目標函數在該時間步上對參數θ所求的梯度,最后再用以上計算出來的值更新模型的參數θ。基于Adam優化的CNN超分辨率重建操作圖如圖3所示,首先對訓練集進行ISODATA聚類,將人臉的圖像分為一類,然后將分類后的訓練圖像輸入到神經網絡,訓練神經網絡參數,最后將重建的LR圖像輸入到訓練好的神經網絡進行特征提取、非線性映射和反卷積操作得到重建圖像。

Fig.3 Operation diagram of CNN super resolution reconstruction based onAdam optimization圖3 基于Adam優化的CNN超分辨率重建操作圖

4 實驗與分析

4.1 初始化

本文的實驗在Intel?Pentium?CPU3550M平臺上進行,主頻為2.30 GHz,內存為4 GB,其中卷積神經網絡在深度學習框架Caffe上搭建,實驗測試在Matlab2014(a)中進行。

在實驗中,訓練卷積神經網絡的圖像集為常用的91幅自然圖像,運用Set5和Set14測試集對卷積神經網絡進行測試。

實驗中的參數設置:f1=9,f2=1,f3=5,n1=64,n2=32,u=0.9,v=0.99,η=0.001,ε=10-8,一階矩mt和二階矩nt初始化設置為0,一階矩的偏差修正m?t和二階矩的偏差修正n?t初始化設置為0。

為了客觀評估使用本文方法獲得的重建圖像的質量,使用經典的Bicubic算法、SRCNN算法和FSRCNN(fast super-resolution convolutional neural network)算法對相同的圖像進行超分辨率重建并進行對比。經典的Bicubic算法是基于插值的超分辨率重建算法,一般用于圖像超分辨率重建的預處理工作。SRCNN算法是基于深度學習的超分辨率重建算法,在圖像應用中具有空間平移、旋轉和縮放不變性,且通過權值共享大大減少了所需要訓練的參數。FSRCNN算法是SRCNN的改進算法,FSRCNN算法使用了更小的卷積核縮減了參數計算量并加快了訓練速度。

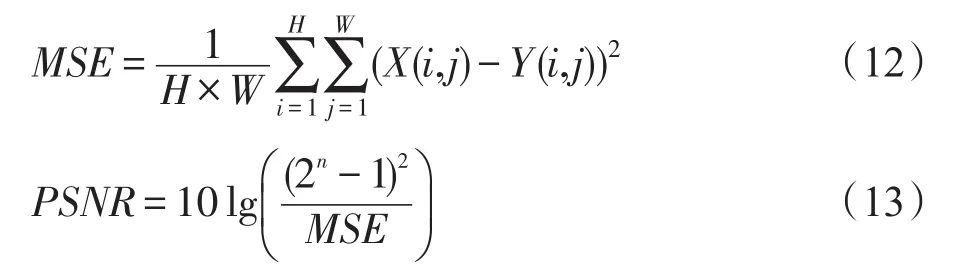

本文實驗采用峰值信噪比(peak signal to noise ratio,PSNR)來評價各種算法的重建效果。

其中,MSE表示當前圖像X和參考圖像Y的均方誤差(mean square error);H和W分別為圖像的高度和寬度;n為每像素的比特數,一般取8,即像素灰階數為256;PSNR的單位是dB,數值越大表示失真越小。

4.2 實驗效果

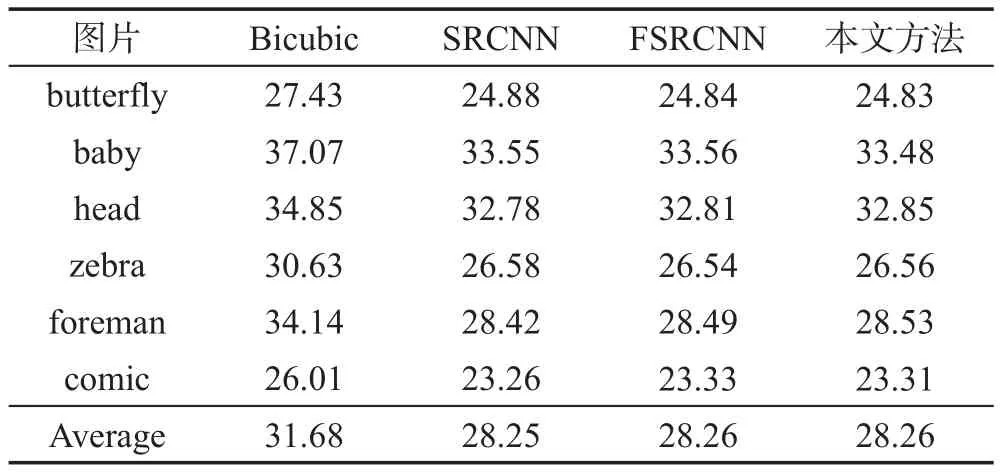

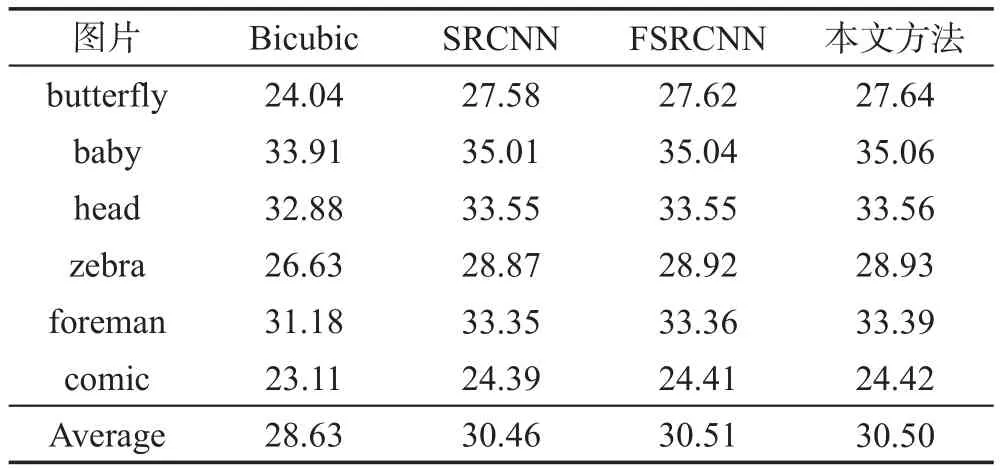

實驗采用放大倍數2、3、4分別獲得本文方法與Bicubic算法[17]、SRCNN算法[11]和FSRCNN算法[18]重建圖像的PSNR值,如表1~表3所示。

Table 1 PSNRvalues of reconstructed images with magnification factor of two表1 放大倍數為2的重建圖像的PSNR值 dB

Table 2 PSNRvalues of reconstructed images with magnification factor of three表2 放大倍數為3的重建圖像的PSNR值 dB

Table 3 PSNRvalues of reconstructed images with magnification factor of four表3 放大倍數為4的重建圖像的PSNR值 dB

從表1~表3中可以分析出,當放大倍數為2時,使用本文方法得到的重建圖像質量差于使用Bicubic算法得到的重建圖像質量,這是因為Bicubic算法是基于插值的方法,放大倍數越小,插值容易且對圖像的影響較小。而SRCNN算法、FSRCNN算法和本文方法是基于學習的方法,圖像上下文數據信息缺少關聯。當放大倍數為3和4時,使用本文方法得到的重建圖像質量優于使用另外3種算法得到的重建圖像質量。在放大倍數為3的情況下,使用本文方法得到的重建圖像質量最好,使用本文方法比使用Bicubic算法獲得的重建圖像的PSNR值平均提高了1.87 dB,比SRCNN算法得到的重建圖像的PSNR值平均提高了0.04 dB,比FSRCNN算法得到的重建圖像的PSNR值平均提高了0.013 dB。

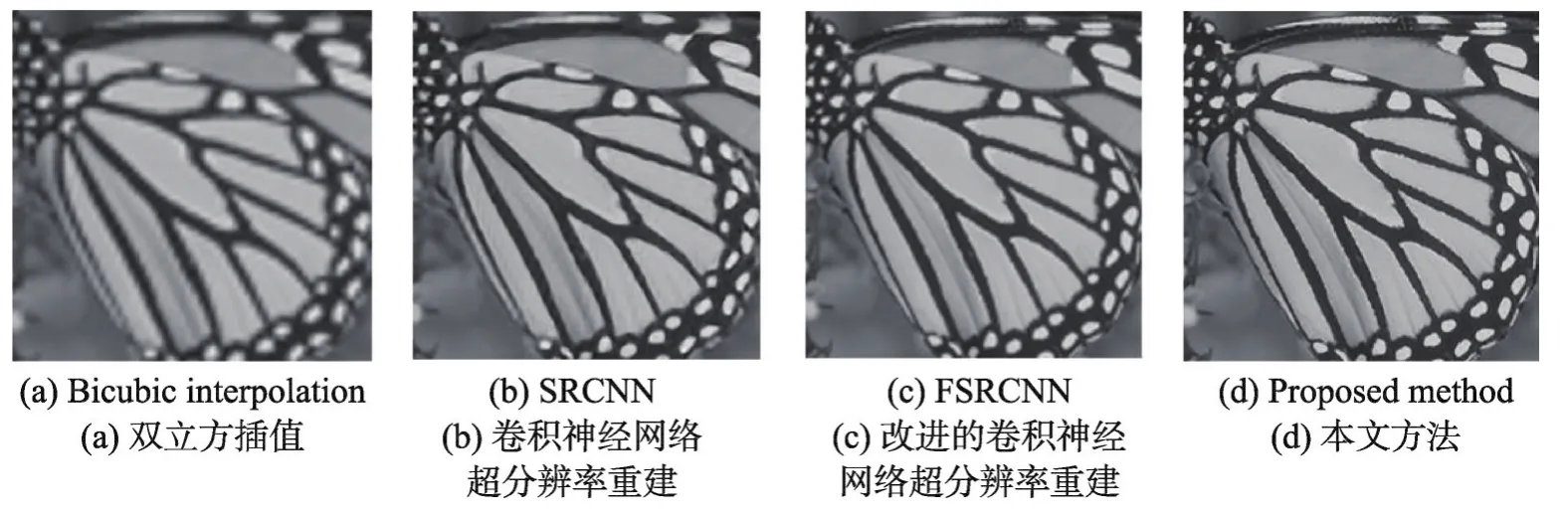

在放大倍數為3的情況下,對Set5和Set14測試集使用本文方法和其他3種算法分別重建的圖像結果如圖4、圖5所示。(a)圖為使用雙立方插值(bicubic interpolation)重建算法得到的圖像,(b)圖為使用基于CNN的超分辨率(SRCNN)重建算法得到的圖像,(c)圖為使用FSRCNN算法得到的圖像,(d)圖為使用本文方法得到的圖像。在Set5中的蝴蝶重建圖像對比圖中進行觀察,如圖4所示,(d)圖比(a)、(b)、(c)圖重建效果更好,細節表現更豐富,蝴蝶翅膀上的花斑表現得很清晰。在Set14中的狒狒重建圖像對比圖中進行觀察,如圖5所示,(d)圖比(a)、(b)、(c)圖在紋理細節區域表現得更好,狒狒的毛發看起來更清晰,沒有模糊感。在Set5、Set14測試集其他的圖像中也可以得到同樣的結果。因此,對同一幅圖像進行超分辨率重建時,與Bicubic算法相比,使用本文方法得到的圖像更清晰,細節表現得更豐富;與FSRCNN和SRCNN算法相比,在圖像紋理信息豐富的區域,使用本文方法得到的重建效果更好。

5 結束語

本文為了解決單幀圖像能夠在不同放大倍數的條件下得到更好的超分辨率重建效果,提出了一種Adam優化的卷積神經網絡超分辨率重建方法。該方法首先使用ISODATA聚類算法對訓練的圖像集進行分類處理,然后在Adam優化的卷積神經網絡中對輸入圖像進行特征提取和非線性映射得到特征映射圖,最后在Adam優化的卷積神經網絡中對特征映射圖進行反卷積重建得到多尺度放大的重建圖像。通過實驗驗證使用本文方法在不同放大倍數條件下的重構效果優于傳統算法,在視覺效果上有較好的表現。

Fig.4 Butterfly reconstruction image in Set 5 image圖4 Set 5中的蝴蝶重建對比圖

Fig.5 Baboon reconstruction image in Set 14 image圖5 Set 14中的狒狒重建對比圖