基于深度學習的棉花發育期自動觀測

胡錦濤 王苗苗 李濤 吳東麗 田東哲

摘要 精準農業是當今世界農業發展的新趨勢,實現精準農業的關鍵基礎是能夠實時準確地提取作物的生長信息以及確定生長環境狀態。現階段國內外利用圖像處理技術對作物生長信息的檢測,主要集中在病蟲害識別、雜草識別等方面,對作物生長期進行自動識別的相關技術鮮有報道。以棉花田間數字圖像為研究對象,結合深度學習的方法,對棉花關鍵發育期的自動觀測方法進行研究。結果表明,相較于傳統特征提取方法,提出了卷積神經網絡CNN-CGS模型對棉花圖像進行特征提取,并進一步結合遷移學習方法訓練網絡,獲得了更加準確的棉花生長期識別結果,同時也為農作物發育期和長勢識別邁向自動化發展提供技術支持,為及時掌握棉花生長狀況、開展農事活動和現代化農田管理提供新的思路。

關鍵詞 作物生長觀測;圖像識別;深度學習;卷積神經網絡

中圖分類號 TP391文獻標識碼 A

文章編號 0517-6611(2019)11-0237-04

doi:10.3969/j.issn.0517-6611.2019.11.068

開放科學(資源服務)標識碼(OSID):

Abstract Precision agriculture is a trend of current agricultural development, the key to achieve that is the ability to accurately extract crop growth information and determine the state of the growing environment in real time.? Most detection methods based on image processing technology for crop growth information mainly focuses on the identification of pests, diseases and weeds. There are few reports on the automatic detection of crop growth period.? In this research, the digital image of cotton field was taken as the research object, and the automatic observation method of key development period of cotton was studied through deep learning method. Compared with the traditional feature extraction methods, we adopted the convolutional neural network(CNN) to extract the features of cotton images, and further combined the transfer learning method to train CNN, which obtained more accurate cotton growth period identification results. Meanwhile, it also provided technical support for the automatic identification of crop growth stages and states. On the other hand, a new idea was presented for realtime acquisition of cotton growth status, development of agricultural activities and modern farmland management, and scientific assessment of the impact of meteorological factors on cotton.

Key words Crop observation;Image recognition;Deep learning;Convolutional neural network

作者簡介 胡錦濤(1987—),男,河南鄭州人,工程師,碩士,從事硬件設計和算法研究。*通信作者,工程師,碩士,從事圖像處理研究。

收稿日期 2019-01-10

作物觀測是農業氣象觀測的重要組成部分。通過作物的觀測,鑒定農業氣象條件對作物生長發育和產量形成及品質的影響,為農業氣象情報、預報,以及作物的氣候評價等提供依據,為高產、優質、高效農業服務。棉花作為重要的經濟作物之一,對其發育期進行自動觀測技術研究具有重要意義。現階段棉花發育期信息的獲取主要依靠人工觀測,觀測人員按照農業氣象觀測規范中的定義和描述,對田間作物進行實地的目測或簡單的器測。這種方式耗時、費力,主觀性強且無法進行連續觀測,同時還容易破環作物及其生長環境。因此,亟需一種自動連續、非破壞性的記錄方法來對棉花的發育期進行觀測。結合計算機視覺技術在田間架構成像設備,成為了解決上述問題的有效途徑之一。由于其具有成本低、直觀、非接觸式等優點,已被逐漸應用于農業自動化的各個領域,例如病蟲害檢測識別、田間雜草識別、作物等級劃分等。研究人員通過提取無土栽培番茄葉片圖像的顏色特征,以及圖像中不易被肉眼發現的顏色變化來判斷作物缺乏的營養元素類型,及時采取相應措施減少生產損失[1-2]。吳茜[2]、李少昆等[3]研究了麥田圖像色調值與中后期小麥長勢的相關性,將圖像處理技術與人工神經網絡技術相結合應用到小麥群體綠色面積和綠色葉面積特征的圖像識別中,對小麥苗情進行自動化快速診斷,該方法也可用于稻谷等其他作物群體特征及病斑、株型、外觀品質等類似目標的識別研究。毛文華等[4]針對苗期田間植物的位置特征,提出了基于計算機視覺技術的算法DBW,對苗期田間雜草進行分割和識別。盡管計算機視覺在上述領域中已經取得較大的研究進展,并成功投入實際的生產過程中,但由于在棉花田間拍攝的靜態圖像只能反映棉花田間的部分信息,導致其并不能完整地反映農業氣象觀測規范中對每個發育期所定義的特點。其次,田間圖像受光照和背景影響較大。不同光照強度下的圖像特征也不同,且背景中的土壤、雜草、薄膜等容易對目標檢測造成很大的干擾,因此自然環境下的棉花圖像特征提取對算法的魯棒性和抗干擾性要求較高,導致了利用計算機視覺技術以及田間架構成像設備對棉花發育期觀測的研究無法順利開展,尤其利用圖像處理技術檢測識別棉花發育期的相關工作在現有文獻中尚鮮見報道。

深度學習作為機器學習領域中的熱門方向,近年來在計算機視覺、語音識別等多類應用中均取得了突破性的進展。其中,深度學習架構由多層非線性運算單元組成,每個較低層的輸出作為更高層的輸入,可以從大量輸入數據中學習有效的特征表示,學習到的高階表示包含輸入數據的結構信息,展現出了強大的從少數樣本集中學習數據集本質特征的能力,近年來已逐漸應用到了計算機視覺領域的方方面面[5-14],并且展現出了很強的優越性。

深度學習展現出的強大的特征提取能力,為該研究的基于計算機視覺的棉花發育期自動觀測方法提出了新思路。鑒于此,筆者以棉花田間數字圖像為研究對象,通過構建的棉花數據集對預先訓練的卷積神經網絡模型進行微調,從而實現利用卷積神經網絡對棉花關鍵發育期的自動觀測,該方法不僅解決了現有棉花圖像數據不充足的問題,還大大提高了網絡模型的收斂速度。相較于傳統的圖像識別方法,該研究提出的基于深度學習的棉花發育期自動觀測方法顯著提高了棉花發育期的識別精度。

1 數據與方法

1.1 數據來源

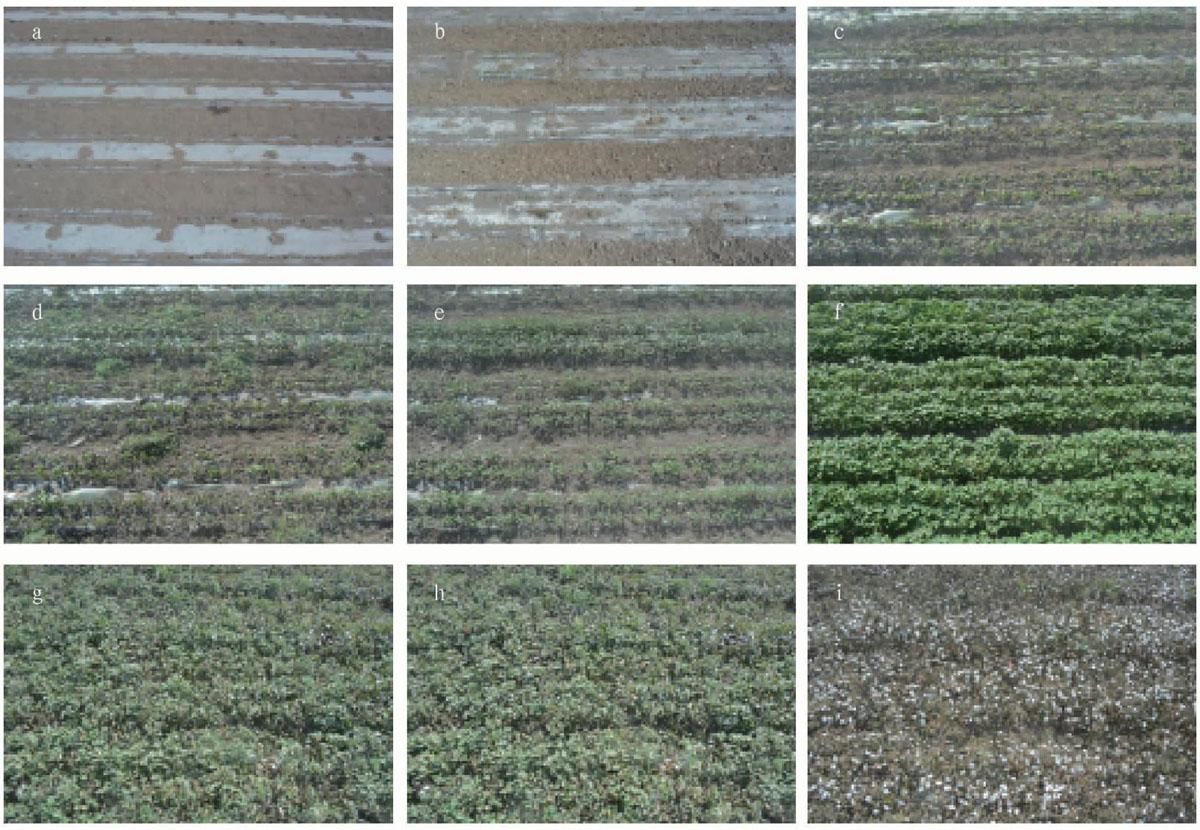

訓練集和測試集均來源于新疆烏蘭烏蘇實驗站的作物生長自動監測系統。通過安裝在農業站上的攝像機獲得特定區域的棉花特寫鏡頭,設定每日9:00、10:00、11:00、12:00、13:00、14:00、15:00、16:00共8個時間點進行自動拍攝棉花生長圖像,圖像分辨率3 648×2 736,彩色,JPG格式。在2013—2018年棉花的生長期內,數據庫中累積了數萬張圖像,涵蓋了棉花的播種期、出苗期、三真葉期、五真葉期、現蕾期、開花期、裂鈴期、吐絮期和停止生長期9種發育期以及不同場景的棉花圖像,確保了該數據訓練的網絡能夠具有很好的魯棒性。同時為了增加訓練數據,使訓練出的網絡具有更好的抗旋轉、平移和縮放不變性,訓練前對訓練數據集進行數據增強操作,包括隨機旋轉圖像,范圍±30°;左右鏡像翻轉圖像;水平、垂直平移圖像,范圍±30像素。試驗中從數據庫選取了8 000張棉花圖像構建訓練數據集,1 025張棉花圖像構建測試數據集。其中訓練集和測試集均涵蓋了棉花的9種發育期,數據集樣例如圖1所示。同時還進一步將每張圖像分割成大小為的圖像塊,這樣在網絡的訓練過程中,卷積層可以對每個圖像塊進行特征提取,不僅保證了圖像數據的充足性,還簡化了網絡的計算量。

47卷11期 胡錦濤等 基于深度學習的棉花發育期自動觀測

1.2 棉花發育期的識別

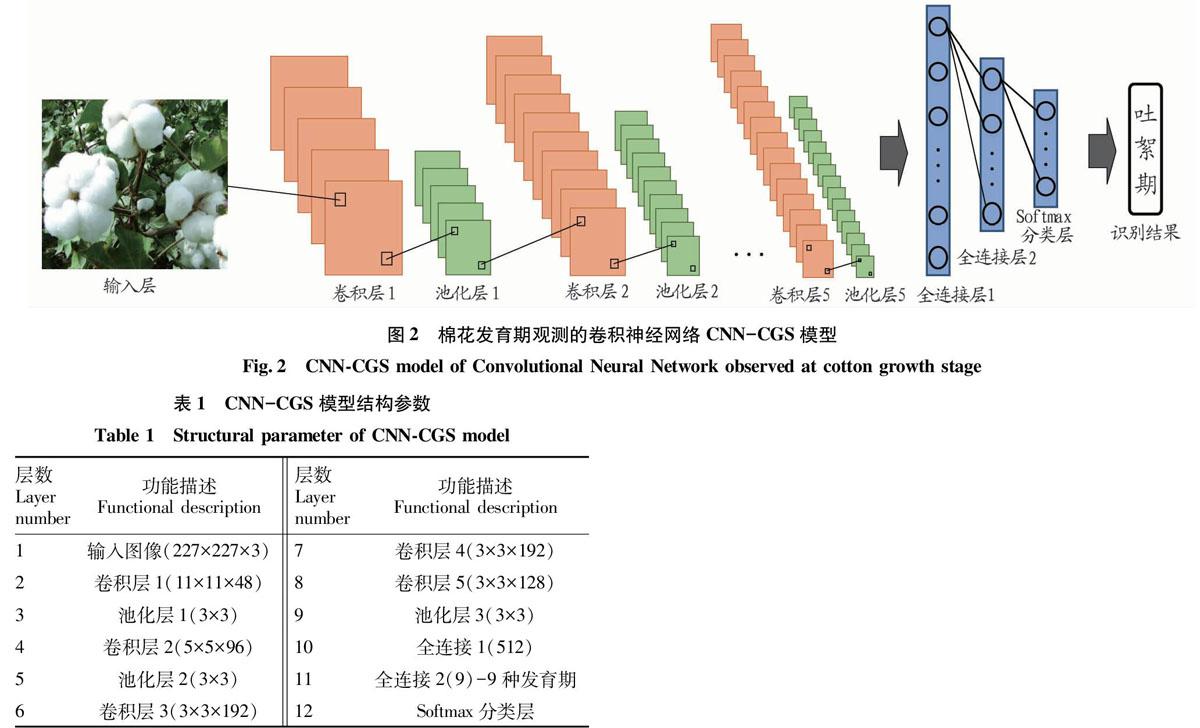

卷積神經網絡(Convolutional Neural Network,CNN)作為第一個真正成功地采用多層次結構網絡的深度學習方法,具有結構簡單、訓練參數少和適應性強等特點。實現棉花發育期觀測的卷積神經網絡CNN-CGS模型如圖2所示。該模型包含1個輸入層、5個卷積層、3個池化層、2個全連接層和1個Softmax分類層。具體每一層的規格大小設定如表1所示,其中輸入層可以直接對原始輸入數據進行處理,輸入的就是圖像的像素值,輸入圖像大小為227×227×3;卷積層作用就是通過卷積核對輸入圖像進行卷積操作實現對輸入信號特定模式的觀測,卷積核的數量越多,相應可提取輸入數據的特征信息也更多,所以卷積層也叫做特征提取層。池化層的輸入一般來源于上一個卷積層,是一個降采樣的操作,主要作用是使網絡具有很強的魯棒性,并且減少了參數的數量,加快了網絡的收斂速度,同時防止了過擬合現象的發生;全連接層實際上就是多層感知機的隱含層部分。通常情況下后面層的神經節點都和前一層的每一個神經節點連接,同一層的神經元節點之間是沒有連接的。每一層的神經元節點分別通過連接線上的權值進行前向傳播,加權組合得到下一層神經元節點的輸入。最后是softmax分類層進行棉花發育期分類,輸出最終的發育期識別結果。

由于深度卷積神經網絡參數多、特征數量大,因此需要大量的圖像數據進行訓練。一般中型網絡的訓練需要的數據量就已達到的百萬級,數據量不足往往會導致網絡過擬合。但該研究構建的棉花數據集圖像數量顯然無法滿足訓練上述卷積神經網絡模型的要求,因此該研究采用深度學習中的遷移學習方法進行網絡模型的訓練和微調。ImageNet數據集[20]是目前深度學習圖像領域應用中被使用最多的數據集,關于圖像分類、定位、檢測等研究工作大多基于此數據集展開,該數據集有1 400多萬幅圖片,涵蓋2萬多個類別,其中有超過百萬的圖片有明確的類別標注和圖像中物體位置的標注。筆者選用該數據集初步預訓練CNN-CGS,待網絡收斂后,保存初步預訓練的模型,再將構建的棉花數據集對預訓練的CNN-CGS進行二次訓練微調。但由于該研究所要識別的棉花圖像數據量少,且同ImageNet數據集中的對象類別差異較大,因此根據新的數據集二次訓練并定制更高層是很重要的,同時由于預訓練CNN-CGS模型的初始1~2層主要學習最基本的圖像特征(例如顏色、邊緣等),所以在微調過程中將其濾波器參數固定不變,其余卷積層的濾波器參數值通過新的網絡訓練進行更新,試驗中設計的具體的微調過程如圖3所示。在用棉花數據集對CNN-CGS模型進行網絡微調過程中,對CNN-CGS模型先后設計了3次迭代訓練。第1次網絡迭代訓練中,固定網絡的1~4層的權重參數,使用棉花數據集訓練更新第5層的濾波器權重參數;第2次網絡訓練中,將第1次迭代訓練得到的CNN-CGS模型作為新的預訓練模型,然后固定網絡的1~3層濾波器參數,再次使用棉花數據集對4~5層濾波器進行參數更新;按同樣的方法,在第3次網絡訓練中,先使用第2次迭代訓練得到的卷積層權重參數對CNN-CGS模型進行初始化,然后固定網絡的1~2層參數,訓練更新3~5層濾波器參數。這樣經過3次迭代訓練CNN-CGS模型在棉花圖像數據不充足的情況下,能夠實現很好的收斂,并將其用于之后的棉花發育期識別精度的測試。這種微調方法不僅解決了現有棉花數據集不充足的問題,還大大提高了網絡收斂速度。特別在網絡訓練過程中,除最后一層卷積層學習率初始化設為0001外,其他所有卷積層的學習率均初始化為0.010。當驗證誤差率在當前學習率下不再提高時,就將學習率除以10。具體棉花發育期識別訓練過程中,CNN-CGS模型學習率下降了2次。

1.3 仿真實驗平臺

仿真平臺為64位window7操作系統,硬件環境為內存16 G,Intel(R)Xeon(R)E5-1607,GPU NVIDIA Quadro K600。選用的深度學習開源架構為MatConvNet,并通過MatConvNet[21]調用GPU實現卷積神經網絡的并行運算。

2 結果與分析

為了評估基于卷積神經網絡方法在棉花發育期識別方面的性能和效率,在測試過程中加入了基于手動特征提取的典型機器學習方法與該研究提出的基于卷積神經網絡的方法進行比較。其中基于手動特征提取的機器學習方法主要通過提取基于GLCM特征和HOG特征的紋理特征,并將其組合成特征集輸入到由樸素貝葉斯分類器(Nave-Bayes)組成的機器學習算法中[22],從而實現棉花發育期的識別。具體的測試數據集的發育期分類結果如表2所示,其中正確分類895,錯誤分類130個,采用卷積神經網絡的方法在棉花發育期識別結果精度達到了87.32%、召回率達到86.14%、F1分數達到了86.58%、準確度高達86.54%,這些都明顯高于基于手動特征提取的方法,證明了深度學習方法在棉花發育期識別方面的有效性。由于卷積神經網絡最初是為物體識別而設計的,試驗結果顯示卷積神經網絡在棉花的識別上也獲得了很高的識別精度,證明了基于卷積神經網絡的方法在捕獲圖像的紋理特征方面的優越性。同時由于結合了GPU并行計算方法,基于卷積神經網絡的方法在識別速度上也遠遠超過基于手動特征提取方法。試驗結果還表明基于卷積神經網絡的方法和基于手動特征提取的方法在棉花的播種期和出苗期識別精度相對較低,通過研究發現在棉花的早期生長階段,圖像中大部分是土壤信息,使得這兩個發育期圖像的土壤特征都是相似的,加大了棉花發育期的識別難度。由于棉花在之后的發育期具有非常獨特的特征屬性,因此CNN-CGS模型對于后面的棉花發育期識別精度較高。

使用卷積神經網絡的方法識別棉花的發育期有以下優勢:①基于深度學習的棉花發育期識別方法直接聯合優化了所有的卷積層,具有結構輕量、各組件優化同步識別速度快等優點;②基于深度學習的方法以新的視角深度挖掘與棉花發育期之間的內在聯系,具有較高的棉花發育期識別精度;③基于深度學習的方法可以對單一圖像進行識別,不要求相鄰圖像數據提供額外的發育期信息,且可以對不同場景的棉花圖像進行識別。同時該研究僅使用簡單的CNN-CGS模型進行了棉花發育期的識別,進一步引入更深層、更復雜的模型將會得到更加高的識別精度,這也是該研究基于深度學習方法棉花發育期識別未來的研究方向。

基于手動特征提取方法Extraction method based on manual feature81.74 80.7280.6680.89

3 小結

針對棉花發育期的自動觀測問題,該研究成功地將深度學習方法應用于棉花的發育期識別,實現了9種棉花發育期的自動觀測。首先構建了棉花圖像數據集,并提出了用于棉花發育期觀測的卷積神經網絡CNN-CGS模型,根據棉花圖像的特點對預訓練的CNN-CGS模型的部分卷積層設計了二次訓練微調過程,不僅解決了棉花圖像數據不充足問題,還簡化了網絡訓練,提高了網絡的魯棒性,防止了網絡的過擬合。為了評估基于深度學習方法在棉花發育期識別方面的性能和效率,該研究使用了基于手動特征提取的機器學習方法與提出的深度學習方法進行對比。試驗結果表明,基于深度學習的方法在棉花發育期的識別方面獲得了更加準確的識別結果,證明了深度學習方法在棉花發育期識別的有效性和優越性。未來的工作還將包括建立更深層的深度學習架構,特別是訓練用于不同農作物發育期識別的深度網絡模型。

參考文獻

[1] 徐貴力,毛罕平,李萍萍.缺素葉片彩色圖像顏色特征提取的研究[J].農業工程學報,2002,18(4):150-154.

[2] 吳茜.基于圖像處理技術的棉花發育期自動觀測研究[D].武漢:華中科技大學,2013.

[3] 李少昆,索興梅,白中英,等.基于BP神經網絡的小麥群體圖像特征識別[J].中國農業科學,2002,35(6):616-620.

[4] 毛文華,王一鳴,張小超,等.基于機器視覺的苗期雜草實時分割算法[J].農業機械學報,2005,36(1):83-86.

[5] KRIZHEVSKY A,SUTSKEVER I,HINTON G E.Imagenet classification with deep convolutional neural networks[J].Advances in neural information processing systems,2012,25(2):1097-1105.

[6] KIM J,LEE J K,LEE K M.Deeplyrecursive convolutional network for image superresolution[C]//Proceedings of the IEEE conference on computer vision and pattern recognition.Las Vegas,NV,SUA:IEEE,2016:1637-1645.

[7] SZEGEDY C,LIU W,JIA Y Q,et al.Going deeper with convolutions[C]//Proceedings of the IEEE conference on computer vision and pattern recognition.Boston,MA,USA:IEEE,2015:1-9.

[8] KARPATHY A,TODERICI G,SHETTY S,et al.Largescale video classification with convolutional neural networks[C]//Proceedings of the IEEE conference on computer vision and pattern recognition.Columbus,Ohio,USA:Curran Associates,Inc.,2014:1725-1732.

[9] SZEGEDY C,TOSHEV A,ERHAN D.Deep neural networks for object detection[C]//BURAES C J C,BOTTOU L,WELLING M,et al.Advances in neural information processing systems.Lake Tahoe,Nevada,USA:TwentySeventh Annual Conference on Neural Information Processing System,2013:2553-2561.

[10] ALEXANDRE L A.3D object recognition using convolutional neural networks with transfer learning between input channels[C]//MENEGATTI E,MICHAEL N,BERNS K,et al.Intelligent autonomous systems 13.Switzerland:Springer International Publishing,2016:889-898.

[11] CHEN L C,BARRON J T,PAPANDREOU G,et al.Semantic image segmentation with taskspecific edge detection using cnns and a discriminatively trained domain transform[C]//Proceedings of the IEEE conference on computer vision and pattern recognition.Las Vegas,NV,SUA:IEEE,2016:4545-4554.

[12] SCHULZ H,BEHNKE S.Learning objectclass segmentation with convolutional neural networks[C]//Proceedings of European symposium on artificial neural networks,computational intelligence and machine learning.Bruges:ESANN,2012.

[13] LONG J,SHELHAMER E,DARRELL T.Fully convolutional networks for semantic segmentation[C]//Proceedings of the IEEE conference on computer vision and pattern recognition.Boston,MA,USA:IEEE,2015:3431-3440.

[14] GIRSHICK R,DONAHUE J,DARRELL T,et al.Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of the IEEE conference on computer vision and pattern recognition.Columbus,Ohio,USA:Curran Associates,Inc.,2014:580-587.

安徽農業科學,J.Anhui Agric.Sci. 2019,47(11):241-243