基于級聯卷積神經網絡的大場景遙感圖像艦船目標快速檢測方法

陳慧元 劉澤宇 郭煒煒 張增輝 郁文賢(上海交通大學電子信息與電氣工程學院 上海 200240)(同濟大學同濟–MIT城市科學國際聯合實驗室 上海 200243)

1 引言

遙感圖像目標檢測是遙感技術領域研究的重要課題之一,基于遙感圖像的艦船檢測在民用和軍事領域得到廣泛關注。傳統的遙感圖像目標檢測方法主要采用從粗到細的多步驟策略,一般包括預處理、海陸分割、感興趣區域提取、目標鑒別等[1,2]。這種多步驟策略各步驟之間相互獨立,每一步驟需要針對具體問題,設計相應的解決方案,存在流程固化、自動化、智能化程度不足等問題。目前,深度學習技術由于其強大的特征表示和端到端的學習能力使得目標檢測性能有了極大地提升[3]。通常,基于深度學習的目標檢測方法首先也是從圖像中提取候選區域,然后采用卷積神經網絡(Convolution Neural Network, CNN)等深度神經網絡對候選區域進行鑒別和邊界框回歸,例如,文獻[4,5]提出的區域卷積神經網絡(Region-based Convolutional Neural network method, RCN)、快速區域卷積神經網絡(Fast Region-based Convolutional Neural network method, Fast-RCN),使用selective search的方法產生候選區域,然后用CNN網絡對候選區域進行分類。但是selective search方法中候選區域重疊,產生冗余,且無法在GPU上訓練,檢測效率低[6]。隨后,文獻[7,8]提出Faster-RCNN檢測網絡,其首先通過一個區域生成網絡 (Region Propsal Network, RPN)來產生候選區域,然后再采用一個分類網絡對候選區域進行分類和邊界框回歸,并且RPN網絡和分類網絡共享底層的特征提取層,極大地提升了訓練速率。文獻[9]中提出的YOLO網絡,將物體檢測作為回歸問題求解,完成從原始圖像的輸入到物體位置和類別的輸出,提高了目標檢測速度,但是對于小目標的檢測效果較差。CNN的計算瓶頸主要在于高維全連接層,其不僅參數多,計算復雜度高,容易導致過擬合,而且需要同樣大小的圖像輸入,因此文獻[10,11]提出了基于全卷積網絡結構(Fully Convolutional Neural network, FCN)的目標檢測方法,其主要特點是去除了CNN中的全連接層并對末層特征進行多層的反卷積,生成與輸入圖像分辨率一致的輸出層,實現了圖像的像素級分類,可以達到更好的檢測效果。

針對大尺寸遙感圖像的艦船檢測,由于遙感圖像尺寸較大(一般包含百萬以上的像素點),而艦船目標在遙感圖像中稀疏分布且相對尺寸較小,如果直接將圖像輸入到上述神經網絡中進行處理,往往是不可行的。因此,目前針對大場景遙感圖像下的艦船檢測,主要使用滑窗的方法將大圖分割為切片后送入到深度網絡中檢測。但是滑窗法存在大量的冗余計算,且對于滑窗參數(窗口大小、滑動間隔步長)的選擇依賴性太高,影響目標的檢測效率和檢測精度[12,13]。因此,本文提出一種級聯型的全卷積網絡模型,將兩個全卷積網絡級聯,第1個網絡是一個簡單的全卷積分類網絡,實現大尺寸圖像中船/非船區域的篩選;第2個網絡是一個改進的UNet 結構,通過在傳統U-Net結構中加入目標掩膜和艦船朝向估計層以進行多任務的學習, 實現任意朝向艦船目標的精細定位。

2 方法

深度學習的方法在處理大尺寸遙感圖像時,為了降低計算量、提高檢測精度,首先采用滑窗的方法將大圖分割為切片,然后將切片送入到Faster-RCNN, YOLO等神經網絡模型中進行檢測。但是滑窗法的使用出現大量冗余信息,嚴重影響檢測效率,且對滑窗參數依賴性比較大,可能出現漏船、船體截斷的現象。

基于以上考慮,對于大場景遙感圖像檢測,本文設計了一種級聯型的全卷積網絡結構,圖1為網絡總體的框架圖。目標預篩選全卷積網絡(FCN for Prescreening, P-FCN)和目標精確檢測全卷積網絡(FCN for Detection, D-FCN)是兩個級聯的全卷積網絡,P-FCN利用深度學習的方法實現了傳統檢測方法中的預篩選功能。將一張大尺寸的遙感圖像輸入P-FCN中后,得到包含艦船位置信息的熱點圖(heatmap),根據熱點圖得到疑似有船的候選區域,將候選區域送入到D-FCN網絡中進行精確的艦船檢測,最終通過兩個級聯的網絡實現了對于大尺寸遙感圖像下的目標快速檢測。

2.1 P-FCN

2.1.1 P-FCN網絡結構

P-FCN主要完成傳統目標檢測步驟中的預篩選功能,是一個簡單的圖像分類網絡。與傳統FCN網絡不同,P-FCN不需要像素級分類即可實現目標預篩選,因此P-FCN不包含反卷積過程。為了滿足檢測速度的要求,將P-FCN設計為一個簡單的4層全卷積結構,包含3個卷積層和1個池化層。如圖1所示,P-FCN結構圖中,Conv1卷積核大小為5×5,步長為4, Padding模式為“SAME”;Conv2卷積核大小為5×5,步長為4, Padding模式為“SAME”; Conv3卷積核大小為4×4,步長為1,Padding模式為“VALID”; Pooling1中卷積核大小為2×2,步長為2, Padding模式為“SAME”。

圖2為P-FCN整體實驗過程,主要分為測試和訓練兩個部分。訓練時,將分為船和背景兩類、尺寸為128×128的遙感圖像輸入到P-FCN網絡中,得到包含船和背景特征的預訓練模型。測試時,將尺寸為[W,H] (W為圖像寬、H為圖像長)圖像,輸入

到預訓練模型中,得到包含艦船位置信息的熱點圖。由于P-FCN中Conv1, Conv2, Pooling1中的Padding模式均為“SAME”,其輸出特征圖大小僅與步長有關。圖像經過Conv2后,輸出特征圖尺寸見式(1)。Conv3中Padding模式為“VALID”,其輸出尺寸與步長、卷積核尺寸均有關,圖像經過Conv3后,最終輸出熱點圖尺寸見式(2)。其中[W,H]為原圖尺寸,[WConv2,HConv2]為經過Conv2后特征圖尺寸, [WConv3,HConv3]為經過Conv3后特征圖尺寸, [Wf3,Hf3]為Conv3卷積核尺寸,Sf3為Conv3卷積步長,為向上取整符號。

為了得到原始圖像中的艦船疑似位置,本文使用雙線性插值方法將熱點圖變換到原圖尺寸。最后對熱點圖進行連通域分析、候選框篩選等圖像處理,得到疑似包含船的候選區域,實現快速預篩選功能。

圖1 級聯型網絡總體架構圖Fig.1 The overall frame structure of cascading network

圖2 P-FCN實驗過程Fig.2 The experimental process of P-FCN

由于P-FCN網絡測試過程中,輸入圖像尺寸較大(均包含百萬像素點),因此,本文在測試前通過對不同分辨率的圖像設置不同的resize參數值(S),使得在保證一定準確率的情況下提高檢測速度。圖像resize公式為

其中,S為resize參數,W,H為原圖尺寸,Wnew,Hnew為resize后圖像尺寸。

2.1.2 P-FCN損失函數

由于網絡是一個級聯型的結構,兩個網絡結構單獨訓練,因此需要分別計算損失函數。P-FCN不是一個傳統的FCN網絡,不包含反卷積過程。訓練時,輸入圖像尺寸為128×128,經過P-FCN后,輸出尺寸為1×2,即實現艦船、背景的二分類。P-FCN使用交叉熵計算損失,式(4)為P-FCN中損失函數的計算公式,需要優化的目標函數是整個數據集中所有數據loss求和。其中N表示訓練集中樣本個數,表示圖像真實的標簽,表示預測標簽。

2.2 D-FCN

2.2.1 D-FCN網絡結構

D-FCN是一個改進的U-Net結構,圖3為D-FCN結構圖。D-FCN主要分為3個部分:特征提取、特征融合以及結果輸出。在特征提取中為了避免訓練過程中可能出現的過擬合以及梯度爆炸等問題,采用遷移學習的方法,通過借鑒ResNet50模型,完成對特征提取網絡的初始化。特征融合部分借鑒了U-Net思想,在FCN的基礎上,融合了卷積網絡中高維和低維的特征,實現圖像像素級分類的同時,提高了檢測精度。結果輸出部分,通過3個1×1的卷積層,分別得到1通道的置信分數圖、4通道的矩形框邊界信息圖以及1通道的艦船旋轉角度圖。

傳統U-Net模型在訓練中將網絡中的底層特征與原圖對比構建損失函數,再利用反向傳播算法對模型參數進行迭代更新。但是根據反向傳播算法原理,模型中最靠近損失約束的參數將優先得到更新,其他參數的更新幅度會隨著傳播距離的拉長而逐漸衰減,這就導致了傳統的U-Net 模型在訓練時偏重底層參數的更新,對頂層的參數優化程度相對較差[11]。據此,本文通過在模型頂層引入額外的損失約束,使不同層級的參數都能得到較好的優化,從而進一步提升檢測精度。

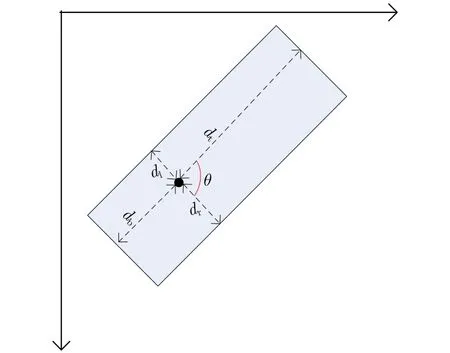

2.2.2 旋轉矩形框定位

艦船目標旋轉矩形框定位需要兩個參數:艦船朝向角度和矩形框邊界信息。在D-FCN網絡中,首先對訓練數據中的艦船目標按照順時針方向,使用旋轉矩形框對頂點坐標進行標注,然后根據標注信息生成目標掩膜,見圖4,其中圖4(a)為原始圖像,圖4(b)為根據真值坐標生成的目標掩膜,圖4(c)為訓練中得到的預測掩膜。最后對目標掩膜中的每個像素點定義為

圖3 D-FCN結構圖Fig.3 The frame structure of D-FCN

圖4 SAR圖像與光學圖像中真值目標掩膜與預測目標掩膜生成Fig.4 The true target masks and the predictive target masks of SAR images and optical images

圖5 旋轉矩形框定位Fig.5 Rotating rectangle positioning

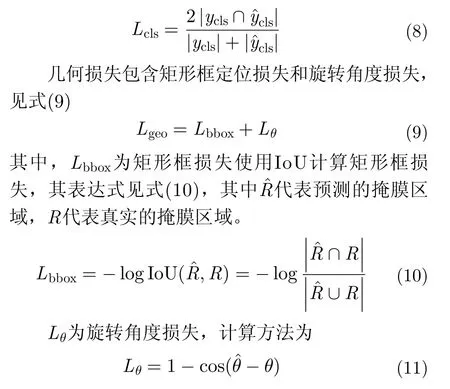

2.2.3 D-FCN損失函數

D-FCN是一個改進的U-Net結構,實現任意旋轉方向的艦船檢測,除了原有的底層損失外,加入了頂層損失,因此,D-FCN中總的損失函數為

其中,Lbottom為底層輸出結果與真值圖的損失值,Ltop為頂層輸出結果與相應低分辨率真值圖的損失值。頂層損失與底層損失的計算過程相同,以底層約束為例,其損失約束分為分類損失和幾何損失

其中,Lcls表示分類損失,在U-Net的預測圖中,每個像素點的值代表艦船的置信分數,本文將大于0.5的值設置為255,得到預測掩模。使用Diss Loss方法通過將預測掩模與真實掩模作比較,構建分類損失函數見式(8),其中ycls代表真實掩模,y^cls代表預測掩模

3 實驗過程與分析

本文主要針對大尺寸遙感圖像艦船檢測設計一種級聯型網絡結構,實現艦船位置快速預篩選與艦船精確檢測。本文分別使用SAR圖像和高分辨率光學遙感圖像對網絡結構進行測試。在SAR艦船檢測實驗中,將級聯型網絡分別與滑窗法以及YOLO3網絡進行比較,驗證網絡性能。在高分辨率光學遙感圖像艦船檢測中,由于YOLO3只能獲得目標的正置邊界框,無法估計有朝向的艦船目標,因此只將級聯型網絡與傳統滑窗方法做對比,驗證網絡性能。

3.1 SAR圖像艦船檢測

3.1.1 數據集構建與分析

(1) 數據集構建

在SAR圖像目標檢測實驗中,主要包括從TerraSAR-X中獲取的8景數據(包括上海港、橫濱港、汕港等數據),具體圖像信息見表1。

表1 TerraSAR-X數據基本信息Tab.1 The basic information of TerraSAR-X

實驗過程主要分為訓練和測試兩個部分,訓練時,P-FCN使用包含船與背景的128×128尺寸圖像,包括7773張艦船圖片,11780張背景圖片。D-FCN使用512×512尺寸共4731張SAR圖像進行訓練。測試時,使用TerraSAR-X中截取的10張大尺寸遙感圖像(3000×3000以上)對網絡結構進行測試分析。

(2) P-FCN訓練數據集分析

P-FCN網絡主要針對大尺寸遙感圖像進行艦船位置預篩選,實現圖像分類功能。P-FCN訓練數據分為背景(負樣本)與艦船(正樣本)兩類,其中背景數據包括陸地、海岸、海面等類型,艦船數據包括簡單海洋背景目標、復雜海洋背景目標(包含海浪、浮標等)、靠岸目標、包含單個目標以及包含多個目標等類型。

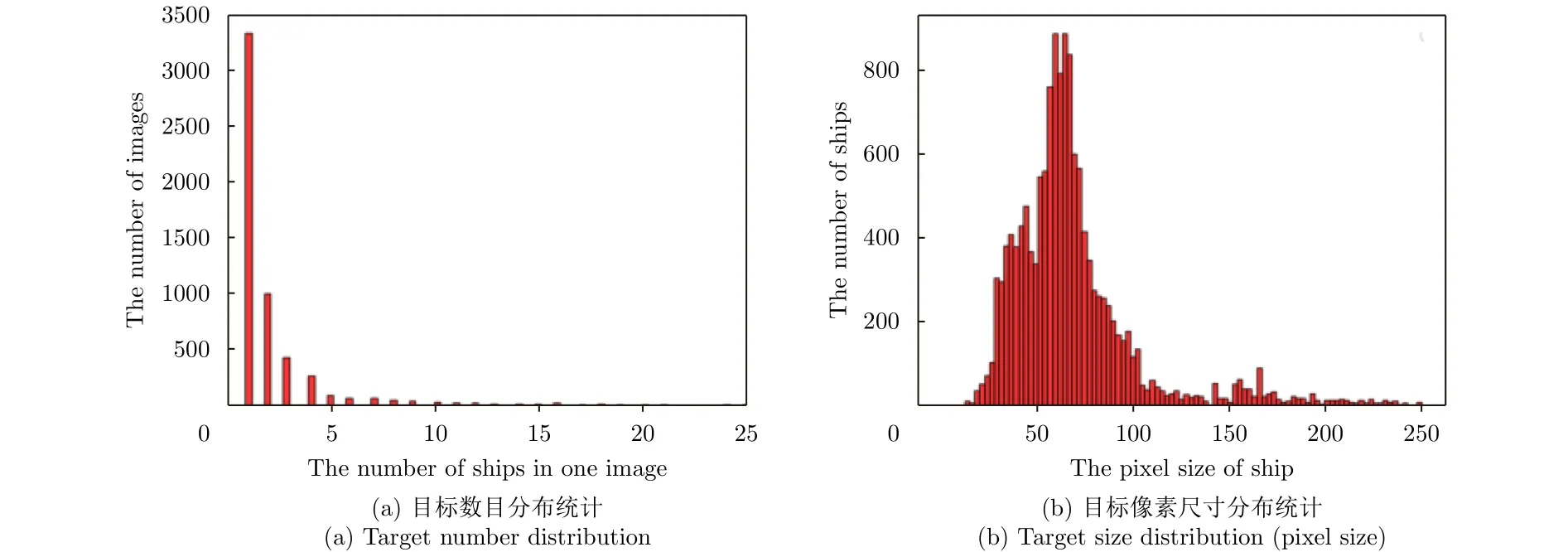

圖6為P-FCN訓練數據集統計,包括TerraSAR-X圖像中單張圖像包含目標數目統計以及目標像素尺寸統計。其中圖6(a)表示TerraSAR-X目標數目統計,圖6(b)表示TerraSAR-X目標像素尺寸統計。圖6表明P-FCN訓練數據集基本包含了所有艦船目標類型:包括不同目標數目、不同目標像素尺寸,滿足訓練要求。圖6(b)顯示訓練樣本中目標像素尺寸集中在128以內,對于尺寸大于128的目標類型,由于訓練樣本的作用是提取艦船特征,最終提取出的heatmap面積大于128,因此可以實現預篩選的功能。

3.1.2 實驗結果分析

(1) P-FCN測試圖像resize參數分析

本文針對大尺寸遙感圖像艦船檢測設計了一種全卷積網絡級聯結構,見圖1。其中P-FCN實現艦船位置快速預篩選,D-FCN實現艦船精確檢測。由于輸入圖像尺寸較大,嚴重影響檢測速度,因此,在P-FCN網絡測試前加入了圖像縮放過程,見圖2,通過設置resize參數值,在保證一定檢測精度的情況下,提高檢測速度。

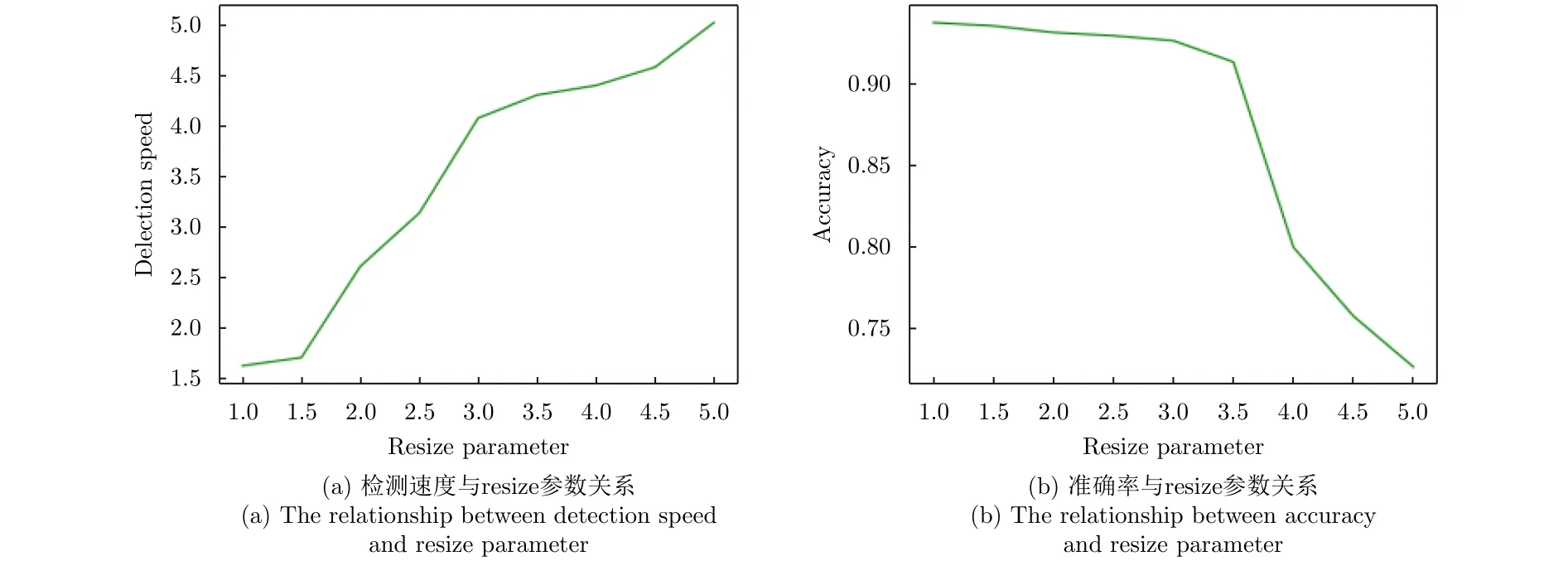

為了得到最優的resize參數,選取10張不同尺寸的SAR圖像進行測試。分別比較resize參數與檢測速度和準確率的關系,見圖7。其中圖7(a)表示resize參數與檢測速度的關系(檢測速度用檢測時間的倒數表示)。由于圖片尺寸不同,單張圖片測試速度差異較大,因此將檢測時間的單位設為s/1000×1000,即平均每1000×1000尺寸圖像所用時間。圖7(b)表示resize參數與準確率(召回率)的關系。

圖6 P-FCN訓練TerraSAR-X數據集統計Fig.6 The training TerraSAR-X dataset statistics of P-FCN

圖7 resize參數與檢測速度和準確率的關系Fig.7 The relationship of resize parameter between detection speed and accuracy

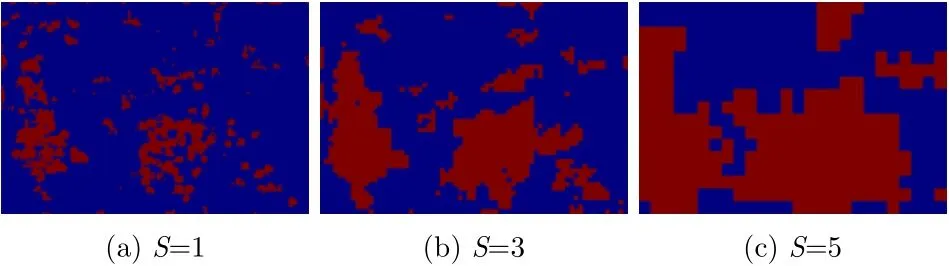

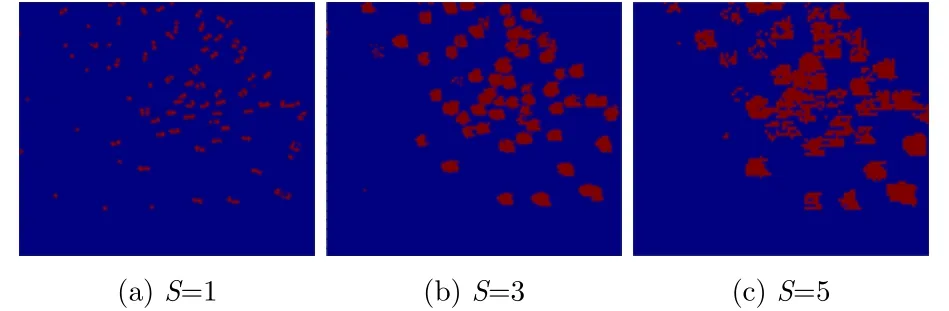

圖8、圖9分別展示了resize參數(S)為1, 3, 5時對應的熱點圖以及候選區域。根據圖7—圖9,對resize參數做如下分析:

圖8 S=1, 3, 5時對應的熱點圖Fig.8 The heat maps corresponding to S=1, 3, 5

圖9 S=1, 3, 5時對應的候選區域Fig.9 The probably proposals corresponding to S=1, 3, 5

(a) 圖8、圖9顯示,S=1時,P-FCN網絡能夠較精確的估計艦船所在位置,但是候選區域較多,且存在大量虛警,影響D-FCN中的檢測速度。S增大時,候選區域數量逐漸減少,且候選框面積增大。S=3時,候選區域相對較少,且能夠篩選出圖像中的所有船只,且虛警率較小,基本達到預篩選的要求。S=5時,候選框數量進一步減少,但是部分候選區域面積過大,影響D-FCN檢測速度,且由于圖像分辨率較低,預篩選時出現漏檢現象,影響檢測精度。

(b) 從圖7(a)中可以看出,在S=3之前,由于輸入圖像尺寸較大,影響檢測速度的主要是P-FCN網絡。進行圖像縮放后,由于計算量大量減少,因此,檢測速度加快。在S=3之后,P-FCN網絡對檢測速度的影響逐漸減小,D-FCN網絡對檢測速度的影響增大,根據(a)中的分析,隨著S增大,候選框面積增大(可以達到3000×5000左右),D-FCN中計算量較大,因此檢測速度增加相對平緩。從圖6(b)中可以看到,檢測準確率隨著S增大而降低。

根據以上分析,由于S=3時檢測速度相對較高,且準確率為0.928,基本滿足艦船檢測要求,因此,在P-FCN網絡中將resize參數值設為3。由于resize的目的是在保證一定檢測精度的前提下降低分辨率,提高檢測速度。從目前實驗結果中可以得到的結論為,分辨率降低為3 m時,不會影響檢測效果,因此對于其他分辨率圖像可按比例設置resize系數。

(2) 預篩選結果分析

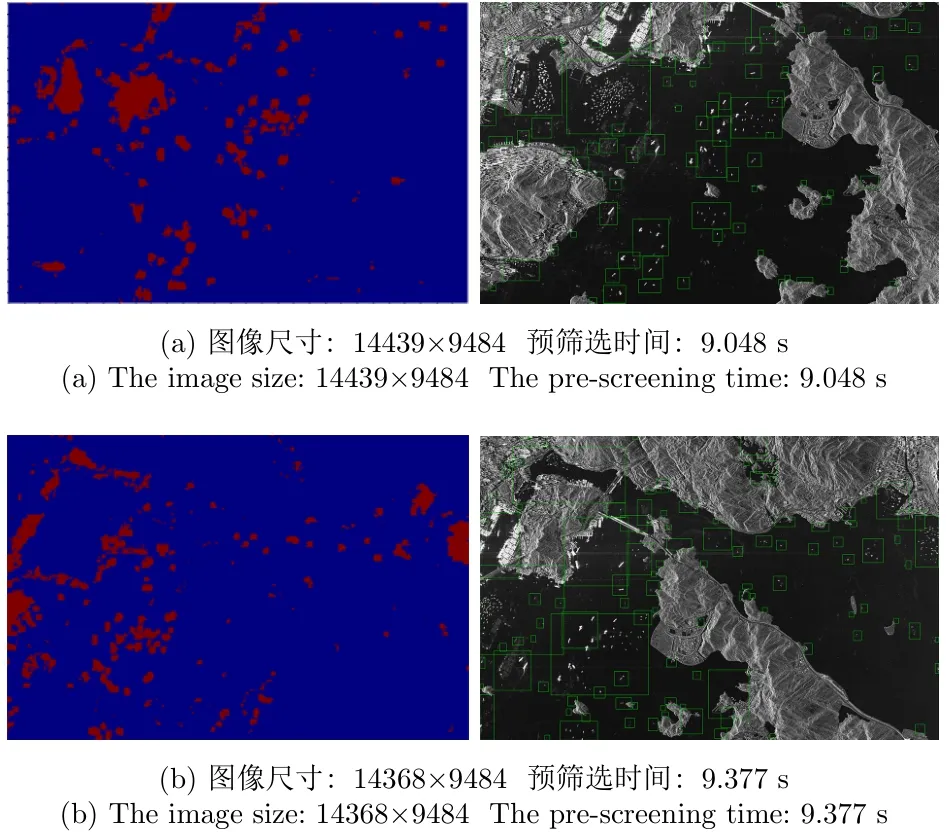

本文用到的級聯型網絡結構中,P-FCN網絡預篩選是針對大場景遙感圖像目標檢測的重要步驟,能夠實現對大場景遙感圖像中艦船位置快速預篩選功能,使得在保證檢測精度的情況下提升檢測速度。預篩選實驗主要對TerrSAR-X中截取的10張大尺寸圖片進行測試,實驗結果展示了具有代表性的兩張TerraSAR-X圖像(包含簡單環境與復雜環境下的目標),見圖10。圖10(a)圖片尺寸為14439×9484,預篩選時間為9.048 s(類型圖1),圖10(b)圖片尺寸為14368×9484,預篩選時間為9.377 s(類型圖2)。實驗結果顯示,P-FCN網絡能夠進行艦船位置的粗略預篩選,對海岸以及部分亮且細的海上建筑存在一定虛警,但是基本不存在漏檢情況,滿足檢測需求。

圖10 TerraSAR數據P-FCN測試結果Fig.10 The test result of TerraSAR in P-FCN

(3) 檢測結果分析

在艦船檢測實驗中,將級聯型網絡結構與滑窗法、YOLO3做對比。用召回率(Recall)、精確率(Precision)衡量檢測精度,用檢測時間衡量檢測效率。表2為對比實驗結果,由于測試圖片尺寸不一致,因此檢測時間單位設為s/1000×1000。其中級聯網絡檢測時間包括預篩選時間與D-FCN精確檢測時間之和;滑窗法檢測時間包括滑窗時間與D-FCN精確檢測時間之和;YOLO3檢測時間為YOLO3網絡目標精確檢測時間。表2結果顯示,級聯法由于使用P-FCN網絡進行預篩選,與滑窗法、YOLO3網絡相比,虛警較少,精確率較高。而相比滑窗法由于檢測冗余較少,檢測速度是滑窗法的2.35倍,相比YOLO3網絡,檢測召回率為0.928,檢測精度更高。

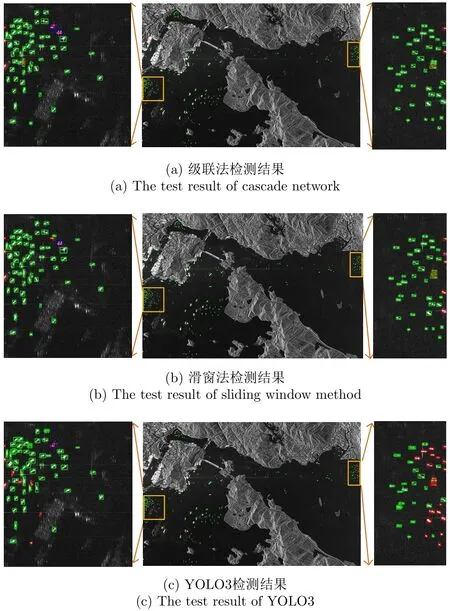

圖11、圖12為類型圖1、類型圖2檢測結果,圖11(a)(b)(c)、圖12(a)(b)(c)分別表示級聯法、滑窗法、YOLO3檢測結果,為了分析檢測結果,將部分檢測區域放大。其中綠色表示正確檢測、紅色表示漏警、藍色表示虛警。表3、表4為檢測結果統計,使用TP(正確檢測)、FN(漏警)、FP(虛警)、精確率、召回率、檢測時間分別對級聯法、滑窗法、YOLO3進行評價分析。根據檢測結果可以看到,級聯法相比滑窗法,召回率相似,但虛警較低,且檢測速度具有明顯的提升;相比YOLO3網絡,YOLO3具有很高的檢測速度,但圖11(c)、圖12(c)顯示,YOLO3對于復雜場景(并排、密集分布、小目標艦船)檢測效果較差,召回率較低。

3.2 光學遙感圖像艦船檢測

3.2.1 數據集構建與分析

(1) 數據集構建

在光學圖像目標檢測實驗中,主要包括從91衛圖和DOTA數據集中獲取的數據,分辨率均為1 m左右[14,15]。

表2 級聯型網絡結構、滑窗法、YOLO3檢測結果Tab.2 The test results of cascade network, sliding window method and YOLO3

圖11 類型圖1檢測結果Fig.11 The test results of type 1 image

實驗過程主要分為訓練和測試兩個部分,訓練時,P-FCN均使用包含船與背景的128×128尺寸圖像,包括4454張艦船圖片,14524張背景圖片。D-FCN使用512×512尺寸共3126張光學遙感圖像進行訓練,由于光學遙感圖像目標特征相對SAR圖像更加明顯,因此,對光學遙感圖像增加艦船旋轉角度信息。測試時,使用大尺寸遙感圖像(3000×3000以上)共50張光學遙感數據(包含10張DOTA數據和40張91衛圖數據)。

圖12 類型圖2檢測結果Fig.12 The test results of type 2 image

表3 類型圖1檢測結果統計Tab.3 The test results of type 1 image

表4 類型圖2檢測結果統計Tab.4 The test results of type 2 image

(2) P-FCN訓練數據集分析

針對光學圖像P-FCN數據集構建時,與SAR圖像相同,分為艦船與背景兩類,并且對于正負樣本的選擇同樣包括不同類型。

圖13為P-FCN訓練數據集統計,包括光學遙感圖像中單張圖像包含目標數目統計、目標像素尺寸統計以及目標朝向統計。其中圖13(a)表示光學圖像中單個樣本中目標數目統計,圖13(b)表示光學圖像中目標像素尺寸統計, 圖13(c)表示光學圖像中目標旋轉角度統計。圖13表明P-FCN訓練數據集基本包含了所有艦船目標類型:不同目標數目、不同目標像素尺寸以及不同目標旋轉方向,滿足訓練要求。

3.2.2 P-FCN測試圖像resize參數分析

針對大尺寸高分辨率光學遙感圖像艦船檢測,在P-FCN網絡預篩選過程中,本文選取10張不同尺寸的光學遙感圖像對resize參數的選取進行測試分析,分別比較了resize參數與檢測速度、準確率的關系,見圖14,圖14(a)表示resize參數與檢測速度關系,檢測速度用檢測時間倒數表示,同樣將檢測時間單位設為s/1000×1000,圖14(b)表示resize參數與準確率(召回率)的關系。圖15、圖16分別表示不同resize參數對應的熱點圖與候選區域。圖14—圖16顯示,S=3時,對于光學遙感圖像艦船檢測,檢測速度較高,且準確率為0.926,滿足艦船檢測要求。因此,在光學遙感圖像艦船檢測實驗中將resize參數設為3。

3.2.3 檢測結果分析

實驗過程中,使用50張尺寸不同的高分辨率光學遙感圖像對網絡性能進行驗證。由于YOLO3只能獲得目標的正置邊界框,對于有朝向的艦船目標不能估計有方向的邊界框,因此在光學圖像實驗中,只將級聯型網絡與傳統滑窗方法做對比。其中滑窗尺寸設置為512×512,步長設置為256,在結果分析中使用召回率衡量檢測精度,使用檢測時間(s/1000×1000)衡量檢測速度。檢測結果見表5。結果顯示,在大尺寸高分辨率光學遙感圖像艦船檢測中,級聯法與滑窗法檢測精度相似,但級聯法的檢測速度是滑窗法的3.34倍。

實驗結果中展示了具有代表性的3張大尺寸光學遙感圖像(包括密集、并排、靠岸艦船),包括PFCN網絡生成的熱點圖、候選區域預篩選結果,以及D-FCN精確檢測結果。由于光學圖像訓練時加入艦船旋轉角度信息,因此,檢測結果中包含艦船旋轉角預測,見圖17。圖17顯示針對大場景光學遙感圖像,級聯型網絡結構能夠對艦船位置進行快速預篩選,并且實現任意朝向艦船的精確定位,檢測速度較快,檢測精度較高,基本滿足目標檢測要求。

圖13 P-FCN 光學圖像訓練數據集統計Fig.13 The training dataset statistics of P-FCN

圖14 resize參數與檢測速度和準確率的關系Fig.14 The relationship of resize parameter between detection speed and accuracy

圖15 S=1, 3, 5時對應的熱點圖Fig.15 The heat maps corresponding to S=1, 3, 5

圖16 S=1, 3, 5時對應的候選區域Fig.16 The probably proposals corresponding to S=1, 3, 5

表5 滑窗法與級聯法檢測結果對比Tab.5 Comparison of sliding window and cascade method

4 結論

本文針對大場景遙感圖像下的艦船快速檢測,設計了一種級聯型的網絡結構。整體框架包括兩個全卷積網絡,第1個全卷積網絡(P-FCN)是一個簡單的二分類網絡,實現對于艦船位置的快速篩選功能;第2個網絡(D-FCN)是一個改進的U-Net結構,在傳統U-Net網絡中加入了頂層損失約束,使不同層級的模型參數均能得到較好地優化,提高檢測精度。為了降低大尺寸圖像在網絡中的計算量,測試時,在P-FCN網絡中加入了圖像縮放(resize)步驟,并且通過比較resize參數與檢測速度和檢測精度(召回率)的關系,找到最優參數,使得在滿足一定檢測精度的前提下,提高檢測速度。

圖17 級聯型網絡結構檢測結果Fig.17 The test results of the cascade network

實驗過程中,對級聯型網絡結構同時在TerraSAR圖像和光學圖像中進行了測試。在SAR艦船檢測實驗中,使用10張TerraSAR圖像,將級聯法與滑窗法、YOLO3進行對比分析,實驗結果表明:(1)級聯型網絡結構中P-FCN能夠進行艦船位置的快速預篩選,排除大量背景冗余信息,虛警率較低;(2)TerraSAR數據測試結果表明,相對于滑窗法,在檢測精度相當的情況下,本文的級聯網絡將檢測耗時縮短為原來的1/3左右;(3)YOLO3本質上屬于“one-step”的檢測方法,在檢測速度上有先天的優勢,但對于復雜場景的適應性差。在艦船密集排布、艦船尺寸多樣等場景中,檢測精度低,無法達到級聯網絡和滑窗法相同的精度水平。在光學遙感圖像艦船檢測實驗中,使用50張光學圖像將級聯法與滑窗法進行對比分析,結果顯示,在光學圖像中,級聯法在與滑窗法檢測精度相當的情況下,檢測耗時同樣縮短為原來的1/3左右。因此,本文所提級聯型網絡結構能夠在保證一定檢測精度的前提下,提升檢測速度,滿足檢測需求。