基于BP神經網絡的SCL譯碼研究①

盧麗金,李世寶

(中國石油大學(華東)計算機與通信工程學院,青島 266580)

Arikan 首次提出極化碼 (Polar Code),且極化碼是人類已知的第一種能夠被嚴格證明達到信道容量的信道編碼方法[1].在串行抵消(SC)譯碼算法下,極化碼的復雜度低、譯碼結構簡單.然而,SC譯碼算法在碼長為有限長的配置下,糾錯性能不理想.

為了提高極化碼的性能,引入置信度傳播[2,3]和線性規劃[4]算法,但,這兩種算法只適用于二進制輸入刪除信道 (BEC).隨后,I.Tal 和 A.Vardy 等提出串行抵消列表(SCL)算法[5,6],其性能非常接近最大似然(ML)的糾錯性能.為了進一步提高極化碼的糾錯能力,幾種解碼方法相繼被提出[7–9].其中,文獻[8]通過級聯循環冗余校驗(CRC)碼,SCL譯碼能夠獲得比Turbo碼和LDPC 碼更好的性能,并記為 CA-SCL.然而,其復雜度與列表大小L呈正比關系.為了降低復雜度,提出一種自適應的串行抵消列表(AD-SCL)譯碼[10],其復雜度不會隨著列表大小L的增大而增加.但是,在低信噪比下,AD-SCL會呈現明顯的高復雜度現象.AD-SCL總是把L的初始值設置為1.當L=1譯碼失敗時,ADSCL會將L更新為2L,并返回根節點,重新進行譯碼,直至L=Lmax.在信噪比較低的情況下,經過基于L=1的譯碼后,往往還需要更新L值.這樣無疑是增加了復雜度.值得考慮的是,由小到大的更新L能夠帶來明顯的低平均譯碼復雜度,這一優勢值得借鑒.如果L的初始值不固定為1,那么,就能夠解決現存的復雜度問題.因而,尋找L的最優初始值是本文的研究關鍵.若L的最優初始值的大小有l種可能,則相當于L的最優初始值有l種類別.在某一實驗配置下,L的最優初始值到底屬于哪一種類別,本文需要處理此問題.若在線階段采用傳統的追蹤記錄與概率統計方式來分類,需要進行大量的數據存儲和計算,將會大幅度增加復雜度,且此處理方式不適用于離線操作.BP神經網絡可以用作分類器[11,12]并實現快速、精確分類.若BP神經網絡的訓練和分類都是在線操作,也會大幅度增加復雜度,但可以離線訓練BP神經網絡,在線時將數據輸入到已完成訓練的BP神經網絡模型中,輸出一個類別,且不會增加復雜度.因此,本文確定采用BP神經網絡來尋找L的最優初始值.

本文的主要工作是介紹極化編碼、極化譯碼與BP神經網絡的相關原理,然后離線構建并訓練BP神經網絡以及在線尋找L的最優初始值,最后提出一種基于BP神經網絡的SCL譯碼算法.

1 相關原理

1.1 極化編碼與極化譯碼

1.1.1 極化編碼

信道極化將一個二進制輸入無記憶信道的一組獨立的時隙看作一組相互獨立的信道,通過信道分割、信道合并操作引入相關性.當參與信道極化的信道(時隙)數足夠多時,所得到的極化信道的信道容量會出現極化現象,即一部分信道的容量將會趨于1、其余趨于0.在信道極化的基礎上,只需要在一部分容量趨于1的信道上傳輸信息比特,而在剩下的容量趨于1的信道以及容量趨于0的信道上傳輸對收發端都己知的固定比特.

用符號W:X→Y來表示一個B-DMC信道,其中X和Y分別表示該信道的輸入、輸出符號集合,X={0,1}.信道轉移函數被定義為W(y|x),其中x∈X,y∈Y.那么,對稱信道容量表示為

其中,β =W(y|x),β0=W(y|0),β1=W(y|1).通過對信道W的N次占用(即信道W的N個可用時隙),能夠得到N個獨立的具有相同信道特性的B-DMC信道,然后對這N個信道進行信道變換,在各個獨立的信道之間引入相關性,將會得到信道轉移概率函數

1.1.2 極化譯碼

當談及SC譯碼時,似然比(LLR)[13]和路徑度量尤為重要.一般地,LLR 的計算如下

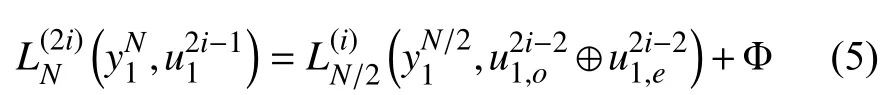

其中,yi是通過AWGN信道獲得的接收信號.LLR的遞歸計算方式為

以及

與傳統的SC譯碼一樣,SCL譯碼仍然是從譯碼樹的根節點開始,逐層依次向葉子節點層進行路徑搜索.然而,與傳統的SC譯碼不同的是,SCL譯碼用路徑度量來估計每一條路徑的可靠性;此外,SCL的每一層譯碼將會把L條最有可能的路徑保存下來.那么,的路徑度量的計算公式為

1.2 BP神經網絡

因強大的學習能力,神經網絡吸引著眾多學者[14].BP神經網絡是神經網絡中的一種,本質上是一種前饋神經網絡.BP神經網絡主要涉及三部分:準備樣本、搭建結構及訓練網絡.

在準備樣本階段,主要是整理訓練集和測試集.在搭建結構階段,主要是設置參數.在訓練網絡階段,基于監督學習,首先計算輸出層和隱藏層的輸出值;然后計算輸出層和隱藏層的誤差項;在此基礎上,通過設定一個學習率來設置參數更新的大小,并不斷迭代調整權值和偏置項,最終完成訓練.特別強調的是,偏置項可以是固定的,也可以設置成同權值相關的.

2 基于BP神經網絡的SCL譯碼算法

由于極化碼能夠達到信道容量,因此它的譯碼技術受到了極大關注.近年來,各種譯碼方法應運而生,如 SC,SCL,CA-SCL,AD-SCL 等.為了降低低信噪比下的平均譯碼復雜度,綜合考慮性能及AD-SCL對L進行由小到大更新時所帶來的低平均譯碼復雜度,若L的初始值不固定為1,那么,就能夠解決低信噪比下的復雜度問題.因而,尋找L的最優初始值是本文的研究關鍵.

假設令Lmax=32,則L的最優初始值有6種情況:1,2,4,8,16,32.當尋找L的最優初始值時,可以看作是簡單的分類問題.在某一信噪比和某一似然比下對應著哪個L值,則相對應的L值即為尋找的L的最優初始值.若用普通的計算來尋找L的最優初始值,需要大量的數據存儲和概率統計,從而導致復雜度呈上升趨勢.而BP神經網絡具有任意復雜的模式分類能力和優良的多維函數映射能力,可以離線操作和準確處理分類問題,因此,其技術適用于尋找L的最優初始值.

本文研究主要分2個階段來進行:離線階段和在線階段,具體的系統框圖如圖1所示.觀察圖1,離線階段主要是構建并訓練BP神經網絡;在線階段首先是尋找L的最優初始值,其次是完成譯碼.對于圖1的整個系統框圖,首先執行離線操作,完成虛框中的各項任務,包括收集數據、構建BP神經網絡及訓練BP神經網絡,得到一個訓練好的BP神經網絡模型;然后啟動在線操作,從極化編碼開始,將碼字發送到信道中,得到接收信號,并根據接收信號來計算似然比,一旦完成似然比的計算,系統會激活已完成訓練的BP神經網絡模型,將似然比及與該似然比相對應的信噪比輸入到BP神經網絡模型中,得到一個值,即為L的最優初始值,最后執行譯碼操作.

2.1 構建與訓練BP神經網絡

綜合考慮網絡訓練復雜度及極化碼譯碼復雜度,確定在離線階段完成BP神經網絡的構建與訓練.需要注意的是,此處理方式不會影響極化碼譯碼復雜度和性能.

2.1.1 樣本數據的準備及預處理

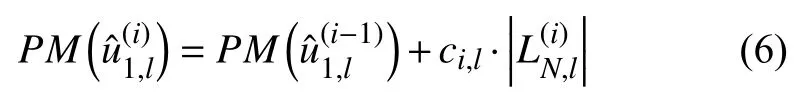

采用BP神經網絡方法建模的首要和前提條件是有足夠多典型性好和精度高的樣本.為此,建模的關鍵是收集并選取樣本數據;在此基礎上,隨機選取其中的75%的數據作為訓練樣本,剩余的25%數據作為測試樣本;最后,通過預處理將樣本數據轉換為數值數據.本文采用的預處理手段是歸一化處理,其線性轉換算法的形式如下:

其中,smin為輸入向量S的最小值,smax為輸入向量S的最大值,zr是節點r的輸出值.

2.1.2 神經網絡的訓練

基于監督學習,利用反向傳播算法來訓練網絡.假設每個訓練樣本為(S,g),向量S是訓練樣本的特征,g是樣本的目標值.

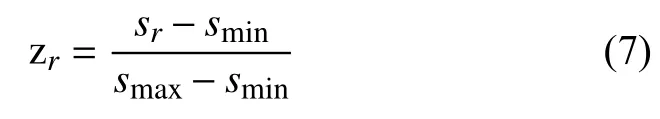

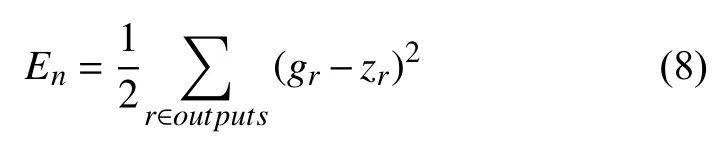

本文取網絡所有輸出層節點的誤差平方和作為目標函數:

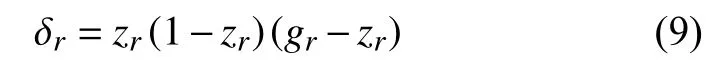

其中,En表示樣本n的 誤差.在此基礎上,運用隨機梯度下降優化方法對目標函數進行優化.經過優化之后,能分別得到輸出層的誤差項、隱藏層的誤差項以及權重的更新方法.對于輸出層節點r,誤差項的計算為

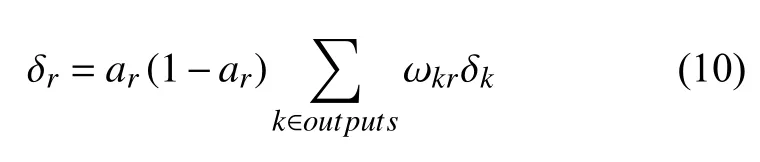

其中,δr是節點r的誤差項,zr是節點r的輸出值,gr是樣本對應于節點r的目標值.對于隱藏層節點,誤差項的計算為

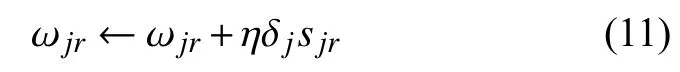

其中,ar是節點r的輸出值,ωkr是節點r到它的下一層節點k的連接權重,δk是節點r的下一層節點k的誤差項.由此,更新每個連接上的權重:

其中,ωjr是節點r到節點j的權重,η是一個學習速率常數,δj是節點j的誤差項,sjr是節點r傳遞給節點j的輸入.由于偏置項的輸入值永遠為1,故偏置項的計算為

根據上述訓練規則,不斷修正 ωjr與 ωrb,則可完成訓練.

2.2 基于BP神經網絡的SCL譯碼算法

為了降低平均譯碼復雜度,本文提出了一種基于BP神經網絡的SCL(BNN-SCL)譯碼算法.BNNSCL譯碼算法包括兩個階段:離線構建并訓練BP神經網絡模型階段與在線譯碼階段.在第2.1節中,已經完成BP神經網絡模型的構建與訓練,對應地,即已完成圖1系統框圖中虛框的操作.因此,在本節中主要介紹的是在線階段的譯碼操作,即從圖1的得到接收信號開始介紹.根據接收信號來計算似然比,一旦完成似然比的計算,系統會激活已完成訓練的BP神經網絡模型,將似然比及與該似然比相對應的信噪比輸入到BP神經網絡模型中,得到一個值,即為L的最優初始值.此時,譯碼端將會進行初始化,將L初始化為L的最優初始值.BNN-SCL算法與現存的譯碼算法不同,L的初始值的大小不固定為1.

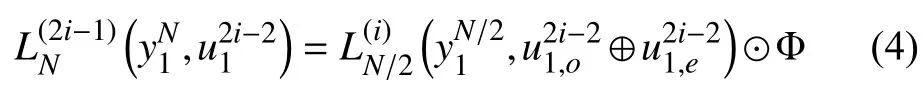

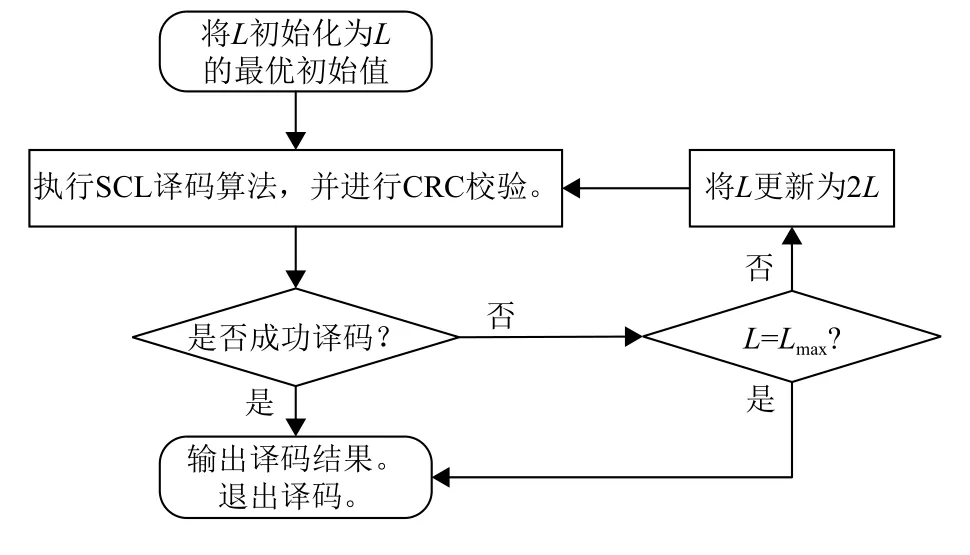

為詳細了解譯碼端進行初始化之后的操作,本文給出具體的后續操作步驟,即本文提出的降低平均譯碼復雜度的SCL譯碼算法在譯碼端的具體步驟如下:

1)對L進行初始化,將L初始化為L的最優初始值;

2)執行SCL譯碼算法,并對其譯碼候選路徑進行CRC校驗;

3)如果有一條或多于一條的候選路徑通過CRC校驗,則輸出一條最有可能的路徑,并退出譯碼;否則,跳到 4).

4)將L更新為2L,并判斷更新之后的L是否大于Lmax.若不大于Lmax,則跳回 2);否則,退出譯碼.

為輔助理解,圖2給出了基于BP神經網絡的SCL譯碼算法在譯碼端的流程圖.

圖2 BNN-SCL 譯碼算法在譯碼端的流程圖

3 實驗結果與分析

本文的仿真實驗包括2個部分:離線部分和在線部分.現將各部分主要涉及的參數、配置列出.離線部分,將輸入層、隱藏層及輸出層的節點數分別設置為2、300、6,采用全連接方式來搭建網絡,并將激活函數設置為sigmoid函數,網絡訓練的目標誤差設為0.01,顯示中間結果的周期設為50,最大迭代次數設為500,學習率設為0.01.在線部分的參數、配置如下所示.

根據實驗的數值結果來分析新提出算法的誤比特率(BER)和復雜度.在本文的仿真實驗中,所涉及的譯碼方案的碼長和碼率分別配置為N=1024,R=0.5.根據文獻[15]構造極化碼,極化碼級聯一個長度為16比特的CRC.

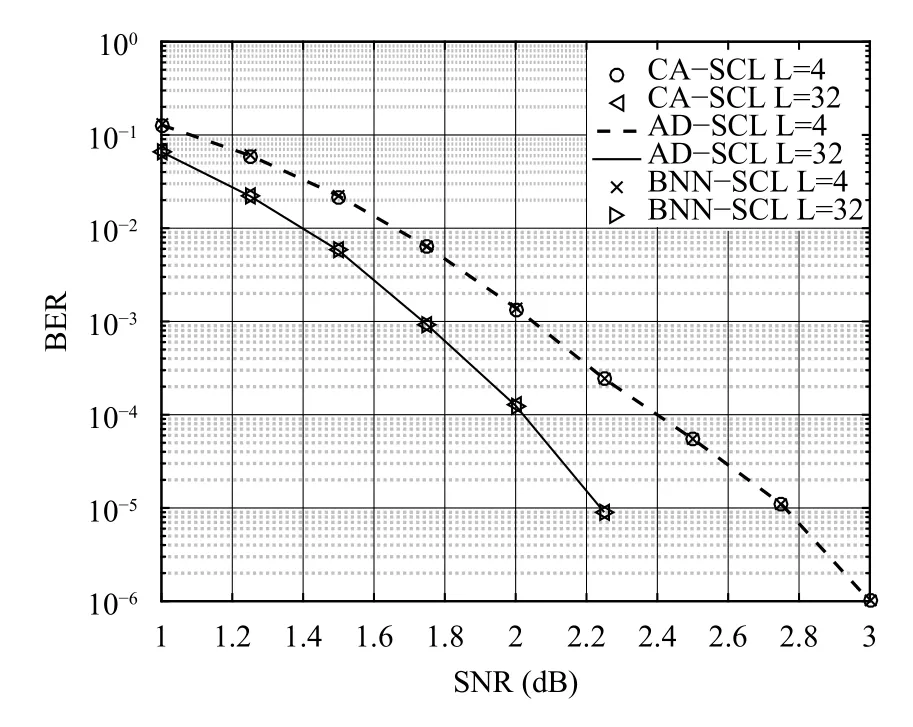

圖3給出不同譯碼算法下的BER性能比較,其中列表譯碼的列表大小分別配置為4和32.對于ADSCL和BNN-SCL譯碼算法,均將最大搜索寬度設置為Lmax=32.通過已完成訓練的BP神經網絡來尋找的L的最優初始值被運用于仿真實驗中.從圖3中可以看出,CA-SCL、AD-SCL及BNN-SCL的曲線是重疊的.與CA-SCL和AD-SCL類似,經過適當配置,BNN-SCL也能夠獲得非常接近ML譯碼的性能.

圖4給出不同譯碼算法下的平均復雜度比較,其中列表譯碼的列表大小為32.對于AD-SCL和BNNSCL譯碼算法,均將最大搜索寬度設置為Lmax=32.如圖4所示,在高信噪比下,BNN-SCL譯碼的復雜度非常接近SC譯碼的復雜度.此外,與AD-SCL譯碼算法相比,在 0~1.25 dB 下,BNN-SCL 能夠顯著降低平均復雜度,例如,在SNR=0.75時,BNN-SCL 能夠降低約26.1%的復雜度.

圖3 不同譯碼算法下的BER性能比較

4 結語

為了降低復雜度,提出一種基于BP神經網絡的SCL譯碼算法.綜合考慮現存算法的優點,通過在離線階段完成訓練的BP神經網絡來尋找L的最優初始值,以改變L的初始值總是設置為1的現狀;在此基礎上,設計一種改進的SCL譯碼算法,最終降低復雜度.實驗結果表明,與 AD-SCL 譯碼算法相比,在 0~1.25 dB 下,BNN-SCL能夠顯著降低平均復雜度且保持譯碼性能不變.