利用多模態U形網絡的CT圖像前列腺分割

凌彤,楊琬琪,楊明

前列腺癌在歐美等國家是最常見的泌尿系惡性腫瘤,在所有直接導致死亡原因的腫瘤中排在第2位,隨著我國人口老齡化,前列腺癌的發生率也越來越高[1]。對前列腺癌進行影像引導放射治療是診治該疾病的關鍵步驟之一。

影像引導放射治療前列腺,通常是對患者進行CT等影像檢查后,由醫生手動分割影像圖像前列腺癌病變部分。但是手動分割病變需要耗費一定的時間與精力,且不同的醫生依據自己的工作經驗對病變分割的結果存在一定的差異性,在某種程度上會影響分割的精度,進而影響對病癥的診斷。因此,準確地自動分割對前列腺癌的診斷是十分重要的。

CT檢查具有快速、薄層、大范圍掃描等優勢,且檢查時間較短,但是由于圖像的低對比度,使得前列腺與周圍組織結構顯像并不清晰,給圖像的自動分割造成了一定的困難。而MRI檢查軟組織分辨率高,圖像對比度好,在顯示腫瘤本身以及前列腺包膜、周圍組織等方面較 CT 更有優勢[2]。為了提高CT圖像的分割精度,對CT圖像進行更有效地自動分割,我們提出利用MRI的高分辨率特點去幫助CT圖像分割前列腺癌的病變部分。

針對這一想法,本文提出一種新的基于深度學習的多模態U形網絡圖像分割模型MM-unet:1)運用深度學習遷移的思想,借用其他MRI數據集(即PROMISE12)輔助訓練MRI圖像的初始分割模型,進而將訓練好的MRI圖像初始分割模型進行遷移到CT圖像的初始分割模型中;2)通過設計一種新型的多模態損失函數MM-Loss,衡量MRI與CT不同模態分割模型間的一致性,并建立它們之間的聯系;聯合訓練基于MRI與CT 圖像的MM-unet,使用監督學習的方式讓兩個模態互相學習,使CT圖像能夠借助MRI提供的影像信息來提高自身的分割精度。

1 相關工作

醫學圖像不同于一般的圖像,具有一定的復雜性、多樣性、不規則性等特點,因此很多用于處理一般圖像的分割方法不能直接用于醫學圖像處理。而CT圖像由于軟組織結構對比度低的特點,使得其分割難度加大。為解決這一問題,近年來有不少研究者提出若干CT前列腺圖像分割方法,如文獻[3]提出基于特征學習的框架實現精準定位的分割方法,文獻[4]提出從之前分割好的訓練圖像中建立可變形的器官模型實現自動分割的方法,文獻[5]提出基于稀疏表示的分類器分割的方法等。上述方法都是利用單模態圖像信息對CT圖像實現分割,而本文提出的多模態U形網絡分割方法是充分利用多模態圖像信息。

單模態,是使用一種成像設備得到的圖像;而多模態圖像是使用兩種以上成像設備得到。不同模態的圖像有著各自的成像特點,能為同一組織結構提供不盡相同的影像信息;而使用多模態圖像能夠結合不同模態的影像信息以幫助更全面的疾病診斷。如文獻[6]提出的多模態堆疊深度多項式網絡通過融合與學習多個模態的特征表示來診斷阿爾茨海默病;文獻[7]提出的變換深度卷積網絡通過融合不同模態的圖像特征對椎體識別更加有效。這兩種方法與本文所提方法均是基于深度學習的方法。

深度學習具有強大的特征學習與表達能力,其概念起源于2006年Hinton等在Neural Computation發表的文獻[8],但真正引起學術界廣泛關注的是2012年Krizhevsky等提出的深度卷積神經網絡Alexnet模型[9]。在那之后,深度學習迅猛發展,且多用于語音識別、圖像分類檢測、目標追蹤等領域。此外,深度學習方法在醫學圖像分割中的應用也是十分廣泛,如文獻[10]提出的基于三維卷積神經網絡分割椎體MRI圖像,文獻[11]提出的基于遞歸神經網絡分割肌束膜病理圖像,文獻[12]提出的基于多尺度特征融合的深度三維卷積編碼網絡分割多發性硬化癥病變等。

由于深度學習的模型訓練往往需要大量的數據儲備,為提升其模型精度且防止過擬合問題,研究者們運用遷移學習,將預訓練好的其他網絡模型遷移到目標模型中,如文獻[13]提出使用基礎數據集訓練深度卷積神經網絡學習模型,使用目標數據集微調該模型中學習到的特征,分別通過選擇性遷移與直接遷移來訓練目標模型,以提高其模型的泛化能力;文獻[14]提出的級聯深度自適應(CDDA)模型通過使用醫生手工標注的掩模在具有不同掩膜比的原始CT圖像上疊加來構建多個連續源域,并將這些源域上學習到的特征遷移到目標域中。

2 卷積神經網絡學習模型

2.1 網絡結構常用層

卷積層[15](convolution layer,Conv),是卷積神經網絡的核心層,通常使用卷積核與輸入的特征圖進行卷積操作以實現特征的提取;池化層(pooling layer),通常是對卷積層輸出的特征圖進行下采樣操作以降低維度并保留有用的信息,有效地防止過擬合,常見的方法有最大池化、均值池化等;修正線性單元[16](rectified linear unit, ReLU),是一種激活函數,用于加快網絡訓練的收斂速度;反卷積層[17](deconvolution layer,Deconv),可以看作是卷積層的逆操作,用于圖像分割中對輸入特征圖的重構。

2.2 單模態U形網絡

醫學圖像具有復雜多樣化、線條不規律等特點,分割時對于圖像中的組織結構等細節信息需要進行精準定位,才能有效地提高分割精度。而文獻[18]提出的全卷積神經網絡U-net模型有效地解決了這一問題,在醫學圖像分割中取得了好的表現。

U-net模型是由兩個路徑呈對稱狀組成,一個收縮路徑用于獲得圖像信息,一個擴展路徑用于實現精確定位。本文中,我們使用了U-net模型并作了一些調整,除最后一層卷積層外,每層卷積層后都增加了一層批處理歸一化[19](batch normalization,BN),用來優化反向傳播中的梯度問題,并將卷積層填充參數設為1,去掉原始的裁剪層,以確保輸入、輸出的圖像大小保持一致,便于圖像的處理。調整后的模型稱為單模態U形網絡。

本文訓練的CT圖像單模態U形網絡結構如圖1所示。我們將兩層3×3大小的卷積層,每層后加上一層修正線性單元與批處理歸一化(ReLU+BN)稱為一個塊結構(Block)。在左邊的收縮路徑中,輸入的CT圖像經過3次塊結構與步長為2的2×2大小最大池化層(Pooling)的下采樣操作,且每次下采樣時都加倍通道數;之后經過一個塊結構后進入擴展路徑,再經過3次塊結構與步長為2的2×2大小反卷積層(Deconv)的上采樣操作,每次上采樣時減半通道數:最后通過一層1×1大小的卷積層[20]映射到目標的類別,使用交叉熵損失函數計算輸出的特征圖與標記圖像的像素值距離,得到輸出圖像。

圖1 訓練CT圖像的單模態U形網絡 (CT-unet)Fig. 1 Singlemodal U-net for training CT images (CT-unet)

3 方法

本節詳細介紹所提出的CT圖像分割方法,主要考慮3個方面:1)充分利用MRI模態的信息指導CT圖像分割;2) 構造MRI與CT之間的中間模態圖像,以縮小與CT模態圖像的差異;3)設計多模態損失函數MM-Loss,衡量MRI與CT模態間的相關性,通過聯合學習訓練MM-unet模型。

3.1 單模態MRI模型指導CT圖像分割

MRI前列腺圖像具有分辨率高、對比度好的特點,與CT圖像相比,顯像更為清晰。一般來說,使用同一標記圖像的數據集訓練時,MRI的分割結果會優于CT圖像,但由于訓練樣本有限,MRI模型的分割精度會受影響。所以在利用MRI圖像特點幫助CT圖像分割時,應當盡可能地提高MRI模型的分割精度,有效地防止過擬合,才能指導CT圖像更好地分割。因此,本文運用遷移學習的思想,首先充分利用其他前列腺圖像的MRI數據集訓練單模態U形網絡,得到的參數模型去初始化訓練與CT圖像配準的MRI數據集,以期望獲得分割精度較高的MRI模型,然后再將MRI模型參數作為初始模型參數,精化訓練CT單模態U形網絡(CT-unet),幫助提高CT圖像的分割精度。

不同于CT圖像分割的單模態U形網絡,由于MRI圖像展示的細節信息豐富且清晰,我們使用具有4次下采樣、上采樣操作的單模態U形網絡模型(MRI-unet)來訓練,以便在模型最底層能夠更精確地捕獲MRI的圖像信息。

3.2 單模態CT-MRI模型指導CT圖像分割

MRI與CT兩個模態圖像因為成像原理不同,圖像外觀存在明顯的差異性,可能會使模態之間的學習受到一些影響。為減小這種影響,需要減小MRI與CT圖像外觀的差異性。對此,本文將對應同一標記已經配準的MRI與CT圖像都進行歸一化處理,再對它們使用取均值操作構造出新的CT-MRI圖像。從外觀的表現來看,CT-MRI圖像既有CT圖像的特點,又有MRI圖像的特點。

我們使用具有4次下采樣、上采樣操作的單模態U形網絡模型訓練CT-MRI圖像 (CT-MRI-unet)。首先利用MRI模型參數作為初始模型,精化訓練CT-MRI模型,進而將訓練好的CTMRI模型進行遷移訓練CT-unet模型,幫助提高CT圖像的分割精度。

3.3 基于多模態U形網絡的CT圖像分割

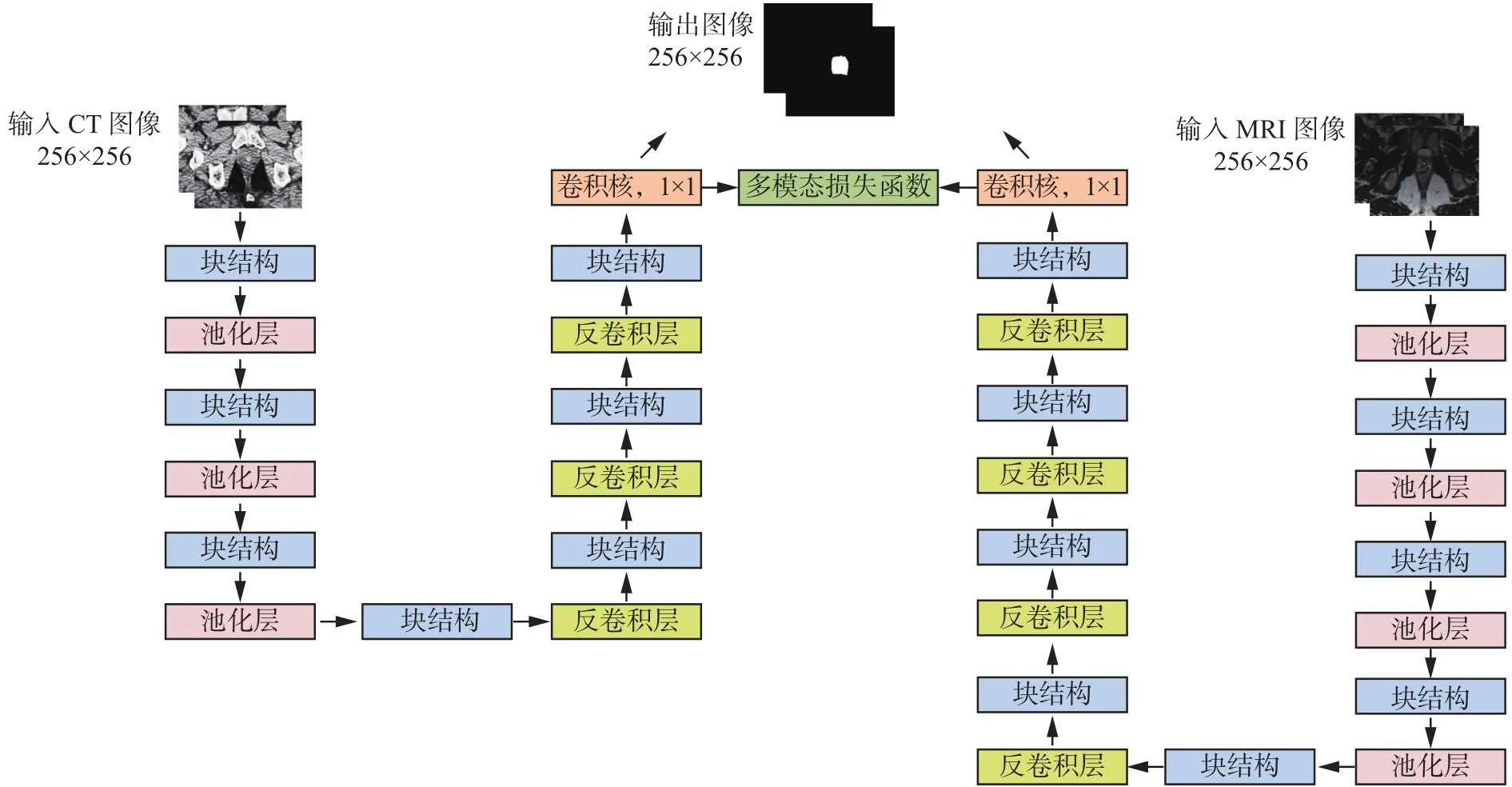

由于不同的模態圖像有各自的特點,提供的影像信息不完全相同,如果將多模態圖像提供的信息結合起來,充分利用其互補性,則有利于提高單模態圖像的分割精度。因此,本文提出基于多模態U形網絡(MM-unet)的CT圖像分割方法,如圖2所示,由MRI-unet與CT-unet構成的,使用了一個MM-Loss損失函數用以建立MRI與CT兩個單模態U形模型之間的聯系。

圖2 MM-unet模型Fig. 2 Multimodal U-unet model

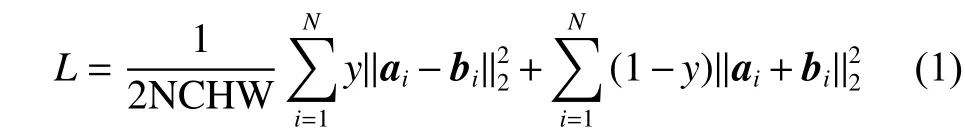

兩個單模態U形網絡同時訓練各自的模態圖像,通過收縮路徑獲取底層圖像信息,擴展路徑實現高層信息的提取,在最后一層卷積層使用MM-Loss損失函數對MRI與CT圖像進行相似性度量。MM-Loss損失函數的定義如下:

式中:ai、bi為輸入的MRI與CT圖像對應的分割結果概率圖,N、C、H、W為輸入圖像的數量、通道、高度、寬度,y為標記圖像。

輸入MRI與CT圖像,對于它們共同對應的標記圖像的分割部分,約束它們相似的部分盡可能接近;對標記圖像的背景部分,促使它們成為分割目標的概率值盡可能地小。以此使兩個模態圖像的分割模型能夠對于分割目標進行互相學習。

3.4 算法流程

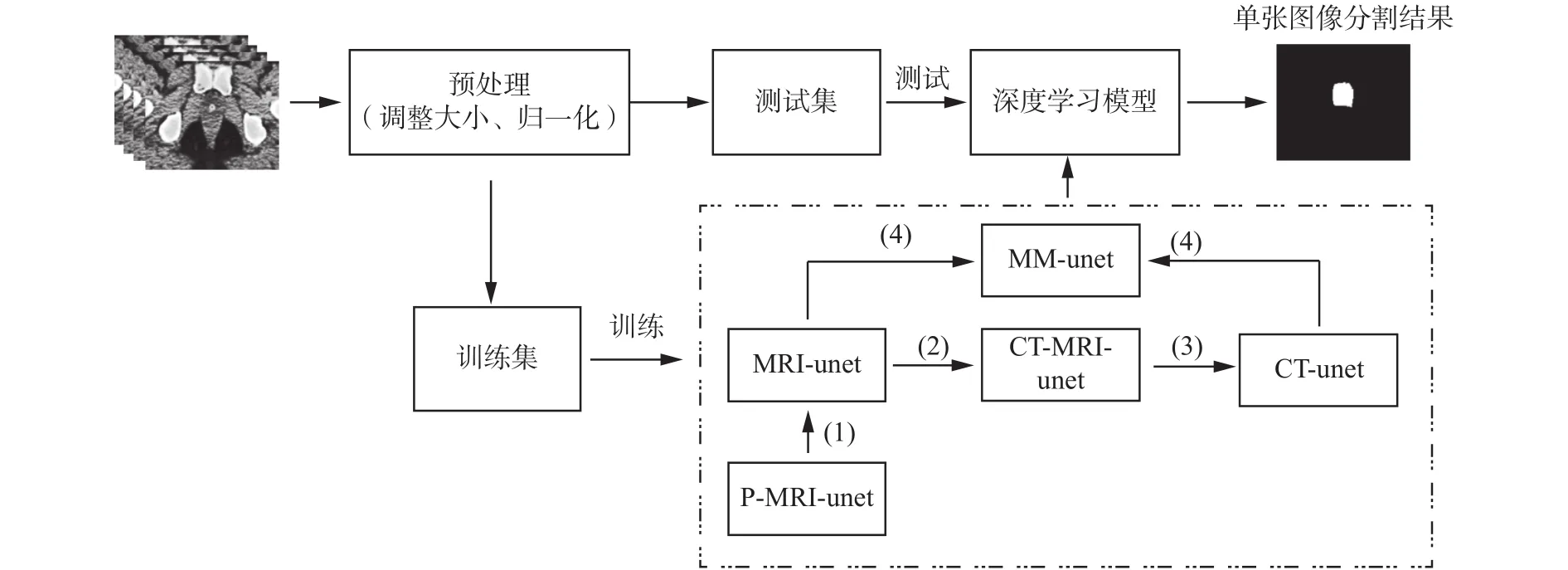

本文方法的整個流程如圖3所示。數據集經過預處理工作后分為訓練集與測試集,在訓練階段,使用訓練集訓練分割模型,算法如圖3虛線框部分,其操作步驟如下:

1)使用PROMISE12數據集[21]預訓練得到的P-MRI-unet模型(詳見4.5節實驗1),進行遷移訓練 MRI-unet模型;

2)構造CT-MRI圖像,將1)中得到的MRI-unet模型進行遷移訓練CT-MRI-unet模型;

3)將2)中得到的CT-MRI-unet模型進行遷移訓練CT- unet模型;

4)將1)中得到的MRI-unet模型與3)中得到的CT-unet模型進行遷移訓練MM-unet模型。

在測試階段,使用訓練階段最終得到的MM-unet模型對測試集里的CT圖像進行分割,得到CT圖像的分割結果圖。

圖3 基于深度學習模型的前列腺CT圖像分割流程圖Fig. 3 The flowchart of deep learning model for prostate segmentation in CT images

4 實驗

4.1 數據集

我們使用的前列腺數據集有兩個,一個是網上公開的PROMISE12數據集[21],一個是某合作醫院提供的Prostate數據集。PROMISE12數據集含有50個患者的MRI圖像與相對應的手工標記圖像,圖像大小不一。刪去無病變的MRI圖像與標記圖像,并將其余的癌病變圖像大小統一調整到256×256,共得到778張MRI圖像與778張標記圖;使用前40個患者的樣本作為訓練集,后10個患者的樣本作為驗證集訓練模型。Prostate數據集含有22個患者的CT、MRI與相對應的病變標記圖像,已經過配準處理,大小為153×193。為便于訓練,我們將圖像大小統一調整到256×256,共得到 658張 CT、658張MRI與658張標記圖;采用二折交叉驗證的方式,第一折使用前11個患者的樣本作為訓練集,后11個患者的樣本作為測試集進行測試;第二折使用后11個患者的樣本作為訓練集,前11個患者的樣本作為測試集進行測試。

4.2 預處理工作

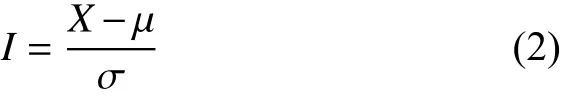

為加快模型的訓練速度,優化訓練過程,我們對數據集進行了歸一化處理。歸一化操作定義為

式中:X為圖像像素,μ為圖像像素值的均值,σ為圖像像素值的標準差。

4.3 實驗設置

本文是在深度學習框架Caffe[22]上進行的實驗。在模型的訓練階段批處理參數設置為2,測試階段的批處理設置為1,使用隨機梯度下降[23]求解器與0.9的動量參數,固定策略的學習率,大小為10-6,權重衰減為0.005。

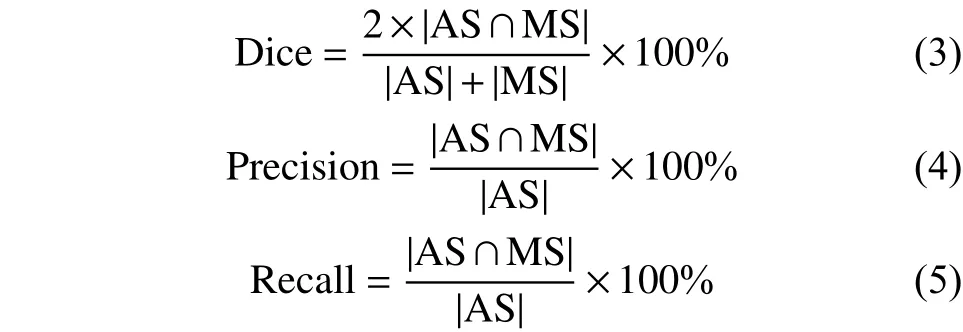

4.4 評價標準

我們使用常用的重合率(Dice)、查準率(Precision)、查全率(Recall)指標[24]來度量自動分割圖像與手工標記圖像之間的差異,以用于評價實驗結果。

定義公式如下:

式中:AS為自動分割圖像,MS為醫生手工標記圖像。

4.5 實驗與結果

本節通過3個實驗來驗證我們的方法的有效性。

實驗1 為評估MRI模型指導CT圖像分割的精度,我們使用PROMISE12數據集訓練MRI-unet,獲得的模型作為初始模型用于訓練Prostate數據集里的MRI圖像,訓練后得到MRI參數模型。將MRI參數模型進行遷移學習得到CT-unet模型,用于對CT測試圖像進行分割,該方法記作 MRI→CT-unet;

實驗2 為評估CT-MRI模型指導CT圖像分割的精度,我們使用Prostate數據集里的MRI與CT圖像構造CT-MRI圖像,使用實驗1里的MRI參數模型作為初始模型訓練CT-MRI圖像,得到的CT-MRI模型再遷移到用于CT圖像分割的CT-unet中,用于對CT測試圖像進行分割,該方法記作 CT-MRI→CT-unet;

實驗3 為評估并驗證文中提出的MM-unet模型的有效性,我們使用實驗1的MRI參數模型、實驗2中通過CT-MRI參數模型遷移學習后的CT參數模型,分別作為MM-unet模型的MRI部分與CT部分的初始模型進行訓練,得到的多模態參數模型用于對CT測試圖像進行分割,該方法記作MM-unet。

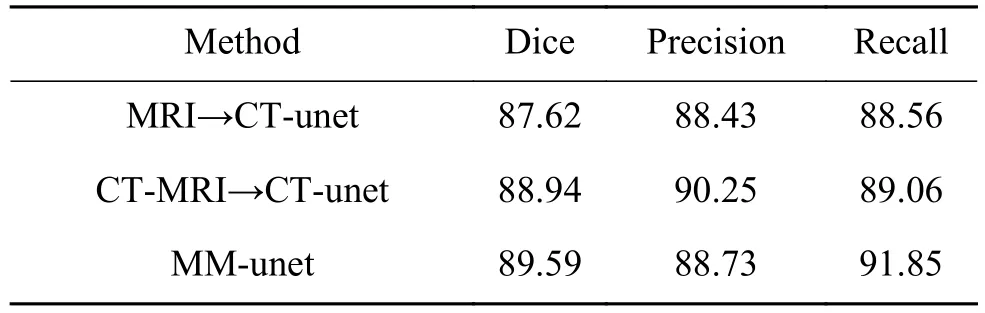

3個實驗的CT圖像分割結果如表1所示。從表格中可看出,第2個方法因為構造的CT-MRI圖像減少了MRI與CT圖像的外觀差異,使其指導CT圖像分割的重合率、查準率、查全率均高于第一個方法;相比前兩個方法,第3個方法的重合率、查全率最高。

表 1 CT圖像分割實驗結果Table 1 Experimental results of CT segmentation %

使用統計性t檢驗對MM-unet模型方法與其他方法的重合率Dice進行比較,P值小于0.05,說明MM-unet顯著地優于其他方法。

4.6 比較實驗

本節將我們的方法(即上述實驗中表現最好的MM-unet方法)與U-net模型方法[18]、CDDA模型[14]方法、無初參的MM-unet模型方法作比較,評價分割結果如表2所示。

表 2 不同模型的實驗結果對比Table 2 Comparisons of experimental results on different models %

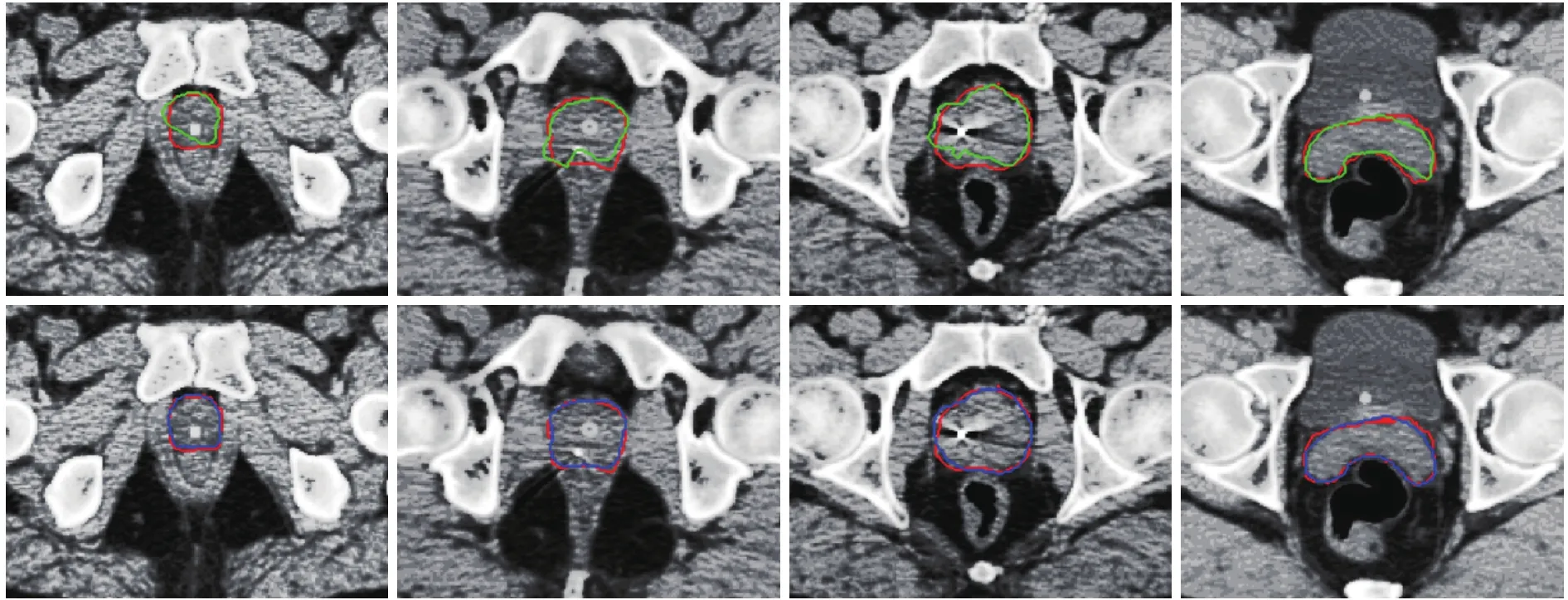

為進一步展示所提方法的分割優勢,部分圖像可視化結果如圖4所示,紅色方框為醫生手工標注的前列腺癌病變部分。第1排圖像綠色方框為U-net模型分割的病變部分,第2排圖像藍色方框為遷移學習的MM-unet模型分割病變的部分。

通過表2與圖4顯示,與U-net模型相比,我們的MM-unet模型方法分割效果有明顯優勢,重合率、查準率、查全率分別提升了3.31%、0.48%、5.61%,分割邊界更接近于由醫生標注的真實標記。

圖4 兩個模型分割CT圖像的可視化結果Fig. 4 Visual results of two models for CT segmentation

5 結束語

本文中,我們提出了基于多模態U形網絡實現CT圖像前列腺癌分割的方法。該方法利用了MRI圖像高分辨率與多模態圖像信息互補的特點,構建基于MRI與CT圖像的多模態深度學習模型指導CT圖像學習前列腺癌分割。實驗結果表明,我們的方法可以有效地提高CT圖像分割精度。本文提出的多模態U形模型分割CT圖像的方法適用于CT/MRI已進行配準匹配的前列腺癌數據集,對于未進行配準的數據集和其他非前列腺癌的數據集有待進一步驗證。