基于在線魯棒判別式字典學習的視覺跟蹤

方云錄

摘 要: 基于稀疏表示與字典學習的視覺跟蹤較好地解決了目標遮擋和表觀變化問題,但是其存在模型漂移和復雜背景下魯棒性差的問題。針對這兩個問題,本文利用L1損失函數和最小化背景樣本在目標模板上的投影提出一種在線魯棒判別式字典學習模型,并用塊坐標下降設計了該模型的在線學習算法用于L1跟蹤模板更新。以粒子濾波為框架,利用提出的字典學習實現了視覺跟蹤方法。實驗結果表明:本文跟蹤方法比現有跟蹤方法具有更強的魯棒性和較高的跟蹤精度。

關鍵詞: L1跟蹤; 字典學習; 模板更新; 粒子濾波

中圖分類號:TP391 文獻標志碼:A 文章編號:1006-8228(2018)07-20-04

Abstract: Sparse representation and dictionary learning based visual tracking have well solved occlusions and appearance changes. However, they are faced with problems of model drifting and low robustness in clutter background. To deal with these two problems, an online robust discriminative dictionary learning model is proposed, and an online robust discriminative dictionary learning algorithm for template update of L1 tracker is designed via block coordinate descent. A visual tracking method is established using the proposed dictionary learning algorithm in particle filter framework. The experimental results on several challenging sequences show that the proposed method has better robustness and accuracy than those of the state-of-the-art trackers.

Key words: L1 tracking; dictionary learning; template update; particle filter

0 引言

視覺跟蹤是計算機視覺領域的一個重要研究內容,其目的是利用序列圖像估算目標的狀態參數。視覺跟蹤在視頻監控和人機交互等方面具有廣闊的應用前景。目前,雖然研究者已經提出一些視覺跟蹤方法,但是現有跟蹤方法仍然面臨復雜背景、目標變化和目標遮擋等難題[1]。

2009年,Mei和Ling[2]首次提出基于稀疏表示的視覺跟蹤方法,又稱“L1跟蹤”。L1跟蹤用目標模板和小模板的組合表示候選目標,以重構誤差作為觀測似然跟蹤目標。L1跟蹤對目標遮擋具有較強的魯棒性,但是L1跟蹤對目標模板的要求較高,當模板中引入離群數據時,會導致跟蹤失敗。為了保證目標模板的正確性,文獻[3-4]提出用小模板系數檢測目標遮擋,并根據檢測結果更新目標模板。文獻[5]利用小模板系數重建跟蹤結果,并利用增量主分量分析更新目標模板。文獻[3-5]中模板更新方法的問題在于,由于小模板也能表示背景[5],這會導致遮擋檢測失敗或者重建圖像不準確。隨著對L1跟蹤研究的深入,研究者逐漸認識到模板字典在視覺跟蹤中的重要作用。為了提升L1跟蹤對復雜背景下目標跟蹤魯棒性,文獻[6]提出用多個特征視圖建立目標模板字典。文獻[7]提出建立多壽命模板字典跟蹤目標,并將目標模板更新等價為在線字典學習問題,從而保證了對目標表觀變化的適應性。文獻[8]利用非負灰度字典設計目標模板,并提出在線魯棒的非負字典學習算法用于模板更新,進一步提升了L1跟蹤的性能。

綜上所述,目標模板的設計與更新對L1跟蹤至關重要。現有L1跟蹤模板更新方法的問題在于模型漂移和復雜背景下目標跟蹤的魯棒性差兩個方面。針對這兩個問題,本文首先提出一種在線魯棒判別式字典學習模型。一方面,該模型以L1范數作為目標模板的損失函數,有效抑制了模型漂移;另一方面,該模型通過最小化背景樣本在目標模板上的投影,增強了目標模板的判別力,提高了復雜背景下目標跟蹤的魯棒性。其次,利用塊坐標下降設計了該模型的在線學習算法。在粒子濾波框架下,利用提出的字典學習實現了目標跟蹤方法。實驗結果表明,本文提出的模板更新方法,用于視覺跟蹤,達到了提高魯棒性與跟蹤精度的預期效果。

1 在線魯棒判別式字典學習模型

視覺跟蹤中的圖像觀測是時變數據,所以從字典學習的角度看,模板更新是在線的字典學習問題[7-8]。目前,一般在“損失函+正則化項”框架下對字典學習問題進行研究[9]。字典學習模型也就是如何設計損失函和正則化項。假設是正例樣本,是負例樣本,其中和是零均值和單位方差向量。,則本文提出的在線魯棒判別式字典學習模型如下:

在線字典學習模型式⑴能夠克服模型漂移,同時對目標樣本與背景樣本又具有較強的判別力。式⑴中為目標樣本在模板字典D上的重建誤差,又稱為損失函數。字典學習中常用的損失函數有L1范數和L2范數。由于離群數據的重建誤差滿足拉普拉斯分布,所以與L2損失函數相比,L1損失函數具有對離群數據魯棒的優點。因此,模型式⑴用L1范數作為損失函數能夠降低遮擋信息等離群數據對目標模板的影響,從而克服模型漂移。模型式⑴不但考慮了模板字典對目標樣本的重建能力,還兼顧了模板字典對背景樣本的辨別能力,這通過最小化背景樣本在模板字典D上的投影得到。

2 在線魯棒判別式字典學習算法

求解式⑴的在線魯棒判別式字典學習算法包括數據采樣、編碼系數求解和在線字典更新三步驟。

2.1 數據采樣

根據至t時刻的跟蹤結果,采樣n+個圖像塊作為正例樣本;在以t時刻跟蹤結果目標中心c為圓心的環形區域內隨機采樣n-個圖像塊作為負例樣本。

2.2 編碼系數求解

假設t-n+時刻的目標模板字典為。采用迭代加權最小二乘法[10](Iterative Reweighted Least Squares,IRLS)求解(i=1,…,n+)。采用嶺回歸求解(i=1,…,n-)。

2.3 在線字典更新

在線字典更新的目標是已知編碼系數和求解字典Dr。假設在t時刻進行第T次模板更新,則在線字典更新也就是求解優化問題式⑵

其中,是樣本個數。由文獻[10]可知,采用塊坐標共軛梯度下降算法逐行求解式⑶,可得到字典Dt。

其中,δ是一個正數(本文取δ=0.0001)。由文獻[10]可知,若定義Bj和Cj分別為式⑹和式⑺,則求解線性系統式⑻可以得到D(j,:)。式⑻是一個可微凸問題,其全局最優解可通過對目標函數求導使其等于零得到。

通過上述分析,可以得到求解模型式⑴的在線魯棒判別式字典學習算法,如“算法1”所示。

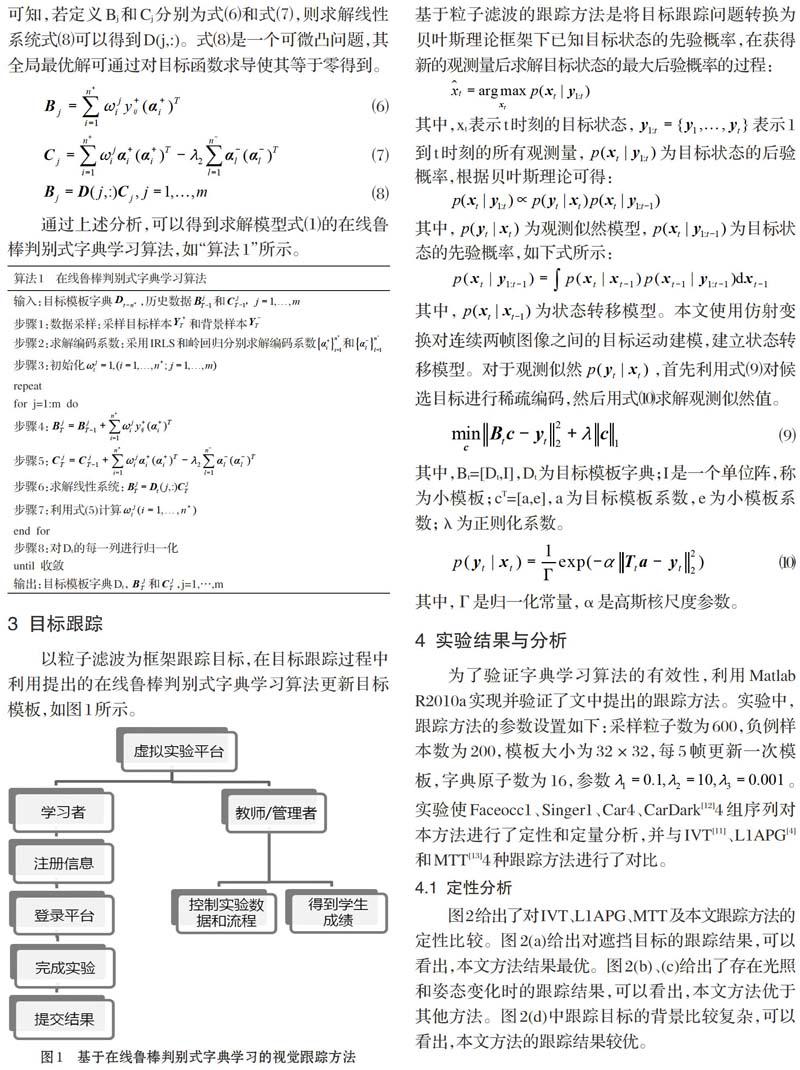

3 目標跟蹤

以粒子濾波為框架跟蹤目標,在目標跟蹤過程中利用提出的在線魯棒判別式字典學習算法更新目標模板,如圖1所示。

基于粒子濾波的跟蹤方法是將目標跟蹤問題轉換為貝葉斯理論框架下已知目標狀態的先驗概率,在獲得新的觀測量后求解目標狀態的最大后驗概率的過程:

其中,為狀態轉移模型。本文使用仿射變換對連續兩幀圖像之間的目標運動建模,建立狀態轉移模型。對于觀測似然,首先利用式⑼對候選目標進行稀疏編碼,然后用式⑽求解觀測似然值。

4 實驗結果與分析

為了驗證字典學習算法的有效性,利用Matlab R2010a實現并驗證了文中提出的跟蹤方法。實驗中,跟蹤方法的參數設置如下:采樣粒子數為600,負例樣本數為200,模板大小為32×32,每5幀更新一次模板,字典原子數為16,參數。實驗使Faceocc1、Singer1、Car4、CarDark[12]4組序列對本方法進行了定性和定量分析,并與IVT[11]、L1APG[4]和MTT[13]4種跟蹤方法進行了對比。

4.1 定性分析

圖2給出了對IVT、L1APG、MTT及本文跟蹤方法的定性比較。圖2(a)給出對遮擋目標的跟蹤結果,可以看出,本文方法結果最優。圖2(b)、(c)給出了存在光照和姿態變化時的跟蹤結果,可以看出,本文方法優于其他方法。圖2(d)中跟蹤目標的背景比較復雜,可以看出,本文方法的跟蹤結果較優。

4.2 定量分析

實驗采用成功率[12]指標進行定量分析,實驗中重疊閾值設定為0到1。圖3給出了4種跟蹤方法對4組圖像序列的成功率曲線。由圖3可知,在成功率方面,本文方法都優于其他4種方法。

5 結論

針對現有L1跟蹤的不足,本文提出一種在線魯棒判別式字典學習模型用于L1跟蹤模板更新。該模型提高了模板更新的魯棒性和跟蹤精度。以粒子濾波為框架實現了基于在線魯棒判別式字典學習的視覺跟蹤方法。采用具有挑戰性的圖像序列對提出的跟蹤方法進行了實驗驗證,實驗結果表明,本文的跟蹤方法優于其他現有跟蹤方法。

參考文獻(References):

[1] 張煥龍,胡士強,楊國勝.基于外觀模型學習的視頻目標跟蹤方法綜述[J].計算機研究與發展,2015.51(1):177-190

[2] Xue Mei, Haibin Ling. Robust visual tracking using L1minimization[C]. Proceedings of IEEE Conference on Computer Vision. Kyoto: IEEE Computer Society Press,2009:1436-1443

[3] Mei X, Ling H B, Wu Y, et al. Minimum error boundedefficient L1 tracker with occlusion detection[C]. Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Colorado: IEEE Computer Society Press,2011:1257-1264

[4] Chenglong Bao, Yi Wu, Haibin Ling, et al. Real time robust L1 tracker using accelerated proximal gradient approach[C]. Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Rhode Island: IEEE Computer Society Press,2012:1830-1837

[5] Dong Wang, Huchuan Lu, Ming-Hsuan Yang. Least soft-thresold squares tracking[C]. Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Portland: IEEE Computer Society Press,2013:2371-2378

[6] Zhibin Hong, Xue Mei, Danil Prokhorov, et al. Tracking via robust multi-task multi-view joint sparse representation[C]. Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Portland: IEEE Computer Society Press,2013:649-656

[7] J. Xing, J. Gao, B. Li, W. Hu, S. Yan. Robust objecttracking with online multi-lifespan dictionary learning[C]. Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Portland: IEEE Computer Society Press,2013:665-672

[8] N. Wang, J. Wang, D. Yeung. Online robust non-negative dictionary learning for visual tracking[C]. Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Portland: IEEE Computer Society Press,2013:657-664

[9] Mairal J, Bach F, Ponce J, et al. Online learning for matrix factorization and sparse coding [J]. Journal of Machine Learning Research,2010(11):19-60

[10] Lu Ce-wu, Shi Jian-ping, Jia Jia-ya. Online robust dictionary learning[C]. Proceedings of IEEE Conference on Computer Vision and Pattern Recognition,Portland,2013:415-422

[11] Ross D, Lim J, Lin R S, et al. Incremental learning for robust visual tracking[J]. International Journal of Computer Vision,2008.77(1-3):125-141

[12] Yi Wu, Jongwoo Lim, Ming-Hsuan Yang. Online object tracking: a benchmark[C]. Proceedings of IEEE Conference on Computer Vision and Pattern Recognition. Portland: IEEE Computer Society Press,2013:2411-2418

[13] Tianzhu Zhang , Bernard Ghanem, Si Liu , et al. Robust visual tracking via multi-task sparse learning[J]. International Journal of Computer Vision,2013.101(2):367-383