基于GRU的命名實(shí)體識(shí)別方法①

王 潔,張瑞東,吳晨生

1(北京工業(yè)大學(xué) 信息學(xué)部,北京 100124)

2(北京市科學(xué)技術(shù)情報(bào)研究所,北京 100048)

1 引言

自然語(yǔ)言處理(Nature Language Processing)是近年來快速發(fā)展的一門涵蓋了數(shù)學(xué)、語(yǔ)言學(xué)和計(jì)算機(jī)科學(xué)的交叉學(xué)科.其旨在讓計(jì)算機(jī)能夠正確的理解人類的語(yǔ)言,并且實(shí)現(xiàn)人與機(jī)器之間通過自然語(yǔ)言進(jìn)行交互,其中包括信息抽取、機(jī)器翻譯、信息檢索、問答系統(tǒng)等方面[1].

命名實(shí)體識(shí)別是自然語(yǔ)言處理的一項(xiàng)關(guān)鍵任務(wù),在1995年的MUC會(huì)議上被第一次引入,目的是識(shí)別文本中的特定類型的事物名稱和有意義的數(shù)量短語(yǔ),包括命名性實(shí)體、時(shí)間、數(shù)字等三大類,又可細(xì)分為七個(gè)小類:人名、地名、機(jī)構(gòu)名、時(shí)間、日期、貨幣以及百分比等[2].作為自然語(yǔ)言處理中的一項(xiàng)基礎(chǔ)任務(wù),命名實(shí)體識(shí)別對(duì)于機(jī)器翻譯、信息的檢索與抽取等工作有重要意義.隨著時(shí)代的發(fā)展,命名實(shí)體識(shí)別的目標(biāo)早已超出了上述幾類的范圍,特定領(lǐng)域的命名實(shí)體識(shí)別需求非常廣泛,如電子病歷、生物醫(yī)學(xué)等領(lǐng)域,本文的子實(shí)驗(yàn)既是在會(huì)議名稱識(shí)別這一特定領(lǐng)域的命名實(shí)體上展開的.除了需要識(shí)別的實(shí)體在不斷增加外,命名實(shí)體識(shí)別方法也在不斷進(jìn)步和完善[3–5].

傳統(tǒng)的命名實(shí)體識(shí)別多采用基于規(guī)則和統(tǒng)計(jì)機(jī)器學(xué)習(xí)的方法.最初,命名實(shí)體識(shí)別采用基于手工制定詞典和規(guī)則的方法.這些方法大多以語(yǔ)言學(xué)專家建立的規(guī)則知識(shí)庫(kù)和詞典為基礎(chǔ),采用模式匹配或者字符串匹配的方法識(shí)別命名實(shí)體[6,7].對(duì)于規(guī)律性強(qiáng)的文本,基于規(guī)則的方法準(zhǔn)確而且高效.但對(duì)于規(guī)律性不強(qiáng)的文本,規(guī)則的編寫變得困難,識(shí)別效果也相當(dāng)不理想,所以人們開始將目光投向機(jī)器學(xué)習(xí)的方法.

在命名實(shí)體識(shí)別領(lǐng)域常用的機(jī)器學(xué)習(xí)方法有隱馬爾可夫模型(Hidden Markov Model,HMM)、條件隨機(jī)場(chǎng)模型(Conditional Random Fields,CRF)、最大熵模型(Maximum Entropy)、支持向量機(jī)模型(Support Vector Machine,SVM)等[8–10].其中最典型的也是應(yīng)用比較成功的是隱馬爾可夫模型和條件隨機(jī)場(chǎng)模型.基于機(jī)器學(xué)習(xí)的方法在遷移性、識(shí)別效果等方面的表現(xiàn)優(yōu)于基于規(guī)則的方法,但使用統(tǒng)計(jì)機(jī)器學(xué)習(xí)方法的命名實(shí)體識(shí)別模型也存在一些局限性.一方面,為了使推理易于處理,它需要明確的依賴性假設(shè);另一方面,以統(tǒng)計(jì)模型為基礎(chǔ)的機(jī)器學(xué)習(xí)方法對(duì)特征選取的要求比較高,需要選擇對(duì)命名實(shí)體識(shí)別任務(wù)有影響的各種特征,即特征工程(feature engineering),它對(duì)識(shí)別結(jié)果有重要影響,但是該過程費(fèi)時(shí)費(fèi)力[11–14];最后,它們通常需要大量的與任務(wù)相關(guān)的特定知識(shí),如設(shè)計(jì)HMM的狀態(tài)模型,或選擇CRF的輸入特征.

隨著深度學(xué)習(xí)研究的不斷深入,人們開始引入深度神經(jīng)網(wǎng)絡(luò)來處理自然語(yǔ)言.2011年Collobert提出一種基于窗口的深層神經(jīng)網(wǎng)絡(luò)模型,該模型可以自動(dòng)學(xué)習(xí)輸入句子中的抽象特征,在訓(xùn)練中使用反向傳播算法來訓(xùn)練參數(shù).其效果和性能超過了之前的傳統(tǒng)算法.該模型的主要局限性是使用固定長(zhǎng)度的上下文,不能充分的利用語(yǔ)境信息[15–18].Mikolov于2010年提出一種基于循環(huán)神經(jīng)網(wǎng)絡(luò)(Recurrent Neural Networks,RNNs)的語(yǔ)言模型,它不使用固定大小的上下文信息,通過重復(fù)鏈接,信息可以在這些網(wǎng)絡(luò)內(nèi)循環(huán),這種信息循環(huán)的方式非常適用于處理序列數(shù)據(jù)[19–24].

本文利用循環(huán)神經(jīng)網(wǎng)絡(luò)在處理序列數(shù)據(jù)方面的優(yōu)勢(shì),建立了基于循環(huán)神經(jīng)網(wǎng)絡(luò)的命名實(shí)體識(shí)別模型.循環(huán)神經(jīng)網(wǎng)絡(luò)包含多種不同的變體,經(jīng)過分析對(duì)比,本文最終選用了由RNN改進(jìn)而來、結(jié)構(gòu)相對(duì)簡(jiǎn)單的GRU.本文結(jié)構(gòu)安排如下:第2節(jié)介紹語(yǔ)料庫(kù)的構(gòu)建;第3節(jié)闡述基于GRU的命名實(shí)體識(shí)別模型;第4節(jié)是實(shí)驗(yàn)和分析;最后做全文總結(jié).

2 基于 GRU 的命名實(shí)體識(shí)別模型

以字作為輸入單位容易產(chǎn)生歧義,需要根據(jù)具體的語(yǔ)境信息判斷每個(gè)字的標(biāo)簽,循環(huán)神經(jīng)網(wǎng)絡(luò)能很好的計(jì)算和保持語(yǔ)境信息.RNN是比較簡(jiǎn)單的循環(huán)神經(jīng)網(wǎng)絡(luò),不含“門”結(jié)構(gòu),訓(xùn)練時(shí)會(huì)出現(xiàn)梯度消失或梯度爆炸的問題.LSTM與GRU是在RNN的基礎(chǔ)上改進(jìn)而來的循環(huán)神經(jīng)網(wǎng)絡(luò),本文分析了RNN、LSTM和GRU三種循環(huán)神經(jīng)網(wǎng)絡(luò)之間的關(guān)系,在此基礎(chǔ)上,提出了一個(gè)基于GRU的命名實(shí)體識(shí)別模型.該模型以字向量作為輸入,經(jīng)過雙向GRU層計(jì)算,提取句子特征,經(jīng)softmax層計(jì)算得到一個(gè)相應(yīng)的輸出序列.

2.1 循環(huán)神經(jīng)網(wǎng)絡(luò)

循環(huán)神經(jīng)網(wǎng)絡(luò)是深度學(xué)習(xí)中常用的一類神經(jīng)網(wǎng)絡(luò),包括RNN和RNN的變體LSTM、GRU等,它利用序列信息并通過中間層保持這些信息,這使它在處理序列數(shù)據(jù)時(shí)有獨(dú)特優(yōu)勢(shì).

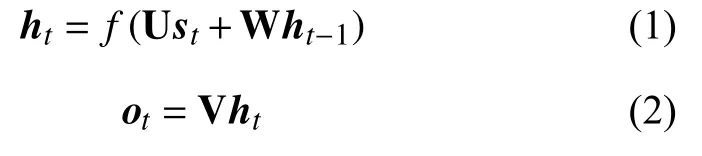

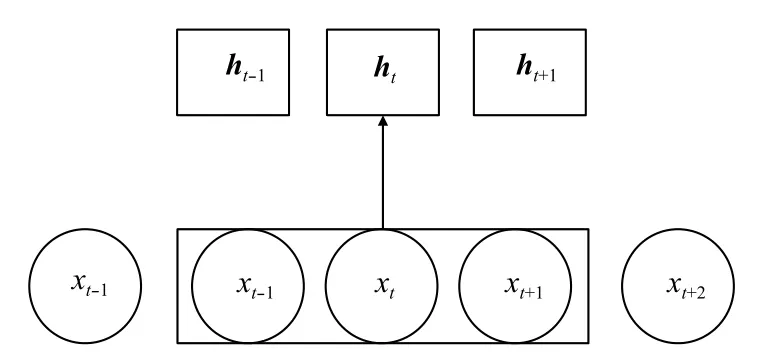

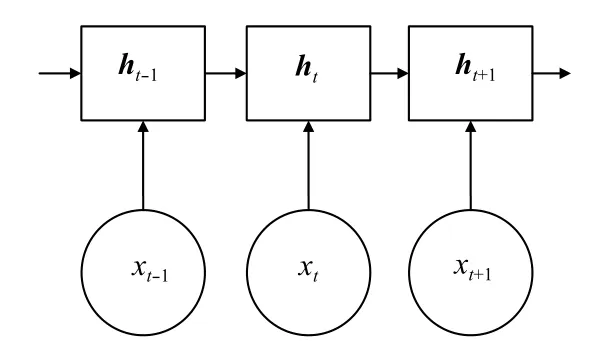

RNN將一個(gè)向量序列(s1,s2,···,sn)作為輸入,得到另一個(gè)序列h1,h2,···,hn,其中st表示時(shí)刻t的輸入向量,ht是隱藏層狀態(tài),表示關(guān)于每個(gè)輸入時(shí)刻t的序列信息,它的結(jié)構(gòu)示意圖如圖1.其中,

U、V、W是權(quán)值矩陣,f是激活函數(shù),一般是Sigmoid或者tanh函數(shù),ot是輸出向量.

圖1 RNN 網(wǎng)絡(luò)

理論上RNN可以學(xué)習(xí)長(zhǎng)期依賴,但實(shí)際上它不能實(shí)現(xiàn)這個(gè)目標(biāo),因?yàn)楦鶕?jù)求導(dǎo)的鏈?zhǔn)椒▌t,公式(1)使得損失函數(shù)的梯度成為連續(xù)乘積的形式,這樣做會(huì)導(dǎo)致梯度消失或者梯度爆炸的問題.

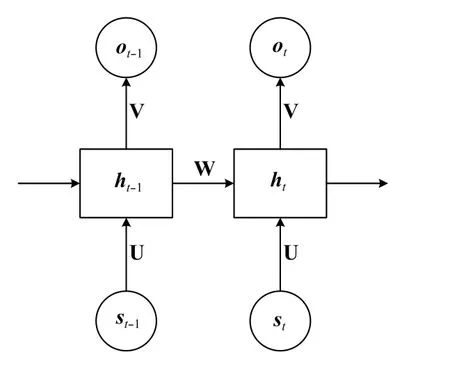

為了解決梯度消失(或者梯度爆炸)的問題,Hochreiter和Schmidhuber[25]提出了一種RNN的改進(jìn)型網(wǎng)絡(luò):LSTM.在自然語(yǔ)言處理中常用的LSTM可以用如下公式來描述:

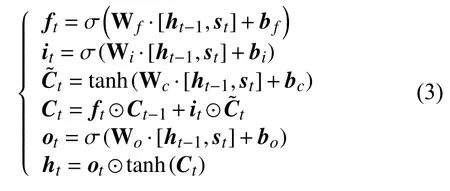

本文使用的GRU是RNN的另一種改進(jìn)模型,它與LSTM非常類似,也是通過門來保持序列信息,同時(shí)克服RNN中的梯度消失問題.它的公式如下:

其中,zt是一個(gè)更新門,決定t–1時(shí)刻的信息有多少進(jìn)入t時(shí)刻.rt是一個(gè)重置門,決定丟棄多少信息,二者共同決定ht的值.GRU只有兩個(gè)門,舍棄了LSTM中增加一個(gè)細(xì)胞狀態(tài)C的做法,把線性自更新的過程放到了隱藏層狀態(tài)的計(jì)算中,把h作為序列信息的載體,這樣做不但使得GRU的結(jié)構(gòu)比LSTM更簡(jiǎn)單,參數(shù)更少,而且加快了神經(jīng)網(wǎng)絡(luò)的計(jì)算速度,節(jié)省了時(shí)間.

2.2 命名實(shí)體識(shí)別模型

近年來,很多學(xué)者使用前饋神經(jīng)網(wǎng)絡(luò)進(jìn)行命名實(shí)體識(shí)別,得到了不錯(cuò)的效果,這種方法一般使用輸入窗口,即利用固定長(zhǎng)度的輸入來學(xué)習(xí)待識(shí)別詞的上下文信息,它的結(jié)構(gòu)可以用圖2描述.

圖2 基于窗口的前饋神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)

因?yàn)榇翱诖笮∮邢?如上圖的窗口大小是3),所以該方法學(xué)習(xí)上下文信息的能力不足.另一方面,該神經(jīng)網(wǎng)絡(luò)的隱藏層狀態(tài)之間沒有聯(lián)系,不能夠?qū)W習(xí)到長(zhǎng)期依賴,對(duì)于序列標(biāo)注任務(wù)來說,這意味著丟失了序列信息.

循環(huán)神經(jīng)網(wǎng)絡(luò)的輸入則不受窗口大小的限制,并且網(wǎng)絡(luò)的隱藏層之間是有聯(lián)系的,即攜帶了序列信息,如圖3所示.

圖3 基于 RNN 的序列處理結(jié)構(gòu)

圖2和圖3中,xt表示t時(shí)刻對(duì)應(yīng)的字或者詞.以字作為輸入單位,命名實(shí)體的長(zhǎng)度一般會(huì)超過三個(gè)字,使用基于窗口的方法無法將整個(gè)名稱作為一個(gè)整體考慮,容易丟失信息,致使邊界判定準(zhǔn)確率低,而且基于字的判別對(duì)上下文環(huán)境的依賴程度更高.循環(huán)神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)上下文信息與窗口大小無關(guān),實(shí)現(xiàn)了學(xué)習(xí)長(zhǎng)期依賴的目的,適用于命名實(shí)體較長(zhǎng)的情況.本文分別使用循環(huán)神經(jīng)網(wǎng)絡(luò)的變體LSTM和GRU作為模型的基本算法,并且對(duì)比說明了GRU的優(yōu)勢(shì).

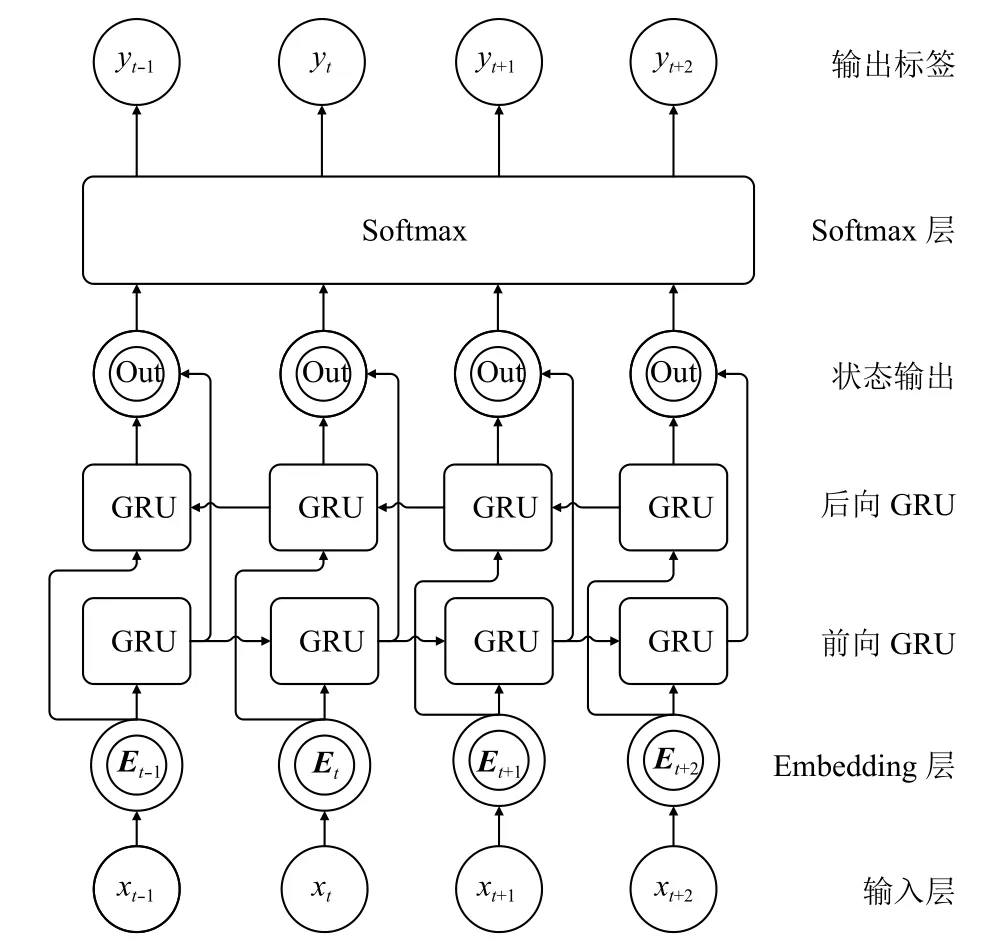

為了充分利用每個(gè)字的上下文信息,這里使用了一個(gè)雙向GRU結(jié)構(gòu),即考慮了句子的正向和反向兩個(gè)方向上的序列信息.另外,用于會(huì)議等新實(shí)體識(shí)別的用料庫(kù)一般較小,所以模型的結(jié)構(gòu)不宜過復(fù)雜,否則容易出現(xiàn)過擬合的現(xiàn)象.本文設(shè)計(jì)的命名實(shí)體識(shí)別模型如圖4所示.

圖4中,模型的第一層和第二層分別對(duì)應(yīng)輸入層和Embedding層.由于神經(jīng)網(wǎng)絡(luò)不能直接處理自然語(yǔ)言符號(hào),所以,應(yīng)該將輸入的字或者詞轉(zhuǎn)換成對(duì)應(yīng)的向量,即Embedding層的工作,其中,向量Et與xt之間的關(guān)系滿足,即通過向量表LT查找xt對(duì)應(yīng)的向量.輸入Et經(jīng)過前向GRU層和后向GRU層計(jì)算得到了句子的正向信息和反向信息,兩者共同組成了隱藏層狀態(tài),這里用ht表示,,經(jīng)過狀態(tài)輸出層計(jì)算得到ot=f(ht),再由Softmax層進(jìn)行概率歸一化計(jì)算,得到最終的預(yù)測(cè)值.

圖4 基于 GRU 的命名實(shí)體識(shí)別網(wǎng)絡(luò)

這里可以把命名實(shí)體識(shí)別當(dāng)作一個(gè)序列標(biāo)注過程,對(duì)于一個(gè)輸入序列:

經(jīng)過模型計(jì)算,給每個(gè)輸入xt一個(gè)對(duì)應(yīng)的標(biāo)簽,得到一個(gè)相應(yīng)的輸出序列:

對(duì)于輸入xt,預(yù)測(cè)結(jié)果為yt滿足:

yt是一個(gè)長(zhǎng)度為n的向量,n是標(biāo)簽種類的個(gè)數(shù),即本文用向量表示預(yù)測(cè)結(jié)果,yt的每個(gè)位置上的值表示是該標(biāo)簽的概率:

訓(xùn)練時(shí),使用交叉熵作為代價(jià)函數(shù):其中,yi表示真實(shí)值,表示預(yù)測(cè)值,n是標(biāo)簽的種類.

得到代價(jià)函數(shù)后,通過訓(xùn)練集訓(xùn)練模型,對(duì)于訓(xùn)練集的使用,一般有批量梯度下降、隨機(jī)梯度下降和mini-batch gradient(小批量梯度下降)三種方法,本文使用第三種方法,因?yàn)榕刻荻认陆捣椒看斡?jì)算損失函數(shù)都要遍歷整個(gè)訓(xùn)練集,并通過計(jì)算函數(shù)對(duì)所有參數(shù)的梯度來更新參數(shù),這種方法每更新一次參數(shù)就要遍歷一次訓(xùn)練集,導(dǎo)致計(jì)算開銷很大,計(jì)算速度較慢;隨機(jī)梯度下降法每次計(jì)算損失函數(shù)僅使用一條數(shù)據(jù),并通過梯度下降來更新參數(shù).與第一種方法相比,雖然該方法的計(jì)算速度比較快,但是收斂性能較差;而第三種方法則結(jié)合了二者的優(yōu)點(diǎn),它把訓(xùn)練數(shù)據(jù)分成多個(gè)批次,計(jì)算損失函數(shù)時(shí)只使用其中的一批.這樣,梯度的方向由這一小批次中的數(shù)據(jù)共同決定,降低了方向選擇的隨機(jī)性,提高了收斂性能;同時(shí),與整個(gè)訓(xùn)練集相比,每個(gè)批次數(shù)據(jù)量要小很多,這降低了計(jì)算量,節(jié)省了計(jì)算開銷.

過擬合是使用人工神經(jīng)網(wǎng)絡(luò)時(shí)經(jīng)常遇到的問題,尤其是語(yǔ)料規(guī)模較小時(shí),更容易產(chǎn)生過擬合現(xiàn)象,為了解決這個(gè)問題,本文采用了 DropOut方法.DropOut是Srivastava[26]提出的用來解決前饋神經(jīng)網(wǎng)絡(luò)過擬合問題的方法,它通過在訓(xùn)練過程中隨機(jī)的讓一些神經(jīng)元暫時(shí)停止工作來增加網(wǎng)絡(luò)的稀疏性.與權(quán)重衰減、過濾器范數(shù)約束等其它防止過擬合的方法相比,DropOut方法更有效,而且計(jì)算方便,只需要在訓(xùn)練過程中產(chǎn)生相應(yīng)的隨機(jī)數(shù)來控制神經(jīng)元的開閉即可.在循環(huán)神經(jīng)網(wǎng)絡(luò)中,將DropOut應(yīng)用到非循環(huán)層,這樣做即能有效的避免過擬合的出現(xiàn),又能保證神經(jīng)元之間不失去“聯(lián)系”,保存了序列信息.

本文提出的模型需要在監(jiān)督訓(xùn)練數(shù)據(jù)上進(jìn)行訓(xùn)練.對(duì)于特定領(lǐng)域的命名實(shí)體識(shí)別來說,往往沒有可用的標(biāo)注語(yǔ)料,自己構(gòu)建的語(yǔ)料庫(kù)規(guī)模又比較小,為了提高模型的效果,一方面,應(yīng)當(dāng)盡可能降低模型的復(fù)雜程度,所以,本文設(shè)計(jì)的模型只使用了一層雙向GRU結(jié)構(gòu);另一方面,將已有的相關(guān)標(biāo)注語(yǔ)料融合到自建語(yǔ)料庫(kù)中,可以豐富預(yù)料的語(yǔ)境語(yǔ)義特征,提高識(shí)別效果,第3節(jié)通過實(shí)驗(yàn)說明了該方法的可行性.

3 實(shí)驗(yàn)與分析

本文分別在人名這一傳統(tǒng)命名實(shí)體和會(huì)議名稱這個(gè)特定領(lǐng)域?qū)嶓w上進(jìn)行了實(shí)驗(yàn).人名識(shí)別實(shí)驗(yàn)使用的是人民日?qǐng)?bào)語(yǔ)料庫(kù).會(huì)議名稱識(shí)別使用的是自建語(yǔ)料庫(kù).由于本文的成果最終要運(yùn)用到情報(bào)所的工作實(shí)踐中,所以兩類實(shí)驗(yàn)使用的都是字向量,第3.2節(jié)會(huì)進(jìn)一步分析使用字向量的優(yōu)勢(shì).

3.1 語(yǔ)料庫(kù)構(gòu)建

語(yǔ)料庫(kù)是進(jìn)行自然語(yǔ)言處理必須的數(shù)據(jù)集,它承載著重要的語(yǔ)言知識(shí).基于神經(jīng)網(wǎng)絡(luò)的命名實(shí)體識(shí)別需要帶標(biāo)注的預(yù)料庫(kù)作為訓(xùn)練數(shù)據(jù).本文除了在傳統(tǒng)命名實(shí)體領(lǐng)域測(cè)試模型外,還使用會(huì)議名稱這一特定領(lǐng)域?qū)嶓w對(duì)模型進(jìn)行了測(cè)試.由于目前沒有會(huì)議名稱識(shí)別的語(yǔ)料庫(kù),本文通過搜集文本、篩選、分詞和標(biāo)注等步驟構(gòu)建了一個(gè)針對(duì)會(huì)議名稱識(shí)別的語(yǔ)料庫(kù).

文本搜集是構(gòu)建語(yǔ)料庫(kù)的第一步.本文搜集的文本來自中國(guó)學(xué)術(shù)會(huì)議在線網(wǎng).這里搜集了會(huì)議預(yù)告、會(huì)議新聞、會(huì)議評(píng)述、會(huì)議回顧的相關(guān)材料,一共得到了31.2 M的初始文本.

第二步需要人工篩選搜集的文本,刪除大量與會(huì)議名稱無關(guān)的段落,并使用結(jié)巴分詞對(duì)文本句子進(jìn)行切分,形成了初步標(biāo)識(shí)的語(yǔ)料庫(kù).

第三步,標(biāo)注已經(jīng)處理過的文本,即人工標(biāo)注會(huì)議名稱.會(huì)議名稱有兩種,一種是簡(jiǎn)單會(huì)議名稱,如“中國(guó)醫(yī)學(xué)會(huì)年會(huì)”、“香山論壇”、“十八屆四中全會(huì)”等,這類名稱不存在嵌套,屬于簡(jiǎn)單的會(huì)議名稱;第二種是結(jié)構(gòu)復(fù)雜的會(huì)議名稱,包括嵌套格式、并列結(jié)構(gòu)等,如“香山科學(xué)會(huì)議第473次學(xué)術(shù)討論會(huì)”、“第四屆中國(guó)古籍?dāng)?shù)字化國(guó)際學(xué)術(shù)研討會(huì)暨第六屆文學(xué)與資訊技術(shù)國(guó)際研討會(huì)”.本文采取的策略是最大化邊界,即將最完整的會(huì)議名稱作為一個(gè)標(biāo)注單位,給予會(huì)議標(biāo)簽,完成標(biāo)注.這樣做的優(yōu)勢(shì)是可以根據(jù)后續(xù)實(shí)驗(yàn)的具體策略靈活的改變會(huì)議名稱的標(biāo)注方式,既可以采用并列結(jié)構(gòu)分別標(biāo)注的方法,也可以采用整體標(biāo)注的方法.

完成上述步驟后,得到了一個(gè)針對(duì)會(huì)議名稱識(shí)別的專用語(yǔ)料庫(kù),為實(shí)驗(yàn)提供了可用的數(shù)據(jù)集.

3.2 字向量

語(yǔ)料庫(kù)中的數(shù)據(jù)并不能直接輸入到本文的模型中,因?yàn)樯窠?jīng)網(wǎng)絡(luò)只能計(jì)算數(shù)字,所以應(yīng)先將詞或者字轉(zhuǎn)換成數(shù)字形式,即轉(zhuǎn)換成向量.傳統(tǒng)的方法是先將文本分詞,以詞向量作為輸入單位.以詞作為輸入單位需要首先進(jìn)行分詞,本文沒有采用先分詞再識(shí)別的方法,而是直接使用字向量作為模型的輸入,采用字向量有如下兩點(diǎn)優(yōu)勢(shì):

1)以字作為輸入單位可以避免不同分詞系統(tǒng)及分詞錯(cuò)誤對(duì)識(shí)別效果的影響,節(jié)省了分詞時(shí)間,提高了模型的識(shí)別速度;

2)新領(lǐng)域的自建語(yǔ)料庫(kù)相對(duì)較小,如果以詞作為輸入單位,那么測(cè)試時(shí)會(huì)遇到很多未登錄詞,降低識(shí)別效果.而常用漢字不超過 3000 個(gè),相對(duì)于詞,數(shù)據(jù)集覆蓋的字的種類更加全面,采用字向量可以避免因?yàn)槲吹卿浽~過多而影響識(shí)別效果的情況.

會(huì)議名稱識(shí)別中,為了進(jìn)一步提高模型的泛化能力,訓(xùn)練字向量時(shí)采用了兩種數(shù)據(jù)集,一種是基于自建語(yǔ)料庫(kù)的數(shù)據(jù)集,記為DataSet1;另一種則通過加入人民日?qǐng)?bào)語(yǔ)料庫(kù)擴(kuò)展了原有數(shù)據(jù)集,這種擴(kuò)展并沒有增加帶標(biāo)注的會(huì)議語(yǔ)料的規(guī)模,只是增加了與會(huì)議無關(guān)的文本,達(dá)到豐富數(shù)據(jù)集特征的目的,該數(shù)據(jù)集記為DataSet2.本文使用的字向量隨循環(huán)神經(jīng)網(wǎng)絡(luò)訓(xùn)練過程產(chǎn)生.

3.3 標(biāo)注策略與評(píng)價(jià)指標(biāo)

命名實(shí)體識(shí)別中常用的標(biāo)注策略有BIO、BIEO、BIESO,O 表示不是實(shí)體,S 表示單個(gè)實(shí)體,B 表示實(shí)體其實(shí)邊界,I表示實(shí)體的中間部分,E表示實(shí)體的結(jié)束邊界.由于本文采用的是輸入形式是字向量,所以必須同時(shí)找出起始和結(jié)束邊界,所以采用BIEO形式的標(biāo)注策略.命名實(shí)體識(shí)別的結(jié)果是否正確有兩個(gè)標(biāo)準(zhǔn):①實(shí)體的邊界正確,類型正確;② 類型正確,邊界只覆蓋了實(shí)體的一部分.只要滿足上述兩個(gè)條件中的一個(gè),就認(rèn)為識(shí)別結(jié)果是正確的.

本文使用精確率、召回率和F值來評(píng)價(jià)模型的識(shí)別效果.命名實(shí)體識(shí)別可以看做分類問題,以人名識(shí)別為例,正類(Positive)表示該詞的預(yù)測(cè)結(jié)果是人名,負(fù)類(Negative)表示該詞的預(yù)測(cè)結(jié)果不是人名.人名被正確識(shí)別的個(gè)數(shù)為TP,即正類中真正的人名個(gè)數(shù)是TP;正類中非人名的個(gè)數(shù)為FP;負(fù)類中非人名的個(gè)數(shù)為TN;負(fù)類中被錯(cuò)誤識(shí)別的個(gè)數(shù)為FN,即被預(yù)測(cè)為負(fù)類的人名的個(gè)數(shù)是FN.則精確率P、召回率R、F值的計(jì)算公式如下:

3.4 實(shí)驗(yàn)結(jié)果與分析

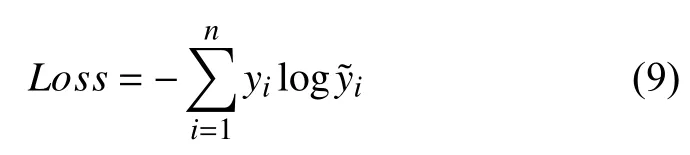

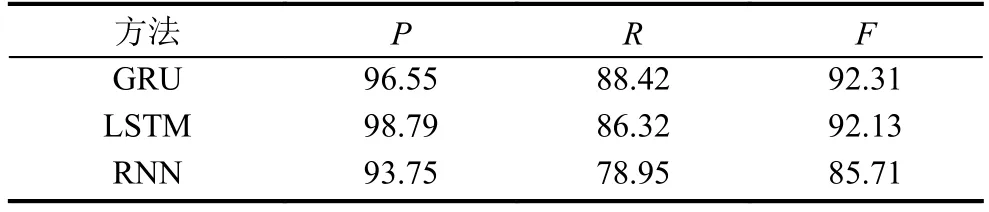

通過上述評(píng)價(jià)指標(biāo),文章對(duì)比了LSTM、GRU和RNN的識(shí)別效果.表1是人名的識(shí)別結(jié)果,可以看出,三種網(wǎng)絡(luò)在召回率方面相差較少,但是GRU的識(shí)別結(jié)果的準(zhǔn)確率更高,得到了最高的F值.

表1 人名識(shí)別實(shí)驗(yàn)結(jié)果

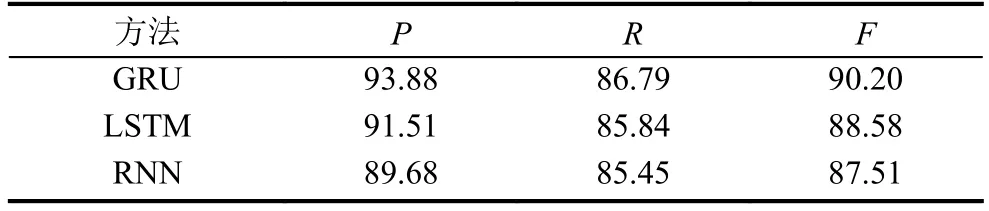

表2和表3分別是在DataSet1和DataSet2上對(duì)會(huì)議名稱進(jìn)行識(shí)別的結(jié)果,觀察兩個(gè)表可知,在兩個(gè)數(shù)據(jù)集上,GRU的都得到了最高的F值.由表2實(shí)驗(yàn)結(jié)果可知,在DataSet2數(shù)據(jù)集上訓(xùn)練的模型,效果要好于DataSet1上訓(xùn)練的模型.雖然DataSet2數(shù)據(jù)集只是增加了與會(huì)議無關(guān)的文本,但它豐富了文本特征,提高了模型的泛化能力.

表2 DataSet1 會(huì)議名稱識(shí)別結(jié)果

表3 DataSet2 會(huì)議名稱識(shí)別結(jié)果

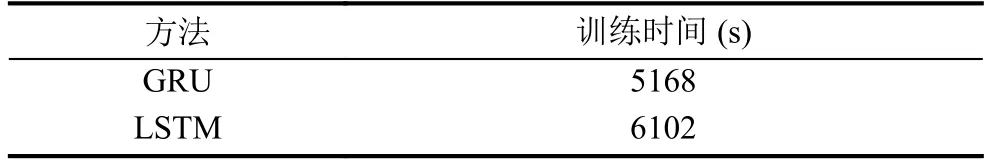

表4是GRU和LSTM的訓(xùn)練時(shí)間,根據(jù)實(shí)驗(yàn)結(jié)果可知,GRU與LSTM的效果相差并不顯著,但是由于GRU結(jié)構(gòu)相對(duì)簡(jiǎn)單,參數(shù)較少,所以它的訓(xùn)練時(shí)間比LSTM減少約15%,這是GRU的優(yōu)勢(shì)所在.

表4 GRU 與 LSTM 訓(xùn)練時(shí)間對(duì)比

4 結(jié)束語(yǔ)

本文提出了一個(gè)基于GRU的會(huì)議名稱識(shí)別模型,并且在傳統(tǒng)命名實(shí)體和特定領(lǐng)域?qū)嶓w兩類實(shí)體上進(jìn)行了實(shí)驗(yàn),并且根據(jù)識(shí)別會(huì)議名稱的需要搜集了會(huì)議文本,通過機(jī)器分詞和人工標(biāo)注構(gòu)建了語(yǔ)料庫(kù).本文使用的方法的最大的優(yōu)勢(shì)是不依賴外部知識(shí),省去了人工設(shè)計(jì)特征的繁瑣工作,是一種端到端的會(huì)議名稱識(shí)別方法.識(shí)別特定領(lǐng)域命名實(shí)體是命名實(shí)體識(shí)別的一個(gè)發(fā)展方向,但經(jīng)常面臨沒有監(jiān)督訓(xùn)練數(shù)據(jù)的困境,自建的數(shù)據(jù)庫(kù)又比較小,這就在一定程度上限制了神經(jīng)網(wǎng)絡(luò)模型的泛化能力,如何利用自建的小語(yǔ)料集訓(xùn)練一個(gè)具有足夠泛化能力的神經(jīng)網(wǎng)絡(luò)模型是一個(gè)值得探索的方向.