基于自學(xué)習(xí)深度卷積神經(jīng)網(wǎng)絡(luò)的姿態(tài)變化人臉識(shí)別

鄒國(guó)鋒,傅桂霞,高明亮,尹麗菊,王科俊

1(山東理工大學(xué) 電氣與電子工程學(xué)院,山東 淄博 255049)

2(哈爾濱工程大學(xué) 自動(dòng)化學(xué)院,哈爾濱 150001)

1 引 言

自動(dòng)人臉識(shí)別因其良好的隱蔽性、快速采集性,在很多實(shí)際應(yīng)用中起著重要作用,特別在公共安全領(lǐng)域具有非常好的應(yīng)用前景[1].非約束環(huán)境中,人臉容易受到很多可變因素(姿態(tài)、光照、遮擋等)干擾,導(dǎo)致現(xiàn)有人臉識(shí)別算法和技術(shù)的可靠性嚴(yán)重下降.姿態(tài)變化是對(duì)非約束環(huán)境下人臉圖像采集和人臉識(shí)別系統(tǒng)性能影響最嚴(yán)重的因素.因此,針對(duì)非受約束環(huán)境下的姿態(tài)變化人臉識(shí)別開(kāi)展分析研究具有重要的理論意義和應(yīng)用價(jià)值.

因姿態(tài)變化已成為人臉識(shí)別在非約束環(huán)境下應(yīng)用的重要瓶頸之一,因此有眾多研究者從事這一領(lǐng)域的研究工作,并取得了很多卓越的研究成果[2].例如基于單樣本的姿態(tài)變化人臉識(shí)別[3-5],基于二維多視圖姿態(tài)矯正的人臉識(shí)別[6-8],三維姿態(tài)變化人臉識(shí)別[9-11],針對(duì)多視圖姿態(tài)人臉的新特征提取方法[12-16]等.姿態(tài)變化的人臉圖像采集通常無(wú)法得到被采集者的有效配合,獲取的人臉圖像分布在高維非線(xiàn)性流形空間.因此,有效提取姿態(tài)人臉圖像的深層非線(xiàn)性特征是解決姿態(tài)人臉識(shí)別問(wèn)題的關(guān)鍵.

深度學(xué)習(xí)作為模擬人腦進(jìn)行分析和學(xué)習(xí)的深層神經(jīng)網(wǎng)絡(luò),其基本思想是通過(guò)有監(jiān)督或無(wú)監(jiān)督方式學(xué)習(xí)層次化特征表達(dá),建立底層信號(hào)到高層語(yǔ)義的映射關(guān)系.卷積神經(jīng)網(wǎng)絡(luò)作為典型的深度學(xué)習(xí)模型,在圖像識(shí)別中展現(xiàn)出獨(dú)特優(yōu)越性.Qin等人[17]提出基于級(jí)聯(lián)卷積神經(jīng)網(wǎng)絡(luò)的無(wú)約束自然狀態(tài)人臉檢測(cè)算法,采用一種聯(lián)合訓(xùn)練算法實(shí)現(xiàn)多個(gè)卷積神經(jīng)網(wǎng)絡(luò)的級(jí)聯(lián)和快速運(yùn)算,并獲得一個(gè)端到端的最優(yōu)化卷積網(wǎng)絡(luò)檢測(cè)器,實(shí)現(xiàn)人臉檢測(cè).Liu等人[18]采用新的深度學(xué)習(xí)理論框架訓(xùn)練卷積神經(jīng)網(wǎng)絡(luò)用于自然狀態(tài)人臉屬性識(shí)別,在類(lèi)別信息明確的大訓(xùn)練樣本集上效果明顯.Iacopo Masi[19]基于深度卷積神經(jīng)網(wǎng)絡(luò)提出一種姿態(tài)感知模型學(xué)習(xí)姿態(tài)變化人臉的多個(gè)判別性表示,并通過(guò)多特征融合獲得姿態(tài)人臉單一模型用于識(shí)別,自然狀態(tài)下的姿態(tài)人臉識(shí)別效果得到一定改善.石祥濱等[20]提出一種對(duì)稱(chēng)神經(jīng)網(wǎng)絡(luò)模型,將兩個(gè)特征維度相同的深度神經(jīng)網(wǎng)絡(luò)作為對(duì)稱(chēng)模型的左右子網(wǎng)絡(luò),通過(guò)前向傳播得到有差異的圖像特征,并在聯(lián)合層對(duì)差異特征進(jìn)行融合,實(shí)驗(yàn)表明該方式集成的對(duì)稱(chēng)深度模型能取得較好的分類(lèi)性能.

盡管卷積神經(jīng)網(wǎng)絡(luò)在圖像識(shí)別中取得了一些令人滿(mǎn)意的成果,但在理論和應(yīng)用方面仍有一些亟待解決的關(guān)鍵問(wèn)題.網(wǎng)絡(luò)模型結(jié)構(gòu)設(shè)計(jì)主要依賴(lài)于人為經(jīng)驗(yàn),網(wǎng)絡(luò)深度、特征圖個(gè)數(shù)等參數(shù)設(shè)置缺乏理論依據(jù),模型構(gòu)建與處理的樣本沒(méi)有直接關(guān)聯(lián);網(wǎng)絡(luò)訓(xùn)練需要大量訓(xùn)練樣本支持,當(dāng)樣本采集受到限制時(shí),如何實(shí)現(xiàn)樣本擴(kuò)充等等.這都是卷積神經(jīng)網(wǎng)絡(luò)研究和應(yīng)用的重點(diǎn)和難點(diǎn)問(wèn)題.因此,針對(duì)卷積網(wǎng)絡(luò)結(jié)構(gòu)設(shè)計(jì)缺乏理論依據(jù)、模型結(jié)構(gòu)與樣本缺乏關(guān)聯(lián)性和姿態(tài)變化人臉樣本的擴(kuò)充等問(wèn)題,本文提出了姿態(tài)變化人臉的樣本擴(kuò)充方法和深度卷積神經(jīng)網(wǎng)絡(luò)模型結(jié)構(gòu)的自學(xué)習(xí)方法.

鑒于姿態(tài)變化人臉圖像分布于非線(xiàn)性流形空間的特點(diǎn),本文提出一種基于局部子空間的姿態(tài)變化人臉樣本擴(kuò)充思路.首先依據(jù)人臉圖像俯仰角的不同,將姿態(tài)變化人臉流形空間劃分為不同流形層;然后在每個(gè)流形層內(nèi),依據(jù)人臉圖像左右視角的不同,將每個(gè)流形層劃分為不同的局部子空間.基于不同流形層和不同局部子空間,分別在子空間內(nèi)、子空間之間,構(gòu)建一種能夠有效克服人臉樣本中存在孤立點(diǎn)或噪聲干擾的人臉底層特征,實(shí)現(xiàn)姿態(tài)變化人臉的擴(kuò)充.

針對(duì)卷積神經(jīng)網(wǎng)絡(luò)模型構(gòu)建缺乏理論依據(jù)和模型結(jié)構(gòu)與樣本缺乏關(guān)聯(lián)性的問(wèn)題,本文提出一種關(guān)聯(lián)訓(xùn)練樣本的深度卷積神經(jīng)網(wǎng)絡(luò)模型結(jié)構(gòu)的自學(xué)習(xí)算法,實(shí)現(xiàn)姿態(tài)變化人臉的深層特征提取和識(shí)別.該算法根據(jù)參與訓(xùn)練樣本的情況實(shí)現(xiàn)網(wǎng)絡(luò)結(jié)構(gòu)的自學(xué)習(xí)擴(kuò)展,直到獲得最優(yōu)的分類(lèi)結(jié)果.首先,將卷積神經(jīng)網(wǎng)絡(luò)模型的卷積層和池化層設(shè)置為僅含一幅特征圖;然后,以卷積神經(jīng)網(wǎng)絡(luò)的收斂速度作為評(píng)價(jià)指標(biāo),對(duì)網(wǎng)絡(luò)進(jìn)行全局學(xué)習(xí),直到網(wǎng)絡(luò)系統(tǒng)平均誤差達(dá)到預(yù)設(shè)期望值,則全局網(wǎng)絡(luò)學(xué)習(xí)結(jié)束.最后,采用交叉驗(yàn)證樣本測(cè)試全局學(xué)習(xí)所得網(wǎng)絡(luò)的識(shí)別率,若識(shí)別率未達(dá)到期望值,則對(duì)卷積神經(jīng)網(wǎng)絡(luò)展開(kāi)局部學(xué)習(xí),直到識(shí)別率達(dá)到預(yù)設(shè)期望值后停止網(wǎng)絡(luò)學(xué)習(xí).通過(guò)自學(xué)習(xí)產(chǎn)生的網(wǎng)絡(luò)模型與訓(xùn)練樣本密切關(guān)聯(lián),不需要人為設(shè)置網(wǎng)絡(luò)結(jié)構(gòu)深度和特征圖個(gè)數(shù),實(shí)現(xiàn)了基于數(shù)據(jù)驅(qū)動(dòng)的網(wǎng)絡(luò)模型構(gòu)建.多個(gè)人臉圖像庫(kù)的識(shí)別實(shí)驗(yàn)驗(yàn)證了本文所提算法在網(wǎng)絡(luò)訓(xùn)練時(shí)間和識(shí)別效果上的有效性.

2 姿態(tài)變化人臉樣本的擴(kuò)充

2.1 人臉底層特征圖構(gòu)建

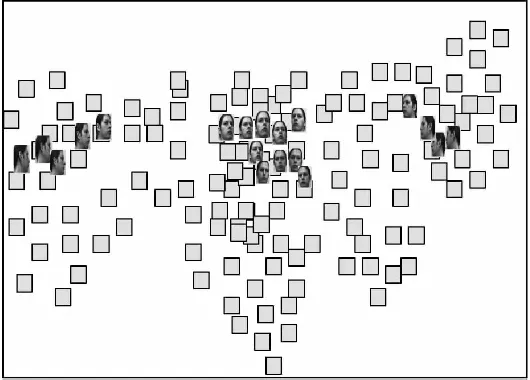

姿態(tài)變化人臉數(shù)據(jù)集包含多人的多幅人臉圖像,且這些圖像分布于高維非線(xiàn)性流形空間.圖1展示了某人的典型人臉圖像的2維嵌入結(jié)果,小方塊表示原始輸入人臉圖像的低維映射,一些代表圖像顯示在相應(yīng)的樣本點(diǎn)位置.從這些代表圖像可以看出,嵌入結(jié)果的坐標(biāo)軸對(duì)應(yīng)于原始數(shù)據(jù)隱含的自由度.橫軸表示這些圖像中的人臉從左轉(zhuǎn)向右發(fā)生了視角變化,而縱軸則表示這些圖像發(fā)生的俯仰角度變化.分析發(fā)現(xiàn),姿態(tài)變化人臉圖像都分布于非線(xiàn)性流形上,而該流形結(jié)構(gòu)可以被劃分為多個(gè)局部線(xiàn)性的子空間結(jié)構(gòu).因此,根據(jù)姿態(tài)變化人臉數(shù)據(jù)集合的分布特點(diǎn),姿態(tài)變化人臉數(shù)據(jù)集被劃分為若干子集合.

圖1 人臉在2維空間的可視化Fig.1 Face visualization in the 2 dimensional space

本文結(jié)合姿態(tài)變化人臉的高維非線(xiàn)性流形分布特點(diǎn),提出了一種針對(duì)姿態(tài)變化人臉?lè)蔷€(xiàn)性流形結(jié)構(gòu)的劃分方法,并基于此劃分方法提出基于局部線(xiàn)性子空間的人臉底層特征構(gòu)建方法.具體描述如下:

2.1.1 人臉?lè)蔷€(xiàn)性流形結(jié)構(gòu)的劃分策略

首先,按照人臉圖像俯仰角度的不同,將姿態(tài)變化人臉流形劃分為不同的流形層,流形層的層數(shù)可根據(jù)需要人為設(shè)定,例如最簡(jiǎn)單的可分為3個(gè)流形層,即仰視流形層(俯仰角度在[5°,30°]間)、平視流形層(俯仰角度在[5°,5°]間)、俯視流形層(俯仰角度在[-30°,5°]間).

然后,在每個(gè)流形層內(nèi),按照人臉左右視角變化的不同,將該流形層劃分為不同的局部子空間.圖2所示為某一流形層內(nèi),根據(jù)人臉左右視角不同劃分出局部子空間的示意圖.

圖2 某流形層劃分為局部線(xiàn)性子空間的示意圖Fig.2 Schematic diagram of manifold layer divided into local linear subspace

2.1.2 人臉底層特征構(gòu)建

在每個(gè)局部子空間內(nèi),將不同的人臉圖像通過(guò)加權(quán)平均的方式形成人臉底層特征,這樣一張?zhí)卣鲌D像能夠反映不同姿態(tài)的人臉變化情況.人臉底層特征不具有明顯的周期性,它表示的是不同俯仰角度和不同搖擺角度的人臉姿態(tài)變化.具體定義如下:

對(duì)于給定的姿態(tài)變化灰度人臉圖像Ij(x,y),人臉底層特征的定義如(1)所示:

(1)

在相鄰的兩局部子空間之間,可采用分布于兩子空間邊界處的姿態(tài)變化人臉圖像通過(guò)加權(quán)平均的方式形成新的人臉底層特征圖,其計(jì)算公式與式(1)相似.通過(guò)構(gòu)建局部子空間內(nèi)部和子空間之間的加權(quán)平均人臉圖像,形成較多的人臉底層特征圖像,這部分新產(chǎn)生的特征圖和原始人臉共同作為訓(xùn)練樣本,用于深度卷積神經(jīng)網(wǎng)絡(luò)的訓(xùn)練學(xué)習(xí).

2.2 人臉底層特征的優(yōu)點(diǎn)

人臉底層特征融合了多幅人臉圖像的綜合信息,蘊(yùn)含了姿態(tài)變化情況下人臉輪廓信息和紋理信息,不僅能夠很好的節(jié)省存儲(chǔ)空間,降低計(jì)算的復(fù)雜度,而且能夠弱化單幀圖像中出現(xiàn)的噪聲干擾和人臉空間分布中的孤立點(diǎn)現(xiàn)象.

設(shè)Ii(x,y)為一幅含有噪聲的人臉圖像,它是由人臉信息圖像fi(x,y)和噪聲圖像γi(x,y)疊加而成,即Ii(x,y)=fi(x,y)+γi(x,y).假設(shè)坐標(biāo)(x,y)處,不同圖像幀中噪聲γi(x,y)是互不相關(guān)的,但具有相同的概率分布.

其中,p是一幅圖像出現(xiàn)噪聲的概率.結(jié)合噪聲的均值和方差,本文給出了人臉底層特征像抑制圖像中加性噪聲影響的結(jié)論,即下面的定理:

3 卷積神經(jīng)網(wǎng)絡(luò)簡(jiǎn)介

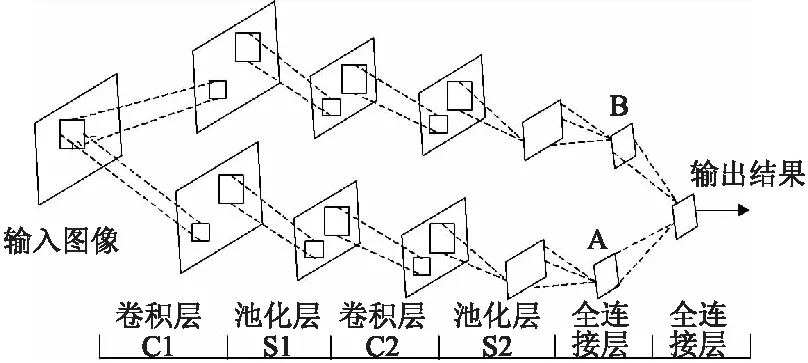

卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)如圖3所示,其中包含三層結(jié)構(gòu):卷積層、池化層和全連接層.而深度卷積神經(jīng)網(wǎng)絡(luò)是指由多個(gè)卷積層、池化層和全連接層共同構(gòu)成的復(fù)雜多層神經(jīng)網(wǎng)絡(luò).

卷積層運(yùn)算如下:

(2)

池化層,主要通過(guò)針對(duì)不同位置的特征進(jìn)行聚合統(tǒng)計(jì),可以有效降低特征圖的維度,能夠降低神經(jīng)網(wǎng)絡(luò)過(guò)擬合現(xiàn)象出現(xiàn)的概率,改善網(wǎng)絡(luò)訓(xùn)練效果.通過(guò)池化操作降低了特征圖的分辨率,同時(shí)降低了網(wǎng)絡(luò)輸出對(duì)于位移和變形的敏感程度.池化層運(yùn)算公式如下:

(3)

其中,f(°)表示激活函數(shù),S(°)表示降采樣函數(shù),采樣運(yùn)算實(shí)現(xiàn)了輸入圖中每個(gè)不同的n×n區(qū)域均值運(yùn)算或取最值運(yùn)算,使得輸出圖比輸入圖在不同維度都減小n倍.δ為每個(gè)輸出圖的乘子偏差,b為附加偏差.

圖3 卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)圖Fig.3 Structure of convolutional neural network

全連接層,主要實(shí)現(xiàn)從特征到類(lèi)別輸出的轉(zhuǎn)換,運(yùn)算公式如下:

(4)

其中,ω為全連接層的權(quán)重取值,bi為全連接層第i個(gè)神經(jīng)元的偏置項(xiàng),yi表示第i個(gè)神經(jīng)元的輸出值,N最后一個(gè)池化層包含特征圖的個(gè)數(shù),M表示每個(gè)特征圖上包含M個(gè)神經(jīng)元,f(°)表示激活函數(shù),m表示類(lèi)別數(shù),Q表示輸出層激活函數(shù)的作用值,Q與y均為m維向量.

4 自學(xué)習(xí)卷積神經(jīng)網(wǎng)絡(luò)

傳統(tǒng)卷積神經(jīng)網(wǎng)絡(luò)模型的定義往往需要較多的人工干預(yù),忽略了數(shù)據(jù)樣本對(duì)網(wǎng)絡(luò)模型的需求和影響.盡管卷積神經(jīng)網(wǎng)絡(luò)性能會(huì)隨網(wǎng)絡(luò)中神經(jīng)元數(shù)目的增加而提高,但卷積運(yùn)算復(fù)雜,增大網(wǎng)絡(luò)規(guī)模,需耗費(fèi)大量訓(xùn)練時(shí)間,且網(wǎng)絡(luò)規(guī)模增加后所提升的性能相對(duì)于所增加的計(jì)算開(kāi)銷(xiāo)而言不成比例,識(shí)別精度有時(shí)略微提升,有時(shí)反而下降.因此,本文根據(jù)姿態(tài)變化人臉的特點(diǎn),設(shè)計(jì)了一種對(duì)網(wǎng)絡(luò)深度和特征圖個(gè)數(shù)具有自學(xué)習(xí)能力的網(wǎng)絡(luò)模型構(gòu)建方法,優(yōu)化了網(wǎng)絡(luò)的層次結(jié)構(gòu)和性能.

4.1 自學(xué)習(xí)深度卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)初始化

已有研究表明[21],當(dāng)深度卷積神經(jīng)網(wǎng)絡(luò)的層級(jí)超過(guò)7層后,網(wǎng)絡(luò)的訓(xùn)練難度明顯增加,誤差反傳過(guò)程中的梯度為零,使網(wǎng)絡(luò)訓(xùn)練陷入中斷狀態(tài),無(wú)法實(shí)現(xiàn)參數(shù)學(xué)習(xí)和更新.因此,本文在網(wǎng)絡(luò)結(jié)構(gòu)初始化時(shí),將網(wǎng)絡(luò)深度設(shè)置為5層,且每層僅包含一幅特征圖.如圖4所示.

圖4 初始網(wǎng)絡(luò)結(jié)構(gòu)Fig.4 Initial network structure

初始網(wǎng)絡(luò)僅包含一條支路,其中含兩個(gè)卷積層(C1、C2)、兩個(gè)池化層(S1、S2)和一個(gè)全連接層,每層僅含一幅特征圖,結(jié)構(gòu)簡(jiǎn)單,參數(shù)較少,減少了訓(xùn)練時(shí)間.訓(xùn)練過(guò)程中,采用BP算法更新權(quán)值,并通過(guò)收斂速度的大小判斷當(dāng)前訓(xùn)練的網(wǎng)絡(luò)是否達(dá)到最優(yōu),網(wǎng)絡(luò)收斂速度定義如下:

errhope-errreal≥T

(5)

其中,errhope表示初始系統(tǒng)的期望平均誤差,errreal表示當(dāng)前系統(tǒng)的真實(shí)平均誤差,T為收斂速度的期望閾值,設(shè)定為0.1.

當(dāng)前系統(tǒng)平均誤差err計(jì)算公式為:

(6)

若式(5)成立,表明初始網(wǎng)絡(luò)具有訓(xùn)練至系統(tǒng)平均誤差達(dá)到期望平均誤差值的能力,則不需要添加新支路;若式(5)不成立,則初始網(wǎng)絡(luò)結(jié)構(gòu)不能達(dá)到收斂,需要對(duì)當(dāng)前網(wǎng)絡(luò)結(jié)構(gòu)展開(kāi)全局?jǐn)U展學(xué)習(xí).

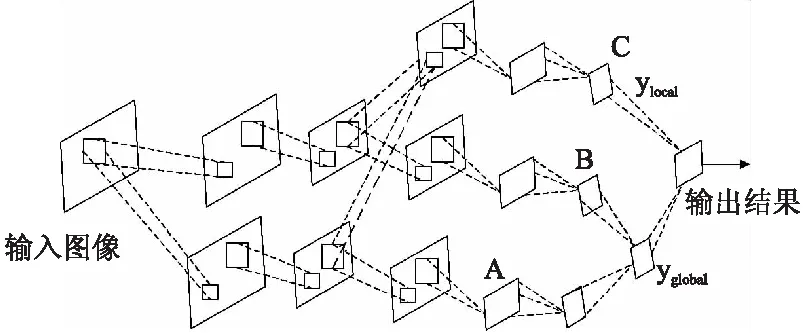

4.2 深度卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)的全局?jǐn)U展學(xué)習(xí)

深度卷積神經(jīng)網(wǎng)絡(luò)的全局?jǐn)U展是在網(wǎng)絡(luò)初始結(jié)構(gòu)基礎(chǔ)上擴(kuò)展出一條新支路,如圖5所示.擴(kuò)展新支路前,先保留初始網(wǎng)絡(luò)卷積層和池化層的相關(guān)參數(shù)及輸出結(jié)果oA.添加新支路B具有與初始支路A相似的結(jié)構(gòu),支路B輸出oB.最后的輸出層為新添加的全連接層,融合了支路A和B的輸出結(jié)果.此時(shí)網(wǎng)絡(luò)深度擴(kuò)展為6層,含兩個(gè)卷積層、兩個(gè)池化層和兩個(gè)全連接層.最終輸出結(jié)果為:

圖5 全局?jǐn)U展網(wǎng)絡(luò)Fig.5 Global expanded network

o=f(oA+ωBoB)

(7)

其中,oA和oB是m×1的二值向量,ωB是m維的列向量,表示了B支路輸出的權(quán)重值,而A支路輸出的權(quán)重值則設(shè)置為1.

訓(xùn)練過(guò)程中初始網(wǎng)絡(luò)結(jié)構(gòu)和相關(guān)參數(shù)固定不變,通過(guò)BP算法只更新增B支路權(quán)值,直到網(wǎng)絡(luò)系統(tǒng)平均誤差達(dá)到期望值,完成網(wǎng)絡(luò)全局?jǐn)U展學(xué)習(xí).

4.3 深度卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)的局部擴(kuò)展學(xué)習(xí)

全局?jǐn)U展后,網(wǎng)絡(luò)系統(tǒng)平均誤差低于期望值,但網(wǎng)絡(luò)識(shí)別性能可能并未達(dá)到最優(yōu).因此,本文采用交叉驗(yàn)證樣本對(duì)網(wǎng)絡(luò)性能進(jìn)行評(píng)估,即通過(guò)交叉驗(yàn)證樣本的識(shí)別率進(jìn)行判斷.當(dāng)不同批次交叉驗(yàn)證樣本的識(shí)別率趨于某一個(gè)穩(wěn)定值,且此穩(wěn)定值為非理想狀態(tài),此時(shí)需對(duì)已有全局支路進(jìn)行融合,構(gòu)建形成新的局部支路,實(shí)現(xiàn)網(wǎng)絡(luò)結(jié)構(gòu)的局部擴(kuò)展學(xué)習(xí),圖6展示了局部擴(kuò)展后的網(wǎng)絡(luò)結(jié)構(gòu).

本文采用的局部擴(kuò)展是對(duì)經(jīng)過(guò)一次卷積和池化之后的特征圖執(zhí)行的卷積和融合運(yùn)算.在執(zhí)行局部擴(kuò)展前,首先需要保存全局?jǐn)U展模型的相關(guān)權(quán)重參數(shù)以及網(wǎng)絡(luò)輸出值.

圖6 全局和局部擴(kuò)展后的網(wǎng)絡(luò)結(jié)構(gòu)圖Fig.6 Network structure of global and local expansion

在訓(xùn)練局部支路時(shí),將全局?jǐn)U展模型中池化層S1的特征圖作為輸入,進(jìn)行特征融合,公式如下:

C1Local=f(S1A*kA+S1B*kB)

(8)

其中,C1Local表示局部支路C1層的特征圖,S1A、S1B分別為全局支路A、B在S1層的特征圖,kA、kB為卷積核,融合方法采用簡(jiǎn)單的求和運(yùn)算.

將全局輸出yGlobal值疊加到局部支路的輸出層上,通過(guò)激勵(lì)函數(shù)f(°)輸出:

o=f(yGlobal+ωLocalyLocal)

(9)

經(jīng)過(guò)局部擴(kuò)展學(xué)習(xí)后,網(wǎng)絡(luò)中又添加一個(gè)新的全連接層,此時(shí)網(wǎng)絡(luò)深度已擴(kuò)展為7層,含兩個(gè)卷積層、兩個(gè)池化層和三個(gè)全連接層.

訓(xùn)練過(guò)程,全局支路網(wǎng)絡(luò)結(jié)構(gòu)固定,在BP算法中只更新局部支路權(quán)值,直到交叉驗(yàn)證樣本的識(shí)別率達(dá)到期望值后停止學(xué)習(xí),此時(shí)網(wǎng)絡(luò)結(jié)構(gòu)具有最高的精確度.

顯然,通過(guò)網(wǎng)絡(luò)收斂速度的大小控制網(wǎng)絡(luò)結(jié)構(gòu)全局?jǐn)U展學(xué)習(xí),采用交叉驗(yàn)證樣本識(shí)別率判斷是否需要執(zhí)行局部擴(kuò)展學(xué)習(xí),深度卷積神經(jīng)網(wǎng)絡(luò)深度和每個(gè)卷積層的特征圖個(gè)數(shù)實(shí)現(xiàn)了自適應(yīng)的學(xué)習(xí),而且網(wǎng)絡(luò)訓(xùn)練也由原來(lái)的整個(gè)網(wǎng)絡(luò)參數(shù)同時(shí)訓(xùn)練轉(zhuǎn)化為分批次的參數(shù)訓(xùn)練,一定程度上降低了訓(xùn)練難度和復(fù)雜度.本文的網(wǎng)絡(luò)構(gòu)建方法克服了傳統(tǒng)卷積神經(jīng)網(wǎng)絡(luò)構(gòu)建過(guò)度依賴(lài)經(jīng)驗(yàn)知識(shí)的弊端,避免了盲目通過(guò)增加訓(xùn)練次數(shù)改善識(shí)別率的弊端,減少無(wú)效訓(xùn)練,提升了識(shí)別準(zhǔn)確度.

5 實(shí)驗(yàn)分析

5.1 人臉庫(kù)及實(shí)驗(yàn)條件介紹

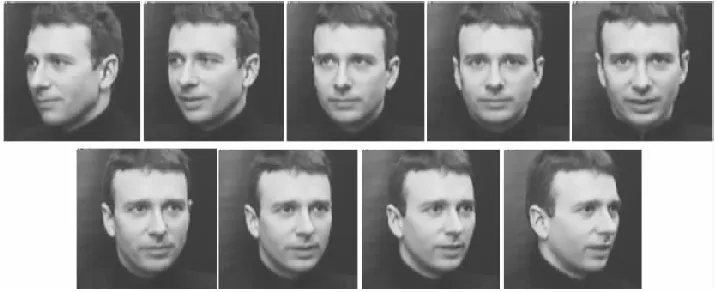

本文使用了卡耐基梅隆大學(xué)CMU-PIE人臉數(shù)據(jù)庫(kù)*http://vasc.ri.cmu.edu/idb/html/face/ 2016, October和麻省理工學(xué)院生物和計(jì)算學(xué)習(xí)中心人臉庫(kù)MIT-CBCL*http://cbcl.mit.edu/softwaredatasets/heisele/facerecognition-database.html 2016, October.實(shí)驗(yàn)中從CMU-PIE人臉庫(kù)隨機(jī)選取每人姿態(tài)變化明顯的人臉50幅,共3400幅圖像(包含姿態(tài),光照變化)構(gòu)建人臉底層特征和訓(xùn)練自學(xué)習(xí)深度卷積神經(jīng)網(wǎng)絡(luò),人臉尺寸歸一化為28×28.隨機(jī)選取每人20幅人臉,共1360幅作為交叉驗(yàn)證樣本.隨機(jī)選取每人20幅人臉,共1360幅作為測(cè)試樣本.圖7所示為人臉庫(kù)中某人姿態(tài)變化時(shí)的人臉.

圖7 CMU-PIE人臉庫(kù)中的人臉圖像Fig.7 Face images in the face database CMU-PIE

MIT-CBCL人臉庫(kù)共10人,每人200幅圖像,包括大范圍連續(xù)的姿態(tài)變化、微弱的光照和表情變化,人臉尺寸歸一化為28×28.圖8給出了該人臉庫(kù)中部分人臉圖像.實(shí)驗(yàn)中,每人選取80幅人臉,共800幅圖像用于構(gòu)建人臉底層特征圖和訓(xùn)練卷積神經(jīng)網(wǎng)絡(luò),其余1200幅人臉中,選取400幅作為交叉驗(yàn)證樣本,800幅作為測(cè)試樣本.

圖8 MIT-CBCL人臉庫(kù)中的人臉圖像Fig.8 Face images in the face database MIT-CBCL

通過(guò)實(shí)驗(yàn)數(shù)據(jù)分析,CMU-PIE人臉庫(kù)中的人臉圖像存在明顯的俯仰角變化和左右視角變化.根據(jù)俯仰角的變化范圍,訓(xùn)練人臉圖像可劃分為3個(gè)流形層(俯視、平視、仰視),根據(jù)視角變化情況每個(gè)流形層又可劃分5個(gè)局部子空間.所以每類(lèi)人可構(gòu)建出27幅人臉底層特征圖像,則每人最終用于網(wǎng)絡(luò)訓(xùn)練的樣本共77幅.

MIT-CBCL人臉庫(kù)中的人臉圖像無(wú)俯仰角變化,只存在明顯的左右視角變化,所以該人臉庫(kù)只包含1個(gè)流形層,而每個(gè)流形層中的左右視角變化連續(xù)性較好,可劃分多個(gè)不同的局部子空間.本文將其劃分為7個(gè)局部子空間:子空間1視角變化范圍為[-90o,-70o);子空間2視角范圍為[-70o,-50o);子空間3視角范圍為[-50o,-30o);子空間4視角范圍為[-30o,-5o);子空間5視角范圍為[-5o,5o];子空間6視角范圍為(5o,30o];子空間7視角范圍為(30o,50o];子空間8視角范圍為(50o,70o];子空間9視角范圍為(70o,90o].顯然,9個(gè)局部子空間可產(chǎn)生17幅人臉底層特征圖像,每人用于網(wǎng)絡(luò)訓(xùn)練的人臉圖像變?yōu)?7幅.

5.2 結(jié)合深度特征提取的姿態(tài)變化人臉識(shí)別

傳統(tǒng)卷積神經(jīng)網(wǎng)絡(luò)中通常采用2個(gè)卷積層、2個(gè)池化層和1個(gè)全連接層的5層結(jié)構(gòu).網(wǎng)絡(luò)結(jié)構(gòu)通常采用卷積層和池化層的特征圖個(gè)數(shù)進(jìn)行表示,例如傳統(tǒng)卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)表示為:2-2-6-6,則說(shuō)明網(wǎng)絡(luò)中卷積層C1和池化層S1包含2幅特征圖,卷積層C2和池化層S2包含6幅特征圖.本文基于不同結(jié)構(gòu)的卷積神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)姿態(tài)變化人臉識(shí)別實(shí)驗(yàn).實(shí)驗(yàn)中學(xué)習(xí)率設(shè)為固定值0.3,池化運(yùn)算采用平均池化,卷積核的大小可設(shè)為5×5或3×3,實(shí)驗(yàn)中對(duì)不同卷積核組合進(jìn)行了對(duì)比,結(jié)果如圖9所示.

上述實(shí)驗(yàn)表明,基于不同人臉庫(kù)和不同結(jié)構(gòu)卷積神經(jīng)網(wǎng)絡(luò)實(shí)驗(yàn)結(jié)果具有明顯差異.網(wǎng)絡(luò)中卷積層和池化層的特征圖個(gè)數(shù)對(duì)識(shí)別效果產(chǎn)生了嚴(yán)重影響.另外,針對(duì)不同的人臉數(shù)據(jù),達(dá)到最優(yōu)識(shí)別效果時(shí)的網(wǎng)絡(luò)結(jié)構(gòu)和卷積核等參數(shù)配置是完全不同的.因此,僅基于經(jīng)驗(yàn)或先驗(yàn)知識(shí)而構(gòu)建的網(wǎng)絡(luò)結(jié)構(gòu)不能充分反映樣本數(shù)據(jù)的本質(zhì)特點(diǎn).而針對(duì)某一樣本集合,通過(guò)大量的實(shí)驗(yàn)確定最優(yōu)的網(wǎng)絡(luò)結(jié)構(gòu)則通常需要消耗較多的時(shí)間和資源,且網(wǎng)絡(luò)結(jié)構(gòu)不具備普適性.因此,基于樣本數(shù)據(jù)本身具有的特點(diǎn)研究一種能夠自適應(yīng)的調(diào)整網(wǎng)絡(luò)結(jié)構(gòu),實(shí)現(xiàn)網(wǎng)絡(luò)特征圖個(gè)數(shù)自主學(xué)習(xí)和調(diào)節(jié)的深層卷積神經(jīng)網(wǎng)絡(luò),對(duì)于完善深度網(wǎng)絡(luò)構(gòu)建理論具有重要意義.

圖9 結(jié)合深度特征提取的姿態(tài)變化人臉識(shí)別Fig.9 Pose-varied face recognition results based on deep feature extraction

另外,分別采用原始姿態(tài)變化人臉圖像和引入人臉底層特征圖擴(kuò)充樣本后的識(shí)別效果進(jìn)一步證明了樣本擴(kuò)增對(duì)于網(wǎng)絡(luò)識(shí)別性能的提升,也說(shuō)明構(gòu)建得到的人臉底層特征圖蘊(yùn)含了姿態(tài)變化人臉的部分非線(xiàn)性信息,對(duì)于具有視角變化的姿態(tài)變化人臉識(shí)別是關(guān)鍵的.

在華人社區(qū),李老頭結(jié)識(shí)了同樣喜歡中醫(yī)的朋友,與他們一起分享中醫(yī)文化與養(yǎng)生之道,也吸引了不少外國(guó)友人。談起健康養(yǎng)生之道,李先生說(shuō):“養(yǎng)生貴在按時(shí),按時(shí)飲食,按時(shí)運(yùn)動(dòng)和睡眠,按時(shí)進(jìn)行各種身心活動(dòng),生活要有規(guī)律。”

5.3 基于自學(xué)習(xí)卷積神經(jīng)網(wǎng)絡(luò)的姿態(tài)變化人臉識(shí)別

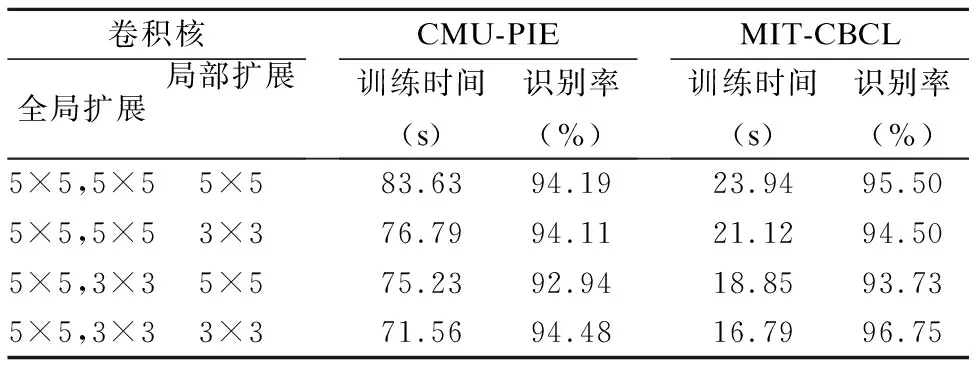

本文基于兩個(gè)不同人臉庫(kù),分別進(jìn)行了基于自學(xué)習(xí)深度卷積神經(jīng)網(wǎng)絡(luò)模型構(gòu)建和識(shí)別實(shí)驗(yàn).網(wǎng)絡(luò)的初始結(jié)構(gòu)設(shè)置為1-1-1-1結(jié)構(gòu),如圖4所示.通過(guò)卷積核大小的調(diào)整和網(wǎng)絡(luò)結(jié)構(gòu)的自適應(yīng)學(xué)習(xí),可以獲得最佳網(wǎng)絡(luò).由于輸入圖像的像素歸一化為28×28,所以深度卷積神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)全局?jǐn)U展學(xué)習(xí)中卷積層1的卷積核僅能設(shè)置為5×5,卷積層2的卷積核可設(shè)置為5×5或3×3,網(wǎng)絡(luò)結(jié)構(gòu)局部擴(kuò)展卷積層的卷積核可選5×5或3×3.不同卷積核組合情況下的實(shí)驗(yàn)結(jié)果如表1和表2.

表1 深度卷積神經(jīng)網(wǎng)絡(luò)全局?jǐn)U展中不同卷積核組合的實(shí)驗(yàn)Table 1 Experimental results of different convolution kernel combinations in the global expansion of deep CNN

表1數(shù)據(jù)表明,在全局?jǐn)U展中不同大小的卷積核對(duì)識(shí)別率產(chǎn)生了不同影響.卷積核大小影響到網(wǎng)絡(luò)結(jié)構(gòu)中的連接權(quán)重個(gè)數(shù),所以卷積核5-3(卷積層1卷積核為5×5,卷積層2卷積核為3×3)組合的訓(xùn)練時(shí)間比5-5組合的訓(xùn)練時(shí)間明顯降低.而不同數(shù)量連接權(quán)重作用下,網(wǎng)絡(luò)識(shí)別性能也受到一定影響.卷積核5-3組合的權(quán)重個(gè)數(shù)較少,但識(shí)別性能卻優(yōu)于5-5組合,因此并不是權(quán)重?cái)?shù)量越多越好,同時(shí)也說(shuō)明每層的特征圖個(gè)數(shù)也不是越多越好.在合理調(diào)整卷積核大小時(shí),根據(jù)數(shù)據(jù)樣本的自身情況,按需添加神經(jīng)元,實(shí)現(xiàn)網(wǎng)絡(luò)結(jié)構(gòu)的自適應(yīng)擴(kuò)展有利于提高運(yùn)算效率,改善網(wǎng)絡(luò)識(shí)別性能.

表2 全局與局部擴(kuò)展結(jié)合時(shí)不同卷積核組合的實(shí)驗(yàn)結(jié)果Table 2 Experimental results of different convolution kernel combinations in global and local expansion

表2的實(shí)驗(yàn)結(jié)果表明,全局?jǐn)U展卷積核5-3組合,局部擴(kuò)展采用卷積核3×3時(shí),網(wǎng)絡(luò)的誤分類(lèi)率最低,本文實(shí)驗(yàn)中選此組合作為深度卷積神經(jīng)網(wǎng)絡(luò)構(gòu)建過(guò)程中的卷積核.而利用兩個(gè)人臉數(shù)據(jù)庫(kù)上的樣本,通過(guò)自學(xué)習(xí)訓(xùn)練得到的最優(yōu)網(wǎng)絡(luò)結(jié)構(gòu)均為1-1-3-3結(jié)構(gòu).

由于學(xué)習(xí)率影響著每次循環(huán)訓(xùn)練中所產(chǎn)生的權(quán)值變化量,較大學(xué)習(xí)速率可以加快訓(xùn)練速度,但易導(dǎo)致系統(tǒng)不穩(wěn)定,而較小學(xué)習(xí)速率則導(dǎo)致訓(xùn)練時(shí)間較長(zhǎng),網(wǎng)絡(luò)收斂速度變慢,但是能保證網(wǎng)絡(luò)誤差最終趨于最小誤差值.因此,網(wǎng)絡(luò)設(shè)計(jì)中傾向于選取較小的學(xué)習(xí)速率以保證系統(tǒng)的穩(wěn)定性.本文通過(guò)實(shí)驗(yàn)確定了最優(yōu)學(xué)習(xí)率取值為0.6.

基于自學(xué)習(xí)的深度卷積神經(jīng)網(wǎng)絡(luò)構(gòu)建過(guò)程簡(jiǎn)單,無(wú)需人工干預(yù)和多次重復(fù)實(shí)驗(yàn),網(wǎng)絡(luò)結(jié)構(gòu)與數(shù)據(jù)密切相關(guān).從識(shí)別性能看,傳統(tǒng)卷積網(wǎng)絡(luò)在CMU-PIE人臉庫(kù)和MIT-CBCL人臉庫(kù)中獲得的最優(yōu)識(shí)別率分別為93.38%和96.875%.自學(xué)習(xí)深度卷積網(wǎng)絡(luò)中,通過(guò)網(wǎng)絡(luò)結(jié)構(gòu)全局?jǐn)U展在CMU-PIE人臉庫(kù)和MIT-CBCL人臉庫(kù)中獲得的最優(yōu)識(shí)別率分別為93.16%和95.25%.而經(jīng)過(guò)局部擴(kuò)展后獲得的最優(yōu)識(shí)別率為94.48%和96.75%.從網(wǎng)絡(luò)構(gòu)建時(shí)間看,傳統(tǒng)卷積網(wǎng)絡(luò)獲取最優(yōu)的網(wǎng)絡(luò)結(jié)構(gòu)需通過(guò)大量重復(fù)實(shí)驗(yàn)確定,耗費(fèi)較多的時(shí)間.而本文提出的網(wǎng)絡(luò)構(gòu)建思想盡管識(shí)別率沒(méi)有達(dá)到傳統(tǒng)卷積網(wǎng)絡(luò)的最優(yōu)值,但是訓(xùn)練時(shí)間大大降低.綜合考慮識(shí)別率和訓(xùn)練效率,本文提出的網(wǎng)絡(luò)結(jié)構(gòu)自學(xué)習(xí)策略是有效可行的.

5.4 與其他方法的對(duì)比實(shí)驗(yàn)

為說(shuō)明人臉底層特征和自學(xué)習(xí)卷積神經(jīng)網(wǎng)絡(luò)模型構(gòu)建在姿態(tài)變化人臉識(shí)別中的有效性,本文分別與其他幾種典型姿態(tài)變化人臉識(shí)別方法進(jìn)行了實(shí)驗(yàn)對(duì)比,其中主要包括基于姿態(tài)校正的方法、基于流形學(xué)習(xí)的方法和基于Gabor變換的方法,分類(lèi)過(guò)程都采用最近鄰分類(lèi)器,實(shí)驗(yàn)結(jié)果如表3所示.

表3 與其他方法的識(shí)別效果對(duì)比Table 3 Comparison of recognition effect on our method with other methods

針對(duì)訓(xùn)練樣本和測(cè)試樣本進(jìn)行Gabor小波變換的姿態(tài)變化人臉識(shí)別中,選取了5個(gè)尺度,8個(gè)方向的Gabor濾波器人臉圖像進(jìn)行卷積運(yùn)算,然后采用卷積圖像的幅值響應(yīng)作為特征進(jìn)行分類(lèi)識(shí)別.實(shí)驗(yàn)中分別采用了訓(xùn)練樣本中的正面人臉(或近似正面的人臉)和具有明顯姿態(tài)變化的人臉作為標(biāo)準(zhǔn)樣本用于識(shí)別.采用正面人臉作為標(biāo)準(zhǔn)人臉的情況下,兩個(gè)人臉庫(kù)中的識(shí)別效果表現(xiàn)優(yōu)秀,CMU-PIE庫(kù)中的識(shí)別率達(dá)到90.22%,MIT-CBCL人臉庫(kù)中的識(shí)別率為91.75%;在采用具有明顯姿態(tài)變化的人臉圖像作為標(biāo)準(zhǔn)樣本時(shí),CMU-PIE測(cè)試人臉庫(kù)中得到的平均識(shí)別率為88.09%,MIT-CBCL測(cè)試人臉庫(kù)中得到的平均識(shí)別率為87.25%.實(shí)驗(yàn)數(shù)據(jù)表明,Gabor變換在一定程度上能夠克服光照和姿態(tài)對(duì)人臉識(shí)別的影響,但是當(dāng)人臉出現(xiàn)大角度姿態(tài)變化時(shí),Gabor函數(shù)無(wú)法準(zhǔn)確提取面部紋理特征,識(shí)別效果變差.另外由于Gabor變換分別增加了標(biāo)準(zhǔn)人臉和測(cè)試人臉的特征維數(shù),極大的增加了數(shù)據(jù)量,使識(shí)別速度慢,實(shí)時(shí)性較差.

基于流形學(xué)習(xí)的方法,本文采用了局部保持鑒別投影算法(LPDP)對(duì)姿態(tài)變化原始人臉訓(xùn)練圖像直接進(jìn)行特征提取獲取變換矩陣,該方法在CMU-PIE人臉庫(kù)上達(dá)到的最優(yōu)識(shí)別率為86.17%,在MIT-CBCL人臉庫(kù)上的識(shí)別率為87.375%.綜合考慮識(shí)別率和識(shí)別時(shí)間,該方法是較優(yōu)秀的,這表明流形學(xué)習(xí)方法在提取姿態(tài)變化人臉的非線(xiàn)性特征中具有一定的優(yōu)勢(shì).

總之,采用深度學(xué)習(xí)算法比傳統(tǒng)姿態(tài)變化人臉識(shí)別方法的總體識(shí)別率要高,且通過(guò)構(gòu)建人臉底層特征圖實(shí)現(xiàn)姿態(tài)變化人臉樣本擴(kuò)充后,訓(xùn)練得到的網(wǎng)絡(luò)識(shí)別效果具有明顯提高.而自學(xué)習(xí)深度卷積神經(jīng)網(wǎng)絡(luò)的構(gòu)建則更好地改善了最優(yōu)網(wǎng)絡(luò)構(gòu)建的重復(fù)訓(xùn)練思想,提高了運(yùn)算效率.

6 結(jié)束語(yǔ)

本文提出基于自學(xué)習(xí)深度卷積神經(jīng)網(wǎng)絡(luò)的姿態(tài)變化人臉識(shí)別方法.首先基于姿態(tài)變化人臉的空間分布信息將姿態(tài)人臉劃分為不同流形層和子空間,通過(guò)構(gòu)建人臉底層特征實(shí)現(xiàn)姿態(tài)變化人臉的樣本擴(kuò)充,克服了原始人臉較少時(shí)訓(xùn)練樣本較少,特征提取不充分等缺點(diǎn).然后針對(duì)傳統(tǒng)卷積神經(jīng)網(wǎng)絡(luò)構(gòu)建過(guò)分依賴(lài)經(jīng)驗(yàn),提出自學(xué)習(xí)深度卷積神經(jīng)網(wǎng)絡(luò)構(gòu)建策略,并將該方法成功應(yīng)用于樣本擴(kuò)充后的姿態(tài)變化人臉識(shí)別.本文所提方法降低了網(wǎng)絡(luò)訓(xùn)練難度,避免了無(wú)效訓(xùn)練,且能有效提取姿態(tài)變化人臉中的非線(xiàn)性信息.

:

[1] Huang Kai-qi,Chen Xiao-tang,Kang Yun-feng,et al.Intelligent visual surveillance:a review[J].Chinese Journal of Computer,2015,38(6):1093-1115.

[2] Zou Guo-feng,F(xiàn)u Gui-xia,Li Hai-tao,et al.A survey of multi-pose face recognition [J].PR&AI,2015,28(7):613-625.

[3] Du Cheng,Su Guang-da,Lin Xing-gang,et al.Synthesis of face image with pose variations[J].Journal of Optoelectronics·Laser,2004,15(12):1498-1451.

[4] Lin Z X,Yang W J,Ho C C,et al.Fast vertical-pose-invariant face recognition module for intelligent robot guard[C].The 4th International Conference on Autonomous Robots and Agents,2009:613-617.

[5] Wang Ke-jun,Zou Guo-feng,F(xiàn)u Gui-xia,et al.An approach to fast eye location and face plane rotation correction[J].Journal of Computer-Aided Design & Computer Graphics,2013,25(6):865-872.

[6] Chai Xiu-juan,Shan Shi-guang,Chen Xi-lin,et al.Local linear regression for pose invariant face recognition[J].IEEE Trans on Image Process,2007,16(7):1716-1725.

[7] Chen Hua-jie,Wei Wei.Multi pose face recognition based on correlative sub region mapping [J].Journal of Image and Graphics,2007,12(7):1254-1260.

[8] Maria De Marsico,Michele Nappi,Daniel Riccio,et al.Robust face recognition for uncontrolled pose and illumination changes[J].IEEE Transactions on Systems,Man,and Cybernetics:Systems,2013,43(1):149-163.

[9] Yin Bao-cai,Zhang Zhuang,Sun Yan-feng,et al.Pose variant face recognition based on 3D morphable model[J].Journal of Beijing University of Technology,2007,33(3):320-325.

[10] Ye Chang-ming,Jiang Jian-guo,Zhan Shu,et al.3D facial depth map recognition in different poses with surface contour feature[J].PR & AI,2013,26(2):219-224.

[11] Zhang Yan-ning,Guo Zhe,Xia Yong,et al.2D representation of facial surfaces for multi-pose 3D face recognition[J].Pattern Recognition Letters,2012,33(5):530-536.

[12] Abhishek Sharma,Murad Al Haj,Jonghyun Choi,et al.Robust pose invariant face recognition using coupled latent space discriminant analysis[J].Computer Vision and Image Understanding,2012,116(11):1095-1110.

[13] Zhang Hai-chao,Nasser M Nasrabadi,Zhang Yan-ning,et al.Joint dynamic sparse representation for multi-view face recognition[J].Pattern Recognition,2012,45(4):1290-1298.

[14] Lian Shu-fen,Liu Yin-hua,Li Li-chen.Face recognition under unconstrained based on LBP and deep learning[J].Journal on Communications,2014,35(6):154-160.

[15] Chen Yong,Huang Ting-ting,Liu Hua-lin,et al.Multi-pose face ensemble classification aided by Gabor features and deep belief nets[J].Optik,2016,127(2):946-954.

[16] Chu Xiao,Leng Ze,Wang Yan-ling,et al.Face recogniton with pose variation based on fusion of multi-scale MRF and SCT [J].Application Research of Computers,2016,33(8):2519-2523.

[17] Qin Hong-wei,Yan Jun-jie,Li Xiu,et al.Joint training of cascaded CNN for face detection[C].IEEE International Conference on Computer Vision and Pattern Recognition,2016:3456-3465.

[18] Liu Zi-wei,Luo Ping,Wang Xiao-gang,et al.Deep learning face attributes in the wild[C].IEEE International Conference on Computer Vision,2015:3730-3738.

[19] Iacopo Masi,Stephen Rawls,G′erard Medioni,et al.Pose-aware face recognition in the wild[C].IEEE International Conference on Computer Vision and Pattern Recognition,2016:4838-4846.

[20] Shi Xiang-bin,Yang Ke,Zhang De-yuan.Symmetric deep neural network for image classification[J].Journal of Chinese Computer Systems,2017,38(3):578-583.

[21] Li Xin-hua,Yu Qian.Face recognition based on deep neural network[J].International Journal of Signal Processing,Image Processing and Pattern Recognition:2015,8(10):29-38.

[22] Wang Ke-jun,Zou Guo-feng.A sub-pattern gabor features fusion method for sigle sample face recogniton[J].PR & AI,2013,26(1):50-56.

[23] Zhao Zhen-hua,Hao Xiao-hong.Linear locality preserving and discriminating projection for face recognition [J].Journal of Electronics & Information Technology,2013,35(2):463-467.

附中文參考文獻(xiàn):

[1] 黃凱奇,陳曉棠,康運(yùn)鋒,等.智能視頻監(jiān)控技術(shù)綜述[J].計(jì)算機(jī)學(xué)報(bào),2015,38(6):1093-1115.

[2] 鄒國(guó)鋒,傅桂霞,李海濤,等.多姿態(tài)人臉識(shí)別綜述[J].模式識(shí)別與人工智能,2015,28(7):613-625.

[3] 杜 成,蘇光大,林行剛,等.多姿態(tài)人臉圖像合成[J].光電子·激光,2004,15(12):1498-1451.

[5] 王科俊,鄒國(guó)鋒,傅桂霞,等.一種快速眼睛定位與人臉平面旋轉(zhuǎn)校正方法[J].計(jì)算機(jī)輔助設(shè)計(jì)與圖形學(xué)學(xué)報(bào),2013,25(6):865-872.

[7] 陳華杰,韋 巍.基于關(guān)聯(lián)子區(qū)域映射的多姿態(tài)人臉識(shí)別[J].中國(guó)圖象圖形學(xué)報(bào),2007,12(7):1254-1260.

[9] 尹寶才,張 壯,孫艷豐,等.基于三維形變模型的多姿態(tài)人臉識(shí)別[J].北京工業(yè)大學(xué)學(xué)報(bào),2007,33(3):320-325.

[10] 葉長(zhǎng)明,蔣建國(guó),詹 曙,等.基于曲面等高線(xiàn)特征的不同姿態(tài)三維人臉深度圖識(shí)別[J].模式識(shí)別與人工智能,2013,26(2):219-224.

[14] 連淑芬,劉銀華,李立琛.基于LBP和深度學(xué)習(xí)的非限制條件下人臉識(shí)別算法[J].通信學(xué)報(bào),2014,35(6):154-160.

[16] 初 曉,冷 澤,王艷玲,等.基于多尺度MRF結(jié)合超級(jí)耦合變換的姿態(tài)變化人臉識(shí)別[J].計(jì)算機(jī)應(yīng)用研究,2016,33(8):2519-2523.

[20] 石祥濱,陽(yáng) 柯,張德園.基于對(duì)稱(chēng)神經(jīng)網(wǎng)絡(luò)的圖像分類(lèi)[J].小型微型計(jì)算機(jī)系統(tǒng),2017,38(3):578-583.

[22] 王科俊,鄒國(guó)鋒.基于子模式的Gabor特征融合的單樣本人臉識(shí)別[J].模式識(shí)別與人工智能,2013,26(1):50-56.

[23] 趙振華,郝曉弘.局部保持鑒別投影及其在人臉識(shí)別中的應(yīng)用[J].電與信息學(xué)報(bào),2013,35(2):463-467.