結(jié)合結(jié)構(gòu)自相似性和卷積網(wǎng)絡(luò)的單幅圖像超分辨率

向 文,張 靈,陳云華,姬秋敏

(廣東工業(yè)大學(xué) 計算機(jī)學(xué)院,廣州 511400)

超分辨率(Super Resolution, SR)圖像重建是指對低質(zhì)量、低分辨率(Low-Resolution, LR)圖像進(jìn)行處理,恢復(fù)出高分辨率(High-Resolution, HR)圖像的技術(shù),在軍事、醫(yī)學(xué)、公共安全、計算機(jī)視覺等方面都存在著廣泛的應(yīng)用前景。超分圖像重建的一種方法是采用大量高分辨率圖像學(xué)習(xí),以得到圖像的高頻細(xì)節(jié)對低分辨率圖像進(jìn)行恢復(fù)[1-4]。目前算法多依賴訓(xùn)練數(shù)據(jù)庫數(shù)據(jù),沒有充分利用待重構(gòu)圖片自身的結(jié)構(gòu)特點(diǎn),造成重構(gòu)效果不佳[5-7]。Freedman等[8]指出在單幅圖像的局部空間鄰域內(nèi)存在大量結(jié)構(gòu)自相似的圖像塊,因而提出了一些利用局部結(jié)構(gòu)自相似性方法[9-10],但是這些算法不能有效處理沒有重復(fù)結(jié)構(gòu)的不規(guī)則紋理圖像塊,圖像塊間的錯誤匹配會帶來很多虛假紋理,重構(gòu)效果難以保證。鑒于目前存在的問題,本文提出了一個基于待重構(gòu)圖像的結(jié)構(gòu)相似性特征和卷積神經(jīng)網(wǎng)絡(luò)(Convolution Neural Network, CNN)相結(jié)合的超分圖像重構(gòu)方法,從單幅低分辨率圖像中獲取自身結(jié)構(gòu)在相同尺度和不同尺度下的結(jié)構(gòu)冗余信息,并結(jié)合深度學(xué)習(xí)方法進(jìn)行超分辨率重建。首先提取單幅圖像在相同及不同尺度下的重復(fù)出現(xiàn)結(jié)構(gòu)特征;然后融合高分辨率字典圖像塊輸入到CNN中進(jìn)行學(xué)習(xí),從而實現(xiàn)單幅低分辨率圖像的重構(gòu),實驗結(jié)果驗證了本文算法的有效性。

1 卷積神經(jīng)網(wǎng)絡(luò)模型

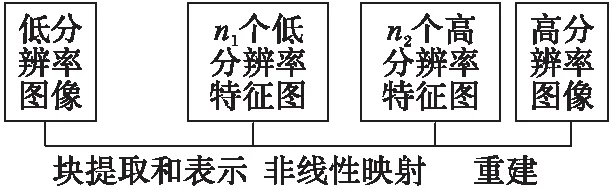

近年來,深度學(xué)習(xí)在許多計算機(jī)視覺圖像問題上取得了很大的成功,說明了神經(jīng)網(wǎng)絡(luò)模型在學(xué)習(xí)數(shù)據(jù)集本質(zhì)特征上具有強(qiáng)大的能力。有研究學(xué)者提出了基于卷積神經(jīng)網(wǎng)絡(luò)的圖像超分辨率(Super-Resolution Convolution Neural Network, SRCNN)方法[11],利用外部數(shù)據(jù)庫中成對的LR和HR圖像,通過CNN模型獲得相應(yīng)的先驗信息,來實現(xiàn)超分辨率重建。超分辨率卷積神經(jīng)網(wǎng)絡(luò)由三層卷積層構(gòu)成,分別為特征提取、非線性映射和高分辨率圖像重構(gòu),該算法框架如圖1所示。SRCNN的深度學(xué)習(xí)網(wǎng)絡(luò)中的三個卷積網(wǎng)絡(luò)公式表達(dá)如下:

Y1=max(0,W1*X+B1)

(1)

Y2=max(0,W2*Y1+B2)

(2)

Y3=max(0,W3*Y2+B3)

(3)

其中:矩陣X代表LR子圖像;Yi(i=1,2,3) 表示每個卷積層的輸出;Wi(i=1,2,3)和Bi(i=1,2,3)分別代表神經(jīng)元卷積核和神經(jīng)元偏置向量;*表示卷積運(yùn)算,卷積得到的特征圖要再經(jīng)ReLU激活函數(shù)max(0,x)進(jìn)行處理。在訓(xùn)練過程,該神經(jīng)網(wǎng)絡(luò)需要學(xué)習(xí)參數(shù)Θ={W1,W2,W3,B1,B2,B3},該參數(shù)通過最小化神經(jīng)網(wǎng)絡(luò)輸出與HR圖像之間的誤差損失進(jìn)行訓(xùn)練估計。給定高分辨率圖像Yi與其相應(yīng)的低分辨率圖像集合Xi,用其均方誤差L(Θ)作為驅(qū)動損失函數(shù):

(4)

式(4)可通過隨機(jī)梯度下降和反向傳播算法進(jìn)行訓(xùn)練求解。

圖1 SRCNN 算法框架 Fig. 1 Structure of SRCNN algorithm

2 結(jié)構(gòu)自相似性理論

2.1 圖像的多尺度自相似

在整幅圖像的各個區(qū)域之間普遍存在的相似特性統(tǒng)稱為圖像相似性。有研究[12]表明,對于自然圖像中一個5×5的圖像塊,在該圖像中能發(fā)現(xiàn)大量與其相似的相同尺度和不同尺度的圖像塊。統(tǒng)計表明,超過90%的圖像塊能找到至少9個相同尺度的相似圖像塊;超過80%的圖像塊能找到至少9個不同尺度的相似圖像塊。根據(jù)這種圖像相似性,可以在相同尺度和不同尺度上提取出圖像自身的很多冗余信息。Candocia等[13]指出一般的圖像具有如下兩個特點(diǎn):整幅圖像中存在著大量具有相似結(jié)構(gòu)的區(qū)域;并且這些結(jié)構(gòu)的相似性在多個尺度上可以保持。

在本文中采用非局部塊匹配的方法對外部數(shù)據(jù)庫在相同尺度和不同尺度上搜尋相似圖像塊,組成具有多尺度結(jié)構(gòu)自相似性的LR和HR圖像塊對,將這種LR和HR圖像塊對作為訓(xùn)練樣本字典。另外對內(nèi)部數(shù)據(jù)庫采取同樣的方法在多尺度上搜索相似高分辨率圖像塊作為內(nèi)部高分辨率字典。

圖2 在相同尺度和不同尺度相似圖像塊的SR方法 Fig. 2 SR method of similar image blocks on same scale and difierent scales

2.2 非局部自相似性約束

由于非局部圖像塊之間可以提供額外的有用信息,因此利用不同區(qū)域圖像塊之間的相似性似乎能夠獲得更高的圖像分辨率[14]。它們首先將訓(xùn)練圖像分成大小相同的圖像塊,然后經(jīng)過將高、低分辨率圖像塊進(jìn)行配對形成字典,最后在字典中尋找與低超分辨率圖像塊相似的若干圖像塊,將全部選中的圖像塊加權(quán)整合得到近似的高分辨率圖像塊,接著將全部的近似高分辨率圖像塊融合得到全部的高分辨率結(jié)果圖像。學(xué)者們經(jīng)過研究分析提出[15-16]:一方面,自然圖像在其紋理、物體邊緣等區(qū)域存在豐富的相似性,低分辨率圖像可以根據(jù)該相似性重建出丟失的高頻細(xì)節(jié);另一方面,高、低分辨率圖像之間具有近鄰保持關(guān)系。

(5)

其中:I為單位矩陣,B為權(quán)值矩陣,ψ為字典矩陣。

3 基于結(jié)構(gòu)自相似性的神經(jīng)網(wǎng)絡(luò)算法

3.1 低分辨率降質(zhì)模型

LR圖像是由HR圖像經(jīng)過模糊、降采樣以及噪聲污染得到的[17],整個降質(zhì)過程近似地表示為一個線性過程,那么圖像降質(zhì)模型可以表示為:

X=HSY+n

(6)

其中:H是下采樣操作,S是模糊算子,n是噪聲污染矩陣。SR問題就是已知給定的單幅LR圖像矩陣X,重建出相同場景中的HR圖像矩陣Y。為了準(zhǔn)確估計出HR圖像矩陣Y,需要引入圖像的一些先驗或正則約束項:

(7)

(8)

其中μ為正則化參數(shù),最后使用迭代反投影算法對圖像進(jìn)一步提升。

3.2 算法實現(xiàn)

先利用原始低分辨率圖像的非局部自相似性提供先驗知識,用多尺度的方法搜索到初始超分辨率圖像塊的最佳匹配塊,作為內(nèi)部字典,進(jìn)行非局部的方法學(xué)習(xí)得到非局部正則化約束項。深度學(xué)習(xí)普遍從大數(shù)據(jù)訓(xùn)練,使用了一個由91張圖像組成的小型訓(xùn)練集[3],將此數(shù)據(jù)庫用多尺度的方法進(jìn)行搜索得到圖片的最佳匹配塊與低分辨率圖像塊形成高低分辨率塊對,作為外部字典,輸入到卷積神經(jīng)網(wǎng)絡(luò)進(jìn)行訓(xùn)練得到卷積神經(jīng)網(wǎng)絡(luò)模型參數(shù);然后再用卷積神經(jīng)網(wǎng)絡(luò)模型參數(shù)對原始低分辨率圖像進(jìn)行重建,防止偽影加入由內(nèi)部數(shù)據(jù)庫得到的非局部正則化約束項。該算法分為4個部分:初始插值、非局部塊匹配、神經(jīng)網(wǎng)絡(luò)模型學(xué)習(xí)和非局部正則化約束。

1)初始插值:本文選取現(xiàn)有比較常用且重建視覺效果較好的三次雙線性插值算法得到初始超分辨率圖像,插值算法的選取對最終超分辨率結(jié)果產(chǎn)生一定的影響,較好的插值算法必然會得到較好的最終結(jié)果。

(9)

3)神經(jīng)網(wǎng)絡(luò)模型學(xué)習(xí):卷積神經(jīng)網(wǎng)絡(luò)模型具有很強(qiáng)的特征學(xué)習(xí)能力,在這里采用SRCNN算法中三層卷積神經(jīng)網(wǎng)絡(luò)模型對高低分辨率圖像塊進(jìn)行學(xué)習(xí)。將塊匹配得到的高低分辨率圖像塊對輸入超分辨率卷積神經(jīng)網(wǎng)絡(luò),經(jīng)過三層卷積層, 通過特征提取、非線性映射,最終得到需要的超分變辨率圖像參數(shù)模型Θ。

4)非局部正則化約束:這部分結(jié)合卷積神經(jīng)網(wǎng)絡(luò)模型,非局部正則化參數(shù)和字典等參數(shù)根據(jù)式(8)進(jìn)行計算,得到重建的超分辨率圖像。

3.3 算法優(yōu)化

使用迭代反投影算法對重建的圖片進(jìn)行提升,該方法采用下采樣子像素位移圖像降質(zhì)模型[18]采樣獲得多幀LR圖像,將其配準(zhǔn), 最后通過對模擬LR圖像和觀測LR圖像的誤差進(jìn)行迭代反投影到HR圖像。假設(shè)輸入K幅觀測LR序列圖像為fk(m1;m2),分辨率為M1×M2,估計的HR圖像f(n1;n2)擴(kuò)大了l倍,則(N1;N2)= (lM1)×(lM2)。用迭代反投影(Iterative Back Projection, IBP)方法對HR圖像進(jìn)行估計,公式可表示為:

(10)

3.4 算法流程

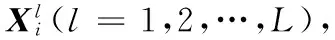

本文提出的結(jié)構(gòu)自相似性結(jié)構(gòu)神經(jīng)網(wǎng)絡(luò)算法分為兩個階段,分別為訓(xùn)練階段和重建階段,具體步驟如下。

3.4.1 訓(xùn)練過程

步驟1 輸入外部數(shù)據(jù)庫,將其縮小至原來的1/3,獲得低分辨率圖像,將其進(jìn)行插值放大得到初始高分辨率圖像。

步驟2 將外部數(shù)據(jù)庫中的初始高分辨率圖像和低分辨率圖像劃分成3×3的小塊。

步驟3 取塊,在相同尺度和不同尺度下用非局部塊匹配搜索的方法,利用式(9)找到最匹配的塊組,再用加權(quán)平均的方法求出最匹配塊。

步驟4 將匹配塊和一一對應(yīng)的低分辨率塊組成具有結(jié)構(gòu)自相似性的LR和HR圖像塊對,作為外部訓(xùn)練樣本字典。

步驟5 將具有結(jié)構(gòu)自相似性的外部數(shù)據(jù)庫LR和HR圖像對作為訓(xùn)練庫輸入卷積神經(jīng)網(wǎng)絡(luò)。

步驟6 利用式(4)學(xué)習(xí)LR到HR圖像的映射函數(shù),得到訓(xùn)練參數(shù)集Θ={W1,W2,W3,B1,B2,B3}。

3.4.2 重建過程

步驟1 利用雙三次插值將輸入單幅LR圖像放大到和HR圖像大小一樣,作為初始重建圖像X0。

步驟2 將初始重建圖像X0用多尺度非局部正則化方法提取內(nèi)部字典和非局部正則化約束參數(shù)矩陣。

步驟3 利用式(8)將外部訓(xùn)練樣本字典作為輸入,正則化約束參數(shù)矩陣作為初始訓(xùn)練參數(shù)通過卷積神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)得到卷積神經(jīng)網(wǎng)絡(luò)模型參數(shù)。

步驟4 利用內(nèi)部字典和卷積神經(jīng)網(wǎng)絡(luò)模型參數(shù)重建目標(biāo)圖像。

步驟5 采用迭代反投影算法對目標(biāo)圖像進(jìn)一步提升重建效果。

3.5 算法示例

為了更加清晰、明確地說明本文算法,給出算法流程如圖3所示。

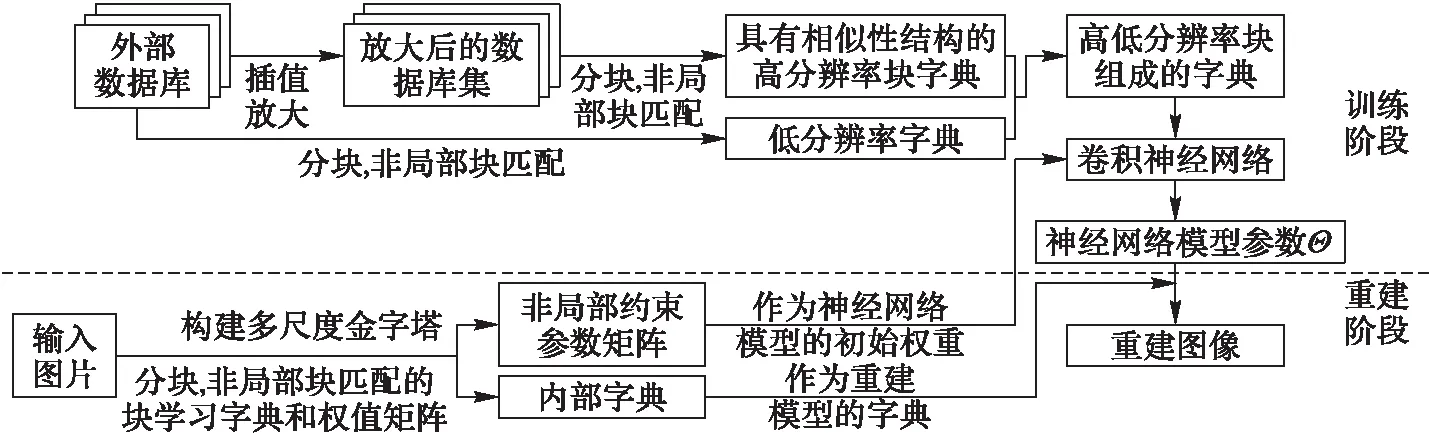

經(jīng)過卷積神經(jīng)網(wǎng)絡(luò)的過程是一種端對端映射的過程,可以用圖4的簡單示例來表示。圖4中的過程由箭頭指引分別為:輸入、第一層的特征圖、第二層的特征圖和輸出。

圖3 本文算法流程 Fig. 3 Flow chart of the proposed algorithm

圖4 卷積神經(jīng)網(wǎng)絡(luò)的示例 Fig. 4 Examples of CNN

4 實驗結(jié)果與分析

4.1 實驗設(shè)置

為了驗證所提方法的有效性,選取3個國際公開的SR數(shù)據(jù)庫:Set5、Set14和Urban100,并在三種常用放大因子(2、3和4)情況下進(jìn)行實驗驗證。實驗中采用三層卷積神經(jīng)網(wǎng)絡(luò)進(jìn)行學(xué)習(xí),利用式(1)~(3)學(xué)習(xí)得到神經(jīng)網(wǎng)絡(luò)模型,第1層的卷積核和神經(jīng)元個數(shù)為9×9和64,第2層的卷積核和神經(jīng)元個數(shù)為1×1和32,第3層的卷積核和神經(jīng)元個數(shù)為5×5和1,本文訓(xùn)練次數(shù)為5萬次。實驗中以雙三次插值(Bicubic)方法作為基準(zhǔn)對比方法,并選擇K-SVD(Singular Value Decomposition)、卷積神經(jīng)網(wǎng)絡(luò)作為對比實驗,以檢驗本方法的性能。利用峰值信噪比(Peak Signal-to-Noise Ratio, PSNR)評價不同圖像SR方法的性能。

4.2 實驗結(jié)果對比

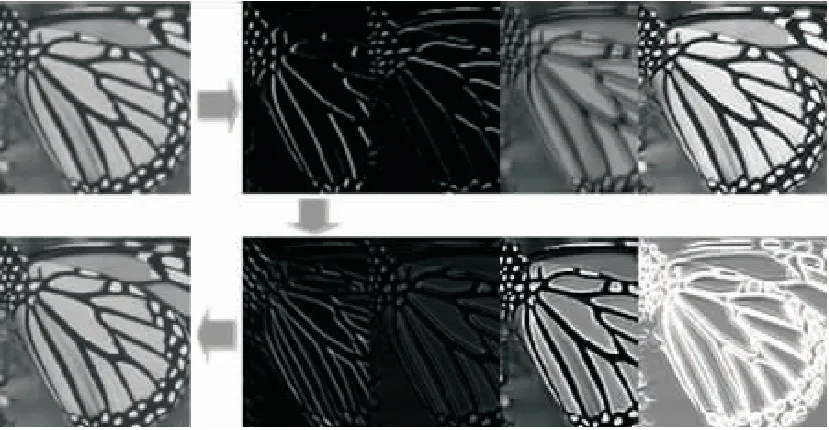

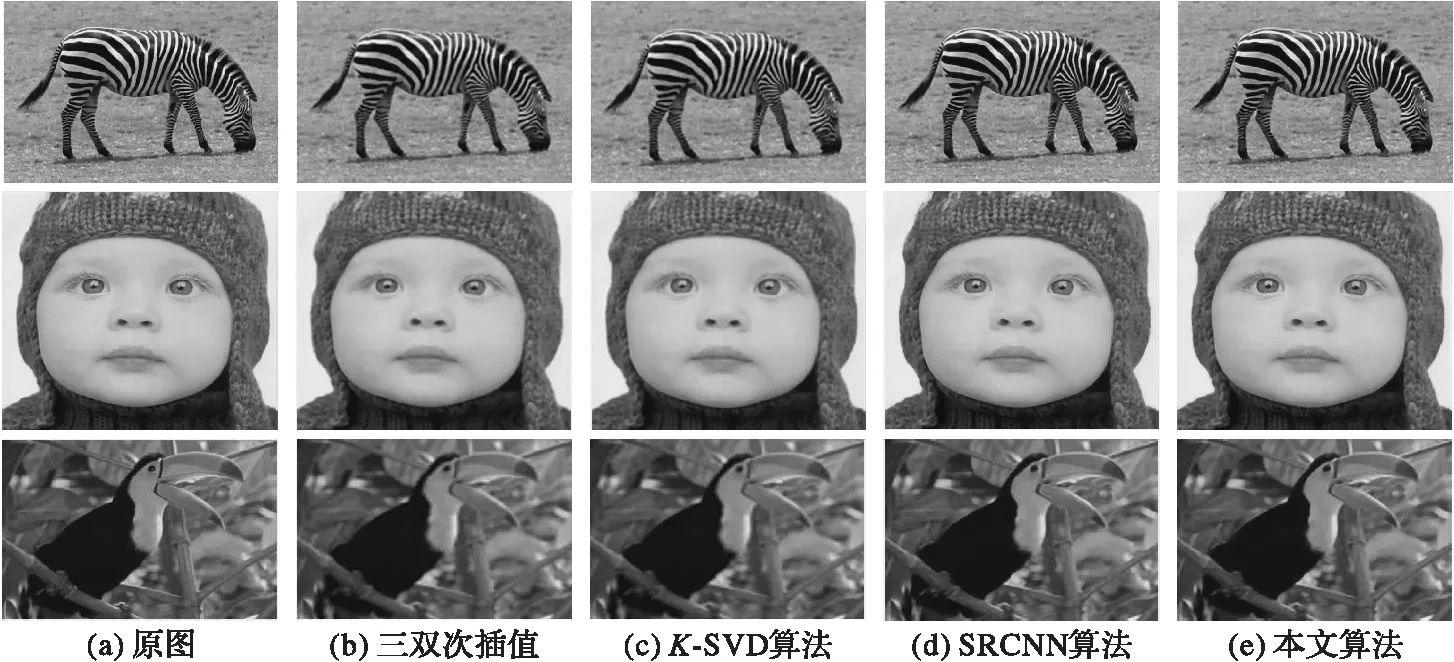

通過實驗結(jié)果來驗證本方法的有效性。為了評價圖像重建的質(zhì)量,同時從主觀視覺和客觀評價兩個方面衡量對比結(jié)果。以數(shù)據(jù)庫Set14中的斑馬圖像為例,圖5為放大3倍情況下,不同方法的主觀視覺圖和相應(yīng)峰值信噪比。

圖5 四種對比算法的圖像重建結(jié)果比較 Fig. 5 Image reconstruction comparison of four algorithms

主觀上,可以看出本文算法的視覺效果最好,優(yōu)于現(xiàn)有方法中的CNN方法和K-SVD。其他對比方法,在重構(gòu)的圖像邊緣處容易產(chǎn)生偽影和振鈴效應(yīng),一些細(xì)節(jié)沒有較好地恢復(fù)出來。本文算法恢復(fù)的局部細(xì)節(jié)信息清晰細(xì)膩,整體效果更接近原始圖像。由于本文算法考慮了內(nèi)在圖像塊自相似特性,因此恢復(fù)的視覺效果最好,產(chǎn)生的邊緣也更清晰。客觀指標(biāo)評價上,同樣以斑馬圖像(zebra)為例,在放大3倍的情況下,如表1:雙三次插值方法的峰值信噪比最低,只有26.633 dB;最好的對比算法只有28.867 dB左右;而本文算法在峰值信噪比上是最好的,能夠達(dá)到28.937 dB。

表1 不同SR方法的平均峰值信噪比對比 dBTab. 1 Average PSNR comparison of different SR methods dB

5 結(jié)語

本文算法從深度卷積網(wǎng)絡(luò)的角度來考慮單幅圖像的超分辨率問題,提出了一種基于結(jié)構(gòu)相似性和卷積神經(jīng)網(wǎng)絡(luò)的單幅圖像超分辨率重建算法。該算法通過圖像的尺度分解獲得自身結(jié)構(gòu)相似性的訓(xùn)練樣本,充分利用了輸入圖像自身具有的結(jié)構(gòu)自相似性,解決了訓(xùn)練樣本過于分散的問題。訓(xùn)練樣本通過內(nèi)在數(shù)據(jù)庫和外部數(shù)據(jù)庫相結(jié)合的方法,充分考慮了訓(xùn)練得到的先驗知識和圖像內(nèi)在的結(jié)構(gòu)自相似性。訓(xùn)練過程中的先驗知識通過卷積神經(jīng)網(wǎng)絡(luò)的端對端的非線性映射得到,圖像內(nèi)在的結(jié)構(gòu)自相似性通過非局部正則化約束項得到。最后采用迭代反投影算法進(jìn)一步優(yōu)化重建效果。本文算法與Bicubic、K-SVD和SRCNN等經(jīng)典算法相比,可以得到更好的超分辨率重建效果。

參考文獻(xiàn)(References)

[1] LI Z, HE H, WANG R, et al. Single image super-resolution via directional group sparsity and directional features [J]. IEEE Transactions on Image Processing, 2015, 24(9): 2874-2888.

[2] DONG C, LOY C C, HE K, et al. Image super-resolution using deep convolutional networks [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(2): 295-307.

[3] YANG J, WRIGHT J, HUANG T S, et al. Image super-resolution via spare representation [J]. IEEE Transactions on Image Processing, 2010, 19(11): 2861-2873.

[4] TIMOFTE R, de SMET V, van GOOL L. Anchored neighborhood regression for fast example-based super-resolution [C]// ICCV ’13: Proceedings of the 2013 IEEE International Conference on Computer Vision. Washington, DC: IEEE Computer Society, 2013: 1920-1927.

[5] TIMOFTE R, de SMET V, GOOL L. A+: adjusted anchored neighborhood regression for fast super resolution [C]// ACCV 2014: Proceedings of the 2014 Asian Conference on Computer Vision, LNCS 9006. Berlin: Springer-Verlag, 2014: 111-126.

[6] YANG C Y, YANG M H. Fast direct super-resolution by simple functions [C]// ICCV ’13: Proceedings of the 2013 IEEE International Conference on Computer Vision. Washington, DC: IEEE Computer Society, 2013: 561-568.

[7] DAI D, TIMOFTE R, van GOOL L. Jointly optimized regressors for image super-resolution [J]. Computer Graphics Forum, 2015, 34(2): 95-104.

[8] FREEDMAN G, FATTAL R. Image and video upscaling from local self-examples [J]. ACM Translations on Graphics, 2011, 30(2): Article No. 12.

[9] PROTTER M, ELAD M, TAKEDA H, et al. Generalizing the nonlocal-means to super-resolution reconstruction [J]. IEEE Transactions on Image Processing, 2009, 18(1): 36-51.

[10] MAIRAL J, BACH F, PONCE J, et al. Non-local sparse models for image restoration [C]// ICCV ’09: Proceedings of the 2009 IEEE 12th International Conference on Computer Vision. Washington, DC: IEEE Computer Society, 2009: 2272-2279.

[11] DONG C, LOY C C, HE K, et al. Learning a deep convolutional network for image super resolution [C]// ECCV 2014: Proceedings of the 2014 European Conference on Computer Vision, LNCS 8692. Berlin: Springer-Verlag, 2014: 184-199.

[12] GKASNER D, BAGON S, IRANI M. Super-resolution from a single image [C]// ICCV ’09: Proceedings of the 2009 IEEE 12th International Conference on Computer Vision. Washington, DC: IEEE Computer Society, 2009: 349-356.

[13] CANDOCIA F M, PRINCIPE J C. Super-resolution of images based on local correlations [J]. IEEE Transactions on Neural Networks, 1999, 10(2): 372-380.

[14] DONG W, ZHANG L, SHI G, et al. Nonlocally centralized sparse representation for image restoration [J]. IEEE Transactions on Image Processing, 2013, 22(4): 1620-1630.

[15] YOU X, XUE W, LEI J, et al.Single image super-resolution with non-local balanced low-rank matrix restoration [C]// ICPR 2016: Proceedings of the 2016 23rd International Conference on Pattern Recognition. Washington, DC: IEEE Computer Society, 2016: 1255-1260.

[16] XU J, ZHANG L, ZUO W, et al. Patch group based nonlocal self-similarity prior learning for image denoising [C]// ICCV ’15: Proceedings of the 2015 IEEE International Conference on Computer Vision. Washington, DC: IEEE Computer Society, 2015: 244-252.

[17] TEKALP A M, OZKAN M K, SEZAN M I. High-resolution image reconstruction from lower-resolution image sequences and space-varying image restoration [C]// ICASSP ’92: Proceedings of the 1992 IEEE International Conference on Acoustics, Speech and Signal Processing. Washington, DC: IEEE Computer Society, 1992: 169-172.

[18] LU Y, IMANURA M. Pyramid-based super-resolution of the undersampled and subpixel shifted image sequence [J]. International Journal on Systems Technology, 2002, 12(6): 254-263.

[19] AHARON M, ELAD M, BRUCKSTEIN A.K-SVD: an algorithm for designing overcomplete dictionaries for sparse representation [J]. IEEE Transactions on Signal Processing, 2006, 54(11): 4311-4322.

This work is partially supported by the Guangdong Natural Science Foundation Doctoral Program (2014A030310169), the Natural Science Foundation Project of Guangdong Province (2016A030313703, 2016A030313713), the Science and Technology Project of Guangdong Province (2016B030305002), the Science and Technology Project of Guangdong Department of Transportation (Sci. and Tech.- 2016- 02- 030).

XIANGWen, born in 1993, M. S. candidate. His research interests include image processing, pattern recognition.

ZHANGLing, born in 1968, Ph. D., professor. Her research interests include data mining, computer vision, wireless sensor.

CHENYunhua, born in 1977, Ph. D., lecturer. Her research interests include computer vision, pattern recognition, deep learning.

JIqiumin, born in 1992, M. S. candidate. Her research interests include image processing, pattern recognition.