基于改進(jìn)HOG特征提取的車型識(shí)別算法

耿慶田,趙浩宇,于繁華,王宇婷,趙宏偉*

(1.長(zhǎng)春師范大學(xué) 計(jì)算機(jī)科學(xué)與技術(shù)學(xué)院,吉林 長(zhǎng)春 130032;2.吉林大學(xué) 計(jì)算機(jī)科學(xué)與技術(shù)學(xué)院,吉林 長(zhǎng)春 130012;3.吉林大學(xué) 學(xué)報(bào)編輯部,吉林 長(zhǎng)春 130012)

1 引 言

車型識(shí)別是對(duì)車輛圖像預(yù)處理后的部分關(guān)鍵區(qū)域進(jìn)行特征提取和特征匹配,從而判斷出該車的品牌并結(jié)合車牌及車標(biāo)等識(shí)別技術(shù),進(jìn)一步協(xié)助驗(yàn)證該車的身份是否真實(shí),是否存在套牌以及假車牌等違法情況,對(duì)于打擊上述犯罪活動(dòng)具有積極的意義。

特征提取作為車型識(shí)別重點(diǎn)研究方法,很多學(xué)者對(duì)此進(jìn)行了深入的研究,并形成了多種理論算法。目前基于特征提取的汽車車型識(shí)別方法有:Sun Z等提出使用支持向量機(jī)作為分類器對(duì)Haar小波特征與Gabor特征相結(jié)合后分類學(xué)習(xí)實(shí)現(xiàn)車輛識(shí)別[1-2];呂恒利提出基于Harris角點(diǎn)和SIFT特征的車輛識(shí)別方法[3-5];華莉琴提出采用改進(jìn)SIFT特征提取及多視角的車型識(shí)別算法[6-9];李文勇給出了基于Bayes理論的感應(yīng)曲線自適應(yīng)特征提取的車型識(shí)別方法[10]。這些方法由于特征提取過(guò)程復(fù)雜,計(jì)算量大,因此識(shí)別時(shí)間較長(zhǎng),不利于實(shí)際應(yīng)用。

本文提出基于方向可控濾波器的改進(jìn)HOG特征提取算法,對(duì)車輛圖像特征進(jìn)行提取同時(shí)采用主成分分析法(PCA)約減特征向量維數(shù),降低計(jì)算的復(fù)雜程度,利用支持向量機(jī)學(xué)習(xí)方法實(shí)現(xiàn)車型的識(shí)別,提高了車型圖像的識(shí)別正確率與速度。仿真實(shí)驗(yàn)結(jié)果表明:該方法對(duì)車輛輪廓外型識(shí)別有較好實(shí)時(shí)性和較高的精確度。

2 基于方向可控的改進(jìn)HOG算法

2.1 梯度方向直方圖算法

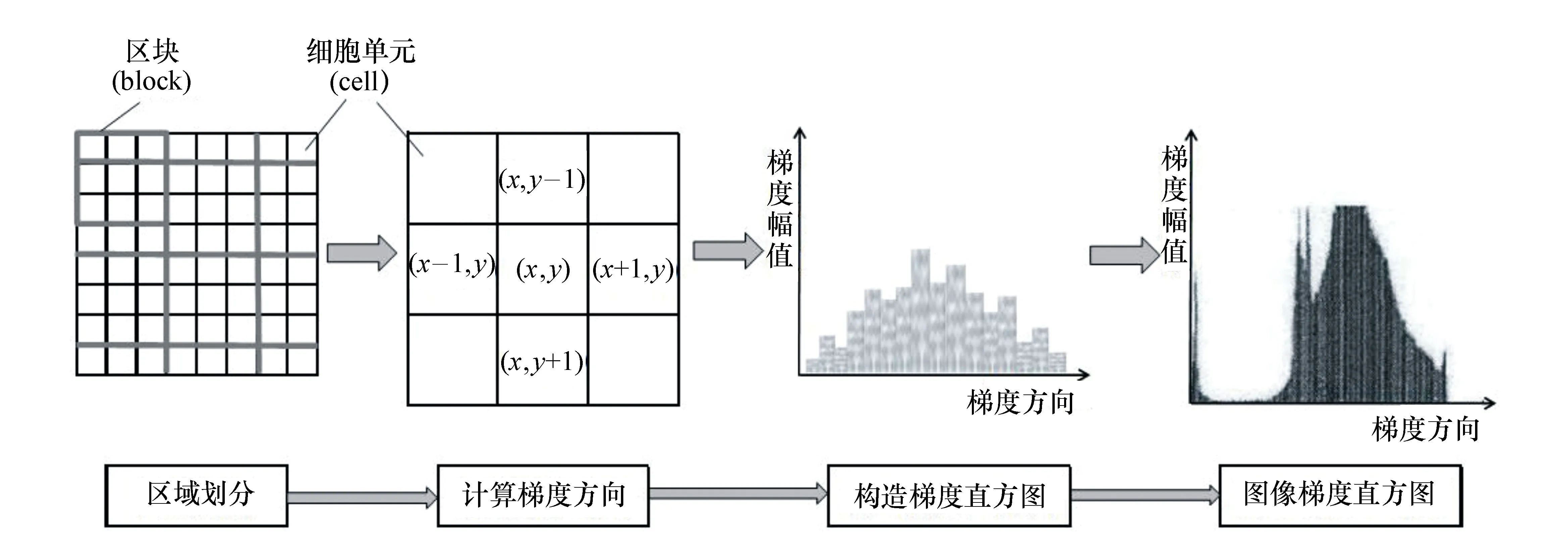

梯度方向直方圖(Histogram of Oriented Gradient,HOG)[11]算法的思想是通過(guò)邊緣方向的分布來(lái)表示圖像目標(biāo)的外形輪廓。具體做法是將被識(shí)別圖像分成若干個(gè)大小固定的區(qū)域,通過(guò)獲得該區(qū)域圖像像素梯度并進(jìn)行特征計(jì)算來(lái)累加梯度特征,從而獲得一定維數(shù)的梯度方向直方圖,如圖1所示,具體由以下幾步完成[12]:

圖1 HOG特征提取過(guò)程 Fig.1 HOG feature extraction process

(1)圖像區(qū)域分層劃分

將圖像劃為兩層,第一層互相連通Cell單元組成,幾個(gè)Cell構(gòu)成一個(gè)Block區(qū)塊,各Block可以重疊。

(2)梯度值計(jì)算

通過(guò)計(jì)算像素點(diǎn)(x,y)的坐標(biāo)方向的梯度來(lái)獲取該點(diǎn)的梯度幅值和梯度方向。具體計(jì)算公式如式(1)、(2)、(3)所示:

(1)

式中,Gx(x,y)、Gy(x,y)、H(x,y)分別表示像素點(diǎn)在二維平面垂直坐標(biāo)系中x軸和y軸方向梯度及像素值。該像素點(diǎn)處的梯度幅值與梯度方向的計(jì)算公式為:

(2)

(3)

(3)構(gòu)建梯度直方圖

將Cell的梯度方向180度等分成n個(gè)被稱為Bin的方向塊,累加每一個(gè)Cell的n維梯度幅度。

(4)塊內(nèi)歸一化

將多個(gè)Cell單元組合為Block塊,進(jìn)行對(duì)比度歸一。

(5)收集HOG特征

收集檢測(cè)窗口中所有重疊的Block塊的HOG特征。

2.2 方向可控濾波器算法

由上述HOG特征提取過(guò)程可以看出,其算法只能計(jì)算出像素點(diǎn)不夠全面的單一梯度方向信息,具有一定的缺陷,不能完全描述車型圖像的方向特征。因此,本文采用能夠獲取多方向信息的方向可控濾波器算法來(lái)彌補(bǔ)HOG算法的不足,使像素的單一方向信息擴(kuò)展為N多個(gè)方向信息。

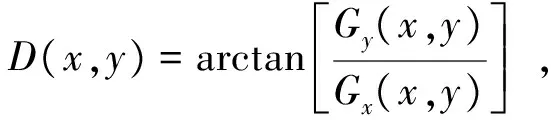

為了計(jì)算出像素點(diǎn)多個(gè)方向信息及方向幅值,Bill Freeman在1991年提出方向可控濾波器(Steerable Filter)[13]。該算法無(wú)論是邊緣檢測(cè)的效果,還是實(shí)現(xiàn)的難易程度都是較好的。其主要思想是通過(guò)在不同方向上產(chǎn)生模板去卷積圖像,從而得到圖像的邊緣。卷積過(guò)程通過(guò)加權(quán)運(yùn)算,對(duì)于有效像素增加權(quán)重,對(duì)于無(wú)效像素減少權(quán)重。一般定義分布在離散域的函數(shù)f與g二者的卷積如式(4):

(4)

方向可控濾波器的一般形式如式(5):

(5)

式中,n表示基濾波器的數(shù)量;Gi表示第i個(gè)基濾波器;ki(α)表示與方向度數(shù)α相關(guān)的濾波器的系數(shù);Gα表示α方向的濾波器。

本文獲取多方向?yàn)V波器的方法是通過(guò)對(duì)一組基濾波器的線性組合來(lái)實(shí)現(xiàn),對(duì)二維高斯函數(shù)求導(dǎo)來(lái)完成,計(jì)算公式如式(6):

G(x,y)=k(α)exp[-(x2+y2)] .

(6)

具體計(jì)算過(guò)程如式(7):

(7)

相應(yīng)系數(shù)如式(8):

(8)

(9)

式中,α表示方向可控濾波器的方向輸入角度。

2.3 改進(jìn)的HOG特征提取方法

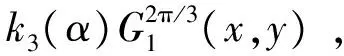

在對(duì)車型的識(shí)別過(guò)程中,最重要的是能有效的提取目標(biāo)圖像中車輛輪廓的邊界特征。由于傳統(tǒng)的HOG方法獲得的梯度方向信息對(duì)于提取邊界特征相對(duì)較弱,本文將方向可控濾波器算法與傳統(tǒng)HOG算法相結(jié)合,提出基于方向可控濾波器改進(jìn)HOG特征的HOS(Histograms of Oriented Steerable Filter)算法。該算法先用方向可控濾波器算法計(jì)算出方向值最高的方向數(shù)量及幅值信息,再使用HOG算法獲得統(tǒng)計(jì)方向直方圖特征。算法流程如圖2所示,具體計(jì)算如下:

(1)設(shè)P(x,y)為灰度圖像的像素點(diǎn),構(gòu)造P像素點(diǎn)相互垂直的兩個(gè)方向的方向可控濾波器(濾波器的方向分別取值為α與β,且α+β=π/2),分別記做Fα與Fβ。則P點(diǎn)在α與β方向的梯度值Gα(x,y)與Gβ(x,y):

(10)

其中,I表示灰度圖像。

圖2 方向可控改進(jìn)的HOG方法流程圖 Fig.2 Flow chart of improved HOG method with direction controlled

(2)計(jì)算出p像素點(diǎn)的邊界方向G(x,y)和幅值θ(x,y):

|Gα(x,y)|+|Gβ(x,y)| ,

(11)

(12)

(3)同樣將目標(biāo)圖像分為Cell單元并將毗鄰的Cell組成有重疊邊緣信息的Block塊,再按邊緣信息的梯度方向劃分區(qū)間Bin,并將Cell像素點(diǎn)的梯度幅值疊加到Bin中,得到Cell的梯度方向直方圖,最后對(duì)統(tǒng)計(jì)出Block的直方圖特征作歸一化處理,即對(duì)于向量ν做如下處理:

(13)

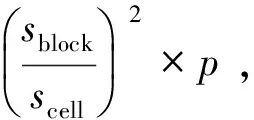

(4)最后將全部Block的HOG特征聚合為目標(biāo)圖像的HOG特征向量,向量的維度用D來(lái)表示,計(jì)算公式如式(14)所示,

(14)

式中,lwidth、lheight分別表示目標(biāo)圖像的寬度與高度;sblock、scell分別表示Block塊和Cell單元的大小;lstep表示Block移動(dòng)的步長(zhǎng);p表示Cell梯度方向的數(shù)量。

3 特征向量降維與SVM模型訓(xùn)練

3.1 PCA算法降維處理

在圖像識(shí)別過(guò)程中,如果采用原始特征空間的高維度進(jìn)行模型訓(xùn)練會(huì)使計(jì)算復(fù)雜度大大增加,致使樣本的統(tǒng)計(jì)特性無(wú)法估計(jì)。因此需要降低原始特征的維數(shù)。本文采用主成分分析PCA(Principal Component Analysis)法[14-15]實(shí)現(xiàn)特征抽取,以達(dá)到“約減維數(shù)”的目的,從而提高圖像識(shí)別速度。

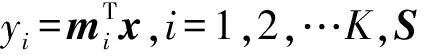

理想情況下,樣本x的特征空間沒(méi)有冗余信息,利用PCA算法可表示為(15)、(16)式:

y=MTx,

(15)

則,

(16)

其中,M=(m1,m2,…,mK)是RK特征空間的一組基底,對(duì)前k項(xiàng)的x進(jìn)行估算,可得式(17):

(17)

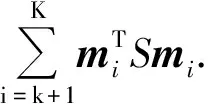

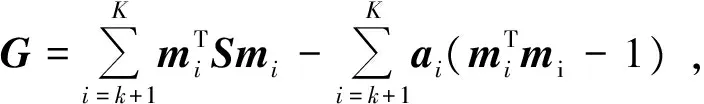

由此產(chǎn)生的均方誤差為:

(18)

根據(jù)拉格朗日乘子,在滿足式(19)的條件下可得到均方誤差極大值表達(dá)式(20):

(S-aiI)mi=0,i=k+1,k+2,…,K,

(19)

(20)

若用k個(gè)特征向量表示x時(shí),其均方誤差為式(21):

(21)

從式(21)可以得出,當(dāng)ai的值越小,對(duì)應(yīng)的特征向量信息減損越少。

本文通過(guò)改進(jìn)HOG特征提取方法同時(shí)采用主成分分析PCA法約減維數(shù)降低特征向量的維度減少了計(jì)算的復(fù)雜度,提高識(shí)別速度。

3.2 構(gòu)建SVM行為模型

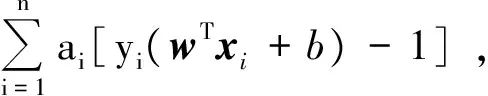

支持向量機(jī)(Supper Vector Machine,SVM)[16-18]通過(guò)在樣本空間計(jì)算出一個(gè)最優(yōu)的平面把不同的樣本區(qū)分開(kāi)。如圖5所示,H為分類面,H1、H2都平行于H,H1、H2是通過(guò)各類樣本且距H最近點(diǎn)的超平面。若H滿足分類間隔最大,則H為最優(yōu)分類面。就意味著間隔越遠(yuǎn),也就說(shuō)明該分類器的推廣能力越強(qiáng)。

設(shè)訓(xùn)練樣本集為S,則

S={(x1,y1),(x2,y2),…,(xn,yn)},

yi∈{-1,1} .

(22)

最優(yōu)分割平面方程定義為:

wTx+b=0 .

(23)

由SVM定義,若樣本線性可分,則須滿足下式條件:

yi(wTxi+b)≥1 ,

(24)

分隔間隔表示為式(25):

δjiange=yi(wTxi+b) ,

(25)

式中,yi表示所屬類別,取值范圍為[-1,1],xi是針對(duì)樣本的特征向量。

分類器用于分類的函數(shù)簡(jiǎn)寫(xiě)為式(26):

f(x)=w·x+b.

(26)

設(shè)閾值為0,由于樣本所在類已確定,則有yi(wxi+b)>0始終成立,用|f(xi)|來(lái)表示。說(shuō)明幾何間隔可用分類間隔表示,如式(27):

δjihejiange=|f(x)|/‖w‖ .

(27)

圖3 最優(yōu)分類面示意圖 Fig.3 Schematic diagram of optimal classification

在對(duì)分類間隔進(jìn)行調(diào)整后,得到最優(yōu)分類面,如圖3所示。 圖3中,H1,H2兩個(gè)分類面之間距離即是公式(27)中所定義的幾何間隔。

當(dāng)樣本發(fā)生錯(cuò)誤分類時(shí),錯(cuò)誤分類的次數(shù)T為式(28):

(28)

其中,R=‖xi‖,i=1,2,…,n,xi表示第i個(gè)樣本的特征向量。

特征向量的最大值R即為‖xi‖中的最大值。為減少錯(cuò)誤分類的次數(shù),就要求有較大的幾何間隔,故而,將任務(wù)調(diào)整為:

(29)

由此,轉(zhuǎn)化為一個(gè)最優(yōu)二次規(guī)劃問(wèn)題。此類問(wèn)題的求解可通過(guò)拉格朗日方法解決。構(gòu)造拉格朗日函數(shù)式(30):

(30)

式中,ai表示的是拉格朗日因子。分別對(duì)w,b求解偏導(dǎo)數(shù):

(31)

將式(31)的結(jié)果代回式(30),可得:

(32)

對(duì)式(32)進(jìn)行最值求解,結(jié)果就是所需要的目標(biāo)函數(shù)。

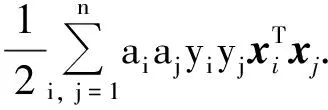

3.3 用SVM訓(xùn)練車型圖像樣本集

本文使用SVM對(duì)分類樣本的學(xué)習(xí)訓(xùn)練,從而達(dá)到完成分類的工作。進(jìn)行樣本訓(xùn)練時(shí)采用LibSVM庫(kù),由于LibSVM使用一對(duì)一策略,即兩類樣本之間構(gòu)建一個(gè)SVM,m種樣本需構(gòu)建m(m-1)/2個(gè)SVM。在對(duì)車型的樣本圖像進(jìn)行訓(xùn)練時(shí),首先將用HOS方法提取的特征向量通過(guò)PCA降維后存入一個(gè)文本文件中,每一張圖片存儲(chǔ)成一個(gè)特征向量。將特征向量轉(zhuǎn)化為標(biāo)準(zhǔn)的SVM樣本格式進(jìn)行訓(xùn)練,程序的主要參數(shù)如表1所示。

表1 樣本訓(xùn)練程序參數(shù)

為了提高SVM訓(xùn)練樣本的收斂速度,本文通過(guò)增設(shè)緩沖區(qū)的方法,將樣本分成多個(gè)樣本子集,一部分子集先預(yù)存于緩沖區(qū)中,每次都訓(xùn)練緩沖區(qū)的樣本,能被確定屬性的樣本離開(kāi)緩沖區(qū)。當(dāng)所有樣本子集都經(jīng)過(guò)訓(xùn)練后,算法結(jié)束。

4 實(shí)驗(yàn)結(jié)果及分析

4.1 數(shù)據(jù)集

為了驗(yàn)證本文算法對(duì)車型識(shí)別的性能,在實(shí)驗(yàn)中所采用的車輛圖像由本實(shí)驗(yàn)室所建的車輛圖像數(shù)據(jù)集,收集了4 000余張各種車輛圖像,圖4是數(shù)據(jù)集中的拍攝時(shí)間、角度、距離不同類型的車輛圖片,包含常見(jiàn)的SUV車型、轎車、面包車等車型,用于車輛識(shí)別檢測(cè)實(shí)驗(yàn)。在訓(xùn)練階段選取若干張車輛圖片作為正樣本,選取不同張不同交通環(huán)境背景的圖片作為負(fù)樣本,通過(guò)SVM分類器進(jìn)行訓(xùn)練,獲得正、負(fù)樣本模型。

圖4 數(shù)據(jù)集樣例圖片 Fig.4 Sample pictures of data set

4.2 同類型車型的識(shí)別結(jié)果及分析

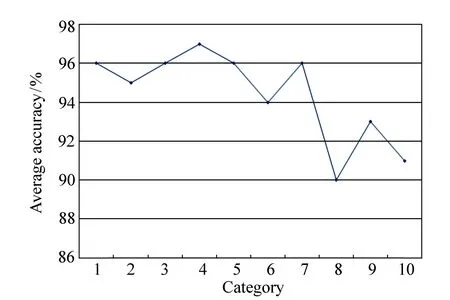

用SVM分類器測(cè)試算法時(shí)可能出現(xiàn)正樣本檢測(cè)為正樣本、正樣本檢測(cè)為負(fù)樣本、負(fù)樣本檢測(cè)為負(fù)樣本、負(fù)樣本檢測(cè)為正樣本四種情況。因此對(duì)車型檢測(cè)識(shí)別的準(zhǔn)確率定義為:

圖5 每類車輛圖片平均識(shí)別準(zhǔn)確率 Fig.5 Average image recognition accuracy for each type of vechile

為客觀檢驗(yàn)本文提出的方法在車型識(shí)別中的有效性,本文在自建的車輛圖像數(shù)據(jù)集進(jìn)行5次獨(dú)立的實(shí)驗(yàn),每次隨機(jī)選取2 058幅圖像進(jìn)行特征提取,并使用SVM進(jìn)行學(xué)習(xí)分類訓(xùn)練作為正樣本,選取1 255幅圖像進(jìn)行特征提取作為負(fù)樣本。每次隨機(jī)選取1 000幅圖片進(jìn)行識(shí)別測(cè)試,由于不同次仿真實(shí)驗(yàn)挑選不同的訓(xùn)練樣本和測(cè)試樣本,同一類車輛圖像在不同次實(shí)驗(yàn)中誤識(shí)數(shù)量也會(huì)發(fā)生變化。每類圖片識(shí)別正確率如圖5所示。

圖5說(shuō)明了各類車輛圖像識(shí)別的平均準(zhǔn)確率,第4類的平均準(zhǔn)確率最高,達(dá)到97%,這主要受此類車輛外形輪廓影響。

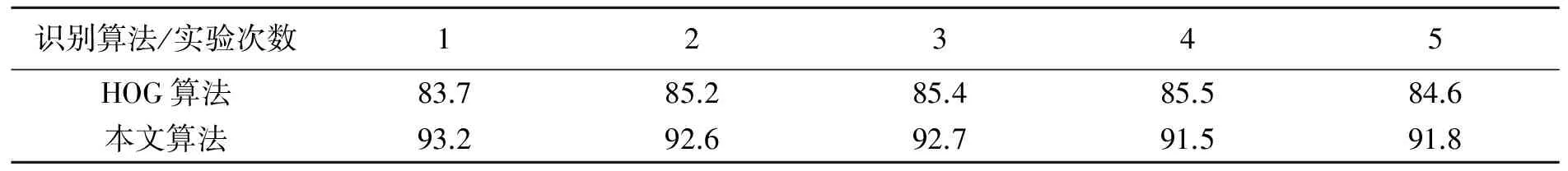

4.3 不同類型車型識(shí)別實(shí)驗(yàn)效率對(duì)比及分析

在車輛圖像數(shù)據(jù)集中,訓(xùn)練正樣本數(shù)量2 236,負(fù)樣本數(shù)量1 225,使用LibSVM在不同算法下,進(jìn)行5次實(shí)驗(yàn),每次隨機(jī)選取1 000幅圖片進(jìn)行識(shí)別測(cè)試,實(shí)驗(yàn)對(duì)比結(jié)果如表2所示。

表2車型識(shí)別實(shí)驗(yàn)結(jié)果

Tab.2 Experimental results of model identification (%)

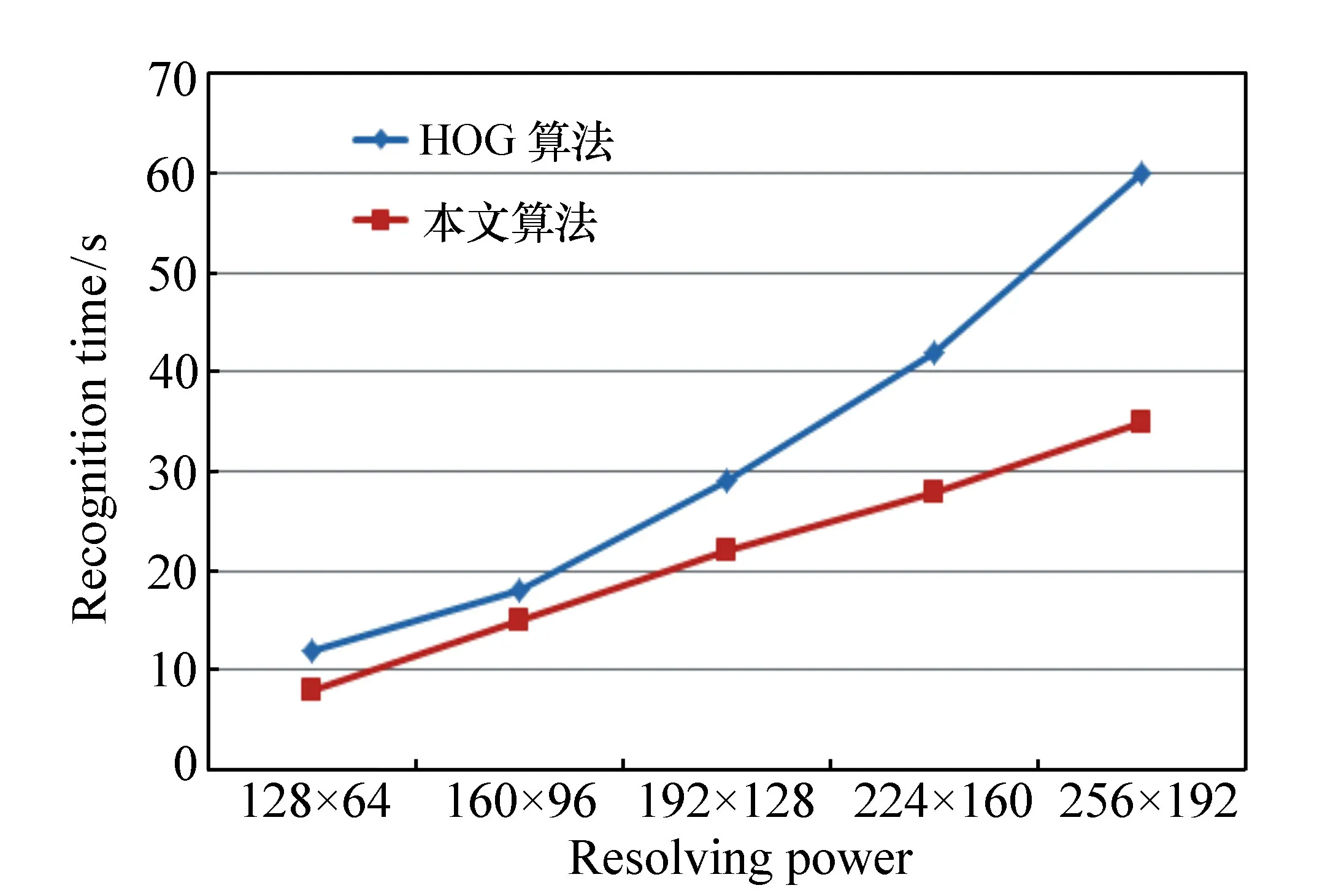

在車輛圖像分辨率大下不同的情況下,傳統(tǒng)HOG特征和改進(jìn)的HOG特征的提取時(shí)間對(duì)比如圖所示。檢測(cè)窗口的大小為128×64,滑動(dòng)距離16×16,各種分辨率條件下的車型識(shí)別時(shí)間同樣以1 000幅隨機(jī)車輛圖片為準(zhǔn)。

從識(shí)別速度對(duì)比圖(圖6)來(lái)看,在車輛圖片不同的分辨率條件下,本文提出的識(shí)別方法所用的時(shí)間較短,圖片分辨率的值越高,識(shí)別速度的差距就越大。

圖6 兩種算法不同分辨率的識(shí)別時(shí)間對(duì)比 Fig.6 Recognition time contrast of two algorithms with different resolutions

仿真實(shí)驗(yàn)結(jié)果表明,在同類型及不同類型的車輛外形識(shí)別中,本文方法有較高的識(shí)別率,平均識(shí)別率達(dá)到92.36%,高于傳統(tǒng)HOG算法的識(shí)別率84.88%。同時(shí)識(shí)別效率也高于傳統(tǒng)HOG算法,提高了3.45%。

5 結(jié) 論

本文將傳統(tǒng)的HOG算法與方向可控濾波器相結(jié)合,提出了HOS算法對(duì)車輛圖像進(jìn)行特征提取,同時(shí)采用主成分分析法(PCA)約減特征向量維數(shù),降低計(jì)算特征向量的復(fù)雜程度,并使用SVM學(xué)習(xí)方法作為樣本分類器進(jìn)行分類識(shí)別車型。仿真實(shí)驗(yàn)結(jié)果表明,本文所提出的基于改進(jìn)的HOG-SVM車輛識(shí)別算法和傳統(tǒng)HOG算法相比,具有較高識(shí)別率和識(shí)別速度,并且對(duì)不同環(huán)境背景、不同角度、不同距離有較強(qiáng)的抗干擾性,能夠滿足智能交通系統(tǒng)中車輛識(shí)別監(jiān)管的需要。

參考文獻(xiàn):

[1]PSYLLOS A,ANAGNOSTOPOULOS C N,KAYAFAS E. Vehicle model recognition from frontal view image measurements[J].ComputerStandards&Interfaces,2011,33(2):142-151.

[2]WANG Y,LI H,KIRUI C K,etal. Vehicle discrimination using a combined multiple features based on vehicle face[J].LectureNotesinElectricalEngineering,2013,256:503-511.

[4]ABADI E A J,AMIRI S A,GOHARIMANESH M,etal. Vehicle model recognition based on using image processing and wavelet analysis[J].InternationalJournalonSmartSensing&IntelligentSystems,2015,9(2):3-8.

[5]SONG M. Vehicle model recognition based on SURF[J].JournalofInformation&ComputationalScience,2015,12(17):6249-6256.

[6]ZHANG X D,QIAN W,GAO J,etal. Vehicle model recognition system based on sparse bayesian classification[J].Mini-microSystems,2005:232-238.

[7]WANG Y Q,HUANG R J,XU T Y,etal. Vehicle model recognition based on fuzzy pattern recognition method[J].AdvancedMaterialsResearch,2012,383-390:4799-4802.

[8]ZHANG Z,TAN T,HUANG K,etal. Three-dimensional deformable-model-based localization and recognition of road vehicles[J].IEEETransactionsonImageProcessing,2012,21(1):1-13.

[9]HSIEH J W,CHEN L C,CHEN D Y. Symmetrical SURF and its applications to vehicle detection and vehicle make and model recognition[J].IEEETransactionsonIntelligentTransportationSystems,2014,15(1):6-20.

[10]CHEN Z,PEARS N,FREEMAN M,etal. A Gaussian mixturemodel and support vector machine approach to vehicle type and colour classification[J].IetIntelligentTransportSystems,2014,8(2):135-144.

[11]葉峰,陳燦杰,賴乙宗,等.基于有序Hough變換的快速圓檢測(cè)算法[J].光學(xué) 精密工程,2014,22(4):1105-1111.

YE F,CHEN C J,LAI Y,etal. Fast circle detection algorithm using sequenced Hough transform[J].Opt.PrecisionEng.,2014,22(4):1105-1111.(in Chinese)

[12]宋悅,林志賢,姚劍敏.基于ε-支持向量回歸機(jī)的背光源亮度均勻性評(píng)價(jià)方法[J].液晶與顯示,2015,30(5):857-863.

SONG Y,LIN ZH X,YAO J M. Luminance uniformity evaluation for backlight based on ε-support vector regression[J].ChineseJournalofLiquidCrystalsandDisplays,2015,30(5):857-863.(in Chinese)

[13]李姜,郭立紅.基于改進(jìn)支持向量機(jī)的目標(biāo)威脅估計(jì)[J].光學(xué) 精密工程,2014,22(5):1354-1362.

LI J,GUO L H. Target threat assessment using improved SVM[J].Opt.PrecisionEng.,2014,22(5):1354-1362.(in Chinese)

[14]王洪濤,李丹.基于改進(jìn)粒子群算法的圖像邊緣檢測(cè)研究[J].液晶與顯示,2014,29(5):800-804.

WANG H T,LI D. Image edge detection based improved PSO algorithm[J].ChineseJournalofLiquidCrystalsandDisplays,2014,29(5):800-804.(in Chinese)

[15]黃璇,郭立紅,李姜,等.磷蝦群算法優(yōu)化支持向量機(jī)的威脅估計(jì)[J].光學(xué) 精密工程,2016,24(6):1448-1454.

HUANG X,GUO L H,LI J,etal. Threat assessment of SVM optimized by Krill Herd algorithm[J].Opt.PrecisionEng.,2016,24(6):1448-1454.(in Chinese)

[16]賈蘇娟,韓廣良,陳小林,等.光度非均勻彩色序列圖像超分辨率重建[J].液晶與顯示,2014,29(1):106-113.

JIA S J,HAN G L,CHEN X L,etal. Super-resolution reconstruction with photometric change of color image sequence[J].ChineseJournalofLiquidCrystalsandDisplays,2014,29(1):106-113.(in Chinese)

[17]徐超,高敏,楊鎖昌,等.視覺(jué)注意機(jī)制下的粒子窗快速目標(biāo)檢測(cè)[J].光學(xué) 精密工程,2015,23(11):3227-3237.

XU CH,GAO M,YANG S CH,etal. Visual attention mechanism-aided fast target detection by particle window[J].Opt.PrecisionEng.,2015,23(11):3227-3237.(in Chinese)

[18]柯洪昌,孫宏彬.圖像序列的顯著性目標(biāo)區(qū)域檢測(cè)方法[J].中國(guó)光學(xué),2015,8(5):768-774.

KE H CH,SUN H B. A saliency target area detection method of image sequence[J].ChineseOptics,2015,8(5):768-774.(in Chinese)

- 中國(guó)光學(xué)的其它文章

- 大相對(duì)孔徑紫外成像儀光學(xué)系統(tǒng)設(shè)計(jì)

- Finite element analysis of infrared thermal imaging forfour-layers structure of human thigh

- Optically controlled narrowband terahertzswitcher based on graphene

- 小型掠入射式近邊X射線吸收譜儀的設(shè)計(jì)

- 微分干涉差共焦顯微膜層微結(jié)構(gòu)缺陷探測(cè)系統(tǒng)

- 基于散斑干涉的光滑表面變形快速檢測(cè)